一种基于深度学习的光学合成孔径成像系统图像复原方法  下载: 1425次

下载: 1425次

1 引言

高分辨成像技术在地形测绘、天文观测、灾情监测和**侦察等领域的应用日益广泛。对于光学成像系统而言,由于衍射极限的存在,在某一特定工作波段下只能通过增加系统口径来提高其成像分辨能力。但在实际应用中,随着系统口径的增大,光学元件的设计、加工、检测难度以及光学系统的体积、质量、成本等都将迅速增加。近年来快速发展的光学合成孔径成像技术将多个子孔径按照某一特定方式排布组合在一起,以获得与单个大孔径光学系统类似的空间分辨率,这是实现与大孔径光学系统等效成像能力的一种有效、低成本途径[1]。

在光学合成孔径成像技术中,精准定位的子孔径透镜阵列将代替传统的大口径成像镜头。通过子孔径透镜阵列的光束发生会聚,在成像平面形成干涉图像。由于可见光波长较短,光学合成孔径成像系统在可见光波段的应用对系统透镜面型精度、光机结构设计和控制精度等要求较高。吕亚昆和吴彦鸿[2]总结了合成孔径技术在激光雷达成像方面的发展历程及其关键技术,李丹阳等[3]初步分析了天基合成孔径激光雷达的成像理论。然而,即使对于满足调试要求的光学合成孔径成像系统而言,其通光孔径面积与等效单孔径成像系统相比仍然较小,系统孔径的限制使系统截止频率之外的空间频率成分被拦截而无法参与成像,导致系统的实际点扩展函数(PSF)发生扩展,调制传递函数(MTF)的中频响应下降甚至缺失。同时,由于成像系统噪声的存在,光学合成孔径成像系统所成图像的清晰度受到严重影响,需要结合图像复原技术获得高分辨率图像。Bell等[4]于1996年首次提出利用图像复原技术补偿系统MTF以获得清晰图像。随后,Fienup等[5]采用多种技术实现了合成孔径系统的图像复原;Wang等[6]通过实验验证了图像复原技术的可行性;Wu等[7]利用维纳滤波算法成功复原图像;Liu等[8]通过噪声分析对图像复原技术进行了改进;魏小峰等[9]通过光瞳结构优化提高成像质量,从而减小图像复原的难度;周程灏等[10]对MTF中频补偿的图像复原方法进行了探索。不过,传统图像复原技术需要针对成像过程中的扰动特性进行分析,这严重依赖于人工设计的信息提取器。在成像过程未知的情况下,往往难以确定图像模糊和畸变的原因,导致图像复原难度增大,这时基于成像系统点扩展函数的非盲性复原算法失效。对于不同场景下的图像,传统图像复原技术需要通过专业调参以达到最优效果;对于同一场景下的不同图像,复原效果也极易受到目标种类和外界因素的干扰。传统图像复原技术各有其针对的问题,通常需要配合使用才能达到最佳效果。综上所述,传统图像复原技术的专业性、针对性有限,且其基于一定的先验信息,难以胜任各种场景图像的快速盲复原工作。

深度学习技术近年来得到快速发展,它通过构建深层神经网络并使用数据集对网络进行训练,利用众多神经节点的参数调节,建立起输入与输出之间的非线性映射关系,目前已在图像目标识别[11]、自然语言处理[12]等领域取得重大进展,并成功应用于超分辨率成像[13]、散射介质成像[14-15]、图像去噪[16-17]、全息重建[18-19]、相位提取[20-21]等光学领域。深度学习利用基于数据的特征提取器,通过大量样本的训练和优化,能够从样本中提取出感兴趣的抽象特征。在样本数据和训练时长均充足的条件下,经过训练的网络能够准确理解图像信息,并迅速产生对应输出,具有不错的鲁棒性和泛化能力,可以适应各种端对端的图像处理工作。针对光学合成孔径成像系统中的图像复原问题,本文提出一种基于深度学习的图像复原方法,在成像模型分析和数值仿真基础上,将光学合成孔径成像系统所成图像设为输入,将原始图像作为标签,构建数据集用于U型卷积神经网络的训练和测试,以实现图像复原的目的,进而通过与盲解卷积算法的图像复原效果对比,验证所提出方法的可行性和优点。

2 方法

2.1 合成孔径系统

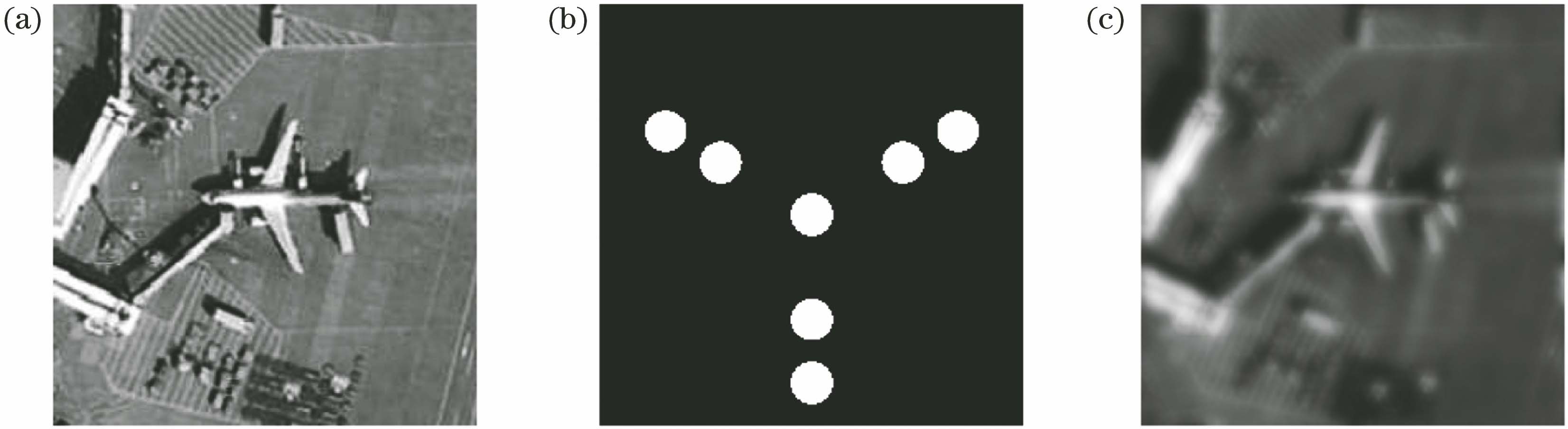

光学合成孔径成像系统(后简称为合成孔径系统)属于非相干成像系统,其成像过程可用线性系统理论来描述。在单色光条件下,合成孔径系统的点扩展函数(又称光强脉冲响应,PSF)可以表示为

式中:P(x0, y0)为系统的光瞳函数;(x0,y0)为光瞳面坐标;FT表示傅里叶变换;(x,y)为像面坐标;(fx,fy)为对应的空间频率;λ为光波波长; f为系统焦距。对PSF作傅里叶变换后进行归一化处理或对光瞳函数进行归一化自相关处理,可得到系统的光学传递函数(OTF)为

式中:di为系统出瞳平面到像平面的距离;表示自相关运算;m(fx, fy)是OTF的模,即MTF;φ(fx, fy)是OTF的幅角,即PTF。MTF和PTF分别描述了光学系统对各频率分量的对比度传递特性和施加的相移。

图 1. 光学合成孔径成像系统的成像效果。(a)原始图像;(b)合成孔径阵列分布图像;(c)所成图像

Fig. 1. Imaging effect of optical synthetic aperture imaging system. (a) Original image; (b) image of synthetic aperture array distribution; (c) imaging map

图 2. 合成孔径系统及其等效单口径系统的MTF对比。(a) MTF主峰截面曲线;(b)合成孔径系统的MTF示意图;(c)等效单口径系统的MTF示意图

Fig. 2. Comparison of MTF between synthetic aperture system and its equivalent single aperture system. (a) Section curve of main peak of MTF; (b) diagram of MTF of synthetic aperture system; (c) diagram of MTF of equivalent single aperture system

因此,根据上述系统的成像特性分析,可得到合成孔径系统所成图像在频域内的数学模型为

式中:F(fx, fy)、G(fx, fy)和N(fx, fy)分别表示原始图像的强度谱、合成孔径系统所成图像的强度谱以及附加噪声的频谱。(3)式代表系统成像过程的普遍模型。因为实际观测目标往往非常遥远,携带目标信息的光波进入合成孔径系统时可近似为平面波,并且合成孔径技术也非常适用于遥感领域,因此选取灰度遥感图像作为原始图像来模拟观测目标。在合成孔径系统的各个子孔径均精确配准的情况下,携带物体信息的光束进入合成孔径系统后,会受到系统OTF的调制并最终在像面上形成干涉图像。实际情况下,目标成像过程存在光子散射噪声、环境噪声、CCD相机的电子噪声等,在此假设合成孔径系统的成像过程较为理想,故在干涉图像上添加信噪比为60 dB~70 dB的加性高斯噪声以模拟弱噪声条件带来的影响,最终获得合成孔径系统所成图像。如

针对合成孔径系统的图像复原问题,常用的算法包括在频域内进行滤波处理的维纳滤波器和在空域内进行解卷积处理的盲解卷积算法[22-25]。然而,维纳滤波器及其变体大多需要使用成像系统的PSF作为模糊核进行图像复原,且只有在附加噪声和原始图像的功率谱之比已知或可估计情形下,才能展现出良好的图像复原能力。在系统PSF以及图像和噪声先验信息未知的情况下,图像复原效果不尽理想。本文采用盲解卷积算法,假定系统所成图像、系统PSF和原始图像均服从概率统计模型,根据贝叶斯理论并利用迭代近似找到模型的极大似然函数,以进行图像复原[26]。该算法的最大优点在于不需要准确的系统PSF和完整的图像先验信息,仅通过迭代就能够同时复原系统PSF和图像,在实际处理图像复原问题上具有较大优势。由

图 3. 盲解卷积算法的图像复原效果。(a)盲解卷积算法复原图像对比;(b)振铃现象;(c)截面灰度对比曲线

Fig. 3. Restoration effect of blind deconvolution method. (a) Restoration maps of blind deconvolution method; (b) ringing phenomenon; (c) comparison of section gray curves

2.2 U型深度卷积神经网络

深度学习通过构建多层神经网络,经过大量样本的持续训练,最终建立输入与输出之间的非线性映射关系,可替代传统算法应用于光学合成孔径系统的图像复原。与全连接神经网络相比,卷积结构的参数共享机制可使卷积神经网络的计算量大幅减少,从而节约计算资源,降低时间成本。因此,本文采用如

利用数值仿真获得的系统所成像和对应的原始图像构建数据集,将系统所成像作为网络输入,对应的原始图像作为网络标签。数据集分为训练集和测试集两部分,训练U-net的过程中,网络只会学习训练集的内容,而测试集不参与训练。训练完成后,使用测试集测试网络效果,将测试集内的系统所成像输入网络,U-net会迅速输出对应的复原图像。

2.3 图像评价标准

峰值信噪比(PSNR)和结构相似度(SSIM)是数字图像处理中常用的两种像质评价标准[30]。为便于比较,本文中同时利用PSNR和SSIM对盲解卷积算法和U-net的图像复原效果进行比较。

PSNR通过量化比较两张图像之间对应像素点值的差距来客观评价图像的失真程度,其计算公式为

式中:X、Y分别表示输入图像与原始图像;EMSE为两张图像的均方误差;H、W分别表示图像的高度和宽度;N为每像素的比特数,一般取8。一般而言,PSNR值越大,代表图像失真越少,但其像质评价结果与人的视觉感受稍有差异。SSIM是一种主观衡量两幅图像相似度的指标,其结果与人眼视觉感受较为接近,其计算公式为

式中:μX 、μY 分别表示X和Y的均值; σX、σY 分别表示X和Y的方差; σXY表示X和Y的协方差; c1=(k1L)2, c2=(k2L)2是稳定常数,其中k1=0.01,k2=0.03,L是像素的动态范围,一般取255。SSIM从亮度、对比度和结构三方面对图像质量进行评价,其取值范围为[0,1],其值越接近1,代表图像越相似。

3 分析与讨论

为证明U-net的图像复原效果以及其针对不同目标的泛化能力,针对性地设计了实验1和实验2,并从NWPU-RESISC45遥感图像集[31]中随机挑选部分图像,用于仿真其合成孔径成像结果并构建网络数据集。数据集的所有图像都经过预处理,因此其灰度分布被调整到同一范围,数据集分为训练集和测试集。实验中采用的数据集与网络之间的对应关系如

3.1 实验1

在实验1中,为证实U-net的图像复原能力以及训练集图像数量对U-net复原能力的影响,从飞机类图像中随机选取2,5,10,50,100,250,500幅图像作训练集1来训练U-net1,其中利用N幅图像的训练集所训练的网络称为U-net1(N)。训练完成后,从同类图像中随机选取50幅与训练集1不重叠的图像作为测试集1来测试复原效果,测试过程耗时约1 s。测试集1的图像复原效果如

表 1. 不同数据集与网络的对应表

Table 1. Correspondence table of different datasets and networks

| ||||||||||||||||||||||||||||||

图 5. 不同训练集下U-net1的复原效果对比

Fig. 5. Comparison of recovery effects of U-net1 under different training datasets

表 2. 测试集1的平均PSNR和SSIM

Table 2. Average PSNR and SSIM of test set 1

| |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

3.2 实验2

U-net对系统所成图像具有一定的复原能力,但在实际应用过程中难以保证所获取图像的数量,且图像种类也会受到实际条件的制约,而不同种类图像的信息差异巨大。为研究U-net的泛化能力及训练集图像种类对其泛化能力的影响,在实验2的训练集2A中选取飞机和机场两类图像各500幅,共计1000幅图像用以训练U-net2A;训练集2B选取飞机、机场、河流、沙漠等10类图像各100幅,共计1000幅图像用以训练U-net2B;测试集2则选取沙滩、桥梁、岛屿、高山等10类图像各30幅,共计300幅图像,用于测试U-net2A网络和U-net2B的复原能力。需要特别指出的是,为防止训练获得的U-net对某一类图像产生依赖,导致其在泛化过程中对其他种类图像的复原能力下降。训练集和测试集中每类图像的数量相等,但图像的选取过程完全随机,且训练集和测试集图像互不重叠。训练过程持续700个epoch,耗时约6 h。测试过程共用300幅图像,耗时约9 s。因为测试集所选图像种类与训练集没有重叠,因此可认为其测试结果证明U-net具有较好的泛化能力。从

图 6. 不同复原方法的效果对比。(a)原始图像;(b)所成图像;(c)盲解卷积所得图像;(d) U-net2A所得图像;(e) U-net2B所得图像

Fig. 6. Comparison of effects of different recovery methods. (a) Original images; (b) imaging maps; (c) images obtained by blind deconvolution; (d) images obtained by U-net2A; (e) images obtained by U-net2B

表 3. 测试集2的平均PSNR和SSIM

Table 3. Average PSNR and SSIM of test set 2

| ||||||||||||||||||

4 结论

由上述实验1和实验2的对比分析可知,在弱噪声条件下,U-net能够成功复原合成孔径系统所成图像,并在复原效果上与盲解卷积算法接近。在训练过程中,U-net仅需少量含有丰富信息的图像构成训练集,而对图像种类没有严格要求,可训练出具有良好复原能力和泛化能力的U-net。面对完全陌生且没有任何先验信息的合成孔径系统所成图像,U-net能够快速、便捷地开展复原工作。与盲解卷积算法相比,U-net能够有效避免振铃现象,且盲复原能力更强,在使用时无需任何先验信息和参数调节过程就能获得清晰的复原图像,其耗时仅为盲解卷积算法的1/100,更加适用于需要大批量复原图像和实时反馈的场景。

[1] Barakat R. Dilute aperture diffraction imagery and object reconstruction[J]. Optical Engineering, 1990, 29(2): 131-139.

[2] 吕亚昆, 吴彦鸿. 合成孔径激光雷达成像发展及关键技术[J]. 激光与光电子学进展, 2017, 54(10): 100004.

[3] 李丹阳, 吴谨, 万磊, 等. 天基合成孔径激光雷达成像理论初步[J]. 光学学报, 2019, 39(7): 0728002.

[4] Bell KD, Boucher RH, VacekR, et al.Assessment of large aperture lightweight imaging concepts[C]//1996 IEEE Aerospace Applications Conference. Proceedings, February 10, 1996, Aspen, CO, USA.New York: IEEE Press, 1996: 187- 203.

[5] Fienup J R, Griffith D K, Harrington L, et al. Comparison of reconstruction algorithms for images from sparse-aperture systems[J]. Proceedings of SPIE, 2002, 4792: 1-8.

[6] Wang D, Han J, Liu H, et al. Experimental study on imaging and image restoration of optical sparse aperture systems[J]. Optical Engineering, 2007, 46(10): 103201.

[7] Wu Q Y, Qian L, Shen W M. Image recovering for sparse-aperture systems[J]. Proceedings of SPIE, 2005, 5642: 478-486.

[8] LiuL, Jiang YS, Wang CW. Noise analysis and image restoration for optical sparse aperture systems[C]//2008 International Workshop on Education Technology and Training & 2008 International Workshop on Geoscience and Remote Sensing, December 21-22, 2008, Shanghai, China.New York: IEEE Press, 2008: 353- 356.

[9] 魏小峰, 耿则勋, 曹力, 等. 一种新的光学合成孔径系统成像性能指标与光瞳优化方法[J]. 光学学报, 2014, 34(11): 1111001.

[10] 周程灏, 王治乐, 张树青, 等. 大孔径衍射受限光学合成孔径系统MTF中频补偿[J]. 光学学报, 2018, 38(4): 0411005.

[11] WangF, Jiang MQ, QianC, et al.Residual attention network for image classification[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA.New York: IEEE Press, 2017: 6450- 6458.

[13] Rivenson Y, Koydemir H C, Wang H, et al. Deep learning enhanced mobile-phone microscopy[J]. ACS Photonics, 2018, 5(6): 2354-2364.

[16] Zhang K, Zuo W M, Chen Y J, et al. Beyond a Gaussian denoiser: residual learning of deep CNN for image denoising[J]. IEEE Transactions on Image Processing, 2017, 26(7): 3142-3155.

[17] Yan K T, Yu Y J, Huang C T, et al. Fringe pattern denoising based on deep learning[J]. Optics Communications, 2019, 437: 148-152.

[18] Wang K Q, Dou J Z, Qian K M, et al. Y-Net: a one-to-two deep learning framework for digital holographic reconstruction[J]. Optics Letters, 2019, 44(19): 4765-4768.

[20] Wang K Q, Li Y, Qian K M, et al. One-step robust deep learning phase unwrapping[J]. Optics Express, 2019, 27(10): 15100-15115.

[21] Wang K Q, Di J L, Li Y, et al. Transport of intensity equation from a single intensity image via deep learning[J]. Optics and Lasers in Engineering, 2020, 134: 106233.

[22] 魏小峰, 耿则勋, 宋向. 光学合成孔径复原图像的振铃探测与消除[J]. 光学精密工程, 2014, 22(11): 3091-3099.

[23] Xu W H, Zhao M, Li H S. Non-iterative wavelet-based deconvolution for sparse aperture system[J]. Optics Communications, 2013, 295: 36-44.

[24] Kundur D, Hatzinakos D. Blind image deconvolution[J]. IEEE Signal Processing Magazine, 1996, 13(3): 43-64.

[25] Kundur D, Hatzinakos D. A novel blind deconvolution scheme for image restoration using recursive filtering[J]. IEEE Transactions on Signal Processing, 1998, 46(2): 375-390.

[26] Yang HL, Chiao YH, Huang PH, et al. Blind image deblurring with modified Richardson-Lucy deconvolution for ringing artifact suppression[C]// Proceedings of the 5th Pacific Rim conference on Advances in Image and Video Technology, November 20-23, 2011, Heidelberg: Springer, 2011: 240- 251.

[27] RonnebergerO, FischerP, BroxT. U-net: convolutional networks for biomedical image segmentation[M] //Lecture Notes in Computer Science. Cham: Springer International Publishing, 2015: 234- 241.

[29] Srivastava N, Hinton G E, Krizhevsky A, et al. Dropout: a simple way to prevent neural networks from overfitting[J]. Journal of Machine Learning Research, 2014, 15(1): 1929-1958.

[30] HoréA, ZiouD. Image quality metrics: PSNR vs. SSIM[C]//2010 20th International Conference on Pattern Recognition, August 23-26, 2010, Istanbul, Turkey. New York: IEEE Press, 2010: 2366- 2369.

[31] Cheng G, Han J W, Lu X Q. Remote sensing image scene classification: benchmark and state of the art[J]. Proceedings of the IEEE, 2017, 105(10): 1865-1883.

唐雎, 王凯强, 张维, 吴小龑, 刘国栋, 邸江磊, 赵建林. 一种基于深度学习的光学合成孔径成像系统图像复原方法[J]. 光学学报, 2020, 40(21): 2111001. Ju Tang, Kaiqiang Wang, Wei Zhang, Xiaoyan Wu, Guodong Liu, Jianglei Di, Jianlin Zhao. Deep Learning Based Image Restoration Method of Optical Synthetic Aperture Imaging System[J]. Acta Optica Sinica, 2020, 40(21): 2111001.