基于柔性靶标定位实现图像拼接的多相机三维测量系统  下载: 1325次

下载: 1325次

1 引言

条纹投影三维(3D)测量技术具有非接触、成本低、速度快和使用方便等优点[1-2],广泛应用于逆向工程[3]、工业在线检测[4-5]、医学成像[6]和文物保护[7]等领域。该技术通过投影仪向被测物体投射编码条纹,相机采集被物体表面调制的条纹,标定调制的条纹相位变化与物体高度之间的关系即可完成物体表面三维形貌的测量。

传统的条纹投影三维测量技术通常由单投影仪和单相机组成,受相机分辨率和视场(FOV)范围限制,无法完成较大测量范围的高精度测量,因此常常需要增加相机数量以扩展视场范围。多相机测量时,每个相机分别进行局部标定,可以完成各自世界坐标系下的测量,但各个相机测量数据不具有统一性,不能对整个被测对象实现一致性描述,因此需要通过全局标定建立全局坐标系。

为了建立全局坐标系,Kawabata等[8]使用了覆盖整个视场的大型靶标,通过靶标图案的几何配准完成各个相机坐标系的相互转换。该方法的标定过程要求精度较高,而精密大型靶标通常成本较高,灵活性差,加工困难。也可以通过辅助仪器建立全局坐标系:Lu等[9]提出了使用双经纬仪测量系统实现全局标定的方法,利用双经纬仪测量靶标特征点的全局世界坐标,即可求解全局坐标系与局部坐标系的转换关系,该方法标定精度高,但需要借助精密辅助设备;Zhang等[10]提出了将投影仪视作反向相机的标定方法,将条纹投影测量系统转化为立体视觉测量系统,随后汤明等[11]扩展了该方法,通过矩阵链乘运算完成邻近相机或投影仪的坐标系转换,该方法可适用于多投影仪、多相机系统,并且使用方便,适应性强,应用范围较广。

本文提出了一种使用柔性靶标定位的方法,利用光栅条纹的相位值完成图像拼接标定,再利用小型平面靶标完成基准相机二维图像坐标到三维世界坐标的标定,从而实现全局标定。其中柔性靶标为具有任意表面特征的物体,其尺寸无需任何高精度加工,仅满足相邻相机匹配同名点的要求即可,因而柔性靶标具有成本低、选用灵活的特点。该全局标定方法无需借助精密大型靶标和辅助设备,具有成本低、结构简单、适应性强等优点。

2 原理

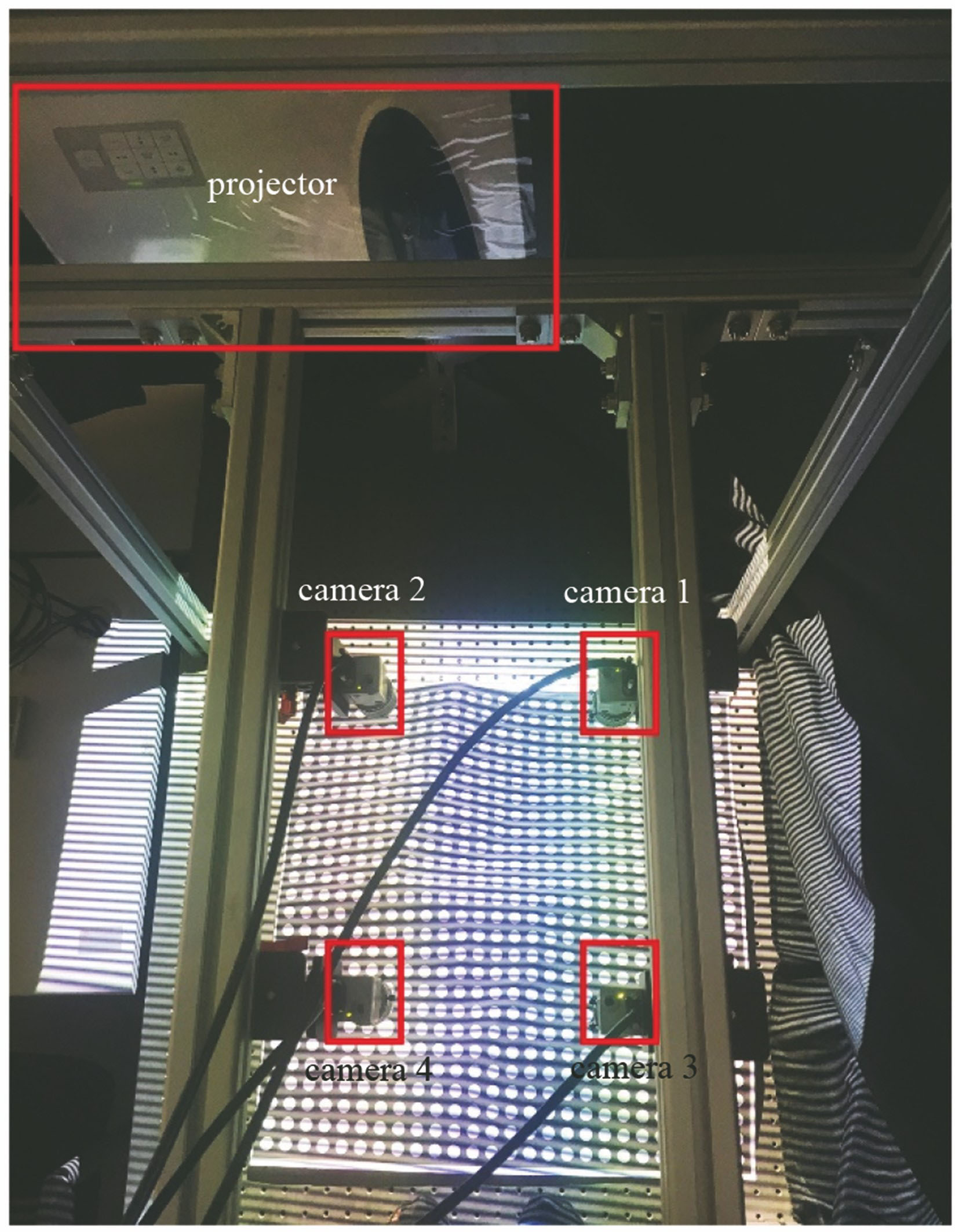

多相机条纹投影三维测量系统采用激光投影仪投射大幅条纹,4个相机分布式采集调制条纹图像。

2.1 相位轮廓术

条纹投影三维测量系统常用正弦相移条纹进行测量[12],以四步相移为例,设I1(u,v),I2(u,v),I3(u,v),I4(u,v)分别为4幅相移条纹图的亮度值,相邻相移图的相位差为π/2,则可得折叠相位为

ϕ(u,v)的取值范围为[0,2π),由于反正切函数的周期性,在视场中呈现周期性分布。为了在单个相机只能拍到部分视场的情况下获取整个视场的全局相位,需要进行相位展开。相位展开方法常使用差频法:对波长分别为λ0和λ1的条纹图像作差,可以获得波长为λ01=λ0λ1/(λ1-λ0)的条纹图像,通过选取合适的波长,即可获得在整个视场中仅有1个周期的相位图像,即全局相位图像。由于λ01/λ0取值过大时会放大图像中的随机噪声,通常选择依次投射条纹数分别为N,N-1,N-

2.2 图像新型拼接算法

传统的图像拼接算法是将不同时刻、使用不同相机采集的同一场景图像,通过图像配准实现几何对齐,将多幅图像拼接为1幅图像[14]。对于多相机的情况,各个相机的位置和姿态互不相同,待拼接的图像存在平移、旋转和尺寸伸缩等几何空间差异。常用的图像转换模型主要有刚体变换、仿射变换、投影变换和多项式变换等[15],其中多项式变换既能实现各种线性变换,也能解决图像中存在的非线性问题,应用广泛[16]。该变换可表示为

式中:(u1,v1)为目标相机的图像坐标;(u2,v2)为待转换相机的图像坐标;n为多项式次数;ai,j,bi,j为多项式系数。多项式拟合模型一般只适用于拍摄表面高度变化不大,近似平面的物体[17]。在三维测量中,物体表面形貌是任意变化的,并且需要测量物体的z坐标,直接使用传统的多项式变换模型不能完成测量任务。

条纹投影三维测量系统中,物体的高度h与调制条纹的全局相位值φ存在一定的对应关系[18],全局相位值的变化可以反映物体表面形貌高度的变化。考虑将全局相位值作为新变量引入多项式模型中,扩大模型的适用范围,使新多项式模型满足三维测量的要求。由于全局相位值可以有纵横2个方向φx和φy,新的模型至少需要引入其中1个,提出如下2个模型:

式中:ai,j,k,bi,j,k,ai,j,k,s,bi,j,k,s为多项式系数。(3)式为(u,v,φx)构成的三元多项式模型,(4)式为(u,v,φx,φy)构成的四元多项式模型。

多项式次数较高时,高次项会显著放大图像噪声,因而多项式次数不应超过3次,同时相位与高度的模型不呈线性关系,多项式次数适合选取2次或3次。由此(3)式和(4)式共有三元二次、三元三次、四元二次、四元三次4个模型可选,利用两相机的重合视场中的同名点定位建立(u1,v1)和(u2,v2)两图像坐标的映射关系[19]。

2.3 系统标定方法

相机畸变模型中含有图像坐标(u,v)的高次项,单独使用图像新型拼接算法完成标定不足以校正图像畸变,因此需要标定各个相机的畸变系数,对采集的图像进行畸变校正[20]。典型的相机畸变模型如下:

式中:(u,v)为理想图像坐标;(ud,vd)为实际图像坐标;r=

完成畸变校正后,需要将所有相机的二维图像坐标转化到基准相机的二维图像坐标系中,为此需要完成图像拼接标定。图像拼接标定使用柔性靶标,其表面特征(如圆轮廓、角点或其他任何可以用图像处理方法提取的特征点)可以是任意的,仅用于同名点定位匹配,而且该靶标不需要物方世界坐标,其尺寸不需要任何精密加工。将柔性靶标在视场内摆放成多种形态,投影仪投射纵横多频相移条纹,完成相位展开后获得全局纵横相位值(φx,φy),两相机通过定位全局纵横相位值相同的同名点完成图像点匹配。

获得N组匹配点后,将其代入(3)式和(4)式,通过Levenberg-Marquardt算法进行优化求解[21],计算匹配点的估算值(

求解多项式参数,即可完成图像拼接标定。

完成图像拼接后,所有相机的二维图像坐标都转化到基准相机的二维图像坐标系中,再使用小型平面靶标标定基准相机二维图像坐标和相位值到三维世界坐标的映射关系[22],应用的多项式模型为

式中:(x,y,z)为三维世界坐标;m为多项式次数;pi,j,k,qi,j,k,ri,j,k为多项式系数。此处m取3时有较好的结果[23]。再次应用Levenberg-Marquardt算法,计算估算值(

求解多项式参数,即可完成系统标定。

3 实验

根据上述系统模型和标定方法,构建多相机三维测量系统。测量系统实验装置如

图 1. 多相机条纹投影三维测量实验装置图

Fig. 1. Experimental setup for multi-camera three-dimensional shape measuring system using digital fringe projection techniques

3.1 系统标定

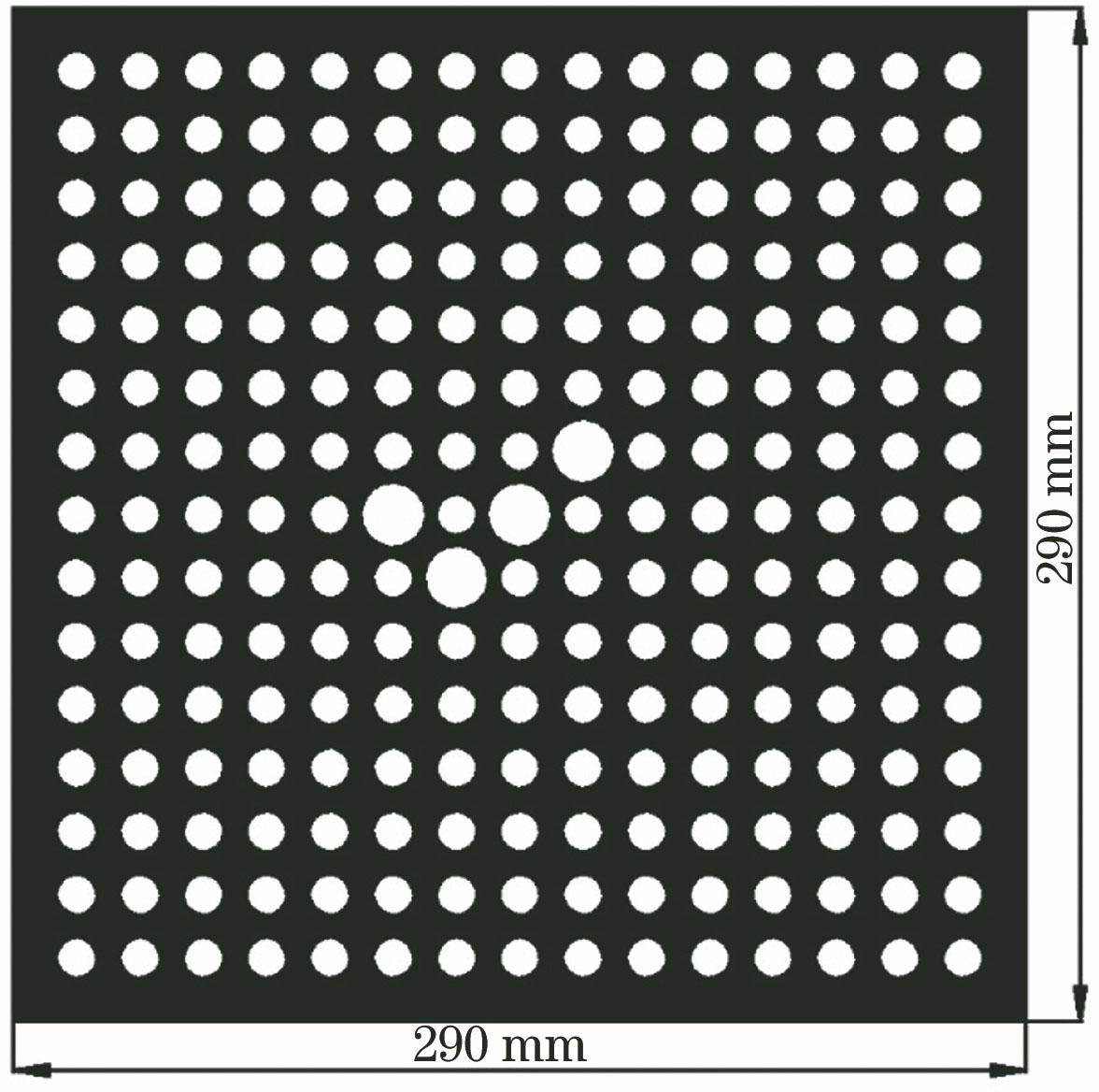

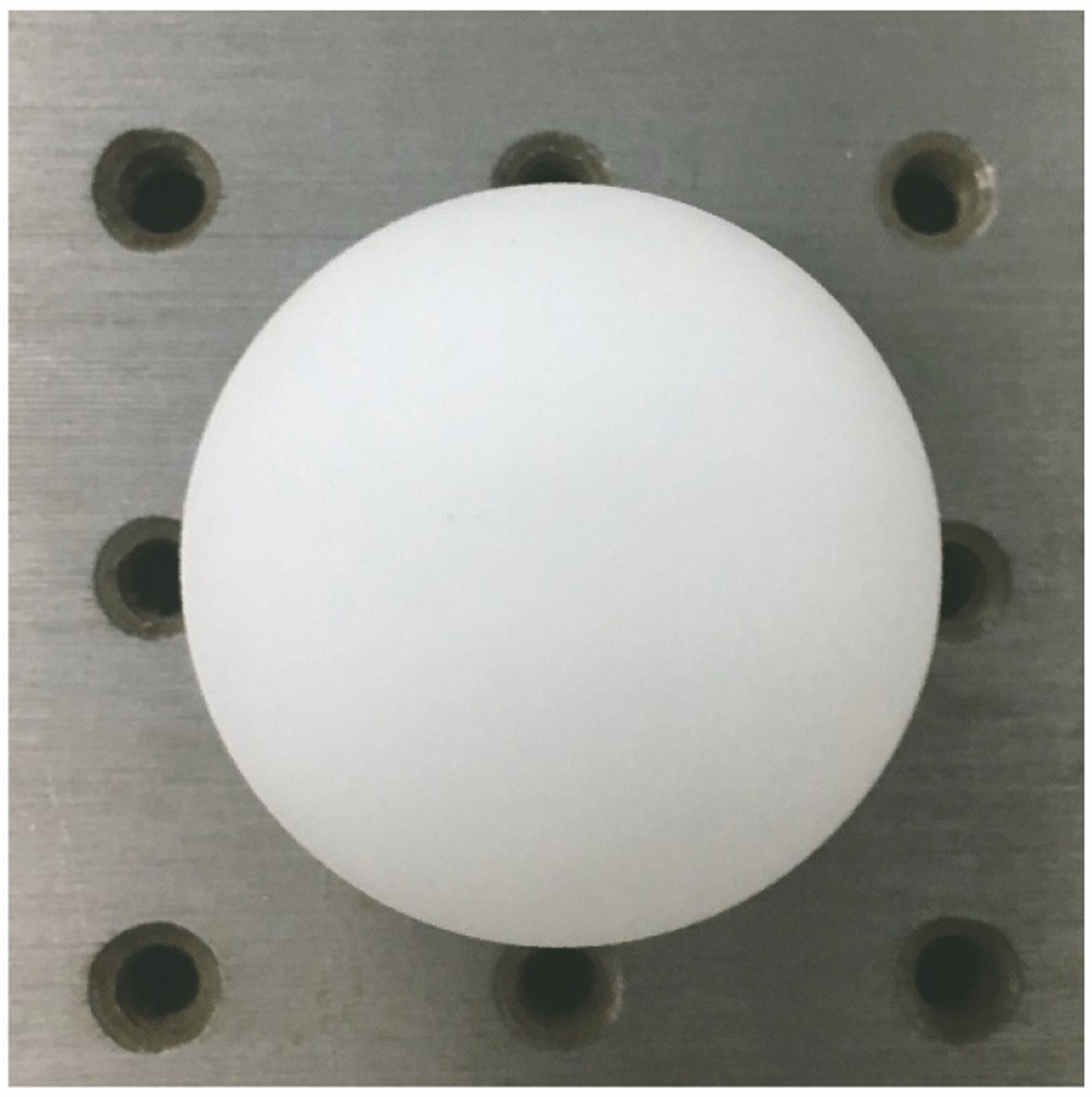

标定过程中,各相机首先标定相机畸变系数,标定使用的方向性平面圆靶标图案如

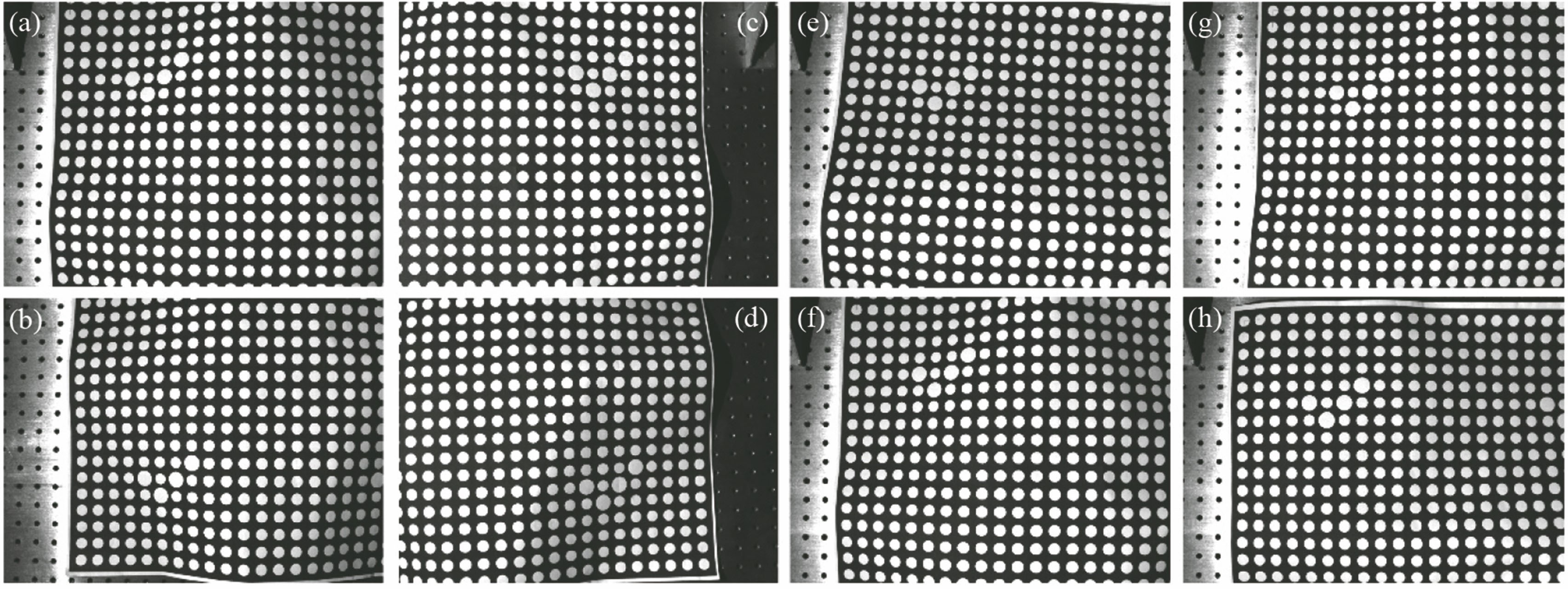

随后进行图像拼接标定,使用一张打印了圆靶标的纸作为柔性靶标,如

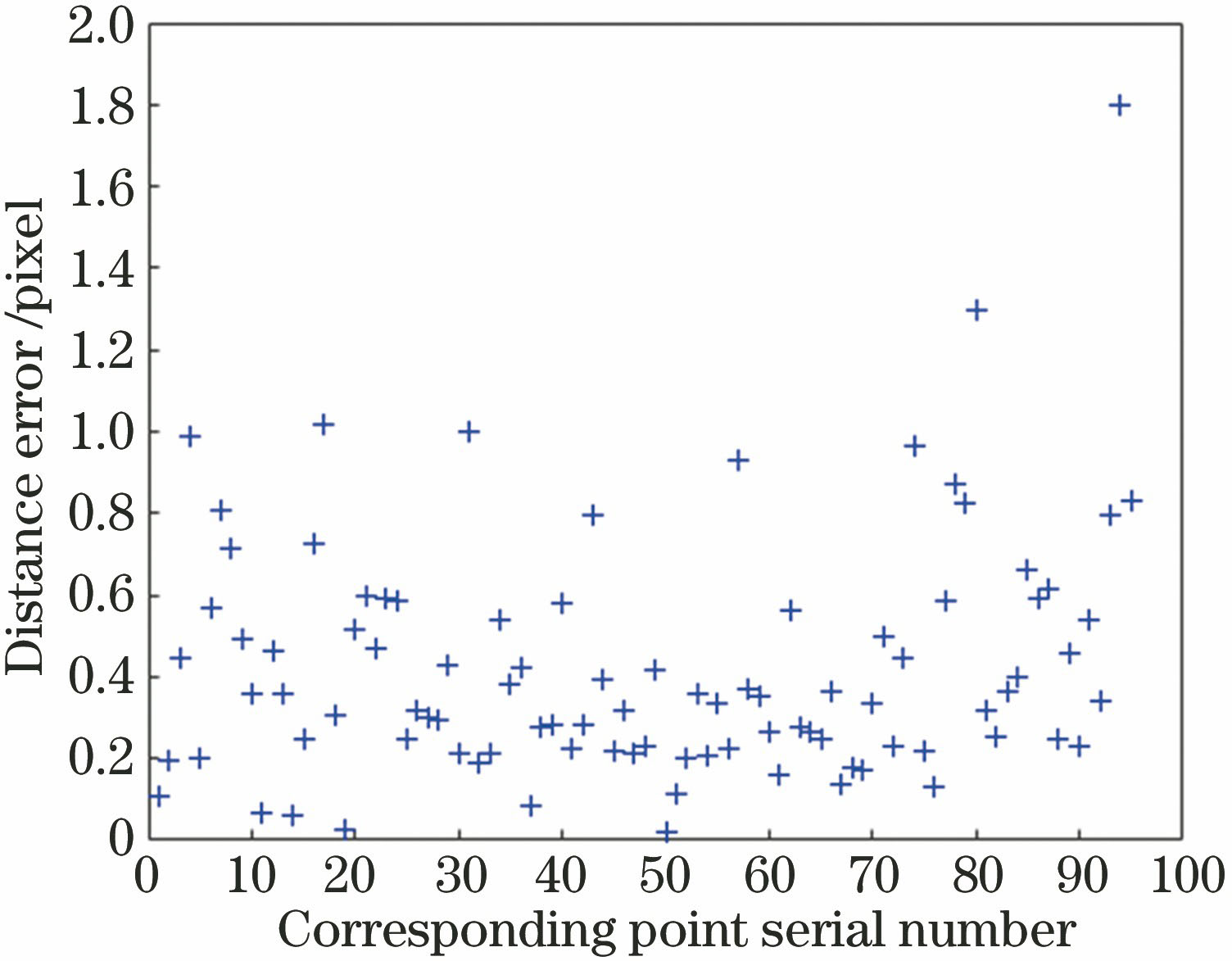

标定误差如

图 3. (a)~(d)不同相机采集的同一柔性靶标图像。(a) 1号相机;(b) 2号相机;(c) 3号相机;(d) 4号相机。(e)~(h) 1号相机采集的不同形态的柔性靶标图像。(e)形态1;(f)形态2;(g)形态3;(h)形态4

Fig. 3. (a)-(d) Images of the flexible calibration target grabbed by different cameras. (a) Camera 1; (b) camera 2; (c) camera 3; (d) camera 4. (e)-(h) Images grabbed by camera 1 of the flexible calibration target with different shapes. (e) Shape 1; (f) shape 2; (g) shape 3; (h) shape 4

图 4. 2号相机到1号相机的四元二次模型标定误差图

Fig. 4. Calibration error diagram from camera 2 to camera 1 in quaternary quadratic model

3.2 测量结果与分析

系统测量时同样投射条纹数为81,80,72的纵横四步相移条纹,展开相位为(φx,φy),除基准相机以外的其他相机将图像坐标代入(3)式或(4)式得到基准相机图像坐标系下的图像坐标,最后将计算得到的图像坐标代入(7)式得到三维世界坐标,生成三维点云数据。

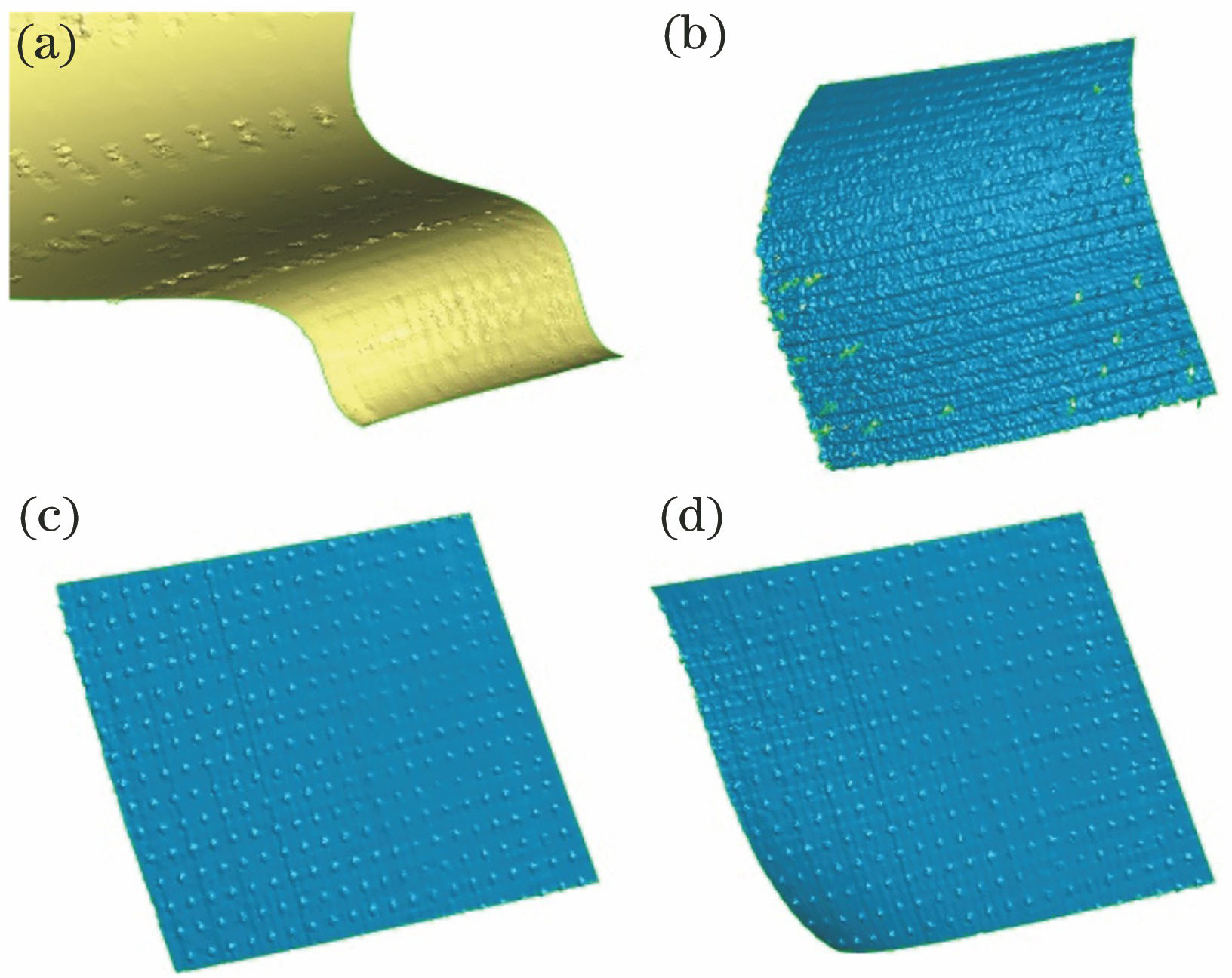

实验中首先测量光学平台平面,对比(3)式和(4)式中的4种模型的测量结果并比较模型的稳定性。选用经过2次转换的4号相机,4种模型封装点云后的测量结果如

图 5. 4种多项式模型对比测量结果。(a)三元二次模型;(b)三元三次模型; (c)四元二次模型;(d)四元三次模型

Fig. 5. Measurement results of 4 different polynomial models. (a) Ternary quadratic model; (b) ternary cubic model; (c) quaternary quadratic model; (d) quaternary cubic model

利用(4)式将四元二次模型展开,展开形式为

式中:a1~a15,b1~b15为模型需要求解的参数。

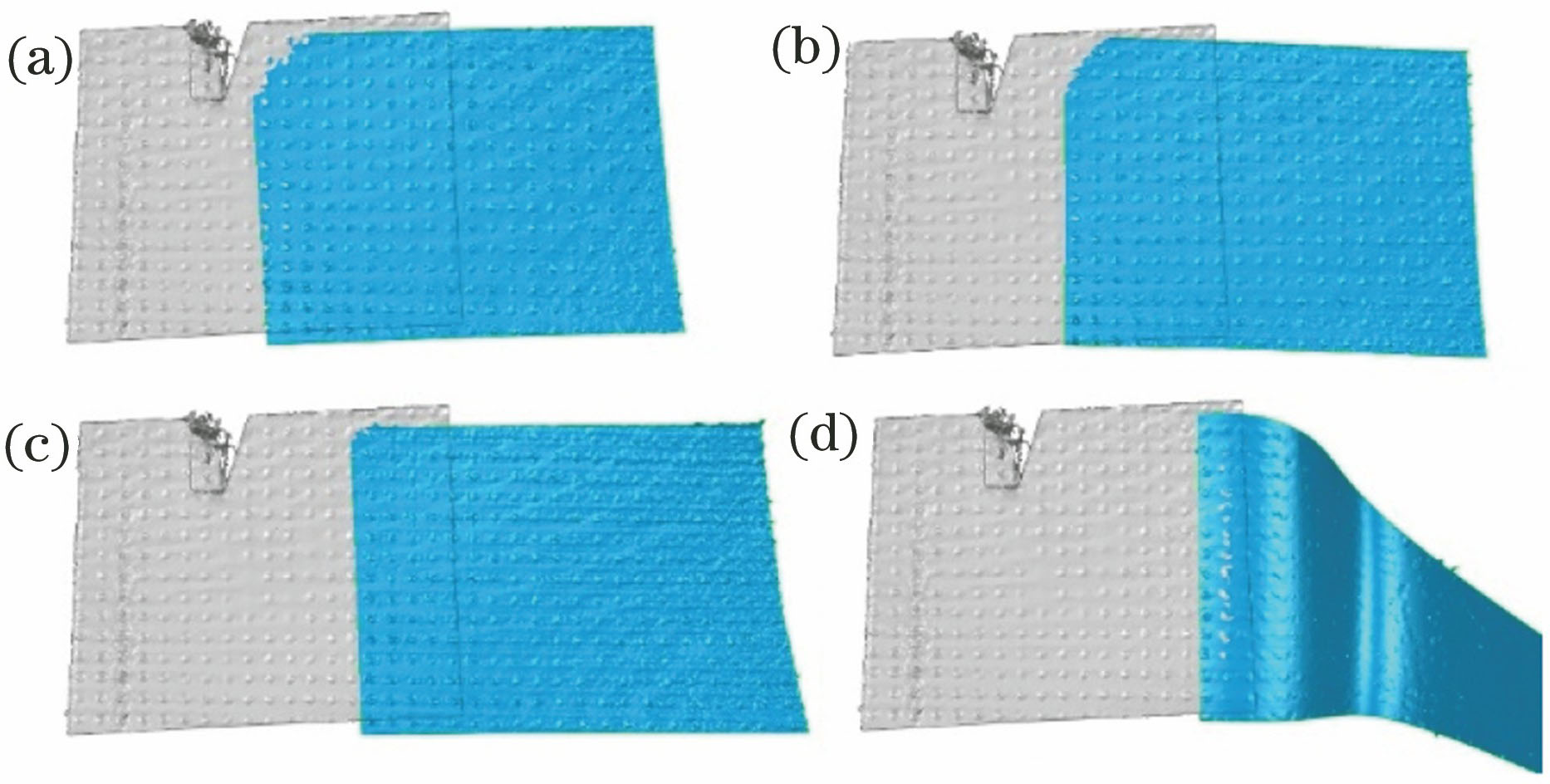

为了对比重合视场大小不同时的测量结果,再次测量光学平台平面。令1号相机作为基准相机保持不动,移动3号相机以产生不同大小的重合视场。测量结果如

图 6. 不同视场重合对比测量结果。(a) 1/2;(b) 1/3;(c) 1/4;(d) 1/6

Fig. 6. Measurement results of different FOV overlapping. (a) 1/2; (b)1/3; (c) 1/4; (d) 1/6

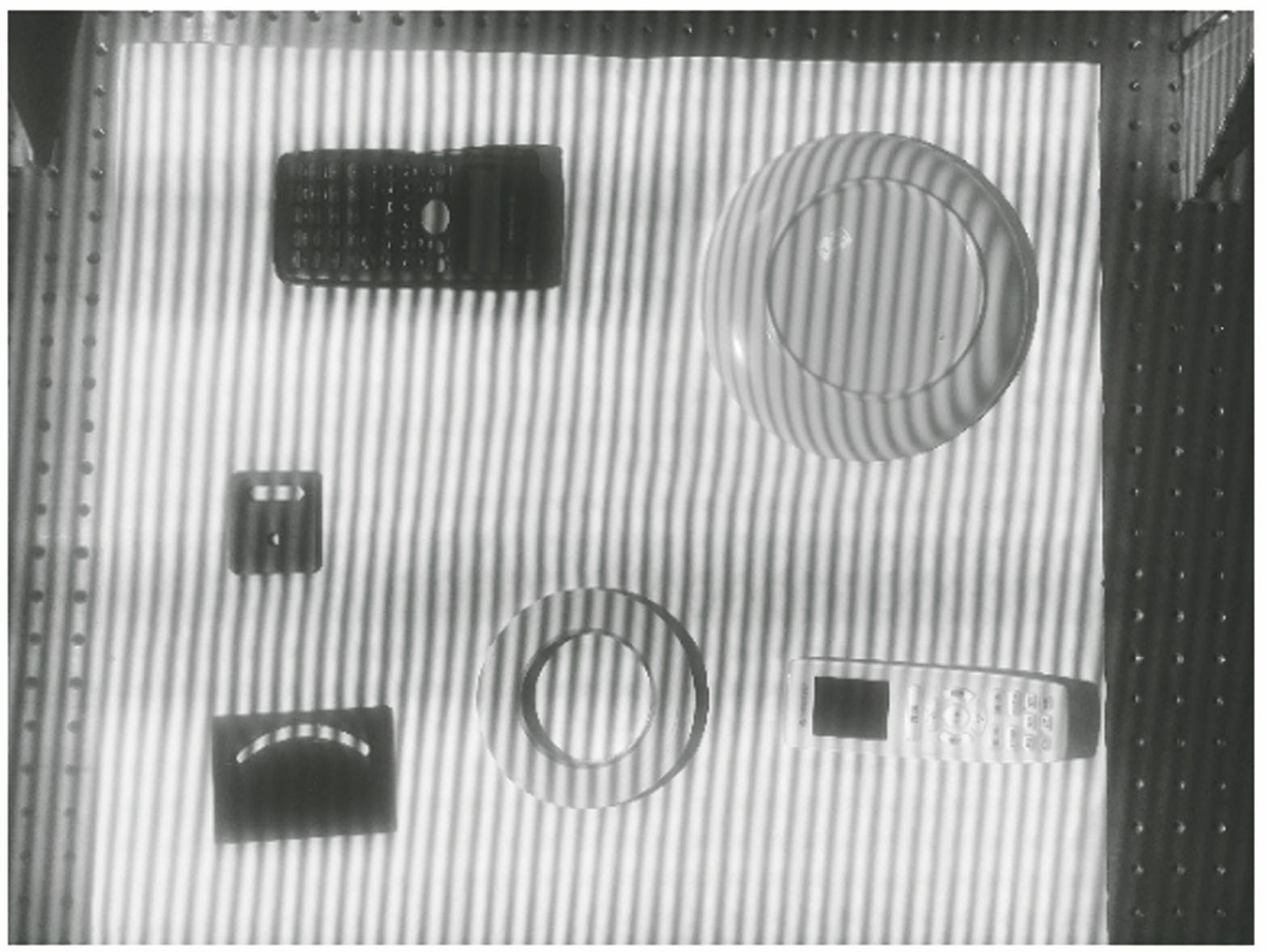

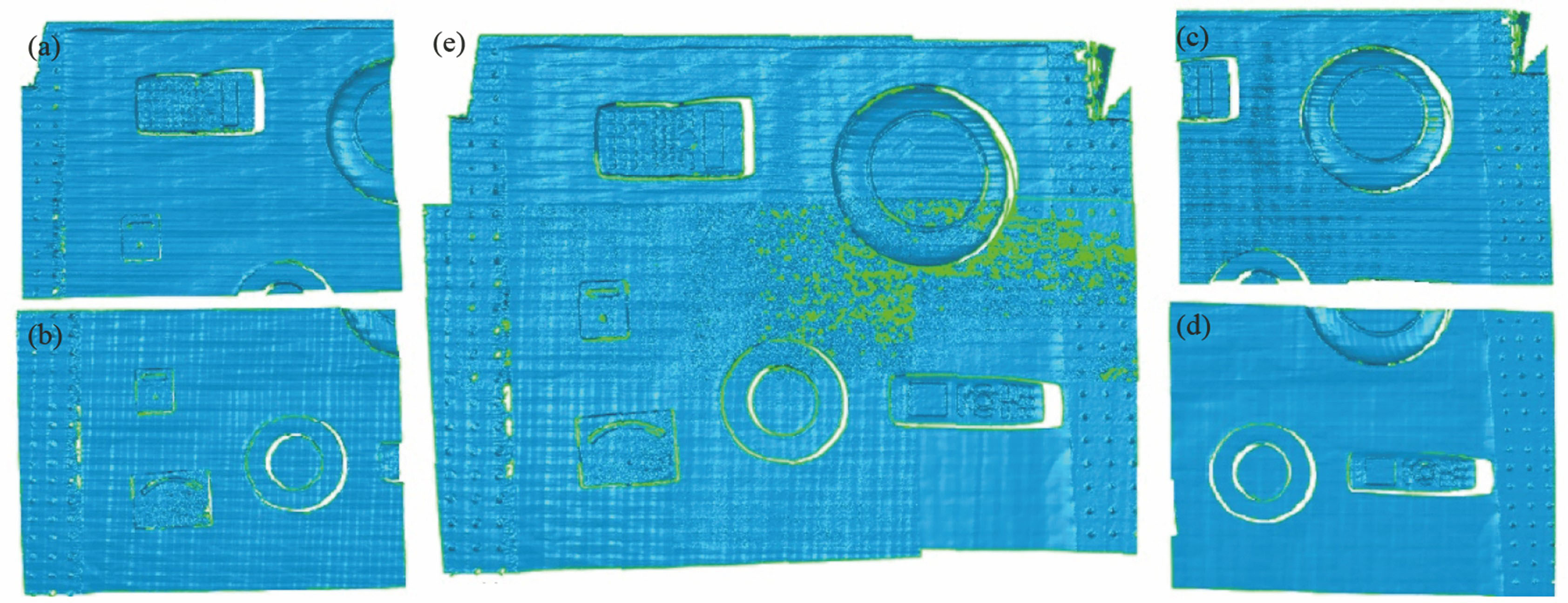

为了直观观察使用图像拼接方法获得的三维点云测量效果,定性判断该方法的有效性,将多个被测物体摆放在视场中,测量整个视场的表面形貌,被测物照片如

图 8. 三维重建结果。(a) 1号相机;(b) 2号相机;(c) 3号相机;(d) 4号相机;(e)合并

Fig. 8. 3D reconstruction images. (a) Camera 1; (b) camera 2; (c) camera 3; (d) camera 4; (e) merged image

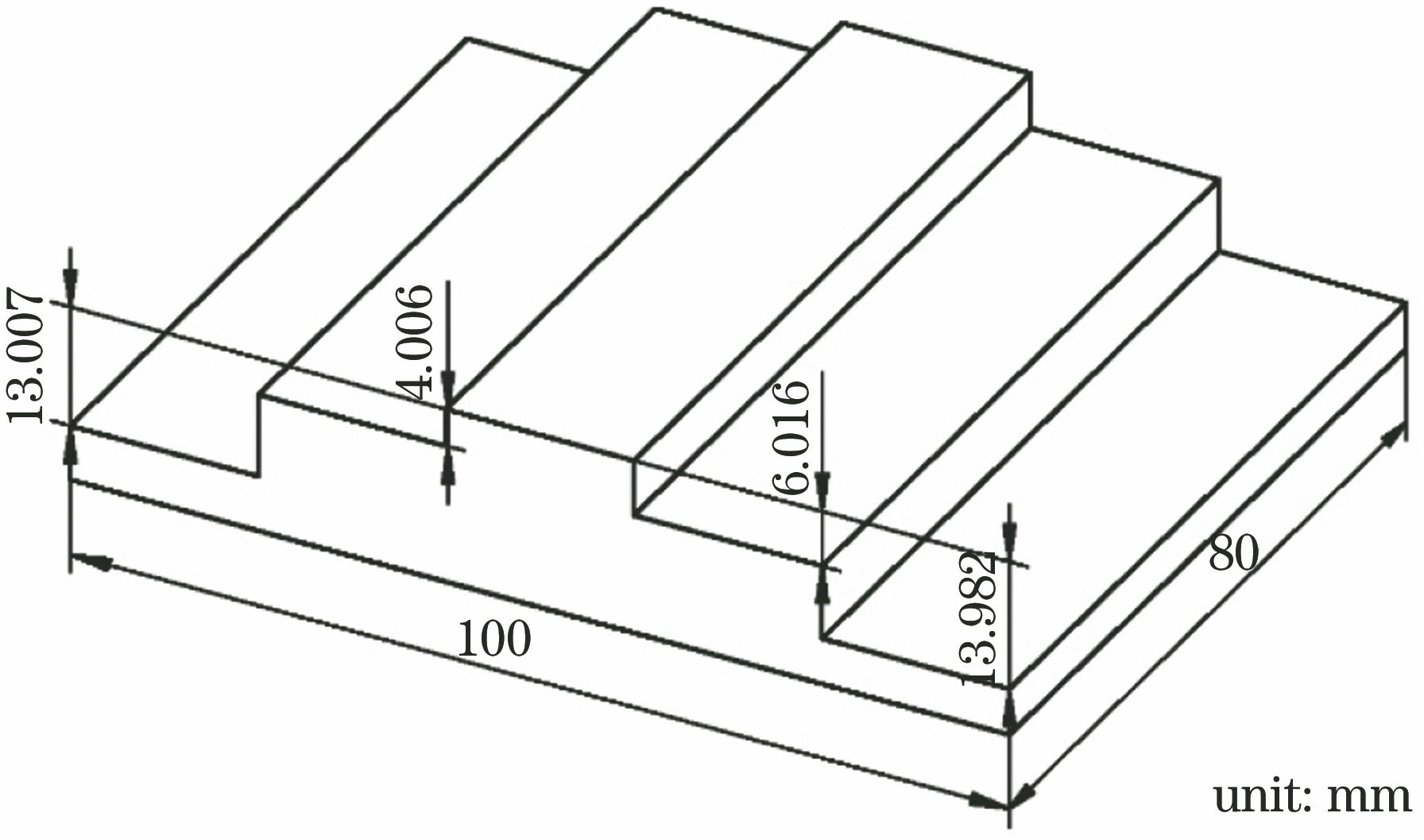

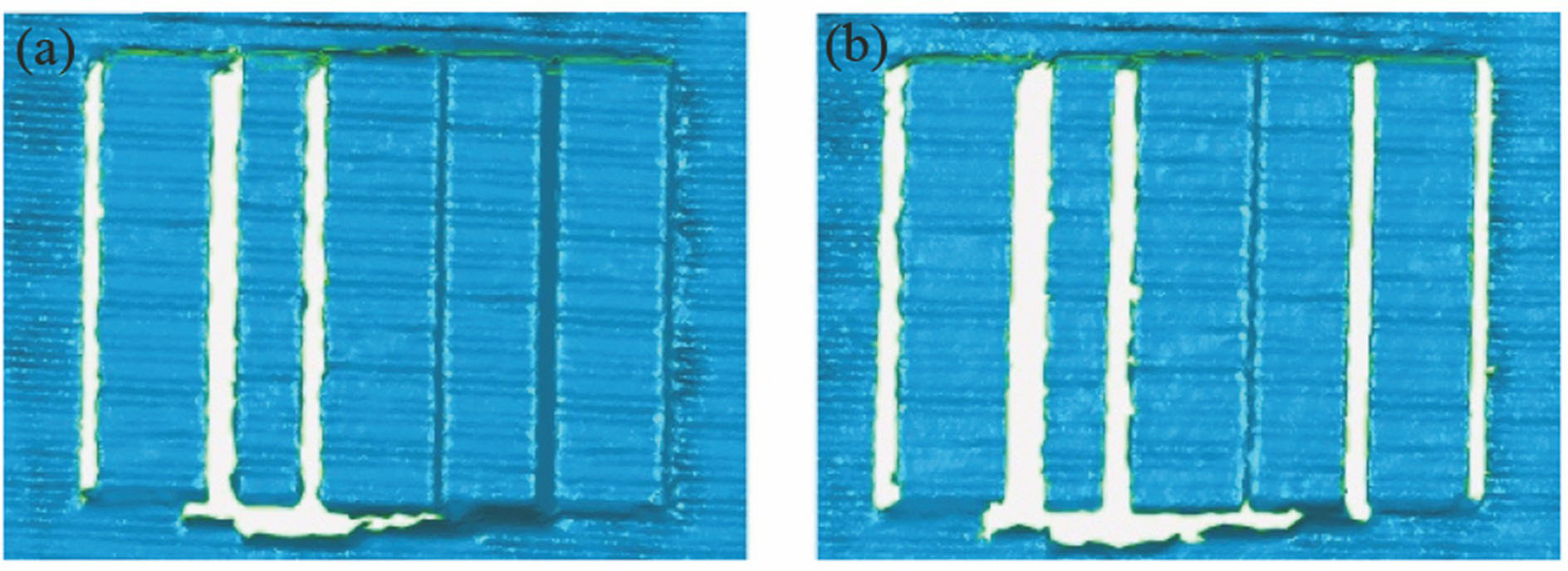

为了定量评估使用图像拼接方法获得的测量结果的准确度,首先使用阶梯状标准块作为被测物。该标准块如

图 10. 2号相机(a)方法1与(b)方法2的台阶三维重建结果

Fig. 10. 3D reconstruction image of the step standard block by camera 2 using (a) method 1 and (b) method 2

表 1. 阶梯标准块测量结果

Table 1. Measurement results of the step standard block

|

由

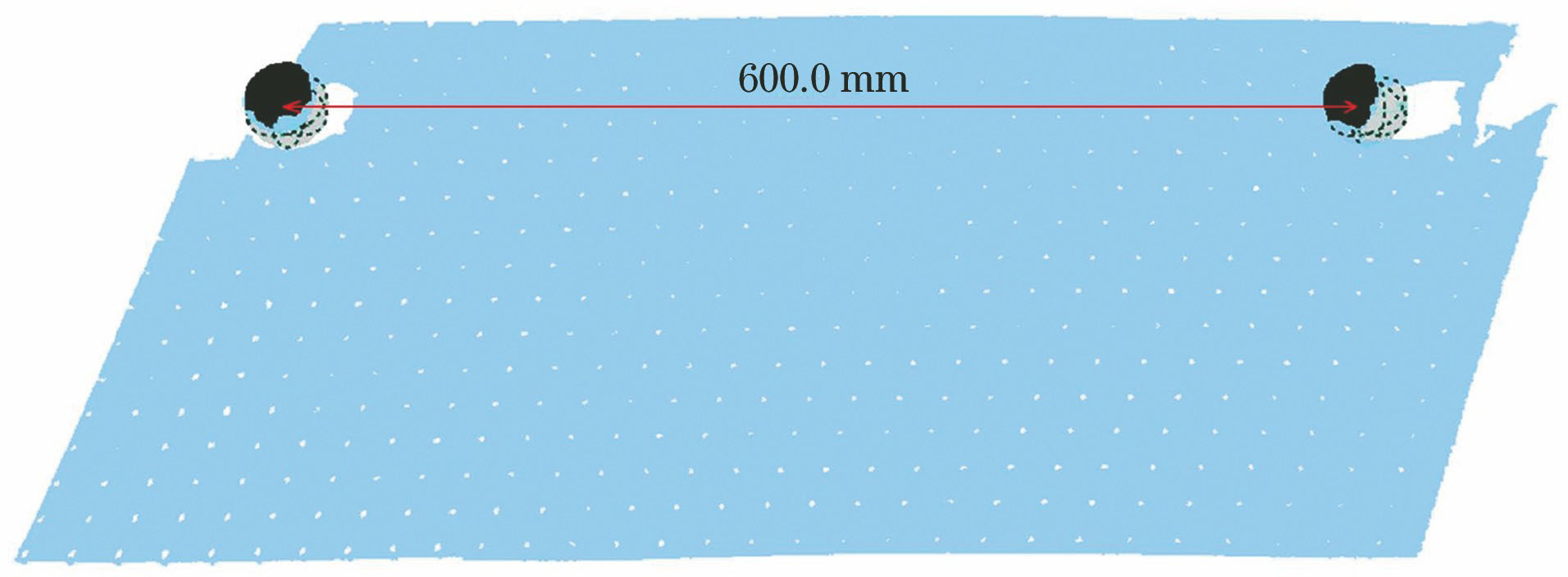

随后测量标准球的球心距,选用哑光陶瓷标准球如

考虑到相机纵横视场大小、各相机的相对位置及定位孔的位置,分别测量3组球心距。第1组将两个标准球分别置于1号相机和2号相机视场的定位孔中,使其间距为400.0 mm,第2组将两个标准球分别置于1号相机和3号相机视场的定位孔中,使其间距为600.0 mm,第3组将两个标准球分别置于1号相机和4号相机视场的定位孔中,使其间距为721.1 mm(即以400.0 mm和600.0 mm为直角边的直角三角形斜边长度)。获得合并点云后,拟合球冠点云数据,

由

表 2. 球心距测量结果

Table 2. Measurement results of the sphere center distance

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||

4 结论

提出了一种基于柔性靶标定位实现图像拼接的多相机三维测量系统,在相邻相机部分视场重合的前提下,利用柔性靶标定位建立相邻相机二维图像坐标的一一映射,由基准相机图像坐标到世界坐标的映射完成全局三维测量。根据实验结果对比,图像拼接方法适合选用四元二次多项式模型,相邻相机至少需要1/3重合视场。该测量方法能够同时测量大视场中多个物体,其测量精度略低于相机单视场测量的精度,但精度损失较小,满足工业在线测量的要求。由于柔性靶标为任意表面特征的物体,其尺寸无需任何高精度加工,仅满足相邻相机定位匹配同名点的要求即可,避免了使用昂贵的辅助测量仪器和加工高精度大型靶标,实现了成本低、结构简单、适应性强、精度高的多相机条纹投影测量系统全局标定。

未来基于图像拼接方法的多相机条纹投影三维测量系统的研究方向,主要是如何在较小重合视场的情况下,保证测量系统的鲁棒性和测量结果的准确性,进一步扩展系统的应用范围。

[2] 陆鹏, 孙长库, 王鹏. 条纹投影相位高度转换映射模型及其标定方法[J]. 光学学报, 2018, 38(2): 0212004.

[3] Park S C, Chang M. Reverse engineering with a structured light system[J]. Computers & Industrial Engineering, 2009, 57(4): 1377-1384.

[4] Song L M, Qu X H, Yang Y G, et al. Application of structured lighting sensor for online measurement[J]. Optics and Lasers in Engineering, 2005, 43(10): 1118-1126.

[5] 彭旷, 曹益平, 武迎春. 一种无需滤波的复合光栅投影的在线三维测量方法[J]. 光学学报, 2018, 38(11): 1112003.

[6] Xue J P, Zhang Q C, Li C H, et al. 3D face profilometry based on galvanometer scanner with infrared fringe projection in high speed[J]. Applied Sciences, 2019, 9(7): 1458.

[7] 任卿, 刁常宇, 鲁东明, 等. 基于结构光的文物三维重建[J]. 敦煌研究, 2005( 5): 102- 106.

RenQ, Diao CY, Lu DM, et al. Three-dimensional reconstruction of cultural relics based on structural light[J]. Dunhuang Research, 2005( 5): 102- 106.

[8] KawabataS, KawaiY. Plane based multi camera calibration under unknown correspondence using ICP-like approach[C]//Proceedings of the 21st International Conference on Pattern Recognition (ICPR2012), November 11-15, 2012, Tsukuba, Japan. New York: IEEE, 2012: 13325367.

[9] Lu R S, Li Y F. A global calibration method for large-scale multi-sensor visual measurement systems[J]. Sensors and Actuators A: Physical, 2004, 116(3): 384-393.

[10] Zhang S, Huang P S. Novel method for structured light system calibration[J]. Optical Engineering, 2006, 45(8): 083601.

[11] 汤明, 达飞鹏, 盖绍彦. 基于光栅投影的多摄像机标定方法[J]. 仪器仪表学报, 2016, 37(9): 2149-2155.

Tang M, Da F P, Gai S Y. Multi-cameras calibration approach based on fringe projection[J]. Chinese Journal of Scientific Instrument, 2016, 37(9): 2149-2155.

[12] Liu X R, Kofman J. Background and amplitude encoded fringe patterns for 3D surface-shape measurement[J]. Optics and Lasers in Engineering, 2017, 94: 63-69.

[13] Towers C E, Towers D P. Jones J D C. Absolute fringe order calculation using optimised multi-frequency selection in full-field profilometry[J]. Optics and Lasers in Engineering, 2005, 43(7): 788-800.

[15] 何援军. 图形变换的几何化表示: 论图形变换和投影的若干问题之一[J]. 计算机辅助设计与图形学学报, 2005, 17(4): 723-728.

He Y J. Geometric representation of graphics transformation[J]. Journal of Computer Aided Design & Computer Graphics, 2005, 17(4): 723-728.

[16] 李卫国, 高飞, 陈文玲. 基于QuickBird卫星遥感影像的几何纠正方法对比[J]. 合肥工业大学学报(自然科学版), 2012, 35(2): 238-241.

Li W G, Gao F, Chen W L. Comparison of geometric rectification methods based on QuickBird satellite remote sensing image[J]. Journal of Hefei University of Technology(Natural Science), 2012, 35(2): 238-241.

[17] Huang F R, Hu Z Y. A note on polynomials based image registration[J]. Acta Automatic Sinica, 2005, 31(2): 188-194.

[18] Yue H M, Zhao B Y, Wu Y X, et al. Flexible global calibration technique for an arbitrarily arranged fringe projection profilometry system[J]. Optical Engineering, 2016, 55(6): 064113.

[19] 吴泽鹏, 郭玲玲, 朱明超, 等. 结合图像信息熵和特征点的图像配准方法[J]. 红外与激光工程, 2013, 42(10): 2846-2852.

Wu Z P, Guo L L, Zhu M C, et al. Improved image registration using feature points combined with image entropy[J]. Infrared and Laser Engineering, 2013, 42(10): 2846-2852.

[20] Tang Z W, von Gioi R G, Monasse P, et al. A precision analysis of camera distortion models[J]. IEEE Transactions on Image Processing, 2017, 26(6): 2694-2704.

[21] 伏燕军, 杨坤涛, 邹文栋, 等. 基于Levenberg-Marquardt算法的图像拼接[J]. 激光杂志, 2007, 28(5): 46-48.

[22] 王涛, 孙长库, 石永强, 等. 基于辅助参考线的光栅投影轮廓测量系统及标定方法[J]. 光学学报, 2011, 31(1): 0115002.

[23] Chen L C, Liao C C. Calibration of 3D surface profilometry using digital fringe projection[J]. Measurement Science and Technology, 2005, 16(8): 1554-1566.

王鹏, 张颖杰, 孙长库, 周舵. 基于柔性靶标定位实现图像拼接的多相机三维测量系统[J]. 光学学报, 2020, 40(4): 0412003. Peng Wang, Yingjie Zhang, Changku Sun, Duo Zhou. Multi-Camera Three-Dimensional Measurement System Using an Image Stitching Method Based on Flexible Calibration Target Positioning[J]. Acta Optica Sinica, 2020, 40(4): 0412003.