基于子空间与纹理特征融合的掌纹识别  下载: 1065次

下载: 1065次

ing at the problem of low recognition rate because the single descriptor cannot accurately obtain the effective palmprint features, a palmprint recognition method is proposed based on subspace and texture feature fusion. The subspace feature and texture feature of a palmprint image are obtained by robust linear discriminant analysis and local direction binary pattern, respectively. The weighted concatenation method is used for the subspace and texture feature fusion. The chi-square distance among the fused feature vectors is used for identification matching. The experimental results on the PolyU and the self-built non-contact databases show that the recognition time is 0.3069 s and 0.3127 s, respectively, and the lowest equal error rate is only 0.3440% and 1.4922%, respectively. Compared with other methods, the proposed method can accurately obtain the effective feature information of a palmprint image and improve the system recognition performance under the premise that the real-time performance is ensured.

1 引言

作为新兴的生物特征之一,掌纹不仅包含基于线的特征,还包含脊和细节点[1],这些特征被认为是不可变的且个体独有的。与其他的生物特征相比,掌纹含有稳定、丰富、易获取的身份鉴别特征[2]。自Zhang等[3]提出掌纹识别技术以来,经过多年发展,该技术现已成为模式识别领域的研究热点。

特征选择和提取在模式识别中起着重要作用,近年来备受关注[4]。特别是对于生物特征识别,原始数据通常包含大量的冗余信息和噪声。在这种情况下,如何为不同的分类任务选择和提取最具辨别力的特征是一项具有挑战性的工作[5]。在模式识别和机器学习领域,特征选择和提取已被证明是降低复杂性、提高效率和识别性能的有效工具[6]。尽管传统方法在应用中具有明显的优越性,但它们只能提取单一特征,存在一定的局限性。因此,识别精度高以及防伪性、稳健性较好的特征融合成为生物特征识别领域的发展方向。掌纹识别技术中主要包含两种特征融合:1)掌纹与掌脉等其他生物模态的特征融合[7-8];2)采用不同方法提取掌纹的不同特征进行融合[9]。

近年来,许多掌纹识别方法相继出现,如文献[ 9]提出了局部二值模式(LBP)与二维局部保持投影(2DLPP)融合的掌纹识别(LBP+2DLPP)方法,该方法分别提取掌纹图像的LBP和2DLPP特征,通过串联方式融合提取的特征向量,提高了系统的识别率。文献[ 10]提出的广义Gabor滤波器的掌纹识别(GGF)方法将两个不同的GGF子库用于特征提取,GGF在捕获方向特征、识别精度和效率方面具有优势。文献[ 11]提出了结合加权自适应中心对称局部二值模式(WACS-LBP)和基于加权稀疏表示的分类算法(WSRC)的掌纹识别(WACS-LBP+WSRC)方法,该方法使分类问题变得简单,类别更少,具有良好的识别性能。这些方法虽然具有一定的优势,但是在识别率方面有待提高。

本文针对单一的特征描述符在掌纹识别系统中无法准确获取有效特征,导致识别性能差的问题,提出一种基于子空间与纹理特征融合的掌纹识别方法。子空间特征提取方法利用空间投影变换对原始掌纹图像降维,从而获得较高的运算效率;纹理分析方法具有较强的描述能力,在掌纹识别领域的通用性较强,直观上比较符合掌纹图像自身特点。所提方法分别利用稳健线性判别分析(RLDA)算法和局部方向二进制模式(LOBP)算法提取掌纹的子空间特征和纹理特征,将获得的特征向量加权串联得到融合特征向量,实现子空间与纹理特征融合的掌纹识别。与最新的LBP+2DLPP、GGF以及WACS-LBP+WSRC方法相比,所提方法具有较高的识别准确性,实用性更好。

2 基本原理

2.1 LDA算法

假设存在

式中:

式中:

求解(4)式,可以得到最优投影向量

2.2 LOBP算法

LOBP算法[13]的基本原理是利用一组具有不同方向的线检测器检测掌纹的主要方向。通常,Gabor滤波器是掌纹方向检测最强大的工具之一,其一般形式为

式中:

式中:

主方向上的卷积结果反映了方向的重要性和稳定性。因此,将最大卷积结果,即

式中:

式中:

主方向上的最大卷积结果

式中

由于

3 基于子空间与纹理特征融合的掌纹识别方法

3.1 RLDA算法

针对LDA的分类准确性易受掌纹图像尺寸大小和噪声的影响,导致系统稳健性下降的问题,提出一种稀疏判别特征提取算法,即稳健线性判别分析算法(RLDA)。为了将原始数据的主要信息保留在判别子空间中,引入正交矩阵连接原始数据和变换数据,使变换后的数据可以保留主要判别信息。为了提高稳健性,引入稀疏误差项消除特征提取过程中的噪声,从而保证该算法具有更好的性能。

判别子空间的表达式为

式中:

传统的LDA对维度

式中:

针对掌纹识别系统易受外界噪声的影响导致识别率低的问题,利用稀疏项补偿噪声,从而可以减少噪声的干扰。因此,RLDA的目标函数为

式中:

使用乘法器的交替方向法(ADMM)[16]解决RLDA的优化问题。将(13)式转换为拉格朗日函数

式中:

1) 求解

令

解得

2) 求解

令

(19)式可以利用正交普鲁克分析进行求解,设SVD(

3) 求解

令

式中shrink表示收缩操作符。

4) 求解

式中

表 1. RLDA算法总结

Table 1. Summary of RLDA algorithm

|

3.2 特征提取

1) RLDA算法提取掌纹的子空间特征:提取子空间特征的目标就是找出一组对分类最有效的特征,而掌纹图像是一个高维空间的数据。因此,RLDA算法把原始的掌纹图像投影到低维的子空间上,得到掌纹的子空间特征。给定掌纹的感兴趣区域(ROI)图像,将其灰度值矩阵转换为低维向量并存入数组

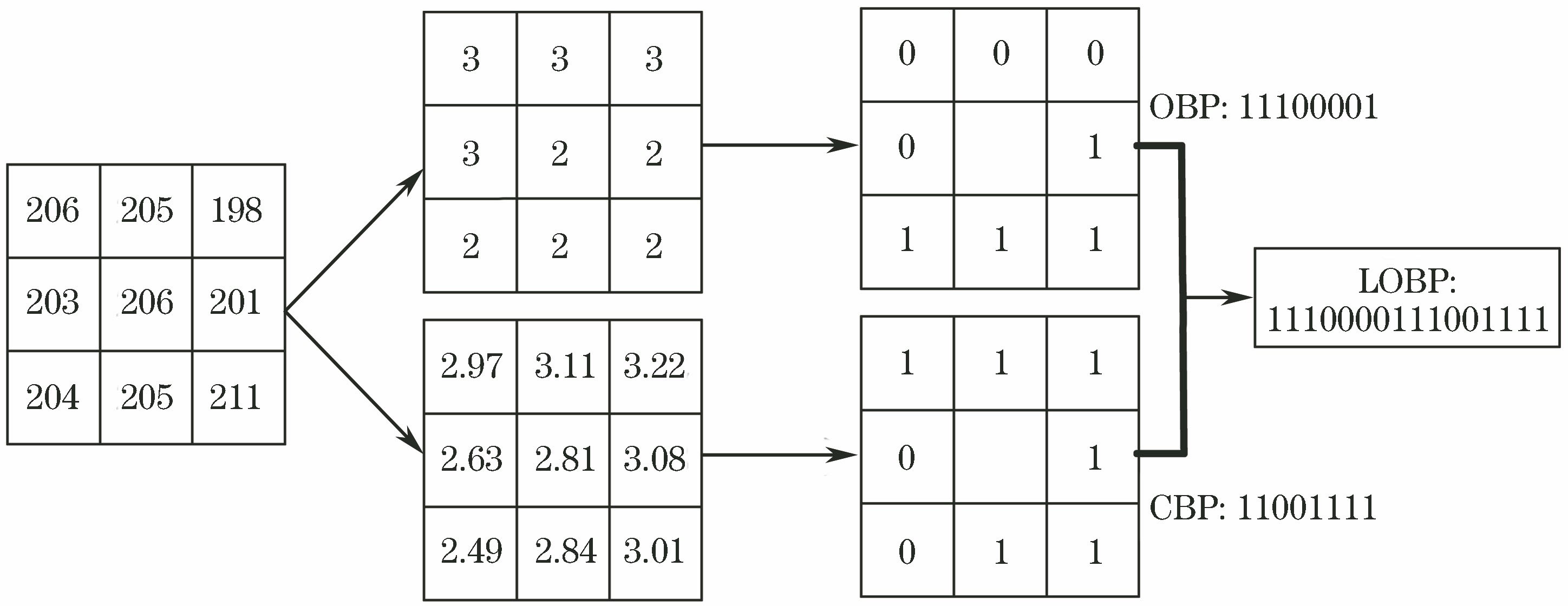

2) LOBP算法提取掌纹的纹理特征:给定掌纹的ROI图像,将其均匀地划分为一组非重叠子块,大小设置为8×8。纹理特征提取过程如

图 2. LOBP提取掌纹纹理特征的流程图

Fig. 2. Flow chart for extracting palmprint texture features by LOBP

对于每个子块,分别提取主方向和相应的方向置信度特征以获得OBP和CBP编码值,进而得到OBP直方图和CBP直方图。最后串联基于子块的OBP直方图和CBP直方图,获得掌纹ROI图像的LOBP直方图特征。

3.3 特征融合

首先,采用RLDA算法提取掌纹ROI图像的子空间特征,有效降低了特征的维数,本文将子空间特征向量标记为

式中:

基于子空间与纹理特征融合的掌纹识别(RLDA+LOBP)方法的流程如

3.4 特征匹配

匹配是指利用一定的匹配算法得到特征间的相似度,为了测试本文方法的识别性能,将卡方距离进行统计判别。利用测试掌纹图像的融合特征向量与其他候选掌纹图像的融合特征向量进行比较,两个向量

式中:

则认为是同一个人的掌纹图像,从而被接受,否则被拒绝。

4 实验与分析

实验环境为Windows 7系统,Matlab2015a软件,处理器为AMD A6-5350M APU with Radeon(tm) HD Graphics,主频2.90 GHz,内存(RAM)2.00 GB。

4.1 实验图库

1) 香港理工大学的超光谱接触式图库(PolyU图库):目前生物特征识别中广泛采用的手部公开标准测试集。该图库采用接触式采集设备在室内环境下进行掌纹图像采集。选择PolyU图库中的100人,每人的5张掌纹图像作为实验图库,ROI图像的大小为128 pixel×128 pixel。

2) 自建非接触图库:实验采用自建非接触图库区别于接触式标准图库。非接触式采集具有友好性和安全性的优势。利用定焦CCD工业摄像头在室内环境下采集手掌自然张开图像,背景为单一的黑色背景,光源为白色LED,采集100人,每人的5张掌纹图像作为实验图库,ROI图像的大小为128 pixel×128 pixel。

图 4. 图库示例。(a) PolyU图库;(b)自建非接触图库

Fig. 4. Examples of databases. (a) PolyU database; (b) self-built non-contact database

4.2 评价指标

根据类内类间匹配算法评估本文方法的性能,其中类内匹配是指对同一人的不同掌纹进行匹配,类间匹配是指对不同人的掌纹进行匹配[19]。类内匹配的实验次数为(100×5×4)÷2=1000,类间匹配的实验次数为(100×5×99×5)÷2=123750,总匹配次数为1000+123750=124750。

通过计算类内类间卡方距离,绘出匹配分布曲线,根据类内距离曲线和类间距离曲线的交点,设点阈值

1) 错误接受率(FAR),即识别系统把假冒者的特征误认为是合法者的特征,接受假冒者,表达式为

2) 错误拒绝率(FRR),即识别系统把合法者的特征误认为是假冒者的特征,拒绝合法者,表达式为

3) 等误率(EER),即ROC曲线上横轴FAR和纵轴FRR的等值点,EER越小说明掌纹识别系统的识别性能越好。

4.3 实验结果及分析

为了验证融合特征在掌纹识别系统中的优势,在PolyU图库和自建非接触图库上将RLDA提取的子空间特征、LOBP提取的纹理特征和RLDA+LOBP得到的融合特征进行对比实验,每种特征对应的最低EER如

表 2. 单一特征与融合特征识别的EER

Table 2. EER for single feature and fusion feature recognitions%

|

分析

为了验证所提方法的实时性和识别准确性,在PolyU图库和自建非接触图库上比较所提方法与传统的PCA、2DGabor、文献[

9]的LBP+2DLPP方法、文献[

10]的GGF方法和文献[

11]的WACS-LBP+WSRC方法的EER和识别时间,结果如

图 5. PolyU图库上的实验结果。(a)匹配结果;(b) ROC

Fig. 5. Experimental results on PolyU database. (a) Matching results; (b) ROC

图 6. 自建非接触图库上的实验结果。(a)匹配结果;(b) ROC

Fig. 6. Experimental results on self-built non-contact database. (a) Matching results; (b) ROC

表 3. 所提方法与其他方法的EER和识别时间比较

Table 3. Comparison of EER and recognition time between proposed and other methods

| |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

分析

在PolyU图库和自建非接触图库上将所提方法与最新的LBP+2DLPP、GGF以及WACS-LBP+WSRC方法的EER和识别率进行统计比较,EER的直观统计结果如

图 7. 所提方法与最新方法的EER比较

Fig. 7. Comparison of EER between proposed method and latest methods

图 8. 所提方法与最新方法的识别率比较

Fig. 8. Comparison of recognition rate between proposed method and latest methods

分析

5 结论

针对掌纹识别技术中单一的特征描述符无法准确获得有效特征导致识别率低的问题,提出了一种基于子空间与纹理特征融合的掌纹识别方法。该方法在特征提取阶段,利用所提RLDA算法提取掌纹图像的子空间特征,有效提高了识别系统的效率,同时采用最新的LOBP算法提取掌纹图像的纹理特征,获取了更全面的纹理特征信息。在特征融合阶段,将获得的纹理特征和子空间特征利用加权串联方法进行融合。在特征匹配阶段,利用卡方距离与阈值的关系确定两幅掌纹图像的相似程度,进而完成匹配。在相同条件下,与RLDA提取的子空间特征、LOBP提取的纹理特征相比,所提方法得到的融合特征在掌纹识别系统中更具有优势。与最新的LBP+2DLPP、GGF和WACS-LBP+WSRC方法的EER、识别时间以及识别率进行了比较,结果表明,所提方法在保证实时性的前提下,有效提高了系统的识别率,具有良好的应用前景。后续工作将进行算法优化,提高算法的运行速率,并融合手部的其他特征。

[2] 岳峰, 左旺孟, 张大鹏. 掌纹识别算法综述[J]. 自动化学报, 2010, 36(3): 353-365.

Yue F, Zuo W M, Zhang D P. Survey of palmprint recognition algorithms[J]. Acta Automatica Sinica, 2010, 36(3): 353-365.

[3] Zhang D, Kong W K, You J, et al. Online palmprint identification[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2003, 25(9): 1041-1050.

[7] 王浩, 康文雄, 陈晓鹏. 基于视频的掌纹掌脉联合识别系统[J]. 光学学报, 2018, 38(2): 0215004.

[8] 李新春, 张春华, 林森. 基于BSLDP和典型相关分析的掌纹掌脉融合识别[J]. 激光与光电子学进展, 2018, 55(5): 051012.

[9] Ali M M H, Yannawar P L, Gaikwad A T. Multi-algorithm of palmprint recognition system based on fusion of local binary pattern and two-dimensional locality preserving projection[J]. Procedia Computer Science, 2017, 115: 482-492.

[11] Zhang S W, Wang H X, Huang W Z, et al. Combining modified LBP and weighted SRC for palmprint recognition[J]. Signal, Image and Video Processing, 2018, 12(6): 1035-1042.

[13] Fei LK, XuY, Teng SH, et al.Local orientation binary pattern with use for palmprint recognition[M]. Cham: Springer International Publishing, 2017: 213- 220.

[15] Zou H, Hastie T, Tibshirani R. Sparse principal component analysis[J]. Journal of Computational and Graphical Statistics, 2006, 15(2): 265-286.

[17] Candès E J, Li X, Ma Y, et al. Robust principal component analysis?[J]. Journal of the ACM, 2011, 58(3): 1-37.

[19] 林森, 徐天扬, 王颖. 基于Gabor小波和NBP算法的手掌静脉识别[J]. 激光与光电子学进展, 2017, 54(5): 051002.

Article Outline

李新春, 马红艳, 林森. 基于子空间与纹理特征融合的掌纹识别[J]. 激光与光电子学进展, 2019, 56(7): 071007. Xinchun Li, Hongyan Ma, Sen Lin. Palmprint Recognition Based on Subspace and Texture Feature Fusion[J]. Laser & Optoelectronics Progress, 2019, 56(7): 071007.