基于跨尺度融合的卷积神经网络小目标检测  下载: 724次

下载: 724次

1 引言

传统目标检测分为区域选择(滑窗)、特征提取(如尺度不变特征变换SIFT、方向梯度直方图HOG)和分类器分类(如支持向量机SVM、Adaboost)三部分。基于滑动窗口的区域选择策略没有针对性,时间复杂度高,窗口冗余,而手工设计的特征对于多样化的目标鲁棒性较差。随着深度学习的不断成熟和发展,其在目标检测上的精度和可靠性已经远优于传统检测技术,成为计算机视觉领域的研究热点。检测的最终目的是从图像中识别目标并提取出目标的空间位置信息[1],已在行人分析、智能机器人导航[2]、辅助自动驾驶等领域[3]得到了广泛应用。目前主流的目标检测方法有one-stage和two-stage两种[4],two-stage是候选窗加深度学习分类检测方法,如区域卷积神经网络(RCNN)[5-7]用生成的候选锚框提取特征信息,该网络检测速度较慢。one-stage是端到端的回归目标检测网络,如SSD(Single shot MultiBox detector)[8]、YOLO(You only look once)网络[9-12]。用one-stage替代two-stage的特征提取过程,可避免候选锚框的生成计算,从而提高检测速度,但检测精度较低。

近年来目标检测进入一个快速发展的阶段,随着检测条件的变化,图像视场中会出现小尺度目标,给检测算法的精确性、可靠性带来了挑战。Bell等[13]提出将小目标定义为COCO数据库中尺寸小于等于32 pixel×32 pixel的目标;Mäenpää等[14]针对像素尺寸小、分辨率低的小目标,通过分析局部二值模式(LBP)算子并结合其他纹理分析方法,发布了一个小目标检测专用数据库,并将尺寸为512 pixel×512 pixel的图像中尺寸约为20 pixel×20 pixel的目标定义为小目标。小目标检测的核心难点是分辨率低、细节特征少,进行图像特征语义信息提取的过程中目标特征细节容易丢失,导致检测识别率不高或误警率高。

为了提高小目标的检测精度,He等[15]提出了用于视觉识别的空间金字塔池,采用多尺度pooling窗口,进一步强调了卷积神经网络(CNN)特征计算前移、区域处理后移的思想,完成单次特征图的计算后,再进行区域窗口信息的结合,在每个特征层进行预测,并利用多尺度特征信息,提高了多尺度目标的检测精度,但检测速度较慢。王海涛等[16]提出了基于两级上下文卷积网络宽视场图像的小目标检测方法,采用两个Faster-RCNN分别学习和建模小目标及其上下文背景特征,提高了小目标特征图的分辨率。周苏等[17]针对PVANet(Performance vs accuracy network)存在的小目标检测能力不足问题,将浅层7×7卷积核拆解成3层3×3卷积核,将深层3×3卷积核进一步非对称地分解成两个1×3和3×1卷积核,以增加浅层卷积滤波器的细粒度及小目标图像特征的提取能力和非线性表达能力,提升了网络对小目标的检测能力。Ju等[18]提出了一种基于交并比(IOU)的数学推导方法,针对YOLOv3网络各候选锚框的数量和纵横比尺寸进行了优化,同时将网络前6个卷积层转换为2个残差单元,以避免梯度衰落并增强特征的重用性,提升了网络检测小目标的能力。王俊强等[19]参考密集连接网络(DenseNet)设计特征提取网络,并用其替代原有的16层VGG-Net(Visual geometry group-network),通过引入特征金字塔网络(FPN)进行多尺度特征融合,实现了对小目标的检测。刘力荣等[20]采用Slim-Net实现了全景图像上小目标的检测,通过建立点云深度图像与全景图像的映射关系,进行小目标的地理定位和矢量提取,给出了城市小目标的精确三维空间地理定位,为小目标的检测定位提供了新思路。

针对目标像素数在图像总像素数中占比小于0.02的小目标检测识别任务,综合考虑了速度和准确率因素,本文提出了一种基于YOLOv3网络的跨尺度融合检测方法。减少了特征提取过程中小目标信息的丢失问题,并通过传递模块结合更多的细粒度信息和语义信息,提高了网络对小目标的检测能力。同时提出了结合深度和广度的残差块组传递结构,丰富了深层特征图的感受野,进一步提高了网络在高分辨率图像下的小目标识别效果。

2 YOLOv3网络的原理

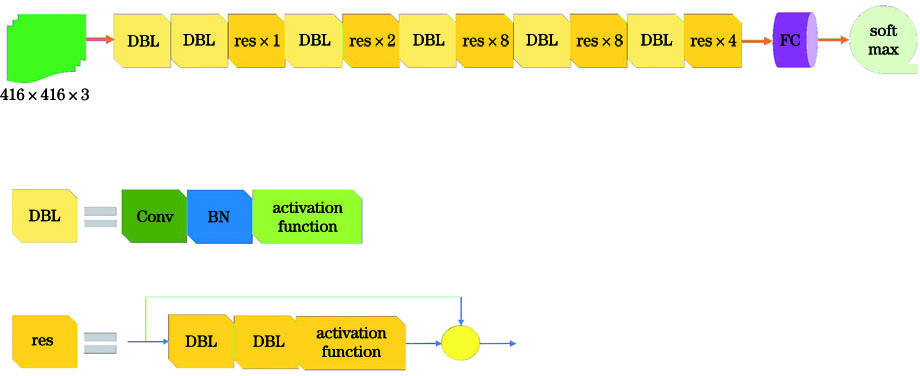

2.1 特征提取网络Darknet-53

Darknet-53将1个卷积层、1个正则化层和1个激活层封装成1个模块,在Darknet-19的基础上引入残差模块,进一步加深了网络结构,该结构共由53个卷积层组合而成,使用了一系列卷积核为3×3、1×1的卷积层。为了降低池化带来的梯度消失问题,直接摒弃了pooling操作,用步长为2的卷积核实现降采样。输入图像经过5次降采样后,用全连接层进行分类预测,其网络结构如

表 1. 不同骨干网络的性能

Table 1. Performance of different backbone networks

|

2.2 YOLOv3网络结构

YOLOv3网络使用Darknet-53的前52层,用单独的逻辑分类器取代了最后的全连接层,是一个全卷积网络。通过特征图的上采样和信息融合在三个尺度特征图上检测目标,用二元交叉熵损失计算类别预测损失,用误差平方和计算位置和尺寸损失,并在计算检测框损失时用系数增加小尺寸目标的学习效果,其中wi和hi分别为第i个真实框的宽和高。相比YOLOv2网络,YOLOv3网络提升了对小目标的检测性能。其损失函数可表示为

式中,lcoord和lnoobj为设定的有目标框与无目标框对损失函数的权重比例,输入图像经卷积网络后被分成K×K个网格,M为每个网格产生的候选框数,

3 数据预处理

3.1 数据来源与扩充

实验使用的训练集是从DOTA数据集提取的Plane、Small-vehicle和Large-vehicle三类。由于DOTA数据集的图像分辨率最大为12029 pixel×5014 pixel,直接将原始图像送入YOLO网络会损失过多的图像信息,训练效果不佳。因此,将DOTA数据集有检测目标的区域统一裁剪成尺寸为1000 pixel×1000 pixel后作为新的数据集,如

图 2. DOTA数据集。(a)原始图像;(b)裁剪后的图像

Fig. 2. DOTA data set. (a) Original image; (b) cropped image

针对数据集中小目标比例少,对小目标训练不足导致的检测效果差问题,对原数据集中的较小目标进行了复制扩充,以增加小目标样本在网络训练过程中对参数修正的影响,结果如

图 3. DOTA数据集的增强。(a)原始图像;(b)增强后的图像

Fig. 3. Enhancement of the DOTA data set. (a) Original image; (b) enhanced image

3.2 重新聚类anchor

不同数据集标注样本的尺度分布不同,实验以小目标为主,与生成YOLOv3网络中先验框的COCO数据集差别较大。因此,仅通过K-means聚类算法对处理后的数据重新进行聚类,得到检测层的先验框尺寸。为了丰富检测尺度,将聚类中心点由9个增至12个,每个检测层分配4个先验框,聚类后的先验框像素尺寸分别为9×11,22×12,13×22,24×18,18×24,25×25,18×46,51×22,39×36,30×56,51×51,86×81。

4 网络结构优化

4.1 网络检测尺度的优化

加深网络后,深层特征图拥有更高的语义特征,但随着降采样深度的增加,目标部分的纹理细节会出现丢失现象,不利于小尺寸目标的检测。而浅层特征图包含更多的细粒度信息,有利于小目标的定位识别。因此,用直通模块将浅层特征图与上采样后的深层特征图进行融合。YOLOv3网络在尺寸为13 pixel×13 pixel、26 pixel×26 pixel、52 pixel×52 pixel的特征图上进行目标预测,实验将输入图像的尺寸统一调整为576 pixel×576 pixel,在更浅层特征图(尺寸为36 pixel×36 pixel、72 pixel×72 pixel、144 pixel×144 pixel)上进行目标预测,改进后的预测结构1如

改进网络预测结构1通过上移检测层的特征图提高对小目标的检测效果,但幅射范围仍为连续的三级特征图。在此基础上,采用跨尺度预测层,在尺寸为18 pixel×18 pixel、72 pixel×72 pixel、144 pixel×144 pixel的特征图上进行了跨尺度目标预测,预测层特征图跨越的尺度更广,改进的预测结构2如

4.2 网络感受野的提高

YOLOv3网络对输入图像进行了5次降采样卷积,并在卷积操作后加入了五组残差块实现恒等映射,解决了网络深度加深导致的退化问题,改善了更深层网络的检测效果。但引入了大量的卷积层和shotcut层,导致网络的检测速度下降。杜泽星等[21]采用多分支不同大小的卷积核提高感受野。为了进一步提高检测层的感受野,避免进入网络前降采样过程中的精度损失,在改进结构2不增加参数量的基础上提出将深度残差块组传递改为结合深度和广度传递的网络结构,如

5 实验结果分析

5.1 评估指标

用精确率(Precision)和召回率(Recall)作为网络的评价指标,精确率为单类别的正确识别个数Ntrue与预测总数(包含正确识别为该类别数Ntrue和错误识别为该类别数Nfalse)的比值,可表示为

召回率表示单类别的正确识别个数Ntrue与实际该类别总数Nall的比值,可表示为

对于多类别数据集用平均精确率(mPre)和平均召回率(mRec)表征网络的性能水平,可表示为

式中,n为类别总数。

5.2 结果分析

将DOTA数据集中的Plane、Small-vehicle和Large-vehicle三类图像裁剪成尺寸为1000 pixel×1000 pixel的图像进行训练测试,Plane图像的目标像素占比为0.02,Large-vehicle图像的目标像素占比为0.002,Small-vehicle图像的目标像素占比为0.0007。用3.1节提出的网络进行训练测试,并与原始YOLOv3网络进行对比,结果如

表 2. 不同网络的召回率

Table 2. Recall rates of different networks unit: %

|

表 3. 不同网络的精确率

Table 3. Precision rates of different networks unit: %

|

图 7. 不同网络的检测效果。(a) YOLOv3;(b)结构1;(c)结构2

Fig. 7. Detection effect of different networks. (a) YOLOv3; (b) structure1; (c) structure2

在保证目标像素大小不变的情况下,基于尺寸大于2500 pixel×2500 pixel的高分辨率图像对结构2与3.2节中优化感受野后的结构进行对比。为了进一步验证优化网络的检测效果,在对比实验中加入了基于区域的全卷积网络(R-FCN)[22],R-FCN引入了位置敏感得分图,实现了更多参数与特征的信息共享,对小目标的检测效果更好。4种网络的召回率、精确率和基本参数如

表 4. 不同网络的多类别召回率

Table 4. Multi-category recall rates of different networks unit: %

|

表 5. 不同网络的多类别精确率

Table 5. Multi-class precision rates of different networks unit: %

|

表 6. 不同网络的基本参数

Table 6. Basic parameters of different networks

|

实验的训练过程基于2台GTX-1080处理器,网络训练过程每轮迭代抽取64张图像,再将batch分4次送入网络训练,权重衰减正则项为0.0005,初始学习率为0.01,随着训练进程逐渐衰减。采用multistep调整策略,设定调整学习率step的间隔为20000,30000,35000,40000,学习率调整比率为0.2。为了生成更多的训练样本,训练过程中将图像随机旋转角度±45°,尺度上训练设定图像在320~576 pixel之间随机调整,以丰富训练样本,训练时的损失曲线如

实验结果表明,进行高分辨率图像的目标检测时,优化感受野后的网络在精确率和耗时一致的情况下,平均召回率由69.3%提升到了80.9%。高分辨率图像的压缩导致Large-vehicle和Small-vehicle容易被混淆,在Large-vehicle上的精确率有所下降。相比R-FCN,优化感受野后的网络在精确率和召回率上均有提高,且速度更快。

结构2与优化感受野后的结构实际测试结果如

图 9. 不同网络的识别效果。(a)结构2;(b)优化感受野的网络

Fig. 9. Recognition effect of different networks. (a) Structure2; (b) optimize the network of the receptive field

为了进一步验证改进网络在其他类型图像中对小目标检测的有效性,将航拍数据集替换为COCO数据集后,对改进的网络和原始YOLOv3网络重新进行训练,并对检测结果进行对比分析,结果如

表 7. 不同网络在COCO数据集下的召回率

Table 7. Recall rates of different networks under the COCO data set unit: %

|

表 8. 不同网络在COCO数据集下的精确率

Table 8. Precision rates of different networks under the COCO data set unit: %

|

图 10. 不同网络在COCO数据集下的检测结果。(a)YOLOv3网络;(b)优化感受野后的网络

Fig. 10. Detection results of different networks under the COCO data set. (a) YOLOv3 network; (b) optimize the network of the receptive field

6 结论

针对小目标检测中的问题,基于YOLOv3网络提出了一种跨尺度融合检测方法,在经过处理的DOTA数据集上进行了训练和测试实验,并进一步在DOTA高分辨率图像和COCO数据集上进行了优化感受野后网络的测试实验。实验结果表明,扩大检测层的辐射范围并提升网络的实际感受野可以提高对视场中小目标的识别检测效果。但本方法在检测速度上并没有太多提升,因此在保证精度的前提下进一步提升检测速度,是下一步需要研究的重点。

[1] Zhao Z Q, Zheng P, Xu S T, et al. Object detection with deep learning: a review[J]. IEEE Transactions on Neural Networks and Learning Systems, 2019, 30(11): 3212-3232.

[2] Yue PY, XinJ, ZhaoH, et al.Experimental research on deep reinforcement learning in autonomous navigation of mobile robot[C] ∥2019 14th IEEE Conference on Industrial Electronics and Applications (ICIEA), June 19-21, 2019, Xi'an, China.New York: IEEE Press, 2019: 1612- 1616.

[3] 张达峰, 刘宇红, 张荣芬. 基于深度学习的智能辅助驾驶系统[J]. 电子科技, 2018, 31(10): 60-63.

[4] 段仲静, 李少波, 胡建军, 等. 深度学习目标检测方法及其主流框架综述[J]. 激光与光电子学进展, 2020, 57(12): 120005.

[5] GirshickR, DonahueJ, DarrellT, et al.Rich feature hierarchies for accurate object detection and semantic segmentation[C]∥2014 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2014, Columbus, OH, USA.New York: IEEE Press, 2014: 580- 587.

[6] He KM, GkioxariG, DollárP, et al.Mask R-CNN[C] ∥2017 IEEE International Conference on Computer Vision (ICCV), October 22-29, 2017, Venice, Italy.New York: IEEE Press, 2017: 2980- 2988.

[7] Ren S Q, He K M, Girshick R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149.

[8] LiuW, AnguelovD, ErhanD, et al. SSD: single shot MultiBox detector[EB/OL]. [2020-07-02].https:∥arxiv.org/abs/1512. 02325.

[9] RedmonJ, DivvalaS, GirshickR, et al.You only look once unified, real-time object detection[C] ∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA.New York: IEEE Press, 2016: 779- 788.

[10] RedmonJ, FarhadiA. YOLO9000:better, faster, stronger[C] ∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA.New York: IEEE Press, 2017: 6517- 6525.

[11] RedmonJ, FarhadiA. YOLOv3: an incremental improvement[EB/OL] [2020-07-04].https:∥arxiv.org/abs/1804.02767

[12] BochkovskiyA, Wang CY, Liao H YMark. YOLOv4: optimal speed and accuracy of object detection[EB/OL] [2020-07-02]. http:∥arxiv.org/abs/2004.10934.

[13] BellS, Zitnick CL, BalaK, et al.Inside-outside net: detecting objects in context with skip pooling and recurrent neural networks[C] ∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA.New York: IEEE Press, 2016: 2874- 2883.

[14] MäenpääT, PietikäinenM. Texture analysis with local binary patterns[M] ∥Kalviainen H, Parkkinen J, Kaarna A, et al. Image Analysis. SCIA 2005. Lecture Notes in Computer Science. Cham: Springer, 2005, 3540: 115- 118.

[16] 王海涛, 姜文东, 程远, 等. 两级上下文卷积网络宽视场图像小目标检测方法[J]. 计算机测量与控制, 2019, 27(6): 199-204.

Wang H T, Jiang W D, Cheng Y, et al. Two-stage context convolutional network for small target detection in wide-view-field images[J]. Computer Measurement & Control, 2019, 27(6): 199-204.

[17] 周苏, 支雪磊, 刘懂, 等. 基于卷积神经网络的小目标交通标志检测算法[J]. 同济大学学报(自然科学版), 2019, 47(11): 1626-1632.

[19] 王俊强, 李建胜, 周学文, 等. 改进的SSD算法及其对遥感影像小目标检测性能的分析[J]. 光学学报, 2019, 39(6): 0628005.

[20] 刘力荣, 唐新明, 赵文吉, 等. 基于影像与激光数据的小交标检测与地理定位[J]. 中国激光, 2020, 47(9): 0910002.

[21] 杜泽星, 殷进勇, 杨建. 基于密集连接网络的遥感图像检测方法[J]. 激光与光电子学进展, 2019, 56(22): 222803.

[22] Dai JF, LiY, He KM, et al. R-FCN: object detection via region-based fully convolutional networks[EB/OL] [2020-07-04].https: ∥arxiv.org/abs/1605.06409.

Article Outline

刘峰, 郭猛, 王向军. 基于跨尺度融合的卷积神经网络小目标检测[J]. 激光与光电子学进展, 2021, 58(6): 0610012. Liu Feng, Guo Meng, Wang Xiangjun. Small Target Detection Based on Cross-Scale Fusion Convolution Neural Network[J]. Laser & Optoelectronics Progress, 2021, 58(6): 0610012.