基于Jeffrey散度相似性度量的加权FCM聚类算法  下载: 828次

下载: 828次

1 引言

聚类是模式识别领域的一个重要的研究方向[1],它是基于某些预先固定的相同或不相同的度量来寻找有意义组的方法,在统计数据分析中被广泛应用[2]。聚类在有效的数据分析过程中起着关键作用,它从原始数据集提取必要信息和粒度信息(指信息单元的相对大小或粗糙程度)。与监督学习和判别分析不同,它不涉及标记数据或训练集。在数据挖掘、信息检索、机器学习和计算机视觉等领域,聚类分析是一项核心技术。已有大量研究基于不同的假设(如连通性、形心、分布、密度和子空间等)提出了多个聚类算法。由于不同的算法会获得不同的效果,因此很难在实践中确定使用哪种算法[3]。经典算法有K-means[4]、模糊C均值(FCM)[5]、DBSCAN[6]等。

然而,现如今的聚类算法基本上还存在一些问题:1)聚类结果可能是局部最优解,例如K-means聚类算法类似于爬山法,会在最近的最优点停止迭代,但是这个最优点不一定是全局的最优点;2)聚类过程中容易受到噪声和环境因素的影响等,因此聚类结果比较依赖于相似性度量。一般来说,在聚类算法中,欧氏相似性度量经常被用来最小化每个点到其最近中心的均方距离。欧氏距离不能总是找到更精确的聚类边界,本研究采用加权的FCM聚类方法作为衡量相似性度量方法的基础算法。近年来,研究者们利用非线性相似性度量代替传统的欧氏距离来确定更精确的聚类边界,相对较为熟悉的是三角不等式性质[7]。Banerjee等[8]在2005年使用广义Bregman散度作为一种相似性度量方法与K-means方法进行结合,改进了传统K-means方法的性能。

在目前的模糊聚类算法研究中,FCM聚类算法有较为完善的理论基础,同时FCM算法能计算样本对所有类的隶属度,提供了参考该样本结果可靠性的计算方式。但是FCM聚类算法仍然存在如下缺点: 1)FCM算法是一种有效的图像分割算法,但对噪声图像分割效果较差[9];2)加权指数b的选取;3)目标函数中相似性度量的定义等。因此不仅需要去探究与解决其聚类结果不稳定性及噪声敏感性,同时还需要提高算法的聚类精确性。

FCM在欧氏距离和外界因素的影响下,聚类结果将会出现偏差。对于聚类算法而言,度量方式的选择对最终的聚类效果起着至关重要的作用。特征加权是一种接近个体特征最优影响程度的技术。每个特征值的大小都衡量了该特征的重要程度,本文将此特征值称为特征权重,其值在区间[0,1]中。在相应的算法中通过一个学习机制来适应权重,用较小的权重值来表示噪声特征或低质量特征,因此对于差异性的计算贡献不大。如果权重值只有0或1(即完全消除不良特征),则特征加权就减少了特征选择的过程。特征选择可以显著减少学习机制中的计算复杂程度,同时可以尽可能避免重要信息的丢失。又由于Jeffrey 散度[10]具备较好的数值稳定性和对噪声的鲁棒性,从Jeffrey散度出发,本文提出相似性度量的概念,解释了基于Jeffrey散度的相似性度量的各种性质,提出基于Jeffrey散度的相似性度量的加权FCM聚类算法,改进后的加权FCM算法的聚类效果有更好的精确性和稳定性。

在模糊聚类中,每个聚类都被视为一个模糊集,所有的数据点都属于不同的模糊集,且有相应的隶属度。2004年,Wang等[11]使用了FCM的全局特征加权方案,为了对特征进行加权,采用了基于学习的方法和进化适应度函数,并且采用梯度下降算法寻找合适的权值。此外,该方法基于数据分布均匀的假设,而在大多数实际数据集中并非如此。2008年,Hung等[12]讨论了一种基于FCM的全局特征加权图像分割的算法,但是该算法计算的特征权重不适合某些极端情况,换言之,在一些数据集中,特征的权重不能恰当地表示特征的重要性[13]。2013年,Nazari等[14]提出自动加权和FCM集成的概念。2014年,Ferreira等[15]对局部和全局特征加权进行了普遍的研究,利用基本的FCM和核距离,讨论了一种利用自适应距离提高聚类质量的聚类方法。2016年,Saha等[16]设计了一种具有可分离几何距离的FCM算法,并证明了其对噪声特征扰动的鲁棒性。2018年,林甲祥等[17]针对传统 FCM 算法无法获得令人满意的聚类结果的问题,提出了基于样本与特征双加权的自适应 FCM 聚类算法。根据Zhou等[18]在2018的文章可知,对这种算法进行实验分析,发现大部分实验中局部自适应距离法优于全局自适应距离法,尽管这种方法可以产生比传统FCM更好的结果,但这类算法可能不适用于对大型数据集进行聚类。2020年,赵战民等[19]针对FCM算法对噪声敏感,且不能有效分割具有类大小不均衡特性的图像的问题, 提出对类大小不敏感的模糊C均值聚类图像分割算法。

2 相关工作

2.1 FCM聚类算法

1973年, Dunn[20]引入了FCM,随后Bezdek[21]在1981年扩展了FCM。FCM通过最小化价值函数Ef(D,K)找到群,即

式中:f为实数,代表模糊系数。此外,成员等级对指标的影响可以通过f来控制。假设增加f,划分就会变得更模糊。研究表明,FCM在1和∞之间对f的任何值都收敛。K为样本个数,K=

FCM算法采取模糊迭代优化的方法,用隶属度λxy和样本kx方程进行更新,即

继续更新,直到

FCM算法确定聚类中心vy和隶属度λxy的一般步骤如下。

1) 用值在

2) 用(5)式计算聚类中心vy,y=1,2,…,n;

3) 根据(1)式计算价值函数,如果它小于某个已知的阈值,或者它相对于上个价值函数值的改变量小于某一个阈值,那么算法停止;

4) 根据(4)式计算新的隶属矩阵U,返回步骤2。

2.2 加权的FCM算法

特征加权是在局部进行的,其方法是根据各个属性对于聚类的贡献程度不同,需要对各个属性赋予相应的权重,从而提高聚类质量。2007年,韦相等[23]对FCM算法进行特征加权,目的是减少迭代次数,提高速度,为了便于对权值进行编码,利用规格化方法进行归一化处理,即

式中:p为样本的维数;Nunitynum为遗传算法中每一代群体的个体数;wij为i行j列矩阵;w'ij为对矩阵进行加权;w'sum为对加权矩阵进行求和计算。

2.3 相似性度量方法及其性质

在聚类分析方法中,对于数据集中每个数据对象之间的关系的分析与判断,需要使用一个相似性度量方法进行测量,例如,欧氏距离、马氏距离、指数距离等经常被用到相似性度量方法中。而它们忽略了全局一致性的特征问题,因此在这一部分,给出所使用的相似性度量的定义及各种性质。

2.4 Jeffrey散度

在传统的相似性度量方法中聚类结果质量会受到加权FCM算法的影响,因此使用根据Kullback-Leibler散度改进之后的Jeffery散度来改进算法,这方种法具有数值稳定性和对噪声鲁棒性,对于方差的不稳定性的影响较小[24]。它的定义为

式中:m(x)为符合条件的概率密度函数,m(x)=

定义1 估计Jeffrey散度Jn,它是在一组n×n的正定矩阵上定义的,即

式中:C=

定义2 任何两个数据点c,d∈

式中:ψ(O)=diag(o1,o2,…,om),O=(o1,o2,…,om)∈

所提出的相似性度量包括如下一些属性。

命题1

式中:c和d为两个数据点,为Z(c,d)=∂

命题2

定理1 相似性度量不是Bregman散度。

定理2 Z(e。c,e。d)=eZ(c,d)表示e∈

定理3 相似性度量是f-散度。

3 算法改进

3.1 将Jeffery散度相似性度量与加权FCM相结合

使用Jeffery散度的相似性度量的加权FCM通过以下公式求解来实现分组。

式中:oy为隶属矩阵的元素到样本kx的映射,即

(12)式精确解不存在,文献[ 25]中存在着一种交替优化方法如下所示。

定理4 假设 τy=

式中的FCM准则可用定理5中的优化无约束FCM准则来表述。

定理5 简化FCM标准出现的公式与文献[ 25]相似,即

收敛加权FCM:假设f(γ1,γ2,…,γc)=

引理1 由(15)式定义,E'f的主项为

式中:导数取

定理6 (交替优化的最速下降法)如果用优化原理调整步长(17)式,则序列

推论1(优化加权FCM的全局收敛性)约化加权FCM算法在(12)式中说明它收敛到一个鞍点。

推论2(优化加权FCM的局部收敛性)如果K=(

推论3(优化加权FCM的收敛速度)FCM在非奇异局部极小值附近与正定Hessian矩阵线性重合。

3.2 改进算法步骤

基于Jeffrey散度相似性度量的加权FCM算法的步骤如下。

1)经过对数据集进行预处理获得聚类数目k,将聚类数目k用作起始聚类中心的代表点,经过初步划分后形成簇;

2)依据预处理获得的数据集,对样本进行初始划分,得到权重向量;

3)将权重向量引入FCM算法,由(6)式对FCM算法进行特征加权,初始化隶属度矩阵uij,设置迭代精度参数ε,迭代次数t=0,模糊加权指数m=2;

4)根据新的聚类中心代入Jeffrey散度相似性度量中计算新的距离,重新计算隶属度和聚类中心,进行迭代循环,当聚类中心的结果不再发生变化时,算法结束。

4 实验结果与分析

4.1 实验介绍

实验环境:Windows 7操作系统,CPU i5-2410M 2.30 GHz,内存为4 GB,编程环境为MALAB R2016b。为了对改进算法进行评估和分析,使用UCI数据集和人工数据集进行实验,实验数据集如

表 1. 实验数据集属性

Table 1. Experimental data set properties

|

4.2 评价指标

本文使用聚类准确率(ACC)[27]、调整兰德系数(ARI)[28]以及鲁棒性(Entropy)对改进算法的聚类效果进行比较与分析。

改进算法的准确率使用ACC来进行评价,即

式中:ci为所提改进算法的类标签;

调整ARI为

式中:a为归属于隶属矩阵U的同类且属于V的同类的数据的对数目;b为归属于U的同类但属于V的不同类的数据的对数目;c为归属于U的不同类而归属于V的同类的数据的对数目;d为归属于U的不同类且归属于V的不同类的数据的对数目。ARI越近似 1 说明聚类效果越好,越临近 0 说明聚类效果越差。

Entropy即熵值,在1854年由Clausius[29]提出,表示一个系统的内在混乱程度。Entropy的取值在[0,1]间,取值越小表示算法中的混乱程度越低,聚类效果越好。

4.3 实验与分析

在本节中进行了多组实验,并将本文所提基于Jeffery散度的相似性度量加权FCM聚类算法与相关算法(FCM、K-means和DPC算法)进行了对比与分析。所用到的数据集主要包括:D31、Isquare2、S1、Spiral 4个人工数据集以及Wine和Thyroid 2个UCI数据集。其中D31、Isquare2、S1、Spiral均为二维数据集,D31的数据样本数量较多,Wine和Thyroid均为多维数据集。

本组实验分别在D31、Isquare2、S1 、Spiral 4个人工数据集以及Wine和Thyroid 2个UCI数据集上进行,实验数据集属性如

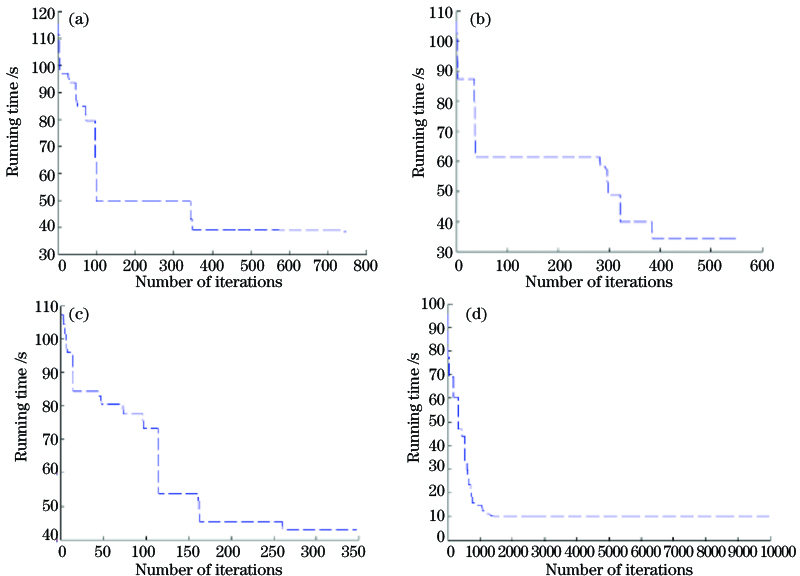

图 1. 四种聚类算法的收敛性分析。(a) FCM;(b) K-means;(c) DPC;(d) JW-FCM

Fig. 1. Convergence analysis of four clustering algorithms. (a) FCM; (b) K-means; (c) DPC; (d) JW-FCM

图 2. 四种聚类算法对数据集Spiral聚类结果。(a) FCM;(b) K-means;(c) DPC;(d) JW-FCM

Fig. 2. Clustering results of four clustering algorithms on Spiral data set. (a) FCM; (b) K-means; (c) DPC; (d) JW-FCM

图 3. 四种聚类算法对数据集S1聚类的结果。(a) FCM;(b) K-means;(c) DPC;(d) JW-FCM

Fig. 3. Clustering results of four clustering algorithms on S1 data set. (a) FCM; (b) K-means; (c) DPC; (d) JW-FCM

图 4. 四种聚类算法对数据集ISquare2聚类的结果。(a) FCM;(b) K-means;(c) DPC;(d) JW-FCM

Fig. 4. Clustering results of four clustering algorithms on ISquare2 data set. (a) FCM; (b) K-means; (c) DPC; (d) JW-FCM

通过对

表 2. 四种聚类算法在数据集上的性能对比

Table 2. Performance comparison of four clustering algorithms on data set

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

比较了收敛性、准确率、聚类效果之后,在实验中,将噪声数据按照0.1、0.2、0.3、0.4、0.5的比例加入6个数据集中分别聚类,实验结果如

5 结论

传统的FCM算法在使用欧氏距离相似性度量中,只考虑数据点之间的局部一致性问题,所以聚类效果差,对此本文将FCM算法进行特征加权,引入遗传算法加快算法的收敛速度,再结合Jeffrey散度对算法进行改进,在加权FCM算法中使用Jeffrey相似性度量代替了欧氏距离,所提JW-FCM算法保证了局部极小。通过将FCM、K-means、DPC算法和本文JW-FCM算法在UCI数据集及人工数据集中进行实验比较及分析,验证了改进算法具有较好的聚类效果,较原始算法有所提升,并且具备高效性、鲁棒性及准确性。但是该算法在处理大规模数据时,其时间复杂度相对较高,同时复杂性度量的研究也是算法下一步的主要研究目标。

[1] 张静, 付建鹏, 李新慧. 基于低秩正则化异构张量分解的子空间聚类算法[J]. 激光与光电子学进展, 2018, 55(7): 071003.

[3] 童绪军, 吴义春. 数据挖掘中一种改进的谱组合聚类算法[J]. 太赫兹科学与电子信息学报, 2020, 18(3): 497-503.

[4] 王千, 王成, 冯振元, 等. K-means聚类算法研究综述[J]. 电子设计工程, 2012, 20(7): 21-24.

[6] 周水庚, 周傲英, 曹晶. 基于数据分区的DBSCAN算法[J]. 计算机研究与发展, 2000, 37(10): 1153-1159.

[8] BanerjeeA, MeruguS, DhillonI, et al. Clustering with bregman divergences[C] //Proceedings of the 2004 SIAM International Conference on Data Mining, Philadelphia, PA: Society for Industrial and Applied Mathematics, 2004.

[9] 朱占龙, 王军芬. 基于自适应模糊C均值与后处理的图像分割算法[J]. 激光与光电子学进展, 2018, 55(1): 011004.

[10] PuzichaJ, HofmannT, Buhmann JM. Non-parametric similarity measures for unsupervised texture segmentation and image retrieval[C] //Proceedings of IEEE Computer Society Conference on Computer Vision and Pattern Recognition, June 17-19, 1997, San Juan, Puerto Rico, USA. New York: IEEE Press, 1997: 267- 272.

[13] Xing HJ, Wang XZ, Ha MH. A comparative experimental study of feature-weight learning approaches[C] //2011 IEEE International Conference on Systems, Man, and Cybernetics, October 9-12, 2011, Anchorage, AK, USA. New York: IEEE Press, 2011: 3500- 3505.

[14] NazariM, ShanbehzadehJ, SarrafzadehA. Fuzzy c-means based on automated variable feature weighting[C] //Proceedings of the International MultiConference of Engineers and Computer Scientists, IMECS 2013, March 13 - 15, 2013, Hong Kong.

[15] Ferreira M R P, de Carvalho F D A T. Kernel fuzzy c-means with automatic variable weighting[J]. Fuzzy Sets and Systems, 2014, 237: 1-46.

[17] 林甲祥, 吴丽萍, 巫建伟, 等. 基于样本与特征双加权的自适应FCM聚类算法[J]. 黑龙江大学自然科学学报, 2018, 35(2): 244-252.

[19] 赵战民, 朱占龙, 刘永军, 等. 对类大小不敏感的图像分割模糊C均值聚类方法[J]. 激光与光电子学进展, 2020, 57(2): 021001.

[21] Bezdek JC. Pattern recognition with fuzzy objective function algorithms[M]. Boston: Springer, 1983, 442: 1- 13.

[23] 韦相, 汤兴华. 一种改进了的基于遗传算法的维特征加权改进FCM算法[J]. 红河学院学报, 2007, 5(2): 39-42.

[24] 郑瑾, 尤红建. 基于Radon变换和Jeffrey散度的SAR图像变化检测方法[J]. 雷达学报, 2012, 1(2): 182-189.

Zheng J, You H J. Change detection with SAR images based on radon transform and Jeffrey divergence[J]. Journal of Radars, 2012, 1(2): 182-189.

[26] 陈叶旺, 申莲莲, 钟才明, 等. 密度峰值聚类算法综述[J]. 计算机研究与发展, 2020, 57(2): 378-394.

Chen Y W, Shen L L, Zhong C M, et al. Survey on density peak clustering algorithm[J]. Journal of Computer Research and Development, 2020, 57(2): 378-394.

[27] Shang F H, Jiao L C, Shi J R, et al. Fast affinity propagation clustering: a multilevel approach[J]. Pattern Recognition, 2012, 45(1): 474-486.

[28] Vinh NX, EppsJ, BaileyJ. Bibliometrics: information theoretic measures for clusterings comparison[C] //The International Conference on Machine Learning, July 11-14, 2010, Qingdao, China. New York: ACM, 2010: 2837- 2854.

[29] Clausius R. Ueber eine veränderte Form des zweiten Hauptsatzes der mechanischen Wärmetheorie[J]. Annalen Der Physik Und Chemie, 1854, 169(12): 481-506.

Article Outline

吴辰文, 马宁, 蒋雨璠. 基于Jeffrey散度相似性度量的加权FCM聚类算法[J]. 激光与光电子学进展, 2021, 58(8): 0810006. Chenwen Wu, Ning Ma, Yufan Jiang. Weighted FCM Clustering Algorithm Based on Jeffrey Divergence Similarity Measure[J]. Laser & Optoelectronics Progress, 2021, 58(8): 0810006.