1 引言 由于光学系统景深的限制,很难将处于不同景深的目标都清晰地显示在所拍摄的图像上。多聚焦图像融合是解决这一问题的有效途径。多聚焦图像融合将来自同一场景不同聚焦区域的两幅或多幅图像进行融合,从而产生一幅全清晰的图像,融合后的图像与任何一幅输入图像相比都具有更大的信息量。多聚焦图像融合多应用于图像处理、视觉感知和计算机视觉等领域[1 ] 。

多聚焦图像融合算法可以大致分为基于空间域的算法以及基于变换域的算法。其中,基于变换域的方法包括3个阶段:图像变换、系数融合以及逆变换[2 ] 。在此类算法中,常用的有基于多尺度分解下的融合方法例如金字塔变换[3 ] 、小波变换[4 ] 、非下采样Shearlet变换[5 ] 等,以及不同于传统变换域方法的基于稀疏表示(SR)[6 ] 和基于梯度域(GD)[7 ] 的方法。基于变换域的方法需要进行融合图像逆变换,计算复杂度高,而基于空间域的方法直接对源图像进行融合,易于实现图像融合的实时性。这类方法可以大致分为3种:基于块的方法、基于区域的方法以及基于像素的方法[8 ] 。在基于块的方法中,首先将源图像划分成大小相等的块,然后对每一块进行聚焦度量。然而块的大小的划分影响融合结果,容易产生块效应。在基于区域的算法中,利用分割技术对源图像进行区域划分,再计算每一个区域的清晰度。但这一类算法的性能受到分割技术的限制,融合图像易产生伪影。为此,Zhang等人[9 ] 提出了一种基于边界的多聚焦图像融合算法,将聚焦区域的检测任务视为从源图像中找到聚焦区域和散焦区域之间的边界,根据找到的边界,生成具有良好视觉效果的融合图像,但其中的分水岭算法对于尖锐的梯度敏感限制了该算法的性能。Li等人[10 ] 提出一种基于引导滤波的多聚焦图像融合算法,能够保存多个输入图像的原始信息和互补信息,但由于不能够正确识别出图像的聚焦区域,造成融合图像边缘模糊。

针对上述算法出现的问题,本文提出一种结合改进拉普拉斯能量和(SML)和差分图像的多聚焦图像融合算法。SML在处理图像边缘和纹理细节上有较大的优势,但不能充分利用图像的局部信息。针对这个不足,本文在进行SML聚焦检测后再利用引导滤波,得到更精确的聚焦度量结果。由于单一的SML聚焦检测并不能够识别图像的全部显著特征,因此结合差分图像算法对源图像进行聚焦度量。通过两种方法结合能够提取更多的图像特征,并通过对融合决策图进行不一致性处理,能够较好地区分图像边界周围的细节信息。实验证明,该算法能够保留图像的边缘、纹理等显著特征,并在边界融合上具有更好的视觉效果,融合时间较短,保证了算法的实时性。

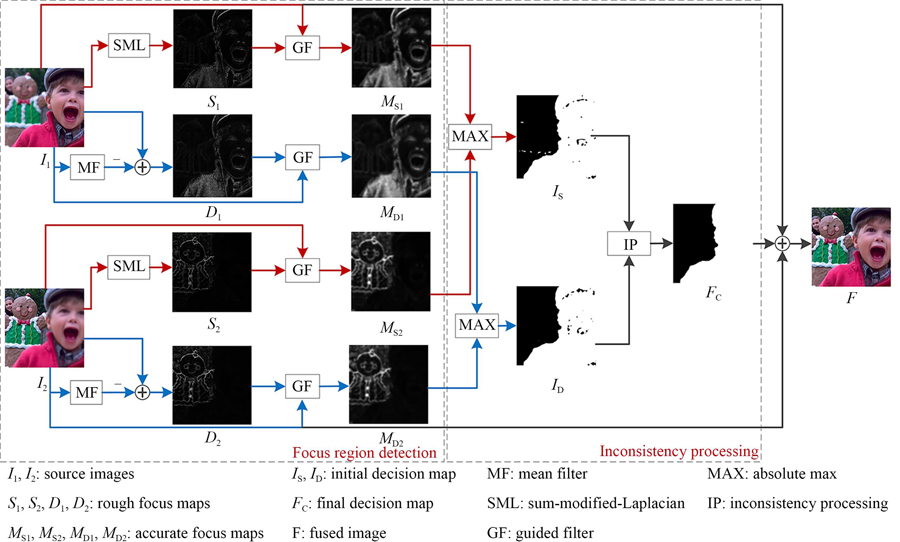

2 所提出方法 本文算法流程如图1 所示,融合过程主要分为3个步骤。首先,利用SML和滤波差分对源图像分别进行聚焦区域检测,得到聚焦特征图像;接着,对聚焦特征图像取绝对值最大得到初始融合决策图,通过小区域去除策略消除噪点,并对聚焦区域进行不一致处理,得到最终融合决策图;最后,根据决策图对源图像逐像素加权平均,得到融合图像。

图 1. 融合算法框架Fig. 1. Framework of image fusion algorithm

2.1 聚焦区域检测 聚焦度量用于评估局部像素锐度。对于一幅多聚焦图像,聚焦区域比散焦区域更尖锐,聚焦度量的最大值意味着产生最佳的聚焦图像,因此,在多聚焦融合领域,源图像的聚焦区域必须产生最大的聚焦度量值,散焦区域必须产生最小的聚焦度量值[11 ] 。在这种情况下,正确检测源图像的聚焦区域非常重要。本节提出的聚焦区域检测主要包括SML聚焦度量和差分图像两部分。

2.1.1 SML聚焦度量 在空间域中常用的聚焦度量方法有方差(Variance)、空间频率(Spatial frequency,SF)、梯度能量和(Energy of gradient,EOG)、改进的拉普拉斯能量和(SML)、双边梯度强度法(Tenengrad)等[12 ] 。文献[13 ]对不同聚焦度量方法区分清晰图像块和模糊图像块的能力进行评估,实验结果表明,SML能够代替SF作为图像清晰度的测量,并且相比于其他方法提供了一种更好的相邻像素的显著相关性。故本研究最终选择SML用来实现对源图像的聚焦度量,其定义如下:

M L x , y = 2 I x , y - I x - s t e p , y - I x + s t e p , y + 2 I x , y - I x , y - s t e p - I x , y + s t e p (1) 式(1) 中:M L I x , y s t e p s t e p s t e p = 1

S M L x , y = ∑ p = - P P ∑ q = - Q Q M L x + p , y + q (2) 其中:S M L x , y ( 2 P + 1 ) × ( 2 Q + 1 )

首先利用式(3) 和式(4) 对源图像I 1 图2 (a1)虚线左侧为散焦区域,右侧为聚焦区域)和I 2 图2 (a2))进行聚焦度量,得到聚焦图S 1 S 2 图2 (b)所示。

S 1 x , y = S M L I 1 x , y (3) S 2 x , y = S M L I 2 x , y (4) 图 2. SML聚焦检测结果图。(a)源图像;(b)SML聚焦图;(c)引导滤波优化结果。Fig. 2. Results of SML.(a)Source images;(b)Focus maps of SML;(c)Refined maps of SML by guided filter.

为了解决SML不能充分利用图像局部信息的问题,采用复杂低并且具有局部特征保持特性的引导滤波器。当引导图像和输入图像不同时,高频信息在引导图像中直接输出,使得输入图像拥有引导图像的部分特征[14 ] 。

He等人[15 ] 提出了具有保边平滑特性的引导滤波器,其关键在于构造引导图像I Q 式(5) 所示:

Q i = a k I i + b k , ∀ i ∈ ω k (5) 其中:i k ω k k r a k b k ω k P Q P Q E a k b k

E a k , b k = ∑ i ∈ ω k a k I i + b k - P i 2 + ε a k 2 (6) 式中:ε > 0 a k

使用引导滤波后得到的聚焦图像为M S 1 M S 2 图2 (c)所示,该过程如式(7) 和式(8) 所示:

M S 1 x , y = G r , ε I 1 x , y , S 1 x , y , r , ε (7) M S 2 x , y = G r , ε I 2 x , y , S 2 x , y , r , ε (8) 其中:G r , ε ε r = 5 , ε = 0.3

2.1.2 差分图像 在多聚焦图像中,聚焦区域比散焦区域包含更多的显著特征信息,单纯利用SML聚焦度量无法有效识别图像的显著特征,所融合生成的图像质量不佳,因此在利用SML进行聚焦检测的同时,本文结合滤波差分[16 ] 对源图像进行聚焦检测。

首先利用均值滤波对源图像I 1 I 2 式(9) 和式(10) 所示:

A 1 x , y = I 1 x , y * f m (9) A 2 x , y = I 2 x , y * f m (10) 其中:f m *

再将滤波后的图像A 1 A 2 x , y D 1 D 2 图3 (b)所示,该过程如式(11) 和式(12) 所示:

图 3. 差分图像聚焦检测结果图。(a)源图像;(b)差分图像;(c)引导滤波优化结果。Fig. 3. Results of difference image.(a)Source images;(b)Difference images;(c)Refined maps of difference image by guided filter.

D 1 x , y = I 1 x , y - A 1 x , y (11) D 2 x , y = I 2 x , y - A 2 x , y (12) 引导滤波通过计算引导图像的内容进行滤波输出,能够较好地保持边缘、纹理等图片信息[15 ] 。因此,在滤波差分的基础上,本文采用引导滤波得到聚焦图像M D 1 M D 2 图3 (c)所示,获得了更多的高频信息。该过程如式(13) 和式(14) 所示:

M D 1 x , y = G r , ε I 1 x , y , D 1 x , y , r , ε (13) M D 2 x , y = G r , ε I 2 x , y , D 2 x , y , r , ε (14) 其中:G r , ε D 1 D 2

2.2 融合决策图生成

2.2.1 初始融合决策图生成 通过上述聚焦区域检测,分别计算得到源图像I 1 I 2 M S 1 M S 2 M D 1 M D 2 式(15) 和式(16) 生成初始决策图I S I D 图4 (a)~(b)所示。

图 4. 初始决策图生成过程。(a)SML的初始决策图;(b)差分图像的初始决策图;(c)图4(a)经小区域去除后的结果;(d)图4(b)小区域去除后的结果。Fig. 4. Generation process of initial decision map.(a)Initial decision map of SML;(b)Initial decision map of difference image;(c)Result of Fig.4(a)with small region removal strategy;(d)Result of Fig.4(b)with small region removal strategy.

I S x , y = 1 , i f M S 1 x , y > M S 2 x , y 0 , o t h e r w i s e (15) I D x , y = 1 , i f M D 1 x , y > M D 2 x , y 0 , o t h e r w i s e (16) 初始决策图I S I D 图4 红色框内),使得黑色背景中包含白色像素,而在白色背景中也同样还有黑色像素,其原因在于,在没有高频信息的区域下聚焦和散焦的状态是相似的。因此,对初始决策图分别利用小区域去除策略来解决这些问题,其计算公式如式(17) 和式(18) 所示:

F S x , y = b w a r e a o p e n I S x , y , S A R E A (17) F D x , y = b w a r e a o p e n I D x , y , S A R E A (18) B w a r e a o p e n S A R E A S A R E A = R × H × W R H W R R =0.01。F S F D I S I D 图4 (c)~(d)所示。

2.2.2 决策图优化 基于空间域的多聚焦图像融合算法在边界处理上常出现块效应或边界模糊等问题,文献[17 ]在聚焦区域检测时将两种聚焦度量方法相结合得到粗略的聚焦图像,但不能很好地区分图像边界周围的细节信息,造成融合边缘模糊。因此本文借助文献[18 ]的方法在生成融合决策图后,再通过不一致处理对融合决策图进行校正,使得对边缘信息处理更为准确,能够更好地区分聚焦区域和散焦区域。

首先,对融合决策图F S F D 式(19) 所示:

F I x , y = 1 , i f F S x , y ≠ F D x , y 0 , o t h e r w i s e (19) 接着,对于所有满足F I ( x , y ) = 1 ( i , j ) R S R D 式(20) 所示:

F S i , j = 1 - F S i , j , i f s t d R S ≠ 0 F D i , j = 1 - F D i , j , o t h e r w i s e (20) 其中s t d

最后,得到最终决策图F C 图5 (a)所示,过程如式(21) 所示:

F C x , y = F S x , y = F D x , y (21) 图 5. 最终决策图生成和图像融合结果。(a)最终决策图;(b)融合图像。Fig. 5. Generation process of final decision map and result of image fusion.(a)Final decision map;(b)Fused image.

2.3 图像融合 基于最终决策图F C F 图5 (b)所示,其表达式为:

F x , y = F C x , y I 1 x , y + 1 - F C x , y I 2 x , y (22)

3 实验结果与分析

3.1 实验设置 为了评估所提出算法的性能,选取公共数据集中的30对多聚焦图像作为测试图像,如图6 所示,其中20对为彩色图像来自Lytro多聚焦数据集,其余10对为灰度图像,分别从主观视觉效果和客观定量评估对融合结果进行分析。实验计算机配置为:Intel(R)Core(TM)i7-5500U CPU,实验平台为Matlab2020a。将所提出算法与DSIFT[19 ] 、CNN[20 ] 、SIGPRO[21 ] 、FGF[22 ] 、CDL[23 ] 等目前具有代表性的5种方法进行了对比实验,对比方法中的参数设置均与各对应文献保持一致。

图 6. 实验中使用的数据集图像Fig. 6. Images of dataset used in experiment

3.2 聚焦度量评估 为了验证所提出的聚焦度量方法的有效性,选择7组经典且具有参考图像的多聚焦图像,将所提出的SML结合引导滤波的聚焦度量方法与EOG[24 ] 、Tenengrad[25 ] 、SF[26 ] 、Variance、SML[27 ] 等5种经典聚焦度量方法进行实验对比。利用融合图像与参考图像间的结构相似性(SSIM)值作为聚焦度量评估指标,衡量不同聚焦度量方法区分聚焦区域和散焦区域的能力。具体过程如下:

(1)计算多聚焦图像A 和B 的聚焦程度,分别用M A M B

(2)根据式(23) 得到源图像的决策图:

M x , y = 1 , i f M A x , y > M B x , y 0 , o t h e r w i s e (23) (3)根据决策图对源图像进行加权平均得到融合图像。

(4)计算融合图像与参考图像之间的SSIM值。

不同聚焦度量方法融合以图像“lab”为示例,结果如图7 所示。从图7 可以看出,所提出的方法得到的融合图像获得了较高的融合质量,能够较好地处理图像边缘信息,边缘轮廓也更加清晰。

图 7. 不同聚焦度量方法融合“lab”图像Fig. 7. Fusion results of“lab”image by different focus measures

表1 为不同聚焦度量方法下的SSIM值,其中最好的结果用粗体显示。由表1 可以看出,所提出的聚焦度量方法在7组图像对中均取得更优的结果,这进一步证明了所提出聚焦度量方法的有效性。

表 1. 不同聚焦度量方法下7组图像的SSIM值Table 1. SSIM values of 7 groups by different focus measuresEOG Tenengrad SF Variance SML Proposed book 0.971 3 0.989 9 0.971 1 0.977 5 0.984 9 0.996 2 Jug 0.955 6 0.978 8 0.955 5 0.982 1 0.945 0 0.988 0 rose 0.905 8 0.946 9 0.905 4 0.895 9 0.945 5 0.989 4 clock 0.957 0 0.977 8 0.957 2 0.965 1 0.969 5 0.982 0 disk 0.938 8 0.963 3 0.938 0.967 5 0.960 4 0.983 7 lab 0.970 0 0.982 1 0.970 0.989 4 0.978 7 0.993 5 pepsi 0.943 7 0.964 7 0.944 1 0.974 3 0.945 3 0.980 4

3.3 聚焦区域检测评估 将一组彩色图像和一组灰度图像作为测试图像,用以比较不同算法区分聚焦区域和散焦区域的性能,结果如图8 所示。由图8 可以看出,SIGPRO方法和CDL方法检测到的聚焦区域不够准确,将聚焦区域的高频信息错误识别成散焦区域内的像素;DSIFT方法受到背景区域梯度信息的影响,分割出的聚焦区域边缘处理比较粗糙;虽然CNN和FGF方法能够获得较好的融合结果,但融合边缘模糊。相较之下,所提出的方法通过结合两种不同聚焦度量算法对边缘信息处理更为准确,能够准确区分聚焦区域和散焦区域,融合边界轮廓更为清晰完整。

图 8. 不同聚焦检测方法所得到的融合结果和决策图Fig. 8. Fusion result and decision map of different methods

3.4 主观视觉评价 在多聚焦图像融合领域,良好的视觉效果意味着有效的融合。实验选取1对彩色多聚焦图像“Diver”和1对灰度图像“Book”作为示例进行视觉评估,实验结果分别如图9 、图10 所示。

图 9. “Diver”融合图像与残差图像Fig. 9. Fusion results and residual images for “Diver” image

图 10. “Book”融合图像与残差图像Fig. 10. Fusion results and residual images for “Book” image

图9 给出了不同融合方法下“Diver”彩色图像的融合结果。为了更直观地区分不同算法的融合性能,在融合结果下方列出了融合图像与左聚焦源图像进行差分得到的差值图像以及部分标记区域的放大图像。由图9 融合图像可以看出,CNN方法和FGF方法在潜水器上方有一块模糊区域,在镜框边缘、潜水器边缘存在不同程度的模糊,影响整体图像的融合效果;DSIFT方法在潜水器边缘融合效果不佳,在潜水器上方较源图像有轻微凹陷,整体看起来比较突兀;SIGPRO和CDL等方法的整体融合效果较好,但在图像边缘存在轻微模糊现象。此外,由图9 的差值图像以及部分标记区域的放大图像还可以看出,FGF、CDL等方法存在不同程度的信息残余(箭头指出),即源图像中散焦部分像素被转移到其融合图像中;DSIFT、CNN、SIGPRO、CDL以及本文提出的算法则没有产生信息残余。与其他方法相比,本文提出的方法融合效果较好,并未出现图像模糊、边缘伪影等问题,在图像背景部分和边界区域附近几乎没有信息残留,具有更良好的视觉效果。

不同融合方法在灰度图像“Book”的融合结果如图10 所示。为了更好地对比不同算法的融合性能,在融合结果下方列出了融合图像与左聚焦源图像进行差分得到的差值图像以及部分标记区域的放大图像。通过观察图10 的融合图像可知,SIGPRO、FGF、CDL等方法的融合图像在书页处因为没能够正确识别出清晰区域,导致在融合结果图中出现一小块模糊区域;DSIFT方法的融合图像没能很好地进行图像边缘配准,在图中大写字母O处出现边缘缺失,损失了部分边缘梯度信息;而CNN和本文提出的方法的整体融合效果较好。在图10 的差值图像以及部分标记区域的放大图像中,SIGPRO、FGF、CNN等方法在书页边缘存在错误检测像素,造成融合图像边缘模糊和不自然;DSIFT和本文提出的算法能够有效检测聚焦区域,在残差图像左侧像素值为0。这表明本文所提出的方法能够较好地保留源图像中的有用信息,融合边界更完整清晰,同时有效避免了伪影问题。

3.5 客观定量评价 为了更好地对融合图像进行全面评估,除了通过主观视觉评估之外,还采用客观评价指标对融合结果进行定量分析。不同的多聚焦图像融合算法在不同的评估指标上可能有很大的差异,为了减少单个指标的不完备性,使用多个指标来评估融合图像质量。本文选取7个常用的融合质量评估指标来广泛地评估其融合效果[28 ] ,将这7个指标分为4类,分别是基于信息论的Q N C I E Q M I Q F M I Q G Q M Q Y Q C B

表2 和表3 为不同融合算法在彩色数据集和灰度数据集上的客观性能。对于每种算法,分别取两个数据集上所有图像对的指标平均值,并将每个指标平均值中取得最优的算法进行字体加粗。

表 2. 不同方法下20组彩色图像的平均评价指标Table 2. Average evaluation metrics of 20 groups of color images under difference methodsQ N C I E Q M I Q F M I Q G Q M Q Y Q C B DSIFT

CNN

SIGPRO

FGF

CDL

Proposed

0.845 4

0.842 9

0.844 8

0.843 0

0.844 7

0.845 6

1.187 6

1.151 2

1.178 8

1.132 7

1.177 5

1.189 7

0.608 0

0.605 2

0.607 5

0.601 6

0.595 1

0.610 3

0.726 5

0.725 0

0.726 1

0.720 7

0.707 9

0.727 3

2.640 4

2.396 5

2.592 5

2.172 6

2.642 6

2.641 2

0.987 6

0.987 0

0.987 8

0.985 5

0.975 4

0.988 7

0.809 3

0.808 3

0.810 4

0.799 9

0.790 1

0.809 5

表 3. 不同方法下10组灰度图像的平均评价指标Table 3. Average evaluation metrics of 10 groups of gray images under difference methodsQ N C I E Q M I Q F M I Q G Q M Q Y Q C B DSIFT

CNN

SIGPRO

FGF

CDL

Proposed

0.848 3

0.847 1

0.848 1

0.846 0

0.848 0

0.849 0

1.251 3

1.231 0

1.244 5

1.211 2

1.247 7

1.260 1

0.656 3

0.660 5

0.657 5

0.659 4

0.647 4

0.665 1

0.719 8

0.723 5

0.719 7

0.722 5

0.710 1

0.725 9

2.524 7

2.428 4

2.515 6

2.302 2

2.541 5

2.539 4

0.972 1

0.981 8

0.979 5

0.980 5

0.962 5

0.980 4

0.797 3

0.801 9

0.795 0

0.797 6

0.774 8

0.798 0

从表2 和表3 可以看出,在彩色图像中,本文所提出方法的Q N C I E Q M I Q F M I Q G Q Y Q M Q C B Q N C I E Q M I Q F M I Q G Q M Q Y Q C B

实验结果表明,本文所提出方法在主观和客观评价获得了一致的结果,较好地保留了源图像的信息量,融合图像清晰程度较高,能够有效地提取边缘信息,总体取得了较好的融合效果。

3.6 时间成本 本节主要是计算出在灰度和彩色图像上不同算法的平均时间,比较不同融合算法在时间成本上的差异,具体数值如表4 所示,将运行时间最短的算法进行字体加粗。

表 4. 不同融合算法计算的平均时间Table 4. Average consuming time calculated by different algorithmsDSIFT CNN SIGPRO FGF CDL Proposed Color images 6.745 4 165.177 8 26.832 2 13.913 8 2.649 7 0.395 9 Grayscale images 11.911 1 163.302 8 10.212 5 4.553 0 2.293 5 0.462 1

从表4 可以看出,不同算法在彩色和灰度图像上耗时不同,本文所提出的方法与其他算法相比,不论是在彩色图像还是在灰度图像上,运行时间都是最短,并且运行时间小于0.5 s,能够保证算法的融合实时性。

4 结论 根据聚焦区域检测方法在多聚焦图像融合算法上的优势,提出了一种基于SML和差分图像的多聚焦图像算法。通过结合两种聚焦检测方法,能够更准确识别多聚焦图像的聚焦区域,生成高质量的融合图像。不同图像得到的仿真实验结果表明,所提出的方法在主观与客观评估指标都表现出较好的融合结果,互信息Q M I Q F M I Q G

廖丽娜, 李伟彤, 项颖. 结合SML与差分图像的多聚焦图像融合算法[J]. 液晶与显示, 2023, 38(4): 524. Li-na LIAO, Wei-tong LI, Ying XIANG. Multi-focus image fusion algorithm based on SML and difference image[J]. Chinese Journal of Liquid Crystals and Displays, 2023, 38(4): 524.