综合深度卷积神经网络的摆扫影像反演恢复算法  下载: 941次

下载: 941次

1 引言

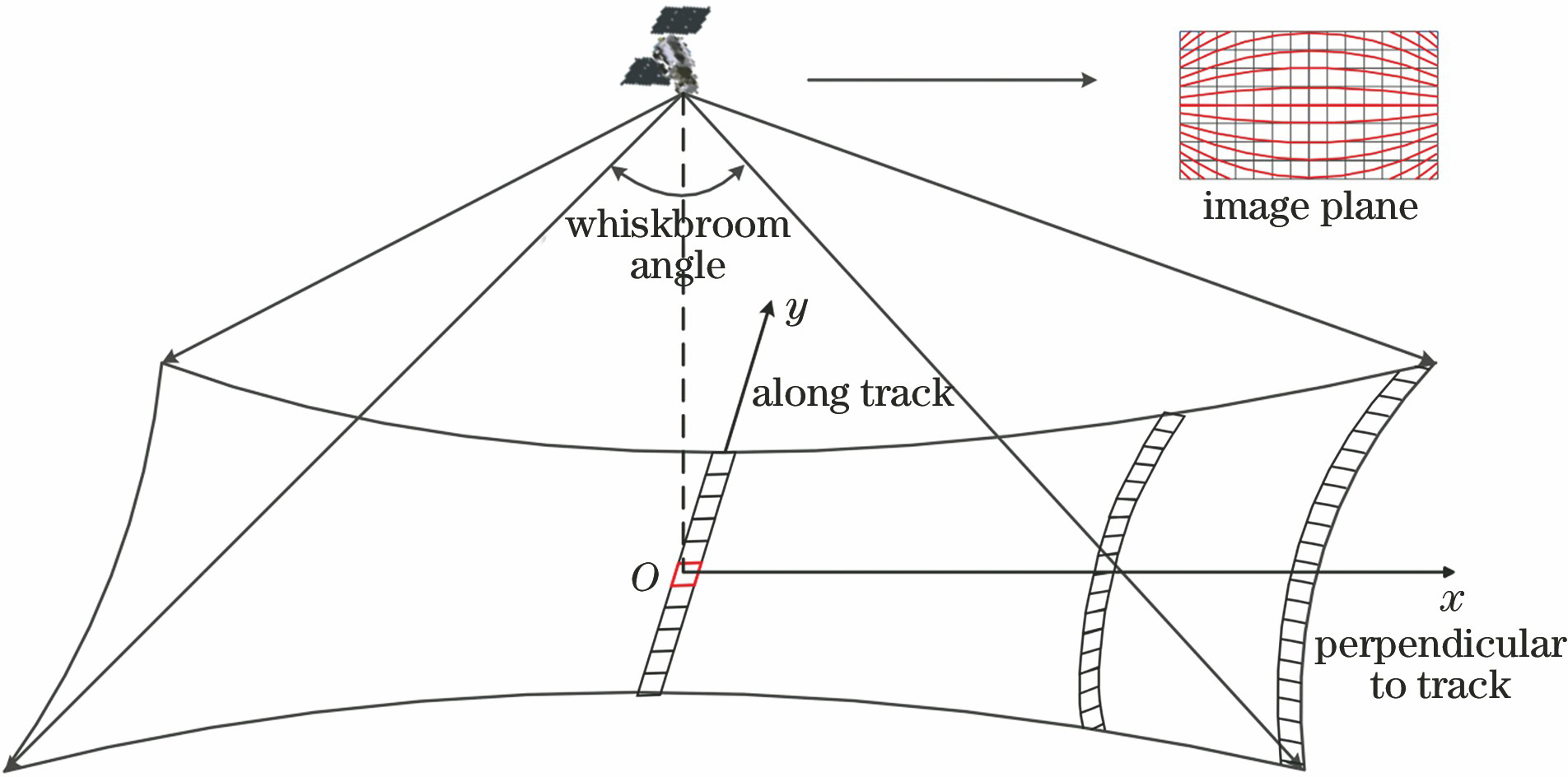

传统的地球可见光遥感卫星主要采用推扫成像方式,对地面景物的重返周期长、幅宽小;受光学特性的约束,空间相机还存在高分辨率与大视场角相互限制的矛盾。以上限制因素大大降低了遥感卫星的成像效率。卫星摆扫成像模式的应用,可以有效克服这个矛盾,能够大大增加观测范围,降低对地观测的重访周期,提高探测信息的时效性[1]。但是,通过这种成像方式获得的图像仍存在一定的畸变和像质下降问题。地面分辨率会随着摆扫角度的增加而急剧降低,在沿轨方向上成像区域的边缘亚像素化,而在垂轨方向上图像两侧的景物会被压缩,这种现象主要是由系统成像的光轴与地面的夹角发生变化引起的[2]。随着卫星宽幅摆扫成像技术的不断发展,遥感产品的垂轨幅宽大大增加,但随之出现的畸变与像质退化问题也更加严重,摆扫影像的几何校正与分辨率提升成为目前急需解决的问题。

对于卫星影像的几何校正方法,国外公开发表的研究主要集中于传统推扫遥感影像的校正[3-5]。一项国外专利公开了一种针对近地卫星的大角度摆扫影像的几何校正方法,在探测器的视场范围内,将地面目标按条带均匀地划分,然后在像面上对每行像素进行拉伸,最后从探测器上去除亚像素部分,输出重建后的地面影像[6]。国内对摆扫影像的研究主要集中于卫星的宽幅成像[7-11]。针对红外摆扫影像,丁一帆等[12]采用单帧影像构建基于视线的模型并进行正向计算,然后将多个单帧影像投影至平面进行拼接,再构建有理函数模型进行反向计算,得到几何校正的影像。杨飞等[13]提出一种光学追迹与像移匹配模型,利用卫星摆扫过程中交轨方向上速度的失配量和成像的变形量,补偿空间相机像面各点处的像移量,从而实现快速的几何校正。莫德林等[14]提出一种利用地物关系约束的坐标反投影计算方法,每次搜索时定位最佳扫描行,这方法提高了摆扫影像几何校正的效率。

以上的几何校正方法只考虑了卫星摆扫过程中的畸变还原问题,仍未解决分辨率下降的问题。随着深度卷积网络和超分辨技术的发展,两者的结合为高效、实时地提高图像分辨率提供了可能。Dong等[15]提出深度卷积神经网络超分辨(SRCNN)方法,将深度学习应用于图像超分辨率重建。SRCNN方法可用于解决单帧图像的超分辨问题,它首先将RGB图像转化到YCbCr颜色空间,然后单独提取亮度通道图像,利用双三次插值将低分辨率图像放大成目标尺寸,接着通过三层卷积网络拟合非线性映射,最后输出高分辨率图像结果。但这方法只针对传统的图像,并不能直接用于遥感数据,特别是摆扫影像。遥感影像具有大尺度、大数据量的特点,单幅图像的覆盖范围可达几十甚至几百平方千米。因此,本文主要解决的问题是如何校正大角度摆扫影像的几何畸变,同时增强校正影像的视觉效果。

本文提出一种综合深度卷积网络的摆扫影像反演恢复算法。摆扫过程中,空间相机的摆扫角和单位视场角保持恒定;成像过程中,像面上的像素点与相机光轴指向的地面景物相对应。基于这两点,能实现像面上被压缩景物的还原,并将其恢复成为与实际地面景物相一致的图像。为训练适用于遥感影像的卷积神经网络框架,采用包含多种地物类型的卫星影像数据,得到优化的网络参数,最终有效地减轻了校正后影像的模糊程度。

2 摆扫影像的反演恢复算法

摆扫成像和推扫成像的几何模型差异在于:摆扫过程中每一帧的影像都对应不同的卫星姿态数据,摆扫角度随时间变化;而推扫成像过程中采用固定的角度,每一帧影像与卫星沿轨道的轨迹相对应。在本节中,首先根据摆扫角、单位视场角恒定和物像映射关系建立分辨率反演模型,对摆扫影像进行几何校正,然后采用改进的基于深度卷积网络的超分辨方法,增强校正后图像的视觉效果。

2.1 分辨率反演方法

摆扫成像是卫星在沿轨飞行过程中,相机沿某方向按一定角速度对地面景物同步进行摆动扫描的动态成像方式。随着空间相机摆扫成像过程中物距的时时变化,对应的像面上成像分辨率也在不断变化,物面上的成像区域呈中间窄、两侧宽的形状,如

图 3. 垂轨方向上星下点地物的像元数目计算示意图

Fig. 3. Calculation of pixel number of nadir ground scene perpendicular to track

2.1.1 垂轨方向上的分辨率反演

根据单一电荷耦合器件(CCD)像素对应的单位成像视场角不变的原理可知,CCD像素与地面景物的像元相对应。以单位视场角对应的星下点地面景物为单位像元,当存在摆扫角时,单位视场角可以对应地面景物的多个像元。由这个原理,可推算出星下点垂轨方向上的地面像元个数。如

由此,可以计算得到在地物总长度下,对应单位视场角α的数量N为

然后,将星下点所在行(即

式中:j=1,2,…,N。

根据探测器各个单位视场角处对应的摆扫角,就可以计算得到实际可观测的成像长度Δxj为

由此,就可以得到星下点垂轨方向上实际的地物像元总数Nx为

如前所述,摆扫成像会导致物面的像元在像面上被压缩。因此,需要对被压缩的景物进行拉伸,即对探测器获得的图像在垂轨方向上进行扩展。如

式中:i=1,2,…,Nx,表示实际地物的像元序号。由于对于地面上的每个像元,探测器的单位视场角保持不变,故可以计算出拉伸后图像与原畸变图像的像元对应关系Ni∝Nj,其中

图 4. 垂轨方向上原畸变图与拉伸图像的像元对应示意图

Fig. 4. Schematic of corresponding pixels of distorted and extended images perpendicular to track

需要指出的是,在本文中符号∝并不代表比例关系,而是代表单个Nj可以对应多个Ni。以

2.1.2 沿轨方向上的分辨率反演

直观来看,当卫星的摆扫角度增大时,在沿轨方向上地面景物的两侧会包含更多的像元,在地面上会显示为视场边缘向外扩张,于是需要将像面上被压缩的图像还原成地面上视场范围内的景象。如

在卫星摆扫过程中,沿轨方向的半视场角η始终保持不变,另外,可依旧沿用第2.1.1节中对星下点所在行的像元编号顺序,推导出当摆扫角为θi时,成像区域在沿轨方向上的宽度yi为

θi的计算方程见(6)式,将 (6)式、(8)式和(9)式代入(10)式中,就能得到yi的完整表达式,即

则不同摆扫角度下,地面景物在沿轨方向上的像元数

在沿轨方向像面上被压缩的像元重新被拉伸成无畸变的枕形,地物的像元个数从

图 6. 沿轨方向上原畸变图与拉伸图像的像元对应示意图。(a)原畸变图;(b)拉伸图像

Fig. 6. Schematics of corresponding pixels of distorted and extended images along track. (a) Original distorted image; (b) extended image

2.2 摆扫影像的超分辨框架

在第2.1节中提出的分辨率反演模型中引入了插值方法,该方法导致亚像素模糊。受益于SRCNN[15-16]在单帧图像超分辨领域的贡献以及海量卫星数据的处理能力,本文提出适用于摆扫影像的深度卷积网络框架(wbi-SRCNN),减轻了拉伸图像中的模糊效应,增强了图像的视觉效果。

2.2.1 SRCNN的结构

SRCNN的结构非常简单,仅仅使用三个卷积层,其结构如

1) 特征提取和表示。从插值后的低分辨率图像Y中提取若干个特征,每个特征都可以用一个向量来表示。数学上,可通过一组卷积核对低分辨率图像进行卷积,这一步可以表示为

式中:F1(Y)为输出的特征映射,由n1个特征映射组成;*为卷积操作;W1为卷积核,大小为c×f1×f1,c为低分辨率图像的通道数,f1为每个卷积核的长、宽维度;图像Y与地面真值(ground truth)的尺寸相同,但在深度学习超分辨领域,通常仍将其称为低分辨率图像;B1为维度为n1的偏置向量。

2) 特征非线性映射。将每个n1维的特征向量映射为n2维向量,可以理解为低分辨率图像在重建的高分辨率网格上的表示,其数学形式为

式中:卷积核W2的大小为n1×1×1,数量为n2;B2为n2维偏置向量。

3) 重建。对高分辨率网格上的图块进行聚合,最终生成高分辨率图像,仍是通过卷积实现,即

式中:F(Y)为重建的高分辨率图像;卷积核W3的大小为n2×f3×f3,通道数量为c,f3为卷积核的长、宽维度;B3为c维偏置向量。在SRCNN中,典型的参数设置为f1=9,f3=5,n1=64,n2=32。实验中,分别采用Timofte数据集(包含91幅图像)和ImageNet大数据集[17](包含约400000张图像)作为训练集,SET5[18]和SET14[19]作为测试集。相比于双三次插值和传统的超分辨方法,SRCNN得到的高分辨率图像更加清晰,能够得到比传统方法更加理想的效果。

2.2.2 wbi-SRCNN的结构

在SRCNN的整个操作过程中,唯一需要的预处理就是对低分辨率图像集进行一次双三次插值,其余过程可以看作是一个输入与输出相对应的系统,输入的是插值后的低分辨率图像,输出的是高分辨率图像。而在第2.1节中获取的摆扫校正图像受到插值模糊的影响,需考虑将其等效为SRCNN系统中的低分辨率图像,进而通过该网络框架提高摆扫影像的分辨率。

但是,与传统图像相比,将SRCNN应用于遥感影像会存在两个严重的问题:首先,遥感影像的数据量远远大于传统图像,以训练集为例,SRCNN中使用的ImageNet[17]包含了约400000张图像,大小约为148 GB,然而单幅遥感影像的大小可以达到1 GB,考虑到训练时包含的多个地面场景,真实遥感影像的训练集体积将远远大于传统图像集;其次,不同遥感影像的地面覆盖尺度差异极大,会对数据预处理技术提出要求。不同轨道的卫星拍摄的遥感影像幅宽不同:高分一号卫星运行轨道高度为644.5 km,高分辨率相机的地面覆盖宽度为60 km;高分四号卫星为地球同步轨道卫星,幅宽为400 km。本研究采用50500 pixel×1197 pixel的真实遥感图像,地面分辨率为0.1 m,利用随机剪切的方法获取训练集与测试集。此外,为增加地物类型,还对JL-1和ZH-1光学卫星的遥感数据作同样的随机剪切处理,获得同样尺寸的子图,并将其加入到训练集当中。受监督学习的影响,更加丰富的地物类型可以增加卫星在轨处理影像时网络框架的稳健性。

采用wbi-SRCNN提高摆扫校正影像的分辨率的另一个因素在于:在端对端的学习中,网络参数的性质只由训练数据决定,这些参数只会对网络的性质产生影响,并不会影响网络本身的结构。因此,本节的主旨就是选取合适的遥感影像数据和网络参数,训练一个深度卷积网络,证明wbi-SRCNN可应用于遥感影像,提高摆扫校正影像的分辨率。wbi-SRCNN的结构如

3 实验

3.1 数据集

在本实验中,获取摆扫影像及大量用于训练的合适图像至关重要,受限于现有的卫星成像技术,目前可供直接使用的样本数量很少。本研究将利用现有的卫星图像与设备,生成符合实际摆扫工况的影像以及生成用于训练和测试神经网络性能的卫星图像数据集。

3.1.1 摆扫影像的获取与处理

利用单轴转台、高分辨时间延时积分(TDI)相机及曲面LED屏幕进行卫星摆扫成像模拟,进而获得摆扫影像。在控制计算机中输入一幅全色靶标影像,投影在LED曲面屏上。转台转动在LED曲面屏上产生的速度为v1,用以模拟卫星摆扫成像的过程;全色图像在垂直于v1的方向上以一定的速度v2运动,用以模拟卫星沿轨道相对于地球的运动过程。两模拟过程如

图 9. 卫星摆扫成像实验装置示意图

Fig. 9. Schematic of experimental device of satellite whiskbroom scanning imaging

曲面LED屏幕模拟地球表面,尺寸为6 m×4 m,曲率半径为32 m,LED像元尺寸为4 mm; 高分辨率TDI相机的像元尺寸为8 μm,焦距为8 mm; TDI相机固联在单轴转台上,在水平方向上连续往返摆动,用以模拟卫星摆扫成像,对LED目标可实现横滚±35°范围内的成像。

在实验过程中,对在轨卫星的成像参数与地面仿真的实验参数进行匹配,对应的成像匹配参数如

表 1. 在轨成像与地面模拟参数

Table 1. Parameters for on-orbit imaging and ground simulation

|

3.1.2 训练集/测试集的获取与处理

除采用第3.1.1节中的全色靶标图像,本节中还加入JL-1和ZH-1光学卫星的遥感数据集,产生实验所需要的训练集和测试集。

采用随机剪切的方法获取大小为190 pixel×570 pixel的高分辨率子图像。首先,针对文中的全色靶标图像,在x方向上,从[0,W-570]范围内生成K个非重复的随机整数,作为x方向上的坐标xm;同理在y方向上,从[0,H-190]范围内生成K个非重复的随机整数,作为y方向上的坐标ym。在这里, W、H和K分别为影像的宽、高及数据集中影像的总数。然后,以(xm,ym)和(xm+570,ym+190)作为矩形对角坐标,即可生成具有随机重叠的子图像。同样的方法应用于JL-1和ZH-1的数据集中,最终获得的训练集包含38000张图像,测试集包含2000张图像。

相应地,为了与分辨率还原模型中的插值方法相对应,采用双三次插值方法获取低分辨率子图像。首先对图像进行上采样,然后进行下采样,尺度因子为2。

3.2 摆扫影像的畸变校正

利用第2.1节中提出的分辨率反演模型,将第3.1.1节中获得的模拟摆扫影像进行畸变校正,得到校正后的图像如

图 10. 摆扫影像的畸变校正结果。(a)地面真值;(b)摆扫影像模拟图;(c)摆扫影像恢复图

Fig. 10. Distortion correction result of whiskbroom scanning image. (a) Ground truth; (b) simulated whiskbroom scanning image; (c) distortion-corrected whiskbroom scanning image

图 11. 摆扫线性靶标的畸变校正结果。(a)摆扫线性靶标模拟图;(b)摆扫线性靶标恢复图

Fig. 11. Distortion correction result of whiskbroom scanning linear target. (a) Simulated whiskbroom scanning linear target; (b) distortion-corrected whiskbroom scanning linear target

同时需要指出的是,

3.3 摆扫影像的增强

在第2.2节中指出,分辨率反演模型中引入的插值模糊可以通过包含相同预处理过程的SRCNN框架进行去除。本研究通过重新训练网络参数,获得了比原先网络结构更好的结果。

除了将SRCNN中的传统图像数据集替换为遥感影像数据集,还对三层卷积网络的结构进行了优化,将卷积核的尺寸从9、1、5调整为9、5、5。使用尺寸更大的卷积核可以获取更丰富的结构信息,从而产生更好的效果,但是网络计算速度会相应降低,这对包含大量信息的遥感图像来说十分重要,因此需要折中计算速度与恢复质量。此外,采用Adam优化算法,学习率η=0.0001,mini batch的大小为32,相对于原先的算子,改进的网络仍具有更快的收敛速度,而且对遥感数据具有更好的损耗稳定性。对畸变校正后的摆扫影像进行剪切,选取中间190 pixel×570 pixel的影像分别输入SRCNN和wbi-SRCNN中,测试图像分别为wall和roof,得到的结果如

图 12. 畸变校正后摆扫影像的增强结果。(a)畸变校正后的摆扫影像;(b) Bicubic结果;(c) SRCNN结果;(d) wbi-SRCNN结果。左图为wall,右图为roof

Fig. 12. Enhanced results of distortion-corrected whiskbroom scanning images. (a) Distortion-corrected whiskbroom scanning images; (b) result of Bicubic; (c) result of SRCNN; (d) result of wbi-SRCNN. Left is wall and right is roof

3.4 结果分析

在对摆扫影像进行畸变校正的过程中,采用了非均匀插值,因此校正后的图像在整体上已经被拉伸,也就是说,对于相同尺寸的地面真值和校正后的图像来说,后者包含的地面景物会更少,因此校正偶的图像无法与原图进行像素级完全匹配。另外,在对重建的高分辨率图像进行像质评价时,多数情况下,无法获得针对同一区域原始高分辨率的卫星数据,也就无法得到参考图像,例如卫星运行时不可避免地存在星上微振动、时刻变化的大气湍流等。那么,利用参考图像进行像质评价的指标,包括结构相似度、峰值信噪比或均方误差,就不适合于实际应用。因此,本文中采用无参考图像质量评价指标(NR-IQA)[20-24]。

a) 相邻像素灰度差(NPGD)。这种算法利用水平与垂直方向上相邻像素灰度差的点积,定义为

式中:f(x,y)为图像中单个像素的灰度值;M和N分别为图像的行数和列数。

b) 边缘点锐度(EPS)。这种算法计算某一像素点8邻域像素与该像素的灰度差,并且需要将插值进行距离加权。约定水平和竖直方向的权重为1,45°和135°方向上的权重为

式中:wi为距离权重;Δf为相邻像素的灰度差。以上两个像质评价指标的原理均基于边缘像素灰度差越大,图像层次越明显,图像纹理更清晰。这两个指标的数值越大,代表重建图像的质量越好。

此外,采用Mittal等[21]提出的基于自然图像的评价指标(NIQE)以及Venkatanath等[22]提出的基于人眼感受的评价指标(PIQUE)进行比对,这两个指标的数值越小,代表图像的质量越好。从

表 2. 测试图像的NR-IQA结果

Table 2. NR-IQA results of test images

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||

本文算法适合于星上使用,分辨率反演模型中包含的物像映射先验关系,能大大减少超分辨网络的训练时间,使卫星能够分配更多的资源给姿轨控制、敏捷拍摄等高精度卫星任务。若使用地面站实现传统遥感影像恢复算法,海量的遥感影像将极大地增加数传时间,即使采用多台高性能的地面处理器训练无先验的卫星数据,也会大大增加训练时间和训练成本。

4 结论

针对卫星大角度摆扫影像的畸变与低分辨率的问题,提出一种综合深度卷积网络的分辨率反演恢复算法。首先提出一种基于摆扫角、单位视场角恒定,以及满足物像映射关系的分辨率反演模型,对大畸变的摆扫影像进行几何校正。该模型先对垂轨方向上的地物进行拉伸,然后对沿轨方向上的地物进行自适应插值,最终能够得到较为理想的去畸变影像。其次,建立一种适用于遥感影像的深度学习超分辨框架wbi-SRCNN,该框架可以有效地增强去畸变后摆扫影像的视觉效果。最后,进行了地面仿真实验,验证了本文算法的有效性。相对于传统的几何校正或者图像增强方法,本文算法能够取得更为理想的恢复效果。对于摆扫影像的恢复,本文采用的是先校正后增强的方法,受益于球面卷积神经网络的思想,将分辨率反演模型进行简化,然后使用深度卷积网络学习畸变影像与去畸变影像之间的映射关系,这将是本文未来主要的研究工作。

[1] 曹喜滨, 金光, 王峰, 等. 一种卫星快速旋转超大幅宽摆扫成像方法: 201610565836.5[P].2017-09-12.

Cao XB, JinG, WangF, et al. A whiskbroom imaging method for the rapidly rotated satellite with large swath: 201610565836.5[P]. 2017-09-12.

[2] 程少园, 张丽, 高卫军, 等. 大视场空间相机侧摆成像时几何参数分析[J]. 红外与激光工程, 2015, 44(6): 1872-1877.

[6] Truxton K F. Geometrically corrected large angle whiskbroom scanner for low earth orbiting satellites: US5420789[P/OL].1995-05-30[2019-04-30]. https:∥patents.glgoo.top/patent/US5420789A/en.

[7] 王义坤. 面阵摆扫宽幅成像技术研究[D]. 上海: 中国科学院大学, 2015: 14- 20.

Wang YK. Research of wide swath imaging technology based on area-array detector adopting whiskbroom scanning mode[D]. Shanghai: University of Chinese Academy of Science, 2015: 14- 20.

[8] 张宗存, 丁学专, 杨波, 等. 超大幅宽低畸变成像系统设计与分析[J]. 红外与毫米波学报, 2017, 36(6): 732-738.

[9] 李昕阳, 张涛, 刘志明, 等. 全景式TDICCD摆扫航空相机像面旋转的高精度补偿[J]. 光学学报, 2014, 34(6): 0611001.

[10] 莫德林, 张永生, 王涛, 等. 航空线阵摆扫式相机成像仿真[J]. 光学学报, 2018, 38(7): 0728002.

[11] 刘超, 丁亚林, 田大鹏, 等. 航空相机像旋动态调制传递函数分析与研究[J]. 光学学报, 2017, 37(2): 0211001.

[12] 丁一帆, 尤红建, 陈双军, 等. 一种面向红外摆扫成像的几何校正方法[J]. 遥感信息, 2018, 33(5): 76-81.

[13] 杨飞, 金光, 曲宏松, 等. 航天时间延迟积分CCD相机摆扫成像快速几何校正设计与分析[J]. 光学学报, 2014, 34(1): 0111001.

[14] 莫德林, 张永生, 王涛, 等. 一种地物关系约束下的线阵影像坐标反投影计算方法[J]. 测绘学报, 2017, 46(5): 583-592.

[15] DongC, Loy CC, He KM, et al. Learning a deep convolutional network for image super-resolution[M] ∥Fleet D, Pajdla T, Schiele B, et al. Computer vision-ECCV 2014. Lecture notes in computer science. Cham: Springer, 2014, 8692: 184- 199.

[17] DengJ, DongW, SocherR, et al. ImageNet: a large-scale hierarchical image database[C]∥2009 IEEE Conference on Computer Vision and Pattern Recognition, June 20-25, 2009, Miami, FL, USA. New York: IEEE, 2009: 248- 255.

[19] ZeydeR, EladM, ProtterM. On single image scale-up using sparse-representations[M] ∥Boissonnat J D, Chenin P, Cohen A, et al. Curves and surfaces. Lecture notes in computer science. Berlin, Heidelberg: Springer, 2012, 6920: 711- 730.

[22] VenkatanathN, PraneethD, Bh MC, et al. Blind image quality evaluation using perception based features[C]∥2015 Twenty First National Conference on Communications (NCC), February 27-March 1, 2015, Mumbai, India. New York: IEEE, 2015: 15058962.

[23] WangZ, Sheikh HR, Bovik AC. No-reference perceptual quality assessment of JPEG compressed images[C]∥Proceedings. International Conference on Image Processing, September 22-25, 2002, Rochester, NY, USA. New York: IEEE, 2002: I477- I480.

Article Outline

徐超, 金光, 杨秀彬, 徐婷婷, 常琳. 综合深度卷积神经网络的摆扫影像反演恢复算法[J]. 光学学报, 2019, 39(12): 1228001. Chao Xu, Guang Jin, Xiubin Yang, Tingting Xu, Lin Chang. Inversion Restoring Algorithm for Whiskbroom Scanning Images Synthesized with Deep Convolutional Neural Network[J]. Acta Optica Sinica, 2019, 39(12): 1228001.