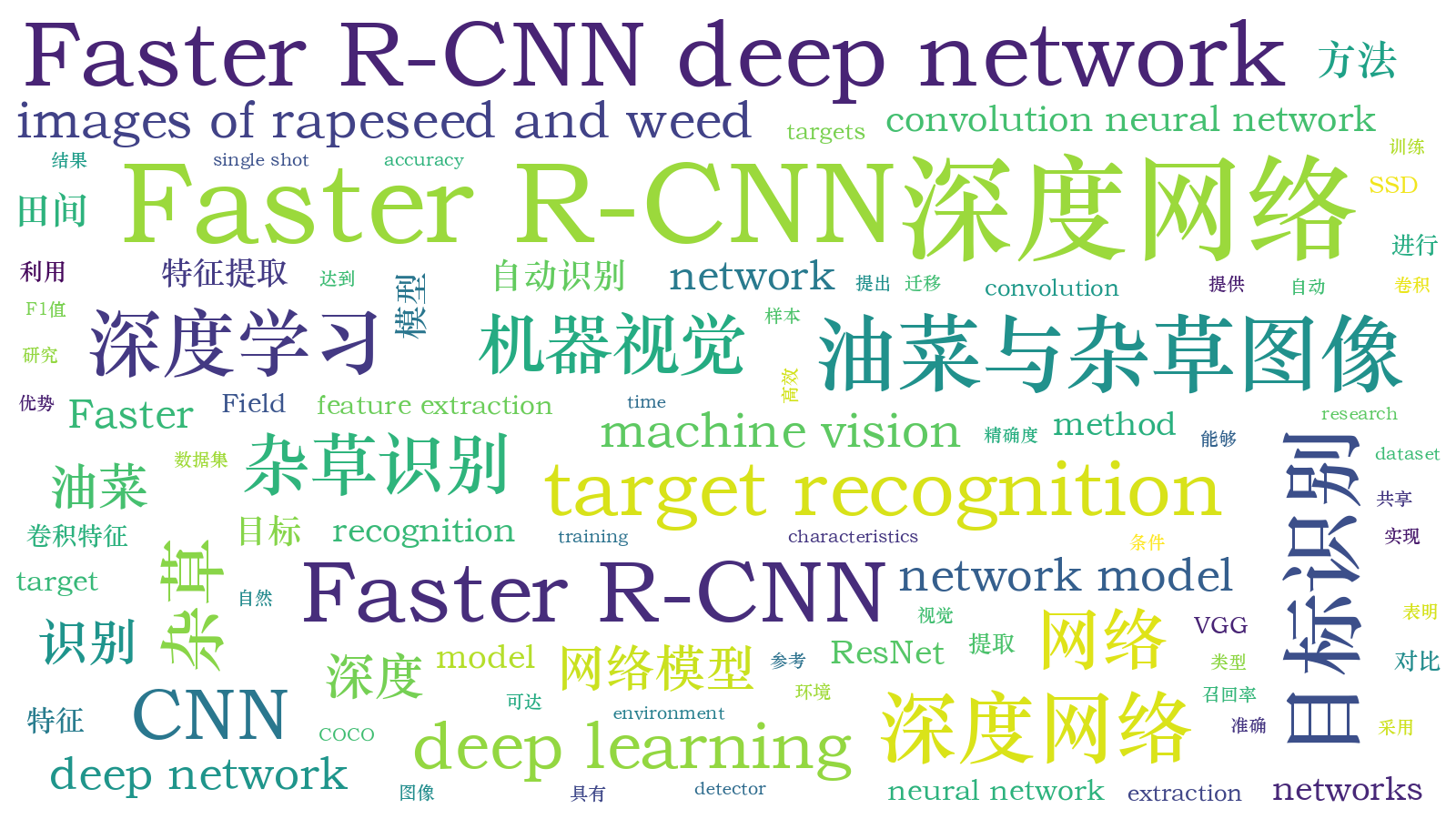

基于Faster R-CNN深度网络的油菜田间杂草识别方法  下载: 1397次

下载: 1397次

1 引言

随着我国农业现代化智能程度的不断加快,在自然生长环境条件下,准确高效地识别田间农作物的杂草目标对于实现田间智能化管理起到重要作用,一方面有助于智能设备的自动化除草作业和自动水肥变量喷施,另一方面有助于减少田间农药化肥的使用[1]。因此,如何准确、快速、高效地识别田间农作物的杂草具有十分重要的意义,对推进现代信息技术与农业深度的跨界融合具有实际理论意义。

目前,国内许多学者对油菜与杂草的目标识别开展了相关研究,并且取得了一定的研究成果。白敬等[2]利用光谱分析技术,以冬油菜苗和冬油菜苗期杂草以及土壤为研究对象,实现了冬油菜苗期杂草的快速识别。潘冉冉等[3]运用近红外高光谱成像技术,同时结合化学计量学方法,对油菜中的杂草进行了准确分类识别。但是,传统的基于机器学习[4-5]或者机器视觉[6-8]的农作物与杂草目标识别方式,依赖于人工的设计与制造检测特征,设计过程中易受主观因素影响,需要理论的指导,会耗费大量的时间,因此要求研发人员具有扎实的专业素养和大量的成熟经验,最终形成的检测特征也是参差不齐,难以适应自然环境因素的变化,泛化能力较差[9]。随着人工智能革命浪潮的来临,深度学习方法的出现有效地解决了这一问题,深度学习中的卷积神经网络[10](CNN)具有目标特征自动提取功能,无需人工干预设计,能够有效、自动地对多任务需求学习目标特征,从而在目标检测与识别方面表现出强大的能力。

近年来,随着深度卷积神经网络[11-12](DCNN)的应用与发展,越来越多的研究人员开始将其应用于目标检测与识别领域。Girshick等[13]提出基于区域卷积神经网络(R-CNN)的目标检测方法,该方法利用选择性搜索(SS)算法生成候选区域,用于提取目标特征,虽然能解决少量有限标注数据训练,生成较高质量模型,但是在提取特征效率和占用内存方面表现欠佳。随后,为了解决R-CNN中出现大量冗余特征提取的问题,Girshick[14]又提出Fast R-CNN模型,该模型采用自适应尺度池化操作,极大地提高了目标检测与识别的性能。He等[15]提出基于深度卷积网络的空间金字塔池化层视觉识别方法,该方法放宽了对输入图片数据尺寸大小的限制,从而显著提高了识别的准确率。Ren等[16]提出Faster R-CNN模型,该模型由区域建议网络(RPN)和Fast R-CNN构成,用区域建议网络替代SS算法,解决了计算区域建议时间开销大的瓶颈问题,使实时目标检测与识别成为可能,于此同时,Faster R-CNN模型被广泛应用于车辆检测领域[9]、遥感影像地物目标识别领域[17-18]、外观缺陷检测领域[19]、行人检测与识别领域[20-21]以及田间图像检测领域[22]等。

为实现油菜与杂草目标的准确高效识别,利用深度学习方法克服传统机器学习方法中存在易受复杂环境背景、农作物与杂草遮挡以及光线等的干扰,以及目标识别效率低下且泛化能力差的问题,本文将Faster R-CNN深度网络模型方法运用到油菜与杂草目标识别中,通过对比3种特征提取网络的性能,同时对比SSD深度网络模型方法[23],结果可知,基于VGG-16特征提取网络的Faster R-CNN深度网络模型在油菜与杂草目标识别中表现出巨大的潜力,为智能除草机器人前期的除草作业以及多类型杂草目标识别的研究提供了参考。

2 实验数据

2.1 图像数据采集

此次实验的油菜与杂草图像数据采集于安徽农业大学庐江农业科技园,采集时间为2018年12月16日—17日,时间段为每日的上午9:00—12:00,下午13:00—16:00,此时油菜目标处于幼苗期,并且该时间段太阳光线充足。采集过程分别以平视、俯视和45°斜视3个方向采集自然条件下生长的油菜与杂草图像,严格地按照采集步骤进行采集。图像数据采集设备采用高清数码相机,型号为佳能EOS 6D Mark II相机,图像分辨率为5472 pixel×3648 pixel,所有图像均为JPEG格式。

2.2 数据集分析

本次实验共采集油菜与杂草图像2826张,其中采集单株油菜786张、采集单株杂草813张、采集油菜与杂草混合1227张。为了训练后续模型以及减少训练所占用的内存与显存,需要将图像分辨率为5472 pixel×3648 pixel的图像进行压缩处理,压缩为500 pixel×400 pixel。然后需要从采集的2826张油菜与杂草图像中随机选取295张图像作为测试集,其余2531张图像用于后续的图像数据增强以及网络模型训练。采用人工标注的方式进行图像标注,利用最小外接矩形法对图像中的油菜与杂草目标进行标注,保证每个标注矩形框内有且仅有一个油菜或者杂草目标,并且尽可能少地包含背景信息。

为了实现图像数据增强,以增加样本的多样性,本文对压缩过后的原始图像进行水平翻转、垂直翻转、水平垂直翻转、亮度增强与减弱、饱和度增强与减弱7种处理操作,如

图 1. 图像数据增强结果。(a)油菜与杂草混合图像;(b)水平翻转图像;(c)垂直翻转图像;(d)水平垂直翻转图像;(b)亮度增强图像 ;(b)亮度减弱图像;(b)饱和度增强图像;(b)饱和度减弱图像

Fig. 1. Results of image data enhancement. (a) Mixed image of rapeseed and weeds; (b) horizontally flipped image; (c) vertically flipped image; (d) horizontally and vertically flipped image; (e) brightness-enhanced image; (f) brightness-reduced image; (g) saturation-enhanced image; (h) saturation reduced image

3 基于Faster R-CNN的油菜与杂草目标识别网络

Faster R-CNN深度网络模型通过对R-CNN和Fast R-CNN模型的分析与优化,形成了一种更优的目标检测网络模型。Faster R-CNN深度网络模型是RPN和Fast R-CNN模型两者的深度结合。其中RPN替换了原有的SS等方法,用于生成高质量的区域建议框,实现了与VGG-16特征提取网络的卷积层共享,有效降低了区域建议检测所需的时间成本;而Fast R-CNN模型负责学习RPN所生成的建议区域特征,处理后续的分类得分与边框回归工作。本文具体的油菜与杂草目标识别网络如

3.1 模型算法

Faster R-CNN深度网络由特征提取网络、RPN和RoI(region of interest)子网组成。其中特征提取网络采用VGG-16卷积神经网络用于提取输入图像的特征,进而形成特征图,与RPN共享卷积特征。该特征提取网络包括13个卷积层和5个池化层,每个卷积层均采用非线性ReLU作为激活函数,卷积核的大小均为3×3,每个池化层均采用最大池化层(max pooling)的形式,最终将该特征提取网络分为5个部分,每个部分之间通过池化层连接。以其中第1个部分为例,该部分按照卷积层(convolution)+激活函数(ReLU)+池化层(max pooling)的组合方式形成,卷积层有2层,由3×3的卷积核和64个通道数组成。

RPN作为目前最先进的区域建议框提取算法,是一个全卷积神经网络(FCN),采用滑动窗口机制实现区域建议框的生成,具体的RPN结构如

对于RPN总体的损失函数定义为[24]

式中:i表示批处理一次中选取锚点的索引;pi表示锚点i是目标的预测概率;

(1)式中的Lcls表示分类损失,实质是两个类别(目标/非目标)的对数损失,定义为

(1)式中的Lreg表示回归损失,定义为

式中:Ncls(Ncls=256)和Nreg(Nreg=2400)表示归一化参数,分别对分类项和回归项两项进行归一化,并通过平衡参数λ(λ=10)进行加权,从而使这两项权重大致相同;lb表示对数损失函数; R表示稳健损失函数(smooth L1)。

对于边框回归,采用4个坐标的参数化,即

式中:x、y、w、h表示预测边框的中心坐标及其宽和高;变量x、xa、x*分别表示预测边框、锚点、真实区域边框的x坐标(y,w,h同样适用)。

RoI子网连接在VGG-16特征提取网络之后,用于准确提取目标的RoI,进而可以对目标区域的位置进行参数回归修正,最终准确实现油菜与杂草的目标识别。将RPN提取的proposals和特征提取网络提取的特征图作为输入,输入感兴趣区域池化层(RoI pooling)用于将大小不同的RoI通过池化操作固定为7×7的RoI特征池化图;然后再通过连接的两个全连接层将RoI特征池化图转化为一个RoI特征向量(4096维),该向量包含RoI最终特征;最后将该向量输入一个对应的全连接层,利用Softmax计算分类得分,输出预测的类别概率,再将该向量输入到另一个对应的全连接层中,利用边框回归(Bbox regressor)获得位置偏移量,进而输出更加准确的目标检测框。

3.2 评价指标

为评价本模型对解决油菜与杂草目标识别时的有效性,采用精确度与召回率两项指标进行模型评价,两者的取值范围均为[0,1],同时引入F1值[12]进行调和平均评价,具体评价计算公式为

式中:P表示精确度;R表示召回率;F1表示精确度和召回率的调和平均;nTP表示正确识别油菜与杂草目标的数目;nFP表示错误识别油菜与杂草目标的数目;nFN表示未识别油菜与杂草目标的数目。

4 结果与讨论

4.1 实验平台及训练设置

本实验在Windows 10企业版操作系统下,基于Intel(R) Core(TM) i5-8400 CPU,2.80 GHz(16 GB运行内存)和NVIDIA GeForce GTX 1080 Ti GPU(11 GB运行显存)的硬件设备搭建TensorFlow深度学习框架,利用Python编程语言实现油菜与杂草目标识别网络模型的训练与测试。

本文以端到端的训练方式共享卷积特征,利用COCO数据集[25]的预训练模型进行初始化参数设置。模型的优化器选择随机梯度下降(SGD)算法,整体学习率设置为0.001,动量因子设置为0.9,最大迭代次数设置为100000步。当迭代次数达到40000步时,学习率进一步调整为0.0001,当迭代次数达到80000步时,学习率再进一步调整为0.00001,用以加速训练模型的收敛。同时,每1000步输出在验证集上测试的平均精度与召回率,当损失函数收敛且迭代次数达到100000步时停止训练。训练结束后需保存训练好的模型,利用测试集对模型效果进一步验证,保留置信度大于0.8的油菜与杂草目标,最后在测试集的图像数据中输出识别情况。

4.2 模型训练结果分析

为了选取更优的深度网络模型以及适宜的特征提取网络,本实验在SSD深度网络模型和Faster R-CNN深度网络模型上,分别利用3种特征提取网络(VGG-16、ResNet-50、ResNet-101)进行各自模型的训练。随着模型训练迭代次数(iterations)的增加,对3种特征提取网络在各自深度网络模型中实时的整体损失函数的损失情况进行对比,具体的对比情况如

为进一步选取更优的深度网络模型以及适宜的特征提取网络,本实验根据上述各自深度网络模型对比的结果选取性能相对较优的2种模型进行进一步对比,因此选取的模型为均采用VGG-16卷积神经网络作为特征提取网络的SSD深度网络模型与Faster R-CNN深度网络模型。分别对他们的迭代次数与模型训练时的整体损失、模型验证时的精确度和召回率进行探究,具体的对比结果如

图 6. SSD与Faster R-CNN模型整体损失对比

Fig. 6. Comparison of total losses for SSD andFaster R-CNN models

根据模型评价,本实验对精确度与召回率两项指标以及F1值与检测时间(单张图像)进行了详细对比,深度网络模型的对比结果如

4.3 模型识别结果

本实验的Faster R-CNN深度网络模型采用VGG-16特征提取网络,利用RPN生成高质量的区域建议框,实现了与VGG-16特征提取网络的卷积层共享,降低了区域建议检测所需的时间成本,有效提高了油菜与杂草目标的识别精度。具体的油菜与杂草目标识别结果如

表 1. 深度网络模型对比

Table 1. Comparison of deep network models

|

图 9. 油菜与杂草目标识别结果。(a)有遮挡识别结果;(b)无遮挡识别结果;(c)复杂背景识别结果;(d)简单背景识别结果

Fig. 9. Results of target recognition for rapeseed and weeds. (a) Results of recognition with occlusion; (b) results of recognition without occlusion; (c) results of recognition with complex background; (d) results of recognition with simple background

4.4 讨论

本文利用深度学习的方法能够自动识别自然环境条件下油菜与杂草目标,目的在于以智能除草机器人视觉角度捕捉识别目标,这对后续油菜与杂草目标定位奠定了研究基础,有望顺利应用于智能除草机器人的除草作业,减少了化学农药的使用。

由上述模型训练结果分析可知,相较于Faster R-CNN深度网络模型,SSD深度网络模型在油菜与杂草目标识别精确度上稍逊一筹,但是在检测速度上却表现出明显的优势。原因如下:第一,SSD深度网络模型采用将整个检测网络作为单个神经网络,根据自动提取多尺度的特征图,利用不同尺度和长宽比的先验框,可以较为准确地预测目标类别概率和边框位置,因此在检测速度上表现出优势;第二,在所研究的野外自然环境中,油菜与杂草目标所处的实验环境背景复杂,背景干扰因素相对较多,另外在野外的油菜与杂草实验田杂草的种类不唯一,存在其他次要杂草目标的干扰,加之采集的目标图像数据多角度,存在严重的覆盖与遮挡问题,从而导致SSD深度网络模型的先验框不能很好地发挥作用,进而影响了模型的准确率。

对比分析VGG-16、ResNet-50和ResNet-101这3种特征提取网络在油菜与杂草目标识别领域的优缺点,发现随着特征提取网络层数的不断加深,深度网络模型性能并没有表现出期望的结果。实验结果表明,基于VGG-16特征提取网络的Faster R-CNN深度网络模型,用于油菜与杂草目标识别具有明显优势。其原因为:第一,采用COCO数据集预训练模型进行初始化参数设置,对深度网络模型进行迁移训练,同时利用Faster R-CNN深度网络模型共享卷积特征;第二,随着特征提取网络卷积层数的不断加深,油菜与杂草目标识别准确率并没有提高,原因主要是过深的卷积层更具有个性化特征,不具有普适性,且会导致模型效果更差。

5 结论

以幼苗期的油菜与杂草图像数据为研究对象,在TensorFlow深度学习框架上构建基于VGG-16特征提取网络的Faster R-CNN深度网络模型。通过COCO数据集的深度网络模型进行迁移训练,对Faster R-CNN深度网络模型在油菜与杂草混合场景下的目标快速准确识别进行分析研究,对比分析3种特征提取网络的实际作用效果。另外,为解决深度学习模型训练时所需数据量大的问题,特别是农业领域中季节性作物存在数据量严重不足的问题,本文通过7种数据增强方式进行数据增强,极大地丰富了训练数据集,有效解决了油菜与杂草图像数据不足问题,从而降低模型训练时的过拟合风险,这也为后续有效解决农业许多领域面临数据匮乏的问题提供了思路。实验结果表明,Faster R-CNN深度网络模型通过采用VGG-16特征提取网络,相较于其余两种特征提取网络表现出明显的优势,实现了快速有效的目标识别,体现出深度学习方法在目标识别领域的强大效率。然而,通过进一步的对比与观察,不难发现,特征提取网络卷积层数的不断加深,并没有在油菜与杂草目标识别上表现出很好的效果,因此,面对复杂环境条件下农作物与杂草混合场景中的目标识别,合理的选择与设计特征提取网络具有十分重要的现实意义。由于该模型依然较为庞大,目标识别准确率仍待提高,故今后需要继续深入研究如何简化网络模型,研发轻量型深度网络模型,设计高识别率的目标识别方法,扩大深度网络模型在农作物其他除草领域的应用。

[1] Sabzi S, Abbaspour-Gilandeh Y. Using video processing to classify potato plant and three types of weed using hybrid of artificial neural network and particle swarm algorithm[J]. Measurement, 2018, 126: 22-36.

[2] 白敬, 徐友, 魏新华, 等. 基于光谱特性分析的冬油菜苗期田间杂草识别[J]. 农业工程学报, 2013, 29(20): 128-134.

Bai J, Xu Y, Wei X H, et al. Weed identification from winter rape at seedling stage based on spectrum characteristics analysis[J]. Transactions of the Chinese Society of Agricultural Engineering, 2013, 29(20): 128-134.

[3] 潘冉冉, 骆一凡, 王昌, 等. 高光谱成像的油菜和杂草分类方法[J]. 光谱学与光谱分析, 2017, 37(11): 3567-3572.

[4] 翟瑞芳, 方益杭, 林承达, 等. 基于高斯HI颜色算法的大田油菜图像分割[J]. 农业工程学报, 2016, 32(8): 142-147.

Zhai R F, Fang Y H, Lin C D, et al. Segmentation of field rapeseed plant image based on Gaussian HI color algorithm[J]. Transactions of the Chinese Society of Agricultural Engineering, 2016, 32(8): 142-147.

[5] Bakhshipour A, Jafari A. Evaluation of support vector machine and artificial neural networks in weed detection using shape features[J]. Computers and Electronics in Agriculture, 2018, 145: 153-160.

[6] 胡炼, 罗锡文, 曾山, 等. 基于机器视觉的株间机械除草装置的作物识别与定位方法[J]. 农业工程学报, 2013, 29(10): 12-18.

Hu L, Luo X W, Zeng S, et al. Plant recognition and localization for intra-row mechanical weeding device based on machine vision[J]. Transactions of the Chinese Society of Agricultural Engineering, 2013, 29(10): 12-18.

[7] 吴兰兰, 徐恺, 熊利荣. 基于视觉注意模型的苗期油菜田间杂草检测[J]. 华中农业大学学报, 2018, 37(2): 96-102.

Wu L L, Xu K, Xiong L R. Detecting weed in seedling rapeseed oil field based on visual-attention model[J]. Journal of Huazhong Agricultural University, 2018, 37(2): 96-102.

[8] Chang C L, Lin K M. Smart agricultural machine with a computer vision-based weeding and variable-rate irrigation scheme[J]. Robotics, 2018, 7(3): 38.

[9] 王林, 张鹤鹤. Faster R-CNN模型在车辆检测中的应用[J]. 计算机应用, 2018, 38(3): 666-670.

Wang L, Zhang H H. Application of Faster R-CNN model in vehicle detection[J]. Journal of Computer Applications, 2018, 38(3): 666-670.

[10] 王璨, 武新慧, 李志伟. 基于卷积神经网络提取多尺度分层特征识别玉米杂草[J]. 农业工程学报, 2018, 34(5): 144-151.

Wang C, Wu X H, Li Z W. Recognition of maize and weed based on multi-scale hierarchical features extracted by convolutional neural network[J]. Transactions of the Chinese Society of Agricultural Engineering, 2018, 34(5): 144-151.

[11] 周云成, 许童羽, 郑伟, 等. 基于深度卷积神经网络的番茄主要器官分类识别方法[J]. 农业工程学报, 2017, 33(15): 219-226.

Zhou Y C, Xu T Y, Zheng W, et al. Classification and recognition approaches of tomato main organs based on DCNN[J]. Transactions of the Chinese Society of Agricultural Engineering, 2017, 33(15): 219-226.

[12] 王丹丹, 何东健. 基于R-FCN深度卷积神经网络的机器人疏果前苹果目标的识别[J]. 农业工程学报, 2019, 35(3): 156-163.

Wang D D, He D J. Recognition of apple targets before fruits thinning by robot based on R-FCN deep convolution neural network[J]. Transactions of the Chinese Society of Agricultural Engineering, 2019, 35(3): 156-163.

[13] GirshickR, DonahueJ, DarrellT, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]∥Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2014, Columbus, Ohio, USA. New York: IEEE, 2014: 580- 587.

[14] GirshickR. Fast R-CNN[C]∥Proceedings of the 2015 IEEE Conference on Computer Vision, December 11-18, 2015, Santiago, Chile. New York: IEEE, 2015: 1440- 1448.

[15] He K M, Zhang X Y, Ren S Q, et al. Spatial pyramid pooling in deep convolutional networks for visual recognition[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2015, 37(9): 1904-1916.

[16] Ren SQ, He KM, GirshickR, et al. Faster R-CNN: towards real-time object detection with region proposal networks[C]∥Advances in Neural Information Processing Systems (NIPS 2015), December 7-12, 2015, Montreal, Quebec, Canada. Canada: NIPS, 2015: 91- 99.

[17] 王金传, 谭喜成, 王召海, 等. 基于Faster R-CNN深度网络的遥感影像目标识别方法研究[J]. 地球信息科学学报, 2018, 20(10): 1500-1508.

Wang J C, Tan X C, Wang Z H, et al. Faster R-CNN deep learning network based object recognition of remote sensing image[J]. Journal of Geo-Information Science, 2018, 20(10): 1500-1508.

[18] 曹宇剑, 徐国明, 史国川. 基于旋转不变Faster R-CNN的低空装甲目标检测[J]. 激光与光电子学进展, 2018, 55(10): 101501.

[19] 马晓云, 朱丹, 金晨, 等. 基于改进Faster R-CNN的子弹外观缺陷检测[J]. 激光与光电子学进展, 2019, 56(15): 151202.

[20] 陈恩加, 唐向宏, 傅博文. Faster R-CNN行人检测与再识别为一体的行人检索算法[J]. 计算机辅助设计与图形学学报, 2019, 31(2): 332-339.

Chen E J, Tang X H, Fu B W. Pedestrian search method based on Faster R-CNN with the integration of pedestrian detection and re-identification[J]. Journal of Computer-Aided Design & Computer Graphics, 2019, 31(2): 332-339.

[21] 田青, 袁曈阳, 杨丹, 等. 基于暗通道去雾和深度学习的行人检测方法[J]. 激光与光电子学进展, 2018, 55(11): 111007.

[22] 孙哲, 张春龙, 葛鲁镇, 等. 基于Faster R-CNN的田间西兰花幼苗图像检测方法[J]. 农业机械学报, 2019, 50(7): 216-221.

Sun Z, Zhang C L, Ge L Z, et al. Image detection method for broccoli seedlings in field based on Faster R-CNN[J]. Transactions of the Chinese Society for Agricultural Machinery, 2019, 50(7): 216-221.

[23] LiuW, AnguelovD, ErhanD, et al. SSD: single shot MultiBox detector[M] ∥Leibe B, Matas J, Sebe N, et al.Computer vision-ECCV 2016. Lecture notes in computer science. Cham: Springer, 2016, 9905: 21- 37.

[24] 冯小雨, 梅卫, 胡大帅. 基于改进Faster R-CNN的空中目标检测[J]. 光学学报, 2018, 38(6): 0615004.

[25] Lin TY, DollarP, GirshickR, et al. Feature pyramid networks for object detection[C]∥The IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, Hawaii, USA. New York: IEEE, 2017: 2117- 2125.

Article Outline

张乐, 金秀, 傅雷扬, 李绍稳. 基于Faster R-CNN深度网络的油菜田间杂草识别方法[J]. 激光与光电子学进展, 2020, 57(2): 021508. Zhang Le, Jin Xiu, Fu Leiyang, Li Shaowen. Recognition Method for Weeds in Rapeseed Field Based on Faster R-CNN Deep Network[J]. Laser & Optoelectronics Progress, 2020, 57(2): 021508.