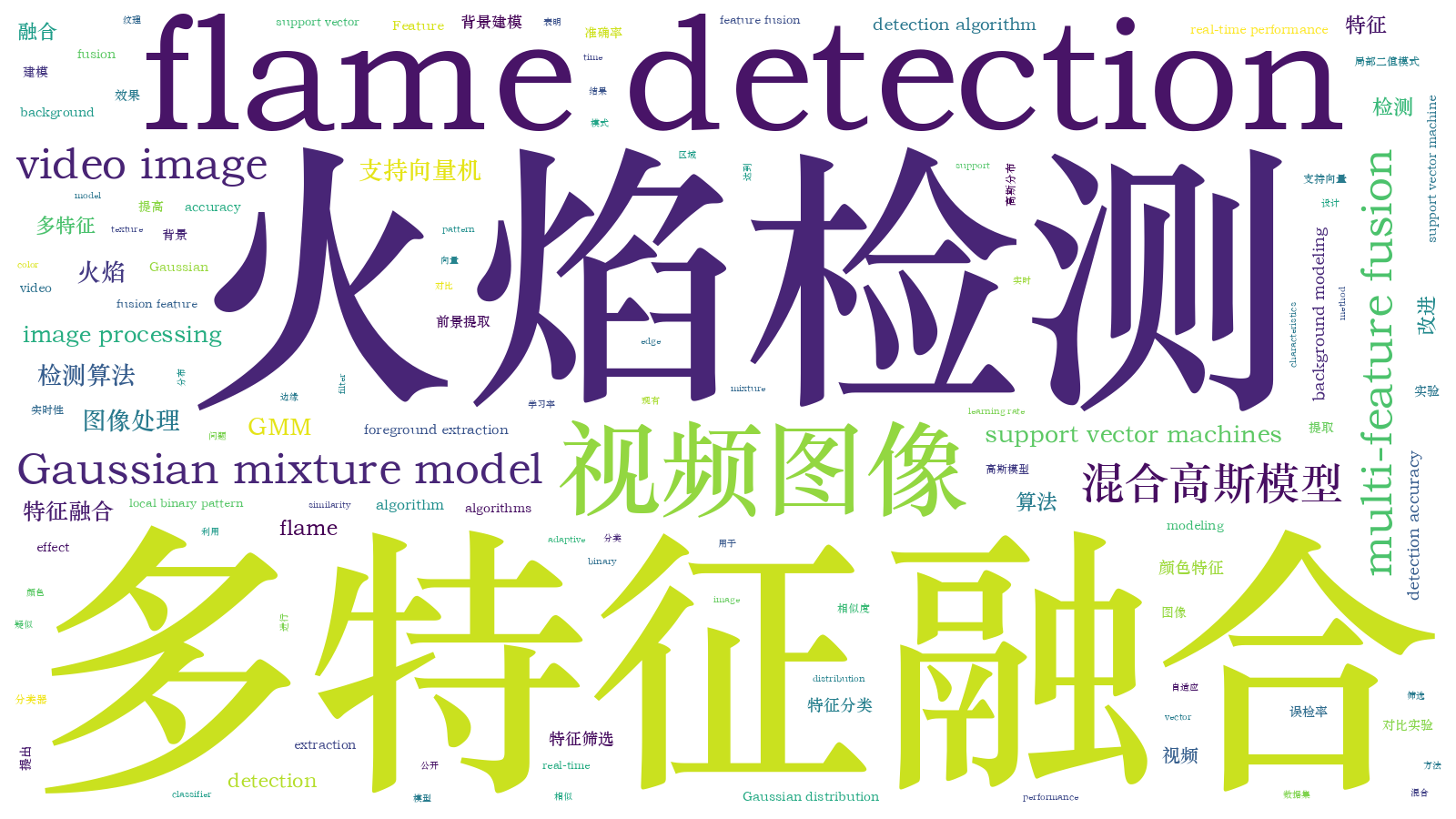

基于改进GMM和多特征融合的视频火焰检测算法  下载: 900次

下载: 900次

1 引言

火灾作为一种破坏力极强的灾害,对社会经济发展和人民生命财产安全构成了严重威胁。国民经济发展的新形势下,随着“智慧消防”建设的推进,公共视频监控发展迅速,诸多火灾高风险区域安装了视频监控[1]。以视频监控为基础的火灾检测,可以克服传统接触式火焰探测器检测范围有限和易受外界干扰等缺点[2]。火灾发生时常伴随火焰和烟雾产生,基于视频的火灾探测方法主要包括火焰和烟雾检测两种形式,火焰检测相较于烟雾有目标可见度高、实时性好和抗干扰性强等优点,成为火灾检测报警的重要研究方向[3]。

基于视频的火焰检测将图像中的火焰部分作为前景进行提取,其他部分作为背景区域。刘立等[4]基于YIQ(Y表示亮度,I和Q代表色彩分量)颜色空间识别火焰,利用火焰颜色和亮度的阈值分割图像获得火焰区域,但是分割效果受设定阈值影响较大,火焰检测准确率较低;邵良杉等[5]提出一种基于Codebook的火焰识别方法,在YUV(Y表示亮度,U和V表示色度)空间利用Codebook模型提取火焰区域,定时更新背景,在复杂场景中取得了较高的识别准确率,但该方法侧重于动态特征提取,需要输入较长的视频序列,算法实时性有待提升,并且基于YUV空间提取的疑似火焰区域存在部分丢失情况,即出现空洞;贾阳等[6]利用改进层次聚类和支持向量机(SVM)识别火焰,根据火焰像素累积结果对火焰进行初步分割,利用改进层次聚类得到疑似火焰区域,减少了算法计算量,但提取到的火焰区域面积偏小,因此增加了特征提取难度,误报率偏高;张丹丹等[7]基于改进YCbCr(Y表示亮度,Cb和Cr表示色彩)和区域生长的多特征融合算法识别火焰,将场景分为反光和非反光区域,避免噪声对分割效果的影响,前景提取精度较高,但没有考虑各特征的优势,只是对同类火焰目标如蜡烛、车灯等进行区分,适用场景有限;唐岩岩等[8]利用混合高斯模型(GMM)提取前景目标,同时对背景和前景建模,提高背景模型的适应性,但该方法采用固定学习率,因此背景模型收敛缓慢,易出现拖影、虚假目标等情况;吴茜茵等[9]提出多特征融合的火焰识别算法,基于改进的颜色特征模型提取疑似火焰区域,融合多种形状结构特征并输入到SVM中进行分类,特征提取较简单,实时性较好,但是没有提取火焰的动态特征,易对部分类火焰目标造成误检。

随着深度学习在计算机视觉领域的广泛应用,基于深度神经网络的火焰识别成为重点研究方向,如Muhammad等[10] 基于SqueezeNet提出了一种火焰识别方法,在ImageNet图像数据集上预训练图像分类网络,而后利用火焰图片数据集进行参数调整。深度学习方法一般需要大量的标注数据,相比于传统特征提取方法,在一定程度上提高了火焰识别率。由于火灾是偶发性事件,难以获得大量标注过的视频数据,缺少通用的火灾视频数据集,因此目前很多深度学习火焰识别方法是基于图像数据进行训练和预测[3],即只利用图像的空间信息而没有利用视频时序信息。

本文针对GMM背景建模存在前景信息丢失、火焰检测准确率低和误检率高等问题,提出一种基于改进GMM和多特征融合的火焰检测算法,给出自适应高斯分布数和学习率的GMM背景建模算法,以增强算法实时性和避免出现“鬼影”等现象,提升背景建模效果;基于SVM融合改进了局部二值模式(LBP)纹理和边缘相似度特征,以改善单一特征不能准确检测火焰区域的问题。

2 改进的GMM背景建模

算法检测流程如

图 1. 基于改进GMM和多特征融合的检测流程图

Fig. 1. Detection flowchart based on improved GMM and multi-feature fusion

2.1 GMM背景建模原理

GMM背景建模将图像中每个像素建模为K个高斯分布,时刻t的观测值是Xt的概率为

式中:K为高斯分布数量(一般取3~5);ωk,t和μk,t分别是t时刻第k个高斯分布的权重和均值。η(Xt,μk,t,Ck,t)表示高斯概率密度函数[13],具体表示为

式中:D表示Xt的维数;Ck,t是t时刻K个高斯分布的协方差。

GMM中K个高斯分布根据ωk,t/σk,t(σk,t是t时刻第k个高斯分布的标准差)按从大到小排序,取前B个高斯分布作为背景模型,B确定方法为

式中:Tth是设定的高斯分布权重阈值,取值影响高斯分布中背景所占比重,当Tth取值较大时,可以提高背景建模抗干扰能力,但同时也加大了运动目标漏检可能性;当Tth取值较小时,可以提高对运动目标提取的灵敏度,但同时降低了抗干扰能力。

处理一帧新的图像时,把每个新观测值Xt+1轮流与K个高斯分布匹配,若对第k个高斯分布有

式中:α为学习率;ρ为参数更新速率。如果观测值Xt+1与K个高斯分布都不匹配,则用一个新的均值为Xt+1、低权重和高方差的高斯分布替代末尾高斯分布[15]。

2.2 自适应高斯分布数

在GMM背景建模过程中,与观测值匹配的高斯分布权重逐渐增大,不匹配的高斯分布随着权重减小逐渐落入前景部分,当某个高斯分布权重ωk,t小于初始权重ωinit,ωk,t/σk,t小于初始ωinit/σinit时,经过排序,此高斯分布会排到序列尾部(对背景建模贡献较小);后续若新一帧观测值与此高斯分布匹配,则更新该高斯分布参数消耗的时间比生成一个与观测值对应的新高斯分布更长,这些小权重高斯分布对计算资源造成浪费,在背景建模时应当删除。由此本文提出一种自适应选择高斯分布数量的算法,用较少的高斯分布表示观测值,以减少背景建模的计算量。具体算法步骤如下。

1) 对于初始观测值X1,用相同参数初始化Nu个高斯分布,

式中:Nu表示模型参数已更新的高斯分布数量,初始化时取1;μk,1、σk,1和ωk,1分别表示根据观测值X1初始化第k个高斯分布的均值、标准差和权重,k=1,2,…,K,K为Nu的上限。

2) 新观测值Xt轮流与Nu个高斯分布匹配,若该观测值与第k个高斯分布匹配,则根据(4)~(8)式更新对应高斯分布参数,按照ωk,t/σk,t从大到小排序。

若新观测值与序列中所有高斯分布都不匹配,则生成一个新高斯分布,当Nu<K时,其参数设置为

式中:λ为平衡系数(0<λ<1),目的是将新高斯分布的方差和权重控制在较合理范围内;ωave和

当Nu达到上限K时(Nu=K),不立即替换末尾高斯分布,而是当新的高斯分布权重大于某一阈值Tw时才替换,替换之前,该新高斯分布按(4)~(8)式更新,为了能够有效替换末尾高斯分布,应尽量避免前景和背景信息丢失以及提高抗噪能力,新高斯分布权重更新取值应逐渐增大,设新高斯分布的权重更新方程(4)式中Mk,t+1恒为1,新高斯分布的学习率αnew公式为

式中:Ccons是常数;q是高斯分布被观测值匹配的次数,匹配次数增多,权重提升较慢。当新高斯分布权重大于阈值Tw时,替换末尾高斯分布,权重归一化后,q置零。

3) 对视频前F帧图像学习后,按照ωk,t/σk,t排序,将排在尾部的高斯分布的权重与其前一个高斯分布的权重相减,如果差值的绝对值小于阈值M,并且视频序列中连续P帧此末尾高斯分布都没有被匹配,则删除末尾高斯分布,重复该步骤,直至完成。

4) 高斯分布权重归一化,表示为

为验证改进GMM的建模效果,选取三段视频进行对比实验,视频序列大小是720 pixel×480 pixel,如

图 2. 火焰视频序列截取帧。(a)室内火焰;(b)室外火焰;(c)森林火焰

Fig. 2. Frame capture of flame video sequence. (a) Indoor flame; (b) outdoor flame; (c) forest flame

表 1. 算法处理速度对比

Table 1. Comparison of algorithm processing speed unit: ms/frame

|

2.3 自适应学习率

视频中环境复杂,天气以及行人都易造成场景变化,GMM背景建模对突发运动、光照突变和噪声等干扰较敏感。传统GMM算法的学习率α值固定,当背景模型在目标环境下发生变化时,难以适应运动目标位置变化,不能精确建模前景和背景。当学习率α设定较大时,背景快速收敛,因此间歇停顿或运动缓慢的目标易更新为背景,导致模型鲁棒性变差;当学习率设定较小时,当前像素点观测值匹配的高斯分布参数更新速率小,使得场景不稳定,背景更新速率变慢,增加了背景建模时间,甚至出现“鬼影”现象。由此,本文提出自适应学习率方法,代表前景和背景的高斯分布采用不同的学习率进行参数更新,背景部分的学习率相对较高,前景部分的学习率相对较低。

具体方法如下:GMM背景建模时,通过对前F帧图像的学习(固定学习率αF=0.006),表示背景的高斯分布学习率较大,较大学习率有利于加速背景建模,在t时刻当原运动前景区域像素观测值匹配第i个高斯分布时,学习率αt按下式更新。

式中:ωi为匹配的高斯分布权重(0<ωi<1);α0和β为常数(本文中α0=0.00001,β=0.01)。(15)式主要通过ωi·β项实现自适应学习率,通常情况下ωi·β比α0大,表示背景的高斯分布有着较大权重,当观测值匹配的高斯分布权重ωi较大时,该高斯分布倾向于表示背景部分,ωi·β项较大,此时较大的学习率有利于加速背景建模,以适应光照、突变运动等情况;当观测值匹配的高斯分布权重ωi较小时,该高斯分布倾向于表示前景部分,ωi·β较小,此时较小的学习率有利于减慢模型收敛速度,以提高抗干扰能力和增强模型鲁棒性。如果匹配的高斯分布权重太小,ωi·β项过小(接近0),则导致静止下来的运动目标难以更新到背景模型,引入学习率下限α0能够避免出现极小学习率,改善背景建模的“鬼影”问题。

在相同测试平台下,选取视频进行背景建模实验。

图 3. 原图以及前景提取图。(a)(b)原图;(c)(d)传统GMM前景提取图;(e)(f)改进GMM前景提取图

Fig. 3. Original and foreground renderings.(a)(b) Original image; (c)(d) traditional GMM foreground extraction map; (e)(f) improved GMM foreground extraction map

从

表 2. 虚警数比较

Table 2. Comparison of false alarms

|

表 3. 漏检数比较

Table 3. Comparison of missed inspections

|

从

3 火焰特征提取与识别

通过GMM背景建模后,获得运动目标区域,在实际火焰检测过程中,仅通过运动目标检测无法将一些类火运动目标如夕阳、车灯和蜡烛等与火焰目标区分开,为了区分火焰和类火运动目标,结合火焰颜色、纹理特性以及形状特性作为火焰检测的依据以获得较好的识别准确率,充分考虑了各特征之间的优势以及视频图像原有特性,能够有效地实现特征互补。

特征流程图如

3.1 颜色特征

颜色是火焰最直观的静态特征,利用颜色模型可以排除部分汽车、行人等运动物体的干扰。在红绿蓝(RGB)颜色模型中,火焰颜色在红黄之间相对集中,并且红色分量占比较大;在色调、饱和度、亮度(HSI)颜色模型中,则表现为红色分量的饱和度较大[16],本文采用文献[ 17]提出的如下火焰颜色规则来检测疑似火焰区域。

该颜色规则将RGB和HSI两种颜色空间的规则融合,其中RT和ST分别为红色分量和饱和度阈值,当像素点都满足上述规则时,则判定该点是火焰像素点,否则,为非火焰像素点。经过颜色模型加权检测,可以排除非火焰运动物体的干扰,如

3.2 纹理特征

纹理特征主要反映图像局部区域像素灰度值的变化情况,能较好描述物体表面局部的粗糙度特性。某些类火目标(如燃烧的蜡烛等)具有和火焰目标类似的形状和颜色,但在纹理特征上有明显区分度,因此可用纹理特征区分火焰和类火目标。

多数纹理特征描述方法(如灰度共生矩阵等)易受到光照、旋转等因素影响。LBP算法是关于图像局部纹理特征的一种描述方法,其优点是具有灰度不变性和旋转不变性,受光照、旋转等因素的影响较小。LBP原理是在一个给定图像的窗口内,以窗口中心像素为阈值,比较中心像素与邻域像素之间的灰度值,若邻域内像素灰度值大于等于中心像素灰度值,则邻域像素值设置为1,否则设置为0,从而可以得到一个二进制序列(位数与窗口大小有关,即LBP码),将该值设为中心像素点的LBP码,用于反映该区域的纹理信息[18]。

Ojala等[19]定义了旋转不变均匀模式LBP来改进LBP特征,在准确反映图像纹理信息的基础上,减小了计算量,同时使特征具有旋转不变性,记为LBPriu。相应计算方法为

式中:s(x)=

为了验证LBPriu提取特征的有效性,统计火焰以及类火目标(摇晃的蜡烛和墙壁)等框内各点LBPriu直方图。

如

图 5. 原图和LBP直方图。(a)(b)火焰图像;(c)(d)类火图像;(e)对(a)提取的直方图;(f)对(b)提取的直方图;(g)对(c)提取的直方图;(h)对(d)提取的直方图

Fig. 5. Original images and LBP histograms. (a)(b) Flame images; (c)(d) fire-like images; (e) histogram extracted from Fig. (a); (f) histogram extracted from Fig. (b); (g) histogram of extracted from Fig. (c); (h) histogram of extracted from Fig. (d)

3.3 边缘相似度特征

火焰燃烧时边缘呈现无规则变化,而相邻帧之间前景区域的面积变化,但整体轮廓边缘相似。边缘相似度特征可以用于区分火焰和车灯、夕阳等类火目标。视频序列中,Ek表示第k帧图像的前景边缘,定义第c帧和第k帧图像前景(假定提取到单一前景区域,多前景区域分别计算)边缘相似度计算公式为

式中:(x,y)表示像素坐标;Ω为图像区域。将视频中某前景区域连续n帧图像的平均边缘相似度特征作为该前景区域的边缘相似度特征,计算公式为

为了验证边缘相似度特征的有效性,选取5段分别含有火焰、路灯、夕阳、闪烁的车灯和摇晃的蜡烛等目标视频进行相似度特征提取实验,连续选取视频中的8帧图像,得到7个相似度值,计算的平均相似度如

表 4. 目标相似度比较

Table 4. Target similarity comparison

|

由

4 实验结果及分析

为了验证本文算法的效果,在相同数据集上与其他文献火焰检测算法(如文献[ 6,9,5])进行火焰检测对比实验。

本文火焰检测实验使用的视频数据来自韩国启明大学CVPR实验室[20]、土耳其比尔肯大学SPG工作组[21]和美国NIST火灾研究实验室[22]等数据集,同时包括部分从网上获取的视频数据,包括火焰视频39段(9764 frame)、干扰视频12段(1825 frame),视频中包含室内、室外不同背景下亮度有差别、形状不同的火焰以及蜡烛、车灯、行人和广告牌等干扰目标。

从视频中疑似火焰区域提取颜色、改进LBP纹理和边缘相似度特征,首先通过颜色特征排除部分类火运动目标的干扰,串联融合改进LBP纹理和边缘相似度特征,构成11维向量X=[H1,H2,…,H10,Esim],作为SVM的输入特征向量进行火焰分类,选择径向基核函数,惩罚因子和核参数选取通过K折交叉验证法获得,最终取C=7.2318,ρ=0.0817。从视频中选取800 frame样本,其中训练集480 frame,包含260 frame火焰样本,220 frame非火焰样本;测试集320 frame,包含180 frame火焰样本,140 frame非火焰样本。

表 6. 非火视频检测结果对比

Table 6. Comparison of non-fire video detection results

| |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

表 5. 火焰视频检测结果对比

Table 5. Comparison of flame video detection results

| |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

为了评价本文火焰检测算法的整体性能,选取多个视频进行验证,部分视频样本如

图 6. 实验视频。(a)室外火焰;(b)室内火焰;(c)森林火焰;(d)走动行人;(e)闪烁的车灯;(f)闪烁的霓虹灯

Fig. 6. Experimental videos. (a) Outdoor flame; (b) indoor flame; (c) forest flame; (d) walking pedestrians; (e) flashing car lights; (f) flashing neon lights

对比算法包括文献[

6]改进层次聚类的视频火焰识别算法、文献[

9]多特征融合的火焰识别算法和文献[

5]Codebook的视频火焰识别算法,选取6段典型视频的识别结果进行对比,如

文献[

6]利用改进层次聚类提取疑似区域,然后融合红绿分量比、面积变化率、平均亮度、相邻帧间相关性和质心偏移距离作为特征向量输入SVM进行分类,对于视频中只包含唯一火焰区域并且火焰燃烧稳定的场景[

本文算法基于改进GMM获得提取运动前景区域,利用颜色特征筛选出疑似火焰目标区域;分别提取目标区域的旋转均匀LBP特征(表征纹理的静态特征)和边缘相似度特征(表征轮廓变化的动态特征)并进行串联融合,融合后的特征具有旋转不变性和灰度不变性,利用训练数据集进行参数调优,获得了较好的特征表达和识别能力,能够较准确地识别火焰区域以及排除类火目标。对比实验中,本文算法对火焰视频的平均识别率为92.26%,高于对比算法;对非火焰视频的平均误检率为2.43%,低于对比算法,即本文算法在火焰识别率和非火焰误检率上都取得较好效果。

5 结论

本文围绕视频火焰检测的问题,提出了改进的GMM和多特征融合的视频火焰检测算法。针对传统火焰前景提取方法运算时间过长、易出现“鬼影”等问题,提出改进GMM背景建模算法,采用自适应高斯分布数和学习率的方法,提升了算法实时性和背景建模效果。针对单一特征无法准确检测出火焰且误检率高等问题,对火焰区域提取颜色、LBP纹理和边缘相似度等特征,有效排除不同特点的类火运动目标干扰,既保持了颜色特征对于火焰色彩变化的敏感性,又具有LBP特征的灰度不变性、旋转不变性和相似度特征对处理轮廓相似区域的有效性。实验结果表明,本文算法有较高检测准确率,同时误检率较低。

[1] 王英. 全力维护火灾形势稳定: 新中国成立70年火灾防控综述[J]. 中国消防, 2019( 10): 28- 31.

WangY. Full efforts to maintain the stability of the fire situation: a summary of fire prevention and control in the 70 years since the founding of new China[J]. China Fire, 2019( 10): 28- 31.

[2] 谭勇, 谢林柏, 冯宏伟, 等. 基于图像的火焰检测算法[J]. 激光与光电子学进展, 2019, 56(16): 161012.

[3] 曹江涛, 秦跃雁, 姬晓飞. 基于视频的火焰检测算法综述[J]. 数据采集与处理, 2020, 35(1): 35-52.

[4] 刘立, 曾花. 基于YIQ颜色空间的火焰轮廓提取算法[J]. 南华大学学报(自然科学版), 2016, 30(2): 72-77, 82.

[5] 邵良杉, 郭雅婵. 基于Codebook的视频火焰识别算法[J]. 计算机应用, 2015, 35(5): 1483-1487.

Shao L S, Guo Y C. Flame recognition algorithm based on Codebook in video[J]. Journal of Computer Applications, 2015, 35(5): 1483-1487.

[6] 贾阳, 王慧琴, 胡燕, 等. 基于改进层次聚类和SVM的图像型火焰识别[J]. 计算机工程与应用, 2014, 50(5): 165-168, 194.

Jia Y, Wang H Q, Hu Y, et al. Flame detection algorithm based on improved hierarchical cluster and support vector machines[J]. Computer Engineering and Applications, 2014, 50(5): 165-168, 194.

[7] 张丹丹, 章光, 陈西江, 等. 改进YCbCr和区域生长的多特征融合的火焰精准识别算法[J]. 激光与光电子学进展, 2020, 57(6): 061022.

[8] 唐岩岩, 严云洋, 刘以安. 应用GMM的快速火焰检测[J]. 计算机科学, 2012, 39(11): 283-285, 297.

Tang Y Y, Yan Y Y, Liu Y A. Fast flame detection with GMM[J]. Computer Science, 2012, 39(11): 283-285, 297.

[9] 吴茜茵, 严云洋, 杜静, 等. 多特征融合的火焰检测算法[J]. 智能系统学报, 2015, 10(2): 240-247.

[12] Sun Y D, Yuan B Z. Hierarchical GMM to handle sharp changes in moving object detection[J]. Electronics Letters, 2004, 40(13): 801-802.

[13] Qi YJ, LiH, Wang YJ, et al.Spinning tri-layer-circle memory-based Gaussian mixture model for background modeling[C]∥2016 IEEE 13th International Conference on Signal Processing (ICSP), November 6-10, 2016, Chengdu, China.New York: IEEE Press, 2016: 943- 948.

[14] Xie XX, Huang WZ, Wang HH, et al.Image de-noising algorithm based on Gaussian mixture model and adaptive threshold modeling[C]∥2017 International Conference on Inventive Computing and Informatics (ICICI), November 23-24, 2017, Coimbatore, India.New York: IEEE Press, 2017: 226- 229.

[15] Pietikainen M. Heikkila M A. texture-based method for modeling the background and detecting moving objects[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2006, 28(4): 657-662.

[16] 孙琛. 基于视频图像的火灾检测算法研究与设计[D]. 济南: 山东大学, 2018.

SunC. Research and design of fire detection algorithm based on video image[D]. Jinan: Shandong University, 2018.

[17] Chen TH, Wu PH, Chiou YC. An early fire-detection method based on image processing[C]∥Image Processing, 2004. ICIP'04. 2004 International Conference on. IEEE, 2004: 1707- 1710.

[18] 刘晓悦, 王云明, 马伟宁. 融合FHOG和LBP特征的尺度自适应相关滤波跟踪算法[J]. 激光与光电子学进展, 2020, 57(4): 041512.

[19] Ojala T, Pietikainen M, Maenpaa T. Multiresolution gray-scale and rotation invariant texture classification with local binary patterns[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2002, 24(7): 971-987.

[20] CVPR Lab. KeimyungUniversity, Korea [EB/OL]. [2019-01-05].https:∥cvpr.kmu.ac.kr/.

[21] Bilkent E E signal processing group [EB/OL]. [2019-01-05].http:∥signal.cc.bilkent,edu.tr/VisiFire/.

[22] NIST. NIST fire research laboratory [EB/OL].[2019-01-05]. http:∥www.nist.gov/video-category/fire.

Article Outline

张驰, 孟庆浩, 井涛. 基于改进GMM和多特征融合的视频火焰检测算法[J]. 激光与光电子学进展, 2021, 58(4): 0410006. Chi Zhang, Qinghao Meng, Tao Jing. Video Flame Detection Algorithm Based on Improved GMM and Multi-Feature Fusion[J]. Laser & Optoelectronics Progress, 2021, 58(4): 0410006.