基于生成对抗网络的多模态图像融合  下载: 2227次

下载: 2227次

1 引言

多波段/多模态成像系统在**、医疗、工业检测等领域已有广泛应用,图像融合是这些系统实现高精度智能探测的关键技术之一,其目的是将同一场景的多幅图像或序列图像合成一幅信息更完整、更全面的图像[1]。

目前的图像融合方法大致可分为两大类:基于模型驱动的传统融合法[2-9],如基于非下采样剪切波变换(NSST)融合法[7]、基于稀疏表示融合法[8]、导向滤波融合法[9]等;基于数据驱动的神经网络融合法[10-14],如基于卷积神经网络的图像融合法[11]、基于编码和解码网络的图像融合法[12]等。基于模型驱动的传统融合法首先对源图像进行分解,再选用合适的融合规则对分解后的子图像进行融合,最后将子图像重构获得最终融合图像。此类方法依赖先验知识选取具有针对性的分解方法和融合规则,并需人工设定模型参数,具有很大的局限性。神经网络具有强大的特征提取和数据表示能力[10],因此,新近有研究探索了基于数据驱动的神经网络融合法,相比传统融合法,其更具优越性。文献[ 11]中将卷积神经网络(CNNs)用于图像融合,使用包含源图像不同模糊程度的图像块来训练网络并获得决策图,最后通过决策图和源图像组合获得融合图像。此方法首次将CNNs用于图像融合,实现了活动水平测量和融合规则的统一,但仅适用于多聚焦图像融合,且因仅使用CNNs最后层计算的结果,丢失了中间层获得的许多有用信息,当网络加深时,信息丢失更加严重。文献[ 13]中提出一种更深的网络结构和多层深度特征图像融合方法,首先利用导向滤波对源图像进行高低频分解,通过加权平均融合规则获取低频融合子图像,然后利用VGG-19网络提取高频细节的多层特征,通过取大规则获得高频融合子图像,最后重构融合图像。该方法仍需使用传统方法进行图像分解,虽然利用了VGG-19网络的中间层特征,但多个中间层特征组合策略过于简单,仍然丢失了许多有用的信息。同时,以上基于深度学习的融合法均只针对双波段/模态图像融合,不能满足多波段/模态探测的需要。

针对以上问题,本文提出了一种新的神经网络架构,并用于多波段/模态图像融合,该网络由生成网络和判别网络组成。生成网络由残差块和卷积层构成,用于提取多波段源图像特征。由于残差块的结构特性,深层特征已包含多层信息,因此本文只使用最后一层生成融合图像。判别网络通过与生成网络的对抗学习提升融合图像质量。主要创新点有:1)图像特征提取和融合一并通过网络学习实现,活动水平的测量和融合规则的统一均未经人为设定,减少了对先验知识的依赖,减小了融合策略选择的不确定性;2)使用生成对抗网络框架(GANs)同步融合三波段图像,获得更清晰、更真实的数据,真正实现了端到端融合。

2 相关工作

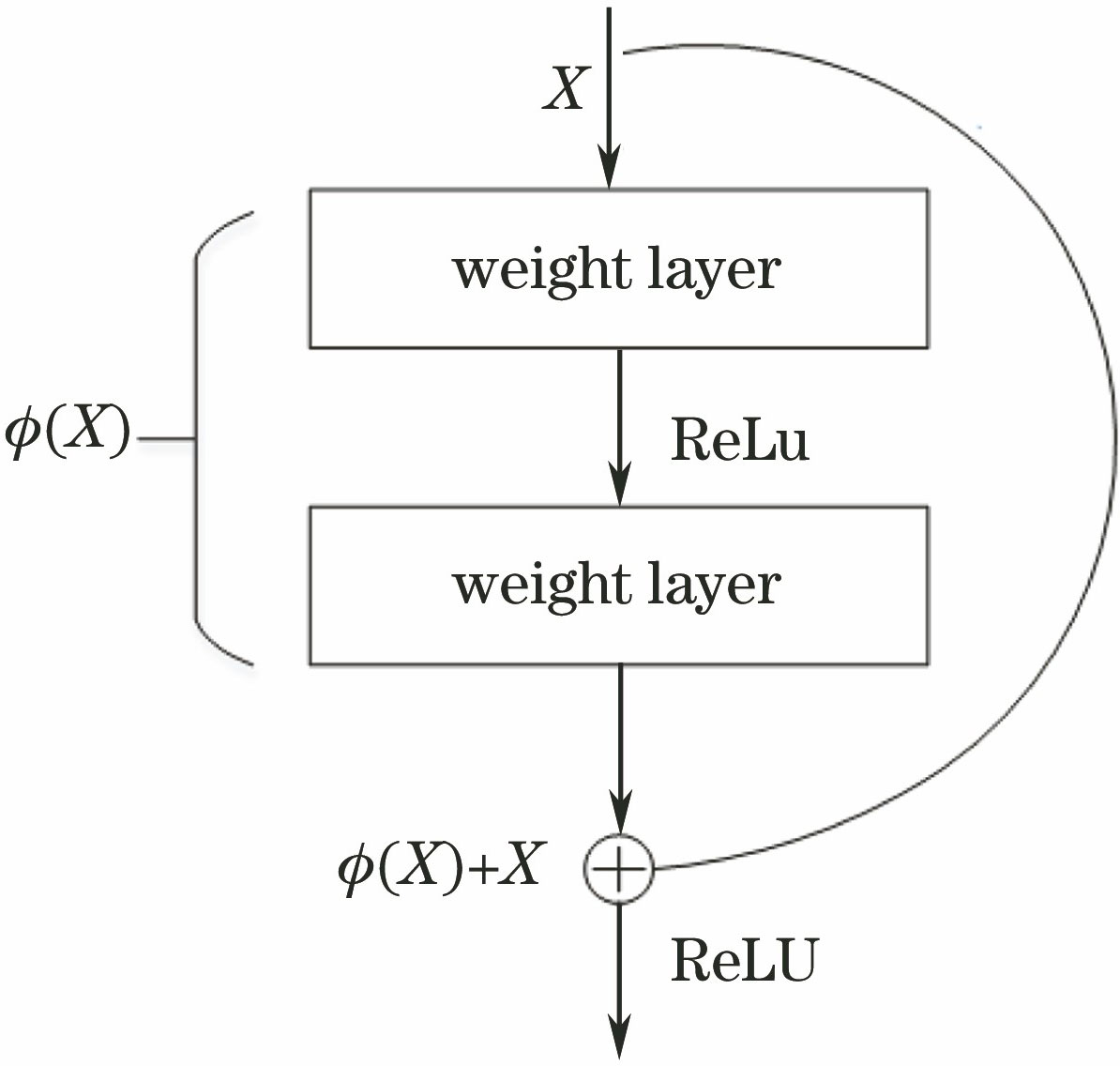

2.1 深度残差网络 (ResNet)

在2016年的计算机视觉和模式识别国际会议(CVPR)中,He等[15]提出了一种新颖的网络架构来解决网络退化问题。以捷径方式连接和残差表示,网络比以前更容易优化;通过增加深度,网络精度亦得到提高。残差块体系结构如

2.2 生成对抗网络(GANs)

2014年,Goodfellow等[19]首次提出GANs概念,其基于对抗思想,提供了一种有效方式来估计目标分布,并生成新的样本。GANs包括生成器和判别器两个模型:生成器用

实现生成功能,式中:

3 基于GANs的图像融合方法

3.1 方法框架

本文方法框架如

3.2 GANs生成模型的构建

本文使用的基于残差块的卷积神经网络如

表 1. 生成器参数

Table 1. Parameters of generator

|

3.3 GANs判别模型的构建

本文使用的判别网络结构如

表 2. 判别器参数

Table 2. Parameters of discriminator

|

3.4 GANs损失函数的构建

使用损失函数来衡量网络输出和数据标签之间的差距。其中,最简单的是使用均方误差损失,虽然有一定的效果,但其不能智能地学习目标细节,故生成的图片稍放大后即变模糊。为此,引入梯度损失优化图像边缘,再加入GAN对抗损失。为明确梯度损失对图像的影响,这里设置权重来提高融合图像质量。

1)均方误差(MSE)损失

MSE损失[25]通过网络训练过程中输出的预测值与真实数据之间的差值促进多尺度图像内容的一致性,计算公式为

式中:

2)梯度损失

梯度是描述图像边缘信息的主要指标之一。由于训练集中图像尺度较小且边缘不清晰,故引入梯度损失来优化边缘,具体实现方法如下。

式中:

3)对抗损失

将对抗损失[19]加入到感知损失中,鼓励生成器适应真实数据的分布,计算公式为

式中:

4)联合损失函数

生成器最终的损失函数是以上3项损失之和,即

对结果施加L2正则化[26],即在原来损失函数的基础上加上权重参数的平方和,用以约束要优化的参数,防止模型过拟合。

4 分析与讨论

4.1 数据集制作

本文GANs网络的数据集有14000张图像,多波段图像来自公开TNO图像融合数据集[27],包含可见光(390~700 nm)、近红外(700~1000 nm)和红外长波(8~12 μm)。医学图像来自哈佛医学院的Neuroimaging Primer。标签图像制作方法如下:将配准好的多模态图像用128×128的滑动窗口以步长14划分成子块,使用基于拉普拉斯金字塔(LP)、离散小波变换(DWT)、非下采样轮廓波变换(NSCT)、NSST传统融合法进行融合,融合规则统一使用“高频梯度取大,低频加权平均”[28]。这时每组多模态子图像均会有多个融合图像,使用包含基于统计特性的评价指标——标准差(SD)、平均梯度(AG)、对比度(Con)、相关系数(CC),基于信息量的评价指标——信息熵(IE)、互信息(MI),以及表示人类视觉感知的视觉信息保真度(VIFF)等多种质量评价指标对融合图像进行评价[29],选取融合效果最好的图像作为最终标签。

从14000张标签图像中随机选取第50张进行可视化展示,如

图 5. 标签图像预选图。(a)红外长波;(b)红外短波;(c)可见光;(d) LP;(e) DWT;(f) NSCT;(g) NSST

Fig. 5. Pre-selection maps of label images. (a) Longwave infrared; (b) shortwave infrared; (c) visible light; (d) LP; (e) DWT; (f) NSCT; (g) NSST

表 3. 标签图像选取依据表

Table 3. Label image selection table

|

4.2 训练参数设置

1) 学习率选取

学习率是衡量网络梯度下降快慢的因子,合适的学习率能使网络快速收敛,减少训练时间。但学习率过大时会出现振荡现象,使网络无法收敛;过小时,网络迭代更新速度慢,训练速度降低。不同学习率对损失函数的影响如

2)

借鉴文献[

22]及文献[

25]实验成果,分别设置梯度损失的权重

图 8. λ取值对图像质量的影响。(a) λ=0 ;(b) λ=0.01;(c) λ=0.1;(d) λ=1

Fig. 8. Effect of different λ on image quality. (a) λ=0; (b) λ=0.01; (c) λ=0.1; (d) λ=1

图 10. λ取值对融合图像客观评价指标的影响。(a)第1组融合图像;(b)第2组融合图像;(c)第3组融合图像

Fig. 10. Effect of λ on objective evaluation index of fused image. (a) The first set of fused images; (b) the second set of fused images; (c) the third set of fused images

4.3 融合结果分析

本实验的硬件平台为NVIDIA英伟达TeslaM40服务器,Matlab版本为R2016a,Python版本为3.6.3。

图 11. 图像融合结果。(a)红外长波;(b)红外短波;(c) 可见光;(d) DTCWT_SR;(e) NSST_NSCT;(f) CNN;(g) CSR;(h)本文方法

Fig. 11. Image fusion results. (a) Longwave infrared; (b) shortwave infrared; (c) visible light; (d) DTCWT_SR; (e) NSST_NSCT; (f) CNN; (g) CSR; (h) proposed method

由于多尺度变换融合方法有很多,各有优劣,这里选择文献中认为效果超过单一多尺度变换方法的混合式融合方法及其他深度学习方法进行比较[4,11,14],包括基于双树复小波变换和稀疏结合的DTCWT_SR方法、基于NSST与NSCT结合的NSST_NSCT,以及基于CNNs的CNN方法、基于卷积稀疏表示的卷积稀疏表示(CSR)神经网络方法。

观察实验结果可知,DTCWT_SR和CNN方法得到的图像目标更突出,但有明显失真现象,且边缘较模糊;CSR方法得到的图像整体偏暗,对比度较低,不利于人眼观察;NSST_NSCT方法得到的图像虽然细节较丰富,但图像中热目标出现伪影;本文方法得到的图像整体更为干净,边缘清晰且没有伪影。为使对比结果更便于观察,将有代表性的部分进行了放大,如图中红框所示。相比之下,本文方法得到的图像中船身轮廓、房屋和树桩边缘,以及草丛纹理等细节信息都较为丰富,且图像清晰。同时,本文方法得到的医学图像中包含的细节纹理特征也更丰富。

由于人的视觉感知存在差异,故采用客观评价指标对融合结果进行评价(

表 4. 融合结果评价指标比较

Table 4. Comparison of evaluation index of fusion results

|

可以看出,在7项评价指标中,本文方法在第3组和第8组图像上有6项指标优于其他方法;在其余图像上也有4~5项指标优于其他方法。总体来说,本文方法在梯度、相关系数、信息熵、互信息、人眼视觉特性这些客观指标上较其他方法均有较大改观,体现出更好的综合性能。

5 结论

提出了一种基于生成对抗网络的多波段/多模态图像融合方法,实现了端到端的自适应图像融合。研究结果表明:利用深度残差块替代传统GANs模型的卷积操作,可以提升图像信息的传递能力;利用传统的模型驱动法可以缓解深度学习中缺乏标签数据的问题。在GANs网络训练过程中,除了传统的对抗损失外,还引入了基于像素的MSE损失和图像梯度损失,使网络训练更稳定。与目前效果突出的几种方法相比,本文方法获得的图像整体更干净,边缘强度更大,且包含更多的细节信息。需要指出的是,由于标签是选用融合效果较好的图像进行分块得到的,因此标签图像的质量限制了融合结果的质量,下一步将重点改进此问题。

[1] Ma J Y, Ma Y, Li C. Infrared and visible image fusion methods and applications:a survey[J]. Information Fusion, 2019, 45: 153-178.

[2] Ranchin T, Wald L. The wavelet transform for the analysis of remotely sensed images[J]. International Journal of Remote Sensing, 1993, 14(3): 615-619.

[3] KingsburyN. A dual-tree complex wavelet transform with improved orthogonality and symmetry properties[C]∥Proceedings 2000 International Conference on Image Processing (Cat. No.00CH37101), September 10-13, 2000, Vancouver, BC, Canada. New York: IEEE, 2000: 375- 378.

[4] Liu Y, Liu S P, Wang Z F. A general framework for image fusion based on multi-scale transform and sparse representation[J]. Information Fusion, 2015, 24: 147-164.

[5] 易维, 曾湧, 原征. 基于NSCT变换的高分三号SAR与光学图像融合[J]. 光学学报, 2018, 38(11): 1110002.

[7] 丁文杉, 毕笃彦, 何林远, 等. 基于剪切波变换和邻域结构特征的红外与可见光图像融合[J]. 光学学报, 2017, 37(10): 1010002.

[8] Zhang Q, Liu Y, Blum R S, et al. Sparse representation based multi-sensor image fusion for multi-focus and multi-modality images: a review[J]. Information Fusion, 2018, 40: 57-75.

[9] 朱达荣, 许露, 汪方斌, 等. 基于快速有限剪切波变换与引导滤波的多聚焦图像融合算法[J]. 激光与光电子学进展, 2018, 55(1): 011001.

[10] Liu Y, Chen X, Wang Z F, et al. Deep learning for pixel-level image fusion: recent advances and future prospects[J]. Information Fusion, 2018, 42: 158-173.

[11] Liu Y, Chen X, Peng H, et al. Multi-focus image fusion with a deep convolutional neural network[J]. Information Fusion, 2017, 36: 191-207.

[12] 蔺素珍, 韩泽. 基于深度堆叠卷积神经网络的图像融合[J]. 计算机学报, 2017, 40(11): 2506-2518.

Lin S Z, Han Z. Images fusion based on deep stack convolutional neural network[J]. Chinese Journal of Computers, 2017, 40(11): 2506-2518.

[13] LiH, Wu XJ, KittlerJ. Infrared and visible image fusion using a deep learning framework[C]∥2018 24th International Conference on Pattern Recognition (ICPR), August 20-24, 2018, Beijing, China. New York: IEEE, 2018: 2705- 2710.

[14] Liu Y, Chen X, Ward R K, et al. Image fusion with convolutional sparse representation[J]. IEEE Signal Processing Letters, 2016, 23(12): 1882-1886.

[15] He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 770- 778.

[16] Jiang X H, Pang Y W, Li X L, et al. Deep neural networks with elastic rectified linear units for object recognition[J]. Neurocomputing, 2018, 275: 1132-1139.

[17] Cai J R, Gu S H, Zhang L. Learning a deep single image contrast enhancer from multi-exposure images[J]. IEEE Transactions on Image Processing, 2018, 27(4): 2049-2062.

[18] ZhangH, DanaK. Multi-style generative network for real-time transfer[M] ∥Leal-Taixé L, Roth S.Computer Vision-ECCV 2018 Workshops. Lecture notes in computer science. Cham: Springer, 2019, 11132: 349- 365.

[19] Goodfellow IJ, Pouget-AbadieJ, MirzaM, et al.Generative adversarial nets[C]∥Proceeding NIPS'14 Proceedings of the 27th International Conference on Neural Information Processing Systems, December 08-13, 2014, Montreal, Canada.Cambridge: MIT Press, 2014, 2: 2672- 2680.

[20] RadfordA, MetzL, Chintala S. Unsupervised representation learning with deep convolutional generative adversarial networls[J/OL]. ( 2016-01-07)[2018-12-25]. https:∥arxiv.org/abs/1511. 06434.

[21] Mao XD, LiQ, Xie HR, et al. Least squares generative adversarial networks[C]∥2017 IEEE International Conference on Computer Vision (ICCV), October 22-29, 2017, Venice, Italy. New York: IEEE, 2017: 2813- 2821.

[22] LedigC, TheisL, HuszárF, et al. Photo-realistic single image super-resolution using a generative adversarial network[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu,HI, USA. New York: IEEE, 2017: 105- 114.

[23] Li Y, Wang N, Shi J, et al. Adaptive Batch Normalization for practical domain adaptation[J]. Pattern Recognition, 2016, 80: 109-117.

[24] Wang S H, Phillips P, Sui Y X, et al. Classification of alzheimer's disease based on eight-layer convolutional neural network with leaky rectified linear unit and max pooling[J]. Journal of Medical Systems, 2018, 42(5): 85.

[25] HuangR, ZhangS, Li TY, et al. Beyond face rotation: global and local perception GAN for photorealistic and identity preserving frontal view synthesis[C]∥2017 IEEE International Conference on Computer Vision (ICCV), October 22-29, 2017, Venice, Italy. New York: IEEE, 2017: 2458- 2467.

[26] Shi J G, Liu X, Zong Y, et al. Hallucinating face image by regularization models in high-resolution feature space[J]. IEEE Transactions on Image Processing, 2018, 27(6): 2980-2995.

[27] Toet A. The TNO multiband image data collection[J]. Data in Brief, 2017, 15: 249-251.

[28] 黄福升. 多波段图像多尺度变换融合方法比较[D]. 太原: 中北大学, 2018.

Huang FS. Comparision of multiscale transform fusion methods for multiband image[D]. Taiyuan: The North University of China, 2018.

[29] Jagalingam P, Hegde A V. A review of quality metrics for fused image[J]. Aquatic Procedia, 2015, 4: 133-142.

Article Outline

杨晓莉, 蔺素珍, 禄晓飞, 王丽芳, 李大威, 王斌. 基于生成对抗网络的多模态图像融合[J]. 激光与光电子学进展, 2019, 56(16): 161004. Xiaoli Yang, Suzhen Lin, Xiaofei Lu, Lifang Wang, Dawei Li, Bin Wang. Multimodal Image Fusion Based on Generative Adversarial Networks[J]. Laser & Optoelectronics Progress, 2019, 56(16): 161004.