基于USENet实现数字全息细胞再现相位像超分辨重构  下载: 514次

下载: 514次

0 引言

数字全息显微(Digital Holography Microscopy,DHM)作为一种可对生物细胞实现连续、快速、非标记定量相位成像的方法,已广泛应用于细胞无损成像观测[1-5].通常情况下,随着DHM物镜倍率的提升,观测范围会不断变小.为保证系统对细胞集群及个体同时具有较好的成像质量,解决视场范围与成像分辨率之间的矛盾显得尤为重要.

受光源相干性和工艺条件制约,DHM系统数值孔径(Numerical Aperture,NA)及探测元件像元尺寸都极大限制了成像分辨率的提高[6-7].目前,为满足大视场、高分辨率的成像需求,总体上有基于成像方式的改进和基于数值重建的方法.

成像方式的改进主要包括NA扩展、角度复用以及亚像素平移等技术.GAO P[8]等,CHOWDHURY S等[9],PARK Y等[10]基于NA扩展的方法,分别利用倾斜光、结构光和随机调制照明技术,通过合成多幅图像的频谱来扩展单幅图像的频域带宽.LAI X J等[11]基于角度复用的方法优化傅里叶频谱的利用率,将不同频谱位置级次对应下不同照明区域内的物体分别重建后实施拼接;GUZHOV V I等[12], WANG Ming-jun等[13], ZHANG Jia-lin等[14]基于亚像素平移的方式,通过获取目标移动距离小于像素尺寸的相邻多帧图像来合成单幅超分辨全息图.上述方法虽能有效提高DHM系统的成像分辨率,但往往需要牺牲时间带宽来换取空间带宽.这就造成目标区域不能够同步成像,不满足活体细胞在动态观测中的实时性需求.

近来,基于优化迭代的稀疏表示重建方法[15-17]已被证明是一种有效的数值手段,但它在整幅图像参数空间搜索最优特征向量过程漫长、抽象并且不易实现.随着卷积神经网络(Convolutional Neural Networks, CNN)在图像超分辨率领域的使用[18-19],基于Visual Geometry Group[20](VGG是CNN下的一种框架)搭建的对抗生成网络[19]被应用到DHM系统.该方法通过样本训练,建立对应高、低分辨率图像之间的泛化映射关系,简单、有效地实现了图像分辨率提升[21].由于DHM细胞再现相位像的背景大多不含可供观测的有效信息,而目前深度学习在该领域的方法是基于图像层面的整体优化.CNN模型为提升包括背景信息的全局图像估算置信度,一定程度上降低了兴趣区域(Region of Interest, ROI)的重建质量.

UNet[22]最初被用于医学图像分割,其良好的结构对称特性可在图像重建中引入残差网络[23-24](Residual Network, ResNet)机制.ResNet通过为内部增加跳跃连接,有效解决了深度神经网络梯度消失和训练退化的问题,使CNN模型层次及性能得都到极大提升.CNN用于图像处理的一个研究主题是寻找更好的空间拓扑和更强的表现形式,通过捕捉给定图像最显著的特征来提升性能[27].在VGG基础上,一种由Inception构建的体系[24-26]通过集成多尺度卷积窗口在特征空间的平面相关性中建立学习机制.基于Inception结构,权重标定网络(Squeeze-and-Extraction Networks, SENet)[27]又通过分化特征通道的权重值,为特征图构建出立体空间依赖关系.标定层经优化目标学习全局信息侧重来显式地修正特征在演化过程中被识别的敏感程度和重建置信度,从而仅以轻量级运算负载使网络性能得到进一步增强.此外,在大规模视觉识别挑战赛中,图像分类(Categories)误判率已从VGG的7.3%降低至SENet的2.251%[28].这意味着SENet具备更加优越的图像重建潜力.

本文在UNet框架下引入SENet学习机制,通过重新构建超参数和层配置,设计USENet提升目标图像分辨率.围绕增强图像尤其是ROI区的重建质量,USENet结构具有以下三个特点:一是基于UNet框架在整体上形成完全对称的拓扑形态便于叠加ResNet;二是将多种尺度卷积层整合为卷积模块作为特征提取和重建的基本单元;三是引入了特征权重标定学习机制.模型损失函数由结构相似性(Structural Similarity Index, SSIM)、均方误差(Mean Square Error, MSE)和峰值信噪比(Peak Signal-to-Noise Ratio, PSNR)加权得到.通过对比SSIM主导下的评定指标,从15个不同方案中筛选最优权重组合.当训练取得收敛,在验证集上分别计算模型输入、输出图像与真实高分辨样本的评定指标,并以伪彩色、三维形貌图等进行可视化对比,验证方法的有效性.

1 USENet设计

1.1 网络结构设计

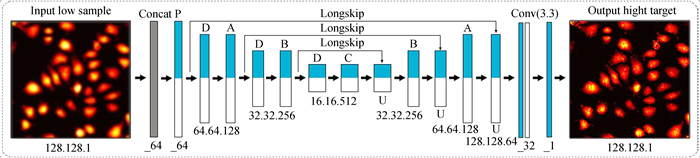

USENet整体结构如图 1所示,详细构造在附录给出.输入样本在过程中连续经历了三次降采样和三次升采样使模型呈现沙漏状.两端对应点位的特征图从像素尺寸到通道数量完全相等,便于引入ResNet(图 1中表示分支的LongSkip),使数据矩阵绕道随后的卷积运算直接叠加到对应输出端,以保留卷积丢失的特征信息并加快深度神经网络的迭代收敛.

图 1用于特征提取的模块(P、A、B和C)由各自相同的卷积单元重复堆叠而成.如图 2(a)示,卷积单元整合了多尺度下的卷积核成为特征提取的基本要素.USENet引入残差后可在一定的模型复杂度下通过适当堆叠卷积单元,合理排列卷积核来加深、拓宽网络的层次结构以提升性能.为增加特征识别的多样性,研究针对4个Block设计了4种不同的卷积单元,详细结构在附录列出.

以P为例,(图 2(a)),它整合了4种尺度的卷积核代替VGG框架中单个3×3的卷积层(图 2(b)),以分支叠加串连的方式提取特征.其中,1×1卷积核可有效关联特征通道之间的信息,1×7和7×1用于拆分7×7卷积核,不仅扩大了模型对特征提取的采样窗口,还额外增加了一层非线性表示,且有效控制了计算负载.由于样本采用0值为基准平面,通过训练标定层参数引导模型有选择性地将背景区域抑制为不敏感特征,从而反向提高ROI区的重建量.为验证标定层对ROI区是否具有促进作用,本研究在网络配置参数完全一致的前提下设置了含有特征图权重标定层的实验组和不含有该层的对照组.实验组权重标定层位于每个征提取模块的尾部,结构如图 3(a)所示.标定过程首先由2个平均池化层将输入矩阵在平面尺寸上压缩为1×1 (通道数不变).随后由中间内置了1个LeakyRelu激活的2个全连接层(FC_1和FC_2)经Sigmoid函数将数值在各通道分别映至0到1区间(图 3(b)).最后用所得权重去修正输入端的数据矩阵.全连接层中的参数经优化目标从全局图像学习特征侧重,进而具备了强化ROI区的自调节能力.图 3(c)为Sigmoid函数表达式与平面曲线示意.

1.2 损失函数设计

损失函数是用来衡量神经网络预测值与实际值差异的一种方式.通过迭代求取差异最小化,模型的预测值将逐渐向真实值收敛.本研究对实验组和对照组模型采用相同的损失函数,函数由三种图像评定因子变形后加权得到.评定因子包括SSIM,MSE和PSNR,定义为

式中,σx、σy表示图像像素矩阵方差,μx、μy为其像素均值,σx,y是两幅图像间的像素矩阵协方差,c1、c2是两幅图像略大于0的界定因子,防止分母出现0使得计算不合法.MSE是目标图像和参考图像间的像素均方误差.PSNR在MSE的基础上进一步施加了对数运算,MAX是图像像素极值的跨度区间.

表 1是用于筛选最优损失函数LT的15种损失因子权重组合方案.

表 1. 损失函数的15组加权组合方案

Table 1. Approaches with 15 different combinations of weighted loss factors

|

由于网络训练是求取损失差异最小化的过程,因此表 1中的L1和L2分别从SSIM和PSNR的计算式变形得到

式中,G是利用模型重建得到的输出图像.由于MSE越小,目标图像和参考图像的相似性越高,因此可直接作为损失因子.损失函数的定义为

α、β、γ则用于调整每部分损失因子在损失函数中的比重(Proportion).实验从15组不同加权组合参数中筛选最优方案.由于PSNR在计算公式上与MSE具有较强的相关性,并且图像极值很可能是噪声点,因此将PSNR放在从属位置.

2 网络训练与学习

2.1 训练样本预处理

首先,在20倍镜下以0值为参考平面采集DHM细胞再现相位像.然后,单张裁切920×920像素尺寸作为原始高分辨训练样本.把图像中临近16像素取均值后进行4×4倍降采样,其次,将降采样后的图像经双三次方插值算法得到920×920的低分辨样本.训练集由1 500个高、低样本对组成.最后,依照同样的步骤额外采集300对样本作为验证集.

2.2 模型训练实施细节

如图 4所示, 训练环节可概括为优化网络参数,使批量的低样本经模型映射与各自对应的真实高样本在整体上谋求差异最小化.由于在卷积运算中对尺寸不足的边缘像素全部采取了零值填充,造成重构图像距边缘6像素成为无效区域,因此只取样本中心116×116像素尺寸计算损失差异.

受硬件显存限制,每次训练需从样本中对随机裁取相同128×128像素区域作为模型输入.为进一步增加样本的多样性,以3/4概率将图像对水平或纵向翻转,或者同时施加两种变换,每批次样本量设置为10.优化算法采用“Adaptive Moment Estimation”,初始学习率以10-4迭代150次,然后将额外50次退化到10-5,共计迭代200次.激活函数全部采用LeakyRelu,定义为

2.3 模型验证实施细节

验证环节包括模型有效性验证和标定机制有效性验证两个步骤.

模型有效性验证是用收敛结果在验证集上获取低分辨样本放大4×4倍后的高保真、高分辨形态,然后与真实图像计算指标得分,验证模型的泛化性.由于网络只能处理128×128的图像输出,且距边缘6像素为无效区域,因此验证环节的重建步骤分为“输入样本边缘像素扩展”“区域分块重建”和“重叠拼接”三个过程,如图 5所示.首先将920×920的验证样本各边向外扩展10个0值像素;然后对扩展后的样本分块重建,单个分块区域为128×128,区域之间单边重叠6像素使每个验证样本能够拆分出64个窗口(每行8个);再用6个零值窗口将验证样本的输入补齐到70(单批次重建数量为10);最后取前64个窗口重构结果中心116×116像素区域拼接出924×924的全局图像,并截取中心920×920得到最终结果.

标定机制有效性验证的目的是证明在网络设计中添加标定层对图像ROI区重建是否具有促进作用.由于两种模型的ROI区重构结果在视觉上没有特别明显的区分度,因此从SSIM的数值差异进行对比.首先以USENet为实验组,并设置不含标定层的模型作为对照组;然后通过训练使两者对图像的全局重建性能在SSIM得分上尽可能接近;再从验证集300个真实样本的细胞区域绘制920×920的图像掩膜;最后将两个模型的重建图像与真实图像分别经掩膜叠加后比较ROI区在全局图像中的SSIM数值差异.

2.4 损失函数的选取策略

15种加权组合得到的优化函数分别被迭代训练200轮,并由验证集逐轮测试评定指标.模型在收敛区间的得分统计如表 2所示.后缀为OPT的项是最优迭代轮次下三个评定指标同时能够达到的相对较好结果时的取值.后缀为AVG的项是各评定指标在收敛范围中的平均表现.OPT与AVG的差异反应了模型的稳定性.差异越小越模型稳定,反之则在不同样本集上表现出的偶然性就越强.由于人类视觉结构对像素数值变化会有一定的感官差异,存在MSE较小,PSNR得分较高,而视觉效果却相对较差的可能性,所以将SSIM作为主要评定指标.表中各项得分是由验证集中的低分辨样本经模型重建后与对应真实高样本计算得到.当两者完全相同时,SSIM为1,MSE为0,目标图像所含有效信息越丰富,PSNR得分越高.

表 2. 不同损失函数在验证集上训练收敛迭代区间的总体表现

Table 2. The performances of net in convergence interval on validation set with 15 different loss functions

|

根据表 1加权方案,1到12号不引入PSNR损失因子并逐渐降低SSIM的比重.表 2统计结果显示:方案1仅以SSIM构建损失函数训练出的模型能够在验证集SSIM评定指标上取得较高得分,但MSE和PSNR却相对较差.当SSIM因子比重降至40%到65%区间时(方案4到9),SSIM指标维持了较高得分,模型稳定性没有被削弱,MSE和PSNR也都得到有效改善,其中又以方案4为最优.当SSIM因子权重降为0,仅以MSE(方案12)或者PSNR(方案13)构建损失函数时,指标得分以及训练稳定性都有明显下降.方案14和15是在方案4的基础上引入占比约5%的PSNR权重,结果明显降低了模型的稳定性.因此方案4(α=0.002 5,β=1,γ=0)在15组实验中被判定为最优.

2.5 软、硬件环境参数

本文原始高分辨样本的采集设备是透射式离轴Mach-Zehnder光路结构下DHM装置.激光器输出功率100 mW,波长532 nm.神经网络模型建立在搭载了Windows10,64位操作系统的工作站上.显卡型号为GTX1080Ti,显存11 GB,处理器为E5-2620-V3,频率2.40 GHz,内存32 GB.Python版本3.6.4,Tensorflow版本1.10.0.程序运行在集成了Python编译环境的Eclipse中.

3 实验结果

3.1 模型有效性验证

模型训练时长为8 414 s,920×920像素单张图像重构时间为0.287 s,模型参数数据量约114 MB.如图 6所示,将验证集300个样本输入、输出分别与其真实高分辨形态计算评估指标得分,并绘制拟合曲线.不难发现,参考真实高分辨样本,重构输出较输入具有更好的SSIM,更低的MSE以及更多有效信息(PSNR).

图 6. 验证集300个样本输入、输出与真实图像在评定指标上的得分拟合曲线

Fig. 6. Fitting curves plotted by assessment scores from the input and output of 300 samples in validation set

图 7和图 8分别是验证集输入、模型输出和真实高分辨样本(从左至右)在伪彩色形态下的对比和频谱域上的对比.图 7(a)和图 7(b)分别是海藻细胞和卵巢癌细胞,其暖色调饱和度与被测目标实际高度成正比.图 7结果显示:首先,输出图像较输入在整体上与真实图像具有更小的高度偏差;然后,输出值在三个选定区域的细节表现与真实样本具有更高的相似性,这也为低分辨形态下的粘连细胞带来更加明显的分割特性.图 8中散点分布越接近于轮廓清晰面积越大的圆,图像细节的可分辨力度越高.结果显示:重构输出相比于插值得到的低分辨输入具有更加丰富的频谱信息.

图 7. 验证集输入、输出和真实样本伪彩色对比

Fig. 7. Fitting curves plotted by assessment scores from the input and output of 300 samples in validation set

为进一步证明方法的有效性,本研究还利用高度等值线和三维形貌格网(图 9)从细胞所在像素区域对比细节信息.依次为输入、输出和真实高分辨形态(从上到下)在123×165的像素选区绘制等值线与三维形貌图.结果显示,USENet能够明显提升输入样本与真实高分辨图像之间的相似程度.

3.2 标定机制的有效性验证

实验组和对照组模型的图像重建数值得分在表 3列出.其中,Reference为不带标定层的对照模型,Global (SSIM)为验证集重建后在全局图像上的得分,ROI (SSIM)为重建图像叠加掩膜后在细胞区域的得分.从验证集的平均表现来看,SSIM数值差异在ROI区被进一步放大.

表 3. 标定层对ROI区重建的得分影响

Table 3. The influence of ROI rebuilding by the calibration layer

|

图 10为300个重建样本在ROI区的SSIM得分分布,虚线是USENet模型,实线为不带标定层的对照模型.除109、173和185号样本表现不佳,其余都得到一定程度的增强.

图 10. 重建验证集在ROI区的得分拟合曲线

Fig. 10. Fitting curves of SSIM performance in the ROI by the rebuilding of validation set

4 结论

本文基于深度学习框架,设计USENet神经网络实现了DHM细胞再现相位像超分辨重构, 为成像视场范围与分辨率之间的矛盾提供了一种有效的解决方案.经频谱、剖面切线、等值线、三维形貌图等对比展示,证明了该网络能够明显改善验证集与真实图像间的细节差异,使SSIM由平均0.770 2提升至0.942 7.根据实验组USENet和不带标定层的对照组模型重建图像对比显示,标定层可进一步在全局图像中将ROI区从平均0.965 5提升至0.970 3.整个过程由数据驱动,方法简单、高效,不需复杂的实验环境和数值推导,且具有广泛的适用性,同时也为DHM细胞再现图像的目标识别、分类以及粘连目标的分割提供了有效的辅助手段.

65 附录

为解决深度神经网络收敛缓慢以及梯度消失的问题,本研究在特定卷积层后增加了BatchNormal层和LeakyRelu层.本文将这三层统称为一个卷积集合,将不带BatchNormal层的卷积集合称为卷积组.通过堆叠卷积集合与卷积组为卷积模块构建出特征提取的基本单元.模型详细结构如图 11所示.

特征图提取主要由4个不同的卷积模块来实现(P、A、B和C).除P外的其他三个卷积模块分别由各自相同的卷积单元堆叠而成.所有卷积模块尾部是用于计算权重的特征标定模块(S).P接收128×128×64特征图.首先给出2个卷积分支.分支1由1个带1×1卷积核的卷积组与1个带3×3卷积核的卷积集合构成,各层不改变长宽尺寸,输出32通道.分支2由2个组(1×7和7×1)及1个3乘3的集合构成,各层不改变长宽尺寸,输出64通道.然后在通道上合并得96.最后通过1个3×3的集合输出64通道.标定层第1个全连接层的输出端连接4个神经元.A单元接收64×64×128特征图.首先给出3个卷积分支.分支1由1个1×1集合输出32通道,分支2由1个3×3集合输出64通道,分支3由1个3×3卷积组与1个3×3集合构成,各输出64通道.然后在通道上合并得到160,最后经1个1×1集合输出128通道.标定层第1个全连接层输出端连接8个神经元.B单元接收32×32×256特征图.首先给出2个卷积分支.分支1由1个1×1集合输出128通道,分支2由1个1×7卷积组和1个7×1集合组成,各层输出128通道.然后在通道上合并得到256.标定层第1个全连接层输出端连接16个神经元.C单元接收16×16×512特征图.首先给出2个卷积分支.分支1由1个1×1集合输出256通道,分支2由1个1×3卷积组和1个3×1集合组成,各层输出256通道.然后在通道上合并得到512.标定层第1个全连接层输出端连接32个神经元.

特征图降采样使输入图像尺寸减半,通道数加倍.D首先给出2个分支,分支1是1个卷积尺寸为2×2,步长为2的平均池化层,分支2是1个尺寸3×3,步长为2的卷积层.各分支不改变通道数量.最后合并分支,经BatchNormal和LeakyRelu层输出.特征图升采样是降采样的逆向操作.U由1个3×3反卷积层,BatchNormal和LeakyRelu构成.

网络中一共设置了三种类型的远跳连接(残差运算),第一种用于连接卷积单元的输入和输出端;第二种用于连接卷积模块的输入和输出端;第三种用于连接降采样输入和对应的升采样输出端.

[19] CHRISTIAN L, LUCAS T, FERENC H, et al. Photorealistic single image superresolution using a generative adversarial wk[C]. 2017 IEEE Conference on Computer Vision Pattern Recognition, 2017: 105114.

[20] KAREN S, REW Z. Very deep convolutional wks f largescale image recognition[J]. arXiv: 1409.1556[cs.CV].

[21] LIU Tairan, KEVIN D H, RIVENSON Y, et al. Deep learningbased superresolution in coherent imaging systems[J]. arXiv: 1810.06611[cs.CV].

[22] OLAF R, PHILIPP F, THOMAS B. U: Convolutional wks f biomedical image segmentation[J]. arXiv: 1505.04597[cs.CV].

[23] HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al. Deep residual learning f image recognition[J]. arXiv: 1512.03385[cs.CV].

[24] CHEN Chao, QI Feng. Single image superresolution using deep CNN with dense skip connections inceptionRes[C]. ITME 2018: IEEE 9th International Conference on Infmation Technology in Medicine Education, 2018, 1: 9991003.

[25] CHRISTIAN S, SERGEY I, VINCENT V. Inceptionv4, inceptionRes the impact of residual connections on learning[J]. arXiv: 1602.07261[cs.CV].

[26] SZEGEDY C, LIU Wei, JIA Yangqing, et al. Going deeper with convolutions[J]. arXiv: 1409.4842[cs.CV].

[27] HU Jie, SHEN Li, SUN Gang. Squeezeexcitation wks[J]. arXiv: 1709.01507[cs.CV].

[28] Categies[EBOL].[20191230]. http:image.gchallengesLSVRC.

Article Outline

肖文, 李解, 潘锋, 赵爽. 基于USENet实现数字全息细胞再现相位像超分辨重构[J]. 光子学报, 2020, 49(6): 0610001. Wen XIAO, Jie LI, Feng PAN, Shuang ZHAO. Super-resolution in Digital Holographic Phase Cell Image Based on USENet[J]. ACTA PHOTONICA SINICA, 2020, 49(6): 0610001.