基于双目视觉的显著性目标检测方法  下载: 1075次

下载: 1075次

1 引言

人眼视觉系统能在复杂场景中选择性地处理感兴趣目标,这种自适应选择的能力被称为视觉注意机制。计算机视觉领域将模仿人眼的注意机制定义为图像显著性检测技术,用于辅助计算机快速提取图像目标区域,实现资源合理分配,提高处理准确率与效率。该技术已被广泛应用于目标检测与识别[1-3]、图像分割[4]、目标跟踪[5]以及图像检索[6]等领域。

Borji等[7]根据目的差异将显著性检测方法分为人眼注意点位置预测和显著性目标检测。本文算法以目标检测为内驱力,属于显著性目标检测范畴。根据检测特征的不同,现存显著性目标检测方法可分为基于对比度信息的显著性目标检测与基于先验信息的显著性目标检测。

在人类注意力模型的简化过程中发现,对比度是视觉注意机制的主要驱动因素。大量基于对比度信息的显著性目标检测算法被相继提出,Ma等[8]在LUV颜色空间计算邻域像素的颜色欧氏距离,利用局部颜色对比信息度量图像显著性,但该方法邻域尺寸固定,难以满足不同尺寸的显著性目标检测。Achanta等[9]提出利用可变尺寸感知单元的对比度信息实现多尺度显著性目标检测,该方法更加注重图像细节,但易受背景噪声的影响,从而增大误检率。Zhai等[10]提出以像素点灰度特征的全局对比度作为显著性度量依据,该方法运算速度快,但忽略了图像空间关系。Achanta等[11]采用图像颜色模型(Lab)均值作为全局信息,根据图像每个像素点的颜色距离得到显著图,但该方法仅考虑了一阶平均颜色,不满足复杂背景下显著目标的检测要求。Cheng等[12]提出基于直方图对比度的方法,根据每一个像素与图像中其他像素的颜色差异确定显著值,该方法考虑了区域的空间相关性,从而提高了检测准确率,但在与目标具有相似颜色或具有复杂纹理的背景下检测效果不佳。综上所述,对比度信息能在显著性检测中取得良好的效果,但仅依靠图像对比度进行检测,难免将图像中具有稀有性或独特性的背景区域误检为目标。因此研究人员根据显著性目标空间位置约束关系,将一些先验条件引入视觉显著性检测模型中,从而降低误检率。

先验信息可大致分为两类:中心先验和背景先验。中心先验通常假设显著性目标位于图像中心,如文献[ 13]以中心矩形构图为先验信息,构建基于中心矩形线上的超像素特征,根据超像素流行排序获取显著图。中心先验方法有一定主观性,易将显著性检测的注意点引入背景范围,从而忽略了显著性区域。与中心先验不同,背景先验则假设图像边界大多为背景区域。Li等[14]通过超像素提取图像边界作为背景模板,计算密集与稀疏重构误差,利用多尺度重建误差融合计算像素级显著性,该算法能有效突出显著性目标,但易造成边界目标的漏检,且同一区域中的显著值不连续。Zhu等[15]提出以边界连通度作为背景定义准则,解决了目标与图像边界连接的问题,但在目标区域与背景区域颜色相似情况下效果不佳。近年来,很多研究人员将两种先验信息相结合,提出新的融合算法。周帅骏等[16]利用边缘超像素为吸收节点计算背景先验值,再将其与中心先验图融合得到视觉显著图,与单一先验信息方法相比,该方法充分利用了图像信息,能够高亮地凸显图像显著目标。林华锋等[17]利用基于目标中心优先与背景模板抑制的空间先验方法获得空间先验显著图,该方法能够准确有效地检测出位于图像任意位置的显著性物体。但是上述两种融合算法在显著性目标与背景模板特征相似的情况下,均不能完整地检测出显著性区域。

人眼视觉由视觉注意力机制和双目视觉系统共同构建。视觉注意力机制通过双目视觉系统接收视觉信号,并根据视觉信息协同处理结果快速提取目标,帮助人类完成重要目标的快速感知。双目视觉系统是在人类的发展进化过程中逐渐形成的,是为感知和适应环境而自我进化的信息获取工具,不仅可以帮助人脑感知画面色彩、亮度等基本信息,还可以根据图像深度分布特征,获取场景深度分布信息,从而更准确地获得外界物体形状、方位以及距离等描述信息,从而判断自身与客观环境间的位置关系,是人类视觉注意力机制感知信息的重要工具。该过程表明深度信息分布也是一种重要的视觉感知信息,将其作为显著性特征与其他现有显著性特征协同处理,可以更加准确地完成相似背景中的目标显著性检测。

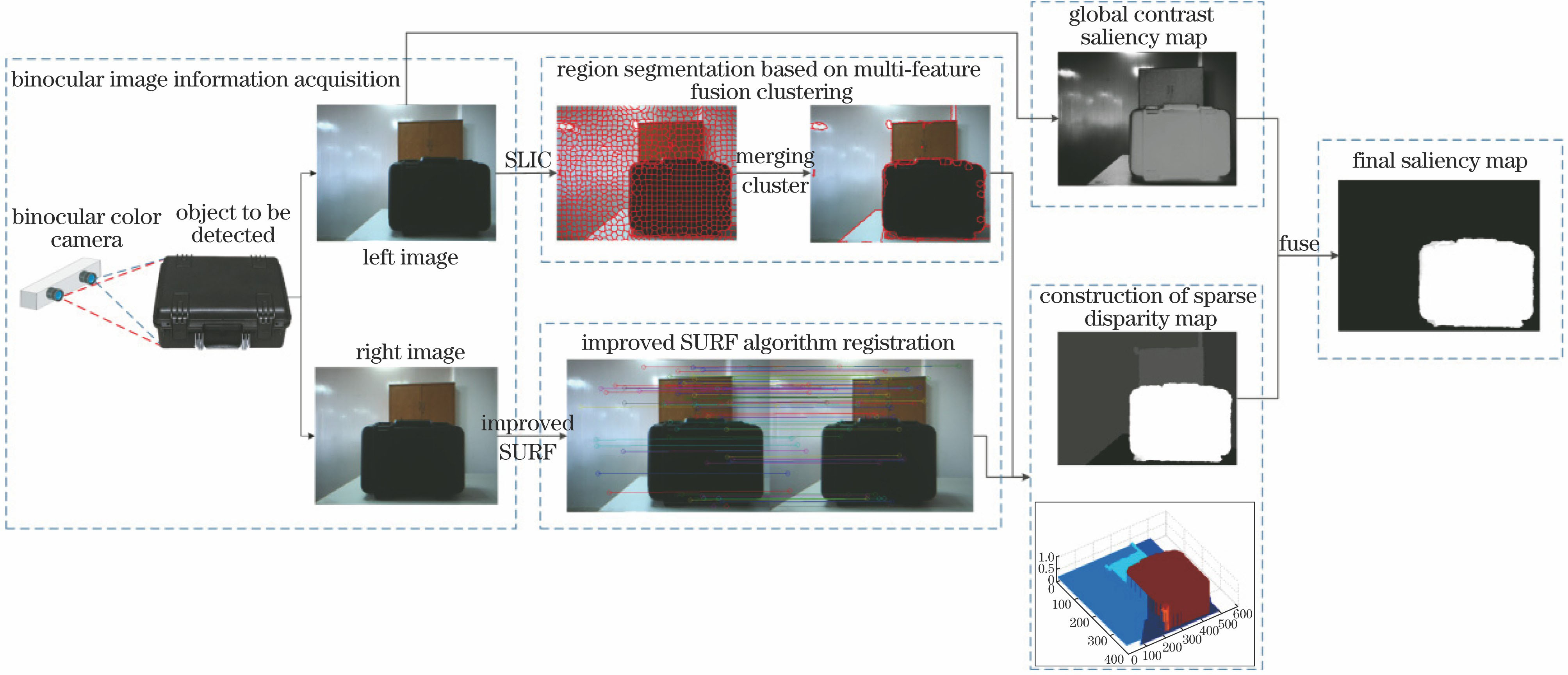

受上述人眼视觉特性的启发,本文提出基于双目视觉的显著性目标检测算法,将深度信息作为视觉显著性特征与其他显著性特征协同处理,克服了显著性目标检测易受相似背景干扰的问题,并且具有显著性目标检测准确度高、通用性好等优点。

2 基于双目视觉的显著性目标检测

本文算法处理过程如

2.1 基于多特征融合聚类的区域分割

人类的视觉观察系统以图像区域为基本单位,基于区域进行显著性检测符合人眼视觉特征。超像素技术作为像素区域的构建方法在计算机视觉领域中得到了广泛应用[18]。超像素能将图像快速分割为具有一定语义的子区域,有利于局部特征的提取与结构信息的表达,满足人眼视觉系统区域观察特性[19]。在众多超像素构建方法中,SLIC算法在边缘贴合度和紧密度两方面取得了较好的平衡,具备较高的计算效率,是目前综合性能较为优异的超像素分割算法[20]。本文采用SLIC算法在左目图像中进行超像素块分割,并利用多特征融合机制制定超像素聚类策略,从而完成整幅图像的区域分割。

将左目图像转换到CIE Lab颜色空间,通过SLIC方法将图像分割为

式中

超像素能够完成局部相似区域的聚类,但不满足大区域分割的需求,为此本文提出利用颜色、纹理特征融合机制,对相邻超像素的差异性进行度量,完成超像素区域的自动合并,实现大区域聚类,从而满足多尺寸目标检测的要求。

利用超像素区域颜色、纹理以及空间位置信息对相似超像素进行合并,实现图像的区域划分。

图 2. 基于多特征融合聚类的区域分割示意图

Fig. 2. Schematic of region segmentation based on multi-feature fusion clustering

1) 首先获取所有超像素的相邻信息,找出所有相邻的超像素对,

式中

2) 以超像素相邻作为合并的前提条件,利用颜色、纹理特征计算所有相邻超像素对

式中

式中(

3) 若相邻超像素之间的差异性小于一定阈值

利用(5)式找出所有相邻且相似的超像素对

1) 以起始点为聚类起点,寻找所有与其相邻且相似的超像素归为一类,同时对寻找到的每个同类超像素继续寻找其相邻且相似的超像素归入该类中,以此类推,直至找到满足条件的所有超像素,则该类超像素的聚类完成,将已归类超像素标记为已处理状态,不再参与其他超像素的聚类,更新聚类初始点。

2) 对新的生长起始点进行同样的归类处理,直至所有超像素均被标记为已处理状态,则停止聚类,获取所有分类情况。

此处可将超像素合并过程视为“tree”的生长,以每个途经超像素为节点,不断向下寻找满足相邻且相似条件的子节点,直到没有满足条件的子节点,则停止该tree的生长。遍历图像中所有超像素,找出每个节点所有的父节点与子节点,最后生长形成若干tree,每棵tree上的所有节点对应的超像素均可合并形成具有相似特征的大区域。

2.2 构建稀疏视差图

双目能够同时从两个不同的角度观察同一个物体,由于视角不同而产生的方向上的位置差异叫做视差。根据视差大小即可获取物体的远近关系,从而找出距离最近的物体区域,利用空间位置信息,将最远的区域作为背景区域,从而有效抑制相似背景区域、亮斑以及噪声的影响。

在构建稀疏视差图的过程中,首先利用改进SURF算法获取稀疏匹配点。因传统SURF算法匹配错误率高,极大地降低了视差计算的准确度,故本文利用几何特征对匹配特征点进行约束,提出基于斜率主导性的改进特征点匹配策略,有效提升了匹配精度。该匹配策略步骤如下:

1) 利用SURF算法获得左目图像和右目图像特征点坐标及所有特征点的64维描述符,左目图像和右目图像的特征点定义为

式中

2) 计算左目图像的特征点参数

3) 根据

式中(

获取的匹配点仅能得到离散的视差点图,不能反映整幅图像的视差信息,获取区域级的视差图还需要进一步的处理。在研究过程中发现,在检测目标时,同一物体上的视差值相近,可视为相同视差。结合分割得到的图像区域,提出基于区域构建图像稀疏视差图,如

式中

将

图 5. 稀疏视差构建示意图。(a)匹配点对;(b)合并区域匹配点;(c)稀疏视差图;(d)立体视差图

Fig. 5. Schematic of sparse disparity construction. (a) Matching point pairs; (b) match points in the merged regions; (c) sparse disparity; (d) stereo image of sparse disparity

2.3 显著图融合背景抑制

根据视差信息可以获取深度显著区域,该区域不仅包含待测物体,也可能包含承载物体的平台等其他背景信息。如

本文利用全局显著信息对该类背景进行抑制,去除距离相机过近的非目标区域信息。Achanta[11]提出的快速显著物体检测算法(FT)计算简单,能有效检测出显著目标区域,弱化背景区域,弥补深度显著性检测的缺陷。将深度显著性检测的稀疏视差图与FT全局显著图按比例进行融合,得到融合显著图

式中[

最后对融合后的所有区域的显著值进行排序,取其中值的80%作为阈值,若显著值低于阈值,则认为该区域为背景区域,将该区域显著值置0,降低背景区域的影响,得到最终显著图:

图 7. 显著图融合背景抑制结果比较示例。(a)原左目图像;(b)稀疏视差图;(c) FT全局显著图;(d) FT区域均值显著图;(e)融合结果显著图;(f)背景抑制结果显著图

Fig. 7. Comparison of saliency map fusion and background suppression results. (a) Original left image; (b) sparse disparity map; (c) FT global saliency map; (d) FT regional mean saliency map; (e) fusing saliency map; (f) saliency map of results after background interference

3 实验结果与分析

本文算法的运行环境为Intel Core I5,2.60 GHz CPU,8 GB内存,编译环境为MATLAB R2013a,仿真操作界面如

3.1 评价准则

本文采用了查准率-查全率(

查准率与查全率的曲线(

式中

由(12)和(13)式可知,查准率与查全率成反比,查全率越高,查准率则会下降,不足以定量地对算法性能进行评价。

式中

由于不同阈值下的查全率与查准率会有不同的表现,因此设置AUC能更全面地评价系统性能。系统的性能越好,其评价曲线就会尽可能地向上突出,即曲线与坐标轴之间的面积越大。平均准确率AUC即

为了避免二值分割阈值选取对算法评价的干扰,可通过MAE评价算法性能。即计算图像中每个像素点的显著值

3.2 结果分析

为全面评价本文算法,将本文算法与12种显著性检测算法进行比较。为更加直观地进行对比,将12种算法按提取特征分为2类:1)基于对比度信息算法,包括LC[10]、AC[9]、FT[11]、CA[21]、SEG[22]、HC[12]、PCA算法[23];2)基于先验信息算法,包括DSR[14]、GR[24]、RBD[15]、LPS[25]、MILPS算法[26]。

采用实验室随机拍摄的100组实景双目图像进行测试,并对本文算法与上述12种算法测试的部分对比显著图像与所有测试图像处理结果进行数据分析,为方便比较,实验中本文算法与12种对比算法均对左目图像进行测试。

3.2.1 显著图视觉效果对比

图 9. 本文算法与全局对比度算法显著图对比。(a)原左目图;(b)原右目图;(c) GT算法;(d)本文算法;(e) LC算法;(f) FT算法;(g) HC算法;(h) PCA算法

Fig. 9. Comparison of saliency maps generated by the proposed algorithm and global contrast algorithms. (a) Original left image; (b) original right image; (c) GT algorithm; (d) proposed algorithm; (e) LC algorithm; (f) FT algorithm; (g) HC algorithm; (h) PCA algorithm

本文算法与局部对比度模型算法的显著图对比情况如

图 10. 本文算法与局部对比度算法显著图对比 (a)原左目图;(b)原右目图;(c) GT算法;(d)本文算法;(e) AC算法;(f) CA算法;(g) SEG算法

Fig. 10. Comparison of saliency maps generated by the proposed algorithm and local contrast algorithms. (a) Original left image; (b) original right image; (c) GT algorithm; (d) proposed algorithm; (e) AC algorithm; (f) CA algorithm; (g) SEG algorithm

图 11. 本文算法与先验信息算法显著图对比。(a)原左目图;(b)原右目图;(c) GT算法;(d)本文算法;(e) DSR算法;(f) GR算法;(g) RBD算法;(h) LPS算法;(i) MILPS算法

Fig. 11. Comparison of saliency maps generated by the proposed algorithm and prior information algorithms. (a) Original left image; (b) original right image; (c) GT algorithm; (d) proposed algorithm; (e) DSR algorithm; (f) GR algorithm; (g) RBD algorithm; (h) LPS algorithm; (i) MILPS algorithm

本文算法与先验信息算法显著图的对比情况如

3.2.2 定量分析

为对本文算法性能进行定量评估,列出了本文算法与12种对比算法对所采集的100组双目图像进行测试的数据分析图,包括

将测试图像从0~255,步长为5取阈值进行二值分割,得到

图 12. 本文算法与其他算法P-R曲线图。(a)与全局对比度算法对比;(b)与局部对比度算法对比;(c)与先验信息算法对比

Fig. 12. P-R curves of the proposed method and other algorithms. (a) Comparison with the global contrast algorithm; (b) comparison with the local contrast algorithm; (c) comparison with the prior information algorithm

图 13. 本文算法与其他算法的MAE、AUC、F值柱状图。(a)与全局对比度算法对比;(b)与局部对比度算法对比;(c)与先验信息算法对比

Fig. 13. MAE, AUC, F value histograms of the proposed method and other algorithms. (a) Comparison with the global contrast algorithm; (b) comparison with the local contrast algorithm; (c) comparison with the prior information algorithm

4 结论

受人眼视觉特性的启发,提出一种基于双目视觉的显著性目标检测算法。该算法首先利用双目视觉模型进行深度感知,再将感知深度与多特征融合聚类结果进行协同处理,获取区域级的深度显著性,最后利用全局显著性与深度显著性的加权融合结果进行背景抑制,完成显著性目标检测。实验结果表明,本文算法能有效抑制相似背景的干扰,较其他算法准确率更高,性能更好。但该算法不能有效抑制具有一定深度显著性的连续背景区域,针对该算法的不足,本文下一步的研究方向是抑制前后分布的连续背景,更有效地突出目标区域。

[2] 杨林娜, 安玮, 林再平, 等. 基于空间距离改进的视觉显著性弱小目标检测[J]. 光学学报, 2015, 35(7): 0715004.

杨林娜, 安玮, 林再平, 等. 基于空间距离改进的视觉显著性弱小目标检测[J]. 光学学报, 2015, 35(7): 0715004.

[3] 王博, 苏玉民, 万磊, 等. 基于梯度显著性的水面无人艇的海天线检测方法[J]. 光学学报, 2016, 36(5): 0511002.

王博, 苏玉民, 万磊, 等. 基于梯度显著性的水面无人艇的海天线检测方法[J]. 光学学报, 2016, 36(5): 0511002.

[5] 江晓莲, 李翠华, 李雄宗. 基于视觉显著性的两阶段采样突变目标跟踪算法[J]. 自动化学报, 2014, 40(6): 1098-1107.

江晓莲, 李翠华, 李雄宗. 基于视觉显著性的两阶段采样突变目标跟踪算法[J]. 自动化学报, 2014, 40(6): 1098-1107.

Jiang X L, Li C H, Li X Z. Saliencybased tracking method for abrupt motions via two-stage sampling[J]. Acta Automatica Sinica, 2014, 40(6): 1098-1107.

[8] Ma YF, Zhang HJ. Contrast-based image attention analysis by using fuzzy growing[C]∥Proceedings of the eleventh ACM international conference on Multimedia, 2003: 374- 381.

Ma YF, Zhang HJ. Contrast-based image attention analysis by using fuzzy growing[C]∥Proceedings of the eleventh ACM international conference on Multimedia, 2003: 374- 381.

[9] AchantaR, EstradaF, WilsP, et al. Salient region detection and segmentation[C]∥Proceedings of the 6 th international conference on Computer vision systems , 2008: 66- 75.

AchantaR, EstradaF, WilsP, et al. Salient region detection and segmentation[C]∥Proceedings of the 6 th international conference on Computer vision systems , 2008: 66- 75.

[10] ZhaiY, ShahM. Visual attention detection in video sequences using spatiotemporal cues[C]∥Proceedings of the 14 th ACM international conference on Multimedia , 2006: 815- 824.

ZhaiY, ShahM. Visual attention detection in video sequences using spatiotemporal cues[C]∥Proceedings of the 14 th ACM international conference on Multimedia , 2006: 815- 824.

[12] Cheng MM, Mitra NJ, Huang XL, et al. Global contrast based salient region detection[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2011, 37( 3): 569- 582.

Cheng MM, Mitra NJ, Huang XL, et al. Global contrast based salient region detection[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2011, 37( 3): 569- 582.

[13] 宋腾飞, 刘政怡. 中心矩形构图先验的显著目标检测[J]. 中国图象图形学报, 2017, 22(3): 315-326.

宋腾飞, 刘政怡. 中心矩形构图先验的显著目标检测[J]. 中国图象图形学报, 2017, 22(3): 315-326.

Song T F, Liu Z Y. Saliency detection based on center rectangle composition prior[J]. Journal of Image and Graphics, 2017, 22(3): 315-326.

[14] Li XH, Lu HC, Zhang LH, et al. Saliency detection via dense and sparse reconstruction[C]. IEEE International Conference on Computer Vision, 2013: 2976- 2983.

Li XH, Lu HC, Zhang LH, et al. Saliency detection via dense and sparse reconstruction[C]. IEEE International Conference on Computer Vision, 2013: 2976- 2983.

[15] Zhu WJ, LiangS, Wei YC, et al. Saliency optimization from robust background detection[C]. IEEE Conference on Computer Vision and PatternRecognition, 2014: 1049/1050( 8): 2814- 2821.

Zhu WJ, LiangS, Wei YC, et al. Saliency optimization from robust background detection[C]. IEEE Conference on Computer Vision and PatternRecognition, 2014: 1049/1050( 8): 2814- 2821.

[16] 周帅骏, 任福继, 堵俊, 等. 融合背景先验与中心先验的显著性目标检测[J]. 中国图象图形学报, 2017, 22(5): 584-595.

周帅骏, 任福继, 堵俊, 等. 融合背景先验与中心先验的显著性目标检测[J]. 中国图象图形学报, 2017, 22(5): 584-595.

Zhou S J, Ren F J, Du J, et al. Salient region detection based on the integration of background-bias prior and center-bias prior[J]. Journal of Image and Graphics, 2017, 22(5): 584-595.

[17] 林华锋, 李静, 刘国栋, 等. 基于自适应背景模板与空间先验的显著性物体检测方法[J]. 自动化学报, 2017, 43(10): 1736-1748.

林华锋, 李静, 刘国栋, 等. 基于自适应背景模板与空间先验的显著性物体检测方法[J]. 自动化学报, 2017, 43(10): 1736-1748.

Lin H F, Li J, Liu G D, et al. Saliency detection method using adaptive background template and spatial prior[J]. Acta Automatica Sinica, 2017, 43(10): 1736-1748.

[18] 陈海永, 郄丽忠, 杨德东, 等. 基于超像素信息反馈的视觉背景提取算法[J]. 光学学报, 2017, 37(7): 0715001.

陈海永, 郄丽忠, 杨德东, 等. 基于超像素信息反馈的视觉背景提取算法[J]. 光学学报, 2017, 37(7): 0715001.

[20] 宋熙煜, 周利莉, 李中国, 等. 图像分割中的超像素方法研究综述[J]. 中国图象图形学报, 2015, 20(5): 599-608.

宋熙煜, 周利莉, 李中国, 等. 图像分割中的超像素方法研究综述[J]. 中国图象图形学报, 2015, 20(5): 599-608.

Song X Y, Zhou L L, Li Z G, et al. Review on superpixel methods in image segmentation[J]. Journal of Image and Graphics, 2015, 20(5): 599-608.

Article Outline

李庆武, 周亚琴, 马云鹏, 邢俊, 许金鑫. 基于双目视觉的显著性目标检测方法[J]. 光学学报, 2018, 38(3): 0315002. Li Qingwu, Zhou Yaqin, Ma Yunpeng, Xing Jun, Xu Jinxin. Salient Object Detection Method Based on Binocular Vision[J]. Acta Optica Sinica, 2018, 38(3): 0315002.