结合图像语义分割的增强现实型平视显示系统设计与研究  下载: 950次

下载: 950次

1 引言

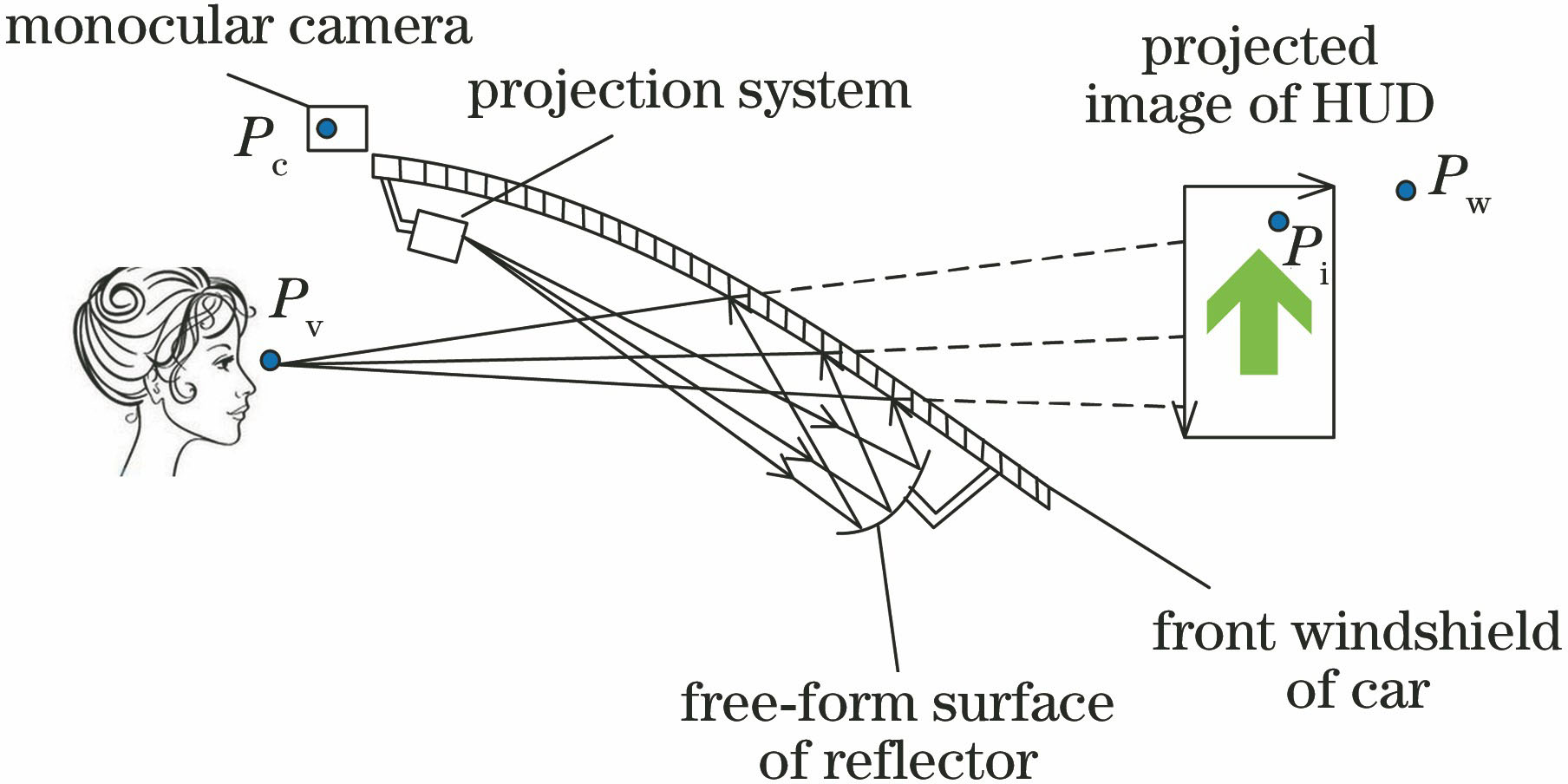

增强现实(AR)技术是一种以真实场景信息为基础,以虚拟对象作为补充信息的一种技术。中国是全球交通和路况最复杂的地区之一,约80%的交通事故是由于驾驶员的注意力分散导致的。汽车平视显示器(HUD)的出现,使驾驶员不用低头就可以看到相关信息,可以将更多的精力放到观察路面情况上,与此同时,也可以减少驾驶员由于要观察远处道路情况与近距离查看导航、车辆信息是而须频繁转换视线所引发的视觉疲劳[1]。一些现有的HUD系统仅在驾驶员视线前方显示虚拟信息[2],没有与真实环境进行融合,这种虚拟内容与真实场景之间的不匹配,会在一定程度上导致驾驶员注意力分散。为此,本文提出一套增强现实型平视显示(AR-HUD)系统,以实现虚拟图像与环境的真正融合,提高行车安全性。

增强现实系统中,首先需要对周围环境进行理解,才能将虚拟物体叠加到场景中的正确位置,即解决虚实注册问题[3]。现有的虚实注册方法可分为有标识[4]和无标识虚实注册[5]两大类。有标识注册方法通常在场景中放置人工标识物,或通过识别自然标识进行虚实注册,此类方法完全依赖于标识信息,若视角不在标识区域,则无法完成注册。无标识的虚实注册通过对场景中的内容进行获取与理解,计算虚实注册矩阵,从而实现虚拟信息与真实环境的融合,克服了前述问题。获取场景的内容信息,即解决场景的语义分割问题。图像的语义分割是指利用计算机自动分割并识别出图像中的内容[6]。一般的AR系统只对场景进行识别,并未对目标之间的像素所属类别进行细致的划分,也有部分系列利用边缘检测、区域提取等方法得到了目标间的像素分类结果,但这些方法需要人为设计算法,事先提取特征,计算过程往往较复杂。随着深度学习[7-10]的发展,出现了一系列语义分割算法,这些基于深度卷积网络的语义分割算法不需要事先提取特征,而是采用学习的方法对网络进行训练。Long等[11]提出了基于深度学习的全卷积网络(FCN)语义分割方法,该网络将最后的全连接层替换为卷积层,再经过上采样得到图像的像素分类结果,并且可以输入任意大小的图像。该方法虽然实现了对目标的分割与标记,但由于在上采样过程中丢失了图像部分像素,精度不是很高。Badrinarayanan等[12]提出了逐像素语义分割(SegNet)网络,将最大池化指数转移至解码器中,改善了分割分辨率,并应用于道路和车辆的分割。Chen等[13]提出前端为FCN、后端采用条件随机场(CRF)优化前端输出的深度卷积网络对图像进行语义分割,采用空洞卷积,在不增加参数数量的情况下增大了感受野,改善了分割网络,并实现多尺度处理,后端通过CRF实现结构化预测,使分割性能得到进一步提升。

本文提出一种基于语义分割和AR相结合的车辆辅助系统。首先设计了改进的单发多框检测器(SSD)网络用于图像的语义分割,获取场景的语义内容信息,并结合AR-HUD系统,分析系统间各部分之间的关系,通过计算虚实注册矩阵,将虚拟图像注册到真实场景中,实现对道路信息的增强,提高驾驶安全性。

2 AR-HUD系统总体架构

系统总体架构如

3 结合语义分割的虚实注册方法

3.1 改进的SSD语义分割网络

为了获取场景的内容信息,从而将虚拟内容叠加到真实场景,提出一种基于改进的SSD深度学习网络的场景语义内容获取方法。

SSD是一种基于回归的目标检测与识别方法[14],使用单个回归器预测真实边框。这种深度学习模型将检测和识别过程在同一个网络中完成,训练时用牛津大学视觉几何课题组提出的16层深度卷积网络(VGG-16)提取特征,通过将VGG-16后两层的全连接层替换为新的卷积层,能够提取不同层次特征图上的特征,再经过特征回归预测,得到不同尺度目标的分类结果。由于得到了多尺度特征,可以对图像中的目标进行多层次判断,在提高精度的同时,保持了算法的速度。

对SSD网络进行改进,不仅在网络中输出目标所属类别结果,并且对目标的像素所属类别进行分类。改进的SSD网络的主要过程分为:1)通过VGG-16深度神经网络提取输入图像的深度特征;2)根据不同尺度的深度特征图设计不同大小的特征抓取盒;3)用转置卷积对深度特征图进行上采样,逐层恢复特征图尺寸;4)通过提取特征抓取盒所对应深度图特征预测目标的所属类别;5)采用非最大值抑制(NMS)筛选预测结果,同时输出像素分割结果。整个网络模型如

网络的输入是整张图片,然后经过VGG-16网络对输入图像提取深度特征,在VGG-16网络后面添加不同尺度的卷积神经网络(CNN)层,用来提取图像的多尺度特征,卷积过程采用空洞卷积算法[15]。其中,conv:3×3×256-s2表示卷积核,其卷积步长为2,用来处理CNN层。经过几次卷积操作,特征图数量变为128,得到用于检测识别的特征图,然后利用双线性插值的方法对特征图进行上采样操作,逐层恢复特征图大小,最终输出目标像素的分类结果。通过对改进SSD网络的训练,可以得到真实场景的目标分类结果,为后续虚拟图像的注册提供环境信息。

3.2 结合语义内容的虚实注册算法

经过深度卷积神经网络对道路图像进行处理,得到了目标的像素分类结果。在获得环境信息后,就可以通过对环境的理解,将虚拟图像注册到真实场景,使驾驶员观察到虚拟信息与道路场景融合的图像。此时,需要获取驾驶员、光学系统、道路场景之间的关系。如

式中

在求解(1)式时,首先用单目深度估计[16]的方法对图像中目标像素点的深度

式中

将(2)式所得结果代入(1)式,经过矩阵求解即可得到空间坐标

当有新帧到来时,相机的姿态改变导致虚实注册矩阵也相应改变。此时对前后两关键帧之间的输入图片进行特征点提取,再对两幅图片的特征点进行匹配,结合点的深度数据二维点转换为三维点,得到特征点集合,记为

此时的问题为相机姿态估计问题,即估计(3)式的

则相机姿态矩阵

这里的相机姿态估计不仅考虑了特征点之间的约束关系,而且增加了同一类别目标物体之间的约束关系。记当前相机相对初始位置的注册矩阵

求出虚实注册矩阵,即可将虚拟图像叠加到道路场景,使驾驶员能够看到虚实融合的图像。

4 实验过程与分析

4.1 语义分割算法实验及性能测试

实验的网络训练环境为64位Windows系统,GPU为GTX1060,实验平台为Caffe。输入图像经过VGG-16网络提取特征后,再经过6层特征提取层提取此时特征图的特征,由于每个特征层的尺度不同,这样就能够获得图像的多尺度特征。为了对图像的像素进行分类,用双线性插值的方法对特征图进行上采样,恢复原图大小。通过上述网络训练过程,即可在网络后端输出图像中不同目标的像素分类结果。模型在训练时采用CamVid数据集[18],训练时初始学习率为0.001,权重惩罚项为0.0005,动量项为0.9,一次处理图像批量为32。在训练时间方面,第一次使用训练集中的全部样本训练,耗时129.8 s,第二次为98.7 s,此后使用训练集中的全部样本训练一次的时间均在95 s左右。

采用两种方法对实验结果进行定量评价。

1)假设输入图像中能够被检测到的物体类别数为

图 3. 改进的SSD网络训练过程。(a)迭代次数与训练损失的关系;(b)迭代次数与准确率的关系

Fig. 3. Training process of improved SSD network. (a) Relationship between iteration number and training loss; (b) relationship between iteration number and accuracy

2)像素的分类问题可以看成集合之间的交集与其并集之间的重合比例计算问题,其中交集为真实正例的数量,并集为错误正例。将真实正例,错误正、负例的和定义为总数量,通过计算真实正例与总数量的比值,并由总类数取平均值,对像素分类结果的准确度进行平均交并比(MIoU)评价。

4.2 视觉虚实注册算法性能测试

通过改进的SSD网络对道路场景进行语义分

表 1. 网络输出结果评价及平均处理时间对比

Table 1. Evaluation of network output results and comparison of average processing time

|

割,然后结合深度信息将图像坐标转化为空间坐标点,获取目标的空间位置,再通过(6)式计算获得虚拟图像在虚拟平面上注册的位置。实验结果如

![不同环境下语义分割及虚实注册结果。(a)原始图像;(b)文献[12]方法结果;(c)本文算法结果;(d)虚实注册结果](/richHtml/gxxb/2018/38/7/0710004/img_4.jpg)

图 4. 不同环境下语义分割及虚实注册结果。(a)原始图像;(b)文献[ 12]方法结果;(c)本文算法结果;(d)虚实注册结果

Fig. 4. Results of semantic segmentation and virtual-real registration in different environments. (a) Original images; (b) method of Ref.[12]; (c) proposed method; (d) virtual-real registration images

图 5. 虚实注册在不同方向上的RMS误差及对比。(a) x;(b) y;(c) z

Fig. 5. RMS error of virtual-real registration and comparison in different directions. (a) x; (b) y; (c) z

5 结论

建立结合图像语义分割的AR-HUD系统。提出改进的基于SSD网络的语义分割算法,通过分析AR-HUD系统各部分之间的关系,结合改进的SSD网络得到的场景语义信息,将虚拟内容叠加到真实场景中,实现了对场景信息的增强。实验结果表明,语义分割算法的准确率为77.8%,虚实注册算法的速度约为22 frame·s-1,与现有的其他方法相比,其注册精度更高,且基本满足实时性要求,驾驶员无须过多分散注意力,即能获得道路信息的有效提示,从而提高行车安全。

研究过程中发现,光照、遮挡、抖动问题等因素会影响虚实注册的稳定性和准确率,这些将作为下一步研究的重点。

[2] 余艳红. 增强现实技术的研究现状及发展趋势[J]. 湖南大众传媒职业技术学院学报, 2016, 16(1): 55-57.

余艳红. 增强现实技术的研究现状及发展趋势[J]. 湖南大众传媒职业技术学院学报, 2016, 16(1): 55-57.

Yu Y H. Research status and development trend of augmented reality technology[J]. Journal of Hunan Mass Media Vocational Technical College, 2016, 16(1): 55-57.

[3] 桂振文, 刘越, 陈靖, 等. 基于自然场景在线学习的跟踪注册技术[J]. 软件学报, 2016, 27(11): 2929-2945.

桂振文, 刘越, 陈靖, 等. 基于自然场景在线学习的跟踪注册技术[J]. 软件学报, 2016, 27(11): 2929-2945.

Gui Z W, Liu Y, Chen J, et al. Online learning of tracking and registration based on natural scenes[J]. Journal of Software, 2016, 27(11): 2929-2945.

[4] FialaM. ARTag, afiducial marker system using digital techniques[C]∥Proceedings of 2005 IEEE Computer Society Conference on Computer Vision & Pattern Recognition, 2005, 2: 590- 596.

FialaM. ARTag, afiducial marker system using digital techniques[C]∥Proceedings of 2005 IEEE Computer Society Conference on Computer Vision & Pattern Recognition, 2005, 2: 590- 596.

[5] 张格, 陈昊升, 叶阳东. 一种基于LoG算子的无标识增强现实算法: LoG-PTAMM[J]. 计算机辅助设计与图形学学报, 2016, 28(9): 1577-1586.

张格, 陈昊升, 叶阳东. 一种基于LoG算子的无标识增强现实算法: LoG-PTAMM[J]. 计算机辅助设计与图形学学报, 2016, 28(9): 1577-1586.

Zhang G, Chen H S, Ye Y D. A LoG operator based markerless augmented reality algorithm: LoG-PTAMM[J]. Journal of Computer-Aided Design & Computer Graphics, 2016, 28(9): 1577-1586.

[6] 高凯珺, 孙韶媛, 姚广顺, 等. 基于深度学习的无人车夜视图像语义分割[J]. 应用光学, 2017, 38(3): 421-428.

高凯珺, 孙韶媛, 姚广顺, 等. 基于深度学习的无人车夜视图像语义分割[J]. 应用光学, 2017, 38(3): 421-428.

[7] 刘程浩, 李智, 徐灿, 等. 基于深度神经网络的空间目标常用材质BRDF模型[J]. 光学学报, 2017, 37(11): 1129001.

刘程浩, 李智, 徐灿, 等. 基于深度神经网络的空间目标常用材质BRDF模型[J]. 光学学报, 2017, 37(11): 1129001.

[8] 陆永帅, 李元祥, 刘波, 等. 基于深度残差网络的高光谱遥感数据霾监测[J]. 光学学报, 2017, 37(11): 1128001.

陆永帅, 李元祥, 刘波, 等. 基于深度残差网络的高光谱遥感数据霾监测[J]. 光学学报, 2017, 37(11): 1128001.

[9] 黄鸿, 何凯, 郑新磊, 等. 基于深度学习的高光谱图像空-谱联合特征提取[J]. 激光与光电子学进展, 2017, 54(10): 101001.

黄鸿, 何凯, 郑新磊, 等. 基于深度学习的高光谱图像空-谱联合特征提取[J]. 激光与光电子学进展, 2017, 54(10): 101001.

[10] 吴寿川, 赵海涛, 孙韶媛. 基于双向递归卷积神经网络的单目红外视频深度估计[J]. 光学学报, 2017, 37(12): 1215003.

吴寿川, 赵海涛, 孙韶媛. 基于双向递归卷积神经网络的单目红外视频深度估计[J]. 光学学报, 2017, 37(12): 1215003.

[14] LiuW, AnguelovD, ErhanD, et al. SSD: single shot multibox detector[C]∥Proceedings of 2016 European Conference on Computer Vision, 2016, 9905: 21- 37.

LiuW, AnguelovD, ErhanD, et al. SSD: single shot multibox detector[C]∥Proceedings of 2016 European Conference on Computer Vision, 2016, 9905: 21- 37.

[15] 张凯. 基于改进atrous小波分解的遥感影像快速融合方法的研究[D]. 开封: 河南大学, 2016: 66- 72.

张凯. 基于改进atrous小波分解的遥感影像快速融合方法的研究[D]. 开封: 河南大学, 2016: 66- 72.

ZhangK. Research on a rapid fusion method for remote sensing images based on an improved atrous wavelet decompsition[D]. Kaifeng: Henan University, 2016: 66- 72.

ZhangK. Research on a rapid fusion method for remote sensing images based on an improved atrous wavelet decompsition[D]. Kaifeng: Henan University, 2016: 66- 72.

[16] 许路, 赵海涛, 孙韶媛. 基于深层卷积神经网络的单目红外图像深度估计[J]. 光学学报, 2016, 36(7): 0715002.

许路, 赵海涛, 孙韶媛. 基于深层卷积神经网络的单目红外图像深度估计[J]. 光学学报, 2016, 36(7): 0715002.

[17] Besl PJ, Mckay ND. Method for registration of 3D shapes[C]∥Proceedings of 1992 Robotics-DL tentative International Society for Optics and Photonics, 1992, 14: 239- 256.

Besl PJ, Mckay ND. Method for registration of 3D shapes[C]∥Proceedings of 1992 Robotics-DL tentative International Society for Optics and Photonics, 1992, 14: 239- 256.

[18] Brostow GJ, ShottonJ, FauqueurJ, et al. Segmentation and recognition using structure from motion point clouds[C]∥Proceedings of 2008 European Conference on Computer Vision.2008, 5302: 44- 57.

Brostow GJ, ShottonJ, FauqueurJ, et al. Segmentation and recognition using structure from motion point clouds[C]∥Proceedings of 2008 European Conference on Computer Vision.2008, 5302: 44- 57.

[19] FeiT, Liang XH, He ZY, et al. A registration method based on nature feature with KLT tracking algorithm for wearable computers[C]∥Proceedings of 2009 International Conference on Cyberworlds.2009, 1: 416- 421.

FeiT, Liang XH, He ZY, et al. A registration method based on nature feature with KLT tracking algorithm for wearable computers[C]∥Proceedings of 2009 International Conference on Cyberworlds.2009, 1: 416- 421.

Article Outline

安喆, 徐熙平, 杨进华, 乔杨, 刘洋. 结合图像语义分割的增强现实型平视显示系统设计与研究[J]. 光学学报, 2018, 38(7): 0710004. Zhe An, Xiping Xu, Jinhua Yang, Yang Qiao, Yang Liu. Design of Augmented Reality Head-up Display System Based on Image Semantic Segmentation[J]. Acta Optica Sinica, 2018, 38(7): 0710004.