基于双线性卷积神经网络的视觉目标跟踪算法  下载: 903次

下载: 903次

1 引言

视觉目标跟踪已成为计算机视觉领域的一个重要研究课题,并广泛应用于视频监控、人机交互和无人驾驶等领域。视觉目标跟踪通常基于第一帧图像中的人工标注和提取的特征来建立适当的外观模型,并用于预测下一帧中目标物体的新状态。尽管目标跟踪近年来取得了相当大的进步,但其跟踪过程中的遮挡、尺度变化、快速运动和旋转方面仍然是一个具有挑战性的问题,故它是计算机视觉领域最活跃的研究领域之一[1]。

典型的跟踪算法主要分为两类。一类是基于分类的两阶段框架,另一类是基于回归的一阶段框架。对于两阶段跟踪框架,第一阶段在前一帧中获得多个候选框,第二阶段将他们分类为目标或背景。MDNet[2]是一个经典的两阶段跟踪框架,可以获得出色的结果。VITAL[3]通过引入GAN[4]进一步改进了MDNet。但是,两阶段跟踪器通常很慢且无法实时跟踪。

一阶段跟踪框架的代表算法是判别式相关滤波器(DCF),它是目标跟踪领域的重大突破之一。DCF的基本原理是学习具有闭环形式解的岭回归分类器,由于其将时域中卷积转化为傅里叶域中乘积而具有出色的计算速度,它在快速跟踪中表现良好。MOSSE[5]是第一个将DCF引入快速目标跟踪领域的跟踪算法,它对物体外观的变化具有很强的适应性,充分展示了DCF在视觉目标跟踪中的出色表现。后来人们提出了许多改进的算法,Danelljan等[6]提出了一种将颜色特征属性集成到循环结构核(CSK)[7]跟踪器中的自适应颜色跟踪方法。Henriques等[8]扩展了CSK跟踪器并提出了一个核相关滤波(KCF)跟踪器,通过搜索区域块的循环移位来生成训练样本,循环移位产生的样本具有明显的边界效应,降低了跟踪精度。杨剑锋等[9]基于KCF并结合自适应局部均值滤波实现了长时间跟踪。高美凤等[10]提出了一种自适应尺度的KCF目标跟踪算法, 在KCF的基础上引入尺度估计方法。然而循环移位产生的样本是合成样本,包含大量背景信息,故模型质量较低,且特征提取和模型更新分离,DCF很难从端到端训练中受益。

另一个一阶段跟踪框架是利用卷积神经网络(CNN)的回归模型。自从引入各种深度学习算法以来,CNN在视觉目标跟踪领域引起了广泛的关注,并在性能方面逐渐超越传统方法,从而取得了巨大的突破。Wang等先后提出了DLT[11]和SO-DLT[12],分别采用自编码网络和卷积神经网络实现了视觉目标跟踪。FCNT[13]通过分析深层网络模型中的特征组合不同的特征层,获得了新的视觉目标跟踪结果。Siamese[14]网络由于其具有两个相同的结构而引起了人们的注意。现有的跟踪器DSLT[15]设计了一个深度回归跟踪框架,实现了良好的性能。CREST[16]属于基于卷积框架的回归算法,该算法是通过逐元素求和运算来执行回归响应图的融合。

本文利用从多个卷积层提取的特征来表示目标外观,然后实现多级响应图的融合,以增加响应图的位置关联和信息交互。在不损失空间分辨率的情况下,引入用于响应图融合的双线性卷积神经网络(BCNN)[17]。BCNN实际上是两个向量的外积,最初用于细粒度分类,近年来它被引入计算机视觉的其他领域,如视觉问答[18]、纹理识别等。该方法有效地结合了两个响应图的位置关联和信息交互,但它不会损失空间分辨率,且可有效保留空间信息。最后基于OTB2013基准数据集对算法性能进行测试,测试结果可知,与现有的跟踪算法相比,BCNN的应用取得了比较有竞争力的结果。

2 基本原理

2.1 回归跟踪框架

DCF是一种基于检测式的跟踪算法,利用两个信号相似性度量进行跟踪,具有快速傅里叶变换的高效计算能力,广泛应用于实时跟踪。它通过在目标周围循环移位采集样本,并利用岭回归训练目标分类器。DCF基于傅里叶域中循环矩阵对角化的性质,可以将时域卷积操作转换为乘积操作。

本研究将DCF回归转换为单通道卷积层输出,以进行端到端训练。本文的一阶段回归算法通过训练卷积层,并使用梯度下降法优化如下的损失函数,

式中:W为卷积层的权重,其卷积核的大小与输入的搜索区域特征的大小成比例;*表示标准卷积运算;X∈ℝw×h×n表示从预训练网络中提取的输入搜索区域的特征,其中w表示特征的宽,h表示特征的高,n表示特征的通道数;Y为通过高斯函数转换的真实软标签;α为正则化系数,以避免过拟合。本研究从预训练的VGGnet[19]中提取特征,为了提高实验结果的准确度,本研究使用主成分分析(PCA)而不是卷积层来降低特征维度。

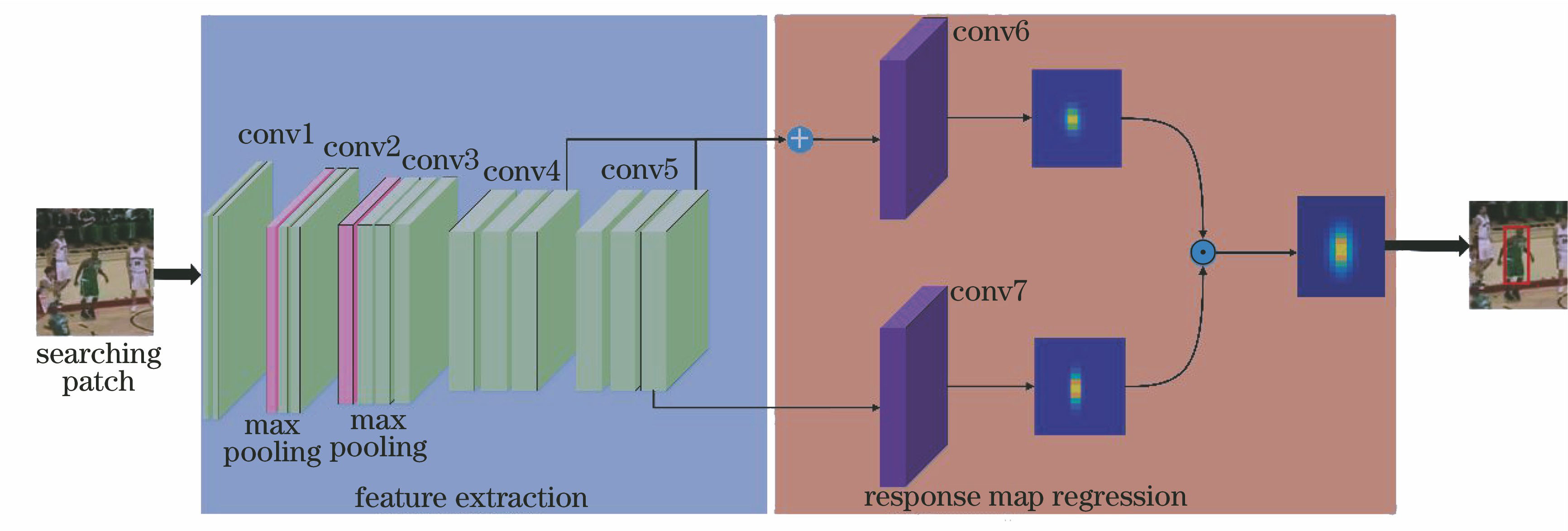

受DSLT[15]的启发,本文提出一种简单易用的跟踪模型。它是一个一阶段的端到端的深度回归框架,如

2.2 双线性卷积神经网络

在跟踪过程中,稳健的特征对于准确预测目标物体的位置非常重要。本研究充分利用从预训练网络中提取的卷积特征来编码目标物体的外观并预测响应图。与传统的逐元素相加或相乘的融合方法不同,本文使用BCNN算法进行响应图融合。BCNN在细粒度识别任务中具有出色的表现。具体地说,它是一种特征交互操作,可通过外积操作结合成对的矢量。

假设f,g是成对的响应图向量,他们必须具有相同的空间分辨率大小,但维度可以不同。 这里假设,f∈

这样就可以得到向量B∈

由于输出向量B的维度大小是两个原始输入通道大小的乘积,因此维度较高,进而导致计算量迅速增加。为了解决这个问题,采用紧凑的双线性池化(Compact Bilinear Pooling)[20],即紧凑的特征表示方法(Tensor Sketch方法),来有效地减小计算量。BCNN结合了两个分支的回归响应图,这种联合表示方式可以捕获两个响应图之间不同的语义和外观信息,从而获得两个分支响应图的丰富位置关联,这对于在视觉目标跟踪任务中目标位置的预测非常有用。

2.3 跟踪过程

给定第一帧图像的真实标签,在第一帧图像的边界框附近裁剪获得搜索区域,该搜索区域被馈送到预训练的VGGnet中以提取特征。然后,多层特征进入回归框架以获得响应图。因此,可以通过回归响应图来预测目标在第二帧中的位置,并获得响应图的最大值。当预测下一帧中目标的位置时,在当前帧的预测位置周围裁剪获得搜索区域。随着跟踪的进行,目标会发生较大变化,因此要每隔t帧更新一次模型。整个过程包括端到端的训练和模型更新,重复上述过程,逐渐更新回归网络。

3 实验

3.1 实验设置

本文的框架是基于Caffe[21]工具箱,在MATLAB平台设计的。本研究使用CPU Intel Xeon E5-2620和GPU GeForce GTX 1080Ti的计算机进行实验。用于特征提取的骨干网络是预先训练的VGGnet[19],本文提取它的cov4_3和conv5_3的特征,并删除conv3_3后面的池化层,仅保留前两个池化层,以保证cov4_3和conv5_3具有相同的空间分辨率。本研究通过PCA将通道数减小到256。用Adam[22]方法训练本文的网络,训练和测试阶段的网络学习率分别为2×10-8和1×10-8。每t=7帧执行一次模型的更新,算法的运行速度是1.0 frame/s。

3.2 数据库和度量准则

本研究在标准数据基准OTB2013[23]上进行了实验,其中包含50个具有挑战性的视频序列。其中名为jogging的序列存在两个不同的跟踪目标。每个序列都有不同的属性标签,可以应对不同的挑战情况,包括遮挡、尺度变化、变形、光照变化、低分辨率、超出视野外、运动模糊、平面内旋转、快速运动、背景杂乱、平面外旋转。

本研究利用广泛使用的方法一次通过评估(OPE)来测量本文在数据集上的算法性能。这两个主要的评估指标包括准确率图和成功率图。前者用于估计边界框中心与真实值之间的距离,它计算了距离小于给定阈值的帧所占的比率,阈值通常设置为20 pixel;后者用于估计边界框和真实值之间的重叠分数(OS)。

3.3 消融实验

为了证明基于BCNN算法的回归响应图融合方式的有效性,设计了一个对比实验,如

结果表明,BCNN操作在准确率上有很小的性能损失,但成功率上有很大提高。BCNN在提高成功率方面具有出色表现的原因在于它以表征不变的方式捕获局部响应图的交互和关联。BCNN可以很好地整合响应图的位置变化,因此相比简单的逐元素求和,它具有更好的表现。

图 3. 在OTB2013数据集上对比算法与基础网络的对比。(a)准确率图;(b)成功率图

Fig. 3. Comparison algorithm on OTB2013 dataset with baseline network. (a) Precision; (b) success rate

3.4 与其他算法的对比

本文算法与OTB2013[23]数据集上现有的15种跟踪算法进行比较,包括STAPLE_CA[24],DeepSRDCF[25],HDT[26],SINTflow[27],ECO-HC[28],FCNT[13],LCT[29],SRDCFdecon[30],Staple[24], KCF[8],DLT[11],DSST[31],SAMF[32],CSR-DCF[33],MOSSE_CA[5]。

整体性能如

图 4. 在OTB2013数据集上与其他跟踪算法的比较。(a)准确率图;(b)成功率图

Fig. 4. Comparison algorithm on OTB2013 dataset with other algorithms. (a) Precision; (b) success rate

如

4 结论

本文设计了一个独特的深度回归网络,它集成了基于双线性卷积神经网络(BCNN)算法的新型回归响应图融合方法。BCNN结合两个响应图并捕获两个图的位置关联和交互信息,通过这种响应图融合方法可以更加准确地预测目标物体的位置。BCNN方法可以与一阶段回归网络完美结合,端对端地训练,显著提高了跟踪性能。结合这种响应图融合方法,基于OTB2013基准数据集进行测试,本文算法相比其他跟踪算法,取得了比较有竞争力的结果。

[1] 何雪东, 周盛宗. 快速尺度自适应核相关滤波目标跟踪算法[J]. 激光与光电子学进展, 2018, 55(12): 121501.

[2] NamH, HanB. Learning multi-domain convolutional neural networks for visual tracking[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 4293- 4302.

[3] Song YB, MaC, Wu XH, et al. VITAL: visual tracking via adversarial learning[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT. New York: IEEE, 2018: 18326240.

[4] GoodfellowI, Pouget-AbadieJ, MirzaM, et al. Generative adversarial nets[C]∥Advances in Neural Information Processing Systems, December 8-13, 2014, Montreal, Quebec, Canada. [S. l. : s. n.], 2014: 2672- 2680.

[5] BolmeD, Beveridge JR, Draper BA, et al. Visual object tracking using adaptive correlation filters[C]∥2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition, June 13-18, 2010, San Francisco, CA, USA. New York: IEEE, 2010: 2544- 2550.

[6] DanelljanM, Khan FS, FelsbergM, et al. Adaptive color attributes for real-time visual tracking[C]∥2014 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2014, Columbus, OH, USA. New York: IEEE, 2014: 1090- 1097.

[7] Henriques JF, CaseiroR, MartinsP, et al. Exploiting the circulant structure of tracking-by-detection with kernels[M] ∥Fitzgibbon A, Lazebnik S, Perona P, et al. Computer vision-ECCV 2012. Lecture notes in computer science. Berlin: Springer, 2012, 7575: 702- 715.

[8] Henriques J F, Caseiro R, Martins P, et al. High-speed tracking with kernelized correlation filters[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(3): 583-596.

[9] 杨剑锋, 张建鹏. 基于核相关滤波的长时间目标跟踪[J]. 激光与光电子学进展, 2019, 56(2): 021502.

[10] 高美凤, 张晓玄. 尺度自适应核相关滤波目标跟踪[J]. 激光与光电子学进展, 2018, 55(4): 041501.

[11] WangN, Yeung DY. Learning a deep compact image representation for visual tracking[C]∥Advances in Neural Information Processing Systems, December 5-8, 2013, Lake Tahoe, Nevada, United States. [S. l. : s. n.], 2013: 809- 817.

[12] Wang NY, Li SY, GuptaA, et al. ( 2015-04-23)[2019-05-16]. https:∥arxiv.gg363.site/abs/1501. 04587.

[13] Wang LJ, Ouyang WL, Wang XG, et al. Visual tracking with fully convolutional networks[C]∥2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 3119- 3127.

[14] BertinettoL, ValmadreJ, Henriques JF, et al. Fully-convolutional Siamese networks for object tracking[M] ∥Hua G, Jégou H. Computer vision-ECCV 2016 Workshops. Lecture notes in computer science. Cham: Springer, 2016, 9914: 850- 865.

[15] Lu XK, MaC, Ni BB, et al. Deep regression tracking with shrinkage loss[M] ∥Ferrari V, Hebert M, Sminchisescu C, et al. Computer vision-ECCV 2018. Lecture notes in computer science. Cham: Springer, 2018, 11218: 369- 386.

[16] Song YB, MaC, Gong LJ, et al. CREST: convolutional residual learning for visual tracking[C]∥2017 IEEE International Conference on Computer Vision (ICCV), October 22-29, 2017, Venice, Italy. New York: IEEE, 2017: 2574- 2583.

[17] Lin TY, RoyChowdhury A, Maji S. Bilinear CNN models for fine-grained visual recognition[C]∥2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 1449- 1457.

[18] FukuiA, Park DH, YangD, et al. and visualgrounding[J/OL]. ( 2016-09-24)[2019-05-16]. https:∥arxiv.gg363.site/abs/1606. 01847.

[19] SimonyanK, Zisserman A. Very deep convolutional networks for large-scale image recognition[J/OL]. ( 2015-04-10)[2019-05-16]. https:∥arxiv.gg363.site/abs/1409. 1556.

[20] GaoY, BeijbomO, ZhangN, et al. Compact bilinear pooling[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 317- 326.

[21] Jia YQ, ShelhamerE, DonahueJ, et al. Caffe: convolutional architecture for fast feature embedding[C]∥Proceedings of the ACM International Conference on Multimedia - MM '14, November 3-7, 2014, Orlando, Florida, USA. New York: ACM, 2014: 675- 678.

[22] Kingma DP, Ba J. Adam: a method for stochastic optimization[J/OL]. ( 2017-01-30)[2019-05-16]. https:∥arxiv.gg363.site/abs/1412. 6980.

[23] WuY, LimJ, Yang MH. Online object tracking: a benchmark[C]∥2013 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2013, Portland, OR, USA. New York: IEEE, 2013: 13824581.

[24] BertinettoL, ValmadreJ, GolodetzS, et al. Staple: complementary learners for real-time tracking[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 1401- 1409.

[25] DanelljanM, HagerG, Khan FS, et al. Convolutional features for correlation filter based visual tracking[C]∥2015 IEEE International Conference on Computer Vision Workshop (ICCVW), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 621- 629.

[26] Qi YK, Zhang SP, QinL, et al. Hedged deep tracking[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 4303- 4311.

[27] TaoR, GavvesE, Smeulders A W M. Siamese instance search for tracking[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 16526810.

[28] DanelljanM, BhatG, Khan FS, et al. ECO: efficient convolution operators for tracking[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 6931- 6939.

[29] MaC, Yang XK, Zhang CY, et al. Long-term correlation tracking[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 7-12, 2015, Boston, MA, USA. New York: IEEE, 2015: 5388- 5396.

[30] DanelljanM, HagerG, Khan FS, et al. Adaptive decontamination of the training set: a unified formulation for discriminative visual tracking[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 1430- 1438.

[31] DanelljanM, HägerG, Shahbaz KhanF, et al.Accurate scale estimation for robust visual tracking[C]∥Proceedings of the British Machine Vision Conference 2014, September 2014, Nottingham.UK: BMVA Press, 2014.

[32] LiY, Zhu JK. A scale adaptive kernel correlation filter tracker with feature integration[M] ∥Agapito L, Bronstein M, Rother C. Computer vision - ECCV 2014 Workshops. Lecture notes in computer science. Cham: Springer, 2015, 8926: 254- 265.

[33] LukezicA, VojirT, Zajc LC, et al. Discriminative correlation filter with channel and spatial reliability[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 4847- 4856.

Article Outline

张春婷. 基于双线性卷积神经网络的视觉目标跟踪算法[J]. 激光与光电子学进展, 2020, 57(4): 041501. Chunting Zhang. Visual Object Tracking Based on Bilinear Convolutional Neural Network[J]. Laser & Optoelectronics Progress, 2020, 57(4): 041501.