基于判别协作表征分类器的人体行为识别  下载: 950次

下载: 950次

1 引言

人体行为识别是模式识别、机器学习、计算机视觉领域的研究热点。近年来,人体行为识别技术被应用于多个领域,如群体行为识别已应用于智能监控系统和人机交互游戏等[1-3]。当前,人体行为识别主要针对4种对象:基于视频流序列[4-5],静态图像序列,深度图像序列和可穿戴传感器。基于静态图像序列的行为识别关注度很高,但是由于二维图像容易受到环境变化以及光照变化的影响,在实际应用中效果并不理想。由于深度信息具有背景简单、受环境影响小等特点,基于深度信息序列的行为识别逐渐成为新兴热点。

人体行为识别最重要的两个步骤为特征提取和行为分类。特征提取方面,文献[ 6]首先将深度运动图像投影到3个视角上,通过差分、阈值化和累加计算得到每个视角下的深度运动映射图(DMMs),然后从DMMs提取方向直方图特征(HOG)作为人体行为特征描述子。虽然,DMMs-HOG特征描述子可以有效地表达出运动对象的形状和运动信息,但是高维的特征增加了计算复杂度,难以保证实时性。文献[ 7]对DMMs-HOG特征描述子进行了改进,省略了HOG特征提取,降低了计算复杂度,提高了人体行为识别的实时性。

行为分类方面,最常用的分类器为支持向量机(SVM),但是需要先进行训练,再进行测试。当数据量大时,SVM训练的时间过长。大量实验证明,稀疏表示分类器(SRC)可以有效解决人脸识别和图像分类等问题[7-12],且SRC所需训练时间短,甚至不需要训练。Wright等[8]最早提出SRC,对系数进行了1范数约束,最终优化得到的系数向量具有稀疏性,但是SRC的优化求解较为困难。Zhang等[9]认为,2范数约束不仅使优化过程变得简单,而且识别率相较于1范数约束没有发生下降,基于此,提出了协作表征分类器(CRC)。文献[ 7]提出了2范数正则化CRC(L2-CRC),并将其应用到人体行为识别领域。首先对深度动作序列提取DMMs特征描述子,然后利用提出的分类器进行稀疏编码及分类,从而实现对人体行为的实时识别。文献[ 10]提出了稀疏增强CRC,结合稀疏特征和密集特征对测试样本进行分类,在人脸库等公开的数据集上进行验证,得到很好的分类结果。文献[ 11]将常见的线性回归分类器和协作表征分类器结合起来,在人脸库得到了良好的识别效果。文献[ 12]将稀疏表示分类器和k近邻结合起来,提出一种稳健性强的高光谱图像分类方法。

虽然,SRC/CRC通过对表征系数进行约束增加了稀疏性,降低了过拟合的风险,然而当训练集中有2类动作非常相似时,这2类样本对重构测试样本的贡献力度相近,那么利用测试样本和重构样本之间残差的分类规则产生的误分类概率就会变大。为此,本文基于L2-CRC[9]提出判别协作CRC(DCRC),通过对协作表征系数的两次2范数约束,得到重构能力较强的协作表征系数,并使用新的分类规则来判定测试样本的类别,提高分类器的分类精度。

2 特征提取

DMMs特征描述子[9]具有实时性高、计算简单的特点,因此,参照文献[ 7]中的方法提取DMMs特征描述子。

首先将N帧动作深度序列的每一帧深度图都投影到笛卡尔直角坐标系的三个方向上,得到三幅视图(前视图、侧视图、上视图)。这一操作可以将一个三维的深度图像映射成为三个二维图像,分别用mf、ms、mt表示三个二维图。然后分别计算相同视角下连续两帧投影图之差的绝对值,累加得到DMMs特征描述子:

式中

提取到的DMMs特征描述子通过限位框来提取非0区域,即感兴趣区域,从而更加精确地捕捉运动动作的变化区域。最后,经过PCA降维处理,得到最终的DMMs特征描述子。由(1)式可以看出,DMMs特征描述子的计算非常简单,可有效提高特征提取阶段的实时性,并且该特征将三维图像映射为二维图像,将行为识别问题转化成为图像分类问题。

3 行为分类

3.1 CRC

CRC是一种非常有效的分类器,它认为测试样本可以由所有训练样本近似线性表示。给定一个具有K类的训练样本集合D=

输入:训练样本集合,测试样本y,正则化参数λ。

1) 基于目标函数,优化协作表征系数向量:

式中f(α)为关于α的函数。

2) 计算重构样本和测试样本间的残差:

式中

3) 计算测试样本的标签

输出:label(y)。

L2-CRC使用Tikhonov矩阵作为正则项对协作表征系数进行约束,目标函数为

式中Γ为Tikhonov正则矩阵,形式如下:

在对(5)式进行优化求解时,Γ可以对系数向量α提供先验知识,从而更精确地逼近最优解,得到的表征系数向量α相较于CRC更加稳健。但对于具有相似动作的训练样本,利用表征系数向量α重构出来的相似样本之间判别性不强。本文通过二次约束项来提升表征系数α的判别性和分类器的性能。

3.2 DCRC

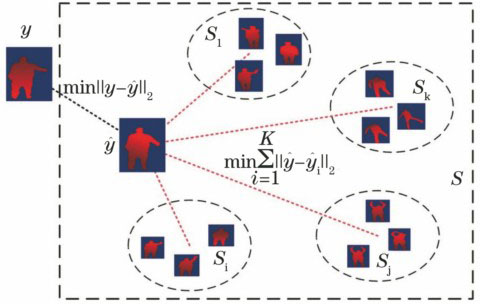

用S来表示由所有训练样本协作张成的线性空间,用Si表示由一个相同类别的样本Di(i=1,2,…,K)张成的线性子空间,用L=

为了提高CRC对相似动作的判别性,提高分类器的性能,本文通过对系数进行二次约束获得判别性强的协作表征系数,据此提出DCRC。首先,确定空间S中一个共享样本点

由经验可知,当2个样本距离越近时,这2个样本属于同一类的概率就越大。假设所有样本都是独立分布的,用l(y)表示样本y的标签,则测试样本y属于类别i的概率为

由于样本之间相互独立,那么P

式中P

为了降低过拟合的风险与计算复杂度,利用文献[ 6]中的Tikhonov矩阵正则项进行约束,得到最终的目标函数:

式中λ和μ为正则化约束参数,都是标量;

约束项

令

与CRC模型的最优解结合起来,可以得到判别协作表征分类器的最优解:

最后,采用一个新的判别规则来判定测试样本的类别:

4 实验结果

在MSR Action 3D Dataset和UTD-MHAD数据集上对所提出的行为识别方法进行验证。

4.1 参数分析

(10)式中包含2个正则化参数λ和μ,有利于表征系数更好地拟合训练数据,且保持表征系数的值较小,防止出现参数过大、过拟合的情况。正则化参数值不能过大或者过小:过大的正则化参数会使最终的表征系数趋近于0,产生欠拟合的情况,模型的泛化能力会很差;过小的表征系数容易造成过拟合的情况。根据经验,正则化参数的取值一般在0.1~1之间。

4.2 MSR Action 3D Dataset

MSR Action 3D Dataset是深度摄像头采集到的深度序列动作集,包含20个动作,每个动作由10个人进行演示,每次演示2~3次,采集到的深度图分辨率为320 pixel×240 pixel。为了保证试验的公正性,采用文献[ 7]中的设置。

从

为了验证DCRC的稳定性,随机选择实验对象的演示动作作为训练数据,其余作为测试数据,进行100次实验,计算平均识别率和平均标准差,结果如

将编号为1、3、5、7、9的对象所演示的所有动作作为训练数据,其余的作为测试数据,使用相同的特征描述子,不同分类器的识别率如

高到93%,Draw x的识别率提高到85.7%,Draw circle的识别率提高到60%,同时,其他动作,如bend的识别率达到100%。这表明DCRC可以提高对相似动作的识别率。

图 2. MSR Action 3D数据集上DMMs+CRC(a)与DMMs+DCRC(b)的混淆图

Fig. 2. Confusion matrix of DMMs+CRC (a) and DMMs+DCRC (b) on MSR Action 3D dataset

表 1. MSR Action 3D数据集上不同方法的识别率

Table 1. Recognition rates of different methods on MSR Action 3D dataset%

|

表 2. MSR Action 3D数据集上实验4的平均识别率和平均标准差

Table 2. Average recognition rates and its standard deviation of MSR Action 3D dataset on test 4

| |||||||||||||||||||||||||||||||||||||||||

表 3. MSR Action 3D数据集DMMs特征下不同分类器的识别率

Table 3. Recognition rates of different classifier on MSR Action 3D dataset with DMMs features

|

表 4. MSR Action 3D数据集上不同方法的识别率

Table 4. Recognition rates of different methods on MSR Action 3D dataset

|

4.3 UTD-MHAD

Chen等[20]提出了一个新的行为识别数据集,命名为 UTD Multimodal Human Action Dataset (UTD-MHAD)。该数据集包含多种模式:RGB视频序列,深度序列,由Kinect采集的骨骼点位置信息,可穿戴式传感器采集的加速和旋转信号。共包含27个动作,每个动作由8个人来演示(4男4女),每个动作演示4遍。除去3个损坏的序列,该数据集一共包含861个动作序列。

在UTD-MHAD数据集上,选择编号为1、3、5、7的对象所演示的动作作为训练数据,剩余的作为测试数据,最终的识别率如

表 5. UTD-MHAD数据集上不同方法的识别率

Table 5. Recognition rate of different methods on UTD-MHAD dataset

|

图 3. UTD-MHAD数据集上DMMs+CRC(a)与DMMs+DCRC(b)的混淆图

Fig. 3. Confusion matrix of DMMs+CRC (a) and DMMs+DCRC (b) on UTD-MHAD dataset

5 结论

提出了DCRC,通过对协作表征系数的二次约束,增强了对相似动作的判别性,提升了分类器的性能。基于该分类器进行人体行为识别。首先,采用复杂度低、实时性好的DMMs作为动作的特征描述子,然后,利用DCRC对提取的DMMs特征描述子进行分类识别,从而实现人体行为识别。在两个数据集上的实验结果表明,DCRC对相似动作具有一定的判别性,且较现有的一些方法具有更高的识别率。虽然DCRC可以提升对相似动作的识别率,但提升的效果有限,因此下一步工作将使用多尺度的深度运动映射图特征来进一步提高对相似动作的识别能力。

[2] ChenC, KehtarnavazN, JafariR. A medication adherence monitoring system for pill bottles based on a wearable inertial sensor[C]// Proceedings of the 36th International Conference of the IEEE Engineering in Medicine and Biology Society, 2014: 4135- 4138.

[3] 张旭光, 刘春霞, 左佳倩. 基于因果网络分析的小规模人群行为识别[J]. 光学学报, 2015, 35(8): 0815001.

[4] 蔡加欣, 冯国灿, 汤鑫, 等. 基于局部轮廓和随机森林的人体行为识别[J]. 光学学报, 2014, 34(10): 1015006.

[5] 蔡加欣, 冯国灿, 汤鑫, 等. 基于姿势字典学习的人体行为识别[J]. 光学学报, 2014, 34(12): 1215002.

[6] YangX, ZhangC, TianY. Recognizing actions using depth motion maps-based histograms of oriented gradients[C]// Proceedings of the 20th ACM International Conference on Multimedia, 2012: 1057- 1060.

[9] ZhangL, YangM, FengX. Sparse representation or collaborative representation: which helps face recognition[C]. IEEE International Conference on Computer Vision, IEEE, 2012: 471- 478.

[10] AkhtarN, ShafaitF, MianA. Sparseness helps: sparsity augmented collaborative representation for classification[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2015: 1- 10.

[13] LiW, ZhangZ, LiuZ. Action recognition based on a bag of 3D points[C]. IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops (CVPRW), 2010: 9- 14.

[14] Vieira 1 AW, Nascimento ER, Oliveira1 GL, et al. Stop: space-time occupancy patterns for 3D action recognition from depth map sequences[M]. Heidelberg: Springer, 2012: 252- 259.

[15] YangX, TianY. Eigen joints-based action recognition using naive-bayes-nearest-neighbor[C]. IEEE Conference on Computer Vision and Pattern Recognition Workshops, 2012: 14- 19.

[16] OreifejO, LiuZ. HON4D: histogram of oriented 4D normals for activity recognition from depth sequences[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2013: 716- 723.

[17] RahmaniH, MahmoodA, Huynh DQ, et al. Real time action recognition using histograms of depth gradients and random decision forests[C]. Applications of Computer Vision, IEEE, 2014: 626- 633.

[19] EvangelidisG, SinghG, HoraudR. Skeletal quads: human action recognition using joint quadruples[C]. International Conference on Pattern Recognition, 2014: 4513- 4518.

[20] ChenC, JafariR, KehtarnavazN. UTD-MHAD: A multimodal dataset for human action recognition utilizing a depth camera and a wearable inertial sensor[C]. IEEE International Conference on Image Processing, 2015: 168- 172.

Article Outline

昝宝锋, 孔军, 蒋敏. 基于判别协作表征分类器的人体行为识别[J]. 激光与光电子学进展, 2018, 55(1): 011010. Zan Baofeng, Kong Jun, Jiang Min. Human Action Recognition Based on Discriminative Collaborative Representation Classifier[J]. Laser & Optoelectronics Progress, 2018, 55(1): 011010.