稳健的双模型自适应切换实时跟踪算法  下载: 797次

下载: 797次

1 引言

视觉跟踪是计算机视觉领域研究的热点之一,其主要任务是在视频第一帧指定目标,然后在后续视频序列中确定目标的位置及其所在的区域,为分析目标的状态和运动轨迹等做准备,在视频监控、智能交通、人机交互、医疗等领域具有广泛的应用,并要求能够达到实时准确的效果。随着计算机性能的快速发展与跟踪算法的不断完善,虽然算法的跟踪性能不断提升,但在实际应用中,当目标遇到尺度变化、遮挡、光照变化、快速运动等复杂情况时,快速精确地跟踪目标仍然面临严峻的考验。

判别式目标跟踪方法是视觉跟踪中重要的一类方法,主要通过在第一帧目标区域和背景区域提取正负样本,利用提取到的样本训练目标分类器,在当前帧利用训练好的分类器来预测目标的位置。其中,相关滤波具有良好的跟踪效果和较快的计算速度,近年来得到了快速发展。Bolme等[1]将相关滤波应用到目标跟踪领域,使用灰度特征来表征目标,跟踪速度达到600 frame/s;Henriques等[2]在相关滤波基础上结合循环矩阵理论和快速傅里叶变换设计了基于稠密采样的快速目标跟踪,解决了训练样本不足的问题。随后,研究者们提出了多种改进的相关滤波跟踪算法。改进的方式主要为三类。第一类是改进目标特征的提取方法。传统目标特征提取方法的改进主要有方向梯度直方图(HOG)特征[3-4]、颜色属性(CN)[5]、颜色直方图特征、HOG和CN特征的组合[6-7],HOG和颜色直方图的组合[8-9]。随着卷积神经网络(CNN)在目标检测和识别等领域取得的重大突破,卷积特征强大的表征能力吸引着众多学者,并开始充分应用到目标跟踪领域。Ma等[10]将分层卷积特征与相关滤波相结合,该算法在实际测试中具有精度高、性能稳定等优点,但未达到实时的效果。Huang等[11]提出一种自适应深度特征选择跟踪策略,提升了利用卷积特征跟踪时的速度。Wang等[12]对ImageNet上预训练得到的卷积特征在目标跟踪中的性能进行深入分析,并根据分析结果设计出特征筛选网络和两个互补的预测网络,通过集成思想预测目标位置,对目标本身的形变具有较好的稳健性。由于卷积特征不像HOG、CN等传统特征具有明显的特性,因此研究者们将局部的统计特征HOG、全局特征CN和颜色直方图等特征进行组合以获取更好的跟踪效果。Ma等[13]在核相关滤波跟踪器中,融合卷积特征、HOG特征,以及局部强度直方图特征(HOI)进行跟踪,该算法跟踪精度较高,王艳川等[14]在基于在线检测和尺度自适应的相关滤波跟踪算法中融合HOG、CN、光照不变性特征进行目标定位,有效提升了目标跟踪过程中遇到遮挡、尺度变化等问题时的稳健性。Danelljan等[6]使用卷积特征、HOG特征、CN特征训练多个滤波器,对所有特征的响应进行加权求和预测目标的位置,虽然跟踪精度高,但跟踪速度慢。Ma等[15]在分层卷积相关滤波算法的基础上,为防止由于遮挡和超出视野导致的跟踪失败问题,额外训练一个HOG相关滤波器,当定位失败时,进行重新检测定位目标,提升了原算法的跟踪精度。

第二类改进是相关滤波分类器本身的改进。Henriques等[3]提出核相关滤波跟踪算法,利用循环矩阵在傅里叶空间可对角化的性质来简化计算,速度达到172 frame/s。Danelljan等[4]对核相关滤波算法进行了改进,在损失函数中引入空间正则化惩罚项,有效地解决了由循环矩阵导致的边缘效应。Song等[16]通过图像前景与背景的颜色直方图特征进行空域的可靠性判断,缓解边界效应。Danelljan等[6]在核相关滤波跟踪算法的基础上,提出一种连续空间域的卷积操作理论框架,将相关滤波跟踪算法的精度提升到新的高度,但速度慢。

第三类改进是通过引入尺度估计算法或其他辅助算法提升相关滤波跟踪效果。Danelljan等[17]融入尺度金字塔策略,训练尺度相关滤波器,预测目标在运动过程中的尺度变化。潘振福等[18]将灰度图像金字塔映射到一维特征向量进行尺度预测,对于目标尺度变化、姿态变化等具有较强的适应性。王鑫等[19]提出多层卷积特征融合的目标尺度自适应稳健跟踪算法,在多层卷积相关滤波跟踪算法的基础上融入了尺度金字塔策略。Danelljan等[6]减少尺度金字塔的变化数,在尺度相关滤波器中融入卷积特征进行尺度预测。Galoogahi等[20]融入目标的背景信息训练相关滤波器,辅助定位目标,提升了目标发生形变遮挡时定位的准确性。Ma等[21]训练多个相关滤波器,在跟踪不准确时,采用辅助滤波器重定位的方式提升算法的稳健性。赵高鹏等[22]利用峰值旁瓣比自适应分配权重融合多特征的响应图,然后根据融合响应图的峰值旁瓣比进行自适应模型更新,跟踪性能较为稳定。

此外,还有一些通过深度卷积特征降维提升相关滤波跟踪速度的方法。Wang等[23]对分层卷积目标跟踪算法进行改进,训练多尺度域滤波器进行跟踪,对卷积特征降维,提升跟踪的速度,达到实时性要求,但跟踪的精度还要进一步提高。蔡玉柱等[24]提出了基于主成分分析降维的自适应卷积特征目标跟踪算法,部分解决了空间正则化相关滤波跟踪算法在旋转变化、超出视野和严重遮挡情况下跟踪失败的问题。Danelljan等[7]采用因式分解的方式对卷积特征进行稀疏选择来降低模型的复杂度,采用样本的空间结构对模型进行更新来降低内存与时间的复杂度,同时采用稀疏模型更新策略防止模型过拟合,提升了算法的精度和速度,但该算法使用卷积特征的跟踪算法速度大约是8 frame/s。

综上,使用传统灰度特征、HOG特征、颜色特征的相关滤波跟踪算法[1-5],虽然跟踪速度快,能达到实时的要求,但其特征表达具有局限性,跟踪效果有待进一步提高。采用CNN特征,或是与CNN特征组合的算法可以取得很好的跟踪效果,但跟踪速度未达到实时的效果,需要进一步提高。使用深度卷积特征的算法跟踪速度非常快,但跟踪的精度不够高[25]。因此,现有相关滤波跟踪算法的实时性和稳健性还没达到很好的平衡。为此,本文提出双模型自适应切换的目标跟踪算法,使用自适应卷积特征选择方法降低卷积特征通道维度,采用稀疏更新的策略提高算法的稳健性和实时性。

2 算法整体框架

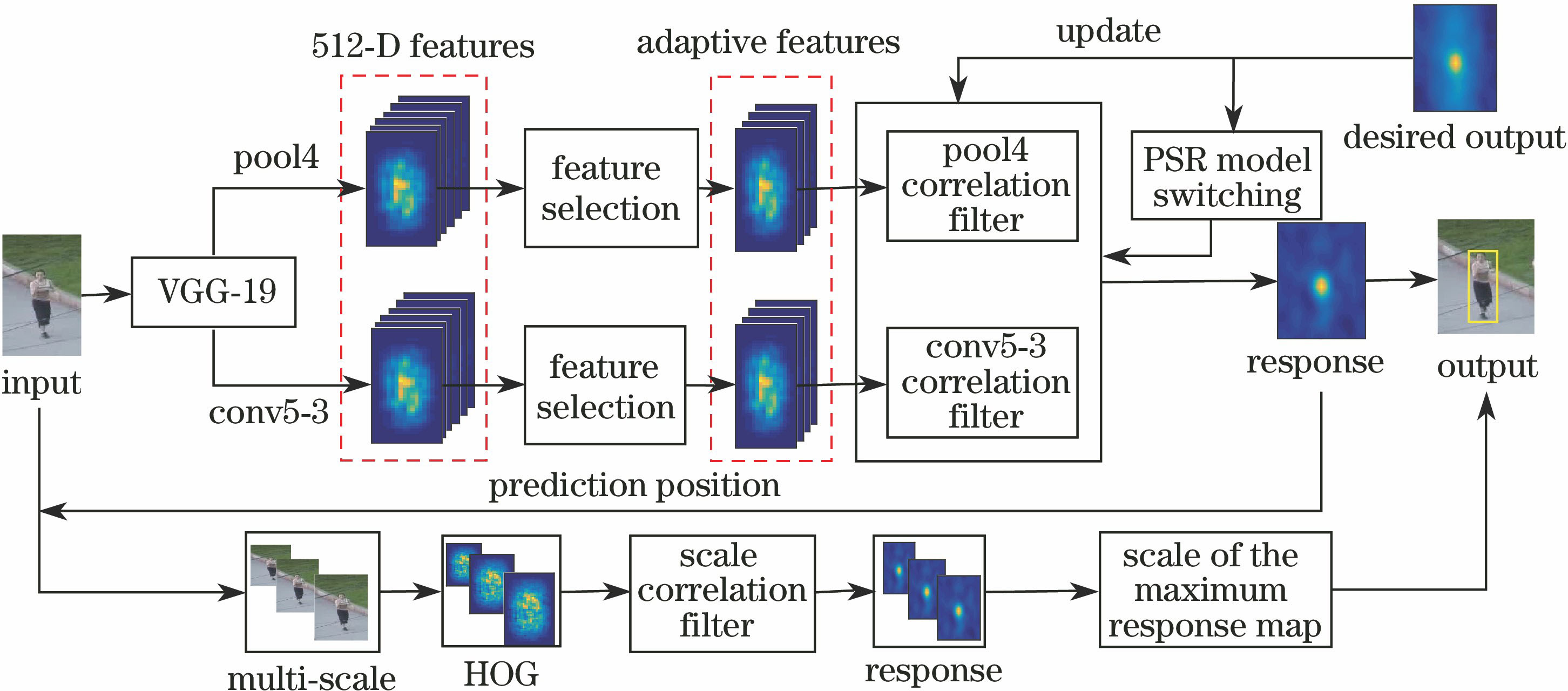

在分层卷积相关滤波跟踪算法的基础上,提出一种稳健的自适应卷积特征选择,以及双模型自适应切换的实时跟踪算法。算法的整体流程如

双模型切换跟踪实例结果如

图 2. 单层自适应特征与模型切换跟踪部分结果。(a) Skiing; (b) Walking2; (c) Freeman1; (d) Tiger1

Fig. 2. Partial tracking results of single-layer adaptive features and model switching. (a) Skiing; (b) Walking2; (c) Freeman1; (d) Tiger1

3 自适应卷积特征选择算法

VGG-19模型在ImageNet数据集上训练得到,包含16层的5组卷积层(conv1~conv5),图像经VGG-19模型前向运算提取特征,低层的卷积特征可更好地保留目标自身的位置和空间信息。随着网络深度的增加,因池化操作得到的卷积特征分辨率不断降低,空间位置信息减少,但包含的语义信息更多。如

图 3. 目标在不同卷积层的特征信息表达。(a)目标图像;VGG-19的(b) pool4和(c)conv5-3输出卷积特征

Fig. 3. Expression of object characteristics in different convolution layer. (a) Target image; output convolution feature of (b) pool4 and (c) conv5-3 with VGG-19

为了防止过拟合,提高模型的泛化能力,在训练深度模型时,会随机舍弃部分神经元,而神经元与特征所包含的语义信息之间具有密切的联系,因此所提取到的卷积图具有稀疏性。有效去除没有激活的神经元对应的卷积图,对提升跟踪的速度和精度都有重大影响,因此,本文利用跟踪目标和搜索区域之间的特征关系提出一种自适应特征选择算法。

相关滤波跟踪算法在获取到新一帧的图片时,会根据上一帧目标的位置,确定目标的搜索区域,然后提取搜索区域的特征,根据特征的相关滤波最大响应值来确定目标的位置,因此,好的目标特征应该满足目标区域的滤波响应值大、其他区域的滤波响应值小,即目标区域应该具有更大的特征值,而非目标区域的特征值小。由此可知,使用目标区域和搜索区域的卷积特征能量均值比来评估深度卷积特征,均值比越大,卷积特征对目标区域的响应越大,对背景区域的响应越小,反之亦然。因此,通过选择满足卷积特征能量均值大于给定阈值的卷积通道、去除不满足条件的特征通道来提升算法跟踪性能。通过VGG-19网络提取的第

为避免被零除,增加系数1。

图 4. 自适应卷积特征选择(a)前、(b)后对比图

Fig. 4. Comparison of images (a) before and (b) after adaptive convolution features selection

4 双模型自适应切换算法

相关滤波跟踪算法对输入特征进行循环平移稠密采样,利用快速傅里叶变换高效训练相关滤波分类器,计算所有循环平移测试样本的响应值,寻找响应值中最大值的位置来定位目标,具有很好的跟踪实时性。本文将自适应选择后的分层卷积特征与相关滤波相结合,针对双层卷积特征训练双跟踪模型,通过模型跟踪输出的相关滤波响应的峰旁比,实现模型的自适应选择,提升算法的跟踪精度。

4.1 训练双模型相关滤波分类器

对于给定视频的第一帧,先获取目标块的第

式中

利用傅里叶变换卷积特征快速求解可得到分类器

式中:

4.2 预测目标位置

选取的VGG-19中pool4和conv5-3卷积特征的网络层深度不同,所包含的语义信息也不同,针对不同形状、场景、背景下目标的表征能力也不同。为了充分利用这两层特征,第一帧训练完分类器

式中:F-1为傅里叶逆变换,

相关滤波跟踪算法通过特征响应的最大值来预测目标位置,相关滤波响应图的PSR可以很好地表示最大响应值与响应图其他位置响应值之间的关系[26]。当目标定位较为准确时,PSR值较高,反之亦然,因此可以用来评估定位的准确性。在视频第

式中

图 5. Freeman1视频跟踪过程的PSR与最大响应值变化曲线。(a) PSR变化曲线;(b)最大响应值变化曲线

Fig. 5. PSR and maximum response curves of Freeman1 video tracking process. (a) PSR curves; (b) maximum response curves

4.3 模型更新

双模型自适应切换跟踪算法属于在线跟踪模型,只能以跟踪序列第一帧作为模型的训练数据,但是在一段视频序列中,目标一直处于运动状态,会发生尺度和形状的改变,因此需要对模型进行不断更新以适应目标的变化。现有的部分基于相关滤波的跟踪算法[4,6,10,15,17]每一帧更新一次模型,但是在一段视频序列中,相邻两帧图片之间目标的变化很小,如果每一帧都对模型进行更新,容易造成时间浪费,并且当目标遇到遮挡或相似物的干扰时,容易出现模型漂移,因此,文献[

23,27]中采用稀疏模型更新策略。受以上文献的启发,经实验验证,采用每两帧更新一次模型的策略,减少模型的过拟合,提高算法跟踪速度。具体更新方式为将相关滤波分类器拆分成分子

式中

4.4 算法具体实施过程

输入:初始目标位置(

输出:预测的目标位置(

过程:

1) 第1帧图像。

2) 以第1帧的目标图像块的中心位置(

3) for

采用(1)式挑选出

end for。

4) 采用(4)式训练分类器

5) repeat。

6) 以

7) 采用(5)式预测目标位置

8) 根据响应值

9) 利用(6)式计算

10) if

end if。

11) if 帧数除2的余数为0 then

采用(7)~(9)式更新相关滤波器

end if。

12) until 结束所有帧。

5 实验结果及分析

5.1 实验环境和参数设置

实验测试所用平台为Ubuntu14.04 系统下的Matlab R2015b,卷积特征计算框架为MatConvNet,所有的实验均在配置为Intel Core i7-4790 4.0 GHz CPU、显存6 GB的GTX980ti台式电脑下完成。实验中所用的正则化参数

实验选用的评估数据集为OTB-100,总共包含100组不同类型的数据集,包括光照变化(IV)、遮挡(OCC)、尺度变化(SV)、快速运动(FM)、背景混乱(BC)、低分辨率(LR)、平面内旋转(IPR)、超出视野(OV)、平面外旋转(OPR)、非刚性形变(DEF),以及运动模糊(MB)等各种干扰。

实验中采用中心位置误差(CLE)、距离精度(DP)、重叠精度(OP)、一次性通过(OPE)的距离精度曲线和成功率曲线对算法进行评估。其中,CLE表示检测到的目标中心位置与目标真实中心位置的平均欧氏距离:

式中(

5.2 实验设计

为验证本文算法的跟踪性能,共设计3组实验。实验1,自适应特征选择及模型切换使用前后对比实验,验证本文自适应特征选择和模型切换的高效性;实验2,定量对比实验,与现有优秀算法的整体性能进行比较,对比评价本文算法的优劣;实验3,定性对比实验,通过典型视频的跟踪结果,直观展示本文算法与其他算法的性能对比结果。

5.2.1 自适应特征选择及模型切换跟踪算法实验

对选择的卷积层进行单层跟踪、单层自适应跟踪,以及本文的双层模型自适应切换跟踪,跟踪结果如

表 1. 特征不同应用方式的跟踪结果

Table 1. Tracking results of different features applications

|

5.2.2 定量对比实验

为了进一步验证本文算法的性能,选取9个主流的跟踪算法与本文算法作比较,分别为空间正则化相关滤波跟踪(SRDCF)算法[4]、连续卷积相关滤波跟踪(CCOT)算法[6]、多特征融合的实时跟踪(Staple)算法[9]、分层卷积相关滤波跟踪(HCFT)算法[10]、HCFT的改进算法(HCFTS)[15]、尺度预测跟踪(DSST)算法[17]、多尺度域跟踪(MSDAT)算法[23]、使用深度特征的多峰目标检测跟踪(D_LMCF)算法[27]、多层卷积相关滤波跟踪(HDT)算法[28]。9种算法均在相关滤波框架下设计,其中,CCOT、HCFT、HCFTS、MSDAT、HDT、D_LMCF算法使用深度卷积特征,CCOT、DSST、Staple、HCFTS4算法自带尺度估计。

根据OTB-100数据集提供的评估方法,对本文算法和上述9种算法进行一次性通过评估(OPE),

图 6. 10种算法的(a)精度和(b)成功率曲线

Fig. 6. (a) Precision and (b) success rate plots of ten algorithms

图 7. 面对不同挑战时各算法精确度曲线。(a) IV; (b) OPR; (c) SV; (d) OCC; (e) DEF; (f) MB; (g) FM; (h) IPR; (i) OV; (j) BC; (k) LR

Fig. 7. Precision plots of ten algorithms on different challenges. (a) IV; (b) OPR; (c) SV; (d) OCC; (e) DEF; (f) MB; (g) FM; (h) IPR; (i) OV; (j) BC; (k) LR

图 8. 面对不同挑战时各算法成功率值。(a) IV; (b) OPR; (c) SV; (d) OCC; (e) DEF; (f) MB; (g) FM; (h) IPR; (i) OV; (j) BC; (k) LR

Fig. 8. Success rate plots of ten algorithms on different challenges. (a) IV; (b) OPR; (c) SV; (d) OCC; (e) DEF; (f) MB; (g) FM; (h) IPR; (i) OV; (j) BC; (k) LR

5.2.3 定性对比实验

选取使用了深度特征的HCFTS、D_LMCF、HDT、HCFT、MSDAT算法与本文算法的跟踪结果进行显示,由于CCOT算法跟踪速度过于缓慢,本实验中不再进行比较。选取6组具有各种挑战的视频,相关属性如

表 2. 测试视频的属性

Table 2. Properties of test videos

|

不同算法在典型视频的部分帧跟踪结果如

图 9. 6种跟踪算法的部分跟踪结果对比。(a) Singer2; (b) Tiger1; (c) Car1; (d) Human3; (e) Girl2; (f) Human2

Fig. 9. Comparison of partial tracking results of six tracing algorithms. (a) Singer2; (b) Tiger1; (c) Car1; (d) Human3; (e) Girl2; (f) Human2

6 结论

为了提高目标跟踪的速度和精度,在分析不同卷积层特性的基础上,选取两层卷积特征训练分类器,利用响应图的PSR构造了一种自适应双模型切换跟踪方法。该方法通过目标区域和跟踪搜索区域卷积特征的均值比评估方法选取有效的卷积通道,在提高算法跟踪效果的同时,减少后续相关滤波跟踪的计算时间,并使用等间隔的稀疏更新方法进一步提高算法的跟踪速度。除了自适应通道选择算法外,还利用相关滤波响应图的PSR系数进行自适应双模型切换跟踪,避免单一模型造成的目标跟踪失败,提高算法的整体跟踪效果。在标准数据集OTB-100上进行算法验证,实验中分析了自适应特征选择、模型切换算法的性能,并与其他算法进行对比分析。实验结果表明,本文算法的平均DP值为89.3%,平均速度为25.8 frame/s,优于HCFTS、D_LMCF、HDT等当前主流的目标跟踪算法。在目标发生光照变化、遮挡、快速运动等干扰时,本文方法具有较强的稳健性。

[1] Bolme DS, Beveridge JR, Draper BA, et al. Visual object tracking using adaptive correlation filters[C]∥ 2010 IEEE Conference on Computer Vision and Pattern Recognition, 2010: 2544- 2550.

[2] Henriques JF, CaseiroR, MartinsP, et al. Exploiting the circulant structure of tracking-by-detection with kernels[C]∥European Conference on Computer Vision, 2012: 702- 715.

[4] DanelljanM, HagerG, Shahbaz KhanF, et al. Learning spatially regularized correlation filters for visual tracking[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2015: 4310- 4318.

[5] DanelljanM, Shahbaz KhanF, FelsbergM, et al. Adaptive color attributes for real-time visual tracking[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2014: 1090- 1097.

[6] DanelljanM, RobinsonA, Khan FS, et al. Beyond correlation filters: Learning continuous convolution operators for visual tracking[C]∥European Conference on Computer Vision, 2016: 472- 488.

[7] DanelljanM, BhatG, Khan FS, et al. ECO: efficient convolution operators for tracking[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2017: 6931- 6939.

[8] 熊昌镇, 赵璐璐, 郭芬红. 自适应特征融合的核相关滤波跟踪算法[J]. 计算机辅助设计与图形学学报, 2017, 29(6): 1068-1074.

[9] BertinettoL, ValmadreJ, GolodetzS, et al. Staple: complementary learners for real-time tracking[C]∥ Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 1401- 1409.

[10] MaC, Huang JB, YangX, et al. Hierarchical convolutional features for visual tracking[C]∥ Proceedings of the IEEE International Conference on Computer Vision, 2015: 3074- 3082.

[11] HuangC, LuceyS, RamananD. Learning policies for adaptive tracking with deep feature cascades[C]∥ IEEE International Conference on Computer Vision, 2017: 105- 114.

[12] WangL, OuyangW, WangX, et al. Visual tracking with fully convolutional networks[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2015: 3119- 3127.

[14] 王艳川, 黄海, 李邵梅, 等. 基于在线检测和尺度自适应的相关滤波跟踪[J]. 光学学报, 2018, 38(2): 0215002.

[16] SongY, MaC, GongL, et al. Crest: convolutional residual learning for visual tracking[C]∥IEEE International Conference on Computer Vision, 2017: 2574- 2583.

[17] DanelljanM, HägerG, KhanF, et al. Accurate scale estimation for robust visual tracking[C]∥British Machine Vision Conference, 2014: 1- 11.

[18] 潘振福, 朱永利. 多尺度估计的核相关滤波器目标跟踪方法[J]. 激光与光电子学进展, 2016, 53(10): 101501.

[19] 王鑫, 侯志强, 余旺盛, 等. 基于多层卷积特征融合的目标尺度自适应稳健跟踪[J]. 光学学报, 2017, 37(11): 1115005.

[20] Galoogahi HK, FaggA, LuceyS. Learning background-aware correlation filters for visual tracking[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017: 1135- 1143.

[21] MaC, YangX, ZhangC, et al. Long-term correlation tracking[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2015: 5388- 5396.

[22] 赵高鹏, 沈玉鹏, 王建宇. 基于核循环结构的自适应特征融合目标跟踪[J]. 光学学报, 2017, 37(8): 0815001.

[24] 蔡玉柱, 杨德东, 毛宁, 等. 基于自适应卷积特征的目标跟踪算法[J]. 光学学报, 2017, 37(3): 0315002.

[25] HeldD, ThrunS, SavareseS. Learning to track at 100 fps with deep regression networks[C]∥European Conference on Computer Vision, 2016: 749- 765.

[26] LiY, Zhu JK, Hoi S C H. Reliable patch trackers: Robust visual tracking by exploiting reliable patches[C]∥ Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2015: 353- 361.

[27] WangM, LiuY, HuangZ. Large margin object tracking with circulant feature maps[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017: 4800- 4808.

[28] Qi YK, Zhang SP, QinL, et al. Hedged deep tracking[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 4303- 4311.

Article Outline

熊昌镇, 车满强, 王润玲, 卢颜. 稳健的双模型自适应切换实时跟踪算法[J]. 光学学报, 2018, 38(10): 1015002. Changzhen Xiong, Manqiang Che, Runling Wang, Yan Lu. Robust Real-Time Visual Tracking via Dual Model Adaptive Switching[J]. Acta Optica Sinica, 2018, 38(10): 1015002.