基于深度对抗域适应的高分辨率遥感影像跨域分类  下载: 1502次

下载: 1502次

1 引言

随着全球对地观测系统的不断发展和完善,地球空间信息的获取已经进入了三高”(高空间分辨率、高光谱分辨率、髙时间分辨率)和“三多”(多平台、多传感器和多角度)时代[1],大量的对地观测影像数据已经成为人类认识理解世界的重要信息来源[2]。高分辨率遥感影像分类是遥感影像智能解译的一项重要任务。遥感影像空间分辨率的逐步提升,改变了遥感对地观测的尺度,小尺度的观测使遥感影像能够提供复杂的地表结构信息,为地表更高层次的语义信息提取提供了数据源[3]。然而,遥感影像的像素或者超像素仅包含地物底层信息,不能对影像高层语义內容进行描述,因此,传统的“面向像素”或“面向对象”的分类方法无法满足遥感影像高层次内容解译的需求[4]。在此背景下,“面向场景”的遥感影像分类引起了广泛关注,并已成为遥感领域的一个活跃的研究课题。

近年来,几种“面向场景”的遥感影像分类方法相继提出,如基于颜色、纹理、形状等底层特征的场景分类方法[5-7],基于视觉词袋模型和概率主题模型的中层特征场景分类方法[8-11]以及基于深度特征的场景分类方法等。基于深度卷积神经网络[12-13]遥感影像场景分类研究在2015年前后相继出现,并在几个基准的遥感数据集上取得了先进结果[14],其研究主要依据两条思路展开:一是将基于大规模自然影像数据训练得到的深度卷积神经网络模型直接或经过微调后应用于遥感影像场景分类,Penatti等[15]首次利用深度卷积神经网络处理高分遥感场景分类问题,将大规模自然影像数据集上预训练的深度神经网络直接迁移至遥感场景数据集,利用神经网络中间层的输出特征作为场景全局特征表达,取得了突出的分类效果;龚希等[16]利用包含场景局部细节信息的卷积层特征和包含场景全局信息的全连接层特征表达遥感影像场景。二是基于公开的遥感影像场景数据集设计并训练一个新的卷积神经网络[17],Basu等[18]基于两个小尺度遥感影像场景数据集测试了不同深度的卷积神经网络分类性能;Zhang等[19]提出一种参数共享的卷积神经网络集成框架,并利用基于UC-Merced数据集训练的4种不同结构的卷积神经网络模型对遥感图像场景进行分类。

上述方法大多针对一个域进行实验,机器学习方法假设训练数据和测试数据独立同分布,当训练数据与测试数据之间的数据分布存在差异时,模型性能大幅下降[20]。针对单个领域分类任务设计的监督学习方法存在两个问题:1) 不同遥感数据集之间由于遥感平台、传感器、拍摄角度、分辨率、拍摄时间的差异,造成同一类型的地物在不同的域中差异巨大,针对单个领域的分类方法对跨域的数据集不具有稳健性,模型泛化能力较弱;2) 监督学习方法需要通过目视解译或地面调查获取大量的标记样本,该方法成本很高,并且人工标注很难跟上当前影像获取的步伐,特别是当任务涉及到非常大的区域或无法进行目视解译时,如树种分类、土地利用分类和叶绿素浓度分类等。从机器学习的角度来看,这种数据漂移问题可以通过迁移学习方法来解决,具体为无监督域适应 (UDA,简称域适应),它包括有标签源域和无标签目标域两个数据集,假设源域和目标域的类别空间和特征空间一致,仅特征的分布不同,目的是通过域适应方法学习到域不变的特征表示,提高模型的泛化能力。综上所述,针对遥感影像标注数据获取困难、模型泛化能力较弱的问题,如何充分利用过去的知识和恰当的域适应方法,训练出泛化能力较强的模型,是目前遥感领域亟待解决的热点和难点问题[21]。

近年来,域适应问题的研究大多针对几个数据量较小的办公数据集和手写数字数据集[22-24],和自然图像相比,遥感影像数据更复杂多变,因此,将自然图像的域适应方法直接用于遥感影像上很难取得较好的分类效果。也有一些关于遥感影像的域适应方法的针对性研究,如文献[ 25]中利用预训练模型初始化特征,利用源域数据的交叉熵损失、最大均值差异(MMD)减少源数据和目标数据的分布差异;文献[ 26]中通过非对称自适应层处理数据转移问题,并通过联合最小化分布的差异和类别分离学习网络权重,由于缺少丰富类别的源域数据集,这些研究大多只对数据集中的少部分类别进行研究,具有一定的局限性。

针对上述问题,本文提出一种基于深度对抗域适应的高分辨率遥感影像跨域分类方法。利用深度卷积神经网络VGG16学习场景影像的深度特征;利用对抗学习方法最小化源域和目标域特征分布差异,以提高模型对目标域的分类性能;为了验证所提方法的有效性利用RSI-CB256(Remote Sensing Image Classification Benchmark)、NWPU-RESISC45(Northwestern Polytechnical University Remote Sensing Image Scene Classification)和AID(Aerial Image data set)数据集构建源域数据集,利用UC-Merced(University of California, Merced)和WHU-RS19(Wuhan University Remote Sensing)两个通用数据集作为目标域数据集进行实验。

2 原理与方法

2.1 生成对抗网络原理

生成式对抗网络模型(GANs)是Goodfellow等[27]提出的一种生成式模型,用于解决许多计算机视觉领域中的相关任务,如图像生成、图像超分辨率、无监督学习、半监督学习以及图像着色等。GANs的基本思想源自博弈论的二人零和博弈,由一个生成器(Generator)和一个判别器(Discriminator)组成,其通过对抗学习的方式进行训练,目的是估测数据样本的潜在分布,并生成新的数据样本。

从一个任意的分布采样出随机噪声,并输入到生成器。生成器尽可能拟合真实数据的分布以欺骗判别器;判别器的输入数据包括真实样本和生成器生成的假样本两个部分,判别器则尽可能区分出两部分样本,生成器和判别器二者通过相互对抗更新迭代,最终达到一个纳什均衡。此时,生成器能够拟合真实数据的分布,生成接近真实数据的样本,判别器无法区分数据来自生成器还是现实世界。GAN的损失函数可表示为

式中:

对于给定的最优生成器

若(3)式取最大值,对于给定的

给定最优判别器

式中:KL表示KL散度(Kullback-Leibler divergence);JS表示JS(Jensen-Shannon Divergence)散度。由(5)式可知,在给定最优判别器

2.2 本文方法

问题描述:给定一个具有

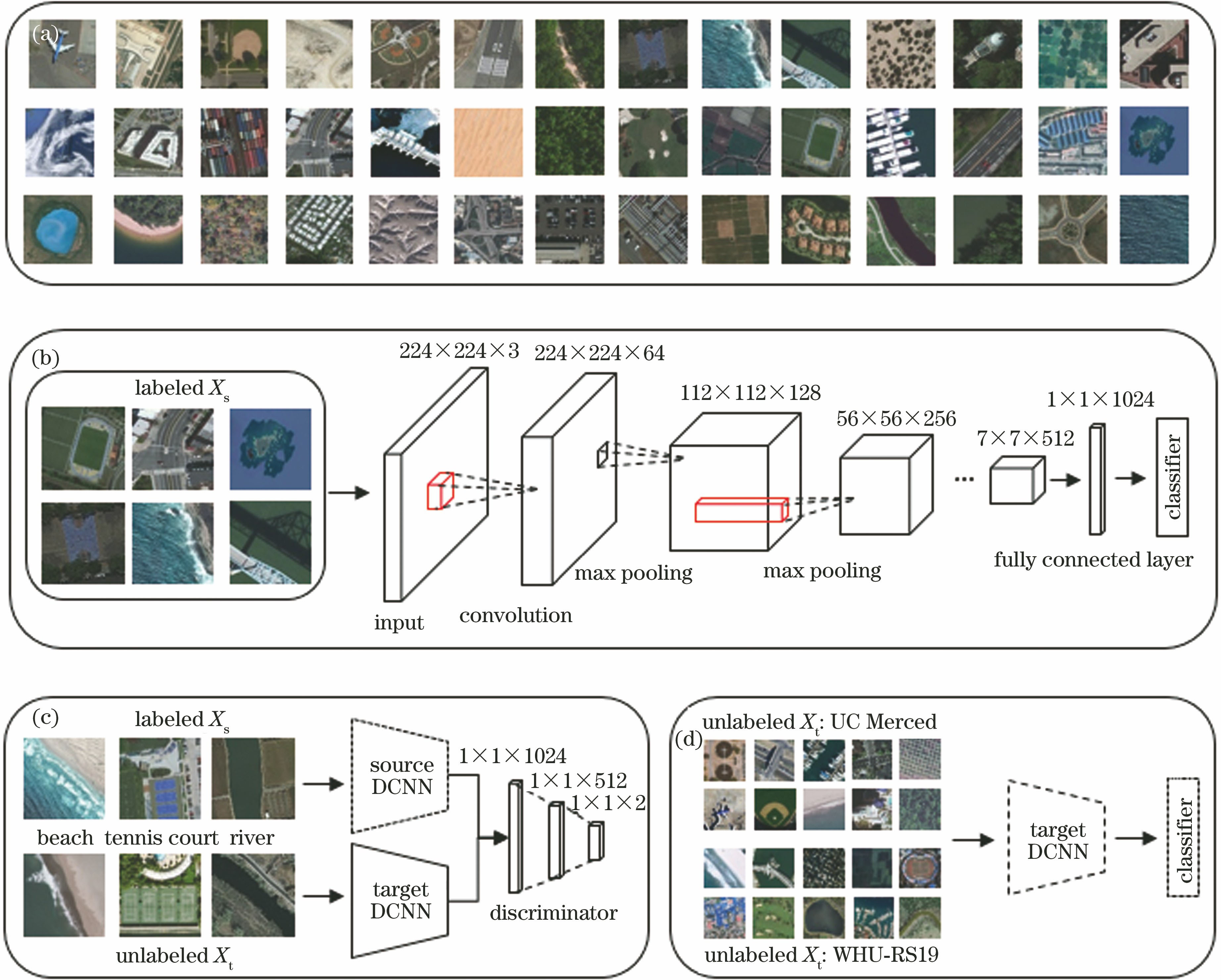

图 1. 所提方法框架。(a)高分辨率遥感影像数据集;(b)源域深度卷积神经网络;(c)无监督对抗域适应;(d)遥感影像场景分类

Fig. 1. Framework of proposed method. (a) High spatial resolution remote sensing image dataset; (b) source deep convolutional neural network; (c) unsupervised adversarial domain adaptation; (d) remote sensing image scene classification

为了充分利用源域知识,首先利用深度卷积神经网络和源域数据集,学习场景影像的深度特征表示,具体的网络结构为VGG团队在ILSVRC 2014(ImageNet Large Scale Visual Recognition Competition)年比赛中提出的16层网络结构。对于训练损失,选择标准的监督损失方法,则损失函数公式为

式中:

基于2.1节对生成对抗网络的推导分析,生成器和判别器相互对抗学习能够对齐两个域分布,为此将对抗学习方法引入高分辨率遥感影像跨域分类,最小化源域场景影像和目标域场景影像的特征分布差异,利用对抗学习方法提高模型对目标域数据集的泛化能力。在对抗学习中使用最大最小损失作为损失函数训练网络,为了能够利用标准的最小损失函数训练生成器(目标域的深度卷积神经网络),所提方法将生成对抗网络的损失函数分为两个独立的损失函数:一个用于生成器,另一个用于判别器。将判别器的损失函数保持不变,生成器的损失利用反向标签进行修改,修改后的损失函数为

修改后的损失函数可以直接使用反向传播和梯度下降方法优化网络。在域适应阶段固定源域特征,仅学习目标域的特征,模拟生成对抗网络的学习方式,将真实图像的分布固定,把生成器生成的分布匹配到真实图像的分布上。在对抗学习中,先固定目标域网络,优化判别网络,提高判别网络对数据来自源域和目标域的区分能力,然后固定判别网络,优化目标域网络,目标域网络和判别器二者通过相互对抗更新迭代,最小化源域和目标域的特征分布,直至达到一个纳什均衡。为了学习到更多的目标域特征,目标域不共享源域的参数,仅利用源域参数初始化目标域模型,可避免目标数据集数据量较少导致的过拟合问题。

为了优化损失函数,所提方法采用Adam优化算法[28]和反向传播更新模型参数,Adam优化算法是经典随机梯度下降法(SGD)的扩展,在训练过程中,SGD对所有的权重都保持一个单一的学习速率,而Adam算法将动量与RMSProp(Root Mean Square Prop)优化算法相结合,利用梯度的一阶矩和二阶矩估计自适应选择每个训练参数的学习率,经过偏置校正后,每一次的迭代学习率都需确定范围,使得参数平稳,故可以为不同的参数计算出不同的自适应学习率。该算法对内存需求较小,具体表示为

式中:

3 实验与分析

3.1 实验数据集介绍

3.1.1 源域数据集构建

由于缺少源域数据集,过去的研究只选择验证数据集中的少部分类别验证算法的有效性,具有一定的局限性。为了有效验证所提方法的性能,构建一个遥感影像场景分类数据集作为源域。与ImageNet相比,收集带标注的遥感影像数据更困难,然而,现阶段遥感影像数据集的构建已取得了一些成果,如RSI-CB256(Remote Sensing Image Classification Benchmark)[29],其利用众包的OSM (Open Street Map)的POI (Point of Interest)数据标注全球范围内的大规模遥感影像,根据中国土地利用现状分类要求与ImageNet的分层分级机制建立了严格的地物分类体系,该数据集包含35类地物,共36000幅影像块,每类约为690幅影像块,数据来源于Google Earth和Bing Maps,空间分辨率为0.22~3 m。与其他遥感数据集相比,RSI-CB256具有高质量、多样性和大尺度等优点,但该数据集的场景类别覆盖不全,和UC-Merced(University of California, Merced)数据集相比,仅包含其中的13类,通过对比现有的遥感影像场景分类数据集发现,NWPU-RESISC45(Northwestern Polytechnical University Remote Sensing Image Scene Classification)[30]与RSI-CB256只有14个类别重复,30个类别不重复,和RSI-CB256具有很强的互补性,并且该数据集分辨率从0.2~30 m,覆盖区域包括全球100多个国家和地区。

本文将NWPU-RESISC45不重复的30个类别添加到RSI-CB框架中,其中RSI-CB256将不同密度的3种居民区合并为1种居民区,而大部分数据集都根据不同密度将居民区划分,因此,本文将RSI-CB256的居民区数据手动划分至不同密度的居民区。最后利用多传感器多分辨率(0.5~8 m)的AID(Aerial Image data set)[31]数据集进一步扩充该数据集,最终构建了多传感器、多分辨率、多地理区域和多类别的源域遥感影像场景分类数据集,该数据集包含6个大类,71个子类,共69087张场景影像。具体类别信息如

表 1. 源域遥感影像场景分类数据集类别

Table 1. Dataset category for remote sensing image scene classification of source domain

|

3.1.2 目标域数据集

为验证所提方法的有效性,采用UC-Merced[8]和WHU-RS[32]两个国际通用的场景分类数据集进行实验。

1) UC-Merced:该场景数据为Yang和Newsam从美国USGS (United States Geological Survey)的一个大型航空正射影像中采集的不同地区的影像,分辨率为0.3 m,共包含21类场景,具体包含:农田、飞机、棒球场、海滩、建筑物、丛林、森林、高速公路、高尔夫球场、港口、移动房车场、十字路口、高架桥、停车场、密集居住区、中等密集居住区、稀疏居住区、河流、机场跑道、储油区和网球场,影像示例如

2) WHU-RS:该数据集为武汉大学测绘遥感信息工程国家重点实验室从Google Earth影像中采集的不同分辨率、不同地区的影像,共包含19类场景,具体包含:飞机场、海滩、桥梁、商业区、沙漠、牧场、足球场、森林、港口、工业区、草地、山脉、公园、停车场、池塘、火车站、居民区、河流、高架桥,影像示例如

表 2. 源域与目标域的深度卷积神经网络结构

Table 2. Deep convolution neural network structure of source domain and target domain

|

3.2 实验设置

本文实验中的源域和目标域的卷积神经网络结构如

表 3. 判别网络结构

Table 3. Structure of discriminator

|

3.3 实验结果与分析

1) UC-Merced数据集分类混淆矩阵、OA和Kappa系数如

图 4. UC-Merced数据集的分类混淆矩阵。(a)源域分类精度; (b)域适应分类精度

Fig. 4. Classification confusion matrix of UC-Merced dataset. (a) Classification accuracy of source domain; (b) classification accuracy of domain adaptation

图 5. WHU-RS数据集的分类混淆矩阵。(a)源域分类精度; (b)域适应分类精度

Fig. 5. Classification confusion matrix of WHU-RS dataset. (a) Classification accuracy of source only; (b) classification accuracy of domain adaptation

2) WHU-RS数据集分类混淆矩阵、OA和Kappa系数如

综上所述,所提出的基于深度对抗域适应的高分辨率遥感影像跨域分类方法是一种有效的分类方法,在目标域无标签的情况下能够提高模型的泛化能力,有效解决了源域和目标域特征分布不同导致的目标域数据集分类精度较低的问题。

3.4 与其他方法对比结果

将本文方法与其他方法进行实验对比。对比的方法有:1) Source Only,利用源域数据集和深度卷积神经网络学习场景影像的深度特征,直接对目标域数据分类,不使用域适应方法;2) MMD[22],使用MMD损失函数最小化源域和目标域的特征分布差异,使用最后一个全连接层输出计算MMD损失;3) DANN[23] (Domain-Adversarial Training of Neural Networks),利用对抗学习方法最小化源域和目标域的特征分布差异,在域分类器前加入一个梯度反转层,使用的模型和参数与所提方法一致。各方法的总体精度如

从

表 4. 不同算法分类精度

Table 4. Classification accuracy of each algorithm%

|

4 结论

提出了一种基于深度对抗域适应的高分辨率遥感影像跨域分类方法。理论分析了对抗学习方法最小化源域与目标域的特征分布差异的原理;利用深度卷积神经网络VGG16学习场景影像的深度特征;利用对抗学习方法最小化源域和目标域特征分布差异,利用反向传播和Adam算法优化最小损失函数,提高了模型对目标域数据集的泛化能力。

为了验证所提方法有效性,构建了一个多传感器、多分辨率、多地理区域、多类别的源域遥感影像场景分类数据集作为源域,利用UC-Merced和WHU-RS两个通用数据集作为目标域数据集验证所提方法的有效性。实验结果表明,采用所提方法,UC-Merced数据集的OA和Kappa系数分别提高16.28%和0.167;WHU-RS数据集的OA和Kappa系数分别提高10.35%和0.110;所提方法能够有效减小源域和目标域的特征分布差异,在目标域数据集没有标签的情况下,能够提高模型对目标域数据集的泛化能力,是一种有效的遥感影像跨域分类方法。

[1] 李德仁, 童庆禧, 李荣兴, 等. 高分辨率对地观测的若干前沿科学问题[J]. 中国科学:地球科学, 2012, 42(6): 805-813.

李德仁, 童庆禧, 李荣兴, 等. 高分辨率对地观测的若干前沿科学问题[J]. 中国科学:地球科学, 2012, 42(6): 805-813.

[2] 张良培, 黄昕. 遥感影像信息处理技术的研究进展[J]. 遥感学报, 2009, 13(4): 559-569.

张良培, 黄昕. 遥感影像信息处理技术的研究进展[J]. 遥感学报, 2009, 13(4): 559-569.

[3] 张帆. 面向高分辨率遥感影像分析的深度学习方法研究[D]. 武汉: 武汉大学, 2017.

张帆. 面向高分辨率遥感影像分析的深度学习方法研究[D]. 武汉: 武汉大学, 2017.

ZhangF. Deep learning for very high resolution remote sensing data analysis[D]. Wuhan: Wuhan University, 2017.

ZhangF. Deep learning for very high resolution remote sensing data analysis[D]. Wuhan: Wuhan University, 2017.

[4] 胡凡. 基于特征学习的高分辨率遥感图像场景分类研究[D]. 武汉: 武汉大学, 2017.

胡凡. 基于特征学习的高分辨率遥感图像场景分类研究[D]. 武汉: 武汉大学, 2017.

HuF. Feature learning based high resolution remote sensing image scene classification[D]. Wuhan: Wuhan University, 2017.

HuF. Feature learning based high resolution remote sensing image scene classification[D]. Wuhan: Wuhan University, 2017.

[5] Xia GS, YangW, DelonJ, et al. Structural high-resolution satellite image indexing[C]∥ISPRS TC VII Symposium-100 Years ISPRS, July 5-7, 2010, Vienna, Austria. [S. l. : s. n.], 2010: 298- 303.

Xia GS, YangW, DelonJ, et al. Structural high-resolution satellite image indexing[C]∥ISPRS TC VII Symposium-100 Years ISPRS, July 5-7, 2010, Vienna, Austria. [S. l. : s. n.], 2010: 298- 303.

[6] RisojevicV, MomicS, BabicZ. Gabor descriptors for aerial image classification[M] ∥Dobnikar A, Lotric U, Šter B. Adaptive and Natural Computing Algorithms. Berlin, Heidelberg: Springer, 2011, 6954: 51- 60.

RisojevicV, MomicS, BabicZ. Gabor descriptors for aerial image classification[M] ∥Dobnikar A, Lotric U, Šter B. Adaptive and Natural Computing Algorithms. Berlin, Heidelberg: Springer, 2011, 6954: 51- 60.

[8] YangY, NewsamS. Bag-of-visual-words and spatial extensions for land-use classification[C]∥Proceedings of the 18th SIGSPATIAL International Conference on Advances in Geographic Information Systems, November 2-5, 2010, San Jose, California. New York: ACM, 2010: 270- 279.

YangY, NewsamS. Bag-of-visual-words and spatial extensions for land-use classification[C]∥Proceedings of the 18th SIGSPATIAL International Conference on Advances in Geographic Information Systems, November 2-5, 2010, San Jose, California. New York: ACM, 2010: 270- 279.

[12] 闫苗, 赵红东, 李宇海, 等. 基于卷积神经网络的高光谱遥感地物多分类识别[J]. 激光与光电子学进展, 2019, 56(2): 021702.

闫苗, 赵红东, 李宇海, 等. 基于卷积神经网络的高光谱遥感地物多分类识别[J]. 激光与光电子学进展, 2019, 56(2): 021702.

[13] 滕文秀, 温小荣, 王妮, 等. 基于深度迁移学习的无人机高分影像树种分类与制图[J]. 激光与光电子学进展, 2019, 56(7): 072801.

滕文秀, 温小荣, 王妮, 等. 基于深度迁移学习的无人机高分影像树种分类与制图[J]. 激光与光电子学进展, 2019, 56(7): 072801.

[14] 钱晓亮, 李佳, 程塨, 等. 特征提取策略对高分辨率遥感图像场景分类性能影响的评估[J]. 遥感学报, 2018, 22(5): 758-776.

钱晓亮, 李佳, 程塨, 等. 特征提取策略对高分辨率遥感图像场景分类性能影响的评估[J]. 遥感学报, 2018, 22(5): 758-776.

[15] Penatti O AB, NogueiraK, dos Santos JA. Do deep features generalize from everyday objects to remote sensing and aerial scenes domains?[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition Workshops (CVPRW), June 7-12, 2015, Boston, MA, USA. New York: IEEE, 2015: 44- 51.

Penatti O AB, NogueiraK, dos Santos JA. Do deep features generalize from everyday objects to remote sensing and aerial scenes domains?[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition Workshops (CVPRW), June 7-12, 2015, Boston, MA, USA. New York: IEEE, 2015: 44- 51.

[16] 龚希, 吴亮, 谢忠, 等. 融合全局和局部深度特征的高分辨率遥感影像场景分类方法[J]. 光学学报, 2019, 39(3): 0301002.

龚希, 吴亮, 谢忠, 等. 融合全局和局部深度特征的高分辨率遥感影像场景分类方法[J]. 光学学报, 2019, 39(3): 0301002.

[17] 李二珠. 遥感图像场景深度学习与应用研究[D]. 南京: 南京大学, 2017.

李二珠. 遥感图像场景深度学习与应用研究[D]. 南京: 南京大学, 2017.

Li EZ. Research on remotely sensed image scene deep learning and application[D]. Nanjing: Nanjing University, 2017.

Li EZ. Research on remotely sensed image scene deep learning and application[D]. Nanjing: Nanjing University, 2017.

[18] BasuS, GangulyS, MukhopadhyayS, et al. DeepSat - a learning framework for satellite imagery[EB/OL]. ( 2015-09-11)[2018-12-01]. https:∥arxiv.org/abs/1509. 03602.

BasuS, GangulyS, MukhopadhyayS, et al. DeepSat - a learning framework for satellite imagery[EB/OL]. ( 2015-09-11)[2018-12-01]. https:∥arxiv.org/abs/1509. 03602.

[20] 许夙晖, 慕晓冬, 张雄美, 等. 结合对抗网络与辅助任务的遥感影像无监督域适应方法[J]. 测绘学报, 2017, 46(12): 1969-1977.

许夙晖, 慕晓冬, 张雄美, 等. 结合对抗网络与辅助任务的遥感影像无监督域适应方法[J]. 测绘学报, 2017, 46(12): 1969-1977.

[21] 龚健雅, 季顺平. 摄影测量与深度学习[J]. 测绘学报, 2018, 47(6): 693-704.

龚健雅, 季顺平. 摄影测量与深度学习[J]. 测绘学报, 2018, 47(6): 693-704.

[22] Long MS, CaoY, Wang JM, et al. Learning transferable features with deep adaptation networks[C]∥Proceedings of the 32nd International Conference on International Conference on Machine Learning, July 6-11, 2015, Lille, France. Massachusetts: JMLR. org, 2015: 97- 105.

Long MS, CaoY, Wang JM, et al. Learning transferable features with deep adaptation networks[C]∥Proceedings of the 32nd International Conference on International Conference on Machine Learning, July 6-11, 2015, Lille, France. Massachusetts: JMLR. org, 2015: 97- 105.

[24] TzengE, HoffmanJ, SaenkoK, et al. Adversarial discriminative domain adaptation[EB/OL]. ( 2017-02-17)[2018-12-01]. https:∥arxiv.org/abs/1702. 05464.

TzengE, HoffmanJ, SaenkoK, et al. Adversarial discriminative domain adaptation[EB/OL]. ( 2017-02-17)[2018-12-01]. https:∥arxiv.org/abs/1702. 05464.

[27] Goodfellow IJ, Pouget-AbadieJ, MirzaM, et al.Generative adversarial nets[C]∥Proceedings of the 27th International Conference on Neural Information Processing Systems, December 8-13, 2014, Montreal, Canada.Cambridge: MIT Press, 2014: 2672- 2680.

Goodfellow IJ, Pouget-AbadieJ, MirzaM, et al.Generative adversarial nets[C]∥Proceedings of the 27th International Conference on Neural Information Processing Systems, December 8-13, 2014, Montreal, Canada.Cambridge: MIT Press, 2014: 2672- 2680.

[28] Kingma DP, Ba J. Adam: a method for stochastic optimization[EB/OL]. ( 2017-01-30)[2018-12-01]. https:∥arxiv.org/abs/1412. 6980.

Kingma DP, Ba J. Adam: a method for stochastic optimization[EB/OL]. ( 2017-01-30)[2018-12-01]. https:∥arxiv.org/abs/1412. 6980.

[29] LiH, TaoC, WuZ, et al. RSI-CB: a large scale remote sensing image classification benchmark via crowdsource data[EB/OL]. ( 2017-06-11)[2018-12-01]. https:∥arxiv.org/abs/1705. 10450.

LiH, TaoC, WuZ, et al. RSI-CB: a large scale remote sensing image classification benchmark via crowdsource data[EB/OL]. ( 2017-06-11)[2018-12-01]. https:∥arxiv.org/abs/1705. 10450.

Article Outline

滕文秀, 王妮, 陈泰生, 王本林, 陈梦琳, 施慧慧. 基于深度对抗域适应的高分辨率遥感影像跨域分类[J]. 激光与光电子学进展, 2019, 56(11): 112801. Wenxiu Teng, Ni Wang, Taisheng Chen, Benlin Wang, Menglin Chen, Huihui Shi. Deep Adversarial Domain Adaptation Method for Cross-Domain Classification in High-Resolution Remote Sensing Images[J]. Laser & Optoelectronics Progress, 2019, 56(11): 112801.