基于特征拼接的行人重识别  下载: 955次

下载: 955次

1 引言

行人重识别是一种给出感兴趣的行人图像的技术,其主要目的是在由不同摄像头或同一摄像头不同时段拍摄的图像数据库中找出与目标行人匹配的行人图像。行人重识别的具体做法是:1)要构建一个提取行人图像特征的模型;2)利用距离度量给出相似性排序。行人重识别在很多领域均有应用,如视频监控、人机交互、机器人、基于内容的视频检索等。亮度、光照等因素的变化会给行人图像带来巨大的影响,因此行人重识别仍然面临着挑战。

最早研究者是对手工设计的特征进行识别[1-2]。随着深度学习的发展,目前行人重识别的主要做法是基于深度学习进行识别。基于深度学习的行人重识别研究方法主要包括基于度量学习的方法和基于卷积神经网络特征学习的方法。基于度量学习方法的主要思想是利用行人之间的特征距离来解决识别问题,通过三元组函数[3]来使相同行人的类内距离尽可能小,使不同行人的类间距离尽可能大。Hermans等[4]发现三元组损失函数的正、负样本对的选择很随机,于是提出了基于难样本挖掘的三元组。Hermans等通过在一个批次中选择最不像的相同行人来构建正样本对,选择同一个批次中最像的不同行人来构建负样本对。为了进一步减小类内方差并增大类间方差,Chen等[5]提出四元组损失函数。基于度量学习的方法有一个比较大的缺点,即训练容易过拟合。目前,基于度量学习的方法主要用于多任务学习[6-7],很少单独使用。基于卷积神经网络特征学习的方法是找到能够较好地表征行人特征的模型。陈兵等[8]通过加强对样本监督信息的利用和提升对样本间距离关系的约束,使神经网络能够得到判别性强的特征。由于单一特征对行人特征描述不够完整,很多研究者把重点由单一特征转移到多特征[9-12]。文献[ 10]中将描述行人的特征变成全局特征和局部特征融合后的特征,利用行人的全局特征和局部特征进行行人重识别。Sun等[11]把行人图片水平切块,然后再利用RPP ( Refined Part Pooling)[11]算法使每个相似的块对齐,每个相似的块均接入损失函数进行训练,通过拼接多个局部特征的方法来得到一个判别性强的行人特征。文献[ 12]中通过语义分割把行人图片分成头部、背景、上半身、下半身和鞋子5个部分,然后通过拼接5个部分的特征对行人图像进行特征表征。上述文献中的模型都是通过增加行人的特征来提高识别准确率。

为了提高模型对行人特征表征的效果,本文也利用多特征对行人特征进行描述。上述文献主要关注全局特征和局部特征或者全局特征和属性特征[9-12],本文则是通过多次提取全局特征来提高模型对行人特征的描述效果,通过对行人特征进行多次提取,减少了信息的缺失。本文所提出的模型在Market1501、CUHK03、DukeMTMC-Reid数据集上进行了实验,实验结果表明本文所提出的模型能够很好地对行人特征进行描述。

2 基本原理

行人重识别在测试时不同于其他的图像识别,行人重识别是用卷积神经网络提取图像中行人的特征,依据特征值的相似程度给出相似性排序。目前研究者都在寻找一种能够对行人特征具有较强辨别力的模型。受集成学习和Inception[13]网络的启发,本文提出利用全局池化和多个卷积对行人进行多次全局特征提取的方法。

2.1 网络结构

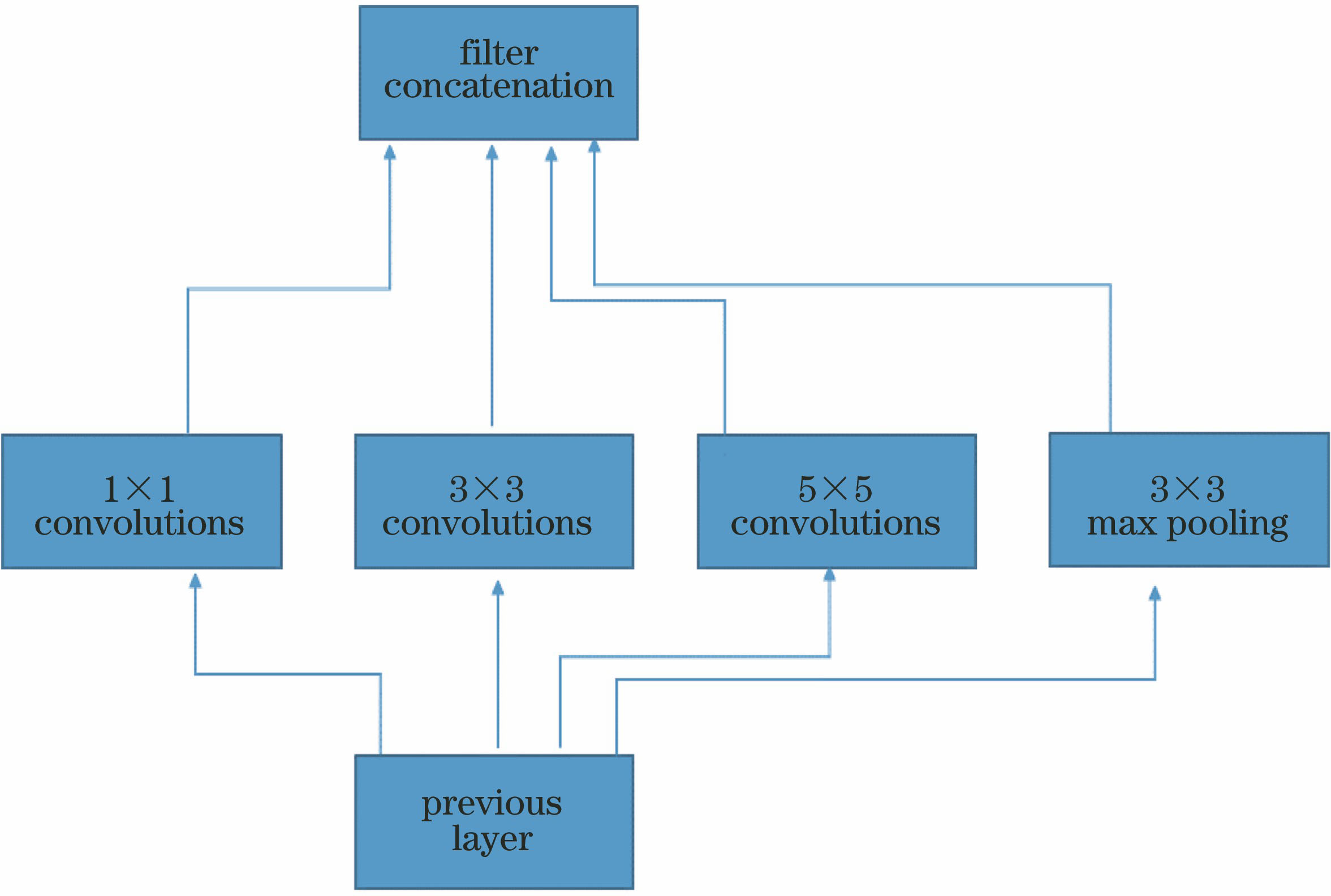

当分类效果不好时,研究者普遍会采用集成学习的方法。集成学习是将多个单一模型集成在一起使用,即先单独训练多个单一模型,测试时再将训练的多个单一模型进行组合使用,形成一个先进的组合模型[14]。如利用Resnet、Inception等不同的卷积神经网络,在测试预测结果时利用某种策略将单一模型的预测结果组合在一起,组合方式一般有平均法和学习法。Inception网络成功的原因在于其扩充了模型的宽度[13],主要思想是对同一个输入运用Inception块进行池化、多个卷积,然后拼接在一起作为输出,如

行人重识别利用模型提取特征,并依据特征值进行相似性排序。设用步长为1的1×1卷积、全局池化和步长为2的1×1卷积三个操作来提取特征,特征值分别为

本文模型如

2.2 损失函数

目前,Softmax损失在各种行人重识别模型中被广泛使用。不同于传统的Softmax损失,根据文献[ 15],本文所采用的Softmax损失的形式去除了线性多类分类器中分类层的偏置项,这有助于提高算法的识别能力。Softmax损失的定义为

式中:

3 实验结果与分析

3.1 数据集

本文所提算法在Market1501、CUHK03、DukeMTMC-Reid数据集上进行了实验,给出每个数据集上的首次预测正确的概率(Rank1)、平均预测均值(mAP)。Market1501数据集包括由6个摄像头(5个高清摄像头和1个低清摄像头)拍摄到的1501个行人和32668个检测到的行人矩形框。训练集有751个行人,包含12936张图像,平均每个人有17.2张训练图片;测试集有750个行人,包含19732张图像,平均每个人有26.3张测试图片。CUHK03数据集含有由5对摄像头采集得到的1467个行人。数据集在使用时一般不采用旧版的测试方式,本文将数据集分为包含767个行人的训练集和包含700个行人的测试集。DukeMTMC-Reid数据集是由8个不同摄像头采集的视频序列经过等间隔采样得到的,共有36411张图片,包含1812类行人。将该数据集中的16522张图片作为本文的训练集,19889张图片作为测试集。

3.2 实验设置

所提算法是在Pytorch深度学习框架上实施的。卷积神经网络采用的是Resnet50,初始学习率为0.01,Bottleneck学习率为0.1,epochs为260,训练批次大小为

3.3 参数对实验的影响

本文所提出的模型用瓶颈层代替分类层以尽可能地避免过拟合现象。瓶颈层中的参数需要合理设置,这些参数包括瓶颈层1中第一个全连接层神经元个数以及瓶颈层2、瓶颈层3中的卷积核个数。在本文中,全连接层神经元个数和卷积核个数取相同值,这主要是为了保持测试进行特征拼接时每个分支的特征值的维数相同。将全连接层神经元个数和卷积核个数统称为参数

Inception网络对辅助分类器设置了损失加权系数,故本文在使用时也设置了加权系数

表 1. 不同N的实验结果

Table 1. Experimental results corresponding todifferent N%

|

表 2. 不同M时的实验结果

Table 2. Experimental results corresponding to different M%

|

3.4 多特征拼接模型

为了验证本文所提出的模型的有效性,在Market1501数据集上对其进行实验验证。

表 3. 基础模型实验结果

Table 3. Experiment results of basic model%

|

表 4. 不同方法的实验结果

Table 4. Experimental results of different methods%

|

3.5 测试运行时间

目前研究者普遍使用全局池化后的2048维特征对算法进行运行时间测试。本文在测试时使用3个分支及辅助分类器各自提取512维特征,并将其拼接在一起,最后得到2048维特征。分支1使用瓶颈层中第一个全连接层后的512维特征,分支2和3均使用瓶颈层中卷积后的512维特征,辅助分类器也是使用瓶颈层中第一全连接层后的512维特征。

表 5. Market1501测试集上测试时间

Table 5. Test time on Market1501 dataset

|

3.6 实验结果与主流算法比较

为了验证本文所提模型的有效性,在三个主流数据集上对基于本文所提模型的行人重识别算法进行实验,并与最近比较先进的算法进行对比。

表 6. 在Market1501数据集上的结果对比

Table 6. Comparison of results on Market1501%

|

表 7. 在DukeMTMC-Reid数据集上的结果对比

Table 7. Comparison of results on DukeMTMC-Reid%

|

表 8. 在CUHK03数据集上的结果对比

Table 8. Comparison of results on CUHK03%

|

本文所提模型在Market1501的Rank1和mAP分别为95.2%和86.0%。从

4 结论

提出一种提取多特征的行人重识别模型,利用拼接后的多特征对行人进行特征表征。基于集成学习的思想设计了多分支来提取多特征。用所设计的瓶颈层代替原先卷积神经网络的分类层。本文所提模型不仅能提取判别力强的特征,还避免了特征学习过程中的信息丢失,从而提高了行人重识别的准确率。在Market1501数据集上使用RK[23]以后,本文算法的Rank1可以达到95.6%,mAP可以达到93.1%,实验结果表明本文所提模型能够对行人提取判别性强的特征。本文所提出的模型相比其他模型加入LSTM、图像水平分割等操作,可以做到端到端的训练。

[1] 孙熊伟, 徐青山, 蔡熠, 等. 基于边缘相位编码的复杂背景下海天线检测[J]. 光学学报, 2017, 37(11): 1110002.

[2] 王博, 苏玉民, 万磊, 等. 基于梯度显著性的水面无人艇的海天线检测方法[J]. 光学学报, 2016, 36(5): 0511002.

[3] ChengD, Gong YH, Zhou SP, et al. Person re-identification by multi-channel parts-based CNN with improved triplet loss function[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 1335- 1344.

[4] HermansA, BeyerL, Leibe B. In defense of the triplet loss for person re-identification[J/OL].( 2017-11-21)[2019-01-05]. https:∥arxiv.org/abs/1703. 07737.

[5] Chen WH, Chen XT, Zhang JG, et al. Beyond triplet loss: a deep quadruplet network for person re-identification[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 403- 412.

[6] Chen WH, Chen XT, Zhang JG, et al. A multi-task deep network for person re-identification[J/OL].( 2016-11-25)[2019-01-06]. https:∥arxiv.org/abs/1607. 05369.

[7] WangC, ZhangQ, HuangC, et al. Mancs: a multi-task attentional network with curriculum sampling for person re-identification[M] ∥Ferrari V, Hebert M, Sminchisescu C, et al. Computer vision-ECCV 2018. Lecture notes in computer science. Cham: Springer, 2018, 11208: 384- 400.

[8] 陈兵, 查宇飞, 李运强, 等. 基于卷积神经网络判别特征学习的行人重识别[J]. 光学学报, 2018, 38(7): 0720001.

[9] Liu H, Feng J S, Qi M B, et al. End-to-end comparative attention networks for person re-identification[J]. IEEE Transactions on Image Processing, 2017, 26(7): 3492-3506.

[10] Wei LH, Zhang SL, Yao HT, et al. Glad: global-local-alignment descriptor for pedestrian retrieval[C]∥Proceedings of the 25th ACM International Conference on Multimedia, October 23-27, 2017, Mountain View, California, USA. New York: ACM, 2017: 420- 480.

[11] Sun YF, ZhengL, YangY, et al. Beyond part models: person retrieval with refined part pooling (and a strong convolutional baseline)[M] ∥ Ferrari V, Hebert M, Sminchisescu C. Computer vision-ECCV 2018. Lecture notes in computer science. Cham: Springer, 2018, 11208: 501- 518.

[12] Kalayeh MM, BasaranE, GökmenM, et al. Human semantic parsing for person re-identification[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE, 2018: 1062- 1071.

[13] SzegedyC, LiuW, Jia YQ, et al. Going deeper with convolutions[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 7-12, 2015, Boston, MA, USA. New York: IEEE, 2015: 15523970.

[14] Schapire RE. The boosting approach to machine learning: an overview[M] ∥ Denison D D, Hansen M H, Holmes C C, et al. Nonlinear estimation and classification. New York, NY: Springer, 2003, 171: 149- 171.

[15] WangF, XiangX, ChengJ, et al. NormFace: L2 hypersphere embedding for face verification[C]∥Proceedings of the 2017 ACM on Multimedia, October 23-27, 2017, Mountain View, California, USA. New York: ACM, 2017: 1041- 1049.

[16] Chang XB, Hospedales TM, XiangT. Multi-level factorisation net for person re-identification[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE, 2018: 2109- 2118.

[17] Sarfraz MS, SchumannA, EberleA, et al. A pose-sensitive embedding for person re-identification with expanded cross neighborhood re-ranking[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE, 2018: 420- 429.

[18] LiW, Zhu XT, Gong SG. Harmonious attention network for person re-identification[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE, 2018: 2285- 2294.

[19] Chen DP, XuD, Li HS, et al. Group consistent similarity learning via deep CRF for person re-identification[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE, 2018: 8649- 8058.

[20] Huang HJ, Li DW, ZhangZ, et al. Adversarially occluded samples for person re-identification[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE, 2018: 5098- 5107.

[21] Shen YT, Li HS, XiaoT, et al. Deep group-shuffling random walk for person re-identification[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE, 2018: 2265- 2274.

[22] Si JL, Zhang HG, Li CG, et al. Dual attention matching network for context-aware feature sequence based person re-identification[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE, 2018: 5363- 5372.

[23] ZhongZ, ZhengL, Cao DL, et al. Re-ranking person re-identification with k-reciprocal encoding[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 3652- 3661.

Article Outline

潘通, 李文国. 基于特征拼接的行人重识别[J]. 激光与光电子学进展, 2019, 56(16): 162001. Tong Pan, Wenguo Li. Person Re-Identification Based on Feature Stitching[J]. Laser & Optoelectronics Progress, 2019, 56(16): 162001.