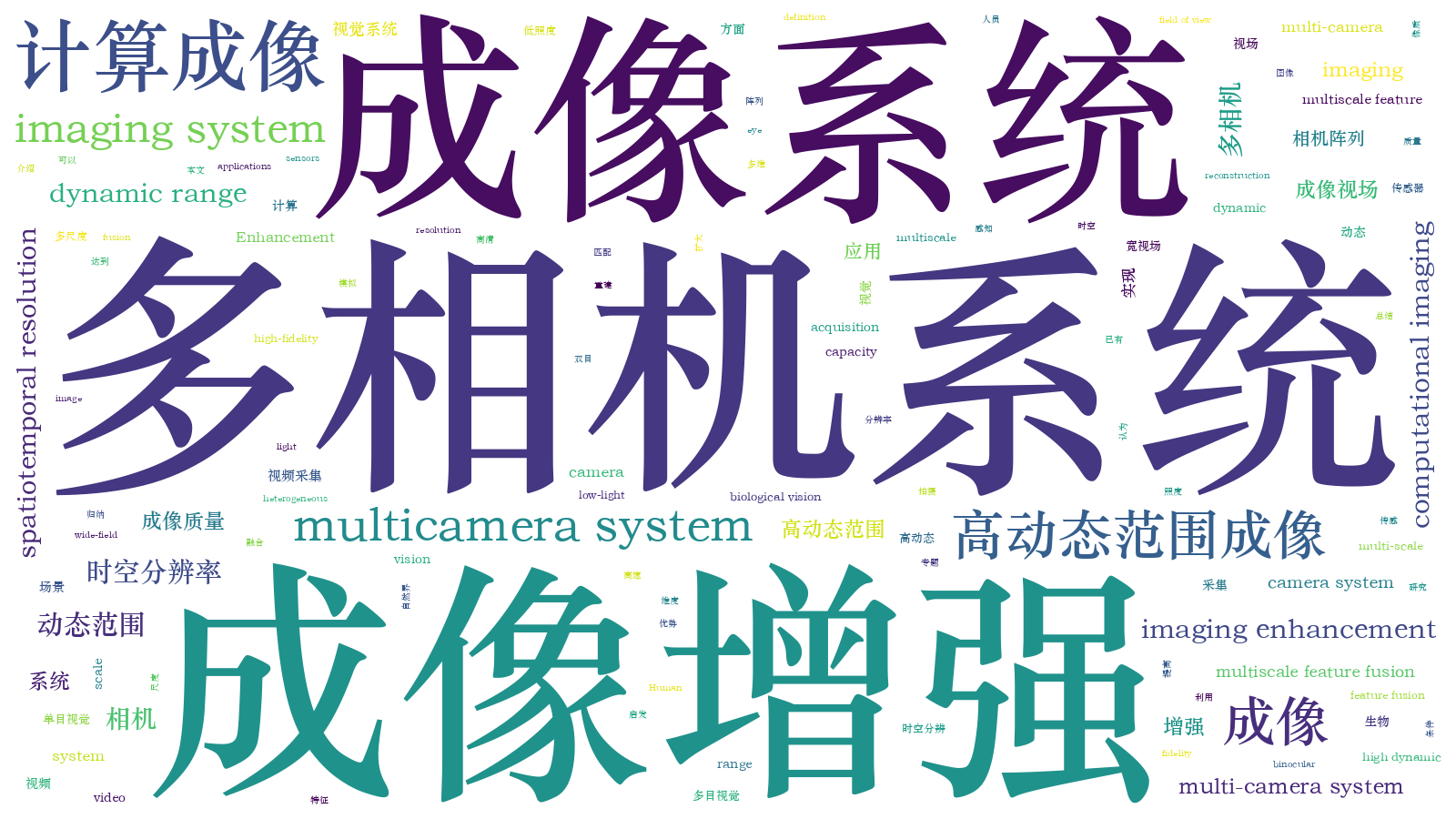

多相机系统:成像增强及应用  下载: 1485次特邀综述

下载: 1485次特邀综述

1 引言

自相机发明以来,提升其成像能力一直是业界追求的目标,如高动态范围 (HDR) 采集,超高分辨率或十亿像素 (gigapixel imaging) 成像,时空高速 (high spatiotemporal resolution imaging) 或高速 (high speed) 录像,低照度 (low-light imaging) 成像等。但由于光的衍射极限、传感器物理参数(如采集速率和传感器动态范围)、环境噪声等的限制,单相机捕获的信息受限,制约了它的成像性能,很难同时兼顾在不同维度及不同尺度等多方面的高质量重建。例如,一般的高速视频采集过程需要牺牲空间分辨率来保证即时的信息存储,而宽视场成像,如全景 (panorama) 拍摄,则会以时间维度换取空间视角信息。

阵列相机 (array camera) 通过多个相机的组合来获取更丰富的不同维度和尺度的场景信息,可以帮助实现更全面的图像重建[1],突破单相机成像的局限。应用多相机系统(multi-camera system) 实现高质量成像的核心是如何利用不同的相机对场景进行精准采样,以及如何有效融合已捕获的信息来帮助重建。近20年来,蓬勃发展的计算成像技术 (computational imaging)已成功实现了对光学成像系统的建模,并利用数学手段从观测图像中逆向求解出了场景目标的高质量、高维度物理信息。目前已有的工作提供了不少利用多维多尺度特征进行计算采样与重构的思路,包括基于先验规则 (rules-based) 的方法[2],以及当前的研究热点——基于深度学习 (deep learning-based) 的策略[3]。同时,在产业中也涌现出了基于多相机成像模组的智能摄像设备,如:Light公司在2015年宣传的L16产品(https:∥www.amazon.co.uk/Light-B077RP4MHN-light-lens-camera/dp/B077RP4MHN,该产品通过16个焦段不同的相机实现了变焦段超高清拍摄),Insta360公司推出的消费者级别的Pro 2产品(https:∥store.insta360.com/product/Pro_2,该产品利用多相机环形架构实现实时全视角4K视频推流),Raytrix公司上线的R42系列(https:∥raytrix.de/wp-content/uploads/software/R42.pdf,R42系列通过多透镜阵列实现了千万像素级别的3D光场视频采集),安科迪公司的Mantis系列(http:∥www.aqueti.cn/mantis70_0601.pdf,该系列结合18个窄视场角相机与1个广视场角相机实现了高达1.07亿像素的广域视场高清视频拍摄)。此外,随着微型处理器计算能力的提升,多相机成像系统已成为移动影像设备(如华为、小米、苹果等系列智能手机)的标配。应用多相机系统探索多维多尺度的计算融合来实现高质量成像也成为这些智能设备巨头争夺用户的必要手段。

本文立足多相机成像增强,对已有的相关研究进行概述总结,深入讨论其在宽视场超高清成像、时空高速视频采集、高动态范围成像、低照度成像中的应用,细述各方案中利用多维多尺度特征进行计算采样与融合重构的策略。同时,本文主要关注多相机系统在成像视场范围、成像时空分辨率以及动态范围等方面的增强表现,对于其在谱段融合[4]、相位增强[5]、偏正感知[6]等方面的应用留待后续归纳。

本文首先介绍多相机成像增强的基本原理,引出多相机成像融合增强的问题,继而针对常见的多种应用案例分章节进行深入讨论,最后对多相机系统在成像增强方面的作用进行总结,并展望了未来小型化、轻便化的多相机系统结构在更多场景下的普及应用。

2 多相机成像增强的基本原理

光信号作为物理世界信息感知的重要载体,其特征涉及空间、角度、时间、动态范围与极化方向等多个维度,从而承载着不同的场景特性[7]。Adelson等[8]于1991年提出用七维全光函数L(x,y,z,θ,ϕ,λ,t)来描述空间中任意位置(x,y,z)、任意角度(θ,ϕ)、任意波长λ、任意时刻t的光线。而经典成像模型下的单相机对曝光时间内来自不同角度的光线进行沿离散频谱通道(一般为R、G、B通道)的响应积分后投影至二维焦平面,最终获得七维全光函数的二维投影子空间信号,仅在空间维度上保留了高分辨率信息。当下市场上传感器的规模尺寸、像元大小、响应灵敏度等存在一定限制,进一步制约了单相机光学成像在空间维度、时间维度、特征维度与探测灵敏度等方面的表现。随着成像电子学以及计算机数据处理技术的发展,众多研究者尝试将信号处理计算手段引入到成像过程中(部分基于深度学习的典型计算光学成像技术如

人类及绝大多数哺乳动物自然演化出了双目视觉系统,而螳螂、蜻蜓等则是多目复眼系统[14],以满足不同的生存需求。多目生物视觉系统可以在长距离、宽视场、极大动态范围以及暗光等条件下实现对场景的良好感知。受上述自然界生物视觉多目采集的启发,研究人员积极探索多相机组合(阵列)来实现真实场景的高质量成像重建。

相较于单相机系统,多相机系统成像可以丰富捕获信息在空域、时域、频谱等维度上的特征,且各相机间对场景各维、各尺度的采样并不一定是均匀分布的(具体见

![多相机系统对模拟场景的多维多尺度采样说明[15]。(a) 模拟场景下,三相机视点示意图; (b) 三相机对场景各维各尺度均匀采样,即三相机的成像控制参数一致;(c)三相机对场景各维各尺度非均匀采样,即三相机的成像控制参数不一致,例如#1相机采用低空间分辨率,#2相机未保留色彩信息](/richHtml/lop/2021/58/18/1811013/img_2.jpg)

图 2. 多相机系统对模拟场景的多维多尺度采样说明[15]。(a) 模拟场景下,三相机视点示意图; (b) 三相机对场景各维各尺度均匀采样,即三相机的成像控制参数一致;(c)三相机对场景各维各尺度非均匀采样,即三相机的成像控制参数不一致,例如#1相机采用低空间分辨率,#2相机未保留色彩信息

Fig. 2. Illustration of various dimensional and multi-scale data acquisition with multi-camera systems in the toy model[15]. (a) The illustration of three cameras’ viewpoints in simulation scene; (b) uniform sampling in the multi-dimensional scene features, namely same imaging control setting for all cameras; (c) non-uniform sampling in the multi-dimensional scene features, namely various imaging control settings among cameras. For example, camera #1 captures at the low spatial resolution and camera #2 doesn’t record color information

利用多相机系统进行成像增强的工作流程一般为:

1) 利用多个相机对场景进行不同分辨率、不同特征维度的采样,优化光信号的低维耦合采集;

2) 基于空域/特征域对捕获的多源信息进行配准,以获取不同相机间每个像素处各维度特征的对应关系;

3) 利用该对应关系实现不同相机间的特征融合补偿,以实现各维度空间内的采样增强。

针对不同的多相机系统成像增强任务,多相机的耦合采集方式各异:为获取高速超清视频,可使用高空间分辨率与低时间分辨率的相机组合,或者使用低空间分辨率与高时间分辨率的相机组合;通过设置各相机间不同的曝光时长,捕获场景在更宽动态范围下的信息。不同相机的采集条件相异,因此如何实现多相机之间的精确配准对于多源信息的交互融合影响重大。经典的匹配方法有单应性矩阵变换[16]、光流矫正[17]等。此外,新近出现的基于深度学习的匹配方法,如局部单应性匹配[18]、可变形卷积[19]等,也逐渐得到广泛应用。对于多源信息的交互融合,一般分为像素级别、特征级别以及决策级别三类,其中:像素级别的融合直接使用经过不同源图像配准后的像素进行处理得到最终的融合图像;特征级别的融合先对配准后的多源图像进行特征提取、融合,再估测出最终的图像;决策级别的融合一般利用目标检测、识别等高阶图像任务对多源图像的决策输出进行融合,从而得出最终的决策结果。近年来,卷积网络凭借其对高维特征更好的表征能力[20],逐渐代替传统的拉普拉斯变换、小波变换[21]或引导滤波[22]等方法来实现多源信息间的高质量融合。

下文将通过不同的实际案例逐步介绍多相机在宽视场超高清成像、时空高速视频采集、高动态范围成像和低照度增强等方面应用的主要架构及性能。

3 宽视场超高清成像

宽视场超高清成像旨在生成同时具有大视场和高分辨率的图像或视频,在智慧城市、卫星侦察、医学显微等领域均有应用。利用宽视场超高清成像设备能够对目标场景进行广视域成像及分析处理,进一步推动基于此类数据的社会行为分析。

在传统的相机设计中,镜头速率(lens speed) 和视场随着镜头孔径的减小而增大。即:为了获取更大的视场,需要减小系统焦距(孔径减小,传感器尺寸不变),从而使得像素密度降低,图像分辨率下降。因此,传统的单孔径成像无法同时实现宽视场和高分辨率成像[23]。一种简单的获取宽视场超高清图像的方式是利用高分辨率相机按照一定路径扫描拍摄后再拼接,但是该方式获取的首帧到尾帧间有较大时间差,每个拍摄时刻都有大面积成像盲区,无法正确处理场景中的运动物体[24]。Kopf等[24]用一台高分辨率佳能相机旋转捕捉不同位置曝光最佳的图像,然后对图像进行匹配拼接得到了十亿像素级宽视场高清图像(见

![单相机扫描拍摄及拼接结果[24]。(a)直接拼接的结果;(b)对(a)进行亮度对齐和色调映射处理后的结果](/richHtml/lop/2021/58/18/1811013/img_3.jpg)

图 3. 单相机扫描拍摄及拼接结果[24]。(a)直接拼接的结果;(b)对(a)进行亮度对齐和色调映射处理后的结果

Fig. 3. Mosaic results acquired with single camera through scanning[24]. (a) Captured images with only geometric alignment; (b) result after radiometric alignment and tone mapping

传统阵列相机依赖于精密的光学、机械设计,大部分需要繁琐的校准以保证拍摄精度,同时需要处理体量庞大的数据流,给系统设计带来了较大挑战。可实现宽视场超高清成像的阵列相机系统最初设计为规则排列的相机阵列,其设计遵从均匀感知原理 (uniform sensation principle),利用计算成像技术同时保证高分辨率和大视场。杜克大学在此基础上提出了多尺度设计的概念[25],使得此类阵列相机系统得以小型化。清华大学最新的系统解除了子相机均匀排列的限制,在多尺度阵列相机的基础上进一步加入了模块化设计,所设计的非结构化相机系统可以根据实际场景分布调整局部相机分布[26]。

本章归纳了基于传统阵列相机及多尺度阵列相机的宽视场超高清典型成像方法,分析了各系统的设计特点及多相机组合成像带来的增益,对比了不同方法的优劣。

3.1 基于传统阵列相机的宽视场高清成像方法

宽视场高清成像的探究从最初的超大胶片成像、单相机扫描拼接到基于阵列相机的复杂系统逐步发展成熟。Wilburn等[27]设计了一个由100个定焦定光圈相机构成的阵列系统,系统中的子相机紧密排列,以近似单中心投影 (single center of projection)。该系统由4台主机控制,利用现场可编程门阵列(FPGA)编程实现相机同步;每个子相机自带一个计算单元,分担数据处理压力。子相机捕获的原始数据被压缩后传输给主机,以减轻数据传输压力,随后通过图像拼接技术进行配准融合,最终合成千万像素级宽视场高清视频。系统结构及对应的生成结果见

![一种宽视场高清成像相机阵列及其合成结果[27]。(a)相机阵列结构图;(b)由该阵列相机拍摄得到的宽视场超高清图像;(c) 图(b)的局部放大视野](/richHtml/lop/2021/58/18/1811013/img_4.jpg)

图 4. 一种宽视场高清成像相机阵列及其合成结果[27]。(a)相机阵列结构图;(b)由该阵列相机拍摄得到的宽视场超高清图像;(c) 图(b)的局部放大视野

Fig. 4. A wide-field high-resolution imaging array camera and its synthesized image[27]. (a) Architecture of the array camera; (b) captured image using the array camera; (c) zoomed-in view of (b)

Nomura等[12]设计了一种可弯曲的小型相机阵列(

3.2 基于多尺度阵列相机的宽视场高清成像方法

基于传统阵列相机设计的宽视场高清成像系统往往体积庞大,多尺度设计的提出实现了阵列相机系统的小型化,成为宽视场超高清成像的主流方法。Brady等[25]发现基于微相机的成像系统的镜头速率和视场可以与镜头尺寸无关,继而基于此设计了基于并行微型相机阵列的AWARE-2相机。AWARE-2为单中心多尺度多孔径设计,由一个球对称的物镜和98个包围物镜的次级微相机组成(见

![AWARE-2的光学结构及重建结果。(a)(b)AWARE-2的并行微型相机结构图[25];(c)AWARE-2 拍摄的宽视场超高清图像及其局部放大[31]](/richHtml/lop/2021/58/18/1811013/img_6.jpg)

图 6. AWARE-2的光学结构及重建结果。(a)(b)AWARE-2的并行微型相机结构图[25];(c)AWARE-2 拍摄的宽视场超高清图像及其局部放大[31]

Fig. 6. Optical structure and image reconstruction of AWARE-2. (a)(b) Structure of AWARE-2’s parallel array of micro-camera [25]; (c) an image captured using AWARE-2, of which the insets are digitally magnified images[31]

上述相机虽然可以拍摄亿级宽视场高清内容,但需要复杂、费时的标定,且要求子相机间有一定的重叠区域以便图像匹配,灵活性和实用性受限。针对以上限制,Yuan等[32]搭建了一个分层模块化设计的非结构化阵列相机系统[26],见

![非结构化阵列相机[26]。(a)相机系统及子模块结构图,相机和镜头的性质根据目标性质非均匀选择;(b) 使用非结构化相机捕获的十亿像素级视频帧,红色和蓝色框分别表示全局和局部摄影机的分布](/richHtml/lop/2021/58/18/1811013/img_7.jpg)

图 7. 非结构化阵列相机[26]。(a)相机系统及子模块结构图,相机和镜头的性质根据目标性质非均匀选择;(b) 使用非结构化相机捕获的十亿像素级视频帧,红色和蓝色框分别表示全局和局部摄影机的分布

Fig. 7. The UnstructuredCam[26]. (a) Schematic of UnstructuredCam system consisting of multiple columns of subarrays and UnstructuredCam module, and the cameras and lenses are selected heterogeneously based on the nature of the targets; (b) gigapixel-level videography captured using the UnstructuredCam, where the red and blue frames represent the distributions of the global and local cameras

多尺度多孔径成像方法目前已有相对成熟的相机系统应用,然而对于其应用和量产还有许多值得探索的方向,如系统功耗优化[1]。

4 时空高速视频采集

在当下消费者级别的成像市场中,相机的主流帧率一般在30~90 frame/s之间。但在燃烧研究、细胞成像、体育赛事分析等特殊应用场景中,高速运动过程中细微的时/空信息变化需要上百乃至上万帧率的高速成像设备才能准确记录,用以后续的研究分析。传统的高速摄像要求感光芯片的灵敏度大幅提升以及电路噪声强度进一步降低,且对数据转化和存储速度有较高要求,这势必会提升成像模块的成本并限制了它的普及应用。此外,消费者追求更高清、更高速的内容获取,对便携型成像模组的需求日益增长。对单个普通相机拍摄的视频进行时间维度上的插值,很容易引起运动混叠(如

![运动混叠现象[34]。(a)红球以正弦状的轨迹在运动;(b)相机以较低帧率对该运动状态进行捕获所获得的帧序列,该帧序列中显示红球沿直线运动,这种错误的感知现象被称为运动混叠现象;(c)利用已有序列在时间维度上理想插值获得的帧序列(蓝色虚线矩形代表预测帧)无法恢复正确的运动信息](/richHtml/lop/2021/58/18/1811013/img_8.jpg)

图 8. 运动混叠现象[34]。(a)红球以正弦状的轨迹在运动;(b)相机以较低帧率对该运动状态进行捕获所获得的帧序列,该帧序列中显示红球沿直线运动,这种错误的感知现象被称为运动混叠现象;(c)利用已有序列在时间维度上理想插值获得的帧序列(蓝色虚线矩形代表预测帧)无法恢复正确的运动信息

Fig. 8. Motion aliasing[34]. (a) A ball moving in a sinusoidal trajectory; (b) an image sequence of the ball is captured at low frame-rate, the perceived motion is along a straight line, this false perception is referred to as “motion aliasing”; (c) the filled-in frames (indicated with blue dashed lines) which are obtained via an ideal temporal interpolation can not produce the correct motion

2002年,Shechtman等[34]第一次提出利用多个低分辨率、低帧率相机输入恢复高帧率视频输出的方法,他们利用不同的相机在不同时刻以相同的帧率采样,从而恢复出了场景在整条时间线上的运动信息。2004年,Wilburn等[35]进一步提出了利用多相机电子卷帘快门相继拍摄合成高清高速视频内容的思路。以上研究主要讨论了如何实现时间维度上更高细粒度的恢复。对于高速成像中的高清图像的获取,Wang等[36]、Cheng等[37]提出了用高分辨率、低帧率相机和低分辨率、高帧率相机同步触发的方式,分路获取高分辨率空间信息或运动信息的方法,实现了高分辨率空间信息与运动信息的融合,进而实现了高速高清成像。

本章根据不同相机的工作协同方式,将现有的基于传统相机的高速高清成像系统分为异步触发和同步触发两种类型进行介绍。

4.1 相同帧率的异步触发相机组合

异步触发组合是指不同的相机在不同的时刻开始记录运动信息,通过不同帧序列在时间轴上的混合再采样获得整个时间轴上的运动信息。

2002年,Shechtman等[34]首次提出了时空超分辨率的概念,并针对多个时刻采集的低分辨率视频帧序列进行了高帧率内容的重建,如

![同帧率的异步触发相机组合[34]。(a)~(d)不同相机在不同时刻开始拍摄的帧序列;(e)恢复的高帧率帧序列](/richHtml/lop/2021/58/18/1811013/img_9.jpg)

图 9. 同帧率的异步触发相机组合[34]。(a)~(d)不同相机在不同时刻开始拍摄的帧序列;(e)恢复的高帧率帧序列

Fig. 9. Illustration of multi-cameras triggered with the same frame rate[34]. (a)--(d)Captured sequences from different cameras at different time; (e) reconstructed sequences with high frame rate

通过多个采样的低分辨率时空域帧序列建立线性方程组,提取其与高帧率视频之间的逆映射函数,采用最小二乘法求解得到高帧率时空域信息,从而实现均匀高帧率内容的重建过程。

Wilburn等[35]在此基础上利用密集普通相机阵列的卷帘快门相继拍摄生成了帧率为1560 frame/s的高速视频。如

![Wilburn等的相机阵列示意图[35]。(a)相机系统;(b)相机阵列的触发顺序;(c)从不同帧中获取相同时刻的数据切片生成最终图片,抑制电子卷帘快门引起的失真;(d)重建的气球被击破的高速视频片段](/richHtml/lop/2021/58/18/1811013/img_10.jpg)

图 10. Wilburn等的相机阵列示意图[35]。(a)相机系统;(b)相机阵列的触发顺序;(c)从不同帧中获取相同时刻的数据切片生成最终图片,抑制电子卷帘快门引起的失真;(d)重建的气球被击破的高速视频片段

Fig. 10. Illustration of Wilburn et al.’s multiple camera array[35]. (a) Detailed structure; (b) firing order for camera array; (c) the final view consists of different rows (shown in gray) in each camera at the same time, which suppresses the distortion caused by rolling shutter; (d) reconstructed high-speed video of a popping balloon

4.2 不同帧率的同步触发相机组合

同步触发组合是指不同的相机在同一时刻开始记录运动,相机间帧率各不相同。一般来说,该组合中各相机间的空间分辨率不尽相同,这样可以保证时空采样特征的多样性,在考虑高帧率的同时实现了高分辨率的保留。目前,高速高清成像系统主要使用的是低帧率、高分辨率相机与高帧率、低分辨率相机的混合。

考虑到一般光场相机每秒钟仅能存储3帧,庞大的光场数据量使得现有相机无法记录视场内完整的运动信息,Wang等[36]提出了一种光场相机和普通相机相结合的混合相机系统,如

![Wang等所提方案的系统结构及输入、输出[36]。(a)系统结构;(b)系统捕获的标准30 frame/s视频内容和3 frame/s光场序列;(c)最终生成的30 frame/s光场视频](/richHtml/lop/2021/58/18/1811013/img_11.jpg)

图 11. Wang等所提方案的系统结构及输入、输出[36]。(a)系统结构;(b)系统捕获的标准30 frame/s视频内容和3 frame/s光场序列;(c)最终生成的30 frame/s光场视频

Fig. 11. System setup and input/output proposed by Wang et al.[36]. (a) Camera setup; (b) the inputs consist of a standard 30 frame/s video and a 3 frame/s light field sequence; (c) finally generated 30 frame/s light field video

![Wang等提出的图像处理框架[36]。(a)估测关键帧间的视差以及视频帧在时间维度上的运动信息,从而预测目标帧时刻两路视角对应的视差图,实现从高帧率视频内容向低帧率视点的映射;(b)融合所有参考图像形成最终的重建图像](/richHtml/lop/2021/58/18/1811013/img_12.jpg)

图 12. Wang等提出的图像处理框架[36]。(a)估测关键帧间的视差以及视频帧在时间维度上的运动信息,从而预测目标帧时刻两路视角对应的视差图,实现从高帧率视频内容向低帧率视点的映射;(b)融合所有参考图像形成最终的重建图像

Fig. 12. Overall image processing architecture proposed by Wang et al.[36]. (a) Estimates the disparity at the key frames, as well as the temporal flow in the 2D video to generate the disparity at the target frame and then warps high frame-rate video to the low frame-rate viewpoint; (b) fuses all the reference images to output the final reconstruction

以上方案利用已知部分时刻的光场相机与标准相机对应帧之间的视差关系预测出每个时刻两者之间的视差图,从而实现标准相机空间特征向光场相机的转化,最后实现光场相机在时间轴上完整的运动信息恢复,获得高速高清成像。

Cheng等[37]从另一个角度出发,将高分辨率、低帧率的空间特征向低分辨率、高帧率视角转换,借助时间维度上的运动向量,将高分辨率信息传递到时间轴上的每个时刻。

如

![Cheng等方案的具体阐述[37]。(a)双相机结构;(b)高分辨率信息在时间维度上的传递过程;(c)高、低分辨率融合的具体流程](/richHtml/lop/2021/58/18/1811013/img_13.jpg)

图 13. Cheng等方案的具体阐述[37]。(a)双相机结构;(b)高分辨率信息在时间维度上的传递过程;(c)高、低分辨率融合的具体流程

Fig. 13. Illustration of Cheng et al.’s proposal[37]. (a) Dual camera setup; (b) propagation of high-resolution map along with the temporal dimension; (c) the detailed pipeline of fusing the high resolution map and the low resolution map

![Cheng等方案的可视化效果[37]。(a) 高分辨率、低帧率的输入图Iref; (b) 上采样的低分辨率、高帧率输入图ILSR↑;(c)(d)Iref和ILSR↑中对应的局部图片特写; (e) 该方案的重建图](/richHtml/lop/2021/58/18/1811013/img_14.jpg)

图 14. Cheng等方案的可视化效果[37]。(a) 高分辨率、低帧率的输入图Iref; (b) 上采样的低分辨率、高帧率输入图ILSR↑;(c)(d)Iref和ILSR↑中对应的局部图片特写; (e) 该方案的重建图

Fig. 14. Visualized results of Cheng et al.’s proposal[37]. (a) Input frame (Iref) with high resolution and low frame rate; (b) input frame (ILSR↑) with low resolution and high frame rate; (c)(d) close-up of patches in Iref and ILSR↑; (e) reconstructed frame with the proposal

当下基于传统相机的时空高速高清视频成像虽然在一定程度上突破了光场相机或普通高清相机在帧率上的限制,但离产业界对高速摄像的帧率要求仍有一定距离,如何解决现有高清相机或光场相机在时间维度上更高密度的采样重建是后续有待解决的问题。

5 多相机高动态范围成像

传统相机难以捕获自然场景中的全部信息,且往往会引入噪声或信息丢失(传统相机成像的流程图见

随着图像处理技术的进步,一些学者提出利用单张图像或多张不同曝光的图像来恢复不合理曝光区域的纹理细节(见

![基于多曝光图像序列的高动态重建和基于反色调映射的高动态重建示意图[39]。(a)基于多曝光图像序列的高动态重建;(b)基于反色调映射的高动态重建](/richHtml/lop/2021/58/18/1811013/img_16.jpg)

图 16. 基于多曝光图像序列的高动态重建和基于反色调映射的高动态重建示意图[39]。(a)基于多曝光图像序列的高动态重建;(b)基于反色调映射的高动态重建

Fig. 16. High dynamic range imaging based on multi-exposure image sequence and high dynamic range imaging based on inverse tone mapping[39]. (a) High dynamic range imaging based on multi-exposure image sequence; (b) high dynamic range imaging based on inverse tone mapping

5.1 基于光学对齐的多相机高动态重建方法

基于硬件的多相机高动态重建方法一般利用分光镜辅助构建系统,分光镜两端为不同类型或功用的相机。Lee等[40]构建了由一台低分辨率相机、一台高分辨率相机和分光镜构成的混合相机系统,在该系统中,主相机接收分光镜的透射光拍摄高分辨率(high resolution) 图像,辅相机接收反射光拍摄低分辨率(low resolution) 图像。随后,利用遮挡区域检测辅助光流计算,更准确地估计主相机和辅相机的帧间运动,进而重建高动态视频。Froehlich等[41]用两台相机分别捕获高光和暗光信息,两台相机的曝光差为4 Fstop,通过一个1∶16透过率的半透射镜使两台相机可以同步拍摄场景内容。该设计在相机使用长焦段时可能会导致伪影,因此部分情况下需要使用50%透过率的分光镜配合减光滤光镜来保证拍摄的曝光比,如

![基于分光镜的高动态相机示意图及重建结果[41]。(a)1∶16透过率的分光镜同步拍摄;(b)50%透过率的分光镜配合减光滤光镜拍摄; (c)高动态相机重建的场景](/richHtml/lop/2021/58/18/1811013/img_17.jpg)

图 17. 基于分光镜的高动态相机示意图及重建结果[41]。(a)1∶16透过率的分光镜同步拍摄;(b)50%透过率的分光镜配合减光滤光镜拍摄; (c)高动态相机重建的场景

Fig. 17. Schematic and reconstructed frames of high dynamic range camera based on beam splitter[41]. (a) Capture with 1∶16 beam splitter; (b) capture with 50% semitransparent mirror and camera mounted with a neutral density filter; (c) reconstructed scene using the high dynamic range camera

Tocci等[42]受多传感器分色相机的启发设计了一个可以捕获高达7 Fstop动态范围的三传感器单镜头相机,如

![多传感器高动态相机及一组拍摄结果[42]。(a)相机的光学结构,其中LE、ME、HE分别代表传感器接收的光的量为低、中、高;(b)最终的重建图像以及由HE、ME、LE传感器得到的低动态范围(LDR)图像](/richHtml/lop/2021/58/18/1811013/img_18.jpg)

图 18. 多传感器高动态相机及一组拍摄结果[42]。(a)相机的光学结构,其中LE、ME、HE分别代表传感器接收的光的量为低、中、高;(b)最终的重建图像以及由HE、ME、LE传感器得到的低动态范围(LDR)图像

Fig. 18. Multi-sensor high dynamic range camera and a group of captured images[42]. (a) Optical architecture of the high dynamic range camera, the terms high, medium, and low exposure (HE, ME, LE, respectively) refer to the sensors based on the amount of light each sensor receives; (b) final reconstructed image, where the inset photos show the low dynamic range images from the high, medium, and low-exposure sensors, respectively

5.2 基于图像处理的多相机高动态重建

已有的基于单帧图像增强进行高动态重建的方法一般采用逆色调映射[43]实现动态范围的扩展[44],如

利用多相机系统拍摄多曝光序列,在捕获更广曝光范围的同时,更完整地记录了场景中空域和时域的有效信息,对重建高动态图像或视频提供了极大的增益。多曝光图像由不同的相机拍摄,因此需要对输入序列间的视差或运动进行补偿,以避免伪影。一般使用深度估计来实现多相机间的匹配,但相机间曝光水平的不同会给深度估计带来一定难度,如何准确估计多曝光多视角图像的深度图是重建过程中的难点。Lin等[45]最早提出了一套多相机高动态重建的完整流程,包括相机响应曲线(CRF) 估计、匹配对齐、融合重建和鬼影去除步骤。他们将不同曝光的图像利用CRF转换为相同亮度的图像,随后使用置信传播 (belief propagation) 进行立体匹配,通过设置阈值来检测对应像素对中的误匹配,以去除鬼影。相机响应曲线为

此外,块匹配、可变形卷积也被运用到多相机高动态重建工作的运动或视差估计中[50-51]。Orozco等[51]将极限约束加入到块匹配(patch match) 中,通过邻近搜索和最大化双向相似度迭代优化寻找最佳匹配块。确定块匹配关系后可得到对齐的图像,进而融合重建高动态图像。Pu等[50]利用可变形卷积对齐多尺度图像特征,随后将对齐的特征输入融合网络中重建参考视角的高动态图像,重建网络流程见

![基于可变形卷积的高动态重建[50]。(a)重建网络流程图;(b)多相机多曝光输入的高动态重建结果](/richHtml/lop/2021/58/18/1811013/img_19.jpg)

图 19. 基于可变形卷积的高动态重建[50]。(a)重建网络流程图;(b)多相机多曝光输入的高动态重建结果

Fig. 19. High dynamic range (HDR) reconstruction based on deformable convolution[50]. (a) Flow chart of HDR reconstruction network; (b) HDR reconstruction on multi-exposure multi-camera input

高动态视频重建需要考虑时域一致性等更多方面,同时相关数据集较少,因此目前已有的多相机高动态重建方法大多数仍然立足于多视角高动态图像重建,而多视角多曝光高动态视频重建的探索较少。但随着HDR10、杜比视界等相关标准及显示设备的升级更新及移动电子设备的多摄化趋势,多相机高动态视频将是未来一个重要的探索方向和应用需求。

6 低照度成像

当成像模块捕获的光子数量不够充分时(拍摄环境照度低、曝光时间过短或光圈较小),拍摄所得的图像往往表现出噪声强、可见度低、对比度低等特征,提供给用户视觉和机器视觉的有效信息大打折扣,严重影响了风光摄影、安防监控、自动驾驶等任务在低照度下的表现。延长曝光时间或增加外置闪光灯,虽然可以改善成像时的光照条件,但容易引起捕获图像中的运动模糊及不自然的眩目感。如何实现低照度条件下的优质成像一直是图像处理领域的热门问题。

早在1990年,Pizer等[52]就利用直方图均衡化来提升图像的全局亮度。而后基于Retinex理论的图像属性分解模型于1997年被应用于低光照图像的增强[53],该模型通过对分离出来的反射图像和光照图像进行噪声抑制、亮度增强来推测理想曝光条件下该场景的成像。近些年来,由于深度学习技术的新兴发展,诸多研究[54]利用深度神经网络在大规模数据集上提取低照度图像的非线性表达,实现了具有较好泛化性的端到端低照度图像的增强。以上方法主要面向单张低照度图像进行质量增强,结合成像的先验知识,全局调整图像亮度水平,优化噪声并改善色彩空间。但由于单图像输入的特征有限,重建后的图像在色彩表现和纹理细节方面缺乏一定的真实性。因此,可以利用多相机系统获取更加丰富的输入信息,为低照度条件下的可靠优质成像提供保障。

低照度条件下的多相机成像模块致力于利用成对的传感器在有限的时间内捕获更多的光子并将其转化为电信号,模块中可使用多个成像参数(快门、分辨率、光圈等)不同的相同传感器或者成像参数相同的不同传感器来丰富低照度下的信号采集,且模块中也保留了一般条件下的彩色成像,可有效规避长曝光时间带来的模糊效应,保障最终成像结果的真实性。以下主要介绍当下三种典型的相机组合形式,并对其性能进行分析。

6.1 有外置光源与无外置光源的相机组合

延长曝光时间、加大光圈或者提高相机增益等方法在改善低照度成像质量的同时会引起运动模糊、景深有限、噪声放大等弊端,而闪光成像可以提供外在瞬间光源,改善周围光照环境,保留高频纹理细节,提升图像的信噪比,且不需要长时间曝光、大光圈或者高相机增益。但闪光光源一般为点光源,会导致场景中的物体受光不均匀,且闪光光源与环境光的差异会破坏原有场景的氛围,同时也会带来红眼效应或者尖锐的阴影等。

Petschnigg等[55]采用无闪光拍摄与闪光拍摄相结合的方式进行了低照度条件下的成像,用噪声水平低的闪光成像辅助去噪,将闪光图像中的高频纹理细节补充到无闪光图像中,在提升图像信噪比的同时保留了无闪光条件下的环境光分布,使得最终的成像更接近于场景的真实分布。此外,闪光图像与无闪光图像中瞳孔的变化也可以帮助定位瞳孔位置,从而削弱闪光带来的红眼效应。该方案在正常成像的基础上融合了闪光成像,并且融合了周围环境光和外在强点光源条件下的场景特征,在提升无闪光拍摄图像质量的同时有效地抑制了外置闪光带来的负面效应,极大地改善了低照度条件下的成像水平(效果见

![无外置光源成像与有外置光源成像的对比[55]。(a) 原始无外置光源成像、有外置光源成像以及两者结合的成像结果;(b)~(d) 三种成像结果的局部细节效果图](/richHtml/lop/2021/58/18/1811013/img_20.jpg)

图 20. 无外置光源成像与有外置光源成像的对比[55]。(a) 原始无外置光源成像、有外置光源成像以及两者结合的成像结果;(b)~(d) 三种成像结果的局部细节效果图

Fig. 20. Illustration of imaging with flash and without flash[55]. (a) Standard photography, flash photography and the combined photography;(b)--(d) enlarged views of the local details

6.2 可见光与不可见光的相机组合

尽管外置闪光灯给低照度条件下的成像提供了足够的亮度,但成像时也会由于瞬间爆发光照而在平滑表面上形成不自然的高光,而且使被拍摄者有眩目感。为了克服外置闪光灯带来的困扰,Krishnan等[56]提出了暗闪光技术。暗闪光是指去除了可见光波段的外置光源,其绝对辐照度如

![传统RGB成像与暗闪光成像的光谱响应曲线说明及不同通道对应亮度的对比[56]。(a)(c)传统RGB成像和暗闪光成像的光谱响应曲线,j∈{1,2,3,4,5}分别对应可见光红色、绿色、蓝色以及红外、紫外波段;(b)暗闪光光源在1 m处对应的绝对辐照度;(d)~(l)低光照条件下,长曝光RGB成像、环境光RGB成像以暗闪光成像在相同位置处可见光红色和红外波段的亮度及其梯度对比](/richHtml/lop/2021/58/18/1811013/img_21.jpg)

图 21. 传统RGB成像与暗闪光成像的光谱响应曲线说明及不同通道对应亮度的对比[56]。(a)(c)传统RGB成像和暗闪光成像的光谱响应曲线,j∈{1,2,3,4,5}分别对应可见光红色、绿色、蓝色以及红外、紫外波段;(b)暗闪光光源在1 m处对应的绝对辐照度;(d)~(l)低光照条件下,长曝光RGB成像、环境光RGB成像以暗闪光成像在相同位置处可见光红色和红外波段的亮度及其梯度对比

Fig. 21. Illustration of spectral response curves for traditional RGB imaging and dark flash imaging along with the luminance comparison between different channels[56]. (a) (c) Spectral response curves for RGB imaging and dark flash imaging, j∈{1,2,3,4,5} for red, green, blue, IR, and UV channels; (b) absolute irradiance at 1 m from the dark flash; (d)--(l) under low-light condition, luminance and its gradient comparison between the red channel and IR channel of the corresponding pixel in the long-exposure imaging, ambient light imaging, and dark flash imaging

在此基础上,Wang等[57]提出了采用多相机系统与暗闪光技术结合的方式来克服不可见光波段成像弊端的方案。该方案中,他们将标准RGB相机中的红蓝通道换成近红外 (NIR) 、近紫外 (NUV) 通道构成NIR-G-NUV相机,同时搭配标准的RGB相机构成双摄系统,使用暗闪光技术实现了低照度成像,见

![可见光与不可见光波段成像组合示意图[57]。(a)理想相机原型;(b)实际搭建系统及光谱曲线](/richHtml/lop/2021/58/18/1811013/img_22.jpg)

图 22. 可见光与不可见光波段成像组合示意图[57]。(a)理想相机原型;(b)实际搭建系统及光谱曲线

Fig. 22. Illustration of hybrid imaging setup with RGB and NIR-G-NUV cameras[57]. (a) An idealized prototype; (b) an actual camera system and spectral curves

该方案考虑到了可见外置闪光光源会对成像对象产生的干扰,结合传统RGB成像与暗闪光成像,利用可见光波段标准成像与不可见光波段闪光成像同时在低照度条件下拍摄,以闪光成像为参考恢复理想RGB成像效果(见

![Wang 等方案的效果图[57]。(a)低照度RGB相机输入(这里显示了5倍数字增益后的图像,便于观察);(b)暗闪光相机输入;(c)输出](/richHtml/lop/2021/58/18/1811013/img_23.jpg)

图 23. Wang 等方案的效果图[57]。(a)低照度RGB相机输入(这里显示了5倍数字增益后的图像,便于观察);(b)暗闪光相机输入;(c)输出

Fig. 23. Visualization of Wang et al.’s method[57]. (a) RGB input (visualized here with a digital gain of 5×); (b) dark-flash input;(c) output

6.3 单通道与多通道相机组合

上文中提及的相机模组使用不可见光波段在低照度条件下进行光电转换,虽然降低了强可见光对人眼造成的眩晕感,但传感器前的滤波片仍造成了部分光信号损失,且容易带来色彩空间的失真。为了最大程度地保留入射光信号,Dong等[58]和Guo等[59]学者提出了使用单通道相机和彩色相机结合的组合方式来实现低照度成像的方法。单通道相机中舍弃了传感器前端的彩色滤波片,虽然无法恢复相应的色彩信息,但凭借其相对更高的光通过率,可以更细腻地保存场景的结构变化,保证了低照度下的清晰成像。

2015年8月,奇酷360首次推出单通道与多通道结合 (monochrome+RGB)的旗舰版双摄手机,该手机利用单通道成像为彩色成像补充场景的高频纹理细节,因此在低照度条件下具有出色的成像结果。该双摄组合后来也成为主流的双摄配置,在华为、OPPO等手机中加以应用[60]。不同于以往利用单通道图像进行结构信息增强的思路,Dong等[58]利用彩色相机获取的色彩信息给细节高清的灰度图像进行上色,实现了高质量成像。他们利用输入图片对在局部灰度空间的相似性来寻找上色的最佳参考,因而对于那些被遮挡的部分,也可以借助局部的灰度分布找到一个最接近的上色区域来辅助上色,最终实现单通道图像的高质量成像。

在此基础上,Guo等[59]采用混合尺度的单通道相机与彩色相机组合系统进行低照度条件下的成像,成像流程如

![混合尺度的单通道相机与彩色相机实现的低照度高质量彩色成像流程图[59]](/richHtml/lop/2021/58/18/1811013/img_24.jpg)

图 24. 混合尺度的单通道相机与彩色相机实现的低照度高质量彩色成像流程图[59]

Fig. 24. Workflow of low-light and high-quality color imaging with hybrid monochrome and color cameras[59]

该方案对输入图像对中特征空间的差异性进行了有参考的补偿,逐步减小输入图像对之间的特征差距,实现了不同视角下的特征匹配迁移。具体来说,该方案利用光信息丰富的单通道图像在低分辨率尺度上对彩色图像进行曝光调整(RefEC模块),使彩色图像与单通道图像的曝光水平一致。接着,在RefColor模块中,利用增强后的彩色图像和单通道图像在亮度空间上的相似性计算两个视角间的对应像素的位移,从而实现了单通道图片在低分辨率尺度上的色彩恢复。最后,将得到的同一个视角的低分辨率彩色信息和高分辨率结构信息输入到RefSR模块中进行色彩空间的插值,最终获得了高分辨率的高质量彩色图像(结果见

![Guo等的方案在低照度实拍数据集上的效果细节可视化[59]。(a)低分辨率RGB输入图像(此处为了方便对比,将低分辨率输入放大到高分辨率大小);(b)高分辨率单通道输入图像;(c)重建后的高分辨率RGB图像; (d) 对(a)图进行数字增益, 用以展示噪声与模糊现象](/richHtml/lop/2021/58/18/1811013/img_25.jpg)

图 25. Guo等的方案在低照度实拍数据集上的效果细节可视化[59]。(a)低分辨率RGB输入图像(此处为了方便对比,将低分辨率输入放大到高分辨率大小);(b)高分辨率单通道输入图像;(c)重建后的高分辨率RGB图像; (d) 对(a)图进行数字增益, 用以展示噪声与模糊现象

Fig. 25. Close-up performance of Guo et al.’s method on the real scenes in the low-light condition[59]. (a) Low-resolution RGB input images (for comparison, the low-resolution inputs are enlarged to the high-resolution sizes); (b) high-resolution monochromic images; (c) reconstructed high-resolution RGB images; (d) the value-amplified low-resolution images from (a) for showing noise and blur

该方案将低照度成像问题化解为混合尺度单通道图像与彩色图像融合的问题,利用输入图像对在不同特征维度空间上的多样性信号进行分辨率空间、色彩空间的高分辨率重建,避免了长曝光引起的动态模糊,也保证了输出图像色彩的真实性。

多相机低照度成像系统架构繁多,成像形式丰富,重建内容更加稳定可靠。但当前的研究工作更多关注于静止场景或运动较小的场景的拍摄,对于低照度下运动信息的有效重建有待后续研究。

7 结束语

受生物双目和多目视觉系统启发的多相机成像系统,通过对不同维度、不同尺度的多源信息输入进行计算融合,实现了更高质量的场景重建,降低了高质量成像对单一相机模组光学硬件的要求。本文逐一介绍了多相机成像系统在宽视场超高清成像、时空高速视频采集、高动态范围成像及低照度成像四个方面的成像增强应用,以期帮助读者理解多相机成像系统在成像质量增强方面的优势。相对于单相机成像时的启发式增强,多相机系统利用不同的相机分别保留了原始场景更多维度的高分辨率采样,而后基于空域/特征域的配准实现各相机间多维特征的参考融合,保障了全系统内各维度成像增强表现的真实性、可靠性,从而更加鲁棒地实现高质量场景重建。但如何利用多相机系统实现更优的低维耦合离散信号采样,提升高质量成像能力是需要进一步深究的问题。

本文主要关注多相机系统在成像视场范围、成像时空分辨率以及动态范围等方面的增强表现。对于多相机系统在显微成像、高光谱高清成像、遥感成像等领域的应用值得读者进一步关注。同时,文中提及的多相机系统在普及应用时如何做到轻便化、小型化还需要学术界和产业界的共同努力。更进一步,人工智能技术的飞速发展带领着计算成像技术实现新的突破,如何更深入地在多相机系统中将人工智能技术与光学系统设计联合起来也是非常值得研究的新兴方向[10,61]。

[1] Brady D J, Pang W B, Li H, et al. Parallel cameras[J]. Optica, 2018, 5(2): 127-137.

[2] 戴琼海, 索津莉, 季向阳, 等. 计算摄像学: 全光视觉信息的计算采集[M]. 北京: 清华大学出版社, 2016.

Dai QH, Suo JL, Ji XY, et al.Computational photography: computational capture of plenoptic visual information[M]. Beijing: Tsinghua University Press, 2016.

[3] Barbastathis G, Ozcan A, Situ G H. On the use of deep learning for computational imaging[J]. Optica, 2019, 6(8): 921-943.

[4] Cao X, Yue T, Lin X, et al. Computational snapshot multispectral cameras: toward dynamic capture of the spectral world[J]. IEEE Signal Processing Magazine, 2016, 33(5): 95-108.

[5] ManekarR, TayalK, KumarV, et al. End-to-end learning for phase retrieval[C] //ICML workshop on ML Interpretability for Scientific Discovery, July 13-18, 2020, Virtual Event. Cambridge: PMLR, 2020.

[6] Yao Y, Zuo M, Dong Y, et al. Polarization imaging feature characterization of different endometrium phases by machine learning[J]. OSA Continuum, 2021, 4(6): 1776-1791.

[7] 索津莉, 刘烨斌, 季向阳, 等. 计算摄像学: 核心、方法与应用[J]. 自动化学报, 2015, 41(4): 669-685.

Suo J L, Liu Y B, Ji X Y, et al. Computational photography: keys, methods and applications[J]. Acta Automatica Sinica, 2015, 41(4): 669-685.

[8] Adelson EH, Bergen JR. The plenoptic function and the elements of early vision[M] // Landy M, Movshon J A. Computational models of visual processing. Cambridge, The MIT Press, 1991.

[9] 左超, 冯世杰, 张翔宇, 等. 深度学习下的计算成像: 现状、挑战与未来[J]. 光学学报, 2020, 40(1): 0111003.

[10] 邵晓鹏, 刘飞, 李伟, 等. 计算成像技术及应用最新进展[J]. 激光与光电子学进展, 2020, 57(2): 020001.

[11] 方璐, 戴琼海. 计算光场成像[J]. 光学学报, 2020, 40(1): 0111001.

Fang L, Dai Q H. Computational light field imaging[J]. Acta Optica Sinica, 2020, 40(1): 0111001.

[12] NomuraY, ZhangL, Nayar SK. Scene collages and flexible camera arrays[C] //Proceedings of the 18th Eurographics Conference on Rendering Techniques, May 25, 2007, Grenoble, France. Geneve: Eurographics Association, 2007: 127- 138.

[13] Lin X, Liu Y B, Wu J M, et al. Spatial-spectral encoded compressive hyperspectral imaging[J]. ACM Transactions on Graphics, 2014, 33(6): 1-11.

[14] Land MF, Nilsson DE. Lens eyes on land[M] //Animal eyes. Oxford: Oxford University Press, 2012: 94- 129.

[15] MildenhallB, Srinivasan PP, TancikM, et al. NeRF: representing scenes as neural radiance fields for view synthesis[M] //Vedaldi A, Bischof H, Brox T, et al. Computer vision-ECCV 2020. Lecture notes in computer science. Cham: Springer, 2020: 405- 421.

[17] Lucas BD, KanadeT. An iterative image registration technique with an application to stereo vision[C] //IJCAI’81: Proceedings of the 7th International Joint Conference on Artificial Intelligence, August 24-28, 1981, Vancouver, BC, Canada. San Francisco: William Kaufmann, 1981.

[19] Dai JF, Qi HZ, Xiong YW, et al.Deformable convolutional networks[C] //2017 IEEE International Conference on Computer Vision (ICCV), October 22-29, 2017, Venice, Italy.New York: IEEE Press, 2017: 764- 773.

[20] Liu Y, Chen X, Wang Z F, et al. Deep learning for pixel-level image fusion: recent advances and future prospects[J]. Information Fusion, 2018, 42: 158-173.

[21] Kaur H, Koundal D, Kadyan V. Image fusion techniques: a survey[J]. Archives of Computational Methods in Engineering, 2021: 1-23.

[23] Lohmann A W. Scaling laws for lens systems[J]. Applied Optics, 1989, 28(23): 4996-4998.

[24] Kopf J, Uyttendaele M, Deussen O, et al. Capturing and viewing gigapixel images[J]. ACM Transactions on Graphics, 2007, 26(3): 93.

[25] Brady D J, Gehm M E, Stack R A, et al. Multiscale gigapixel photography[J]. Nature, 2012, 486(7403): 386-389.

[26] Zhang JN, Zhu TY, Zhang AK, et al.Multiscale-VR: multiscale gigapixel 3D panoramic videography for virtual reality[C] //2020 IEEE International Conference on Computational Photography (ICCP), April 24-26, 2020, St. Louis, MO, USANew York: IEEE Press, 2020: 1- 12.

[27] Wilburn B, Joshi N, Vaish V, et al. High performance imaging using large camera arrays[J]. ACM Transactions on Graphics, 2005, 24(3): 765-776.

[30] Cossairt OS, MiauD, Nayar SK. Gigapixel computational imaging[C] //2011 IEEE International Conference on Computational Photography (ICCP), April 8-10, 2011, Pittsburgh, PA, USA.New York: IEEE Press, 2011: 1- 8.

[31] Son H S, Marks D L, Hahn J, et al. Design of a spherical focal surface using close-packed relay optics[J]. Optics Express, 2011, 19(17): 16132-16138.

[32] Yuan X Y, Ji M Q, Wu J M, et al. A modular hierarchical array camera[J]. Light, Science & Applications, 2021, 10(1): 37.

[33] Yuan XY, FangL, Dai QH, et al.Multiscale gigapixel video: a cross resolution image matching and warping approach[C] //2017 IEEE International Conference on Computational Photography (ICCP), May 12-14, 2017, Stanford, CA, USA. New York: IEEE Press, 2017: 1- 9.

[34] ShechtmanE, CaspiY, IraniM. Increasing space-time resolution in video[M] //Heyden A, Sparr G, Nielsen M, et al. Computer vision-ECCV 2002. Lecture notes in computer science. Heidelberg: Springer, 2002, 2350: 753- 768.

[35] WilburnB, JoshiN, VaishV, et al.High-speed videography using a dense camera array[C] //Proceedings of the 2004 IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 2004. CVPR 2004, June 27-July 2, 2004, Washington, DC, USA.New York: IEEE Press, 2004, II

[36] Wang T C, Zhu J Y, Kalantari N K, et al. Light field video capture using a learning-based hybrid imaging system[J]. ACM Transactions on Graphics, 2017, 36(4): 1-13.

[38] Debevec PE, MalikJ. Recovering high dynamic range radiance maps from photographs[C] //ACM SIGGRAPH 2008 classes on-SIGGRAPH’08, August 11-15, 2008, Los Angeles, California.New York: ACM Press, 2008: 1- 10.

[39] Chen Y Y, Jiang G Y, Yu M, et al. Learning stereo high dynamic range imaging from a pair of cameras with different exposure parameters[J]. IEEE Transactions on Computational Imaging, 2020, 6: 1044-1058.

[40] Lee B, Song B C. Multi-image high dynamic range algorithm using a hybrid camera[J]. Signal Processing: Image Communication, 2015, 30: 37-56.

[41] Froehlich J, Grandinetti S, Eberhardt B, et al. Creating cinematic wide gamut HDR-video for the evaluation of tone mapping operators and HDR-displays[J]. Proceedings of SPIE, 2014, 9023: 90230X.

[42] Tocci M D, Kiser C, Tocci N, et al. A versatile HDR video production system[J]. ACM Transactions on Graphics, 2011, 30(4): 1-10.

[43] Huo Y Q, Yang F, Dong L, et al. Physiological inverse tone mapping based on retina response[J]. The Visual Computer, 2014, 30(5): 507-517.

[44] BanterleF, LeddaP, DebattistaK, et al.Expanding low dynamic range videos for high dynamic range applications[C] //Proceedings of the 24th Spring Conference on Computer Graphics-SCCG’08, April 21-23, 2008, Budmerice, Slovakia.New York: ACM Press, 2010: 33- 41.

[45] Lin HY, Chang WZ. High dynamic range imaging for stereoscopic scene representation[C] //2009 16th IEEE International Conference on Image Processing (ICIP), November 7-10, 2009, Cairo, Egypt.New York: IEEE Press, 2009: 4305- 4308.

[46] Selmanovic E, Debattista K, Bashford-Rogers T, et al. Enabling stereoscopic high dynamic range video[J]. Signal Processing: Image Communication, 2014, 29(2): 216-228.

[47] Bätz M, Richter T, Garbas J U, et al. High dynamic range video reconstruction from a stereo camera setup[J]. Signal Processing: Image Communication, 2014, 29(2): 191-202.

[48] Park W J, Ji S W, Kang S J, et al. Stereo vision-based high dynamic range imaging using differently-exposed image pair[J]. Sensors, 2017, 17(7): 1473.

[49] Heo Y S, Lee K M, Lee S U. Depth maps and high-dynamic range image generation from alternating exposure multiview images[J]. Journal of Electronic Imaging, 2017, 26(4): 043006.

[50] Pu ZY, Guo PY, Asif MS, et al. Robust high dynamic range (HDR) imaging with complex motion and parallax[M] //Ishikawa H, Liu C L, Pajdla T, et al. Computer vision-ACCV 2020. Lecture notes in computer science. Cham: Springer, 2021, 12623: 134- 149.

[51] Orozco RR, LoscosC, MartinI, et al. HDR multiview image sequence generation[M] //High dynamic range video. Amsterdam: Elsevier, 2017: 61- 86.

[52] Pizer SM, Johnston RE, Ericksen JP, et al.Contrast-limited adaptive histogram equalization: speed and effectiveness[C] //Proceedings of the First Conference on Visualization in Biomedical Computing, May 22-25, 1990, Atlanta, GA, USANew York: IEEE Press, 1990: 337- 345.

[53] Jobson D J, Rahman Z, Woodell G A. A multiscale retinex for bridging the gap between color images and the human observation of scenes[J]. IEEE Transactions on Image Processing, 1997, 6(7): 965-976.

[54] Liu J Y, Xu D J, Yang W H, et al. Benchmarking low-light image enhancement and beyond[J]. International Journal of Computer Vision, 2021, 129(4): 1153-1184.

[55] Petschnigg G, Szeliski R, Agrawala M, et al. Digital photography with flash and no-flash image pairs[J]. ACM Transactions on Graphics, 2004, 23(3): 664-672.

[56] Krishnan D, Fergus R. Dark flash photography[J]. ACM Transactions on Graphics, 2009, 28(3): 1-11.

[57] WangJ, Xue TF, Barron JT, et al.Stereoscopic dark flash for low-light photography[C] //2019 IEEE International Conference on Computational Photography (ICCP), May 15-17, 2019, Tokyo, Japan.New York: IEEE Press, 2019: 1- 10.

[58] Dong X, Li W X. Shoot high-quality color images using dual-lens system with monochrome and color cameras[J]. Neurocomputing, 2019, 352: 22-32.

[59] Guo PY, MaZ. Low-light color imaging via dual camera acquisition[M] //Ishikawa H, Liu C L, Pajdla T, et al. Computer vision-ACCV 2020. Lecture notes in computer science. Cham: Springer, 2021, 12623: 150- 167.

[60] 刘亿. 光学专题研究报告: 手机摄像头持续创新, 多方位支撑技术升级[R]. 厦门: 长城国瑞证券, 2020.

LiuY. Special research report on optics: continuous innovation of mobile camera and upgrading of multi-directional support technology[R]. Xiamen: Great Wall Glory Securities Co., LTD, 2020.

[61] Brady D J, Fang L, Ma Z. Deep learning for camera data acquisition, control, and image estimation[J]. Advances in Optics and Photonics, 2020, 12(4): 787-846.

Article Outline

郭珮瑶, 蒲志远, 马展. 多相机系统:成像增强及应用[J]. 激光与光电子学进展, 2021, 58(18): 1811013. Peiyao Guo, Zhiyuan Pu, Zhan Ma. Multi-Camera System: Imaging Enhancement and Application[J]. Laser & Optoelectronics Progress, 2021, 58(18): 1811013.

![基于深度学习的典型计算光学成像技术[9]](/richHtml/lop/2021/58/18/1811013/img_1.jpg)

![可弯曲相机阵列及其拍摄的街景图[12]](/richHtml/lop/2021/58/18/1811013/img_5.jpg)

![相机成像原理流程图[38]](/richHtml/lop/2021/58/18/1811013/img_15.jpg)