基于特征密集计算与融合算法的教师课堂行为分析  下载: 777次

下载: 777次

1 引言

当前,视频监控已经逐渐成为了辅助教育教学的一种手段。从视频中准确识别出教师的教学行为方式,有助于教学方式的统计与评价,改善教师教学质量。同时,将得到的数据和结论推送给教师本人或学校,有助于多方位了解教学状况,从而对教师在课堂教学方式上出现的问题制定针对性的解决方案。对课堂场景下教师的行为进行分析,旨在提高教师行为识别的准确率,充分利用视频资源辅助分析教师整体行为,从而自动生成教学方式评估。

在针对目标行为识别方法的研究中,文献[ 1]中提出一种基于时空方向主成分直方图的人体行为识别方法,解决了由视角、尺度等变化造成的行为类内差别大的问题。文献[ 2]中基于一种视觉词袋表示方法和融合模型表示人体行为特征,获得了较好的识别性能。然而,上述方法在学习数据特征信息方面受到限制,无法针对识别任务自动生成适应模型[3]。

近年来,深度卷积神经网络在行为识别、目标检测等视觉任务上展现出了较大的优势[4]。基于卷积神经网络的方法具有强大的特征表达能力,但该方法存在对样本监督信息利用不充分的问题[5],文献[ 6]和文献[ 7]中使用了多种特征信息对目标进行组合识别,提高了分类的正确率。

大多数行为识别网络模型采用的是视频处理的方法,从视频中提取时间和空间信息,然后组合预测视频中的行为类别[8]。3D DenseNets[9]、C3D[10]和3D ResNets[11]都是基于3D卷积神经网络设计的模型结构。其中,3D DenseNets为密集连接型卷积结构,因其能够重复利用各层特征,行为识别准确率得到了很大提升。然而,3D DenseNets虽然采用了特征复用的方式提高特征利用率,但该网络在进行综合预测时未考虑时空特征点之间的关联性[12]和融合多尺度特征 [13],不能充分利用视频特征信息。此外,传统算法要求输入的三维视频数据的时长和空间分辨率均固定,因此,不能使用不同时间和空间尺寸的训练样本进行训练。为此,本文提出一种基于时空信息密集计算与融合的深度卷积神经网络。该网络在加深三维密集连接型结构的同时,引入了时空金字塔池化模块和时空特征非局部计算模块,将时空信息密集计算和时空信息密集融合技术相结合,改善特征空间的行为表征能力,从而提高视频数据行为识别的准确率。

2 基于时空信息密集计算与融合的深度卷积网络

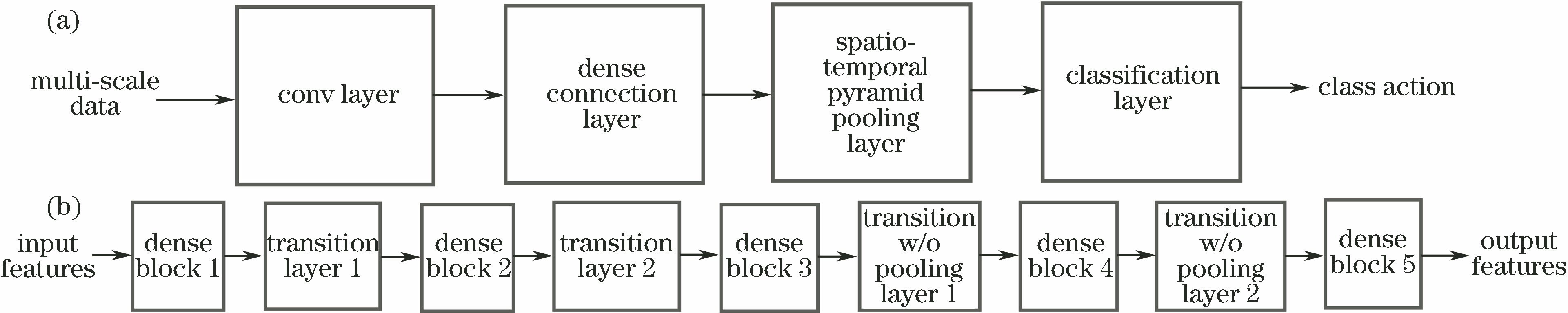

设计的基于时空信息密集计算与融合的深度卷积神经网络(TSDCFN)是在改进型三维密集连接卷积神经网络的基础上引入非局部特征密集计算算法提取时空信息,然后使用一种三维金字塔池化模块得到时空信息的密集融合。

TSDCFN整体结构如

图 1. TSDCFN结构框图。(a) TSDCFN整体结构;(b)密集连接模块结构(其中,w/o表示不包含)

Fig. 1. Schematic of TSDCFN structure. (a) Overall structure of TSDCFN; (b) structure of densely connected module (in which, w/o represents without)

在TSDCFN中,非局部特征计算模块使特征图的每个特征点都是由邻近的其他特征点计算得出,同时时空金字塔池化模块将特征图池化成多种尺度,从而得到更有效的行为类别特征表示。

2.1 时空金字塔池化模块

针对输入视频数据尺寸不一致的问题,提出了一种时空金字塔池化模型,如

式中:cell为向上取整函数;floor为向下取整函数;

最后通过Flatten函数和Concatenation函数将特征图展开并连接成一维特征向量,送入全连接层。

2.2 改进型三维密集连接网络

改进型三维密集连接卷积神经网络由深度监督的DenseNets网络经过膨胀化卷积和池化得到。为了扩展更多的dense blocks以加深网络,同时防止特征图的分辨率被过分降低,引入DSOD算法[14]中的transition w/o pooling layer,使网络不只是通过增加每个block内部的层数来加深网络。改进型三维密集连接卷积神经网络包含1个3D卷积层、5个dense blocks、2个transition layers、3个transition w/o pooling layers和1个classification layer。

表 1. 改进型三维密集连接卷积神经网络参数

Table 1. Parameters of modified 3D densely connected convolutional neural network

|

2.3 非局部特征计算模块

三维视频数据中存在时间维度的信息,特征点不仅与同一帧空间内部的其他特征点有关,还与相邻帧的特征点有关。非局部(non-local)特征计算模块[12]可将某点处的特征与相邻点处的特征联系起来,充分挖掘空间帧内部以及时间帧之间的关系。

式中:softmax(·)为归一化指数函数;

3 实验与分析

利用课堂场景下的教师行为数据库对提出的TSDCFN进行训练和测试。下面首先介绍实验使用的教师行为数据库,给出网络训练相关的设置,然后通过实验验证不同的网络参数配置、非局部特征计算模块以及三维金字塔池化模块对教师行为识别准确率的影响。

3.1 教师行为数据库的建立

课堂场景的教师行为数据库共包含1800个动作短视频,设计了9种不同的行为类别,分别为黑板板书(blackboard writing)、纸上写字(paper writing)、长时注视学生(long time staring)、坐下(sitting)、使用手机(phone using)、讲授投影仪(projector teaching)、讲话(speaking)、操作计算机(computer operating)和翻阅资料(material browsing),各类样本的数量分别为169,225,250,130,182,230,255,139,220。为了增强数据库的丰富性,提高网络模型的泛化性,制作样本时考虑了光线、背景、分辨率和尺度等变化因素。

3.2 训练设置

训练时,超参数Nesterov momentum和weight decay分别设置为0.9和10-4,根据文献[ 15]中的方法进行参数初始化,使用Xavier对全连接层的权重进行初始化[16]。当序列长度为16时,使用批大小8;当序列长度为32时,使用批大小4,这样可以保证每次学习时图形处理器(GPU)处理的帧数据量均为128。迭代训练次数为200。学习率最初设置为0.1,在迭代次数Epoch为90和150处分别减小为原来的1/10和1/100。dense block中1×1×1卷积层的输出通道数均设置为128,时空金字塔池化模块的参数集bins设置为[4, 3, 2, 1]。

3.3 实验结果与分析

不同参数配置的实验结果见

由

表 2. 不同参数配置的网络在教师行为数据集上的测试结果(其中,Data Aug表示数据增强)

Table 2. Test results of networks with different configuration parameters on dataset of teachers' actions (in which, Data Aug represents Data Augmentation)

|

本文设计的网络对教师行为的识别示例如

4 结论

提出了一种基于时空信息密集计算与融合的深度卷积神经网络,该网络通过引入非局部特征计算模块和三维金字塔池化模块,使视频中的时空信息得到了充分利用,从而大大提高了对行为特征的表示能力。将该网络应用于课堂场景下教师行为数据集,实验结果表明,时空特征密集计算和多尺度特征密集融合的互补特性可以有效提升教师行为识别的准确率。

致谢 感谢广州海昇计算机科技有限公司对本项目的支持

[1] 徐海洋, 孔军, 蒋敏, 等. 基于时空方向主成分直方图的人体行为识别[J]. 激光与光电子学进展, 2018, 55(6): 061009.

[2] Peng X J, Wang L M, Wang X X, et al. Bag of visual words and fusion methods for action recognition: comprehensive study and good practice[J]. Computer Vision and Image Understanding, 2016, 150: 109-125.

[3] Hinton G E. Reducing the dimensionality of data with neural networks[J]. Science, 2006, 313(5786): 504-507.

[4] Russakovsky O, Deng J, Su H, et al. ImageNet large scale visual recognition challenge[J]. International Journal of Computer Vision, 2015, 115(3): 211-252.

[5] 陈兵, 查宇飞, 李运强, 等. 基于卷积神经网络判别特征学习的行人重识别[J]. 光学学报, 2018, 38(7): 0720001.

[6] 刘峰, 沈同圣, 马新星. 特征融合的卷积神经网络多波段舰船目标识别[J]. 光学学报, 2017, 37(10): 1015002.

[7] 李此君, 刘云鹏. 基于协方差流形和LogitBoost的异常驾驶行为识别方法[J]. 激光与光电子学进展, 2018, 55(11): 111503.

[8] Ng J YH, HausknechtM, VijayanarasimhanS, et al. Beyond short snippets: deep networks for video classification[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 7-12, 2015, Boston, MA, USA. New York: IEEE, 2015: 4694- 4702.

[9] Gu DF. 3D densely connected convolutional network for the recognition of human shopping actions[D]. Ottawa,Ontario: University of Ottawa, 2017.

[10] TranD, BourdevL, FergusR, et al. Learning spatiotemporal features with 3D convolutional networks[C]∥2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, Santiago, Chile. New York: IEEE, 2016: 4489- 4497.

[11] HaraK, KataokaH, SatohY. Learning spatio-temporal features with 3D residual networks for action recognition[C]∥2017 IEEE International Conference on Computer Vision Workshops (ICCVW), October 22-29, 2017, Venice, Italy. New York: IEEE, 2018: 3154- 3160.

[12] Wang XL, GirshickR, GuptaA, et al. Non-local neural networks[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE, 2018: 7794- 7803.

[14] Shen ZQ, LiuZ, Li JG, et al. DSOD: learning deeply supervised object detectors from scratch[C]∥2017 IEEE International Conference on Computer Vision (ICCV), October 22-29, 2017, Venice, Italy. New York: IEEE, 2017: 1937- 1945.

[15] He KM, Zhang XY, Ren SQ, et al. Delving deep into rectifiers: surpassing human-level performance on ImageNet classification[C]∥2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 1026- 1034.

[16] GlorotX, BengioY. Understanding the difficulty of training deep feedforward neural networks[C]∥Proceedings of the 13th International Conference on Artificial Intelligence and Statistics, May 13-15, 2010, Chia Laguna Resort, Sardinia, Italy. Cambridge: PMLR, 2010, 9: 249- 256.

Article Outline

张晓龙, 刘剑飞, 郝禄国. 基于特征密集计算与融合算法的教师课堂行为分析[J]. 激光与光电子学进展, 2019, 56(16): 161503. Xiaolong Zhang, Jianfei Liu, Luguo Hao. Analysis of Teachers' Actions Using Feature Dense Computation and Fusion Algorithm[J]. Laser & Optoelectronics Progress, 2019, 56(16): 161503.