Adaptive Tracking Algorithm for Aerial Small Targets Based on Multi-Domain Convolutional Neural Networks and Autoregression Model

1 引言

空中目标跟踪是航空航天领域各类探测系统的关键技术之一,由于观测距离较远,该类目标在地面观测和跟踪过程中,往往因缺少形状和纹理特征而呈现为小目标甚至点目标状态,造成检测和跟踪困难。特别是夜晚星空背景下,卫星等小目标与恒星较难区分,当其他卫星和行星等伪目标与其交会时,跟踪就更加困难。因此,精确跟踪空中小目标具有挑战性。

根据目标特征及跟踪策略的不同,小目标跟踪算法大致可分为基于特征的跟踪方法[1-2]、基于模板匹配的跟踪方法[3]和基于统计的跟踪方法[4]三大类。基于特征的跟踪方法综合考虑了背景和目标的特征,极大地提高了跟踪算法的稳健性,成为当前的研究热点。该方法主要采用光流法[5]、相邻帧差法[6]和背景减法[7]进行目标跟踪,这些方法各有特点,但共同之处都是针对特定目标由人工设计特征,所以算法泛化能力不强。为此,有研究探索了基于深度学习的小目标跟踪方法[8-9],代表性的有基于深度卷积神经网络以数据驱动方式自动学习特征的方法[2]和利用双层卷积神经网络增强特征表示的方法[10],二者均能有效区分目标与背景信息,在降低跟踪误差的同时极大提高算法的稳健性。在此基础上,Nam等[11]基于多域卷积神经网络(MDNet)跟踪方法较好地解决了伪目标干扰问题,但该方法用于星空背景下的小目标跟踪,特别是存在伪目标与目标交会时,往往会产生跟踪漂移。

为此,本文提出基于MDNet与自回归(AR)模型的空中小目标自适应跟踪方法。利用MDNet自适应提取空中小目标的特征后,训练模型[12]以估计目标运动轨迹并预测目标位置,再经约束MDNet采样候选区域有效区分目标与伪目标,解决星空背景下卫星跟踪过程中伪目标对运动小目标的干扰问题。

2 跟踪方法

2.1 方法框架

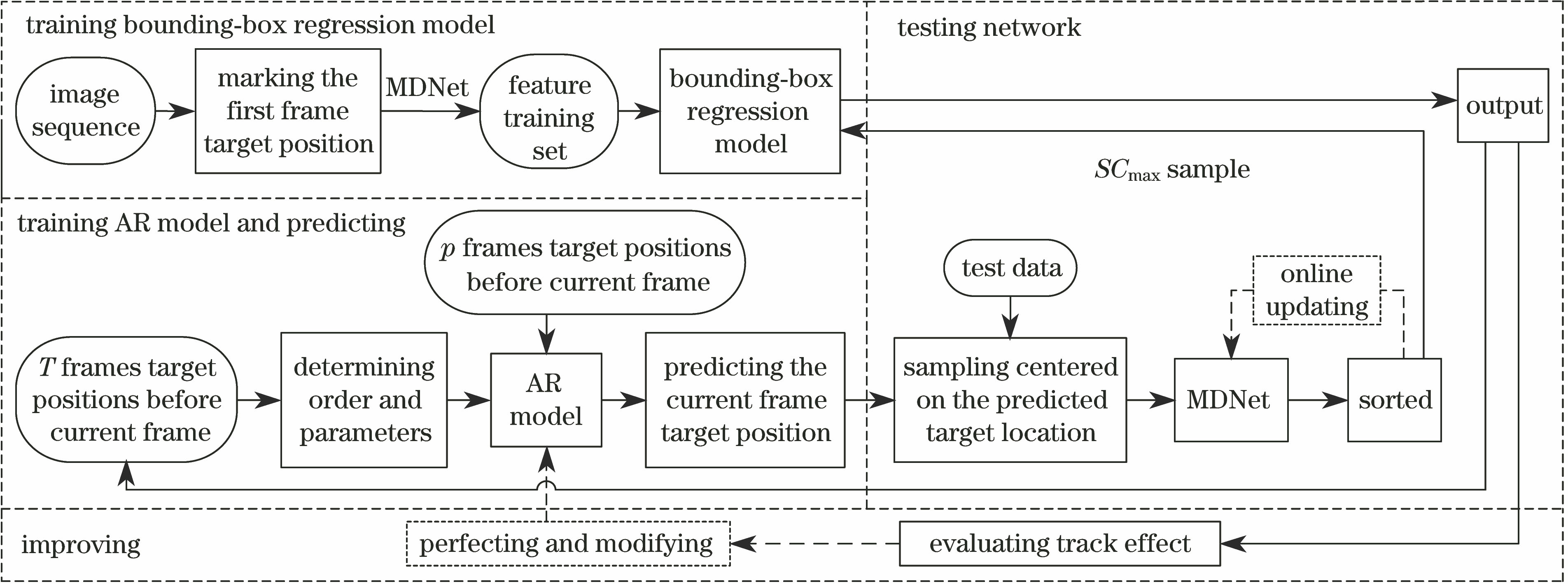

方法框架如图1所示。

1) 训练bounding-box回归模型:MDNet以标定的第1帧目标位置为中心采样,将正样本的特征作为特征训练集训练bounding-box回归模型。

2) AR模型训练与预测:输入当前帧前T帧目标位置训练AR模型,估计目标的运动轨迹;将当前帧前p帧的目标位置输入训练好的AR模型,预测目标位置。

3) 网络测试:输入测试数据,MDNet以预测的目标位置为中心采样生成候选样本,计算样本置信度并将置信度最高的样本输入bounding-box回归模型,调整目标位置完成跟踪。

4) 完善与修改:整个网络完成跟踪后,根据评价指标分析各因素对跟踪效果的影响,进一步对AR模型进行优化和完善。

图 1. 方法框架图

Fig. 1. Framework of the method

下载图片 查看所有图片

2.2 MDNet跟踪器

MDNet跟踪器采用难例挖掘和bounding-box回归模型训练样本,通过训练特定域层(fc6)获得目标通用的特征表达,用于各类场景的目标跟踪。MDNet网络结构如图2所示,输入图像大小为107 pixel×107 pixel,conv1~conv3为卷积层,采用视觉几何组-中速卷积神经网络(VGG-M)结构自适应提取特征,fc4~fc6为全连接层,将特征图表示转换为一维向量,fc6有K个分支,每个分支包含一个二分类层:网络输出图像目标与背景的置信度。具体训练过程见文献[

11]。

图 2. MDNet结构图

Fig. 2. Structure of MDNet

下载图片 查看所有图片

2.3 在线跟踪

2.3.1 AR模型

AR模型常用于动态数据处理中的模型预测[13],表达式为

式中{

t=1,2,…,T}是一个时间序列的子样观测值,T为时间序列的长度,xt-1,xt-2,…,xt-p为自身某一时刻t的前p个时刻的子样观测值,εt为预测误差,φ1,φ2,…,φp为模型的参数,p为模型的阶数。

用AR模型预测目标位置的关键是确定模型参数和阶数。常用的参数估计法包括矩估计、最大似然估计、最小二乘法估计等。最小二乘法估计比矩估计精度高,比最大似然估计计算简单[14],因此本文采用最小二乘法估计参数并用其最小信息准则(AIC准则)确定阶数。

(1)式的最小二乘解为

式中β为参数矩阵,X为T时刻前的观测值矩阵,Y为T+1时刻预测值的矩阵。

因此AR(p)模型的残差方差的无偏估计公式为

最小信息准则的形式为

设模型阶的上界为pmax,m={1,2,…,pmax},

是用最小二乘法对AR(p)模型拟合的残差方差估计。在不同阶数下,若p=m时fAIC(p)取最小值,则确定m为模型的阶数。

2.3.2 在线跟踪过程

1) 训练bounding-box回归模型

标定第一帧目标位置

=(x1,y1,sw,sh),MDNet以

为中心采样生成回归样本,设重叠率的阈值r=0.6,将大于r的样本作为

输入网络经conv1~conv3的特征图表示,fc4~fc6将特征图表示变换为一维向量训练bounding-box回归模型;提取第一帧图像

、

经conv3的特征图表示,选择难例样本

和

输入至网络微调fc4~fc6。

2) AR模型训练与预测

①训练AR模型:根据(4)式可得p=4时fAIC(p)最小,确定模型为AR(4)模型。经实验得T=16,输入训练数据X,根据(2)式计算出模型不同的参数矩阵β,再由(3)式选出最佳参数,训练AR模型,估计目标的运动轨迹。

②预测目标位置:从第n(n≥17)帧开始预测,将参数和第n帧中前4帧目标的位置代入(1)式,分别对x、y坐标进行预测,得到第n帧目标位置的预测值为(x'n,y'n)。

3) 网络测试与完善

MDNet以(x'n,y'n)为中心采样约束采样候选区域,用多维高斯分布采样M(M=256)个候选样本

=(

,

,

),i=1,2,…,M,输入网络得

目标和背景的置信度,将SCmax样本输入bounding-box回归模型进行调整,最终确定目标位置,完成跟踪。最后,根据定性和定量分析结果,进一步优化和完善AR模型。

3 实验结果与分析

对涵盖了噪声、单个伪目标、多个伪目标、快速运动、遮挡等复杂情况的8组视频图像序列进行测试,如表1所示。实验对比算法为基于学习机制的深度学习跟踪(DLT)算法[8]、AR 模型辅助深度学习(DLTAR)算法、实时性较强的尺度自适应的多特征跟踪(SAMF)算法[15]、判别性尺度空间跟踪(DSST)算法[16]、可对特征进行辨别分类的核化相关滤波器跟踪(KCF)算法[17]、卷积网络跟踪(CNT)算法[10]和MDNet算法。

表 1. 实验中的测试图像序列

Table 1. Experimental test image sequences

| Image sequence | True target | Track/Speed | Main challenge |

|---|

| seq1 | 1 | Straight line/Faster | Single pseudo target, moving fast | | seq2 | 2 | Curve/Fast | Single pseudo target, background interference | | seq3 | 3 | Straight line/Fast | Multiple pseudo targets rendezvous, background interference | | seq4 | 4 | Curve/Fast | Multiple pseudo targets rendezvous, background interference | | seq5 | 5 | Curve/Faster | Multiple pseudo targets rendezvous, background interference, moving fast | | seq6 | 6 | Straight line/Fast | Multiple pseudo targets rendezvous, similar noise | | seq7 | 7 | Straight line/Slow | Multiple pseudo targets rendezvous, similar noise | | seq8 | 8 | Curve/Fast | Multiple pseudo targets rendezvous, background interference |

|

查看所有表

3.1 定性分析

对以星空为背景、同时存在目标和伪目标的seq1~seq8为对象进行定性分析,图3所示为部分跟踪结果。

图 3. 跟踪算法性能的定性比较。(a) seq1; (b) seq2; (c) seq3; (d) seq4; (e) seq5; (f) seq6; (g) seq7; (h) seq8

Fig. 3. Qualitative comparison of tracking algorithm performance. (a) seq1; (b) seq2; (c) seq3; (d) seq4; (e) seq5; (f) seq6; (g) seq7; (h) seq8

下载图片 查看所有图片

1) 伪目标和噪声干扰

①单个伪目标干扰

图3(a)、(b)为单个伪目标及噪声对目标的干扰。SAMF、CNT、MDNet算法在目标与伪目标交会时误检跟错目标;DLT、DLTAR算法有时可完成跟踪,但在二者交会期间发生漂移,跟踪不稳定;本文方法稳定完成目标跟踪。

②多个伪目标多次干扰

图3(c)~(h)为多个伪目标,且全程多次与目标交会的情况。图3(c)~(e)及图3(h)中对比算法均在目标与多个伪目标第1次交会时发生跟踪漂移;图3(d)和图3(e)中第146帧、图3(h)中第130帧为目标与多个伪目标第2次交会,对比算法已丢失目标,本文方法仍能稳定跟踪;图3(e)、(f)中干扰物较多,DLTAR算法发生严重漂移,DLT、SAMF算法出现轻微漂移,CNT、MDNet算法误检目标;图3(f)、(g)中噪声与目标大小相似,DLT、SAMF算法受噪声干扰发生轻微漂移,本文方法在抑制噪声的同时自适应更新跟踪模型,实现了全程稳定跟踪目标。

2) 目标快速移动

图3(a)、(e)中目标移动速度快,SAMF算法分别在第43帧和第60帧发生跟踪漂移,DLT、DLTAR算法跟踪效率下降,本文方法精确跟踪目标。

3.2 定量分析

选择中心位置误差(CLE)、平均覆盖率(MOR)、成功率(SR)作为评测指标。

中心位置误差计算公式为

式中(xng,yng)和(xnt,ynt)分别为第n帧目标的实际中心位置和跟踪结果的目标中心位置。

成功率和平均覆盖率计算公式为

式中N为图像序列帧数,NS为跟踪成功的次数,St为跟踪方法输出的跟踪框区域,Sg为实际目标区域,area表示区域面积。NS由(7)式统计获得,若RMO>0,则NS增加一次。

8种跟踪方法对8组图像序列的评价结果如图4、表2~4所示。

图 4. 中心位置误差比较。(a) seq1; (b) seq2; (c) seq3; (d) seq4; (e) seq5; (f) seq6; (g) seq7; (h) seq8

Fig. 4. Comparison of center location error. (a) seq1; (b) seq2; (c) seq3; (d) seq4; (e) seq5; (f) seq6; (g) seq7; (h) seq8

下载图片 查看所有图片

图4中目标与伪目标交会时为跃变点。图4(a)和图4(b)中只包含单个伪目标,在跃变点附近,DLT、DLTAR算法在跟踪成功的情况下发生轻微漂移,中心位置误差较高,其他算法无法获取目标位置,跟踪失败;图4(c)~(h)包含多个伪目标且伪目标与目标多次交会,与单个伪目标干扰相比,DLT、DLTAR算法的中心位置误差偏高,跟踪效率较差,其他对比算法的中心位置误差持续累积。图4(a)和图4(e)中目标快速运动,SAMF、KCF算法早期发生跟踪漂移,相较于其他算法中心位置误差较大。本文方法在不同运动轨迹和运动状态下都保持较低的中心位置误差和较高的跟踪精度。

表2~4表明,存在单个伪目标干扰时,在跟踪成功的情况下DLT算法的成功率及DLTAR算法的平均覆盖率仅次于本文方法, DLTAR算法的平均中心位置误差比DLT算法略低。但是,由于DLT算法采样区域比MDNet算法大且采集到的样本数量多,AR模型在预测目标位置时稍有误差便跟踪到采样区域的其他样本,影响了DLT算法的网络稳定性,导致DLTAR算法跟踪过程中多次发生跟踪漂移,成功率不及DLT算法;其他算法跟踪失败。存在多个伪目标干扰时,对比算法的全程平均覆盖率与仅有单个伪目标干扰时的平均覆盖率相比有所下降。在这两种情况下,本文方法保持了较高的成功率和平均覆盖率,与仅使用MDNet算法相比成功率均值由38.5%提高到97.7%,平均中心位置误差大幅度降低,平均覆盖率均值由19.37%提高到46.94%,表现出较强的抗干扰能力和稳健性。

表 2. 成功率

Table 2. Success rate%

| Image sequence | DLT | DLTAR | SAMF | CNT | DSST | KCF | MDNet | Proposed |

|---|

| seq1 | 51.9 | 32.9 | 35.6 | 55.7 | 55.4 | 35.6 | 55.6 | 100.0 | | seq2 | 92.4 | 71.7 | 51.5 | 51.8 | 49.5 | 50.5 | 51.7 | 99.5 | | seq3 | 57.6 | 28.4 | 53.5 | 52.8 | 53.2 | 53.5 | 52.3 | 95.3 | | seq4 | 16.5 | 7.2 | 13.9 | 19.5 | 13.7 | 10.5 | 21.7 | 96.4 | | seq5 | 18.2 | 8.1 | 12.7 | 19.3 | 12.4 | 9.8 | 21.9 | 95.8 | | seq6 | 38.6 | 16.4 | 36.4 | 39.8 | 36.3 | 28.7 | 40.2 | 98.7 | | seq7 | 37.9 | 16.2 | 61.2 | 39.4 | 35.8 | 21.1 | 41.7 | 99.1 | | seq8 | 17.7 | 8.1 | 13.2 | 20.7 | 11.2 | 10.3 | 22.8 | 96.6 | | Mean | 41.4 | 23.6 | 34.8 | 37.4 | 33.4 | 27.5 | 38.5 | 97.7 |

|

查看所有表

表 3. 平均中心位置误差

Table 3. Mean center location errorpixel

| Image sequence | DLT | DLTAR | SAMF | CNT | DSST | KCF | MDNet | Proposed |

|---|

| seq1 | 90.1 | 98.7 | 215.9 | 84.8 | 88.1 | 228.3 | 84.7 | 1.3 | | seq2 | 13.6 | 14.4 | 184.8 | 184.8 | 186.2 | 184.9 | 184.8 | 0.9 | | seq3 | 17.4 | 16.1 | 70.5 | 68.7 | 70.7 | 71.5 | 68.4 | 4.9 | | seq4 | 251.4 | 257.3 | 275.2 | 283.4 | 258.1 | 273.5 | 281.9 | 40.9 | | seq5 | 158.2 | 149.3 | 262.4 | 256.3 | 272.5 | 272.5 | 274.6 | 46.7 | | seq6 | 53.7 | 48.7 | 72.8 | 53.4 | 45.0 | 46.7 | 46.7 | 1.3 | | seq7 | 70.3 | 68.7 | 20.2 | 28.0 | 26.5 | 26.0 | 40.8 | 1.2 | | seq8 | 243.5 | 233.8 | 305.2 | 242.2 | 317.7 | 238.4 | 243.9 | 40.7 | | Mean | 112.3 | 110.9 | 175.9 | 150.2 | 158.1 | 167.7 | 153.2 | 17.2 |

|

查看所有表

表 4. 平均覆盖率

Table 4. Mean overlap rate%

| Image sequence | DLT | DLTAR | SAMF | CNT | DSST | KCF | MDNet | Proposed |

|---|

| seq1 | 34.97 | 32.28 | 19.66 | 34.81 | 32.38 | 20.64 | 35.48 | 64.63 | | seq2 | 61.84 | 59.26 | 21.37 | 31.89 | 26.00 | 21.40 | 32.80 | 64.12 | | seq3 | 56.64 | 58.25 | 33.04 | 30.26 | 33.49 | 33.40 | 31.56 | 60.08 | | seq4 | 5.89 | 5.14 | 5.57 | 5.64 | 6.01 | 6.02 | 7.72 | 31.56 | | seq5 | 6.69 | 7.02 | 5.10 | 5.49 | 5.91 | 6.14 | 7.88 | 30.47 | | seq6 | 6.59 | 6.81 | 7.32 | 9.18 | 9.18 | 9.76 | 15.49 | 39.18 | | seq7 | 6.47 | 7.85 | 16.30 | 17.17 | 15.76 | 16.68 | 15.76 | 39.21 | | seq8 | 6.52 | 7.24 | 5.39 | 5.59 | 6.01 | 6.03 | 8.28 | 46.29 | | Mean | 23.20 | 22.98 | 14.22 | 17.50 | 16.84 | 15.00 | 19.37 | 46.94 |

|

查看所有表

4 结论

提出了一种基于MDNet和AR模型的空中小目标自适应跟踪方法。通过采用具有强大特征表达能力的MDNet有效分类目标,自适应提取目标特征,在跟踪过程中利用AR模型对目标运动轨迹进行估计并预测不同轨迹和运动状态的目标位置,采用bounding-box回归模型调整目标位置,实现了星空背景下伪目标与目标交会时稳定、精确的跟踪。采用星空背景下包含单个及多个伪目标的8组图像序列进行测试,结果表明,本文方法的成功率及平均覆盖率均值均优于其他7种算法,相比仅使用MDNet算法分别提高了59.2%和27.57%。定量和定性分析表明,在伪目标、噪声和星空背景干扰、遮挡、目标运动速度快等复杂场景下本文方法与其他典型算法相比,具有较高的精确性和稳健性。

本文方法跟踪速度较慢,而且仅针对单目标跟踪进行了研究,这是其局限性所在。下一步将研究快速的多目标跟踪算法。

参考文献

[1] 李双双, 赵高鹏, 王建宇. 基于特征融合和尺度自适应的干扰感知目标跟踪[J]. 光学学报, 2017, 37(5): 0515005.

李双双, 赵高鹏, 王建宇. 基于特征融合和尺度自适应的干扰感知目标跟踪[J]. 光学学报, 2017, 37(5): 0515005.

Li Shuangshuang, Zhao Gaopeng, Wang Jianyu. Distractor-aware object tracking based on multi-feature[J]. Acta Optica Sinica, 2017, 37(5): 0515005.

Li Shuangshuang, Zhao Gaopeng, Wang Jianyu. Distractor-aware object tracking based on multi-feature[J]. Acta Optica Sinica, 2017, 37(5): 0515005.

[2] Chen Y, Yang X, Zhong B, et al. CNNTracker: online discriminative object tracking via deep convolutional neural network[J]. Applied Soft Computing, 2016, 38: 1088-1098.

Chen Y, Yang X, Zhong B, et al. CNNTracker: online discriminative object tracking via deep convolutional neural network[J]. Applied Soft Computing, 2016, 38: 1088-1098.

[3] Li Z, Gao S, Ke N. Robust object tracking based on adaptive templates matching via the fusion of multiple features[J]. Journal of Visual Communication & Image Representation, 2017, 44: 1-20.

Li Z, Gao S, Ke N. Robust object tracking based on adaptive templates matching via the fusion of multiple features[J]. Journal of Visual Communication & Image Representation, 2017, 44: 1-20.

[4] Qian K, Zhou H, Rong S, et al. Infrared dim-small target tracking via singular value decomposition and improved kernelized correlation filter[J]. Infrared Physics & Technology, 2017, 82: 18-27.

Qian K, Zhou H, Rong S, et al. Infrared dim-small target tracking via singular value decomposition and improved kernelized correlation filter[J]. Infrared Physics & Technology, 2017, 82: 18-27.

[5] 厉丹, 鲍蓉, 孙金萍, 等. 多分辨率LK光流联合SURF的跟踪方法[J]. 计算机应用, 2017, 37(3): 806-810.

厉丹, 鲍蓉, 孙金萍, 等. 多分辨率LK光流联合SURF的跟踪方法[J]. 计算机应用, 2017, 37(3): 806-810.

Li Dan, Bao Rong, Sun Jinping, et al. Tracking method of multi-resolution LK optical flow combined with SURF[J]. Journal of Computer Application, 2017, 37(3): 806-810.

Li Dan, Bao Rong, Sun Jinping, et al. Tracking method of multi-resolution LK optical flow combined with SURF[J]. Journal of Computer Application, 2017, 37(3): 806-810.

[6] 王宜贤, 石德乐, 杨宁. 帧差法和Mean shift算法融合的高速无人机目标跟踪[J]. 海军航空工程学院学报, 2016, 31(4): 437-441.

王宜贤, 石德乐, 杨宁. 帧差法和Mean shift算法融合的高速无人机目标跟踪[J]. 海军航空工程学院学报, 2016, 31(4): 437-441.

Wang Yixian, Shi Dele, Yang Ning. Fusion algorithm of frame difference and mean shift for high-speed UAVs’ tracking[J]. Journal of Naval Aeronautical and Astronautical University, 2016, 31(4): 437-441.

Wang Yixian, Shi Dele, Yang Ning. Fusion algorithm of frame difference and mean shift for high-speed UAVs’ tracking[J]. Journal of Naval Aeronautical and Astronautical University, 2016, 31(4): 437-441.

[7] 谭艳, 王宇俊. 一种结合背景差分的改进CamShift目标跟踪方法[J]. 西南师范大学学报(自然科学版), 2016, 41(9): 120-125.

谭艳, 王宇俊. 一种结合背景差分的改进CamShift目标跟踪方法[J]. 西南师范大学学报(自然科学版), 2016, 41(9): 120-125.

Tan Yan, Wang Yujun. On a combination of background difference improved CamShift target tracking method[J]. Journal of Southwest China Normal University (Natural Science Edition), 2016, 41(9): 120-125.

Tan Yan, Wang Yujun. On a combination of background difference improved CamShift target tracking method[J]. Journal of Southwest China Normal University (Natural Science Edition), 2016, 41(9): 120-125.

[8] Li H, Li Y, Porikli F. DeepTrack: Learning discriminative feature representations online for robust visual tracking[J]. IEEE Transactions on Image Processing, 2016, 25(4): 1834.

Li H, Li Y, Porikli F. DeepTrack: Learning discriminative feature representations online for robust visual tracking[J]. IEEE Transactions on Image Processing, 2016, 25(4): 1834.

[9] 蔡玉柱, 杨德东, 毛宁, 等. 基于自适应卷积特征的目标跟踪算法[J]. 光学学报, 2017, 37(3): 0315002.

蔡玉柱, 杨德东, 毛宁, 等. 基于自适应卷积特征的目标跟踪算法[J]. 光学学报, 2017, 37(3): 0315002.

Cai Yuzhu, Yang Dedong, Mao Ning, et al. Visual tracking algorithm based on adaptive convolutional features[J]. Acta Optica Sinica, 2017, 37(3): 0315002.

Cai Yuzhu, Yang Dedong, Mao Ning, et al. Visual tracking algorithm based on adaptive convolutional features[J]. Acta Optica Sinica, 2017, 37(3): 0315002.

[10] Zhang K, Liu Q, Wu Y, et al. Robust visual tracking via convolutional networks without training[J]. IEEE Transactions on Image Processing, 2015, 25(4): 1779-1792.

Zhang K, Liu Q, Wu Y, et al. Robust visual tracking via convolutional networks without training[J]. IEEE Transactions on Image Processing, 2015, 25(4): 1779-1792.

[11] NamH,

Han B. Learning multi-domain convolutional neural networks for visual tracking[EB/OL]. (

2016-01-06)[2017-03-20].

https:∥arxiv.org/abs/1510.

07945.

NamH,

Han B. Learning multi-domain convolutional neural networks for visual tracking[EB/OL]. (

2016-01-06)[2017-03-20].

https:∥arxiv.org/abs/1510.

07945.

[12] Lu F B, Qiao H, Wang S Y, et al. Time-varying coefficient vector autoregressions model based on dynamic correlation with an application to crude oil and stock markets[J]. Environmental Research, 2017, 152: 351-359.

Lu F B, Qiao H, Wang S Y, et al. Time-varying coefficient vector autoregressions model based on dynamic correlation with an application to crude oil and stock markets[J]. Environmental Research, 2017, 152: 351-359.

[13] Wan H J, Xiao L. Variational Bayesian learning for robust AR modeling with the presence of sparse impulse noise[J]. Digital Signal Processing, 2016, 59: 1-8.

Wan H J, Xiao L. Variational Bayesian learning for robust AR modeling with the presence of sparse impulse noise[J]. Digital Signal Processing, 2016, 59: 1-8.

[15] 王媛.

线性回归模型的二阶最小二乘估计[D].

北京: 北京交通大学,

2016.

王媛.

线性回归模型的二阶最小二乘估计[D].

北京: 北京交通大学,

2016.

WangYuan.

Second-order least squares estimation for linear regression model[D].

Beijing: Beijing Jiaotong University,

2016.

WangYuan.

Second-order least squares estimation for linear regression model[D].

Beijing: Beijing Jiaotong University,

2016.

[16] LiY,

Zhu JK.

A scale adaptive kernel correlation filter tracker with feature integration[C]. European Conference on Computer Vision,

2014,

8926:

254-

265.

LiY,

Zhu JK.

A scale adaptive kernel correlation filter tracker with feature integration[C]. European Conference on Computer Vision,

2014,

8926:

254-

265.

[17] DanelljanM,

HägerG,

Khan FS,

et al. Accurate scale estimation for robust visual tracking[C]. Proceedings of the British Machine Vision Conference,

2014:

65.

1-65.

11.

DanelljanM,

HägerG,

Khan FS,

et al. Accurate scale estimation for robust visual tracking[C]. Proceedings of the British Machine Vision Conference,

2014:

65.

1-65.

11.

[18] Henriques JF,

CaseiroR,

MartinsP, et al.

High-speed tracking with kernelized correlation filters[C]. International Conference for High Performance Computing, Networking, Storage and Analysis, SC14, IEEE,

2014:

375-

386.

Henriques JF,

CaseiroR,

MartinsP, et al.

High-speed tracking with kernelized correlation filters[C]. International Conference for High Performance Computing, Networking, Storage and Analysis, SC14, IEEE,

2014:

375-

386.

蔺素珍, 郑瑶, 禄晓飞, 曾建潮. 基于多域卷积神经网络与自回归模型的空中小目标自适应跟踪方法[J]. 光学学报, 2017, 37(12): 1215006. Suzhen Lin, Yao Zheng, Xiaofei Lu, Jianchao Zeng. Adaptive Tracking Algorithm for Aerial Small Targets Based on Multi-Domain Convolutional Neural Networks and Autoregression Model[J]. Acta Optica Sinica, 2017, 37(12): 1215006.

下载: 1003次

下载: 1003次