惯性导航辅助图像特征匹配方法研究  下载: 914次

下载: 914次

1 引言

随着科学技术的发展,具有高度自主性、隐蔽性以及运动信息完备性的惯性导航系统在**和民用领域的应用越来越广泛[1]。惯性导航系统基于牛顿运动学定律,能够同时输出载体的姿态信息、速度和位置等导航参数[2]。图像特征匹配是对图像的内容、结构、纹理和灰度等信息进行相似性和一致性分析,以达到寻找相似图像目标的目的,即根据相关的图像特征、相似性准则和搜索策略对两帧图像进行相关的信息处理,以确定两帧图像中能够匹配的最佳空间对应点[3-4]。随着移动机器人、无人机和自动驾驶等产品和技术的快速发展,研究人员对其采用的同时定位与地图构建(SLAM)技术进行了广泛研究[5-6],其中以相机作为唯一传感器的视觉SLAM技术具有更大的研究和应用潜力[7]。目前视觉SLAM系统主要分为视觉里程计前端和优化后端两部分。基于特征点法的视觉里程计对光照变化不敏感,具有比较高的运行稳定性,是比较成熟的前端解决方案。其工作原理是根据相邻两帧图像的特征匹配信息对相机的运动状态进行估计,因此图像匹配是视觉SLAM系统正常运行的基础,匹配准确性直接影响视觉SLAM系统的精度[8-10]。目前常用的图像匹配方法主要可以分为基于特征的匹配、基于灰度的匹配和基于关系的匹配三类,其中基于特征的匹配是当前图像匹配算法的主方向[11-13]。特征点提取算法主要有尺度不变特征变换(SIFT)、加速稳健特征(SURF)和ORB(Oriented FAST and Rotated BRIEF)特征算法。SIFT充分考虑了图像变换中可能出现的各种图像变化,具有较好的鲁棒性,但是计算量非常大,严重地影响了系统的实时性。SURF是SIFT的高效改进,计算的复杂程度相比于SIFT显著降低,能够更加快速地进行计算。ORB是在适当降低精度和鲁棒性的基础上,极大地提升了计算速度[14-17]。

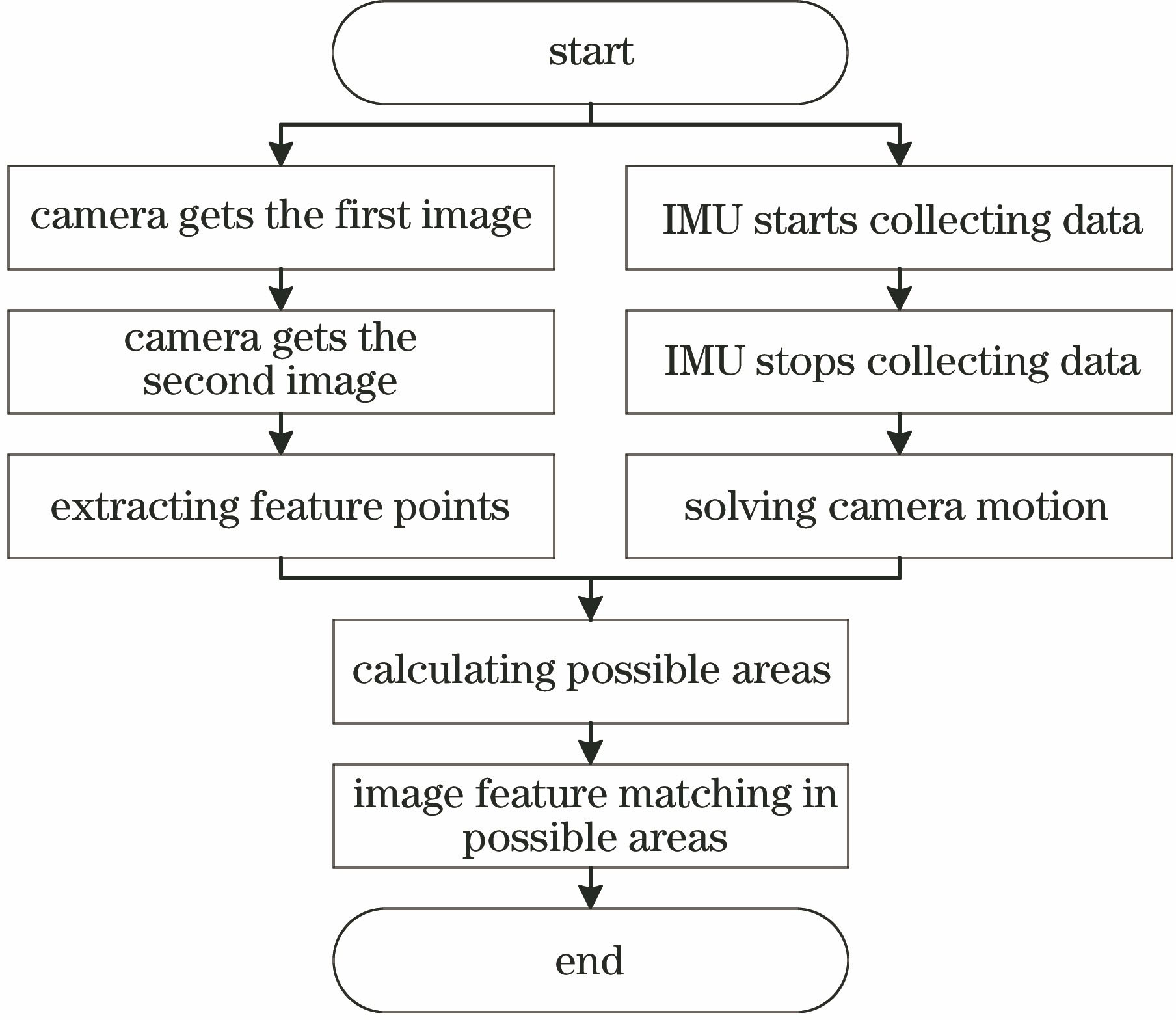

针对图像特征点误匹配率高的问题,本文提出一种惯性导航辅助图像特征匹配的方法,该方法利用惯性导航解算出两帧图像之间相机的运动,然后根据相机的运动计算前一帧图像中的特征点在后一帧图像中可能出现的区域,从而将全图像的特征点匹配转化为局部区域的特征点匹配。加入惯导约束的特征点匹配,不仅能够降低误匹配率,提高匹配的准确性,还能够有效地避免两帧图像中出现非重叠区域特征点匹配的情况。

2 惯性导航辅助图像特征匹配的原理

惯性导航系统使用的惯性敏感器件是惯性测量单元(IMU),由加速度计和陀螺仪组成[18],其中加速度计和陀螺仪分别测量载体坐标系下载体运动时的线性加速度和角速度[19],因此惯性测量单元的测量数据可应用于计算前后两帧图像间相机的运动,即相机的旋转矩阵和平移向量。惯性导航辅助图像特征匹配的基本原理是利用惯性测量单元的测量数据解算出前后两帧图像之间相机的运动,然后根据相机的运动求解基础矩阵,由基础矩阵便可计算前一帧图像中提取的特征点在后一帧图像中可能出现的区域,最后在后一帧图像中的可能区域对特征点进行搜索匹配,这样不仅能提高特征点匹配的准确率,还能减少匹配所需的计算量和时间,提高特征点匹配的效率。

2.1 旋转矩阵

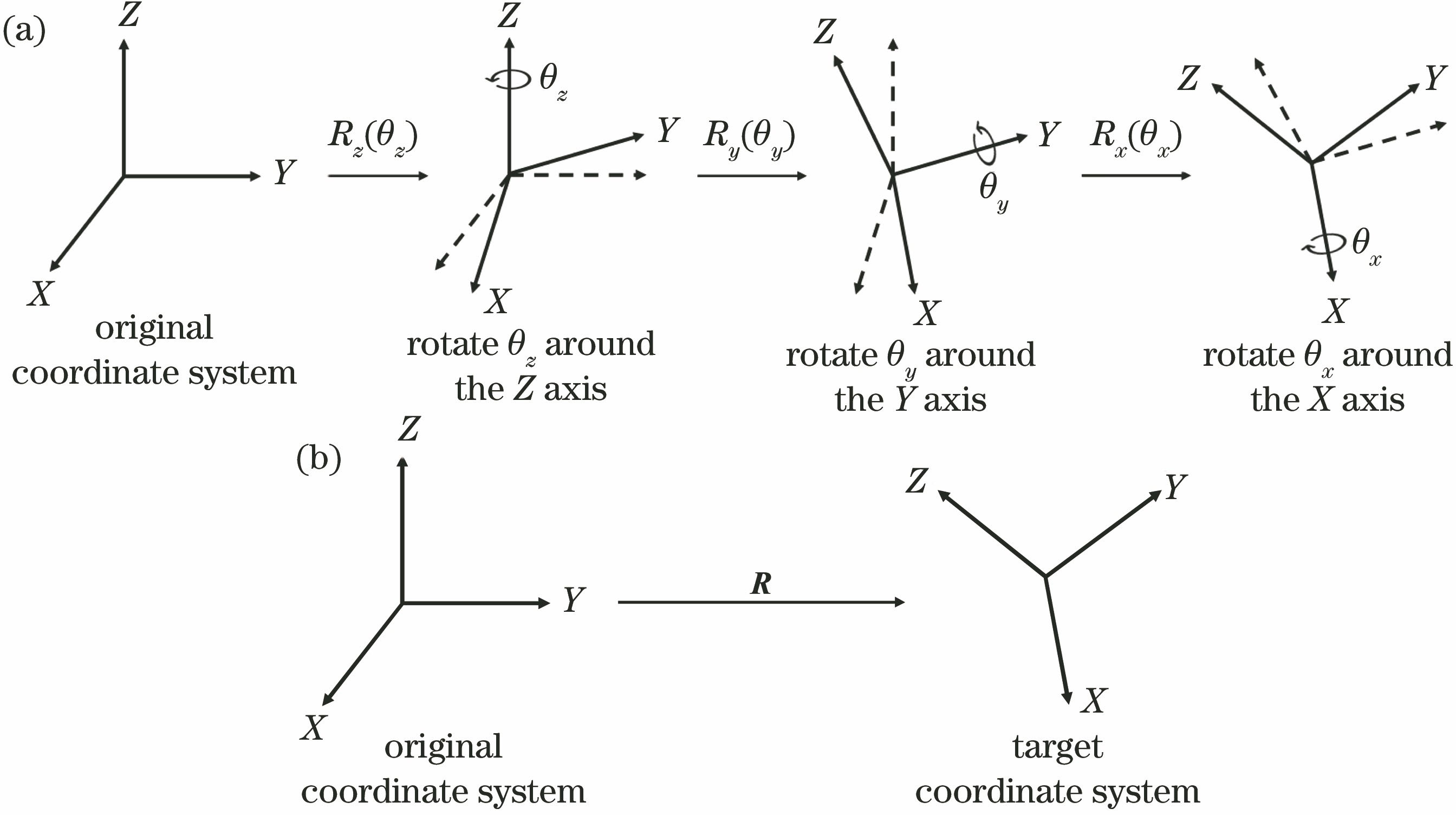

前后两帧图像间相机的旋转可以用旋转矩阵来表示,由空间旋转理论可知空间中的三维旋转可以简化为三次绕不同轴的旋转。对于右手笛卡尔坐标系,绕X轴、Y轴和Z轴的主动旋转定义为

式中:Rx(θx)、Ry(θy)和Rz(θz)分别为绕X轴、Y轴和Z轴的主动旋转;θx、θy和θz分别为两帧图像之间相机绕X轴、Y轴和Z轴旋转的角度。

按照欧拉角即ZYX的旋转方式,可得前后两帧图像之间相机的旋转矩阵为

式中:R为两帧图像之间相机的旋转矩阵。

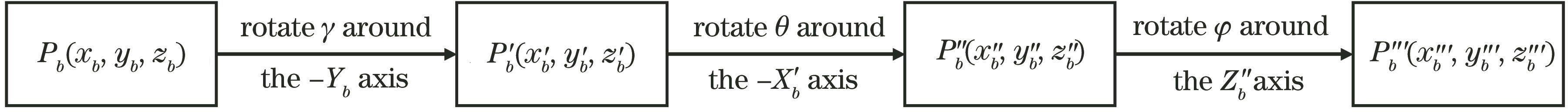

以ZYX的旋转方式进行空间三维旋转的过程如

图 1. 三维旋转过程。(a)旋转过程;(b)三维旋转

Fig. 1. Process of three-dimensional rotation. (a) Process of rotation; (b) three-dimensional rotation

2.2 平移向量

对于相机的平移向量,则需要通过惯性导航计算相机在前后两帧图像之间的位移变化量。惯性测量单元测量的是载体坐标系下的加速度和角速度,为了正确地解算相机运动需要将载体坐标系下的测量值转换到导航坐标系[20]。其中,载体坐标系用ObXbYbZb表示,原点位于载体质心,轴向分别指向载体的横滚轴、俯仰轴和偏航轴的正交坐标系;导航坐标系用OnXnYnZn表示,原点位于载体重心,Xn轴沿纬线指向东边,Yn轴沿子午线指向北边,Zn轴则沿着当地地理垂线指向上边并且与Xn轴,Yn轴构成右手直角坐标系。假设载体坐标系下有一空间点Pb,其空间坐标为(xb,yb,zb),同时该点在导航坐标系下表示为Pn,其空间坐标为(xn,yn,zn)。载体的航向角、俯仰角和横滚角分别用φ、θ和γ表示,则载体坐标系下的空间点Pb转换为导航坐标系下的空间点Pn的过程可以简化为三次坐标轴旋转。首先载体坐标系绕-Yb轴旋转角度γ,得到中间坐标P'(x'b,y'b,z'b),然后绕新的-X'b轴旋转角度θ,得到中间坐标P″(x″b,y″b,z″b),最后绕新的Z″b轴旋转角度φ,得到坐标P‴(x‴b,y‴b,z‴b),该坐标就是导航坐标系下的坐标Pn(xn,yn,zn),具体的坐标转换过程如

根据上述坐标转换过程可得载体坐标系与导航坐标系之间的坐标转换矩阵为

式中:

惯性测量单元中加速度计在载体坐标系下的比力测量值可以表示为

将载体坐标系下的比力测量值fb转换到导航坐标系并移除重力加速度的影响,可得导航坐标系下加速度的测量值为

式中:g为当地的重力加速度;g为当地重力加速度的幅值。

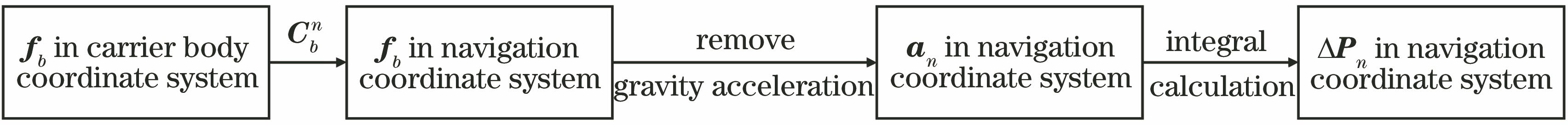

一般来说惯性测量单元的采样周期很短,可以认为载体在每个采样周期内均做匀加速直线运动。在惯性测量单元和相机时间对齐和空间对齐的基础上,根据牛顿运动学定律,导航坐标系下相机在加速度计的一个采样周期内的位移变化量可以离散地表示为

式中:ΔPn为导航坐标系下相机在惯性测量单元的一个采样周期内的位移变化量;vn为前一帧图像对应的时刻相机在导航坐标系下的速度,该向量是运动解算的初始条件;Δt为惯性测量单元的一个采样周期。

一个采样周期内,相机在导航坐标系下的位移变化量的计算过程如

图 3. 导航坐标系下位移变化量的计算过程

Fig. 3. Calculation process of displacement variation in navigation coordinate system

因为惯性测量单元的采样频率高于相机,所以相机采集两帧图像的时间会包含多个惯性测量单元的采样周期,因此计算前后两帧图像之间相机的平移向量t需累加多个惯性测量单元采样周期内的相机位移变化量。

2.3 惯导辅助图像特征匹配的方法

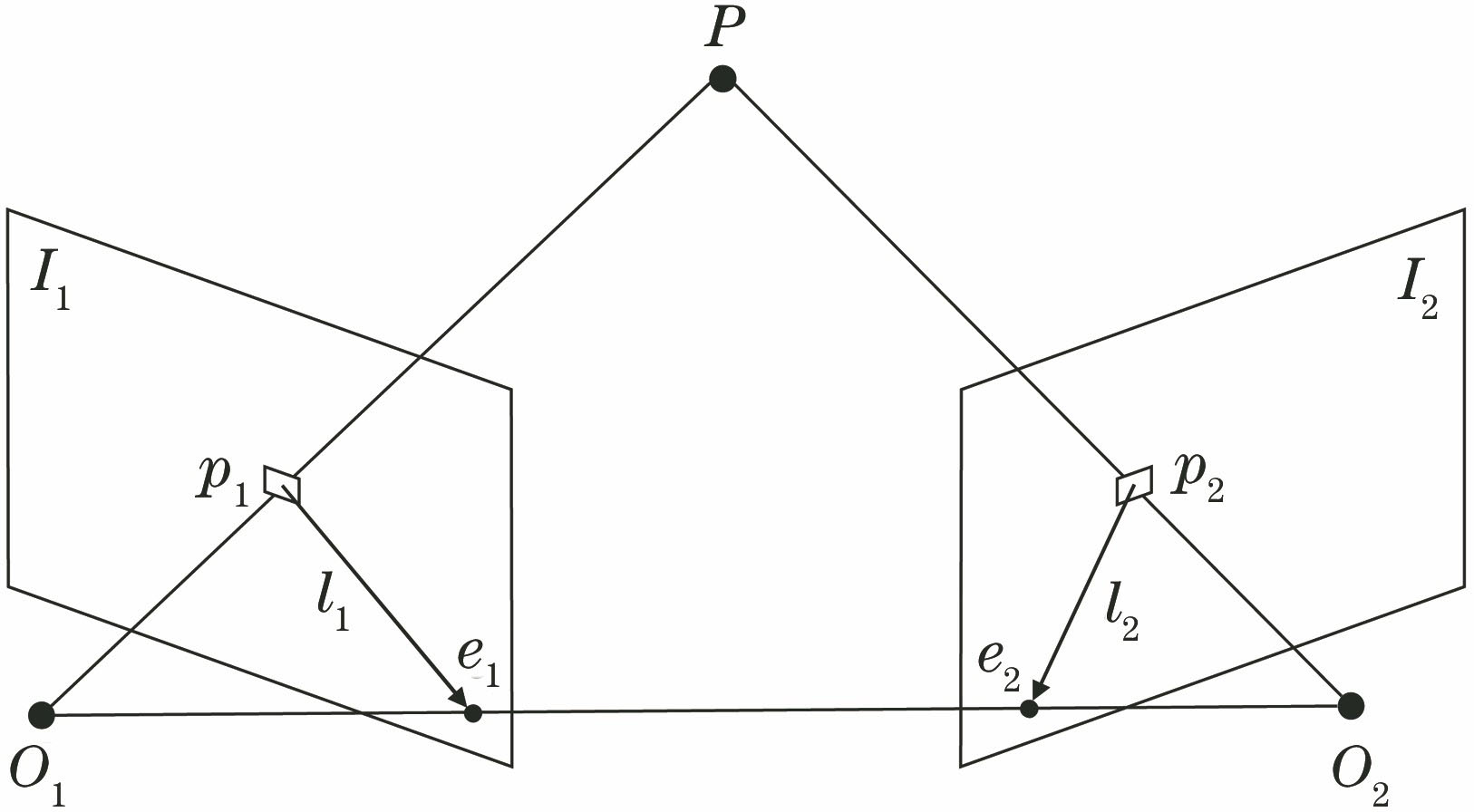

两帧图像中匹配点的相对位置受到两帧图像平面空间几何的约束,这种约束关系就是图像的对极几何约束,如

根据惯性测量单元的加速度和角速度测量值可以计算出相机在前后两帧图像之间的旋转矩阵R和平移向量t。当相机模型为针孔相机模型时,空间点P在两帧图像上的对应点p1和p2的齐次坐标为

式中:

像素点p1和p2在归一化平面上的齐次坐标分别为

式中:

将(10)式代入(9)式可得

令上式两侧同时左乘

式中:t^为相机平移向量t的反对称矩阵;t^

将

(13)式称为对极约束,其几何意义表明,点O1、O2和P三者共面。由(13)式可以定义基础矩阵F为

对于第二帧图像,像素点p2在极线l2上,根据几何关系有

由(13)式和(15)式可得

(16)式表明第一帧图像上的像素点在第二帧图像中的对应位置。相机的内参数矩阵K可以通过相机标定求出,因此只需通过惯性导航解算出相机在前后两帧图像之间的旋转矩阵R和平移向量t便可确定基础矩阵F。对于第一帧图像中的特征点,在得到基础矩阵后,便可计算出其在第二帧图像中可能出现的位置。因为惯性导航解算的相机运动存在一定的误差,所以可适当地将极线搜索匹配扩大为极线周围区域的搜索匹配,以防出现无法匹配的情况。惯性导航辅助图像特征匹配的基本原理如上所述,其基本流程如

3 实验结果与分析

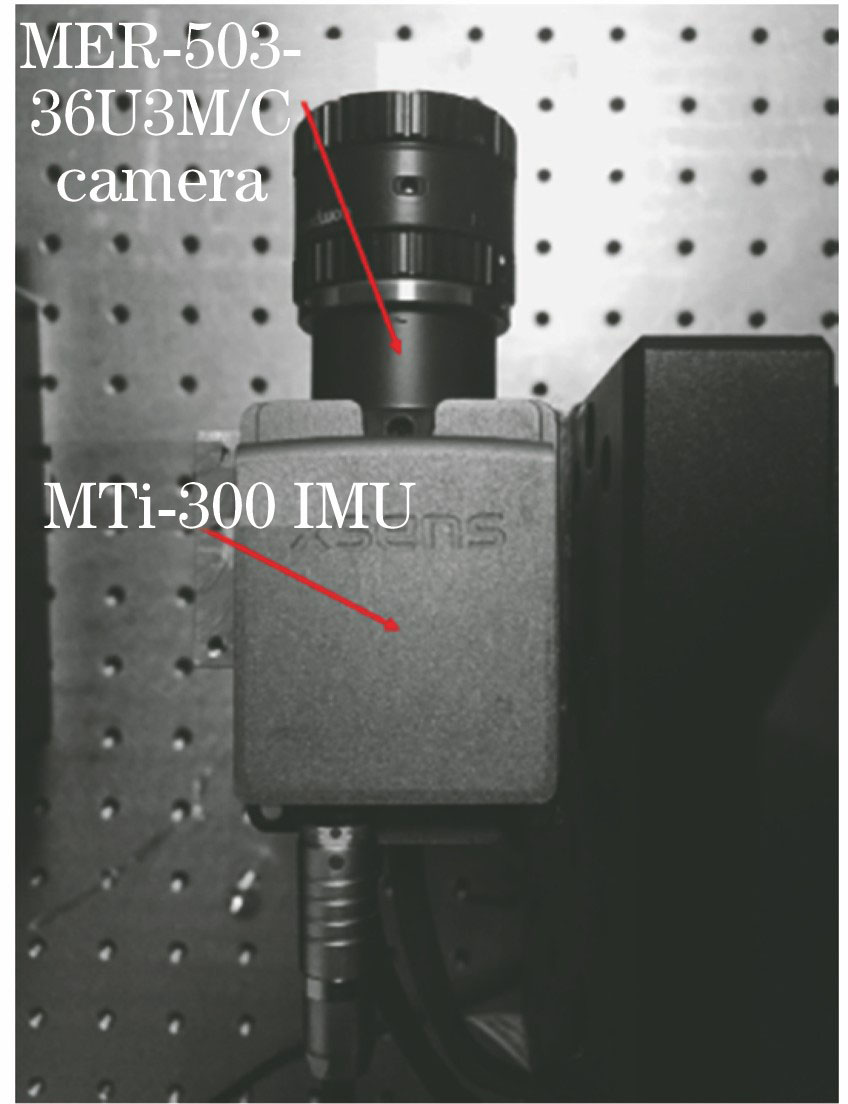

本文通过实际实验对惯导辅助图像特征匹配的方法进行验证,实验时将相机和惯性测量单元两种传感器固连在一起,惯性测量单元采用荷兰Xsens公司生产的MTi-300,相机为大恒图像公司生产的水星MERCURY系列的MER-503-36U3M/C相机,实验设备如

表 4. 三组图像的匹配结果

Table 4. Matching results of three sets of images

|

表 2. 平移向量

Table 2. Translation vector

|

在进行实验之前首先需要对单目相机进行标定,相机标定采用张正友棋盘格标定法,标定的结果为

实验过程中相机分别获取实验台、实验室和办公室的图像,同时惯性测量单元获取相机的运动数据。通过惯性导航解算的前后两帧图像之间相机的旋转矩阵如

通过惯性导航解算的前后两帧图像之间相机的平移向量如

由相机的内参数矩阵、旋转矩阵和平移向量可计算得到基础矩阵,基础矩阵的计算结果如

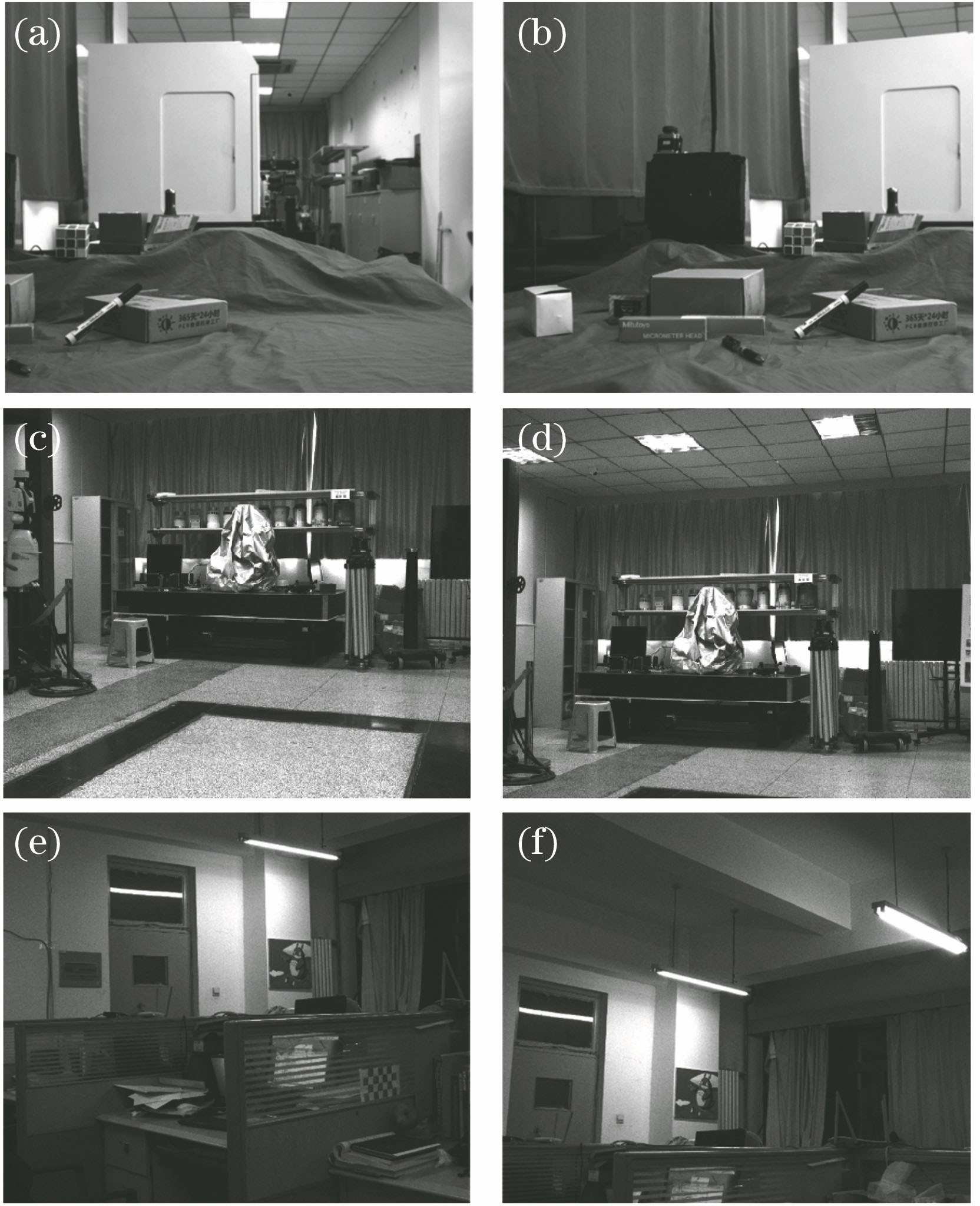

实验过程中相机获取的三组图像如

图 7. 源图像。(a)第一幅实验台图像;(b)第二幅实验台图像;(c)第一幅实验室图像;(d)第二幅实验室图像;(e)第一幅办公室图像;(f)第二幅办公室图像

Fig. 7. Source images. (a) First image of experimental table; (b) second image of experimental table; (c) first image of laboratory; (d) second image of laboratory; (e) first image of office; (f) second image of office

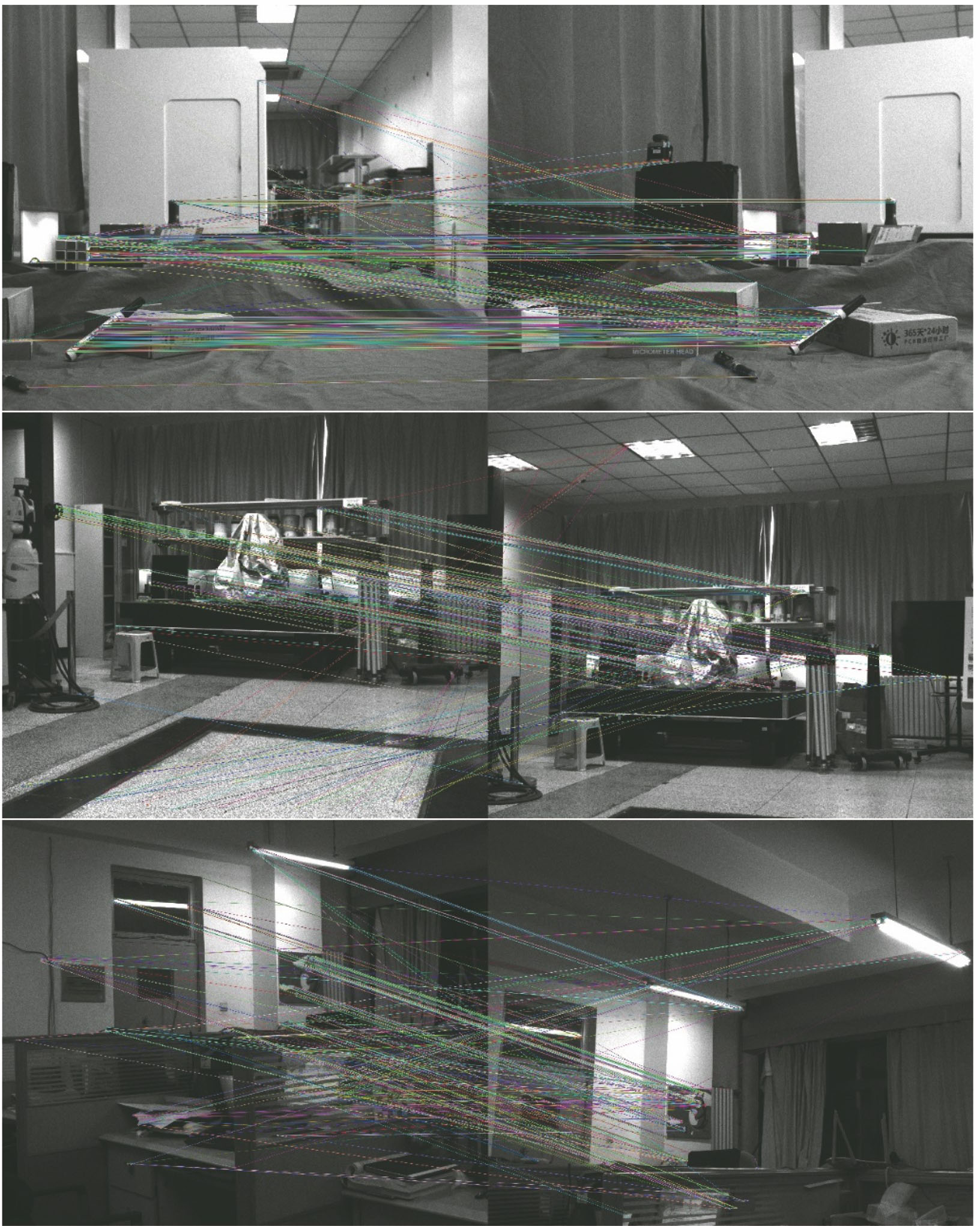

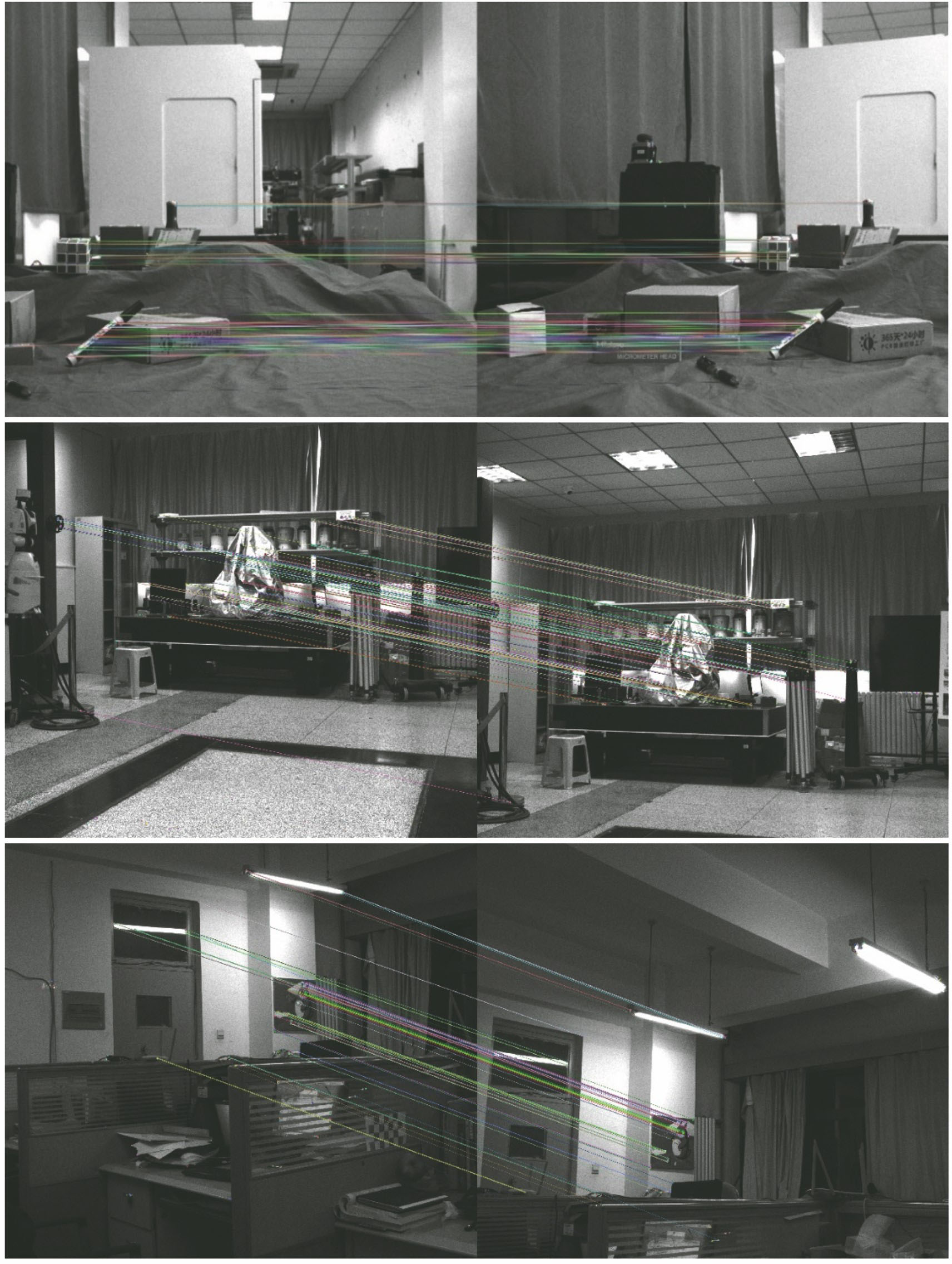

对以上三组图像进行特征点提取后,首先采用暴力匹配方法对三组图像的特征点进行匹配,得到的匹配结果如

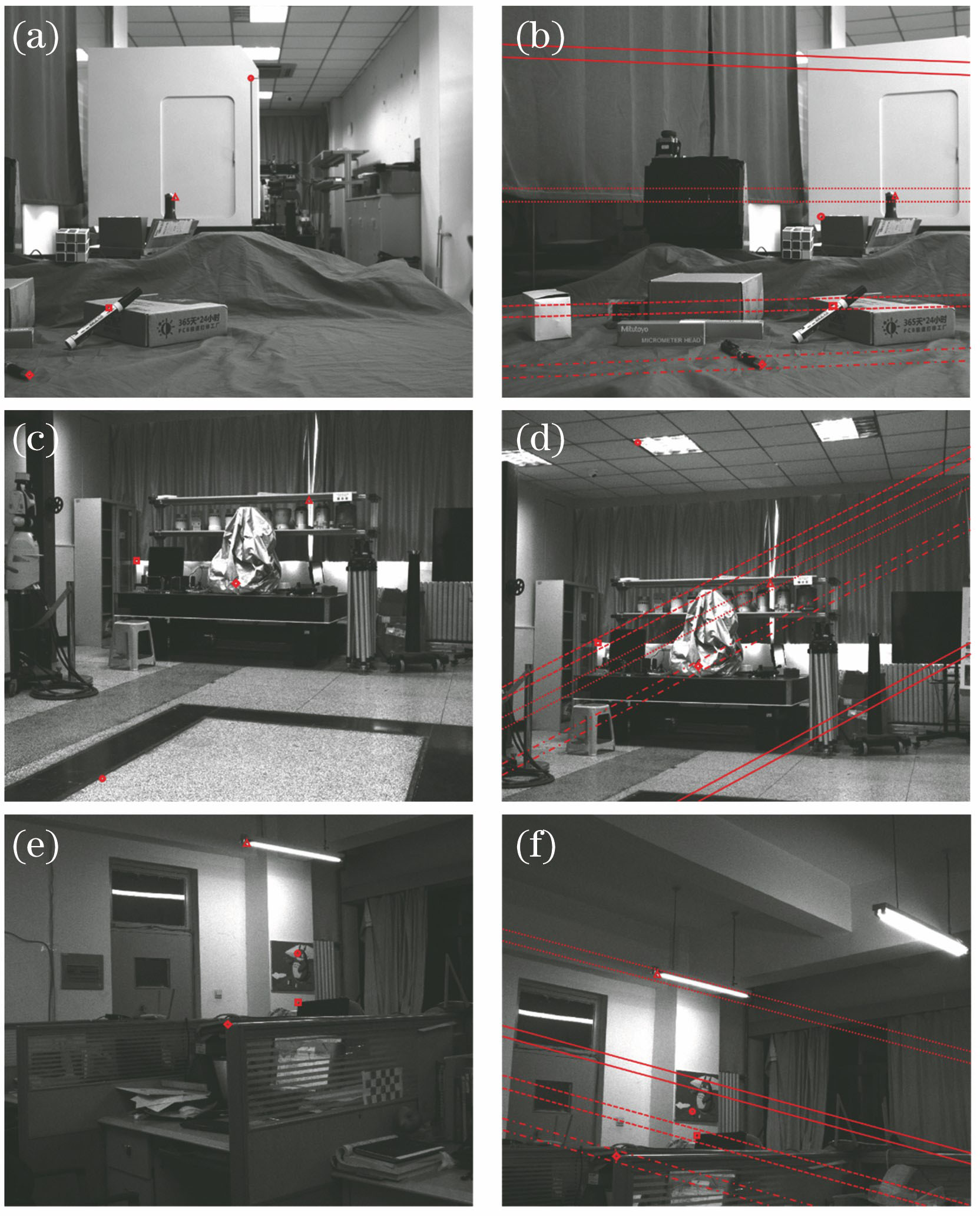

得到暴力匹配的结果后,再对匹配结果加上惯性导航提供的极线约束。考虑到惯性导航的解算结果有一定的误差,故将极线约束拓展为一个可能区域。以四个特征点为例,展示第一幅图像中的特征点在第二幅图像中可能出现的区域,结果如

图 9. 可能区域。(a)第一幅实验台图像中选择的四个特征点;(b)第一幅实验台图像中的特征点对应的可能区域;(c)第一幅实验室图像中选择的四个特征点;(d)第一幅实验室图像中的特征点对应的可能区域;(e)第一幅办公室图像中选择的四个特征点;(f)第一幅办公室图像中的特征点对应的可能区域

Fig. 9. Possible areas. (a) Four feature points selected in the first image of experimental table; (b) possible areas corresponding to the feature points in the first image of experimental table; (c) four feature points selected in the first image of laboratory; (d) possible areas corresponding to the feature points in the first image of laboratory; (e) four feature points selected in the first image of office; (f) possible areas corresponding to the feature points in the first image of office

但第二幅图像中圆形处的特征点并未出现在其对应的可能区域,属于误匹配的特征点。通过观察发现,第一幅和第二幅图像中的圆形处特征点实际对应的是不同的物点,故应该剔除。

将惯性导航提供的约束加入到特征点匹配中可以得到如

图 10. 三组图像添加约束后的匹配结果

Fig. 10. Match results of three sets of images after adding constraints

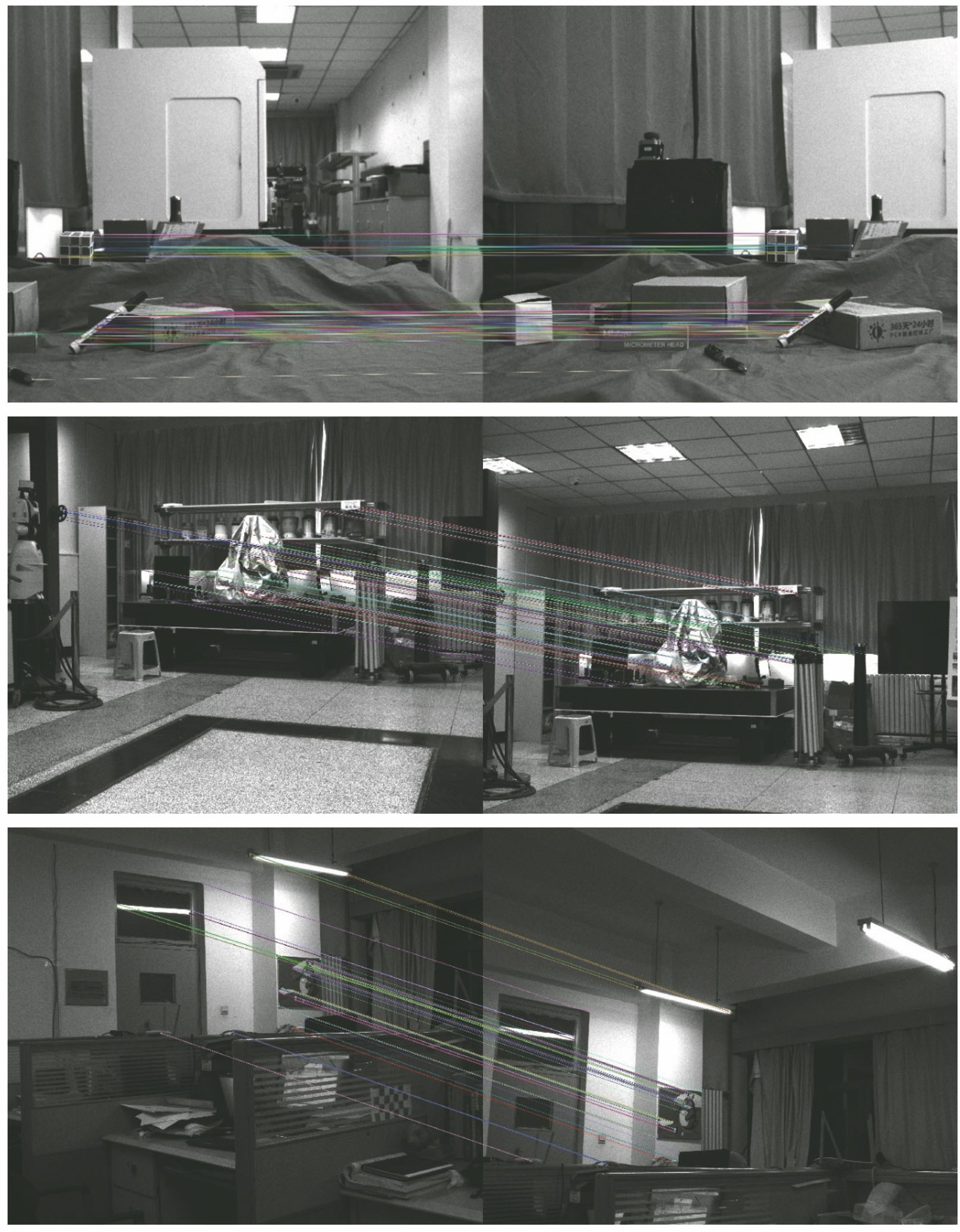

图 11. 三组图像采用RANSAC剔除外点后的匹配结果

Fig. 11. Match results of three sets of images after removing outliers by RANSAC

由

4 结论

为了提高图像特征匹配的准确率,本文提出并推导了一种惯性导航辅助图像特征匹配的方法。该方法将惯性测量单元的测量数据和相机获取的图像进行融合,结合惯性导航解算的相机运动能够为特征点提供区域约束,有效地剔除误匹配的特征点,提高图像特征匹配的准确性;此外惯性导航的加入可以使该方法更好地适应动态场景和纹理重复的场景,具有更好的鲁棒性。最后,通过实验证明了本文方法能够通过惯性导航提供的约束对特征点匹配进行有效地筛选,降低误匹配率。

[1] Li P J, Sheng G L, Zhang X F, et al. Underwater terrain-aided navigation system based on combination matching algorithm[J]. ISA Transactions, 2018, 78: 80-87.

[2] Asl H G, Firouzabadi A D. Integration of the inertial navigation system with consecutive images of a camera by relative position and attitude updating[J]. Proceedings of the Institution of Mechanical Engineers, Part G: Journal of Aerospace Engineering, 2019, 233(15): 5592-5605.

[3] 贾迪, 朱宁丹, 杨宁华, 等. 图像匹配方法研究综述[J]. 中国图象图形学报, 2019, 24(5): 677-699.

Jia D, Zhu N D, Yang N H, et al. Image matching methods[J]. Journal of Image and Graphics, 2019, 24(5): 677-699.

[4] Mohammed H M, El-Sheimy N. Feature matching enhancement of UAV images using geometric constraints[J]. ISPRS-International Archives of the Photogrammetry, Remote Sensing and Spatial Information Sciences, 2018, 42(1): 307-314.

[5] 周梦妮, 张国伟, 卢秋红. 视觉SLAM中图像特征提取算法研究[J]. 电子测试, 2019( 6): 42- 43, 78.

Zhou MN, Zhang GW, Lu QH. Research on image feature extraction algorithm in visual SLAM[J]. Electronic Test, 2019( 6): 42- 43, 78.

[6] 孙彤, 秦文虎, 孙立博. 基于松组合的视觉惯性SLAM方法[J]. 测控技术, 2019, 38(4): 17-21.

Sun T, Qin W H, Sun L B. Visual-aid inertial SLAM method based on loose couple[J]. Measurement & Control Technology, 2019, 38(4): 17-21.

[7] Kim C H, Lee T J, Cho D I. Matching risk for feature selection in visual SLAM[J]. IFAC-PapersOnLine, 2018, 51(22): 144-147.

[8] Hong S, Kim J. Selective image registration for efficient visual SLAM on planar surface structures in underwater environment[J]. Autonomous Robots, 2019, 43(7): 1665-1679.

[9] Li S P, Zhang T, Gao X, et al. Semi-direct monocular visual and visual-inertial SLAM with loop closure detection[J]. Robotics and Autonomous Systems, 2019, 112: 201-210.

[10] Krombach N, Droeschel D, Houben S, et al. Feature-based visual odometry prior for real-time semi-dense stereo SLAM[J]. Robotics and Autonomous Systems, 2018, 109: 38-58.

[11] 李倩. 基于特征描述的图像匹配技术研究[D]. 桂林: 桂林电子科技大学, 2017: 1- 32.

LiQ. Research on image matching technology based on feature description[D]. Guilin:Guilin University of Electronic Technology, 2017: 1- 32.

[12] 惠国保. CNC视觉系统中的图像特征匹配技术及其应用研究[D]. 南京: 南京理工大学, 2014: 1- 33.

Hui BG. Research on image features matching and application of CNC-vision system[D]. Nanjing: Nanjing University of Science and Technology, 2014: 1- 33.

[13] Liu ZX, Wang YX, JingY, et al. An illumination and affine invariant descriptor for aerial image registration[C]∥Photonics Asia. Proc SPIE 8558, Optoelectronic Imaging and Multimedia Technology II, Beijing, China, 2012, 8558: 85580Z.

[14] Lowe D G. Distinctive image features from scale-invariant keypoints[J]. International Journal of Computer Vision, 2004, 60(2): 91-110.

[15] 胡晓彤, 任辉, 刘楠. 尺度与特征强度自适应的SURF特征点匹配算法[J]. 天津科技大学学报, 2019, 34(2): 70-74, 80.

Hu X T, Ren H, Liu N. Adaptive SURF feature points matching algorithm based on scale and feature intensity[J]. Journal of Tianjin University of Science & Technology, 2019, 34(2): 70-74, 80.

[16] Vinay A, Cholin A S, Bhat A D, et al. An efficient ORB based face recognition framework for human-robot interaction[J]. Procedia Computer Science, 2018, 133: 913-923.

[17] 索春宝, 杨东清, 刘云鹏. 多种角度比较SIFT、 SURF、 BRISK、 ORB、 FREAK算法[J]. 北京测绘, 2014( 4): 22- 26.

Suo C B, Yang D Q. Liu Y P. Comparing SIFT, SURF, BRISK,[J]. ORB and FREAK in some different perspectives Beijing Surveying and Mapping, 2014(4): 22-26.

[18] 邵安成. MEMS惯性测量单元设计与相关技术研究[D]. 南京: 东南大学, 2017: 1- 18.

Shao AC. Design of MEMS inertial measurement unit and research on its related techniques[D]. Nanjing: Southeast University, 2017: 1- 18.

[19] 代刚. MEMS-IMU误差分析补偿与实验研究[D]. 北京: 清华大学, 2011: 1- 69.

DaiG. MEMS-IMU error analysis compensation method and experiment research[D]. Beijing: Tsinghua Univesity, 2011: 1- 69.

[20] 刘丽明. 基于惯性测量单元的上肢位置跟踪技术研究[D]. 天津: 天津大学, 2018: 1- 54.

Liu LM. Inertial measurement units based hand position tracking technology research[D]. Tianjin: Tianjin University, 2018: 1- 54.

[21] 彭科举. 基于序列图像的三维重建算法研究[D]. 长沙: 国防科学技术大学, 2012: 1- 47.

Peng KJ. 3D reconstruction using image sequences[D]. Changsha: National University of Defense Technology, 2012: 1- 47.

[22] Goldman Y, Rivlin E, Shimshoni I . Robust epipolar geometry estimation using noisy pose priors[J]. Image and Vision Computing, 2017, 67(2017): 16-28.

吴斌, 王旭日. 惯性导航辅助图像特征匹配方法研究[J]. 激光与光电子学进展, 2020, 57(10): 101509. Bin Wu, Xuri Wang. Inertial Navigation Aided Image Feature Matching Method[J]. Laser & Optoelectronics Progress, 2020, 57(10): 101509.