基于改进HED网络的视网膜血管图像分割  下载: 1277次

下载: 1277次

1 引言

视网膜成像是诊断青光眼、高血压性视网膜病、白内障和糖尿病视网膜病变(DR)等各类疾病的基本技术,其中DR被世界卫生组织(WHO)视为发达国家和发展中国家患者失明的主要原因[1]。检测这类疾病的关键指标之一就是视网膜上的血管是否出现异常,因此眼底图像上的视网膜血管分割是诊断和治疗眼部疾病的关键步骤。

目前,眼底图像上的视网膜血管仍是通过专业的眼科医生通过手动分割来获取的。然而,在眼底图像中手动标记血管是一项费力且耗时的任务,并且由于眼底图像不同局部区域中血管的大小、形状和强度的极端变化,即使是经验丰富的眼科医生也难以获得准确的分割结果,因此迫切需要一种能准确分析视网膜血管的自动分割系统,为医生分析眼科疾病时提供有价值的辅助诊断。尽管近些年来已经提出了用于视网膜血管分割的许多方法,但是由于视网膜血管自身结构的复杂性、眼底图像的低对比度、低质量以及存在一些病理结构如渗出物、出血等的影响,提出一种快速准确的血管分割系统仍然是一项极具挑战的任务[2]。目前为止,已有的方法大致可分为非监督方法和监督方法两大类。

非监督方法通常是在视网膜图像中人工提取血管的固有属性并加以结合适当的形态学操作或模型构建来提取视网膜血管。其主要包括匹配滤波、形态学处理、血管跟踪和基于模型的方法等。Zhang等[3]通过将原始的匹配滤波器和一阶高斯导数组合,根据视网膜图像对其的响应来检测血管。Dash等[4]提出了一种基于形态学算子和Kirsch模板的视网膜静脉提取方法。Zhao等[5]利用图像的混合区域信息通过主动轮廓模型来解决血管分割任务。非监督方法中采用的操作方法和构建的模型大多是针对有限的视网膜图像而言,并不具有普遍性和实用性。

监督方法将图像分割描述为一种像素分类问题,通过提取各种视觉特征来训练能够区分血管和非血管像素的强大分类器。因此,这类方法需要人工注释的标签用以训练。 常用的监督方法主要包括基于机器学习算法的方法和基于深度学习网络的方法。其中基于机器学习的方法主要是通过人工提取眼底视网膜图像的多维特征再通过支持向量机(SVM)、AdaBoost 或贝叶斯分类器等进行血管分割的。Ricci 等[6]使用两个正交线检测器以及目标像素的灰度值构造特征向量并采用SVM进行监督分类。 Lupascu等[7]将视网膜图像的空间属性和几何信息等41维特征向量输入至AdaBoost 分类器中进行训练并完成血管分割。虽然传统的机器学习方法相较于非监督方法,其准确度性能方面有了不小的提高,但是人工提取特征在很大程度上取决于经验和技能,这将大大增加人为因素导致分割结果错误的可能性。

为此,人们将深度学习引入图像分割领域,因其具有捕获高级语义特征信息的超强能力,该类方法在血管分割领域取得了比其他方法更好的性能。在这类方法中,Wang等[8]结合卷积神经网络(CNN)和随机森林(RF)两种分类器的优点,以CNN为特征提取器,结合RF的强大分类能力,对视网膜血管进行了分割。Lu等[9]提出了一种具有编码器-解码器结构的卷积神经网络进行视网膜血管分割,其中编码器部分用于提取图像特征而解码器部分用于重建图像。Hu等[10]提出了一种基于卷积神经网络和全连通条件随机场(CRF)的视网膜血管分割方法,通过提取网络中间层的特征图来构建多尺度网络,并应用CRF来获得最终的分割结果。总而言之,深度学习方法可以克服传统的非监督方法和监督方法中存在的困难,但同时也存在着一个重要的局限性:随着神经网络的加深,虽然可以提取到更高层次的全局信息,但丧失了一些必要的低级的细节信息,这对于血管分割领域而言影响是很大的,因为细小的血管是判断患者病症的重要依据之一。

因此本文提出了一种基于可变形卷积和扩张卷积的改进整体嵌套边缘检测(HED)网络用于视网膜血管分割。所提网络主要有三个特点:1)采用一种可根据血管的大小和形状自适应地调整感受野的可变形卷积代替普通卷积,使得模型更容易捕获具有复杂结构的血管;2)将卷积网络中的池化层替换成扩张卷积,使得模型在增加感受野的同时不损失图像分辨率,进而保留了血管特征的空间位置信息;3)使用加入底部短连接的HED网络对血管进行分割,充分利用不同尺度下血管图像的语义信息,使得最终的分割结果既保留了高级侧输出中血管的结构信息又融入了低级侧输出中血管的细节信息。因此所提出的网络可以有效地提高血管分割的准确性和灵敏度。

2 网络结构与算法原理

2.1 残差可变形块

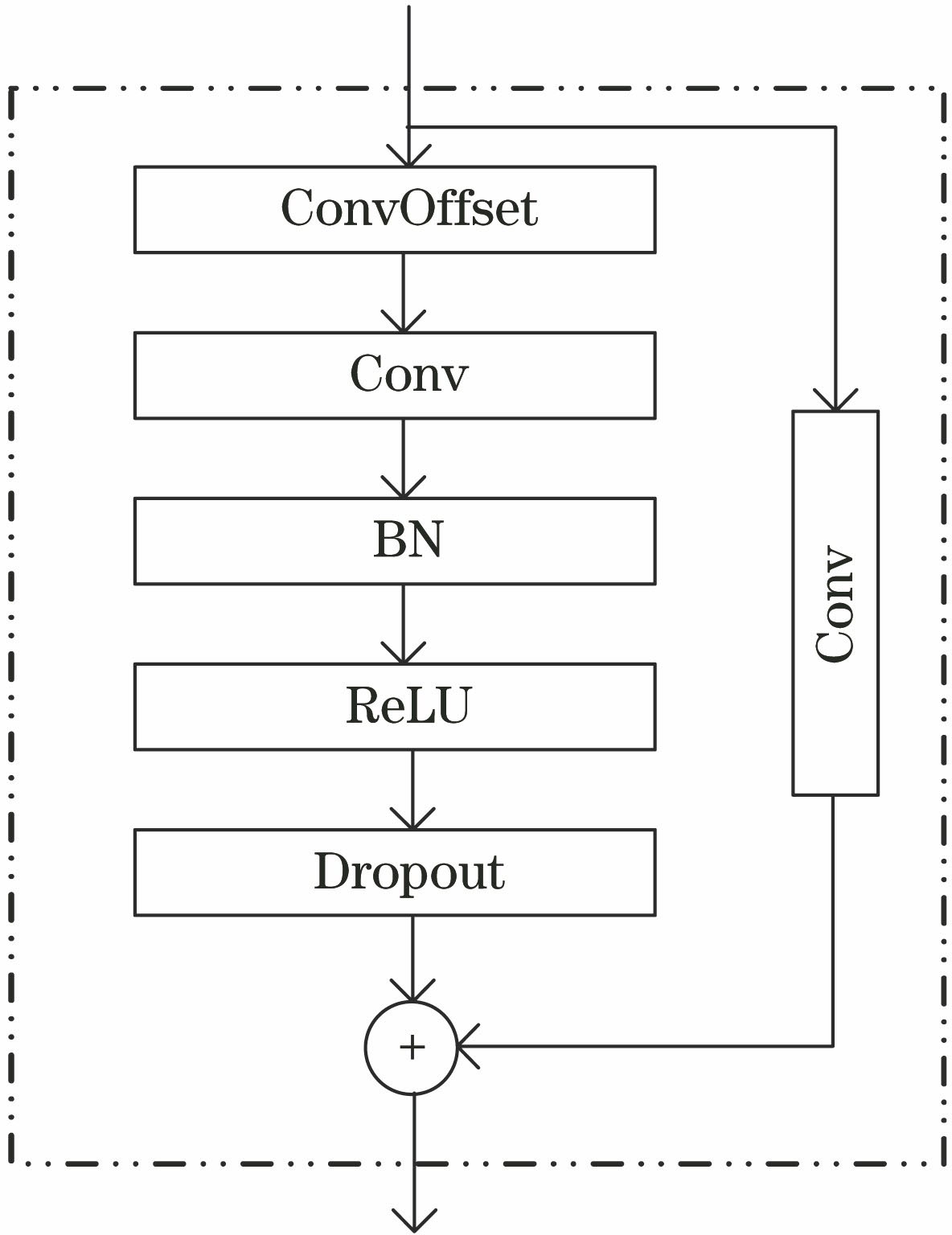

本文引入了一种在残差结构中内含一层可变形卷积的残差可变形块用于学习局部细节特征和自适应调整感受野,以捕获各种形状和尺度的视网膜血管。其模块结构如

可变形卷积是对传统方块卷积的一种改进,传统的方块卷积中规则的采样点限制了卷积神经网络对于结构复杂多变、尺度大小不一的血管的建模能力,而在文献[

11]中所提出的可变形卷积可以通过适应输入层特征的可变形感受区捕获各种形状和尺度的特征区域,极大地改善了卷积神经网络在处理视网膜图像时提取血管尺度和结构特征的能力。可变形卷积在普通卷积的网格采样点位置上添加了一个偏移变量,使得其卷积核的大小和位置可以根据当前需要识别的图像内容进行动态调整。以大小为5×5的卷积核为例,标准的方块卷积核如

其对应的输出结果Y上M0处的结果可表示为

式中:x表示输入特征映射;w表示采样点的权重;Mn表示在M区域中的位置。

而对于可变形卷积而言,由于其卷积核中每个采样点的位置都增加了一个偏移的变量ΔMn,且这个偏移变量是可学习的,故它打破了传统方块卷积的限制,可以根据视网膜图像中血管的结构特征进行自适应调整[如

图 2. 5×5普通卷积和可变形卷积的采样位置示意图。(a)预处理后的图像;(b)普通卷积;(c)可变形卷积

Fig. 2. Schematic diagram of the sampling position of a 5×5 ordinary convolution and a 5×5 deformable convolution. (a) Image after preprocessing; (b) ordinary convolution; (c) deformable convolution

2.2 扩张卷积

本研究用于改善血管分割系统性能的另一个改进之处是使用扩张卷积来代替传统卷积神经网络中常用的池化层。在卷积神经网络中,池化层的主要作用是逐步对特征进行下采样以减小输出空间的大小,进而增大感受野并减少网络参数数量,降低计算量[12]。但池化层在用于处理分割问题时会导致空间敏锐度丧失,在医学图像分割领域分辨率的降低将影响分割的准确性,具体到视网膜血管分割任务中,将会导致细小的血管遗漏。

相较而言,本研究采用的扩张卷积是标准卷积的另一种改进卷积,其在允许增加感受野的同时不损失图像分辨率,也就是说可以在不损失精确度的情况下保留视网膜图像中血管的空间位置信息,且扩张卷积是可训练的。在扩张卷积中,扩张率d被定义为指定内核元素之间的零的数量[13]。假设扩张卷积的内核大小为k,则其扩张后的卷积核大小s为

因此,扩张率的应用将导致有效核尺寸的增加。

图 3. 扩张卷积示意图。(a)扩张率为1;(b)扩张率为2;(c)扩张率为3

Fig. 3. Schematic of dilated convolution. (a) Dilation rate is 1; (b) dilation rate is 2; (c) dilation rate is 3

2.3 网络框架

本研究所提出的用于血管分割的网络结构是一种改进的HED网络。HED网络将卷积网络不同阶段的特征进行融合,以充分利用从低级到高级不同感受野下提取的多尺度特征,如

第一部分是预训练部分。

第二部分是侧输出部分。由于深层卷积所提取的特征过于抽象,无法表达有实际意义的血管结构[14],因此本研究只采用主干网络的前四个阶段进行特征提取。首先将每个阶段所提取的特征经过16个1×1的普通滤波器进行卷积运算并采用1个1×1的滤波器将每个阶段的16个特征图融合成1个特征图,然后采用从高到低短连接将高级语义信息传递到低级语义信息中,用以降低低级语义特征中存在的噪声。最后,将每个阶段最终所获得的特征图与专家手动标记的结果图进行比较,以获得每个侧输出层的损失用以训练。

第三部分是权值融合部分。将每个阶段的侧输出所获得的特征图进行权值融合,以得到最终的血管分割图。

2.4 损失函数

由于在眼底图像中血管像素与非血管像素的比例为1∶9,如果采用一般的损失函数,监督学习过程将倾向于分割占比大的非血管部分,最终会导致血管分割的特异性比较好,但灵敏度会很差,因此本研究采用文献[ 10]中所提出的类别平衡损失函数用于训练所提模型。在侧输出阶段进行训练时,第m层侧输出的损失函数定义为

式中:

则最终用于训练整个侧输出部分的目标损失函数定义为

式中:αm为第m层侧输出在加权融合时所占的权重,M为侧输出的数量。

3 实验

3.1 数据集与网络参数设置

使用DRIVE[15]和STARE[16]两个公开的标准眼底图像数据集来测试所提网络的可用性和有效性。DRIVE数据集包括40张分辨率为565 pixel×584 pixel的TIFF格式的彩色眼底图像, 其中33张图像无糖尿病视网膜病变现象,7张图像有轻度早期糖尿病视网膜病变现象。 DRIVE数据集分为两组:训练组和测试组,每组包含20个图像。 训练组包括掩模图像和来自第一观察者的手动分割结果图片。测试组中采用第一观察者的手动分割结果作为标准结果对模型进行评估,并将模型的输出结果与第二观察者的手动分割结果进行比较。STARE数据集包括20张分辨率为700 pixel×605 pixel的PPM格式的彩色眼底图像,其中有50%的图像为病变图像。由于STARE数据集未划分训练集和测试集,为了能更好地比较分割网络的性能,采用文献[ 17-20]中所使用的留一法进行交叉验证,并且同样采用第一观察者的手动分割结果作为标准结果对模型进行评估,并将模型的输出结果与第二观察者的手动分割结果进行比较。

此外,由于DRIVE和STARE数据集中的图像数据严重不足,为了有效避免模型训练过程中的过度拟合现象,通过旋转和裁剪预处理训练图像来增加训练的数据量。在实验的实施阶段,首先将预处理后的图片进行90°,180°和270°的旋转操作,然后从每张图片中随机提取5000个小图像块用于模型的训练,并且为了降低计算复杂度并确保血管的局部特征,本文根据经验将小图像块的大小设置为48 pixel×48 pixel。因此,本文将从DRIVE和STARE训练数据集上分别获得的400000和380000个大小为48 pixel×48 pixel的小图像块用于各自的训练。

在网络参数设置方面,本研究在网络的预训练阶段采用Adam算法对损失函数进行优化,初始学习率为0.001,权重衰减为0.001,模型的迭代次数为150。在对预训练后的网络进行侧输出训练时,初始学习率设置为0.001,权重衰减设置为0.001,模型的迭代次数为100。

3.2 图像预处理

为了提高所提网络的血管检测水平,对输入网络图像的预处理是一个必不可少的环节。本文采用的预处理方法包括三个步骤:1)合并图像通道;2)对所合并的通道进行归一化并采用对比度受限自适应直方图均衡(CLAHE)对其进行对比度增强;3)采用伽马校正进一步提高图像质量。

3.2.1 提取通道

目前几乎所有的视网膜血管分割方法都是基于单一的绿色通道,或者选取整个RGB眼底图像来进行分割的,而基于G通道的模型通常比基于原始图像的模型表现得更好。因为G通道通常包含最小的噪声和最多的细节,且血管与眼底背景的对比度最高,相反红色和蓝色通道通常饱和且有噪声,特别是蓝色通道对比度非常差,所包含的可用信息很少。然而文献[ 20]中指出在单一绿色通道中加入一定比例的红色通道可以使模型的性能进一步优化,并且显示红绿通道比例为3∶7的模型性能要优于单一绿色通道模型。因此本研究采用红绿通道比例为3∶7进行组合并应用于后面的处理。

3.2.2 图像归一化和CLAHE

通过对合并后的图像进行归一化来进一步标准化图像,然后利用CLAHE增加血管与背景的对比度,相比于自适应直方图均衡化,本文采用的CLAHE在增加图像对比度的同时不会对图像的噪声进行放大,因此可以更容易关注到眼底图像中血管的结构和特征[21]。

3.2.3 伽马校正

图像的伽马校正是一种非线性变换,可以增强眼底图像中亮度较暗的血管部分,同时又不影响亮度较强部分的质量。整个图像预处理的结果如

图 5. 预处理后的典型图像。 (a)原始图像;(b)红绿通道融合后的图像; (c) CLAHE操作后的图像;(d)伽马校正后的图像

Fig. 5. Typical image after preprocessing. (a) Original image; (b) merged image between a red channel and a green channel; (c) image after CLAHE operation; (d) image after Gamma correction

3.3 性能评估指标

模型输出的视网膜血管分割图为二值图像:血管(阳性)和非血管(阴性)。本研究使用以下几个常用的指标用以评估所提出模型的性能:准确度(Acc,Acc),灵敏度(Sn,Sn)和特异性(Sp,Sp),受试者工作特征曲线(ROC,ROC)的曲线下面积(AUC,AUC)。 其中:Sn表示模型区分血管的能力;Sp表示模型区分非血管的能力;Acc表示模型判断血管与非血管的能力;AUC表示模型整体分割性能的一种指标,AUC越大证明分割性能越好。以上指标的标准定义式为

式中:真阳性(TP,xTP)是指正确分类的血管像素;假阴性(FN,xFN)是指错误分类为非血管像素的血管像素;真阴性(TN,xTN)是指正确分类的非血管像素;假阳性(FP,xFP)是指错误分类为血管像素的非血管像素。

3.4 结果分析

3.4.1 所提出方法的结果

3.4.2 与其他先进方法的比较

本文将所提方法与其他先进的方法在 DRIVE和STARE数据集上的Sn,Sp,Acc和AUC等性能方面进行了比较。其中,所比较方法的性能测量结果均来自于各自的源文献。从

表 1. DRIVE和STARE数据集上的性能评估结果

Table 1. Segmentation results on DRIVE and STARE

|

图 6. 在DRIVE数据集上的分割结果。(a)原始图像;(b)标准图;(c)分割结果图

Fig. 6. Segmentation results on DRIVE. (a) Original images; (b) ground truth; (c) segmentation result images

图 7. 在STARE数据集上的分割结果。(a)原始图像;(b)标准图;(c)分割结果图

Fig. 7. Segmentation results on STARE. (a) Original images; (b) ground truth; (c) segmentation result images

表 2. 在DRIVE数据集上所提方法与其他先进方法的比较

Table 2. Performance comparison of the proposed method with state-of-the-art methods on the DRIVE

|

表 3. 在STARE数据集上所提方法与其他先进方法的比较

Table 3. Performance comparison of the proposed method with state-of-the-art methods on the STARE

|

3.4.3 在病变图像上的表现

病变区域血管的检测被认为是视网膜血管分割领域最大的挑战之一,也是很多研究者始终难以克服的问题,但其在医疗诊断中又起着不可忽视的作用。因此,本文将所提方法在不同的病变图像上进行研究,并在

![在病变图像上的分割结果图。(a)原始图像;(b)标准图;(c)本文所提出方法的分割结果图;(d)文献[24]的分割结果图](/richHtml/gxxb/2020/40/6/0610002/img_8.jpg)

图 8. 在病变图像上的分割结果图。(a)原始图像;(b)标准图;(c)本文所提出方法的分割结果图;(d)文献[ 24]的分割结果图

Fig. 8. Segmentation results on lesion images. (a) Original images; (b) ground truth; (c) segmentation result images by proposed method; (d) segmentation result images in Ref. [24]

3.4.4 与原始HED网络的比较

为了验证所提方法的有效性以及每个改进之处对于分割结果所产生的具体影响,本研究在4种不同的HED架构上进行了实验,即Model1采用原始的HED网络不做任何修改;Model2仅采用残差可变形块代替原有HED骨干网络中的普通卷积块;Model3仅采用扩张卷积替代HED骨干网络中的池化层;Model4骨干网络不做任何改变,在侧输出部分加入由高到低的短连接,并将这4种模型与所提方法在DRIVE和STARE数据集上进行Se,Sp,Acc和AUC等性能方面比较,如

表 4. 不同的HED模型在DRIVE和STARE 数据集上的性能评估结果

Table 4. Performance results of different HED models on the DRIVE and STARE

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

图 9. 不同模型的分割细节图。(a)原始图像;(b)标准的局部图;(c)~(f)模型1~4分割的局部图;(g)本文所采用模型分割的局部图

Fig. 9. Local maps segmented by different models. (a) Original image; (b) standard local map; (c)-(f) local maps segmented by model 1 to model 4, respectively; (g) local map segmented by the proposed method

由

4 结论

本文提出了一种基于改进HED网络的视网膜血管图像分割方法,首先在特征提取阶段采用残差可变形块和扩张卷积的组合,使得模型可以最大程度地获取视网膜图像中血管的结构特征和空间信息,然后在特征融合阶段采用由高到低的短连接将各层所提取的血管特征充分融合。通过在DARIVE和STARE数据集上的实验证明,所提方法获得的分割结果最优,且由于克服了传统深度学习因网络层数的增加而导致细节信息丧失的问题,所获得的结果在检测血管的灵敏度性能方面远远超过了其他方法。另外,本文将所提方法应用于包含病理性结构的视网膜图片上时,也得到了比现有的其他方法更好的结果。因此,本文所提方法在实际医疗诊断的应用中比其他方法更具潜力。下一步将继续开发该方法,并将其应用于更多的医学图像领域中。

[2] Shao F, Yang Y, Jiang Q P, et al. Automated quality assessment of fundus images via analysis of illumination, naturalness and structure[J]. IEEE Access, 2017, 6: 806-817.

[3] Zhang B, Zhang L, Zhang L, et al. Retinal vessel extraction by matched filter with first-order derivative of Gaussian[J]. Computers in Biology and Medicine, 2010, 40(4): 438-445.

[4] DashJ, BhoiN. Retinal blood vessel extraction using morphological operators and Kirsch's template[M] ∥Wang J, Reddy G, Prasad V, et al. Soft computing and signal processing. Advances in Intelligent Systems and Computing. Singapore: Springer, 2019, 900: 603- 611.

[5] Zhao Y T, Rada L, Chen K, et al. Automated vessel segmentation using infinite perimeter active contour model with hybrid region information with application to retinal images[J]. IEEE Transactions on Medical Imaging, 2015, 34(9): 1797-1807.

[6] Ricci E, Perfetti R. Retinal blood vessel segmentation using line operators and support vector classification[J]. IEEE Transactions on Medical Imaging, 2007, 26(10): 1357-1365.

[7] Lupascu C A, Tegolo D, Trucco E. FABC: retinal vessel segmentation using AdaBoost[J]. IEEE Transactions on Information Technology in Biomedicine, 2010, 14(5): 1267-1274.

[8] Wang S L, Yin Y L, Cao G B, et al. Hierarchical retinal blood vessel segmentation based on feature and ensemble learning[J]. Neurocomputing, 2015, 149: 708-717.

[9] Lu YQ, Zhou YP, Qin JC. A convolutional encoder-decoder architecture for retinal blood vessel segmentation in fundus images[C]∥2018 5th International Conference on Systems and Informatics (ICSAI), November 10-12, 2018. Nanjing, China. New York: IEEE, 2018: 1071- 1075.

[10] Hu K, Zhang Z Z, Niu X R, et al. Retinal vessel segmentation of color fundus images using multiscale convolutional neural network with an improved cross-entropy loss function[J]. Neurocomputing, 2018, 309: 179-191.

[11] Dai JF, Qi HZ, Xiong YW, et al. Deformable convolutional networks[C]∥2017 IEEE International Conference on Computer Vision (ICCV), October 22-29, 2017. Venice. New York: IEEE, 2017: 764- 773.

[12] Soomro T A, Afifi A J, Gao J B, et al. Strided fully convolutional neural network for boosting the sensitivity of retinal blood vessels segmentation[J]. Expert Systems With Applications, 2019, 134: 36-52.

[13] YuF, KoltunV, FunkhouserT. Dilated residual networks[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017. Honolulu, HI. New York: IEEE, 2017: 472- 480.

[14] LongJ, ShelhamerE, DarrellT. Fully convolutional networks for semantic segmentation[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 7-12, 2015. Boston, MA, USA. New York: IEEE, 2015: 3431- 3440.

[15] Staal J, Abràmoff M D, Niemeijer M, et al. Ridge-based vessel segmentation in color images of the retina[J]. IEEE Transactions on Medical Imaging, 2004, 23(4): 501-509.

[16] Hoover A D, Kouznetsova V, Goldbaum M. Locating blood vessels in retinal images by piecewise threshold probing of a matched filter response[J]. IEEE Transactions on Medical Imaging, 2000, 19(3): 203-210.

[17] Liskowski P, Krawiec K. Segmenting retinal blood vesselswith_newline deep neural networks[J]. IEEE Transactions on Medical Imaging, 2016, 35(11): 2369-2380.

[18] FuH, XuY, LinS, et al. Deepvessel: retinal vessel segmentation via deep learning and conditional random field[C]∥Ourselin S, Joskowicz L, Sabuncu M, et al. Medical Image Computing and Computer-Assisted Intervention(MICCAI 2016), Lecture Notes in Computer Science. Cham: Springer, 2016, 9901: 132- 139.

[19] Wang X H, Jiang X D, Ren J F. Blood vessel segmentation from fundus image by a cascade classification framework[J]. Pattern Recognition, 2019, 88: 331-341.

[20] Tang P, Liang Q K, Yan X T, et al. Multi-proportion channel ensemble model for retinal vessel segmentation[J]. Computers in Biology and Medicine, 2019, 111: 103352.

[21] Reza A M. Realization of the contrast limited adaptive histogram equalization (CLAHE) for real-time image enhancement[J]. The Journal of VLSI Signal Processing-Systems for Signal, Image, and Video Technology, 2004, 38(1): 35-44.

[22] Yan Z Q, Yang X, Cheng K T. A three-stage deep learning model for accurate retinal vessel segmentation[J]. IEEE Journal of Biomedical and Health Informatics, 2019, 23(4): 1427-1436.

[23] Khan M AU, Soomro TA, Khan TM, et al. Automatic retinal vessel extraction algorithm based on contrast-sensitive schemes[C]∥2016 International Conference on Image and Vision Computing New Zealand (IVCNZ), November 21-22, 2016. Palmerston North, New Zealand. New York: IEEE, 2016: 1- 5.

[24] Zhuang J. LadderNet: multi-path networks based on U-Net for medical image segmentation[EB/OL]. ( 2018-10-17)[2019-08-28]. https:∥arxiv.xilesou.top/abs/1810. 07810.

Article Outline

张赛, 李艳萍. 基于改进HED网络的视网膜血管图像分割[J]. 光学学报, 2020, 40(6): 0610002. Sai Zhang, Yanping Li. Retinal Vascular Image Segmentation Based on Improved HED Network[J]. Acta Optica Sinica, 2020, 40(6): 0610002.