快速尺度自适应核相关滤波目标跟踪算法  下载: 1275次

下载: 1275次

1 引言

可视化目标跟踪是计算机视觉中的研究热点之一,在智能交通、机器人、人机交互、无人驾驶等视觉场景中得到了广泛的应用。近年来,目标跟踪领域的研究取得了很大的进步,但光照变化、运动模糊、背景混乱、遮挡、尺度变化等因素的影响使得利用单一跟踪模型很难解决目标跟踪领域存在的问题。因此,研究者们提出了大量的目标跟踪算法,其中平方误差的最小输出和(MOSSE)[1]第一次展示了相关滤波应用于跟踪算法的巨大潜能,随后核检测跟踪的循环结构(CSK)[2]、自适应颜色属性跟踪(CN)[3],核相关滤波(KCF) [4]的提出使相关滤波跟踪算法获得了越来越多的关注。

Henriques等[2]提出CSK来研究一种基于循环结构的稠密采样策略,该策略可采集更多的样本,并且不影响跟踪的速度,取得了很好的效果。Danelljan等[3]提出CN,使用颜色属性扩展稠密采样相关滤波跟踪器,并采用主成分分析[5]将原本11维的颜色属性降为2维的颜色特征,并与灰度特征融合成3维特征,改进了目标的表观特征。Henriques等[4]提出的KCF使用方向梯度直方图(HOG)特征和核机制,对稠密采样相关滤波跟踪器进行改进,得到基于HOG特征的KCF跟踪算法,在跟踪精度和稳健性上有了较大的提高。虽然上述算法实现了精度与稳健性的大幅度提升,但是这些基于相关滤波的跟踪算法采用的是固定大小的模板,仅评估目标的位置,不能处理目标尺度的变化,而能否自适应地处理尺度变化直接关系到跟踪算法的综合性能。

在相关滤波框架下的目标跟踪研究有效解决了目标尺度问题,其中效果最好的是使用尺度金字塔,国内大多数研究也是以KCF为基础添加尺度估计机制,例如高美凤等[6]提出尺度自适应核相关滤波目标跟踪,王鑫等[7]提出基于多层卷积特征融合的目标尺度自适应稳健跟踪,沈秋等[8]提出基于自适应特征选择的多尺度相关滤波跟踪,李聪等[9]提出特征融合的尺度自适应相关滤波跟踪算法,这些研究都是通过对目标区域进行多尺度采样或者使用不同的特征表征来提高跟踪精度。同样,稳健视觉跟踪的精确尺度估计(DSST)[10]和特征整合尺度自适应核相关滤波跟踪算法(SAMF)[11]均采用尺度固定的尺度因子,DSST使用一个独立的尺度滤波器,尺度个数为33,在目标位置确定后,以目标的不同尺度采样作为样本训练尺度滤波器,从而求得最优目标尺度。SAMF采用7个尺度模板,与DSST不同的是,SAMF寻求位置和尺度同时最优。DSST是基于MOSSE进行改进,增加了HOG与原始特征的融合。SAMF基于KCF并在HOG特征提取时增加了颜色特征,提高了外观表征的能力。判别式尺度空间跟踪(fDSST)[12]是DSST的加速版。利用检测方案实现视觉跟踪中的尺度和纵横比适应性(KCFDPT)[13],把类不可知的检测建议方法与相关滤波进行整合来解决尺度问题。

上述DSST与SAMF解决尺度变化的方法大同小异,均使用尺度模版,只是使用个数和对尺度设计的方法不同,最终效果类似。虽然上述2种方法效果很好,但是DSST在大部分情况下可以实现实时检测,而SAMF不像DSST一样借助快速傅里叶变换(FFT),每一帧循环7次来求解位置与尺度同时最优,很难实现实时检测。考虑到KCF能够快速地应对各种复杂情况,而DSST与SAMF不管尺度变化与否,对每一帧都重复同样次数的计算,并且为了进一步验证仅利用检测响应图的峰值来应对目标尺度的有效性,以响应图与期望输出图的欧氏距离作为峰值的可靠程度,以两者的乘积作为最终比较结果,先使用3个尺度因子确定目标尺度变化方向,然后在尺度变化方向求解最优尺度,可大幅减少计算量。由于通常情况下,目标尺度变化不大,又考虑到遮挡等复杂情况的影响,因此通过实验可知,迭代次数设置为5是最优的方法。

为了在确定最优位置后独立地评估目标尺度,本文提出一种由粗到细的快速、新颖的快速尺度自适应核相关滤波目标跟踪(FSAKCF)算法。该方法可以嵌入基于相关滤波的跟踪算法中进行快速尺度评估。与其他先进的未处理尺度的CSK、CN、KCF进行比较,以证明本文提出的方法能够处理尺度变化;并与先进的尺度处理算法DSST、SAMF、KCFDPT、fDSST进行比较,考察各算法的中心位置精度和跟踪速度。

2 KCF

KCF跟踪器基于CSK跟踪器进行扩展,以HOG特征代替原先的灰度特征,并把只能使用单通道的灰度特征改进为可以使用多通道的HOG特征或者其他特征。KCF使用目标周围区域的循环矩阵采集正负样本,利用岭回归训练目标检测器,并成功地利用循环矩阵在傅里叶空间可对角化的性质,将矩阵的运算转化为向量的Hadamad积,即元素的点乘,大幅减少了运算量,提高了运算速度,使算法满足实时性要求。并将线性空间的岭回归通过核函数映射到非线性空间,在非线性空间通过求解一个对偶问题和某些常见的约束,同样可以使用循环矩阵傅里叶空间对角化简化计算,给出了一种将多通道数据融入该算法的途径。

KCF是一种判别式追踪方法,一般在追踪过程中训练一个目标检测器,使用目标检测器检测下一帧预测位置是否为目标,然后使用新检测结果更新训练集,进而更新目标检测器。而在训练目标检测器时,一般选取目标区域为正样本,目标的周围区域为负样本,越靠近目标的区域为正样本的可能性越大。KCF跟踪算法主要包括分类器训练、快速检测与模型更新3个部分。

2.1 分类器训练

利用岭回归进行分类器训练,原因是它可以提供一个简单的封闭形式的解决方案,并可以实现接近更复杂方法的性能,比如支持向量机(SVM)。训练的目的是找到一个函数

式中:

式中:

将线性问题的输出用核机制映射到非线性空间

式中:

点乘形式的算法为

式中:

式中:

式中:

式中:

2.2 快速检测

采用2.1节中训练的分类器检测下一帧目标的位置,即采集搜索区域内所有测试样本, 获得分类器的响应输出,响应输出值最大的位置为下一帧目标所在的位置。对于给定的单个测试样本

对所有的候选块计算回归函数。注意到

式中:

直观上来看,计算

2.3 模型更新

在目标跟踪过程中,目标经常会因环境和自身的变化而受到影响,需要及时更新目标表观模型来应对目标的变化。模型更新主要包括预测位置的目标表观模型

式中:

3 快速尺度自适应

3.1 快速尺度评估

针对现有大多数跟踪算法无法解决尺度变化问题和尺度解决方案存在冗余、固定的问题,提出一种快速尺度评估方法。该方法采用由粗到细的策略,粗略地确定目标尺度变化方向,以在该方向上迭代求解的响应图最大值作为最优尺度,从而实现快速尺度估计。为了进一步验证仅利用检测响应图的峰值应对目标尺度的有效性,以响应图与期望输出图的欧氏距离作为峰值的可靠程度,即

式中:

快速尺度评估算法步骤如下。

1) 输入图像

2) 输出尺度因子

①根据

②将

③比较

a) 如果

b) 如果

c) 如果

3.2 快速尺度自适应目标跟踪算法

KCF算法中的目标跟踪框固定不变,当目标逐渐变大时,只能捕捉到目标的某一部分,当目标逐渐变小时,跟踪的目标区域又易于掺杂干扰的背景信息。为了解决这一问题,在原始算法的跟踪过程中加入3.1节中提出的尺度估计的方法。

快速尺度自适应目标跟踪算法步骤如下。

1) 输入图像

2) 输出位置

位置评估:

①根据

②将

③

尺度评估:

①参照3.1节,获得

②

模型更新:

①根据

②根据(10)式和(11)式,更新

4 实验

在KCF跟踪算法中嵌入所提出的快速尺度估计方法,以解决目标尺度问题并极大地提高算法性能,进一步与DSST、SAMF、KCFDPT和fDSST尺度估计算法进行比较,并与其他先进的跟踪算法进行定性与定量比较。

4.1 算法参数和实验配置

本文提出的方法仅使用了HOG特征,特征的单元大小为4×4,方向梯度设置为9。目标填充为1.5,归一化参数为10-4,期望输出标准差为0.1,高斯函核大小为0.5,学习率设置为0.02。

从评估基准OTB-100[15]中挑选出26个包含尺度变化属性的基准序列,序列属性如

表 1. 26个跟踪序列对应的帧数和序列属性

Table 1. Frame numbers and sequence attributes of 26 tracking sequences

|

4.2 评估方法

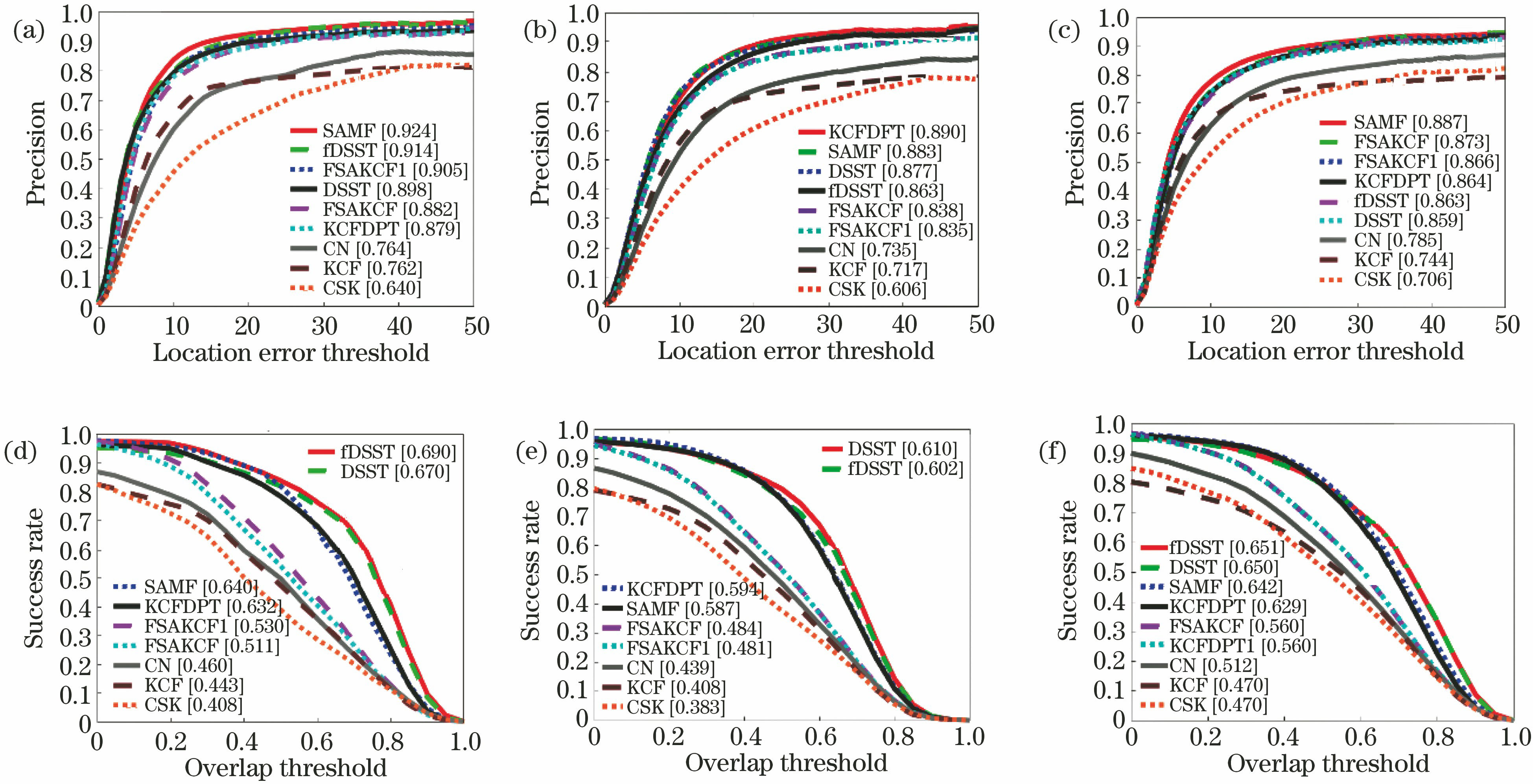

本文提出方法的性能通过文献[

16]中的协议进行定量验证。提出方法的性能包括距离精度(DP)、中心位置误差(CLE)和重叠精度(OP)。第一度量CLE是基准和评估的目标位置的平均欧氏距离。第二度量DP是CLE小于某阈值序列中相对数量的帧数,文献[

16]中选择的阈值为20 pixel。第三度量OP是边框重叠率超过某个

在精度图中根据某范围内的阈值来绘制平均DP,给出每种方法20 pixel上的平均DP分数。在成功率图中绘制平均OP,给出曲线下面积(AUC)。精度图和成功率图提供了26个序列的平均结果。最后,给出本文提出的方法与现有其他先进跟踪算法的定量分析。

4.3 与其他先进跟踪算法的比较

为了评估本文提出的快速尺度估计方法的性能增益,在26个序列上运行9种跟踪算法:CSK、CN、KCF、DSST、SAMF、KCFDPT、fDSST,以及本文提出的方法FSAKCF(仅以响应图的最大值作为比较标准)与FSAKCF1(以误差权重与响应图峰值乘积作为比较标准)。所有方法都基于相关滤波框架。

表 2. 9种跟踪算法的特点

Table 2. Characteristics of 9 tracking algorithms

|

图 1. 26个序列的精度和成功率。(a) OPE的精度;(b) SRE的精度;(c) TRE的精度;(d) OPE的成功率;(e) SRE的成功率;(f) TRE的成功率

Fig. 1. Precision and success rate of 26 sequences. (a) Precision of OPE; (b) precision of SRE; (c) precision of TRE; (d) success rate of OPE; (e) success rate of SRE; (f) success rate of TRE

图 2. KCF与FSAKCF在David、CarScale、Dog1序列上的跟踪效果。(a) David,跟踪帧数为11;(b) David,跟踪帧数为149;(c) David,跟踪帧数为462;(d) CarScale,跟踪帧数为11;(e) CarScale,跟踪帧数为167;(f) CarScale,跟踪帧数为242;(g) Dog1,跟踪帧数为11;(h) Dog1,跟踪帧数为733;(i) Dog1,跟踪帧数为1290

Fig. 2. Tracking effect of KCF and FSAKCF on sequences of David, CarScale, and Dog1. (a) David, tracking frame number of 11; (b) David, tracking frame number of 149; (c) David, tracking frame number of 462; (d) CarScale, tracking frame number of 11; (e) CarScale, tracking frame number of 167; (f) CarScale, tracking frame number of 242; (g) Dog1, tracking frame number of 11; (h) Dog1, tracking frame number of 733; (i) Dog1, tracking frame number of 1290

5 结论

提出了一种由粗到细快速解决目标尺度变化的方法。提出的尺度估计方法可以嵌入其他基于相关滤波框架的跟踪算法。与现有其他先进的DSST和SAMF这2种代表性尺度处理算法相比,本文提出的方法不仅解决了目标尺度变化问题,从而提高了跟踪性能,而且实时跟踪速度是DSST的2.5倍,是SAMF的6倍,解决了添加尺度处理机制导致跟踪不实时的问题。实验结果表明,提出的方法成功处理了目标尺度的变化,与KCF相比,平均位置误差和重叠率大幅提升。TRE的精度均超过DSST、KCFDPT、fDSST。

本文主要研究目标跟踪过程中目标尺度对跟踪性能的影响,虽然本文提出的方法能够有效应对部分遮挡和短时间遮挡,但对于全部遮挡和长时间遮挡情况下没有进行处理。在未来的研究中将更多地研究目标严重遮挡的情况。

[1] Bolme DS, Beveridge JR, Draper BA, et al. Visual object tracking using adaptive correlation filters[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2010: 2544- 2550.

[2] Henriques JF, CaseiroR, MartinsP, et al. Exploiting the circulant structure of tracking-by-detection with kernels[C]. European Conference on Computer Vision, 2012: 702- 715.

[3] DanelljanM, Khan FS, FelsbergM, et al. Adaptive color attributes for real-time visual tracking[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2014: 1090- 1097.

[5] Jolliffe I T. Principal component analysis[J]. Journal of Applied Statistics, 1986, 87: 41-64.

[6] 高美凤, 张晓玄. 尺度自适应核相关滤波目标跟踪[J]. 激光与光电子学进展, 2018, 55(4): 041501.

[7] 王鑫, 侯志强, 余旺盛, 等. 基于多层卷积特征融合的目标尺度自适应稳健跟踪[J]. 光学学报, 2017, 37(11): 1115005.

[8] 沈秋, 严小乐, 刘霖枫, 等. 基于自适应特征选择的多尺度相关滤波跟踪[J]. 光学学报, 2017, 37(5): 0515001.

[9] 李聪, 鹿存跃, 赵珣, 等. 特征融合的尺度自适应相关滤波跟踪算法[J]. 光学学报, 2018, 38(5): 0515001.

[10] DanelljanM, HägerG, Khan FS. Accurate scale estimation for robust visual tracking[C]∥Proceedings of the British Machine Vision Conference, 2014: 65.

[11] LiY, Zhu JK. A scale adaptive kernel correlation filter tracker with feature integration[C]. European Conference on Computer Vision, 2014: 254- 265.

[12] Danelljan M, Häger G, Khan F S, et al. Discriminative scale space tracking[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(8): 1561-1575.

[13] Huang DF, LuoL, WenM, et al. Enable scale and aspect ratio adaptability in visual tracking with detection proposals[C]∥Proceedings of the British Machine Vision Conference, 2015: 185.

[14] Rifkin R, Yeo G, Poggio T. Regularizedleast-squares classification[J]. Acta Electronica Sinica, 2003, 190(1): 93-104.

[15] Wu Y, Lim J, Yang M H. Object tracking benchmark[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1834-1848.

[16] WuY, LimJ, Yang MH. Online object tracking: a benchmark[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2013: 2411- 2418.

Article Outline

何雪东, 周盛宗. 快速尺度自适应核相关滤波目标跟踪算法[J]. 激光与光电子学进展, 2018, 55(12): 121501. Xuedong He, Shengzong Zhou. Fast Scale Adaptive Kernel Correlation Filtering Algorithm for Target Tracking[J]. Laser & Optoelectronics Progress, 2018, 55(12): 121501.