基于人眼视觉特性的自适应支持权重立体匹配算法  下载: 1204次

下载: 1204次

1 引言

正常人在获取外界信息时,有75%的信息都来自眼睛。人眼之所以可以感受到场景三维(3D)信息,主要原因就是双眼在获取同一副场景图像时存在视差。利用视差原理可以让计算机也获得3D场景的深度信息,其中的关键就是如何找到图像上的一点在另一幅图像上所对应的点,这就是立体匹配技术。立体匹配技术在视觉导航、3D显示、3D重构等领域都有广泛的应用[1-2]。由于立体匹配的准确性将直接影响所得3D信息的准确性,因此精确又符合人眼视觉特征的立体匹配方法具有重要的意义。

立体匹配算法一般分为全局匹配算法和局部匹配算法。全局匹配算法在本质上属于优化算法,它是将立体匹配问题转化为寻找全局能量函数的问题,代表算法主要有图割法[3]、置信度传播算法[4]和动态规划算法[5]等。全局算法能够获得较低的总误匹配率,但算法复杂度较高,不利于在实际工程中使用。局部匹配算法则是利用待匹配点周围邻域窗口内的信息进行计算从而得到视差图,与全局算法相比,涉及信息量较少、运算时间较快,但是匹配精度略有逊色。

局部匹配算法的代表主要有绝对误差和(SAD)算法、平方误差累积(SSD)算法、归一化互相关(NCC)算法等。Yoon等[6]提出了一种自适应支持权重(ASW)算法,它的实质是根据色彩相似性和几何距离确定权重,为支持窗口内各邻域像素点分配权重值,使与中心点具有很强相似性的邻域点获得较大的权重。这一算法的应用使得局部立体匹配算法的匹配性能可以与全局方法相媲美。近年来,很多学者对局部方法提出了一些改进算法。De-Maeztu等[7]提出一种利用像素颜色信息计算自适应权值的匹配方法,提高了原算法的匹配精度。Einecke等[8]提出了一种基于标准互相关函数进行匹配代价聚合的方法,在提高匹配精度的同时,降低了时间冗余度。龚文彪等[9]提出了一种基于颜色内相关和自适应支撑窗口的方法,同时在匹配代价计算过程中加入rank变换,有效算消除了光照差异的影响,提高了算法精度。但是这些算法往往都是一些数学上的计算,把图像单纯的看成数据集合,将其视做图像处理过程,而非一个视觉的过程,与人眼的视觉特征差别较大,缺少人眼的关注度体制。针对此问题,本文从人眼视觉特性出发,分别从颜色特征和距离特征两方面对传统自适应权重算法的权重分配策略进行了改进。

2 自适应权重算法原理

Yoon等[6]提出的自适应支撑权重算法本质上是根据窗口内各个像素点与待匹配点的颜色相似性和空间接近性为其分配合适的权重。一般来说,窗口内的像素

式中色彩相似性强度为

式中

(1)式中空间接近性强度为

式中

根据(2)~(5)式,像素

式中

原算法文献[4]提到,当仅考虑参考图像时,目标图像窗口像素可能来自不同深度,这会对匹配结果产生不良影响,为了最小化这种影响,同时考虑目标图像支持窗口和参考图像支持窗口的权重。根据双权重的思路,参考图像上的待匹配像素

式中

式中

式中

3 改进的自适应支撑权重算法

3.1 同心圆拮抗式感受野

人眼的视觉回路中,视网膜上的光传感器(感光细胞)接收光信号并将其传给相应的视觉神经细胞,从而让大脑对相应的光信息产生反应。这些光传感器就是相应的视觉神经细胞的感受野。感受野分为两种,一种是由中心的兴奋作用区域和周边的面积更大的抑制作用区域构成的同心圆拮抗式感受野,另一种是由中心的抑制区域和周边的兴奋区域构成的感受野。人类视觉神经细胞的感受野就是同心圆拮抗式感受野。

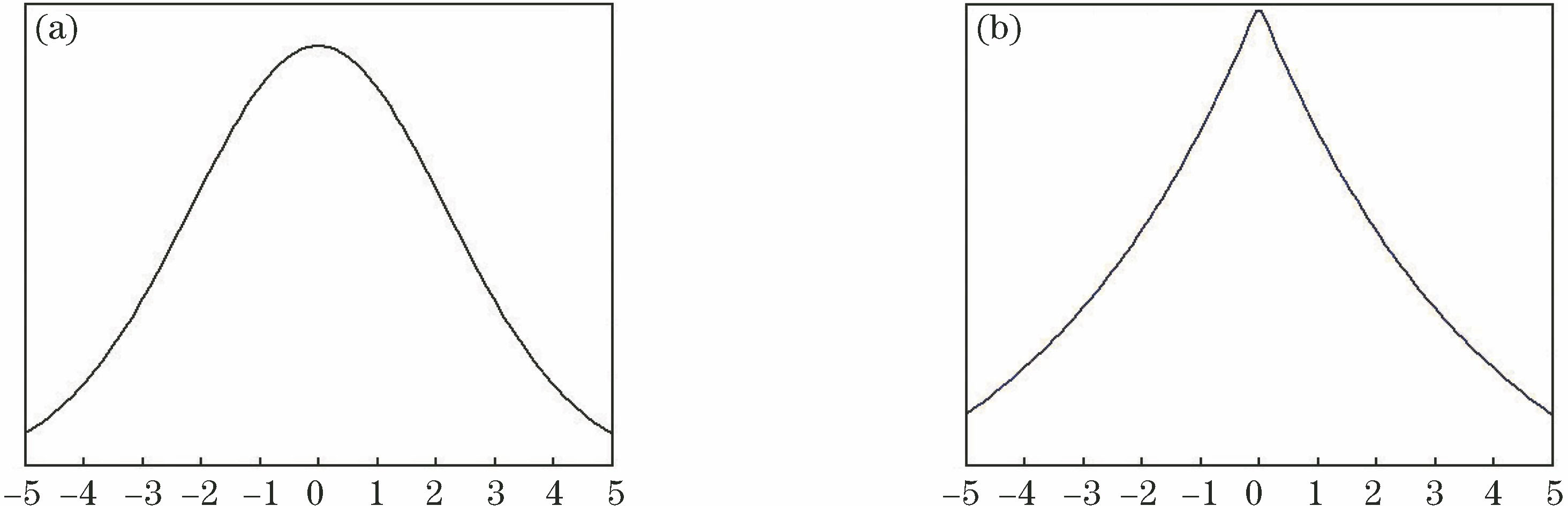

Rodieck于1965年提出了同心圆拮抗式感受野具有高斯分布性质的数学模型。也就是说,在人眼的一个视觉场景中,离目标像素越近的点越能够获得更多的关注,同时关注程度的权值与离关注中心的距离关系呈高斯分布。

由于人眼同心圆拮抗式感受野是具有高斯分布性质的数学模型,而原自适应权重算法对几何接近性对权重的影响只是单纯的根据像素点与中心像素的距离分配权重,基于这点,提出一种改进的方法。将(1)式中的由几何接近性

式中

图 1. (a)高斯分布式权重分配曲线;(b)原算法的权重分配曲线

Fig. 1. (a) Gaussian weight distribution curve; (b) weight distribution curve of original algorithm

可以看到,越接近中心点,曲线衰减的越慢,即中心的附近的像素参考价值大;远离中心的则衰减速度迅速加快,即参考价值迅速变小,这是符合人眼同心圆拮抗式感受野模型特性的。

3.2 HSI色彩空间

除高斯分布式关注度特性外,人眼对颜色的感受还有两个显著的特点:1) 对光强度的敏感程度高于对色彩的敏感程度;2) 对颜色的感受只取决于色调和颜色的饱和度,而与光强无关。基于这两个事实,美国色彩学家孟塞尔提出了HSI色彩空间。其中

HSI模型是一个基于圆柱极坐标的双锥体坐标系,如

色调分量为

式中

饱和度分量为

强度分量为

根据HSI模型与人眼对颜色感受的相符性,对(2)式中颜色相似性

由于HSI颜色模型中色调分量

这样(2)式中,色彩相似性强度变为

最终的权重表达式为

4 视差优化

由于摄像机位置的不同,前景对后景的遮挡部分不同,这就造成左图像中的一点在右图像中并没有对应点,但在匹配过程中,匹配算法肯定会赋予该点一个视差值,这就会导致匹配精度下降。为此,采用左右一致性校验(LRC)来检测图像中的遮挡点,并对其进行视差值填充。

左右一致性校验具体做法为:首先分别以左右图像作为参考图像和目标图像求得左右视差图,对于左视差图中的任意一像素

在上述处理结束后,视差图中通常只会剩有一些孤立的噪声点和误匹配点,因此再对处理后的视差图做3 pixel×3 pixel中值滤波处理,可以有效剔除这些干扰,提高匹配精度。

5 实验结果及分析

实验采用Middlebury测试平台上提供的三组标准立体图像对,分别为Venus、Teddy、Cones。计算机硬件配置为Inter Core i7 CPU,主频为3.6 GHz,内存容量为8 GB。软件编程环境为Visual Studio 2010和Opencv 2.4。为方便实验对比,按原ASW算法选取参数:窗口尺寸

为了验证两处权重分配准则的改动对算法性能的影响,分别对只使用高斯分布式空间接近性强度和HSI空间颜色相似性强度的算法进行测试。使用Middlebury平台提供的误匹配像素比率评价指标(PBM)的测试对比结果如

总体上来看,高斯分布式几何距离权重和HSI空间色彩权重都对实验正确率提高有所贡献,但高斯分布的引入对实验结果的影响更大一些。而Teddy图中由于存在多块颜色相同但光照有变化区域,HSI空间模型的引入对结果影响有所提升,这是模型中光强分量和色彩分量分开独立计算的原因。

同时,为了说明(17)式中

表 1. 分别只改进一项权重分配法则的实验结果

Table 1. Experimental result with only one weight distribution rule improved%

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||

由

图 4. 视差计算结果。(a)真实视差图;(b)原ASW算法;(c)本文算法

Fig. 4. Results of parallax calculation. (a) Real parallax; (b) original ASW algorithm; (c) proposed algorithm

从直观上可以看出,按本文算法在原ASW算法上引入符合人眼视觉特征的权重分配方法后,原方法在Teddy和Venus图中低纹理区域的误匹配很大程度上得到解决,同时,深度不连续部分的误匹配也得到直观的改善。但是,Teddy和Cones图中的重复纹理区域的误匹配依然存在,

另外,国内外有不少学者也对ASW算法进行了优化改进,如文献[

10]中的基于颜色区域生长的自适应支持权重(CAG)方法、文献[

11]中的两路自适应支持权重(TP)方法、文献[

12]中的联合近似双边滤波(FBS)方法等。本文算法与这些改进ASW算法的误匹配率和运算时间比较结果如

表 2. 本文算法和其他算法的误匹配率比较

Table 2. Comparison of matching error rate with proposed algorithm and other algorithms%

| |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

表 3. 本文算法和其他算法的误匹配率和运算时间比较

Table 3. Comparison of matching error rate and operation time with proposed algorithm and other algorithms

| |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

通过

6 结论

根据人眼视觉特征提出了一种改进的自适应权重算法,并在VS2010平台上进行了测试。本文算法一方面通过改变方法窗口内的距离权重计算方法,从而改变权重分布,提高匹配精度,另一方面使用HSI颜色模型计算颜色相似性,进一步提高视差计算的准确度,再利用左右一致性校验和中值滤波方法对视差图进行优化。与其他方法的实验对比,结果表明本文改进算法可以有效降低原算法在各个不同区域的误匹配率,平均误匹配率为6.92%,匹配效果优于大部分其他局部算法和其他改进ASW算法,但计算速度上有待提高。

[1] 单宝华, 霍晓洋, 刘洋. 一种极线约束修正数字图像相关匹配的立体视觉测量方法[J]. 中国激光, 2017, 44(8): 0804003.

[2] 桑新柱, 于迅博, 陈铎, 等. 三维光显示技术研究进展[J]. 激光与光电子学进展, 2017, 54(5): 050006.

[3] 龚文彪, 顾国华, 钱惟贤, 等. 基于图像分割和自适应支撑权重的立体匹配算法[J]. 光学学报, 2015, 35(s2): s210002.

[5] 祝世平, 闫利那, 李政. 基于改进Census变换和动态规划的立体匹配算法[J]. 光学学报, 2016, 36(4): 0415001.

[8] EineckeN, EddertJ. A two-stage correlation method for stereoscopic depth estimation[C]. 2010 International Conference on Digital Image Computing: Techniques and Applications (DICTA).2010: 227- 234.

[9] 龚文彪, 顾国华, 钱惟贤, 等. 基于颜色内相关和自适应支撑权重的立体匹配算法[J]. 中国激光, 2014, 41(8): 0812001.

[10] 吴方, 王沛. 一种改进的自适应权重立体匹配算法与校正[J]. 电视技术, 2012, 36(11): 19-23.

Wu F, Wang P. Improved adaptive support-weight algorithm and adjustment[J]. Video Engineering, 2012, 36(11): 19-23.

[11] WangL, LiaoM, GongM, et al. High-quality real-time stereo using adaptive cost aggregation and dynamic programming[C]// Proceedings of the third International Symposium on 3D Data Processing, Visualization, and Transmission, 2006: 798- 805.

[12] MattocciaS, VitiM, RiesF. Near real-time fast bilateral stereo on the GPU[C]// Proceedings of the IEEE International Conference on Computer Vision and Pattern Recognition Workshops, 2011: 136- 143.

[13] LeiC, SelzerJ, YangY. Region-tree based stereo using dynamic programming optimization[C]. IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 2006: 2378- 2385.

刘雪松, 沈建新, 张燕平. 基于人眼视觉特性的自适应支持权重立体匹配算法[J]. 激光与光电子学进展, 2018, 55(3): 031013. Xuesong Liu, Jianxin Shen, Yanping Zhang. Adaptive Support Weight Stereo Matching Algorithm Based on Human Visual Characteristics[J]. Laser & Optoelectronics Progress, 2018, 55(3): 031013.