结合分水岭和回归网络的视频时序动作选举算法  下载: 1151次

下载: 1151次

1 引言

视频中的时序动作检测任务是当今计算机视觉领域最具挑战性的研究课题之一,具有视频监控与安全、人机交互、视频检索和医疗监控等应用[1-2]。与视频动作识别相比,时序动作检测任务更具挑战性,不仅需要预测动作类别,还要预测动作发生时精确的开始和结束时间点[2-5]。

随着卷积神经网络的发展,视频动作识别的准确度得到显著提升[3]。传统的针对动作片段的时序检测方法[4]缺乏对动作上下文信息的利用,导致时序检测的精度并不理想,并且大多依赖手工特征,Thumos Challenge 2014[1]和2015[5]中最佳的方法都使用改进的密集轨迹(iDT)和Fisher矢量。近年来,一些研究将iDT特征与帧级深度网络[1]提取的外观特征相结合,然而这样的2D卷积网络只能捕获空间表征信息,不能捕获视频中对于建模动作来说非常重要的运动信息。

2D图像的目标检测任务[6-7]与视频时序动作检测任务密切相关,传统的目标检测方法大多依赖于密集滑动窗口[8]。近年提出的空间结构建模[9]是目标检测任务的关键步骤,RoI池化的引入可以以最小的额外成本对目标的空间结构建模。

在时序检测领域,基于视频片段的方法[3]通常是独立处理各片段而不考虑它们之间的时序结构。现有方法在两个关键方面受到限制:1)SCNN[10]等方法只能对固定且有限长度的时序结构建模,没有顾及到动作发生长度的多样性;2)可以对较长动作建模的循环网络[11]等方法依赖于密集的时序片段采样,计算量太大,无法实现端到端训练。

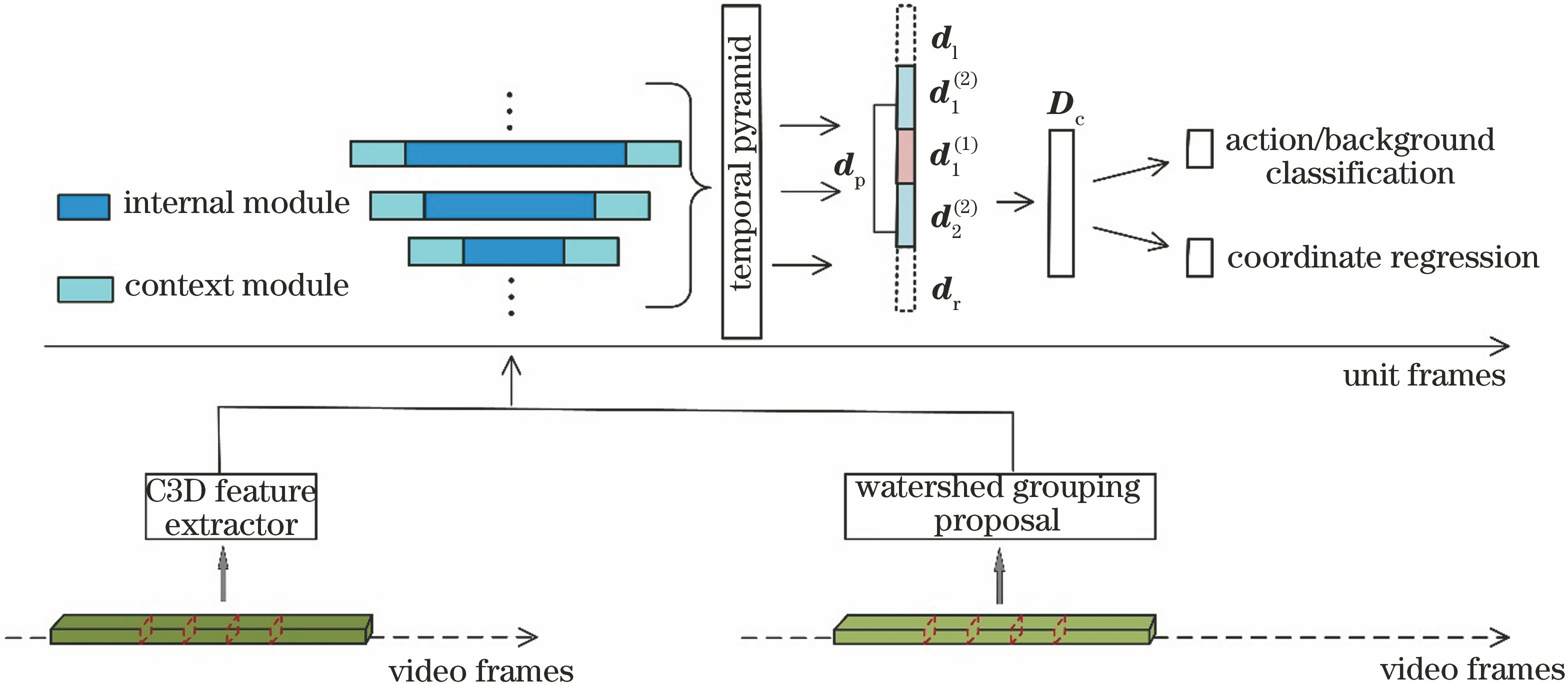

针对上述问题,本文主要进行以下工作:1)提出一个两段式候选区域选举模型。第一段选举算法首次将改进的分水岭算法应用于一维时序信号,通过聚类产生多种不同长度的候选区域,兼顾动作长度的多样性,实现动作边界的粗定位;第二段用时序回归选举网络设计两个同级结构,该结构能够同时实现动作边界的坐标回归定位及动作/背景候选区域的分类和过滤,得到精确的时序边界,实现端到端的训练。2)提出时序金字塔结构化分析方法,引入动作片段的上下文信息模块,对候选区域的主体信息和上下文信息进行结构化建模,生成一个全局表达,针对性地增强了动作片段的时序结构特征,允许对不同长度动作片段的建模。3)整个框架基于三维卷积神经网络(C3D)[4]单元级特征进行训练。C3D能够同时挖掘视频的时域和空域信息,提升时序检测的精度。相比于传统的单帧训练,单元级特征训练在大大提升时序检测速度的同时保证了精度。提出的时序动作选举算法生成的候选区域在Thumos 14和ActivityNet中达到了最优的平均召回率,在时序定位应用中具有极具竞争力的平均精度均值。

2 改进的分水岭选举算法

结合分水岭和回归网络的视频时序动作选举算法整体结构如

2.1 C3D单元级特征处理

计算高效性对于大型视频分析任务非常重要。近期的研究[10-11]将双流网络或三维卷积网络应用于视频特征提取,虽然效率有所提升,但仍是针对单帧图片的特征提取,效率无法得到进一步提高。针对此问题,提出一种基于单元级特征训练的方法,不再以单帧为单位提取视频特征。一个包含

2.2 改进的分水岭选举算法

将应用于二维图像分割任务的分水岭算法改进为应用于一维时序信号聚类的时序区域选举算法。在二维图像分割领域,分水岭算法的优点是计算简单,对于较均匀的连通目标有较好的分割效果,而视频中动作发生的时间段相对于整个视频时间段来说,也是较均匀的联通目标。同时,受文献[ 12]空间动作定位任务中二元动作性分类器的启发,本文创将二元动作性分类器应用于一维时序动作定位任务,主要思想是筛选出动作可能性得分高的单元动作片段,将包含高分单元动作片段较多的时序区间汇聚为一个连通的候选区域,作为对动作时序边界的粗定位。

将二元动作性分类器[12]应用于时序动作定位任务,二元动作性分类器采用在Kinetics数据集下预训练的ResNet。利用ResNet对每个单元级片段进行动作可能性评估,将其包含动作真值的概率作为该片段的动作可能性得分。

改进的分水岭算法将视频以单元级片段(

基于改进的分水岭方法得到盆地

考虑到视频动作时序长度的多样性,选取多组

区别于传统的滑窗法[10]大批量随机选取候选区域,改进的分水岭选举算法依据动作可能性对时序区域进行更合理的初步定位,过滤掉一部分背景信息,节省了后续的计算成本。不同注水等级

3 时序回归选举算法

3.1 时序金字塔结构化算法

将视频单元输入到视频特征提取器C3D,可得到单元级特征

为更好地利用视频中的运动信息和因果语义信息,引入上下文信息模块,

时序金字塔结构化算法的设计灵感来自于spacial pyramid pooling[9]在目标识别任务中的成功应用。对于一个扩展增强过的候选区域

该公式可以更详细地表示为

式中,‖表示向量拼接,

串联各部分

图 3. 内部区域及扩展区域的时序金字塔结构化

Fig. 3. Structure of temporal pyramid of internal and extended regions

3.2 单元级时序回归选举网络

在时序金字塔结构化模块之后连接两个同级网络结构,一个为动作/背景分类器

将全局区域金字塔特征

式中,

训练阶段收集两种训练样本。1)动作样本:将与最相近的真值gt的时间交并比(tIoU)大于0.5的候选区域标记为正样本;2)背景样本:将与真值没有任何重叠,即tIoU为0的候选区域标记为负样本。采用多任务损失函数实现分类器

式中,

式中:

将改进的分水岭选举算法与时序回归选举算法相组合,分别实现对动作时序区间的粗定位和细定位,然后加入上下文信息模块、C3D单元级特征提取模块和时序金字塔结构化模块,得到一个完整的两段式时序区域选举网络,整个架构支持端到端的训练。

4 实验与分析

4.1 数据集与实验设置

Thumos 14数据集的时序动作定位子集包含来自20个类别的超过20 h的视频。此子集包含200个验证集视频和213个测试集视频。由于Thumos 14的训练集仅包含修剪的视频,本文模型在验证集上训练。

ActivityNet数据集提供了丰富的视频数据,该数据集共包含3个子集,分别是v1.1、v1.2、v1.3。其中v1.3被用作ActivityNet Challenge的竞赛数据集,包含200个类别共19994个视频。每个子集都以2∶1∶1的比例被划分为训练集、验证集和测试集。

参数设置。1)C3D单元级特征:以

4.2 两段式候选区域选举网络

为验证两段式时序区域选举算法“改进的分水岭选举算法和时序回归选举算法”生成的候选区域的质量,设计了两实验。

1) 从候选区域是否精准的角度,将本文算法与其他时序动作选举方法的召回率进行比较,采用2种评估方法。a)AR-AN:随着平均检索到的候选区域数量增加,平均召回率相应地变化;b)Recall-AN-tIoU:固定选取前平均数(AN ,

2) 从对后续时序定位效果影响的角度,将不同选举方法产生的候选区域连接到相同的动作分类器上。根据最终定位坐标的平均精度均值(mAP),评价其产生的候选区域的质量。其中相同的分类器选用两种,一种是SVM分类器,一种是SCNN中的第三段结合时序重叠率的分类器。a)SVM分类器:利用C3D的fc6特征训练,实现21个类别的分类(20个动作类,1个背景类);b)SCNN定位器:SCNN[10]三段式时序动作检测方法中的第三阶段,是结合时序重叠率的新型分类器,由分类器的动作预测得分对候选区域进行非极大值抑制过滤,产生最终定位坐标。

4.2.1 两段式区域选举算法候选区域的精度

采用AR-AN和Recall-AN-tIoU方法下对两段式区域选举算法产生的候选区域与其他时序区域选举算法(如DAPs[14],Sparse-prop[15],SST[16],BSN[17])产生的候选区域进行比较,结果在AR-AN和Recall-AN-tIoU方法下比较,如

从

图 4. 候选区域在Thumos 14上的表现。(a) AR-AN;(b) Recall-AN-tIoU

Fig. 4. Performances of candidate regions on Thumos 14. (a) AR-AN; (b) Recall-AN-tIoU

4.2.2 两段式候选区域对时序定位的影响

将本文算法与其他先进的时序动作选举算法,包括DAPs[14]、Sparse-prop[15]、SST[16]、SCNN-prop[10]、BSN[17],在Thumos 14数据集上进行对比。将不同选举算法产生的候选区域输入到相同的动作分类器中,通过最终定位的mAP取0.5来衡量候选区域的质量。同时,为验证 “分水岭+时序回归”两个选举阶段各自的有效性,对改进的分水岭选举算法(Watershed)、时序回归选举算法(Reg)、整体两段式时序区域选举算法(Watershed+Reg)产生的候选区域的质量分别进行评估,见

表 1. 不同时序选举方法在Thumos 14数据集上产生的候选区域在后续定位任务中的表现

Table 1. Performances of different temporal proposal methods in subsequent localization in candidate regions on Thumos 14 %

|

结果显示,不论后续连接SVM分类器还是SCNN定位器,两段式时序区域选举算法产生的候选区域的精度均高于其他算法。两段式时序区域选举算法产生的候选区域连接SCNN定位器后,定位精度比DAPs[14]方法高出20.9%,比Sparse-prop高出21.9%,比SST方法高出14.2% ,比BSN方法高出7.8%。其中DAPs利用C3D提取视频特征,BSN利用全局化的边界敏感网络,SST引入非常长的视频序列。注意到,相比于SCNN[10]原始的三段式架构,将前两段SCNN-prop替换为 “分水岭+时序回归”两段式选举算法后,准确率提升了18.2%。验证了两段式区域选举算法产生的候选区域具有高质量特性,也说明高质量的时序区域选举算法对时序定位任务具有促进作用。

直接将第一段改进的分水岭选举算法“Watershed”得到的候选区域输入定位器,精度就能够达到15.2%,而“Watershed+Reg”两段式组合的形式与其他方法相比则达到了最高的识别精度。这是因为第一段选举算法为第二段选举算法提供了具有动作可能性依据的时序区间,且考虑了动作长度的多样性,使得回归结果更加精准。这验证了第一段选举算法的有效性,也说明了两段式选举算法的必要性。

ActivityNet v1.3测试集的结果如

表 2. ActivityNet v1.3数据集中,各方法时序定位坐标在不同tIoU下的mAP

Table 2. mAP of temporal localization coordinate of each method with different tIoU on ActivityNet v1.3 dataset %

|

其中:CDC[18]也运用了C3D,在其结构上进行卷积和反卷积的改进,并且同样对结果进行了微调;BSN[17]利用全局化的边界敏感网络,同样提取了动作候选区域的特征,并且加入了起始和结束边界特征;TCN[19]同样引入动作的时序上下文信息,并且利用成对尺度采样特征对候选区域进行排序。这强有力地证明两段式候选区域选举算法的高精度性和有效性。

两段式候选区域选举算法产生的时序区间如

图 5. 两段式区域选举算法在各阶段产生的候选区域示意图

Fig. 5. Schematic of candidate regions generated in each stage of two-stage regional proposal algorithm

4.3 消融研究

为验证本文时序上下文信息模块、时序金字塔结构化模块、C3D单元级别特征训练这3个模块的有效性和必要性,对两段式时序区域选举网络的4种变体进行比较。1) w/o ctx & w/o pyramid:去掉时序上下文扩展模块和时序金字塔结构化模块,w为with的缩写,代表包含某模块,w/o为without的缩写,代表不包含某模块;2) w/ctx & w/o pyramid:保留时序上下文扩展模块,但不对内部候选区域进行特殊的

图 6. 时序上下文信息模块、时序金字塔模块、C3D单元级别特征的消融研究

Fig. 6. Ablation study oftemporal context module, temporal pyramid module, and C3D unit-level feature

可以看出,时序上下文扩展模块为时序检测任务提供了额外的语义信息,增强了候选区域的动作完整性。因此包含时序上下文模块的网络w/ctx & w/o pyramid 比w/o ctx & w/o pyramid检测精度更高。没有针对内部候选区域实施金字塔结构化处理的w/o ctx & w/o pyramid识别精度不如运用金字塔结构化处理的frame reg w/both,说明时序金字塔结构化模块的引入可以更具针对性地对动作本身(内部候选区域)及其上下文信息(扩展候选区域)建模,提升了准确度。而运用C3D单元级别特征的unit reg w/both比只利用帧级信息的网络frame reg w/both 精度更高,说明挖掘了视频时域和空域信息的C3D单元级别特征可以提升时序区间定位的准确度。

4.4 效率分析

为验证两段式区域选举算法的高效性,保持4.1节参数设置不变,将两段式区域选举算法的3种变体(Proposal-16, Proposal-32,Proposal-w/o unit)与其他方法进行运行速度(FPS)和召回率(AR-AN of 1000)上的比较。其中Proposal-16和Proposal-32分别代表以一个单元为16 frame或32 frame提取的单元级C3D特征,Proposal-w/o unit代表不使用单元级特征,只用单帧特征进行时序定位。随机抽取Thumos 14验证集中的100个视频,并在一个单个的Nvidia TITAN X GPU上进行训练,运行结果如

表 2. ActivityNet v1.3数据集中,各方法时序定位坐标在不同tIoU下的mAP

Table 2. mAP of temporal localization coordinate of each method with different tIoU on ActivityNet v1.3 dataset %

|

可以看出:精度上Proposal-16、Proposal-32、Proposal-w/o unit依次降低;速度上,Proposal-32、Proposal-16、Proposal-w/o unit依次降低;Proposal-w/o unit在速度和精度上都是最低的。这说明C3D单元级别特征的引入从整体上提升了算法的效率和精度。此外,更长的单元级别特征速度更快(Proposal-32的速度高于Proposal-16),但同时降低了召回率的准确度(Proposal-32的召回率小于Proposal-16)。AR和FPS之间呈现一种此消彼长的关系,这是由于更短的单元级别特征会产生更多的特征向量,从而消耗更多的计算时间,但由于回归的基础坐标单位变小,更短的单元级别特征会提升时序坐标回归时的精确度。与其他时序动作选举方法相比,Proposal-16超越了DAPs、Sparse-prop和SST,达到了最优的召回率,并且速度比传统的DAPs方法提升了3倍。其中CDC同样利用动作边界进行微调,后续应用C3D,但速度慢于Proposal-32,这是因为相比于传统的手工特征或传统的单帧训练,单元级别特征的引入提升了训练效率。由

5 结论

针对长视频中时序动作发生时间的定位任务,提出一种两段式时序区域选举算法。第一段选举算法通过改进的分水岭浸水聚类产生多种不同长度的候选区域,实现动作时序边界的粗定位。进而提出一种时序金字塔结构化分析方法,引入时序上下文信息模块,对候选区域进行结构化建模,增强了动作片段的结构特征。第二段时序回归选举网络采用多任务损失函数,实现时序坐标回归器和动作/背景分类器的同时训练,过滤掉背景区域的同时得到了更加精确的时序边界。整个两段式区域选举网络以C3D提取的单元级视频特征进行训练,挖掘了视频时域和空域的丰富语义,提升了算法的精度和训练效率。多组实验结果表明,结合分水岭和回归网络的时序动作选举算法能够有效提高视频时序动作检测的准确度。

[1] OneataD, VerbeekJ, SchmidC. The LEAR submission at thumos 2014[M] ∥Fleet D, Pajdla T, Schiele B, et al. European conference on computer vision-ECCV 2014. Lecture notes in computer science Cham, 2014, 8692: 1- 7.

[2] 李艳荻, 徐熙平. 基于空-时域特征决策级融合的人体行为识别算法[J]. 光学学报, 2018, 38(8): 0810001.

[3] 李庆辉, 李艾华, 王涛, 等. 结合有序光流图和双流卷积网络的行为识别[J]. 光学学报, 2018, 38(6): 0615002.

[4] TranD, BourdevL, FergusR, et al. Learning spatiotemporal features with 3D convolutional networks[C]∥2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 4489- 4497.

[5] GorbanA, IdreesH, Jiang YG, et al. THUMOS challenge: action recognition with a large number of classes[OL]. 2015[ 2019-05-25]. http:∥www.thumos.info/.

[6] 冯小雨, 梅卫, 胡大帅. 基于改进Faster R-CNN的空中目标检测[J]. 光学学报, 2018, 38(6): 0615004.

[7] 辛鹏, 许悦雷, 唐红, 等. 全卷积网络多层特征融合的飞机快速检测[J]. 光学学报, 2018, 38(3): 0315003.

[9] LazebnikS, SchmidC, PonceJ. Beyond bags of features:spatial pyramid matching for recognizing natural scene categories[C]∥2006 IEEE Computer Society Conference on Computer Vision and Pattern Recognition (CVPR'06), June 17-22, 2006, New York, NY, USA. New York: IEEE, 2006.

[10] ShouZ, WangD, Chang SF. Temporal action localization in untrimmed videos via multi-stage CNNs[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 1049- 1058.

[11] DonahueJ, Hendricks LA, GuadarramaS, et al. Long-term recurrent convolutional networks for visual recognition and description[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 7-12, 2015, Boston, MA, USA. New York: IEEE, 2015: 2625- 2634.

[12] Wang LM, QiaoY, Tang XO, et al. Actionness estimation using hybrid fully convolutional networks[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 2708- 2717.

[13] Wang LM, Xiong YJ, WangZ, et al. Temporal segment networks: towards good practices for deep action recognition[M] ∥Leibe B, Matas J, Sebe N, et al. European conference on computer vision-ECCV 2016. lecture notes in computer science. Cham: Springer, 2016, 9912: 20- 36.

[14] EscorciaV, Caba HeilbronF, Niebles JC, et al. DAPs: deep action proposals for action understanding[M] ∥Leibe B, Matas J, Sebe N, et al. European conference on computer vision-ECCV 2016. lecture notes in computer science. Cham: Springer, 2016, 9907: 768- 784.

[15] Heilbron FC, Niebles JC, GhanemB. Fast temporal activity proposals for efficient detection of human actions in untrimmed videos[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 1914- 1923.

[16] BuchS, EscorciaV, Shen CQ, et al. SST: single-stream temporal action proposals[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 6373- 6382.

[17] Lin TW, ZhaoX, Su HS, et al. BSN: boundary sensitive network for temporal action proposal generation[M] ∥Ferrari V, Hebert M, Sminchisescu C, et al. European conference on computer vision-ECCV 2018. lecture notes in computer science. Cham: Springer, 2018, 11208: 3- 21.

[18] ShouZ, ChanJ, ZareianA, et al. CDC: convolutional-de-convolutional networks for precise temporal action localization in untrimmed videos[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 1417- 1426.

[19] Dai XY, SinghB, Zhang GY, et al. Temporal context network for activity localization in videos[C]∥2017 IEEE International Conference on Computer Vision (ICCV), October 22-29, 2017, Venice, Italy. New York: IEEE, 2017: 5727- 5736.

[20] Heilbron FC, BarriosW, EscorciaV, et al. SCC: semantic context cascade for efficient action detection[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 3175- 3184.

Article Outline

黄韵文, 王斐, 李景宏, 王国锐. 结合分水岭和回归网络的视频时序动作选举算法[J]. 中国激光, 2019, 46(11): 1109001. Yunwen Huang, Fei Wang, Jinghong Li, Guorui Wang. Algorithm for Video Temporal Action Proposal Combining Watershed and Regression Networks[J]. Chinese Journal of Lasers, 2019, 46(11): 1109001.