用于空中红外目标检测的增强单发多框检测器方法  下载: 1188次

下载: 1188次

1 引言

目标检测一直是计算机视觉领域的研究重点和热点[1-2],在无人驾驶、安防监控、机器人视觉、防空光电跟踪等领域具有不可替代的作用。在红外光电跟踪系统中,空域背景变化多样,并且空中目标占有的像素数较少、特征结构稀疏;另外,高机动性的飞行器难以捕捉定位,成像容易出现模糊失真的现象,加大了算法识别的难度。因此,有效的空中目标检测算法成为了提高跟踪精度和实时性的关键技术。

目标检测要求同时获得目标的类别信息和定位信息。传统的模式识别方法大多依赖先验特性来建立数学模型并完成求解匹配,如帧差法[3]、光流法[4]、Hough变换法[5]等;另一种主流的方法采用特征算子[如SIFT(Scale-Invariant Feature Transform)[6]、方向梯度直方图[7]]加分类器(如支持向量机[8]、AdaBoost[9])的模式,对数据量要求较少,在某些项目中能获得不错的效果。随着深度网络在计算机视觉领域获得突破,卷积神经网络(CNN)被用于提取更高层、表达能力更强的特征,并形成两种主流的深度网络检测框架:一类是结合区域提名和CNN的基于分类的R-CNN(Regions with CNN features)系列目标检测框架;另一类是将目标检测算法转换为回归问题的单步算法。

Faster R-CNN采用RPN (Region Proposal Networks)结构,能够在一个网络框架内完成候选区域、特征提取、分类和定位修正等操作,真正实现了端到端的网络计算,检测精度达到73.2%mAP(mean average precision)/5 frames·s-1(以下若无特殊说明,数据集均指VOC2007)[10];YOLOv3(You Only Look Once)将图片划分成多个网格,在每个网格上一次性完成目标bounding box、置信度以及类别概率的预测,牺牲了精度但换取了检测速度的大幅度提升,最新版本引入多尺度特征融合的方式,对小目标检测效果提升明显,检测精度达到了57.9%mAP/20 frames·s-1(COCO数据集),基本代表了业界的最高水平[11];单发多框检测器(SSD)结合了以上两者的优势,可以实现高准确率和实时检测[12],在300 pixel×300 pixel分辨率时,准确率为74.3%mAP/59 frames·s-1,在512 pixel×512 pixel分辨率时,SSD获得了80%mAP/19 frames·s-1的结果,超过了Faster R-CNN,但仍存在小目标容易漏检、多个边界框重复检出的问题,针对此类问题,主要从改进网络结构和多尺度特征融合两个方向进行改善。全卷积网络的应用开创了语义分割的先河[13],与之后的Mask-RCNN[14]都可以实现目标像素级别的分类,对于小目标能做出更精细的位置划分;另一方面,文献[ 15-16]借鉴了FPN(Feature Pyramid Networks)的思想,提出的FSSD(Feature fusion Single Shot multibox Detector)模型可以连接不同尺度的特征图,重构出一组特征金字塔,在小物体上获得了比原始SSD更高的检测精度;文献[ 17]中的DSSD(Deconvolutional Single Shot Detector)模型将基础网络从VGG换成了表征能力更强的ResNet,并引入反卷积层作为编解码器传递上下文信息,在小物体检测上实现了优异的效果,但是模型复杂度的增加削弱了实时性能;文献[ 18]提出改进的R-SSD模型,将特征图采用简单的连接和转置卷积两种方式进行融合,充分利用了特征图的方向信息,改进了小目标的检测能力;文献[ 19]以经典SSD模型为基础,从开辟多视窗结构出发,通过融合5个预设视窗的输出结果,在相应的小目标数据集上获得了一定的性能提升。

红外探测器的工艺水平限制了响应率和分辨率,与可见光图像相比,一定距离外的红外目标图像不具备丰富的纹理细节、边界比较模糊,只能利用热辐射几何分布和拓扑关系、飞行姿态与辐亮度的关联等浅层特征。本文基于SSD深度网络框架,针对空中大视场背景下,红外目标有效像素数少、特征稀疏,伴随云朵遮挡、大幅度的姿态变化等不利因素,提出了双向的特征图融合方法,增强了各尺度上特征图的表达能力;同时,引入语义分割支路,通过增强更浅层特征层的语义,获得更多的预测框。实验结果表明,在VOC2007的小目标数据集和空中红外数据集中,mAP分别增加了7.1%和8.7%。

2 SSD检测框架

SSD是一种能够直接预测目标类别和位置的多目标检测方法[12]。不同于Faster R-CNN等采用两阶段实现的深度检测框架,它采用了回归的思想来解决多目标的检测问题,大大地简化了网络结构和训练难度,提高了算法的实时性能;引入的anchors机制有利于提取多尺度、多比例的特征,相对于YOLO等全局特征提取的方法,获得了更高的定位精度。

2.1 SSD模型结构

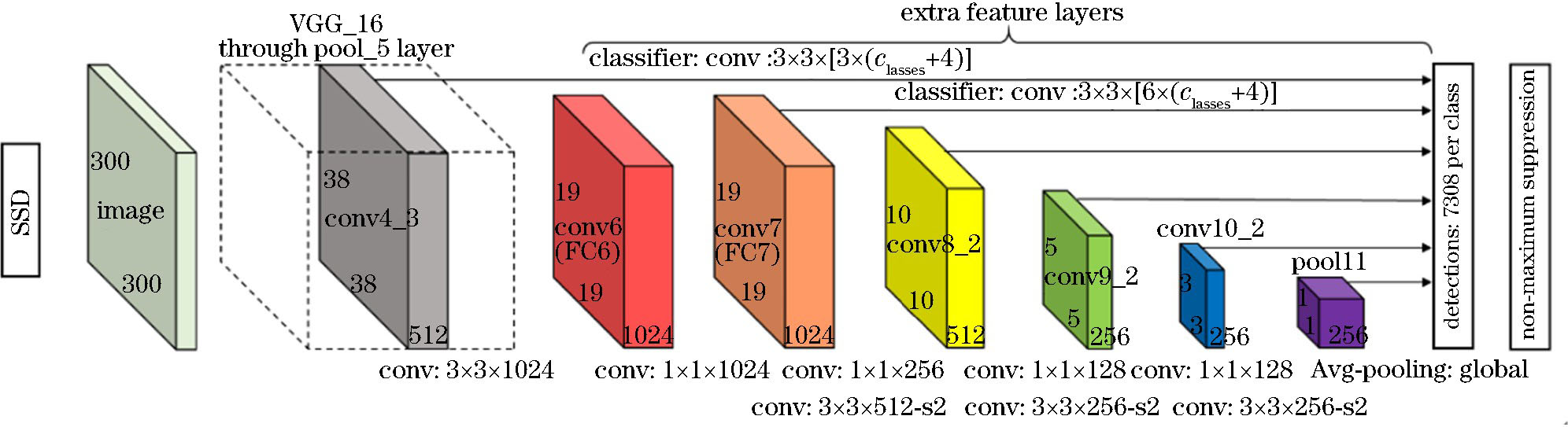

SSD的检测模型主要由两部分组成:1)用于提取多层图像特征的深度CNN,位于整个结构的前端,可采用去除分类层后的图像分类网络,如VGG_16[20]、ResNet-101[21]等,其中原先骨干网络中的全连接层(FC6、FC7)替换为相应的卷积层(conv),卷积核尺寸和输出通道数详见

2.2 特征层映射和损失函数

在SSD的基础网络结构之后,通过增加额外的卷积层,能够产生信息更全面的多尺度特征图,然后在各个特征图上分别进行目标预测。假设检测模型采用了

式中:

另外,SSD引入了Faster R-CNN的anchors机制,在同一特征层上的默认框采用多个长宽比,能够增强默认框对不同形状物体的稳健性。通常采用5种高宽比:

设定默认框的中心坐标为

SSD在训练时对边界位置和目标种类同时进行回归,其损失函数

式中:

2.3 经典SSD在目标检测中的不足

SSD对不同的特征图取不同尺寸的先验框,通过回归得出目标类别的置信度和先验框与ground truth间的偏差。SSD选取IOU(Intersection Over Union)大于0.5的先验框作为正样本,小于0.5的先验框作为负样本,由于大尺寸物体覆盖IOU大于0.5的先验框多,此时正负样本数目均衡;而小尺度目标的正样本数较少,导致正负样本失衡难以训练。采用Focal Loss可以有效地解决上述问题[22]。

随着CNN层数的增加,特征图的维度越来越小,特征越来越抽象,语义特征越来越明显,而位置信息越来越模糊[23]。假设采用SSD_300×300的模型,即处理的图像分辨率为300 pixel×300 pixel,其特征层为conv4_3、conv7、conv8_2、conv9_2、conv10_2、conv11_2。小目标的检测,主要依赖于conv4_3的浅层特征,它具备38 pixel×38 pixel的高分辨率,包含的先验框尺寸也与目标尺寸较接近,但其特征表达能力仅来源于前10层的卷积层,不能捕捉深层次的语义信息;另一方面,随着卷积层数的增加,输入图像的感受野也迅速上升,卷积层感受野的计算公式如下:

式中:

通过计算,得到各卷积层的感受野大小及各特征层默认框映射的图像区域如

表 1. SSD_300×300卷积感受野、默认框映射图像区域

Table 1. Convolution receptive field and mapping image region of default boxes of SSD_300×300

|

3 增强的SSD模型

为了提升SSD对小目标的检测能力,应尽量使用较高分辨率的特征图,并进一步挖掘浅层特征的表达能力,同时将浅层的细节特征和高层的语义特征结合起来,有利于为小目标提供精确的定位信息和目标类别信息。本文提出一种基于语义分割的浅层特征增强方法,以及双向的特征层融合机制,用于改进原始SSD的检测性能。

3.1 特征层双向融合

原始SSD在多层特征图上进行目标预测,虽然能够起到类似于图像金字塔的作用,但每次只利用了一层的特征图,浅层特征缺乏类别识别的语义信息,而深层特征随着感受野的增大,分辨率降低,不利于精确定位。为此,在SSD的主干网络的基础上,加入特征融合以提升检测性能。

在不同特征层合并的过程中,需要保持分辨率的一致。池化层结构简单,高分辨率特征层通过池化后,便获得降采样的特征;转置卷积与上采样的作用相同,但卷积核参数可在训练过程中调整,使上采样参数更加合理,对低分辨率特征进行转置卷积后,完成上采样。将统一分辨率的多层特征按通道连接,便获得融合后的多尺度特征图。

3.2 浅层特征增强分支

为了进一步提升SSD模型预测小目标的效果,将75 pixel×75 pixel高分辨率特征图添加进检测层,由于其拥有较少的语义信息,本文模型加入语义分割支路,用以增强浅层特征图的语义信息。分支结构如

具体地,模块的输入

图 2. 多种特征融合方法示意图。(a)池化;(b)转置卷积;(c)双向融合

Fig. 2. Schematics of multiple feature fusion methods. (a) Pooling; (b) transposed deconvolution; (c) bi-direction fusion

采用联合训练的策略,在目标检测损失函数

式中:

式中:

4 实验与分析

在实际的物体检测中,分类性能体现在预测框的置信度高低上,定位的准确性由预测框的坐标偏差衡量[25]。本文提出的改进模型,着重于改善小目标的检测,为验证本文算法的有效性,将其与原始SSD方法在具有代表性的小目标数据集上的mAP进行对比,并将置信度阈值统一设为0.5。所采用的实验平台操作系统为Ubuntu 16.04LTS,深度学习软件框架为TensorFlow-GPU,CUDA-9.0,Cudnn-7.3.1,主要硬件配置如下:NVIDIA GTX1080Ti×2 GPU, Intel i7-8700k CPU,DDR4 32G Memory。

4.1 PASCAL-VOC2007小目标数据集测试结果

为了对比本文提出的增强SSD与原始SSD模型的性能,挑选了VOC2007数据集中137张具有代表性的小目标图片,涉及的物体类别有8种,包括飞机(aero plane)、鸟(bird)、船(boat)、瓶子(bottle)、小汽车(car)、狗(dog)、羊(sheep)、人,经过相应处理之后,标注物体的ground truth共计1164个。分别采用原始SSD算法和本文方法进行目标检测实验,部分场景下的检测结果如

从

图 4. 原始SSD与改进SSD检测小目标的结果对比。(a)原始SSD; (b)改进模型

Fig. 4. Comparison of detection results of small targets obtained by original SSD and improved SSD. (a) Original SSD; (b) improved model

表 2. VOC2007数据集小目标检测结果

Table 2. Small object detection results of VOC2007 dataset

| ||||||||||||||||||||||||||||||||||||||

4.2 空中红外目标数据集测试结果

在空中红外目标识别中,特别是地基红外光电跟踪系统中,目标往往只占据少量的有效像素,另外云朵遮挡、大幅度的姿态变化等因素,也增加了目标跟踪识别的难度。自建的空中红外目标数据集筛选自外场实验视频流,分辨率为320 pixel×256 pixel和640 pixel×512 pixel的图像,包含了J型战斗机(fighter_J)、直升机(helicopter)、S型战斗机(fighter_S)、民航客机(airliner)、飞鸟(bird)共5类目标,并以海天线、城市天际线、云朵背景为主。各类目标数量均衡,约为550张图,全部采用多目标标记,随机选取总数的30%作为测试集,剩余的又划分为训练集和验证集。

采用VGG_16基础网络的卷积层参数,并在红外数据集上进行微调,部分场景检测结果如

表 3. 红外数据集空中目标检测结果

Table 3. Aerial target detection results of infrared dataset

| |||||||||||||||||||||||||||||||||

为了进一步验证本文模型的有效性,利用召回率-准确率曲线对最终检测结果进行定量评价。准确率衡量被模型提取的目标中真实标记的比例,召回率反映了被正确提取的标记占总目标标记的比重[26]。

图 6. 空中红外目标召回率-准确率曲线对比

Fig. 6. Comparison of recall-precision curve of infrared aerial targets

4.3 增强SSD的实时性分析

浅层特征的语义增强分支将更高分辨率的特征层引入检测中,不仅在语义增强过程中增加了卷积运算量,还扩大了预测框的总数,必然会导致预测速度的降低。但是,相对于简单的加深基础网络中特征层通道的方法,浅层特征的语义增强分支具有更少的网络参数。

双向特征融合采用最大池化和转置卷积,将高低特征层归一化到相同尺寸,再通过串联获得良好的表征能力,并且没有带来太多的计算开销。通过拼接后的特征金字塔,每一层都有3072个通道(串联256,512,1024,512,256,256,256的通道),每个特征层具有相同通道数,为不同层之间共享分类网络权重提供了可能。进一步地,修改原始SSD模型中各分类网络中预测框数目,使得每个特征层统一,实现权重的共享。

对原始SSD和增强SSD方法的速度进行定量评估,为了测试的公平性,统一将batchsize设置为8,同时去除了批归一化层,以缩短预测时间和减少内存消耗。

表 4. 每个分类网络的预测框数目及运行速度对比

Table 4. Number of predictive boxes for each classi?ed network and speed comparison

| |||||||||||||||||||||||||||||||||||||

综上所述,增强后的SSD较原始SSD方法对小目标检测效果提升明显,在VOC2007的小目标数据集和空中红外数据集中,mAP分别增加了7.1%和8.7%,在检测速率上FPS达到了9.4 frames·s-1,验证了本文算法能够实现精度和实时性的平衡。分析其主要原因,在于引入语义增强后的conv3_3层用于检测,同时增加了预测框的数量,增强了小目标的检测能力;另外,双向特征融合机制较好地结合了语义信息与定位信息,从整体上提升了物体检测性能。

5 结论

首先阐述了经典SSD深度网络检测框架的结构和机理,并通过进一步分析卷积核感受野与默认特征框在输入图像上的映射关系,指出小目标检测能力不足的原因。在原始SSD模型基础上,引入浅层特征图语义增强分支,并提出了一种双向的特征融合机制,在VOC2007的小目标数据集和空中红外数据集上进行测试,得到的mAP分别提高了7.1%和8.7%,获得了较好的检测效果。未来的工作将围绕模型简化、参数压缩展开,以改善该模型的实时性能,并针对特定应用场景寻求更加合理的特征利用方式。

[1] ErhanD, SzegedyC, ToshevA, et al. Scalable object detection using deep neural networks[C]//2014 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2014, Columbus, OH, USA. New York: IEEE, 2014: 2155- 2162.

ErhanD, SzegedyC, ToshevA, et al. Scalable object detection using deep neural networks[C]//2014 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2014, Columbus, OH, USA. New York: IEEE, 2014: 2155- 2162.

[3] Singla N. Motion detection based on frame difference method[J]. International Journal of Information & Computation Technology, 2014, 4(15): 1559-1565.

Singla N. Motion detection based on frame difference method[J]. International Journal of Information & Computation Technology, 2014, 4(15): 1559-1565.

[4] Horn B K P, Schunck B G. Determining optical flow[J]. Artificial Intelligence, 1981, 17(1/2/3): 185-203.

Horn B K P, Schunck B G. Determining optical flow[J]. Artificial Intelligence, 1981, 17(1/2/3): 185-203.

[7] DalalN, TriggsB. Histograms of oriented gradients for human detection[C]//2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition (CVPR'05), June 20-25, 2005, San Diego, CA, USA. New York: IEEE, 2005: 886- 893.

DalalN, TriggsB. Histograms of oriented gradients for human detection[C]//2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition (CVPR'05), June 20-25, 2005, San Diego, CA, USA. New York: IEEE, 2005: 886- 893.

[9] Hastie T, Rosset S, Zhu J, et al. Multi-class AdaBoost[J]. Statistics and Its Interface, 2009, 2(3): 349-360.

Hastie T, Rosset S, Zhu J, et al. Multi-class AdaBoost[J]. Statistics and Its Interface, 2009, 2(3): 349-360.

[12] LiuW, AnguelovD, ErhanD, et al. SSD: single shot multibox dtector[M] //Leibe B, Matas J, Sebe N, et al. Computer Vision: ECCV 2016. Cham: Springer, 2016, 9905: 21- 37.

LiuW, AnguelovD, ErhanD, et al. SSD: single shot multibox dtector[M] //Leibe B, Matas J, Sebe N, et al. Computer Vision: ECCV 2016. Cham: Springer, 2016, 9905: 21- 37.

[14] He K M, Gkioxari G, Dollár P, et al. Mask R-CNN[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 2844175.

He K M, Gkioxari G, Dollár P, et al. Mask R-CNN[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 2844175.

[19] 唐聪, 凌永顺, 郑科栋, 等. 基于深度学习的多视窗SSD目标检测方法[J]. 红外与激光工程, 2018, 47(1): 126003.

唐聪, 凌永顺, 郑科栋, 等. 基于深度学习的多视窗SSD目标检测方法[J]. 红外与激光工程, 2018, 47(1): 126003.

[21] He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 770- 778.

He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 770- 778.

[23] 辛鹏, 许悦雷, 唐红, 等. 全卷积网络多层特征融合的飞机快速检测[J]. 光学学报, 2018, 38(3): 0315003.

辛鹏, 许悦雷, 唐红, 等. 全卷积网络多层特征融合的飞机快速检测[J]. 光学学报, 2018, 38(3): 0315003.

[24] Zhang ZS, Qiao SY, Xie CH, et al. Single-shot object detection with enriched semantics[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE, 2018: 5813- 5821.

Zhang ZS, Qiao SY, Xie CH, et al. Single-shot object detection with enriched semantics[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE, 2018: 5813- 5821.

[25] 冯小雨, 梅卫, 胡大帅. 基于改进Faster R-CNN的空中目标检测[J]. 光学学报, 2018, 38(6): 0615004.

冯小雨, 梅卫, 胡大帅. 基于改进Faster R-CNN的空中目标检测[J]. 光学学报, 2018, 38(6): 0615004.

[26] 王文秀, 傅雨田, 董峰, 等. 基于深度卷积神经网络的红外船只目标检测方法[J]. 光学学报, 2018, 38(7): 0712006.

王文秀, 傅雨田, 董峰, 等. 基于深度卷积神经网络的红外船只目标检测方法[J]. 光学学报, 2018, 38(7): 0712006.

Article Outline

谢江荣, 李范鸣, 卫红, 李冰, 邵保泰. 用于空中红外目标检测的增强单发多框检测器方法[J]. 光学学报, 2019, 39(6): 0615001. Jiangrong Xie, Fanming Li, Hong Wei, Bing Li, Baotai Shao. Enhancement of Single Shot Multibox Detector for Aerial Infrared Target Detection[J]. Acta Optica Sinica, 2019, 39(6): 0615001.