基于深度学习行人属性自适应权重分配行人再识别方法  下载: 1086次

下载: 1086次

1 引言

行人再识别是利用计算机视觉技术从不同摄像头下拍摄的视频候选图像集中搜索指定行人,以弥补目前固定摄像头位置单一与方向限制的技术,被广泛用于智能视频监控、智能安保、智能商业等领域。由于不同摄像设备之间的差异,且行人形态为非刚体,外观易受穿着、尺度、遮挡、姿态和视角等的影响,存在较大的形变,使得行人再识别技术成为一个既具有研究价值又极具挑战性的热门研究方向。

行人再识别通常构建稳健的特征表示或距离度量学习。用于行人再识别的特征主要包括:颜色梯度直方图特征[1-3]、局部二值模式(LBP)特征[4]和Gabor特征[5]等。Gray等[6]使用Adaboost选择颜色和纹理特征之间的最佳特征;Ma等[7]使用基于颜色和梯度信息的局部描述符,并使用高维的傅里叶变换器进行特征编码。特征表示方法较直观简单,在小数据集上,行人再识别的识别率达到了良好的效果;但是对于存在较大形变的行人,例如在姿态、视角变化较大的情况下,特征表示的方法效果较差。距离度量学习方法通过学习两个行人图片的相似度,使同一行人的相似度尽可能高,不同行人图片相似度尽可能低。文献[ 8]提出利用极大似然法判断两个行人的相似度;文献[ 9-10]利用局部与边际Fisher判别分析方法;文献[ 11]利用交叉视角二次判别分析两个行人的相似度。但是进行距离度量的学习方法计算开销较大,整体识别效果依旧欠佳。在现实场景中,即使同一个人的外表也容易受到许多因素的影响,他/她的高级语义概念在不同的摄像机下仍然可以保持相对稳定和一致,这些语义概念也称为属性,对于出现在不同相机中的人来说,他/她的属性比低级特征更稳定和一致。例如,如果朝相机行走的人具有短发属性,则即使该行人转身背向相机,也仍然可以检测到该短发属性。因此基于行人属性的行人再识别方法近年来也成为了热门研究方向。

在Vaquero等[12]的开创性工作中,将行人属性用于行人再识别,其采用人工分割区域,进行属性识别,这种方法的性能相当有限,因为它取决于行人分割的准确性,并且在现实中无法保证行人的正面图像。Layne等[13]定义了15个与服装、发型、携带物品和性别相关的二元属性。从每个图像中提取了一个2784维底层颜色和纹理特征向量,并且训练每个属性的支持向量机(SVM)分类器进行行人属性分类。Zhu等[14-15]提出提取下半身和上半身区域的色调、饱和度、明度(HSV)直方图、多尺度块局部二值模式(MB-LBP)和方向梯度直方图(HOG)特征,利用Adaboost进行特征选择和加权K最近邻(k-NN)分类算法进行分类。然而对于这些方法,行人属性是完全独立的,即没有将它们的相互关系考虑在内。

随着深度学习在计算机视觉领域的成功应用,对于行人属性的分类,近年来已经提出了很多利用深度多任务学习网络进行分类的方法。通常是构建一个多任务网络,该网络在除了预测每个单独任务的最后一层之外的所有层中共享模型参数。虽然很简单,但是当两个任务不同时,强制共享参数可能会损害学习的表现而产生负转移的问题。解决这个问题的一个常见做法是增加顶层的数量,这些顶层可以专门学习每个单独的任务[16-19]。因为网络可以强制底层共享低层特征[20],并在顶层学习特定任务子网络。然而,配置多任务深度学习网络的权重参数组合空间很大,并且如文献[ 21]中所指出,通常设计的网络会受到设计者对不同任务之间关系的主观偏见。现有的多任务学习方法是保持每个学习任务的权重相同,而不是动态和自适应地调整学习参数。学习行人属性的不同任务具有不同的学习困难以及不同的收敛率。例如,学习识别“背包”属性比估计“年龄”属性容易得多。且基于行人属性的行人再识别,对于不同的行人属性有不同的行人再识别贡献率,例如,待识别行人的性别与该行人的鞋子类型对此行人身份的识别贡献率不同。

基于以上考虑,提出了具有自适应权重配置的行人再识别方法(AW-MTL-PID),旨在研究一种共享机制。该机制可以动态地、自适应地调整学习不同属性任务的关系,将加权损失层定义为模拟学习不同行人属性任务的关系,将不同任务的验证损失所反映的行人属性学习困难度,以及属性对于行人再识别的贡献率自适应地反馈给训练损失进行加权,并根据所识别的行人属性与行人类别之间的对应关系进行概率求解,判断出行人身份。

本文主要特色与贡献体现在如下方面:1) 度量基于训练时历史验证损失所反映的行人属性训练难度,度量行人属性与行人类别对应关系信息熵对行人再识别贡献率,结合两个度量指标,利用实验结果,设置合适的训练难度与行人识别贡献率尺度因子,自适应求解行人属性多任务分类的训练损失权重,以解决多任务分类时分配相同的损失权重造成的负转移问题,提高每个任务学习器的泛化能力以及对行人类别判别的泛化能力;2) 基于已有数据集中行人属性与行人类别的映射关系计算行人类别在某属性下的条件概率,结合已训练好的模型求解样本与属性的后验概率,计算行人类别与样本的后验概率分布,用最大值法判断样本的行人类别。通过与现有方法在多个公开数据集上的客观对比实验表明所提方法的有效性与可行性。

2 多任务学习数学模型构建

为了有效地学习预测行人属性,数据集数学建模为

当只训练第

式中:

当同时学习预测多个行人属性时,即为多任务学习的过程,训练目的是获得最小化多属性目标函数的参数集:

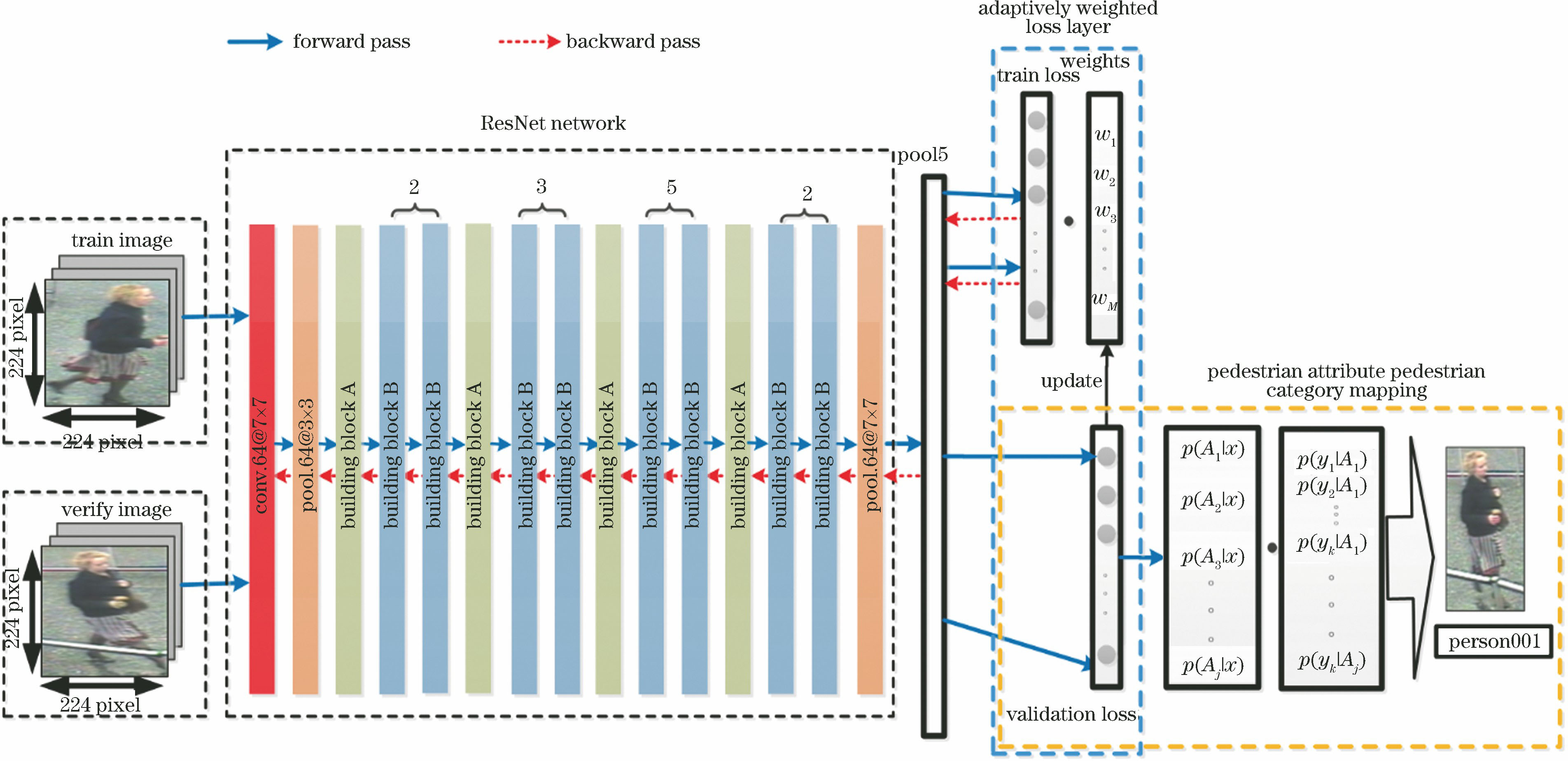

3 深度学习自适应权重分配网络模型

如

图 1. 深度学习自适应权重分配行人再识别网络框架结构

Fig. 1. Pedestrian re-identification network framework with deep learning adaptive weight distribution

3.1 ResNet基础网络

对于多层网络,层数越深网络提取的特征越抽象,越具有语义信息。但简单地加深网络的深度,在网络的训练过程中会引起梯度弥散或梯度爆炸等问题,导致整个网络在训练过程中无法收敛。不同于普通卷积神经网络,ResNet[22]网络学习残差函数实现了恒等映射,解决了深层网络退化和训练中无法收敛的问题,且不增加额外的网络参数和计算复杂度。在文献[

23]中,ResNet网络显示出具有竞争力的行人再识别性能。因此本文使用ResNet-50作为基础网络。此基础网络具有50层残差网络,主要由卷积层、池化层和残差块组成。残差块是整个网络的核心部分,其基本思想是在一个浅层网络基础上叠加一个恒等映射,使得输入信息可以直接传输到输出,避免信息的丢失,从而使得网络不退化而且性能更好。具体结构如

3.2 权重更新网络

(3)式表示针对不同行人属性的学习共享网络参数,且以相同的权重进行损失函数的反馈,以相同的收敛率进行学习。针对学习任务的重要程度,提出了两个度量策略来进行自适应权重加权,在训练阶段,首先利用验证损失,计算出每个行人属性学习难易程度度量;然后利用数据集中先验知识以及信息熵,求解出每个属性对行人分类的贡献率,对两个指标进行加权融合后反馈给训练损失进行加权,作为每个属性的损失函数的权重进行反馈学习。因此,所涉及的最优化目标函数表示为

式中:<·>表示內积;

对于网络权重的更新,主要目的是在更新周期内自适应调整训练损失权重,计算一组维数与行人属性个数相同的权重向量,权重更新具体流程为:1) 假设当前训练迭代

3.2.1 属性学习难易度度量

对一个已经训练了多个任务的学习模型,较难学习的任务应该被设置为更高的权重。对于属性难易程度度量,从历史验证损失集中进行学习和计算,作为训练难易程度的客观度量。每迭代通过迭代周期

Attribute learning difficulty measure//update_weithts(),

initialization:

if

end if

return

3.2.2 行人属性对行人再识别贡献率度量

特征重要性度量是分类任务中的一项重要任务。直接度量分类任务重要性的一种常见的做法是手动定义主要和辅助任务。如文献[ 24-25]中提出主要任务是重要任务,应始终优先考虑;而辅助任务的优先级较低,如果这些任务损害了主要任务学习者的表现,则应该停止这些任务。提出行人属性-行人再识别贡献率的概念,即利用某一行人属性进行行人再识别的任务重要程度度量,后面简称再识别贡献率;同时提出利用信息熵的理论进行再识别贡献率计算。

信息熵表示系统的混乱程度,系统越单调有序,信息熵越低;系统越无序,信息熵越高。某属性在不同类别中分布概率越无序,表示不是所有类别都含有或者都不含有此属性,此属性对类别的区分度越高,即此属性对类别的信息熵越高,此属性的分类贡献率越高,因此属性对分类的重要程度可以用属性在类别中的分布概率的信息熵来表示。通过已有的属性与类别对应关系计算出属性的信息熵,此属性信息熵越高,对应其分类能力越强。对于属性信息熵的计算,属性

式中:

3.2.3 学习任务重要性度量

最终权重的计算方法与属性学习困难度以及属性分类贡献率都有关,有必要将任务学习难易度

式中:

3.3 行人类别判断

通过ResNet基础网络得到样本中属性

得到行人类别对于给定样本的后验概率的概率分布,求取其中的概率最大值作为行人类别的判别类:

4 实验结果与讨论

4.1 数据集

在Market-1501[26]数据集与DukeMTMC-reID[26]数据集上进行了行人属性分类实验与行人再识别实验。Market-1501[26]包含1501个行人的32688张行人图片,标记了27个行人属性,其中年龄是多类属性,将其转换为4个二进制属性进行实验,即一共30个行人属性。DukeMTMC-reID[26]包含1812个行人的34183张图片,标记了23个属性。

4.2 参数设置

对于基础网络部分,使用开源深度学习网络框架Caffe[27]来实现加权多任务学习网络,训练过程中的批处理尺寸设置为20,学习率初始值设置为0.0001,随后每迭代1000次,学习率减小10%。(4)式中的损失函数利用平方差损失,使用随机梯度下降算法进行迭代寻优,将Dropout用于全连接层且比率设置为0.5。对于权重更新网络模块,权重更新周期

4.3 评价指标

对于属性识别任务,测试每个属性的分类准确率。将所有属性的平均识别率作为整体属性预测准确度。对于行人再识别任务,使用累积匹配特征曲线(CMC)中第一次能匹配出正确的标签的测试数目与总的测试样本数目之比rank-1和平均精度(mAP)作为评价指标,对于每个查询,其平均准确率由其准确率召回曲线计算得出。mAP是所有查询中平均准确率的平均值,CMC反映了检索精确度,而mAP反映了召回率。

4.4 实验结果与对比

在Market-1501[26]数据集上进行实验,对有权重网络与无权重网络进行训练,得到验证损失走势图如

图 2. 训练阶段有权重与无权重训练损失对比

Fig. 2. Comparison of weights and weightless training losses during training phase

![α变化时,Market-1501[26]的验证集上的行人再识别准确度](/richHtml/lop/2019/56/14/141003/img_3.jpg)

图 3. α变化时,Market-1501[26]的验证集上的行人再识别准确度

Fig. 3. Pedestrian re-identification accuracy on validation set of Market-1501 when scale factor parameter α changes

由

由

![Market-1501[26]数据集中不同行人属性的学习难易程度量](/richHtml/lop/2019/56/14/141003/img_4.jpg)

图 4. Market-1501[26]数据集中不同行人属性的学习难易程度量

Fig. 4. Learning difficulties of different pedestrian attributes in Market-1501[26] data set

由

![Market-1501[26]数据集中行人属性贡献率分布图](/richHtml/lop/2019/56/14/141003/img_5.jpg)

图 5. Market-1501[26]数据集中行人属性贡献率分布图

Fig. 5. Contribution rate distribution of pedestrian attributes in Market-1501[26] data set

为进一步验证本文方法的有效性,基于Intel core i7处理器、8 GB NVIDIA TITAN X GPU工作站,选择在Market-1501[26]、DukeMTMC-reID[26]公开测试数据集上,分别与同类基于行人属性学习的行人再识别方法比较,其中行人属性辅助行人再识别网络APR[26]训练耗时16 h、属性分组多任务学习方法MCM[28]训练耗时10 h及基于特征选择的行人属性识别方法TCPAR[29]训练耗时6 h。而本文方法训练耗时5 h,这表明本文方法在计算复杂度方面具有优越性,所得具体实验结果如

![基于Market1501[26]行人属性识别结果对比](/richHtml/lop/2019/56/14/141003/img_6.jpg)

图 6. 基于Market1501[26]行人属性识别结果对比

Fig. 6. Comparison of pedestrian attribute recognition results based on Market1501

![基于DukeMTMC-reID[26]行人属性识别结果对比](/richHtml/lop/2019/56/14/141003/img_7.jpg)

图 7. 基于DukeMTMC-reID[26]行人属性识别结果对比

Fig. 7. Comparison of pedestrian attribute recognition results based on DukeMTMC-reID[26]

为定量评价本文方法对行人属性识别的有效性,统计

表 1. 在不同数据集上行人属性识别准确率结果对比

Table 1. Comparison of pedestrian attribute recognition accuracy in different data sets%

| |||||||||||||||||||

为进一步验证本文方法对行人再识别的先进性与有效性,分别与同类方法APR[26]、MCM[28]、TCPAR[29]以及非基于行人属性的行人再识别方法DTL-PR[30]进行客观定量对比实验。所得实验结果如

表 2. 在不同数据集上行人再识别准确率结果

Table 2. Comparison of pedestrian attribute re-identification accuracy in different data sets%

| ||||||||||||||||||||||||||||||||||

与行人属性分类对比的方法相同,对于行人再识别结果加入非行人属性学习基于无监督学习网络方法DTL-PR [30]进行对比。由

5 结论

由于在多任务学习中不同任务的重要性存在差异,因此提出自适应配置不同任务学习权重的策略,以提高多任务学习网络的有效性,而对于不同任务的重要性,根据不同任务学习的难易程度与不同任务对行人再识别结果的贡献率进行度量。所提自适应权重方法解决了多任务分类时分配相同的损失权重造成的负转移问题,提高了每个任务学习器的泛化能力以及对行人类别判别的泛化能力。并且,利用已有数据集中行人属性与行人类别的映射关系,根据已训练好的模型求解样本属性后验概率,结合条件概率计算出最可能的行人类别,利用高层属性特征相对稳定的特性,在一定程度上解决了全局行人再识别网络中无法识别因视角变化而造成的行人外观剧烈变化的问题。后续研究将基于感兴趣区域行人属性分类进行行人再识别的研究。

[1] ZhaoR, Ouyang WL, Wang XG. Person re-identification by salience matching[C]∥2013 IEEE International Conference on Computer Vision, December 1-8, 2013, Sydney, NSW, Australia. New York: IEEE, 2013: 2528- 2535.

[2] 朱小波, 车进. 基于特征融合与子空间学习的行人重识别算法[J]. 激光与光电子学进展, 2019, 56(2): 021503.

[3] 黄新宇, 许娇龙, 郭纲, 等. 基于增强聚合通道特征的实时行人重识别[J]. 激光与光电子学进展, 2017, 54(9): 091001.

[4] Liu CX, Gong SG, Loy CC, et al. Person re-identification: What features are important?[M] ∥Fusiello A, Murino V, Cucchiara R. Computer Vision-ECCV 2012. Workshops and Demonstrations. Berlin, Heidelberg: Springer, 2012, 7583: 391- 401.

[5] LiW, Wang XG. Locally aligned feature transforms across views[C]∥2013 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2013, Portland, OR, USA. New York: IEEE, 2013: 3594- 3601.

[6] GrayD, TaoH. Viewpoint invariant pedestrian recognition with an ensemble of localized features[M] ∥Forsyth D, Torr P, Zisserman A. Lecture Notes in Computer Science. Berlin, Heidelberg: Springer, 2008, 5302: 262- 275.

[7] Ma BP, SuY, JurieF. Local descriptors encoded by fisher vectors for person re-identification[M] ∥Fusiello A, Murino V, Cucchiara R. Computer Vision-ECCV 2012. Workshops and Demonstrations. Berlin, Heidelberg: Springer, 2012, 7583: 413- 422.

[8] KöstingerM, HirzerM, WohlhartP, et al. Large scale metric learning from equivalence constraints[C]∥2012 IEEE Conference on Computer Vision and Pattern Recognition, June 16-21, 2012, Providence, RI, USA. New York: IEEE, 2012: 2288- 2295.

[9] PedagadiS, OrwellJ, VelastinS, et al. Local fisher discriminant analysis for pedestrian re-identification[C]∥2013 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2013, Portland, OR, USA. New York: IEEE, 2013: 3318- 3325.

[10] XiongF, Gou MR, CampsO, et al. Person re-identification using kernel-based metric learning methods[M] ∥Fleet D, Pajdla T, Schiele B, et al. Computer Vision-ECCV 2014. Cham: Springer, 2014, 8695: 1- 16.

[11] Liao SC, HuY, Zhu XY, et al. Person re-identification by local maximal occurrence representation and metric learning[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 7-12, 2015, Boston, MA, USA. New York: IEEE, 2015: 2197- 2206.

[12] Vaquero DA, Feris RS, TranD, et al. Attribute-based people search in surveillance environments[C]∥2009 Workshop on Applications of Computer Vision (WACV), December 7-8, 2009, Snowbird, UT, USA. New York: IEEE, 2009: 5403131.

[13] LayneR, Hospedales TM, GongS, et al. Attributes-based re-identification[M] ∥Gong S, Cristani M, Yan S, et al. Person re-identification. London: Springer, 2014: 93- 117.

[14] Zhu JQ, Liao SC, LeiZ, et al. Pedestrian attribute classification in surveillance: database and evaluation[C]∥2013 IEEE International Conference on Computer Vision Workshops, December 2-8, 2013, Sydney, NSW, Australia. New York: IEEE, 2013: 331- 338.

[15] Zhu JQ, Liao SC, YiD, et al. Multi-label CNN based pedestrian attribute learning for soft biometrics[C]∥2015 International Conference on Biometrics (ICB), May 19-22, 2015, Phuket, Thailand. New York: IEEE, 2015: 535- 540.

[16] Huang JS, FerisR, ChenQ, et al. Cross-domain image retrieval with a dual attribute-aware ranking network[C]∥2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 1062- 1070.

[17] JouB, Chang SF. Deep cross residual learning for multitask visual recognition[C]∥Proceedings of the 24th ACM International Conference on Multimedia, October 15-19, 2016, Amsterdam, The Netherlands. New York: ACM, 2016: 998- 1007.

[18] LeeG, YangE, Hwang SJ. Asymmetric multi-task learning based on task relatedness and loss[C]∥Proceedings of the 33rd International Conference on International Conference on Machine Learning, June 19-24, 2016, New York, USA. Massachusetts: JMLR. org, 2016, 48: 230- 238.

[19] Ranjan R, Patel V M, Chellappa R. HyperFace:a deep multi-task learning framework for face detection, landmark localization, pose estimation, and gender recognition[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2019, 41(1): 121-135.

[20] YosinskiJ, CluneJ, BengioY, et al. How transferable are features in deep neural networks?[J/OL]. ( 2014-11-06)[2018-12-15]. https:∥arxiv.org/abs/1411. 1792.

[21] Lu YX, KumarA, Zhai SF, et al. Fully-adaptive feature sharing in multi-task networks with applications in person attribute classification[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 1131- 1140.

[22] He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 770- 778.

[23] ZhengL, YangY, Hauptmann A G. Person re-identification: past, present and future[J/OL]. ( 2016-10-10)[2018-12-15]. https:∥arxiv.org/abs/1610. 02984.

[24] Zhang ZP, LuoP, Loy CC, et al. Facial landmark detection by deep multi-task learning[M] ∥Fleet D, Pajdla T, Schiele B, et al. Computer Vision-ECCV 2014. Cham: Springer, 2014, 8694: 94- 108.

[25] Zhang Z P, Luo P, Loy C C, et al. Learning deep representation for face alignment with auxiliary attributes[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2016, 38(5): 918-930.

[26] LinY, ZhengL, ZhengZ, et al. Improving person re-identification by attribute and identitylearning[J/OL]. ( 2017-04-16)[2018-12-15]. https:∥arxiv.org/abs/1703. 07220.

[27] JiaY, ShelhamerE, DonahueJ, et al. Caffe: convolutional architecture for fast feature embedding[J/OL]. ( 2014-06-20)[2018-12-16]. https:∥arxiv.org/abs/1408. 5093.

[28] Abdulnabi A H, Wang G, Lu J W, et al. Multi-task CNN model for attribute prediction[J]. IEEE Transactions on Multimedia, 2015, 17(11): 1949-1959.

[29] Chen YQ, DuffnerS, StoianA, et al. Triplet CNN and pedestrian attribute recognition for improved person Re-identification[C]∥2017 14th IEEE International Conference on Advanced Video and Signal Based Surveillance (AVSS), August 29-September 1, 2017, Lecce, Italy. New York: IEEE, 2017: 8078542.

[30] Chen HR, Wang YW, Shi YM, et al. Deep transfer learning for person Re-identification[C]∥2018 IEEE Fourth International Conference on Multimedia Big Data (BigMM), September 13-16, 2018, Xi'an, China. New York: IEEE, 2018: 8499067.

Article Outline

李净, 管业鹏. 基于深度学习行人属性自适应权重分配行人再识别方法[J]. 激光与光电子学进展, 2019, 56(14): 141003. Li Jing, Yepeng Guan. Pedestrian Re-Identification Based on Adaptive Weight Assignment using Deep Learning for Pedestrian Attributes[J]. Laser & Optoelectronics Progress, 2019, 56(14): 141003.