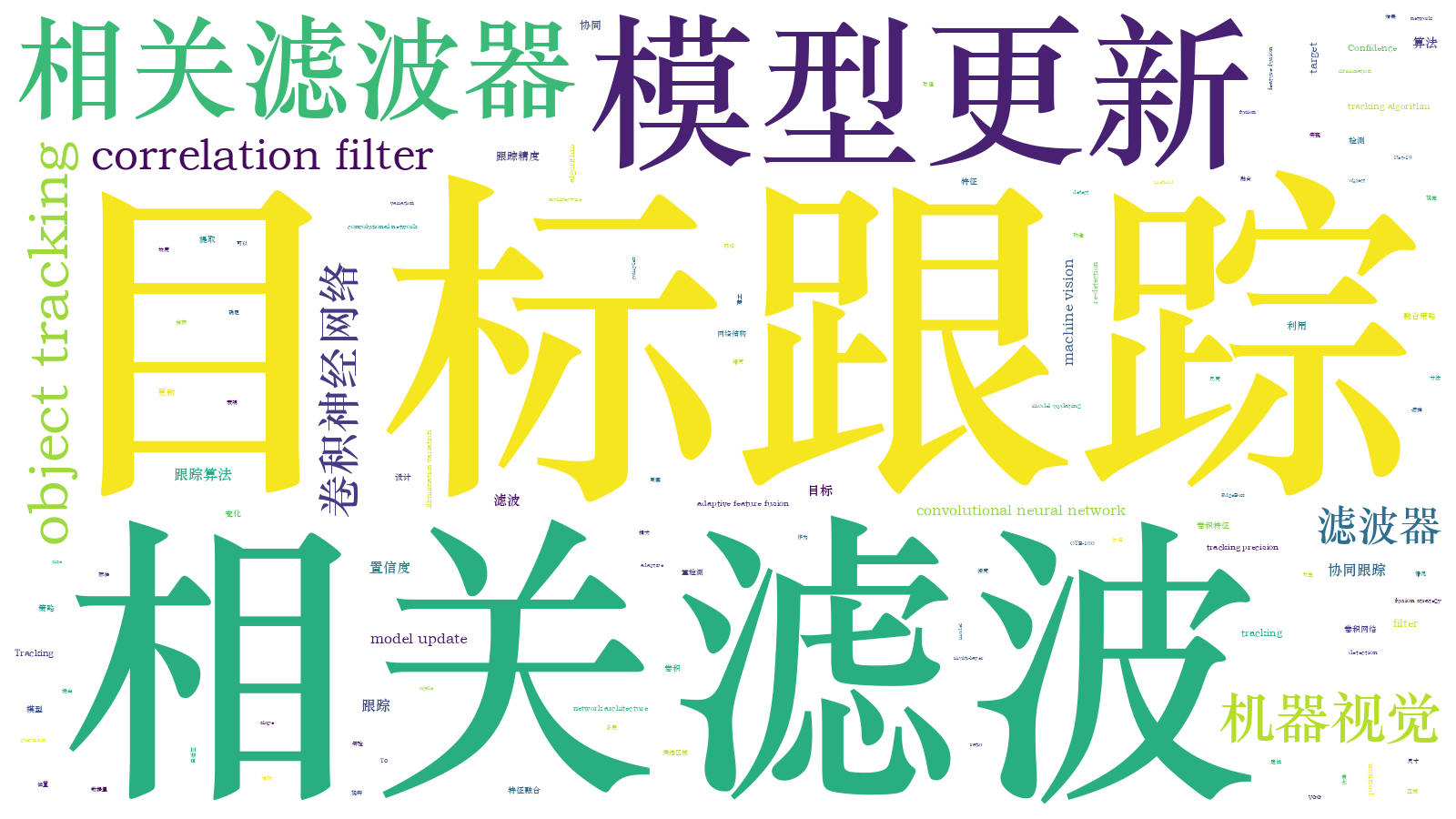

基于高置信度更新的多滤波器协同跟踪算法  下载: 835次

下载: 835次

1 引言

目标跟踪是计算机视觉领域的一个重要问题,在视频监控、人机交互、自动驾驶等领域都有广泛的应用[1]。视觉跟踪的典型场景是在第一帧中以包围框的形式给定任意一个目标的初始位置和尺寸,跟踪器需要在接下来的图像序列中预测出该物体的位置。尽管最近几十年跟踪领域取得了重大的突破,但受光照变化、遮挡、背景干扰等诸多影响,目标外观的变化性很大,因此视觉跟踪仍然是一个极具挑战性的问题。

近年来,基于相关滤波的跟踪器由于具有较好的准确度和实时性,吸引了相关学者的广泛关注。Bolme等[2]利用图像的灰度特征构建了一个最小输出平方误差和的跟踪器模型,开创了相关滤波在视觉目标跟踪领域的先河;Henriques等[3]对循环移位密集采样得到的图像块进行傅里叶变换,在频域内高效地训练滤波器,并使用方向梯度直方图(HOG)特征提升对目标的描述能力,极大地提高了跟踪器的准确性;Danelljan等[4]将颜色属性特征引入相关滤波框架,使得跟踪器能更好地适应彩色序列;Bertinetto等[5]在相关滤波框架下将HOG 特征和颜色统计特征进行融合互补,进一步提升了跟踪性能。为解决跟踪过程中目标的尺度变化,Li等[6]结合尺度金字塔与相关滤波,对不同尺度的图像块进行检测,以最大响应值对应的尺度作为当前最佳尺度;Danelljan等在文献[ 7]中提出一维尺度滤波器,并在文献[ 8]中通过减少尺度检测数以及对HOG特征进行降维,提高了跟踪速度。

上述跟踪算法都是采用传统的手工特征对目标进行描述,近些年,由卷积神经网络提取的深度特征在很多视觉任务上都取得了不错的表现,在视觉跟踪领域,基于深度特征的跟踪算法[9-13]也表现出了优秀的性能。Ma等[9]提出基于分层卷积特征的目标跟踪算法,利用3层卷积特征和由粗糙到细粒的搜索思想来确定目标位置;Qi等[12]在充分利用多层卷积特征的基础上,采用自适应对冲方法将多个弱跟踪器融合为一个强跟踪器,进一步提升了跟踪精度;Wang等[13]通过分析卷积网络不同层提取的特征,构建了特征筛选网络和两个互补的预测网络,有效抑制跟踪器的漂移。

模型更新也是跟踪器的一个重要组成部分。大多数现有的跟踪算法采用逐帧更新的方式,以适应目标的外观变化,但是当目标被干扰时,这种更新方式极易导致跟踪漂移。最近,一些学者从响应图的角度考虑模型更新问题,Ma等[14]利用响应图的最大峰值判别是否更新;Wang等[15]提出平均峰值相关能量,从响应图的波动程度确定更新策略。

尽管上述算法在跟踪领域已经做出了巨大的改进,但是它们大多针对某一个方面去完善,因此在整体的跟踪成功率和稳健性上仍然有待提高,尤其是在一些复杂场景下,如目标被严重遮挡甚至出视野时,这些算法都极易跟踪失败。为此,本文结合位置预测、尺度估计、模型更新,提出一种基于高置信度更新策略的多滤波器协同跟踪算法。在相关滤波框架下,设计一种多滤波器协同合作的方式以实现目标跟踪,提出一种跟踪置信度指标(主次峰坡度比)用以判断跟踪结果是否可靠,并依据该指标设计了高置信度下的更新策略,有效减缓了模型退化问题;利用本文算法在OTB-100[16]和TC-128[17]这2个大规模数据集上进行测试。通过详细的实验,来验证本文跟踪算法具有较高的跟踪精度与稳健性。

2 基于高置信度更新策略的多滤波器协同跟踪算法

设计3种相关滤波器协同完成跟踪任务,分别从位置计算、尺度估计、目标丢失后的重检测这3个角度考虑,构建不同的滤波器,相互合作。相比之前的跟踪算法,本文算法更加全面,能有效提升整体的跟踪成功率。同时,与传统的相关滤波类方法的模型更新策略相比,本文算法使用更可靠的高置信度更新策略,能减少误差积累,缓解模型退化问题。

2.1 基于深度滤波器的目标初定位

由于不同深度的卷积层对物体的表达能力不一致,为充分描述目标的外观,使用VGG-19深度卷积网络的Conv1-2, Conv2-2, Conv3-4, Conv4-4和Conv5-4这5层来提取目标特征,构建深度滤波器。给定跟踪目标的多通道卷积特征

式中,

式中,

式中,

式中,F-1是傅里叶逆变换,

采用的自适应融合策略由2部分组成。首先,因为深层特征可以从高级的语义层面描述目标,相比浅层特征更具备泛化性和稳健性,因此赋予深层特征图更大的固定权值,为

由于最大响应值在一定程度上可以反映跟踪置信度,同时观察到浅层特征响应图的最大响应值比深层的大,因此采用自适应的方式进行处理:

对(5)式和(6)式进行融合得到不同层相应的权重,可表示为

通过寻找融合特征响应图的最大值所在的位置来确定目标此时的中心位置:

2.2 基于高置信度的模型更新策略

相关滤波跟踪器通常采用逐帧更新模型的方式,以适应目标发生的一系列变化,实际上,这很容易产生模型退化问题。当某一帧已经跟踪不准确甚至漂移的时候,尤其是当目标已经被遮挡或发生出视野的情况时,如果仍然更新模型,跟踪器就会学习到遮挡物和杂乱背景这些不是目标本身的特征,误差逐渐累积,模型被逐渐污染,等到物体重新出现时,跟踪器最终无法识别出目标导致跟踪失败。

为解决模型退化问题,以跟踪结果响应图作为反馈,确定是否需要在当前帧更新模型。理想的响应图应当是只有一个尖锐的单峰且该峰值较大,其他部分都比较平滑,这意味着跟踪器完美地匹配上目标。而当响应图出现多峰,且波动程度较大时,跟踪器此时感受到的物体不一定是真实的目标,很大程度上已经发生了漂移,此时就应当停止模型的更新,防止跟踪器被污染。因此本文提出一种跟踪结果置信度指标,即主次峰坡度比

式中:

图 1. Box序列的跟踪结果与响应图。(a)~(c)第199、462、505帧图像;(d)~(f)第199、462、505帧图像的响应图

Fig. 1. Tracking results and response maps in Box sequence. (a)-(c) 199th, 462nd, and 505th frame images; (d)-(f) 199th, 462nd, and 505th frame response maps

利用

式中,

从

图 2. Box序列在2种更新策略下的中心位置误差

Fig. 2. Center location errors of two updating strategies in Box sequence

另外,对于大多数相关滤波类的由响应图决策跟踪结果的跟踪算法,主次峰坡度比这一置信度指标可以便捷地帮助跟踪器判断当前跟踪结果是否可靠,及时减少误差的积累。

2.3 目标重检测机制

当目标发生遮挡、出视野等情况时,虽然利用高置信度模型更新策略可以有效缓解模型退化问题,但是依然存在跟踪失败的情况,为进一步提升跟踪器的成功率,本文建立低置信度下的目标重检测机制。该机制由2部分组成:1)使用EdgeBox[18]在一定搜索范围内生成潜在的目标框;2)构建基于Hog特征的重检测滤波器,使用其对潜在的目标框进行评分,当满足一定条件时采用重检测的结果。

2.3.1 EdgeBox检测器

EdgeBox方法利用物体的边缘信息可以快速地提取出高质量的目标候选区域,与传统的滑动窗口扫描整幅图像相比,该方法可以消除大量冗余的窗口,筛选出较精确地包含目标的候选框。一些研究人员也将该方法应用在跟踪领域[19-21]。

2.3.2 重检测滤波器

在深度滤波器得到目标中心后,裁剪出与目标尺寸相同的区域并提取该区域的HOG特征,然后使用重检测滤波器计算该区域的响应,设定

式中,

2.4 尺度估计

在得到目标的中心位置后,对目标区域的图像块进行缩放,构建图像金字塔,完成多尺度采样。每个图像块的大小为

式中,

式中,

选择最大响应值对应的尺度因子,完成当前帧目标的尺度估计。同时,为提高算法速度,只有当初定位后得到的响应

2.5 算法流程

3 实验结果与分析

3.1 实验平台与参数设置

实验算法采用Matlab与C++混合编程,均在Windows 10操作系统下进行。处理器为Intel i7-8700,主频是3.20 GHz,内存是16 G,显卡是NVIDIA Geforce GTX 1070,显存是8 G。算法主要参数:模型更新率

3.2 实验数据与评估方式

为充分验证跟踪算法的精确性与稳健性,首先采用OTB-100标准数据集中全部100个序列进行测试,这100个序列包含快速运动、尺度变化、遮挡、出视野等11个跟踪领域常见的难点,因此能够对跟踪算法进行全面且客观的评价。

实验采用一次通过评估(OPE)的方式,即根据第一帧中对目标的标注位置进行初始化,然后在该序列中运行算法直至结束。实验采用距离精度和成功率曲线下的面积这2个指标来衡量跟踪算法的准确性。

1) 距离精度:中心位置误差小于20 pixel的帧数占视频总帧数的百分比。中心位置误差为算法跟踪的目标中心与实际目标中心的欧氏距离,可表示为

式中,(

2) 成功率: 跟踪算法预测的目标包围框与真实标注的包围框的交并比(IOU)大于0.5的帧数占视频总帧数的百分比。IOU的计算公式为

式中,

3.3 实验设计与分析

为充分验证所提算法的跟踪性能,将其与8种主流算法进行对比,具体包括核相关滤波跟踪器(KCF),多尺度跟踪器(DSST),多特征融合跟踪器(Staple),空间正则化相关滤波跟踪器[22](SRDCF),卷积神经网络-支持向量机跟踪器[23](CNN-SVM),分层卷积网络跟踪器(HCF),对冲多卷积特征跟踪器(HDT)和长短时记忆跟踪器[24](LCT2)。其中,KCF、 DSST、Staple、 SRDCF和LCT2是基于传统特征的相关滤波类方法,CNN-SVM、 HCF、 HDT是基于深度特征的相关滤波类方法。

3.3.1 定性分析

图 5. 9种跟踪算法在9组序列下的结果。(a) Lemming; (b) Human3;(c) Girl2;(d) DragonBaby;(e) MotorRolling;(f) Human7;(g) Skiing;(h) Shaking;(i) Tiger2

Fig. 5. Results of nine tracking algorithms for nine sequences. (a) Lemming; (b) Human3; (c) Girl2; (d) DragonBaby; (e) MotorRolling; (f) Human7; (g) Skiing; (h) Shaking; (i) Tiger2

表 1. 9组视频序列及其属性与帧数

Table 1. Attributes and frame numbers of 9 video sequences

|

从目标被遮挡、目标快速运动和光照变化这3个方面对本文算法与8种对比算法进行分析。

1) 目标被遮挡:以Lemming,Human3和Girl2这3个长时序列为例,

2) 目标快速运动:以DragonBaby,MotorRolling和Human7这3个序列为例,

3)光照变化:以Skiing,Shaking和Tiger2这3个序列为例,

3.3.2 定量分析

图 6. 9种算法在OTB-100序列上的总体跟踪性能。(a)距离精度曲线;(b)成功率曲线

Fig. 6. Overall performance of 9 tracking algorithms on OTB-100. (a) Distance precision curve; (b) success rate curve

3.3.3 算法结构分析

为说明本文算法的有效性,设计了组内对照实验。将本文算法拆分成3个部分:没有重检测滤波器同时采用逐帧更新的方式(Alg1),没有重检测滤波器但是采用高置信度更新的策略(Alg2),有重检测滤波器但采用逐帧更新的方式(Alg3)。用这3种跟踪方法与本文算法在100个序列上进行测试,

表 2. 9种算法在11种属性上的距离精度值

Table 2. Distance precision scores of nine algorithms in terms of 11 attributes

|

表 3. 9种算法在11种属性上的AUC值

Table 3. AUC scores of nine algorithms in terms of 11 attributes

|

图 7. OTB-100上的算法结构总体分析。(a)距离精度曲线;(b)成功率曲线

Fig. 7. Overall analysis of algorithm structure on OTB-100. (a) Distance precision curve; (b) success rate curve

3.3.4 置信度参数的设定

本文算法采用高置信度的模型更新策略,因此深度滤波器的更新阈值

图 8. 本文算法在OTB-100序列上不同的更新阈值参数下的结果。(a)距离精度曲线;(b)成功率曲线

Fig. 8. Overall performance of our algorithm under different updating parameters on OTB-100. (a) Distance precision curve; (b) success rate curve

3.3.5 算法时间分析

表 4. 9种跟踪算法的平均速度对比

Table 4. Comparison of average tracking speeds of 9 tracking algorithmsframe/s

|

3.3.6 TC-128数据集结果评估

为进一步验证本文算法的稳健性,将本文算法与其他算法在TC-128数据集上进行测试,评价标准与OTB-100一致。

图 9. 9种算法在TC-128序列上的总体跟踪性能。(a)距离精度曲线;(b)成功率曲线

Fig. 9. Overall performance of 9 tracking algorithms on TC-128. (a) Distance precision curve; (b) success rate curve

可以看出,本文算法在TC-128序列上仍然表现最优。另外,本文算法在OTB-100和TC-128这2个数据集上使用相同的参数,因此进一步验证本文算法具备较强的稳健性,在不同的环境下都能取得较好的结果。

4 结论

提出一种基于高置信度模型更新策略的多滤波器协同跟踪算法。算法构建3种相关滤波器协同完成跟踪任务。利用多层卷积特征构建深度滤波器,以自适应的特征融合策略进行目标初定位;为解决目标的尺度变化,设计尺度滤波器进行准确的尺度估计;提出一种跟踪置信度指标:主次峰坡度比,用以确定跟踪结果是否可靠,从而决策是否需要更新模型,缓解模型退化问题;设计重检测滤波器,当跟踪结果不可靠时,进行目标重定位。在标准数据集OTB-100和TC-128上进行详实的算法验证,实验结果表明本文算法具备较高的精度与稳健性,尤其是在目标被遮挡、出视野等长时跟踪场景中普遍存在的情况下,依旧可以稳定地跟踪。此外,虽然深度特征对于目标的描述能力与稳健性更强,但是基于深度特征的跟踪算法在速度方面比较慢,因此,未来的研究重点是在保持较高精度的同时提高跟踪器的实时性。

[2] Bolme[\s]{1}DS,[\s]{1}Beveridge[\s]{1}JR,[\s]{1}Draper[\s]{1}BA,[\s]{1}et[\s]{1}al.[\s]{1}Visual[\s]{1}object[\s]{1}tracking[\s]{1}using[\s]{1}adaptive[\s]{1}correlation[\s]{1}filters[C]∥2010[\s]{1}IEEE[\s]{1}Computer[\s]{1}Society[\s]{1}Conference[\s]{1}on[\s]{1}Computer[\s]{1}Vision[\s]{1}and[\s]{1}Pattern[\s]{1}Recognition,[\s]{1}June[\s]{1}13-18,[\s]{1}2010,[\s]{1}San[\s]{1}Francisco,[\s]{1}CA,USA.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2010:[\s]{1}2544-[\s]{1}2550.[\s]{1}

[3] Henriques J F, Caseiro R, Martins P, et al. High-speed tracking with kernelized correlation filters[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(3): 583-596.

[4] DanelljanM,[\s]{1}Khan[\s]{1}FS,[\s]{1}FelsbergM,[\s]{1}et[\s]{1}al.[\s]{1}Adaptive[\s]{1}color[\s]{1}attributes[\s]{1}for[\s]{1}real-time[\s]{1}visual[\s]{1}tracking[C]∥2014[\s]{1}IEEE[\s]{1}Conference[\s]{1}on[\s]{1}Computer[\s]{1}Vision[\s]{1}and[\s]{1}Pattern[\s]{1}Recognition(CVPR),[\s]{1}June[\s]{1}23-28,[\s]{1}2014,[\s]{1}Columbus,OH,[\s]{1}USA.New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2014:[\s]{1}1090-[\s]{1}1097.[\s]{1}

[5] BertinettoL,[\s]{1}ValmadreJ,[\s]{1}GolodetzS,[\s]{1}et[\s]{1}al.[\s]{1}Staple:[\s]{1}complementary[\s]{1}learners[\s]{1}for[\s]{1}real-time[\s]{1}tracking[C]∥2016[\s]{1}IEEE[\s]{1}Conference[\s]{1}on[\s]{1}Computer[\s]{1}Vision[\s]{1}and[\s]{1}Pattern[\s]{1}Recognition[\s]{1}(CVPR),[\s]{1}June[\s]{1}27-30,[\s]{1}2016,[\s]{1}Las[\s]{1}Vegas,[\s]{1}NV,[\s]{1}USA.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2016:[\s]{1}1401-[\s]{1}1409.[\s]{1}

[6] LiY,[\s]{1}Zhu[\s]{1}JK.[\s]{1}A[\s]{1}scale[\s]{1}adaptive[\s]{1}kernel[\s]{1}correlation[\s]{1}filter[\s]{1}tracker[\s]{1}with[\s]{1}feature[\s]{1}integration[M][\s]{1}∥[\s]{1}Agapito[\s]{1}L,[\s]{1}Bronstein[\s]{1}M[\s]{1}M,[\s]{1}Rother[\s]{1}C.[\s]{1}Computer[\s]{1}vision-ECCV[\s]{1}2014.[\s]{1}Lecture[\s]{1}notes[\s]{1}in[\s]{1}computer[\s]{1}science.[\s]{1}Cham:[\s]{1}Springer,[\s]{1}2015,[\s]{1}8926:[\s]{1}254-[\s]{1}265.[\s]{1}

[7] DanelljanM,[\s]{1}HägerG,[\s]{1}Khan[\s]{1}FS,[\s]{1}et[\s]{1}al.Accurate[\s]{1}scale[\s]{1}estimation[\s]{1}for[\s]{1}robust[\s]{1}visual[\s]{1}tracking[C]∥British[\s]{1}Machine[\s]{1}Vision[\s]{1}Conference[\s]{1}2014,[\s]{1}September[\s]{1}1-5,[\s]{1}2014,[\s]{1}Nottingham,[\s]{1}British.[\s]{1}Durham,England:[\s]{1}BMVA[\s]{1}Press,[\s]{1}2014.[\s]{1}

[8] Danelljan M, Hager G, Khan F S, et al. Discriminative scale space tracking[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(8): 1561-1575.

[9] MaC,[\s]{1}Huang[\s]{1}JB,[\s]{1}Yang[\s]{1}XK,[\s]{1}et[\s]{1}al.[\s]{1}Hierarchical[\s]{1}convolutional[\s]{1}features[\s]{1}for[\s]{1}visual[\s]{1}tracking[C]∥2015[\s]{1}IEEE[\s]{1}International[\s]{1}Conference[\s]{1}on[\s]{1}Computer[\s]{1}Vision[\s]{1}(ICCV),[\s]{1}December[\s]{1}7-13,[\s]{1}2015,Santiago,[\s]{1}Chile.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2015:[\s]{1}3074-[\s]{1}3082.[\s]{1}

[10] 王鑫, 侯志强, 余旺盛, 等. 基于多层卷积特征融合的目标尺度自适应稳健跟踪[J]. 光学学报, 2017, 37(11): 1115005.

[11] 毛宁, 杨德东, 杨福才, 等. 基于分层卷积特征的自适应目标跟踪[J]. 激光与光电子学进展, 2016, 53(12): 121502.

[12] Qi[\s]{1}YK,[\s]{1}Zhang[\s]{1}SP,[\s]{1}QinL,[\s]{1}et[\s]{1}al.[\s]{1}Hedged[\s]{1}deep[\s]{1}tracking[C]∥2016[\s]{1}IEEE[\s]{1}Conference[\s]{1}on[\s]{1}Computer[\s]{1}Vision[\s]{1}and[\s]{1}Pattern[\s]{1}Recognition[\s]{1}(CVPR),[\s]{1}June[\s]{1}27-30,[\s]{1}Las[\s]{1}Vegas,[\s]{1}NV,[\s]{1}USA.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2016:[\s]{1}4303-[\s]{1}4311.[\s]{1}

[13] Wang[\s]{1}LJ,[\s]{1}Ouyang[\s]{1}WL,[\s]{1}Wang[\s]{1}XG,[\s]{1}et[\s]{1}al.[\s]{1}Visual[\s]{1}tracking[\s]{1}with[\s]{1}fully[\s]{1}convolutional[\s]{1}networks[C]∥2015[\s]{1}IEEE[\s]{1}International[\s]{1}Conference[\s]{1}on[\s]{1}Computer[\s]{1}Vision[\s]{1}(ICCV),[\s]{1}December[\s]{1}7-13,[\s]{1}2015,Santiago,[\s]{1}Chile.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2015:[\s]{1}3119-[\s]{1}3127.[\s]{1}

[14] MaC,[\s]{1}Yang[\s]{1}XK,[\s]{1}Zhang[\s]{1}CY,[\s]{1}et[\s]{1}al.[\s]{1}Long-term[\s]{1}correlation[\s]{1}tracking[C]∥2015[\s]{1}IEEE[\s]{1}Conference[\s]{1}on[\s]{1}Computer[\s]{1}Vision[\s]{1}and[\s]{1}Pattern[\s]{1}Recognition[\s]{1}(CVPR),[\s]{1}June[\s]{1}7-12,[\s]{1}2015,[\s]{1}Boston,[\s]{1}MA,[\s]{1}USA.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2015:[\s]{1}5388-[\s]{1}5396.[\s]{1}

[15] Wang[\s]{1}MM,[\s]{1}LiuY,[\s]{1}Huang[\s]{1}ZY.[\s]{1}Large[\s]{1}margin[\s]{1}object[\s]{1}tracking[\s]{1}with[\s]{1}circulant[\s]{1}feature[\s]{1}maps[C]∥2017[\s]{1}IEEE[\s]{1}Conference[\s]{1}on[\s]{1}Computer[\s]{1}Vision[\s]{1}and[\s]{1}Pattern[\s]{1}Recognition[\s]{1}(CVPR),[\s]{1}July[\s]{1}21-26,[\s]{1}2017,[\s]{1}Honolulu,[\s]{1}HI,[\s]{1}USA.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2017:[\s]{1}4021-[\s]{1}4029.[\s]{1}

[16] Wu Y, Lim J, Yang M H. Object tracking benchmark[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1834-1848.

[17] Liang P P, Blasch E, Ling H B. Encoding color information for visual tracking: algorithms and benchmark[J]. IEEE Transactions on Image Processing, 2015, 24(12): 5630-5644.

[18] Zitnick[\s]{1}CL,[\s]{1}DollárP.[\s]{1}Edge[\s]{1}boxes:[\s]{1}locating[\s]{1}object[\s]{1}proposals[\s]{1}from[\s]{1}edges[M][\s]{1}∥Fleet[\s]{1}D,[\s]{1}Pajdla[\s]{1}T,[\s]{1}Schiele[\s]{1}B,[\s]{1}et[\s]{1}al.[\s]{1}Computer[\s]{1}vision-ECCV[\s]{1}2014.[\s]{1}Lecture[\s]{1}notes[\s]{1}in[\s]{1}computer[\s]{1}science.[\s]{1}Cham:[\s]{1}Springer,[\s]{1}2014,[\s]{1}8693:[\s]{1}391-[\s]{1}405.[\s]{1}

[19] ZhuG,[\s]{1}PorikliF,[\s]{1}Li[\s]{1}HD.[\s]{1}Beyond[\s]{1}local[\s]{1}search:[\s]{1}tracking[\s]{1}objects[\s]{1}everywhere[\s]{1}with[\s]{1}instance-specific[\s]{1}proposals[C]∥2016[\s]{1}IEEE[\s]{1}Conference[\s]{1}on[\s]{1}Computer[\s]{1}Vision[\s]{1}and[\s]{1}Pattern[\s]{1}Recognition[\s]{1}(CVPR),[\s]{1}June[\s]{1}27-30,[\s]{1}2016,[\s]{1}Las[\s]{1}Vegas,[\s]{1}NV,[\s]{1}USA.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2016:[\s]{1}943-[\s]{1}951.[\s]{1}

[20] 葛宝义, 左宪章, 胡永江. 基于特征融合的长时目标跟踪算法[J]. 光学学报, 2018, 38(11): 1115002.

[21] Ma C, Huang J B, Yang X, et al. Robust visual tracking via hierarchical convolutional features[J]. IEEE transactions on pattern analysis and machine intelligence, 2018.

[22] DanelljanM,[\s]{1}HagerG,[\s]{1}Khan[\s]{1}FS,[\s]{1}et[\s]{1}al.[\s]{1}Learning[\s]{1}spatially[\s]{1}regularized[\s]{1}correlation[\s]{1}filters[\s]{1}for[\s]{1}visual[\s]{1}tracking[C]∥2015[\s]{1}IEEE[\s]{1}International[\s]{1}Conference[\s]{1}on[\s]{1}Computer[\s]{1}Vision[\s]{1}(ICCV),[\s]{1}December[\s]{1}7-13,[\s]{1}2015,Santiago,[\s]{1}Chile.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2015:[\s]{1}4310-[\s]{1}4318.[\s]{1}

[23] HongS,[\s]{1}YouT,[\s]{1}KwakS,[\s]{1}et[\s]{1}al.[\s]{1}Online[\s]{1}tracking[\s]{1}by[\s]{1}learning[\s]{1}discriminative[\s]{1}saliency[\s]{1}map[\s]{1}with[\s]{1}convolutional[\s]{1}neural[\s]{1}network[C]∥Proceedings[\s]{1}of[\s]{1}the[\s]{1}32nd[\s]{1}International[\s]{1}Conference[\s]{1}on[\s]{1}International[\s]{1}Conference[\s]{1}on[\s]{1}Machine[\s]{1}Learning,[\s]{1}July[\s]{1}6-11,[\s]{1}2015,[\s]{1}Lille,[\s]{1}France.[\s]{1}New[\s]{1}York:[\s]{1}ACM,[\s]{1}2015,[\s]{1}37:[\s]{1}597-[\s]{1}606.[\s]{1}

[24] Ma C, Huang J B, Yang X K, et al. Adaptive correlation filters with long-term and short-term memory for object tracking[J]. International Journal of Computer Vision, 2018, 126(8): 771-796.

Article Outline

张超溢, 彭力, 贾天豪, 闻继伟. 基于高置信度更新的多滤波器协同跟踪算法[J]. 激光与光电子学进展, 2019, 56(19): 191502. Chaoyi Zhang, Li Peng, Tianhao Jia, Jiwei Wen. Multi-Filter Collaborative Tracking Algorithm Based on High-Confidence Updating Strategy[J]. Laser & Optoelectronics Progress, 2019, 56(19): 191502.