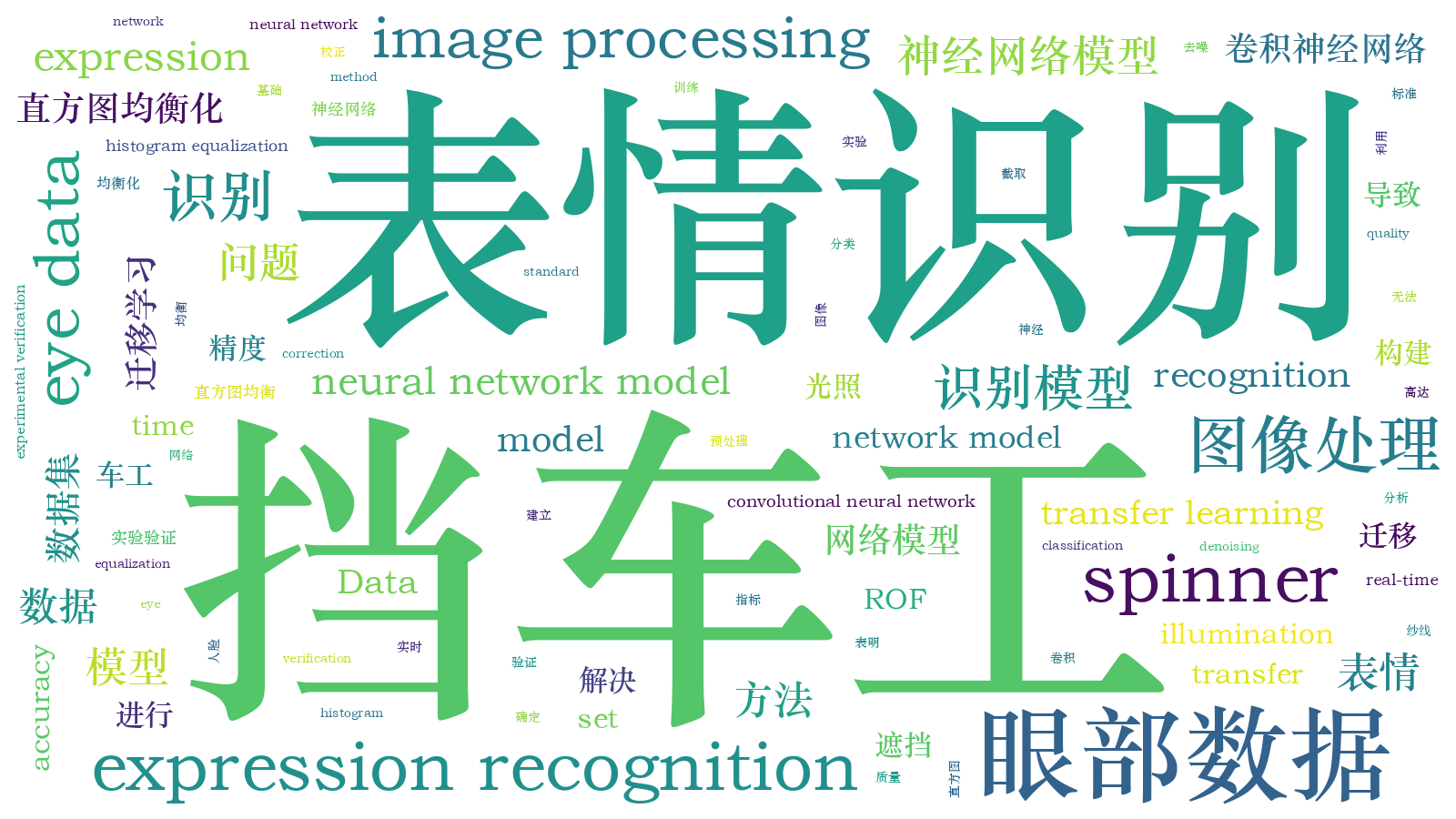

基于眼部数据的挡车工表情识别方法  下载: 810次

下载: 810次

1 引言

人脸表情识别一直是人工智能领域的重要分支,它对我们的社会发展有很大的影响。目前在纺纱车间,受采集环境的限制,获取的人脸图像经常存在光线昏暗、遮挡干扰等问题,从而导致人脸表情识别效果不佳。

国外学者针对该问题的研究主要集中在对输入图像的处理方面。Yeh等[1]提出了一种基于深度卷积生成对抗网络的图像绘制方法,运用该方法将图像进行了填补,使得图像信息相对完整,取得了良好的预测结果。Hammal等[2]利用基于几何形变的方法获取图像的几何形变参数,加之进行识别。Cotter[3]提出了一种基于稀疏表示分类器的人脸局部分类算法,用每个局部区域的表示误差特征,动态确定最优分类的局部区域集,结果表明该方法识别率高于其他方法。

在国内,学者们主要集中于对卷积神经网络的改进方面。王素琴等[4]提出一种基于生成对抗网络的表情识别算法,先对遮挡人脸图像进行填补和修复,再进行表情识别。该方法提高了人脸大面积遮挡时的识别率。王海涌等[5]提出一种基于改进生成式对抗网络的表情识别模型,实验证明该方法的识别率很高。叶学义等[6]提出了一种基于判别性非凸低秩矩阵分解的叠加线性稀疏表示算法,以达到去除遮挡干扰的目的。张红颖等[7]为解决单一特征对人脸信息表征不全面的问题,提出一种结合局部二值模式和梯度特征的双通道卷积神经网络表情识别算法,进而提高表情识别的准确率。

综上,目前学者们的研究大多是基于对原始图像的变换,利用生成对抗网络形成非真实图像,并对其进行研究,以提高遮挡人脸表情的识别效率。但在特殊的环境下,学者们的识别效率会受到严重限制,不能很好地处理纺纱车间挡车工的面部表情识别问题。为此,分析其原因,包括以下3点:

1)在昏暗的光线下,监测挡车工的表情十分困难;

2)对于挡车工表情数据的分类标准难以确定;

3)挡车工工作状态下常佩戴口罩,使用全脸检测识别,效率较低。

本文为了解决上述问题,首先利用熵权法提出一种挡车工表情分类标准,从而构建挡车工人脸表情数据集。其次利用直方图均衡化、ROF去噪、校正变换等图像预处理技术解决原始图像光线昏暗、对比度低等问题。然后利用人眼截取算法,提出一种针对挡车工眼部表情识别的卷积神经网络模型。最后对实验结果分析及比较,得出该方法具有良好的识别效果和有效性。

2 挡车工图像数据集的建立

2.1 关键指标选取的方法

在数字化纺纱车间,纱线质量直接决定着成品织物的质量。文献[ 8-11]提出员工表情可以表征员工的工作集中度,工作集中度决定着员工的工作投入与绩效产出。另外,好心情可以有效提升每日的工作绩效,心情变化在现实工作中出现频率很高且难以避免。由于在纺纱车间中,员工的工作绩效反映在纱线的质量方面,因此,为了对挡车工表情进行分类,综合考虑挡车工表情可能影响的各种纱线指标,运用熵权法计算纱线质量指标的权重,找出挡车工表情影响最为强烈的纱线质量指标作为分类标准。

熵权法在信息论基本原理中阐述,信息是衡量系统有序程度的物理量,而熵是衡量系统无序程度的物理量,因此,它可以准确反映出挡车工影响纱线质量指标的所有信息量。一般来说,若某个指标Ej的信息熵越小,表明指标值的变异程度越大,提供的信息量越多,所能起到的作用也越大,其权重也越大[12]。因此,我们可以看到指标值的变化程度与权重之间的关系是呈正向相关的。具体算法流程如下。

1) 假设样本数为m,评价指标数为n,得到的原始数据矩阵如下:

2)计算Pij,其中

3)计算所有样本对指标Xj的总贡献量Ej,计算公式为

其中,常数K=1/ln m,它保证了0≤Ej≤1。

4)求出各指标所占权重Dj=1-Ej。

2.2 关键指标的选取

为了建立挡车工表情数据集,进行表情识别,前期利用大量的纺纱生产数据进行数据挖掘分析和应用验证,结果表明,细度不匀、细节、粗节、毛羽数、断裂强度、断裂伸长率等6个指标是影响纱线质量的关键指标,它们之间具有强相关性。因此,本研究主要针对上述6个重要质量指标进行分析,以获取挡车工的表情分类标准。

由于本研究仅考虑挡车工的表情对纱线质量指标的影响,所以使用控制变量法进行分析。在纺纱车间随机抽取3名挡车工作为被试者,并将被试者放在同一车间、同一机器设备上生产同一种纱线,记录每名挡车工连续工作8 h的质量指标,总样本数据为24个(如

对于每个样本数据,采用熵权法计算挡车工的表情对成纱指标影响的权重比例,结果见

分析

表 1. 样本数据

Table 1. Sample data

|

表 2. 挡车工的表情对成纱指标影响的权重比例

Table 2. Weight proportion of yarn index influence for the expression of the spinner%

| ||||||||||||||||||||||||||||||||||

2.3 挡车工表情数据集的建立

根据上文确定的分类标准,选择某一纺纱车间对图像数据进行采集,并将采集到的数据按照3 mm毛羽数进行分类。将每米的3 mm毛羽数和3根/米(车间自行制定的标准)进行比较。当每米3 mm毛羽根数小于3根时,将图像数据划分为正常表情数据;每米3 mm毛羽根数大于3根时,将图像数据划分为异常表情数据。由此得到了640×480尺寸大小的挡车工人脸表情数据集。

3 图像预处理

3.1 直方图均衡化

如前所述,由于车间缺少光线、环境昏暗,本研究采用直方图均衡化方法,使图像的灰度值分布均匀,更多的细节凸显,具体算法如下:

1) 假设o和h分别表示图像变换之前和变换之后的图像灰度级,且o和h都进行了归一化处理。假设变换函数为h=T(o),此变换公式满足0≤o≤1,0≤h≤1;当0≤o≤1时,T(o)是单调递增的。

2) 假设o和h的概率密度分别为Po(o)和Ph(h)。由于映射前后的像素个数不变,可知Po(o)do=Ph(h)dh,可求出图像均衡化后的概率密度函数为

3) 根据直方图均衡化原理,可知灰度变换函数为

式中T(o)为o的累积分布函数。

4) 利用灰度变换函数计算图像的累积分布函数,并映射原图像的所有灰度像素值,得到均衡化后概率密度Ph(h)均匀的函数。

5) 输出直方图均衡化后的处理图像。

3.2 图像去噪

在图像的传输、转换和存储过程中,为了抑制图像的失真、降质、噪声,采用ROF去噪方法提高图像质量。该模型的实质是求解最小化能量泛函

式中,‖·‖v表示v的范数;u0表示原始图像;u表示去噪后图像;ΩBV表示定义在图像支撑域Ω上的有界变差函数(BV)空间,且ΩBV={u|u∈L(Ω)},L(Ω)为‖Ñu‖,‖Ñu‖<∞(Ñ是梯度算子);λ>0是尺度参数,在残差项和正则项之间起平衡作用。

由于该模型存在唯一解,故对应的Euler-Lagrange方程为

(6)式可以用最速下降法求解,即

3.3 人脸校正

测试样本和训练样本的一致性在一定程度上影响了人脸表情的识别效果,一致性越高,识别率越高。如果一致性差别过大,识别率明显降低[13]。针对这一问题,采用仿射变换技术对人脸图像进行校正,使其拥有较高的一致性和良好的训练效果,具体算法步骤如下。

首先,通过landmarks人脸关键点模型对人脸关键点进行获取。然后,求出左右眼像素点的中心坐标P(x,y),并求出其与水平面的夹角θ。最后,假设校正点的坐标为P'(x',y'),将其代入仿射矩阵中进行仿射变换,可得校正后的图像。仿射矩阵为

3.4 眼部截取

校正挡车工面部表情后,为了去除遮挡部分干扰,将人脸图像的眼部进行截取。由于Dlib库是一个开放源码的机器学习库,所以本研究采用了Python中Dlib库来实现截取,并使用Dlib库中的正面人脸检测器来检测图像中的人脸。

为了得到每个关键点的坐标并截取眼睛的像素点,使用Dlib库提供的68个经过训练的人脸关键点模型。具体算法流程如下。

1) 使用Dlib库找出68个人脸关键点并进行标记,结果如

2) 从人脸关键点中提取4个特征点坐标,分别是右眼眉毛特征点(记号20)、下眼睑特征点(记号42)、左眼眉梢特征点(记号27)和右眼眉梢特征点(记号18)。

假设右眼眉毛特征点坐标为(ax,ay),下眼睑特征点坐标为(bx,by),左眼眉梢特征点坐标为(cx,cy),右眼眉梢特征点坐标为(dx,dy),则眼部区域范围为[dx,cx]&[by,ay]。

3) 如

3.5 预处理结果

将建立好的图像数据集进行上述预处理操作,如

由于纺纱车间获取的图像数据过少往往会带来过拟合现象,故可采用数据增强的方式,减少过拟合现象的发生,使网络模型具有更好的分类效果。

数据增强操作如下:对数据集中每张图像随机作幅度为20%的水平偏移、幅度为20%的垂直偏移、强度为20%的剪切、幅度为20%的缩放以及随机水平翻转。最终获得拥有异常表情的图像450张,拥有正常表情的图像892张,共1342张299×299尺寸大小的挡车工表情图像,如

4 模型建立

迁移学习是一种机器学习方法,它以小数据集作为目标域,以大量标注的数据集作为源域[14]。它可以将模型已经学到的知识通过某种方式共享给新的模型,从而加快并优化网络模型的学习效率。文献[ 15]利用迁移学习的方法对森林火灾进行目标检测,结果具有准确率高、误报率低、检测时间短等优点。因此,为了解决数据集小、识别速度慢的问题,本文将Inception-v3模型应用到瓶颈层(网络层在全连接层之前)作为迁移学习的特征提取过程,然后利用提取的特征向量作为输入,训练一个新定义的单层全连接神经网络进行图像分类。

本研究使用的Inception-v3模型由46层网络和11个Inception模块组成。模型中保留了预训练Inception-v3模型中的所有卷积层参数,我们仅对模型进行微调,将全连接分类器替换为针对挡车工表情分类的全连接层。模型结构如

4.1 特征提取器

将Inception-v3模型去掉全连接层和分类器,使用其预训练的卷积层和池化层提取挡车工图像的特征向量,完成特征提取过程。假设输入挡车工表情图像为P,Fx表示卷积神经网络第x层的特征图(F0=P),则卷积和池化操作过程可以分别表示为

式中:Wx表示第x层卷积核的权值向量;表示卷积核与第x-1层图像或特征图进行卷积运算;最后将卷积运算的输出与第x层的偏移量bx相加,所得结果利用非线性的激活函数f(x)运算,得到第x层的特征图Fx;subsampling函数为下采样函数,用于降低特征图维度。

4.2 全连接层

在特征提取过程后,将所提取到的特征向量与全连接层每个节点连接,并使用修正线性单元(Relu)作为激活函数。激活函数的表达式为

4.3 Softmax分类器

模型将全连接层输出的特征输入到Softmax分类器中进行分类。本文分类标签y分为正常和异常两类。

5 实验结果及分析

本研究通过使用Python和Google开源深度学习框架TensorFlow搭建卷积神经网络,训练模型的计算机配置为处理器Interl(R)core(TM)i5-7500 CPU@3.40 GHz。将经过预处理好的数据图像按照8∶1∶1的比例进行划分,分为训练集、验证集和测试集。设置模型训练参数学习率为0.1,迭代次数为5万次,分支大小为100。将图像输入到本文所使用的基于迁移学习的Inception-v3网络结构中,得到精度曲线(

对于给定的测试数据集,精确度η为分类器正确分类的样本数(ntd)与总样本数(mtd)之比,即

采用交叉熵作损失函数,使用随机梯度下降法来优化损失函数,其计算公式为

式中:α为分支大小;β为类别数;Q为总类别数;Y为神经网络计算的预测输出,其维度为α×β,Yαβ表示其第α行第β列的元素;y为数据的标签,它的维度与Y相同。

我们使用200张挡车工表情数据对本文所构建的基于迁移学习的Inception-v3网络结构模型进行测试,结果显示该模型对挡车工的表情识别具有较高的准确度,可准确识别挡车工表情196张,测试准确度可以达到98%。

最后,为了验证该方法的有效性,对两组对比实验进行分析。分别将不使用图像预处理的眼部图像、使用图像预处理的人脸图像输入到Inception-v3模型中进行训练。针对同一图像具体识别结果进行比较,如

图 8. 经过不同处理的图像识别精度的对比。(a)眼部截取;(b)图像预处理;(c)本文方法

Fig. 8. Comparison of image recognition accuracy after different processing. (a) Eye interception; (b) image preprocessing; (c) our method

6 结论

为了解决挡车工表情识别精度受识别过程中光照不足、遮挡干扰等影响的问题,根据细纱机生产的纱线质量数据,找出了与挡车工表情直接相关的重要指标,进而建立了挡车工表情数据集。对含有噪声、光照不足等问题的原始数据进行预处理,建立了基于迁移学习的挡车工表情识别模型。通过实验验证与对比分析,得出该模型能够有效地识别挡车工表情,识别精度可靠有效。

[1] Yeh RA, ChenC, Lim TY, et al.Semantic image inpainting with deep generative models[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA.New York: IEEE Press, 2017: 6882- 6890.

[2] Hammal Z, Arguin M, Gosselin F. Comparing a novel model based on the transferable belief model with humans during the recognition of partially occluded facial expressions[J]. Journal of Vision, 2009, 9(2): 22.

[3] Cotter SF. Recognition of occluded facial expressions using a fusion of localized sparse representation classifiers[C]∥2011 Digital Signal Processing and Signal Processing Education Meeting (DSP/SPE), January 4-7, 2011, Sedona, AZ, USA.New York: IEEE Press, 2011: 437- 442.

[4] 王素琴, 高宇豆, 张加其. 基于生成对抗网络的遮挡表情识别[J]. 计算机应用研究, 2019, 36(10): 3112-3115, 3120.

Wang S Q, Gao Y D, Zhang J Q. Occluded facial expression recognition based on generative adversarial networks[J]. Application Research of Computers, 2019, 36(10): 3112-3115, 3120.

[5] 王海涌, 梁红珠. 基于改进的GAN的局部遮挡人脸表情识别[J]. 计算机工程与应用, 2020, 56(5): 141-146.

Wang H Y, Liang H Z. Recognition of occluded facial expressions based on improved generative adversarial network[J]. Computer Engineering and Applications, 2020, 56(5): 141-146.

[6] 叶学义, 罗宵晗, 王鹏, 等. 基于非凸低秩分解判别的叠加线性稀疏人脸识别[J]. 中国图象图形学报, 2019, 24(8): 1327-1337.

Ye X Y, Luo X H, Wang P, et al. Face recognition with superposed linear sparse representation based on discriminative nonconvex low-rank matrix decomposition[J]. Journal of Image and Graphics, 2019, 24(8): 1327-1337.

[7] 张红颖, 王汇三. 结合LBP和梯度特征的双通道表情识别[J]. 激光与光电子学进展, 2020, 57(14): 141005.

[8] Ashkanasy NM. Emotions in organizations: a multi-level perspective[M] ∥Dansereau F, Yammarino F J. Multi-level issues in organizational behavior and strategy. Bingley: Emerald Group Publishing Limited, 2003: 9- 54.

[9] Totterdell P. Catching moods and hitting runs: mood linkage and subjective performance in professional sport teams[J]. Journal of Applied Psychology, 2000, 85(6): 848-859.

[10] Brief A P, Weiss H M. Organizational behavior: affect in the workplace[J]. Annual Review of Psychology, 2002, 53(1): 279-307.

[11] Miner A G, Glomb T M. State mood, task performance, and behavior at work: a within-persons approach[J]. Organizational Behavior and Human Decision Processes, 2010, 112(1): 43-57.

[12] 李刚, 程砚秋, 董霖哲, 等. 基尼系数客观赋权方法研究[J]. 管理评论, 2014, 26(1): 12-22.

Li G, Cheng Y Q, Dong L Z, et al. Research on objective weighting method of Gini coefficient[J]. Management Review, 2014, 26(1): 12-22.

[13] 李海彦, 徐汀荣, 张立晓, 等. 基于仿射变换的多姿态人脸矫正和识别[J]. 计算机应用研究, 2014, 31(4): 1215-1219, 1228.

Li H Y, Xu T R, Zhang L X, et al. Multi-pose face correction and recognition based on affine transformation[J]. Application Research of Computers, 2014, 31(4): 1215-1219, 1228.

[14] 褚晶辉, 吴泽蕤, 吕卫, 等. 基于迁移学习和深度卷积神经网络的乳腺肿瘤诊断系统[J]. 激光与光电子学进展, 2018, 55(8): 081001.

[15] 富雅捷, 张宏立. 基于迁移学习的卷积神经网络森林火灾检测方法[J]. 激光与光电子学进展, 2020, 57(4): 041010.

Article Outline

邵景峰, 冯海强. 基于眼部数据的挡车工表情识别方法[J]. 激光与光电子学进展, 2020, 57(18): 181026. Jingfeng Shao, Haiqiang Feng. Facial Expression Recognition Method of Spinner Based on Eye Data[J]. Laser & Optoelectronics Progress, 2020, 57(18): 181026.