基于嵌入注意力机制层级LSTM的音视频情感识别  下载: 1570次

下载: 1570次

1 引言

目前,由于人工智能技术的飞速发展,人类已不单单通过单纯的用户指令来进行人机交互。情感识别在其中的地位日益提升,其中语音和面部表情的识别是情感识别应用领域的关键组成部分之一,例如自动驾驶汽车、智能电话语音助手、人类心理分析及医疗服务等。随着研究人员的不断探究,对情感的识别也逐渐从原来的单模态向双模态甚至多模态转变,相比于单模态的情感识别,多模态往往有着更好的识别率和鲁棒性[1-3]。

语音情感识别的目的是从原始的语音信号中提取某些可用特征,如声道频谱、韵律及其他非线性特征,然后对其进行情感状态的识别和分类。传统的语音情感识别技术包括隐马尔可夫模型(HMM)、人工神经网络(ANN)、高斯混合模型(GMM)、支持向量机(SVM)及K近邻(KNN)等。Nwe等[4]将HMM作为分类器,证明当HMM为4状态时,它用于情感识别分类时的识别效果最好。由于深度学习的发展和普及,许多研究人员将深度神经网络和语音情感识别结合起来,并取得了很好的实验效果。Satt等[5]使用卷积神经网络(CNN)和长短期记忆(LSTM)网络对语音频谱进行处理,取得了良好的识别效果。由于语音的连贯性和所提取的情感信息有着一定的上下文关系,故本文构建一个基础CNN-LSTM架构对音频中的语音频谱进行建模。单层LSTM网络在处理复杂问题时有时会出现表达能力较差的情况,Sutskever等[6]构建了4层LSTM网络并将它应用在编码器-解码器,实现了良好的实验效果,其提取出的深层次模型要明显优于浅层次模型。Irsoy等[7]提出的具有多层体系架构的循环神经网络(RNN)在观点挖掘领域要明显优于传统的浅层RNN。因此本文构建多层LSTM网络,通过利用多层LSTM网络提取每帧频谱的抽象信息来获得更好的性能。受很多动物和人在接受视觉信息时会聚集在某些区域而不是整个画面的这种视觉注意力的启发,研究人员将注意力机制引入深度学习中,这样不仅提高了识别的准确性而且很好地降低了信息处理的工作量。目前该技术被广泛应用于机器翻译、语音识别等领域。Lin等[8]在基于文本的机器翻译方法中应用了一种新的注意力模型,与以往不同的是,该模型可以通过自己的信息来更新迭代模型的参数,该方法能够更好地聚焦句子的重要部分。Guo等[9]提出一种具有可以并行处理多图像学习功能的新型CNN深度架构。研究人员通过最佳融合各种输入信号、特征、情感语音来进行广泛的实验。张石清等[10]提出了一种对监督局部线性嵌入策略进行某些改进,然后将其应用到情绪特征的降维方法。本文基于CNN-LSTM的语音情感识别网络基线模型,提出一种在各层LSTM网络间引入自注意力机制的改进方法,为各层LSTM网络的隐藏状态和单元状态分配权重,这样可以使不同层级得到更明显的区分,表示不同特征层级的关系,提升所提取特征的非线性表达能力。

传统面部表情识别方法流程为:首先从输入的数据集图片中检测出人脸图片和五官等关键部分,然后从中提取关于面部表情的特征,如几何特征、深度特征等,最后对这些特征进行训练和分类。由于所用到数据集中的视频并非每一帧都与情感表达相关,因此本文使用注意力机制,根据每个视频帧所包含情感信息的多少来为其分配权重。对于大多数情感识别的工作,往往通过对两个或多个模态信号进行融合来提升系统的识别效果[11]。一般来说,不同模态信号的融合可以自上而下地归为3类:判决层融合、中间层融合及特征层融合[12]。本文通过利用加权融合的策略来对面部图像和语音信号进行判决层融合,与融合前的各系统相比,该方法有着更好的识别率。

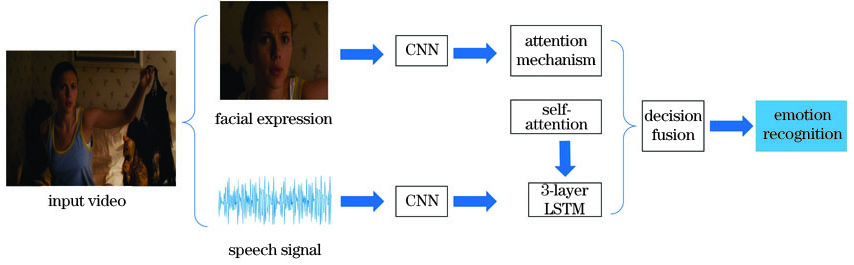

综上所述,对于音频的情感识别,本文基于CNN-LSTM基线模型,提出一种嵌入注意力机制的层级LSTM模型。所提方法首先通过CNN提取语音信号的特征并将其送入LSTM网络;再在层级LSTM间引入自注意力机制,使每层LSTM得到更好的区分,增强系统的鲁棒性;最后在损失函数中引入惩罚项,使网络性能得到进一步提升,这样可以使各个层的状态向量更加多样化,最终得到分类结果。实验结果表明,所提方法有着良好的识别效果。对于视频的情感识别,本文采用基于深度卷积网络(VGGNet)模型的改进模型等一系列方法来提取视频序列中每帧图像特征;然后通过注意力机制为每帧图像分配权重,以此筛选出与情感信息最相关的图像帧;此后进行情感识别;最后在决策层利用加权融合方法对两个模态进行融合,系统性能得到进一步提升。

2 基于嵌入注意力机制层级LSTM的音视频情感识别方法

将语音信息和面部表情结合在一起以实现情感识别。所提方法流程如

2.1 语音情感识别方法

基于深度卷积神经网络的体系结构在图像建模和视频建模(例如图像的识别、分类、检索)中取得了优异的性能。为了实现语音情感识别,将语音信号转换为图像后再进行分类工作[13],将CNN和LSTM网络无缝结合以实现语音情感识别。Shelhamer等[14]针对图像的语义分割,提出一种基于全卷积网络的工作方法,该方法有效解决了网络输入大小的局限问题。故本文去掉AlexNet中的全连接层来构建一个全卷积网络用于特征提取,由于情感信息是存在于图像中的高级信息,故用CNN可以更好地捕获到此类信息及其抽象特征。常规RNN由于梯度消失和梯度爆炸问题,难以从随机长度输入序列中学习特征;LSTM是一种特殊类型的RNN,它能够学习长期依赖的信息,适用于处理和预测时间序列中间隔和延迟很长的重要事件,故用LSTM解决这个问题[15]。标准的递归神经元定义为

式中:函数f(·)为非线性激活函数;

式中:符号c和b分别为遗忘门和输入门;与函数f(·)相似,g(·)也为非线性激活函数。其输入包括三个分量,即来自上一层的信号、宿主单元、先前的输出,可以表述为

式中:α为门的范围;ν为宿主单元的连接权重。

Bahdanau等[16]在机器翻译领域应用注意力机制,将其引入到模型中的输入和输出之间,从而使模型的性能得以提升。注意力机制的主要工作原理:将source中的元素想象成由一系列<K,V>数据对构成,给定元素Q,通过计算Q和每个K的相关性,得到每个K对应V的权重系数,然后对V进行加权求和,得到最终的attention数值Yatt,如

式中:l为source的长度。自注意力机制并不是指target和source之间的attention机制,而是source或target内部元素之间发生的注意力机制,可以理解为K=V=Q的情形。自注意力机制能够更容易捕获输入序列中长距离相互依赖的特征。

在所应用的栈式LSTM网络中,将三个LSTM堆叠在一起,该模型可以学习更高层次的时域特征表示。利用LSTM对序列数据进行操作,这意味着层的添加增加了输入观察时间的抽象级别,有着更好的表达能力。

为了使栈式LSTM网络中的各层LSTM有不同的占比,从而让所提网络性能得到进一步提升,在每层LSTM网络之间引入自注意力机制,与注意力机制不同的是,它可以通过自身的信息来进行迭代更新。该部分方法流程如

图 4. 嵌入注意力机制的栈式LSTM模型示意图

Fig. 4. Schematic of stacking LSTM model with attention mechanism

式中:向量

接下来对权重向量

式中:

由于相邻时间步之间的自注意力机制往往会分配相近的权重,可以在其中加入惩罚项来防止该问题的发生,使不同层级状态权重向量更具有多样性。惩罚项在优化权重的同时,不仅减少了多余的特征信息,而且使栈式LSTM中的层级关系更具差异化,所以采用统计方差的方法来对网络进行优化。

式中:

式中:

2.2 视频情感识别方法

与传统手工提取人脸面部特征不同的是,深度神经网络可以直接从所输入的原始图片中提取所需特征。对于视频的图像分类,LSTM网络通常被用来提取分析与图像有关的时间域信息对。Fan等[17-18]为处理视频中时间域信息,引入三维卷积网络和LSTM网络。不过对于AFEW这种非标准的数据集来说,并不是所有的视频帧都与情感表达有关,对此,使用注意力机制来筛选出最富有情感信息的视频帧,以进行视频序列的情感识别分类工作。

所使用的系统如

采用文献[ 19]中提出的4种人脸特征提取方法来进行分类任务,特征提取的方法分别为VGG-Face、FR-Net-A、FR-Net-B、FR-Net-C。本文分别将所提取的视频序列特征称为EF-VGG、EF-A、EF-B、EF-C。

为了根据数据集视频中每一帧图片所包含情感信息的多少来为其分配不同的权重,采用注意力机制来计算每一帧图片的情感相关程度,然后对各帧图片进行加权融合得到情感特征。进行训练之前,需要对其所得特征进行降维,以降低计算复杂度,具体步骤表达式为

式中:

2.3 音视频融合的情感识别方法

本文集成面部表情和语音信号来进行情感识别,而且利用决策融合方法来解决两个不同模态的融合问题。决策融合的目的是处理每种模型产生的类别,并利用特定的标准再进行重新区分。人脸面部表情识别和语音情感识别都使用Softmax函数来进行分类。将面部表情识别和语音情感识别的输出分别定义为

式中:

式中:

3 实验结果与分析

对所提方法进行有效性验证。实验是在NIVADA 1060ti,4.00GB RAM的计算机上进行的。实验中使用三个人类情感数据集,包括RML[20]、AFEW6.0[21]及eNTERFACE'05[22]。

3.1 数据集简介

RML:RML是一个双模态数据集,其中包括面部表情和语音信息。该数据集由720个视频样本组成,其中包含6种基本表情。数据集的采样率为44100 Hz,视频帧率为30 frame/s。

AFEW6.0:该数据集由773个训练样本、383个验证样本及593个测试样本组成,总共包含7类情感。该数据集的数据均是从电影、电视、脱口秀等影视片段中采集到的,更能体现真实场景下的人类情感表达。

eNTERFACE'05:该数据集将42个具有不同国籍的个体作为视频样本,其中包括1263个视频。在这些视频剪辑中,有81%是从男性那里收集的,而19%是从女性那里收集的。每帧的尺寸为720×576。

在本实验中,首先利用旋转、翻转、颜色失真、镜像变换操作对数据进行扩充。使用Caffe深度学习框架来实现所提方法。最初对整个数据集进行100个周期的训练,批次大小为32;初始学习率为0.01,在10000次迭代后将其设置为0.005;将权重衰减量和动量分别设置为0.0002和0.9。深度情感识别模型采用随机梯度下降(SGD)方案训练。

3.2 语音情感识别

由于传统语音数据的规模小,将具有不同权重和信噪比的高斯白噪声集成到原始语音信号上。最初将训练周期设置为100,批次大小为32。初始学习率为0.01,在10000次迭代后将学习率设置为0.005。将权重衰减量和动量分别设置为0.00001和0.9。通过随机梯度下降(SGD)算法来训练深层模型。长期和短期存储网络中的隐藏层单元数固定为128。比较结果如

表 1. 语音情感识别实验的识别率对比

Table 1. Comparison of recognition rate in speech emotion recognition experiment

|

3.2.1 LSTM堆叠层数对系统识别率的影响

为了探究LSTM层数是否会对实验结果有相应的改进作用,基于基线模型,在不同层数的LSTM下进行对比实验。

3.2.2 层级注意力机制对系统识别率的影响

系统引入注意力机制后可以使网络的不同层级在各个时间步上有选择的被关注。为了研究注意力机制是否对网络的提升有一定影响,设计了相应的对比实验,结果如

表 2. 层级注意力机制的识别率对比

Table 2. Recognition rate comparison of hierarchical attention mechanism

| ||||||||||||||

3.2.3 惩罚项对系统识别率的影响

在注意力机制中,通过改变注意力的权重系数来达到改善识别效果的目的。其中,惩罚项可以用来更新权重系数,不同的权重系数得到的识别模型有所差异。通过引入方差,得到不同权重系数情况下的区别,再使用反向传播算法使方差最大化。

表 3. 惩罚项情况下的识别率对比

Table 3. Recognition rate comparison under penalty items

|

3.3 面部表情识别

分别在AFEW 6.0、RML、eNTERFACE'05数据集上对所设计的模型进行实验验证。在所提模型中,所提取的特征长度为256,训练过程中,将batch size设置为64,迭代200个epoch,学习率为3×10-5。分别使用EF-A、EF-B、EF-C、EF-VGG作为系统输入的特征,由于所提取的特征之间存在一定程度上的差异,在输入系统前要对其进行规整,表达式为

式中:

表 4. 面部表情的识别率

Table 4. Recognition rate of facial expression

|

3.4 音视频融合的情感识别

利用面部表情识别和语音情感识别来进行决策融合。对在决策层融合的两种模态信号而言,两种信号与情感表达程度大小各异,如何合理分配权重也成为融合的关键,由实验效果和经验可知,该实验可为视频信号分配更大的权重。

表 5. 三种数据集的权重设置

Table 5. Weight settings on three datasets

|

4 结论

提出一种应用于语音情感识别的基于自注意力机制的堆叠LSTM模型。与其他的现有模型相比,它能提取时间序列数据中更复杂的依赖关系,并且通过注意力机制,可以使模型聚焦于更为重要的层级,在引入惩罚项后,不同时间步之间的注意力向量更具有多样性。针对视频情感识别,引入了注意力机制,相比其他现有的模型而言,大大减少了模型训练学习的时间,同时还具有良好的识别效果。最后应用加权融合算法,将面部信号和语音信号融合在一起,融合后的系统识别率相较于其他系统提升4%左右,进一步提升了识别的准确率。除了语音和面部表情,人类的情感还有着多种载体,比如姿态动作、生理信号等,如何更加有效利用并融合多模态的信息来提升识别准确率将是下一步的研究工作。

[1] 袁配配, 张良. 基于深度学习的行人属性识别[J]. 激光与光电子学进展, 2020, 57(6): 061001.

[2] 刘芾, 李茂军, 胡建文, 等. 基于低像素人脸图像的表情识别[J]. 激光与光电子学进展, 2020, 57(10): 101008.

[3] 张义超, 孙子文. 基于优化卷积深度信念网络的智能手机身份认证方法[J]. 激光与光电子学进展, 2020, 57(8): 081009.

[4] Nwe T L. Foo S W, de Silva L C. Speech emotion recognition using hidden Markov models[J]. Speech Communication, 2003, 41(4): 603-623.

[5] Satt A, Rozenberg S, Hoory R. Efficient emotion recognition from speech using deep learning on spectrograms[J]. Proceedings of Interspeech, 2017, 2017: 1089-1093.

[6] SutskeverI, VinyalsO, Le QV. Sequence to sequence learning with neural networks[C]∥Proceedings of the 27th International Conference on Neural Information Processing Systems, December 8-13, 2014, Montreal, Quebec, Canada. New York: Curran Associates, 2014, 2: 3104- 3112.

[7] IrsoyO, CardieC. Deep recursive neural networks for compositionality in language[C]∥ Proceedings of the 27th International Conference on Neural Information Processing Systems, December 8-13, 2014, Montreal, Quebec, Canada. New York: Curran Associates, 2014, 2: 2096- 2104.

[8] Lin ZH, Feng MW, dos Santos CN, et al. ( 2017-03-09)[2020-07-05]. https:∥arxiv.org/abs/1703. 03130.

[9] Guo Z H, Zhang L, Zhang D. A completed modeling of local binary pattern operator for texture classification[J]. IEEE Transactions on Image Processing, 2010, 19(6): 1657-1663.

[10] 张石清, 李乐民, 赵知劲. 基于一种改进的监督流形学习算法的语音情感识别[J]. 电子与信息学报, 2010, 32(11): 2724-2729.

Zhang S Q, Li L M, Zhao Z J. Speech emotion recognition based on an improved supervised manifold learning algorithm[J]. Journal of Electronics & Information Technology, 2010, 32(11): 2724-2729.

[11] WangS, Wang WX, Zhao JM, et al.Emotion recognition with multimodal features and temporal models[C]∥Proceedings of the 19th ACM International Conference on Multimodal Interaction-ICMI 2017, November 3-17, 2017, Glasgow, UK.New York: ACM Press, 2017: 598- 602.

[12] Wu C H, Lin J C, Wei W L. Survey on audiovisual emotion recognition: databases, features, and data fusion strategies[J]. APSIPA Transactions on Signal and Information Processing, 2014, 3: e12.

[13] Abdel-Hamid O, Mohamed A R, Jiang H, et al. Convolutional neural networks for speech recognition[J]. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2014, 22(10): 1533-1545.

[14] Shelhamer E, Long J, Darrell T. Fully convolutional networks for semantic segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(4): 640-651.

[15] Hochreiter S, Schmidhuber J. Long short-term memory[J]. Neural Computation, 1997, 9(8): 1735-1780.

[16] BahdanauD, ChoK, Bengio Y. Neural machine translation by jointly learning to align and translate[EB/OL]. ( 2016-05-19)[2020-07-05]. https:∥arxiv.org/abs/1409. 0473.

[17] FanY, Lu XJ, LiD, et al.Video-based emotion recognition using CNN-RNN and C3D hybrid networks[C]∥Proceedings of the 18th ACM International Conference on Multimodal Interaction-ICMI 2016, October 31-November 16, 2016, Tokyo, Japan.New York: ACM Press, 2016: 445- 450.

[18] NguyenD, NguyenK, SridharanS, et al.Deep spatio-temporal features for multimodal emotion recognition[C]∥2017 IEEE Winter Conference on Applications of Computer Vision (WACV), March 24-31, 2017, Santa Rosa, CA, USA.New York: IEEE Press, 2017: 1215- 1223.

[19] KnyazevB, ShvetsovR, EfremovaN, et al.Leveraging large face recognition data for emotion classification[C]∥2018 13th IEEE International Conference on Automatic Face & Gesture Recognition (FG 2018), May 15-19, 2018, Xi'an, China.New York: IEEE Press, 2018: 692- 696.

[20] Wang Y J, Guan L. Recognizing human emotional state from audiovisual signals[J]. IEEE Transactions on Multimedia, 2008, 10(4): 659-668.

[21] DhallA, GoeckeR, JoshiJ, et al.EmotiW 2016: video and group-level emotion recognition challenges[C]∥Proceedings of the 18th ACM International Conference on Multimodal Interaction-ICMI 2016, October 31-November 16, 2016, Tokyo, Japan. New York: ACM Press, 2016: 427- 432.

[22] MartinO, KotsiaI, MacqB, et al.The eNTERFACE'05 audio-visual emotion database[C]∥22nd International Conference on Data Engineering Workshops (ICDEW'06), April 3-7, 2006, Atlanta, GA, USA.New York: IEEE Press, 2006.

[23] Avots E, Sapiński T, Bachmann M, et al. Audiovisual emotion recognition in wild[J]. Machine Vision and Applications, 2019, 30(5): 975-985.

[24] Noroozi F, Marjanovic M, Njegus A, et al. Audio-visual emotion recognition in video clips[J]. IEEE Transactions on Affective Computing, 2017, 10(1): 60-75.

[25] Wang X S, Chen X, Cao C J. Human emotion recognition by optimally fusing facial expression and speech feature[J]. Signal Processing: Image Communication, 2020, 84: 115831.

[26] Zhang YY, Wang ZR, DuJ. Deep fusion: an attention guided factorized bilinear pooling for audio-video emotion recognition[C]∥2019 International Joint Conference on Neural Networks (IJCNN), July 14-19, 2019, Budapest, Hungary. New York: IEEE Press, 2019.

[27] Dangol R, Alsadoon A. Prasad P W C, et al. Speech emotion recognition using convolutional neural network and long-short term memory[J]. Multimedia Tools and Applications, 2020, 79: 32917-32934.

Article Outline

刘天宝, 张凌涛, 于文涛, 魏东川, 范轶军. 基于嵌入注意力机制层级LSTM的音视频情感识别[J]. 激光与光电子学进展, 2021, 58(2): 0210017. Tianbao Liu, Lingtao Zhang, Wentao Yu, Dongchuan Wei, Yijun Fan. Hierarchical LSTM-Based Audio and Video Emotion Recognition With Embedded Attention Mechanism[J]. Laser & Optoelectronics Progress, 2021, 58(2): 0210017.