特征融合的卷积神经网络多波段舰船目标识别  下载: 1378次

下载: 1378次

1 引言

随着海洋环境的开发和利用日渐增多,海上舰船目标的准确识别无论在**还是民用领域都得到广泛的应用,如海上搜救、渔船监控、精确制导**以及多方面的潜在海洋威胁等。可见光图像分辨率高,细节纹理清晰,并且对目标的区分度好。红外图像不受光照情况影响,可满足夜间无光情况下的工作需要,若能利用不同传感器成像的优点进行融合识别,可以有效扩展复杂条件下多波段图像目标识别的适用范围,并提高识别率。

目前常用的目标识别方法主要分为两类:基于特征的方法和基于神经网络的方法。前者主要依赖人工设计的特征向量,并结合目标自身具有的结构、纹理、颜色等特征作为判别依据,进行目标的识别和分类。常用的有方向梯度直方图(HOG)特征[1-3]、尺度不变特征变换(SIFT)算法[4]、Fisher向量[5]等。

张迪飞等[1]利用HOG特征,结合支持向量机(SVM)的方法,对海面上的红外舰船目标进行识别分类,在一定程度上克服了背景的干扰,但是实验中并没有对多种目标及形变、光照等变化进行测试。Feineigle等[4]利用SIFT算法描述子对港口中的舰船目标进行识别,通过对目标局部特征的描述和匹配实现了对光照和角度的不变性,但是利用滑动窗口对目标进行特征提取造成维数过高,计算效率较低。Sánchez等[5]利用Fisher向量结合高斯混合模型对大规模数据集进行线性分类,目标类别包含千种以上,通过对最损失函数进行优化得到了当时最好的分类准确率。Smeelen等[6]利用基于协方差的融合方法,将可见光和红外图像特征向量进行特征级融合,但该方法仅限于较低维度的特征融合,高维情况会使计算量显著增加。

基于卷积神经网络(CNN)的识别方法是一种端到端的模型结构,使图像可以直接作为网络的输入,避免了传统识别算法中复杂的特征提取和数据重建过程。多层的卷积结构设计使得该网络对平移、比例缩放、倾斜或者其他形式的形变具有高度不变性[7]。目前,该方法在图像分类[8-10]、目标检测[11-12]、显著性分析[13]等众多计算机视觉领域取得了突破性的进展。Krizhevsky等[8]提出的AlexNet模型在图像分类挑战赛中赢得了当年的第一名,证明了CNN在复杂条件下的有效性,并使用图形处理器(GPU)使大数据训练在可接受的时间范围内得到了结果。在此基础上He等[10]将CNN的模型深度扩展到152层,使得ImageNet大规模视觉识别挑战赛(ILSVRC)的目标分类识别率已经达到甚至超越了人类的识别能力。Bousetouane等[14]针对港口中的舰船目标,提取目标候选区域,利用超快区域卷积神经网络(Faster-RCNN)[11]方法进行训练提取目标特征,可同时识别多种舰船目标及背景。Zhang等[15]建立可见光/长波红外双波段数据集,采用牛津大学视觉研究组提出的VGG-16[9]神经网络,并且在单波段图像无法获取目标时,利用另一种波段图像对目标进行识别。通过足够多转换的组合,可以学习到更加复杂的函数表达。

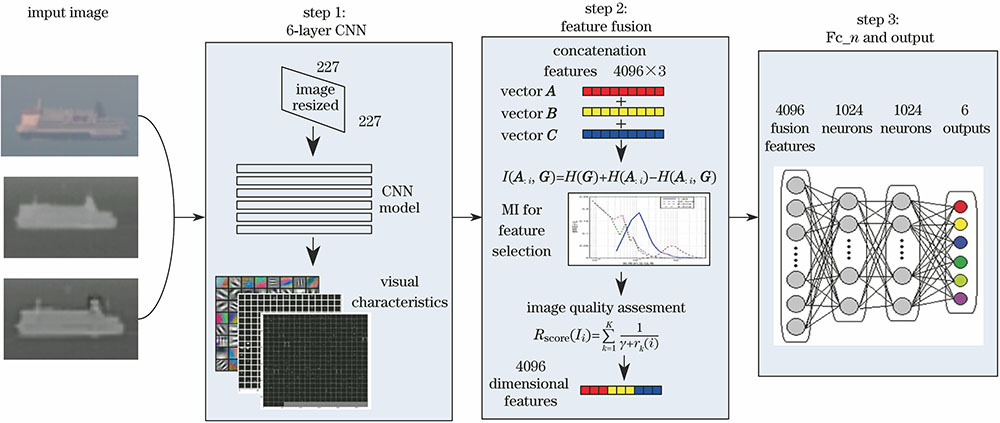

以上述分析为基础分析,本文提出一种基于CNN的多波段舰船目标融合识别方法。该方法可以分别提取三波段图像特征,并利用基于互信息的特征选择方法和图像清晰度指标对串联特征进行自适应降维,最后通过全连接层实现目标的分类。

2 融合算法模型

2.1 算法总体框架

本文算法一方面克服了目前CNN模型仅针对单一波段图像作为数据输入的限制,可同时提取三波段图像的目标特征,并对其进行有效的融合识别;另一方面限于多波段图像数据集的资源较少,在对模型的研究过程中,自建三波段舰船目标数据集进行实验验证,该数据集共包含6类目标,5000余张图像。设计的三波段融合识别方法主要包含3个步骤:1)利用改进的AlexNet网络实现对三波段图像的并行特征提取;2)利用基于互信息的特征选择方法对串联的融合特征进行降维,去除无关的特征向量;3)添加2个全连接层和1个输出层对网络进行回归训练,得到目标分类结果。本文算法流程如

2.2 特征提取网络结构

将改进的AlexNet作为网络特性提取的基本结构,利用神经网络的迁移学习能力,将ILSVRC12中训练好的模型作为网络的初始化参数,再利用自建的多波段数据集进行微调。设计的网络结构如

将同一目标的三波段图像并行送入3个相同的神经网络进行特征提取,网络的具体参数如

表 1. 神经网络结构及参数

Table 1. Structure and parameters of the neural network

| |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

式中

在训练过程中,针对不同尺寸的输入图像,需要将其映射为227 pixel×227 pixel的矩形,以适应网络结构的输入。Krizhevsky等[8]验证了不同的映射方法对识别率的影响,本文采用双线性插值法。将输入图像减去像素均值后利用CNN进行训练,通过前向传播逐层提取特征,在第6层得到4096维的特征向量,记为向量

2.3 自适应权重的互信息特征选择

特征压缩是通过投影将所有信息进行压缩,保留的信息仍含有一定的冗余和噪声,而特征选择的过程是通过舍弃冗余信息而保留对分类贡献较高的有用信息。采用基于互信息特征选择的方法对串联特征进行降维,并按照重要性进行排序,该方法可根据需要任意设定阈值,选择不同维度的特征向量,而不再需要重新计算。串联融合的特征按照可见光、中波红外、长波红外的顺序进行排列,在降维过程中3类图像的特征向量彼此互不干扰。特征的排序与选择仅在同一幅图像的特征向量中进行。为了确保融合后特征向量具有固定的维数,利用图像清晰度评价指标可以自适应确定不同波段图像的阈值。

利用文献[

17]中基于互信息的特征选择方法计算维度和标签之间的互信息是一种基于监督的方法,以可见光图像特征向量

式中

利用定量的离散变量方法代替核密度分布计算随机变量

式中

式中

评价指标如下:

1) 梯度相似性偏差(GMSD)[19],计算像素间梯度相似性;

2) 视觉信息保真度指数(VIF)[20],基于小波变换的多尺度高斯混合模型,计算图像失真程度;

3) 特征相似性指数(FSIM)[21],测量图像的梯度幅值和相位一致性;

4) 颜色特征相似性指数(FSIMC)[21],在可见光图像中,与特征相似指数相比增加了颜色信息;

5) 结构相似性指数(SSI)[22],测量图像中物体的结构失真程度。

(4)式是对多种评价方法进行综合考虑,得到单张图像相对于整个数据集中图像的质量指标,并不是对图像清晰度的客观评价。分别对三波段图像计算

式中

2.4 数据集构建与训练

利用具有共视轴的三轴经纬仪对海上舰船目标进行拍摄,采样帧频均为1 s,同一时刻拍摄的三波段图像作为一个整体进行存储。可见光图像分辨率为1024 pixel×768 pixel,中波传感器工作波段为3.7~4.8 μm、图像分辨率为320 pixel×256 pixel,长波传感器工作波段8~14 μm、图像分辨率为640 pixel×480 pixel。拍摄海面上行驶的舰船在不同时刻、不同背景下的图像,构建多波段舰船图像目标数据库,共包括6类目标,5187幅图像。数据库中包括游轮A 354×3幅,游轮B 337×3幅,铁路轮渡208×3幅,货船236×3幅,小型渔船291×3幅,某型军舰303×3幅。在训练之前需要对数据集中的目标进行类别标注,并按照随机采样的方式将其按照50%,20%和30%的比例划分为训练集、验证集和测试集。网络训练采用随机梯度下降(SGD)方法,批处理尺寸

3 实验验证及对比

图 4. 目标识别数据库示例图片。(a)游轮A;(b)游轮B;(c)渔船;(d)铁路轮渡;(e)军舰;(f)货船

Fig. 4. Examples in target identification database. (a) Cruise A; (b) cruise B; (c) fisher; (d) railway ferry; (e) warship; (f) merchant ship

三波段图像的融合特征维度直接影响本文算法的识别率和计算时间,通过实验确定融合特征的特征维度

利用构建的多波段舰船目标数据集进行实验验证,所有方法采用相同的训练集和测试集,并将本文方法与其他4种方法进行对比,分别为:

1) HOG+SVM识别[1],HOG特征描述子选择64 pixel×128 pixel的图像块,步长为8,共3780维特征向量;

2) SIFT特征识别[4],将图像划分为64 pixel×64 pixel的图像块,分别提取128维SIFT特征;

3) AlexNet模型[8],利用ILSVRC12中训练得到的参数进行初始化,再用本文数据进行微调;

4) VGG-16模型[9],与AlexNet类似,通过微调测试网络层数增加对本文目标识别效果的影响;

5) 本文方法,单波段识别为不经过特征选择、直接利用6层网络提取的特征进行识别的概率。

表 2. 不同方法识别率对比

Table 2. Recognition rate comparison of different methods

| ||||||||||||||||||||||||||||||||||

在5种识别方法中,基于词袋模型(BOW)的方法识别率普遍低于神经网络方法,主要原因在于人工提取的特征是独立存在的,不包含语义信息,在进行匹配时缺少目标之间的关联性。基于AlexNet和VGG-16的神经网络识别方法在大规模识别任务中取得了较为理想的结果,但是该模型只能对单波段图像分别进行目标识别,不能充分利用多波段图像间的融合特征,在图像清晰度不高的情况下难以取得较高的识别率。本文方法在利用CNN特征提取的基础上,利用基于互信息的方法对融合特征按照图像清晰度指标进行重要性排名,消除单一波段中存在的干扰,最终得到了84.5%的识别率,相比于前2类识别方法的识别率分别提高了近40%和20%。

图 6. 本文方法识别率矩阵。 (a)融合识别;(b)可见光;(c)中波红外;(d)长波红外

Fig. 6. Recognition rate matrices of the proposed method. (a) Proposed fusion recognition; (b) visible light; (c) medium-wave infrared; (d) long-wave infrared

本文方法适用于可见光无法获得精细成像的情况,在测试的数据集中,可见光图像受海上水雾及光照影响,存在大量噪声且细节纹理特征缺乏,红外图像可用信息较少难以进行分类识别。

4 结论

在单波段图像无法获得精细成像的情况下,对多波段舰船目标的融合识别问题进行研究。利用深度CNN在目标分类上的优势,设计合理的网络模型对三波段图像进行特征提取并进行有效融合。合理的特征融合方法不但可以提高识别率,同时还可以消除冗余信息,提高计算效率。在本文应用场景下,多波段图像融合后的目标识别率明显高于其他方法和单波段目标识别率。目前构建的数据集还不够完善,样本集中的目标应包含不同光照、角度、尺度、遮挡、复杂背景等多种情况下的训练数据,才能具有更好的泛化能力和实验说服力。在今后的研究中,将进一步丰富数据集并优化算法模型。

[1] 张迪飞, 张金锁, 姚克明, 等. 基于SVM分类的红外舰船目标识别[J]. 红外与激光工程, 2016, 45(1): 0104004.

张迪飞, 张金锁, 姚克明, 等. 基于SVM分类的红外舰船目标识别[J]. 红外与激光工程, 2016, 45(1): 0104004.

[2] RamananD, ZhuX. Face detection, pose estimation, and landmark localization in the wild[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2012: 2879- 2886.

RamananD, ZhuX. Face detection, pose estimation, and landmark localization in the wild[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2012: 2879- 2886.

[4] Feineigle PA, Morris DD, Snyder FD. Ship recognition using optical imagery for harbor surveillance[C]. Proceedings of AUVSI Unmanned Systems North America Conference, 2007: 249- 263.

Feineigle PA, Morris DD, Snyder FD. Ship recognition using optical imagery for harbor surveillance[C]. Proceedings of AUVSI Unmanned Systems North America Conference, 2007: 249- 263.

[6] Smeelen M A. Schwering P B W, Toet A, et al. Semi-hidden target recognition in gated viewer images fused with thermal IR images[J]. Information Fusion, 2014, 18: 131-147.

Smeelen M A. Schwering P B W, Toet A, et al. Semi-hidden target recognition in gated viewer images fused with thermal IR images[J]. Information Fusion, 2014, 18: 131-147.

[7] 周飞燕, 金林鹏, 董军. 卷积神经网络研究综述[J]. 计算机学报, 2017, 40(6): 1229-1251.

周飞燕, 金林鹏, 董军. 卷积神经网络研究综述[J]. 计算机学报, 2017, 40(6): 1229-1251.

Zhou Feiyan, Jin Linpeng, Dong Jun. Review of convolutional neural network[J]. Chinese Journal of Computers, 2017, 40(6): 1229-1251.

[8] KrizhevskyA, SutskeverI, Hinton GE. ImageNet classification with deep convolutional neural networks[C]. International Conference on Neural Information Processing Systems, 2012: 1097- 1105.

KrizhevskyA, SutskeverI, Hinton GE. ImageNet classification with deep convolutional neural networks[C]. International Conference on Neural Information Processing Systems, 2012: 1097- 1105.

[9] 刘大伟, 韩玲, 韩晓勇. 基于深度学习的高分辨率遥感影像分类研究[J]. 光学学报, 2016, 36(4): 0428001.

刘大伟, 韩玲, 韩晓勇. 基于深度学习的高分辨率遥感影像分类研究[J]. 光学学报, 2016, 36(4): 0428001.

[10] HeK, ZhangX, RenS, et al. Deep residual learning for image recognition[C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 770- 778.

HeK, ZhangX, RenS, et al. Deep residual learning for image recognition[C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 770- 778.

[11] RenS, HeK, GirshickR, et al. Faster R-CNN: towards real-time object detection with region proposal networks[C]. Advances in Neural Information Processing Systems, 2015: 91- 99.

RenS, HeK, GirshickR, et al. Faster R-CNN: towards real-time object detection with region proposal networks[C]. Advances in Neural Information Processing Systems, 2015: 91- 99.

[12] RedmonJ, DivvalaS, GirshickR, et al. You only look once: unified, real-time objectdetection[J/OL]. ( 2016-05-09)[2017-01-05] https:∥arxiv. org/abs/1506. 02640.

RedmonJ, DivvalaS, GirshickR, et al. You only look once: unified, real-time objectdetection[J/OL]. ( 2016-05-09)[2017-01-05] https:∥arxiv. org/abs/1506. 02640.

[13] KuenJ, WangZ, WangG. Recurrent attentional networks for saliency detection[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2016: 3668- 3677.

KuenJ, WangZ, WangG. Recurrent attentional networks for saliency detection[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2016: 3668- 3677.

[14] BousetouaneF, MorrisB. Fast CNN surveillance pipeline for fine-grained vessel classification and detection in maritime scenarios[C]. IEEE International Conference on Advanced Video and Signal Based Surveillance, 2016: 242- 248.

BousetouaneF, MorrisB. Fast CNN surveillance pipeline for fine-grained vessel classification and detection in maritime scenarios[C]. IEEE International Conference on Advanced Video and Signal Based Surveillance, 2016: 242- 248.

[15] Zhang MM, ChoiJ, DaniilidisK, et al. VAIS: a dataset for recognizing maritime imagery in the visible and infrared spectrums[C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition Workshops, 2015: 10- 16.

Zhang MM, ChoiJ, DaniilidisK, et al. VAIS: a dataset for recognizing maritime imagery in the visible and infrared spectrums[C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition Workshops, 2015: 10- 16.

[16] NairV, Hinton GE. Rectified linear units improve restricted Boltzmann machines[C]. Proceedings of the 27 th International Conference on Machine Learning , 2010: 807- 814.

NairV, Hinton GE. Rectified linear units improve restricted Boltzmann machines[C]. Proceedings of the 27 th International Conference on Machine Learning , 2010: 807- 814.

[17] ZhangY, WuJ, CaiJ. Compact representation for image classification: to choose or to compress?[C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2014: 907- 914.

ZhangY, WuJ, CaiJ. Compact representation for image classification: to choose or to compress?[C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2014: 907- 914.

[18] YeP, KumarJ, DoermannD. Beyond human opinion scores: blind image quality assessment based on synthetic scores[C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2014: 4241- 4248.

YeP, KumarJ, DoermannD. Beyond human opinion scores: blind image quality assessment based on synthetic scores[C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2014: 4241- 4248.

刘峰, 沈同圣, 马新星. 特征融合的卷积神经网络多波段舰船目标识别[J]. 光学学报, 2017, 37(10): 1015002. Feng Liu, Tongsheng Shen, Xinxing Ma. Convolutional Neural Network Based Multi-Band Ship Target Recognition with Feature Fusion[J]. Acta Optica Sinica, 2017, 37(10): 1015002.