基于图卷积网络的深度学习点云分类模型  下载: 1790次

下载: 1790次

1 引言

点云分类是点云处理领域中十分重要的一项任务。传统的点云分类方法是通过手工提取的特征来捕捉点云的几何属性[1-3],但手工提取无法完全利用三维点云的全部信息,即该方法的分类精度存在瓶颈。深度学习兴起之后,研究者开始探索利用深度神经网络学习点云特征。典型的处理方法是将点云数据转换为体素表示,进而在三维深度学习模型上进行特征提取,完成分类任务。三维体素的表示形式完整地保留了原始三维形状信息,因而具有较好的特征鉴别力,但是该方法对内存的开销很大,导致在实际情况下无法使用分辨率高的体素网络。斯坦福大学的Charles等[4]提出PointNet模型,开创性地利用深度网络直接处理不规则的三维点云数据,模型以原始的点云作为输入,是一个可以同时进行分类和分割的联合结构,在分类任务上取得了较好的效果。但该模型仍存在一个明显的不足,即没有考虑到点云的局部结构,这也导致其识别细粒度模式的能力及对复杂场景的泛化能力较差。本文针对此问题,设计一个基于图卷积网络的分类模型,提出一个

2 算法描述

2.1 图卷积网络

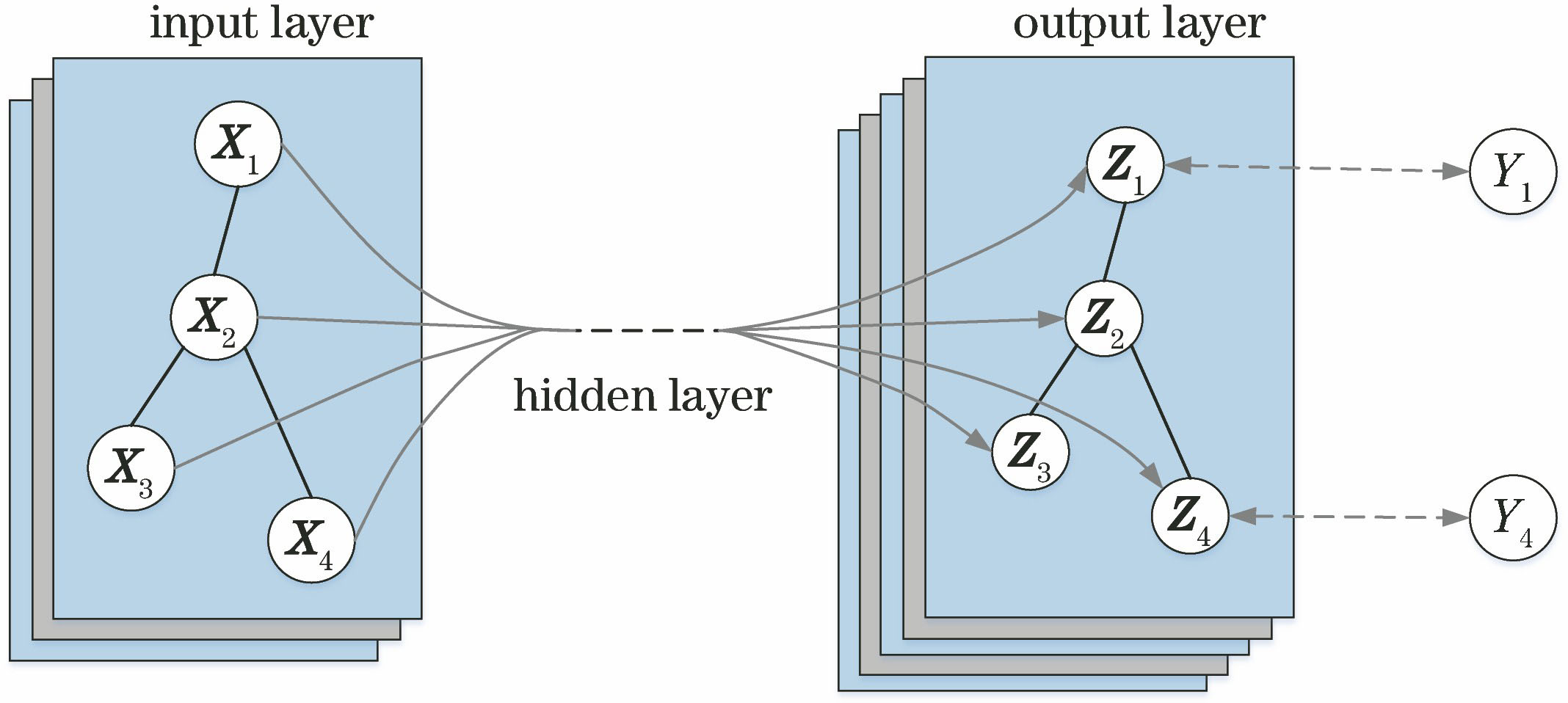

卷积网络在计算机视觉领域已经取得了巨大的成功,受此启发,研究者开始在图数据上进行卷积操作,这些研究统称为图卷积网络(GCN)[5-7]。GCN的模型框架如

现有的图卷积网络可以分为两类:基于谱的图卷积网络和基于空间的图卷积网络。基于谱的图卷积网络在谱图理论的框架下提出一种CNNs的表达式,利用图信号处理中的滤波器来定义图卷积,图信号中的噪声可以通过图卷积运算去除[8];基于空间的图卷积网络将图卷积定义为来自邻居的特征信息的聚合[9]。本文中的图卷积结构参考基于空间的图卷积网络,利用

2.2 基于图卷积网络的点云分类模型设计

本文在PointNet体系结构基础上,改进点云信息编码方式,提出一个

网络的原始输入是一个

模型

式中,(

边缘函数和聚合操作的选择对

边缘函数选择:PointNet中只编码了全局形状信息而没考虑局部邻域结构,导致其识别细粒度特征的能力受到限制。考虑点云的局部特征,即关注点和邻近点之间的联系,将边缘函数定义为

(1)式将三维形状看作是多个patch的集合,编码时考虑到点云的局部特征,从而得到更好的分类效果。

聚合函数的选择:图的邻接矩阵表示节点的局部连接,与图像的卷积运算不同的是,图中相邻的节点无法区分。节点

式中,

3 实验及结果分析

为评估模型的分类效果,在ModelNet40数据集上进行训练和测试。该数据集包含用于训练深度网络的40个类别的12311个CAD模型。根据官方的训练和测试标准,有9843个形状用于训练,2468个形状用于测试。实验在Ubuntu14.04.5系统下进行,配置显卡GTX 1060,Python 2.7,TensorFlow-GPU 1.2.0,实验数据集为Princeton ModelNet40。

分类结构中,

表 1. 参数设置

Table 1. Parameter settings

|

为获得三维点云,从ModelNet40中每个物体形状的网格面上均匀采样1024个点,并将它们归一化到一个单位球面[10]。部分采样结果如

表 2. 几种模型在ModelNet40上的分类精度和计算复杂度对比

Table 2. Comparisons of classification accuracy on ModelNet40 and computational complexity of several models

|

将模型在ModelNet40数据集上的分类准确率与其他三维模型分类网络输出精度作对比,同时也比较模型的复杂性,衡量指标为forward time,如

由

为验证

由

表 3. 不同k值下分类精度对比

Table 3. Comparison of classification accuracy under different k values

|

4 结论

设计并实现一种基于图卷积网络的深度学习点云分类模型。该模型考虑点云的局部特征对点云分类的重要作用,在PointNet模型的结构基础上,加入一个

[1] 雷钊, 习晓环, 王成, 等. 决策树约束的建筑点云提取方法[J]. 激光与光电子学进展, 2018, 55(8): 082803.

[2] 佟国峰, 杜宪策, 李勇, 等. 基于切片采样和质心距直方图特征的室外大场景三维点云分类[J]. 中国激光, 2018, 45(10): 1004001.

[3] 贾勇杰, 熊风光, 韩燮, 等. 基于SHOT的多尺度关键点检测技术研究[J]. 激光与光电子学进展, 2018, 55(7): 071013.

[4] Charles RQ, SuH, KaichunM, et al. PointNet: deep learning on point sets for 3D classification and segmentation[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 652- 660.

[5] Li YG, YuR, ShahabiC, et al. Diffusion convolutional recurrent neural network: data-driven traffic forecasting[J/OL]. ( 2018-02-22)[2019-2-20]. https:∥arxiv.org/abs/1707. 01926.

[6] YuB, Yin HT, Zhu Z X. Spatio-temporal graph convolutional networks: a deep learning framework for traffic forecasting[J/OL]. ( 2018-07-12)[2019-2-20]. https:∥arxiv.org/abs/1709. 04875.

[7] Yan SJ, Xiong YJ, Lin DH. Spatial temporal graph convolutional networks for skeleton-based action recognition[C]∥The Thirty-Second AAAI Conference on Artificial Intelligence (AAAI-18), February 2-7, 2018, Hilton New Orleans Riverside, New Orleans, Louisiana, USA. New York: AAAI, 2018: 7444- 7452.

[8] JainA, Zamir AR, SavareseS, et al. Structural-RNN: deep learning on spatio-temporal graphs[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 5308- 5317.

[10] Cignoni P, Callieri M, Corsini M, et al. Meshlab: an open-source mesh processing tool[J]. Eurographics Italian Chapter Conference, 2008, 2008: 129-136.

[11] Wu ZR, Song SR, KhoslaA, et al. 3D ShapeNets: a deep representation for volumetric shapes[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 7-12, 2015, Boston, MA, USA. New York: IEEE, 2015: 1912- 1920.

[12] MaturanaD, SchererS. VoxNet: a 3D convolutional neural network for real-time object recognition[C]∥2015 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS), September 28-October 2, 2015, Hamburg, Germany. New York: IEEE, 2015: 922- 928.

[13] Qi CR, YiL, SuH, et al. Pointnet++: deep hierarchical feature learning on point sets in a metric space[C]∥Advances in Neural Information Processing Systems, December 4-9, 2017, Long Beach Convention Center, Long Beach. New York: NIPS, 2017: 5099- 5108.

[14] KlokovR, LempitskyV. Escape from cells: deep kd-networks for the recognition of 3D point cloud models[C]∥2017 IEEE International Conference on Computer Vision (ICCV), October 22-29, 2017, Venice, Italy. New York: IEEE, 2017: 863- 872.

王旭娇, 马杰, 王楠楠, 马鹏飞, 杨立闯. 基于图卷积网络的深度学习点云分类模型[J]. 激光与光电子学进展, 2019, 56(21): 211004. Xujiao Wang, Jie Ma, Nannan Wang, Pengfei Ma, Lichaung Yang. Deep Learning Model for Point Cloud Classification Based on Graph Convolutional Network[J]. Laser & Optoelectronics Progress, 2019, 56(21): 211004.