一种应用于光遗传激光投影系统的目标检测算法  下载: 923次

下载: 923次

1 引言

目前,光遗传学技术已经成为神经科学研究的重要工具。该技术使用光学信号刺激细胞膜上的光敏离子通道,从而调控神经细胞活性,对动物活动进行空间和时间上的精确控制[1-2]。然而,典型的光遗传学实验通常需要在动物(比如小鼠)体内植入光纤进行光传输[3],在许多行为测试中,这种有线光源系统阻碍了动物的自由移动,使得动物行为分析复杂化。随着计算机视觉的不断发展,Wang等[4]提出使用传统的图像检测方法确定动物的位置,配合机械控制系统对其进行无线光传输。传统的图像检测方法受光照等环境因素的影响较大,很容易导致检测失败,而光遗传实验需要对动物进行实时准确的光传输,所以需要一种检测速度极快、检测精度较高、鲁棒性强的目标检测算法用于无线光传输。

近年来,卷积神经网络(CNN)已经成为一种从数据中自动学习特征表示的有效方法[5],基于CNN的目标检测算法在计算机视觉领域越来越受欢迎[6]。文献[ 7]提出的Faster RCNN (Faster Region Convolutional Neural Networks)采用双步检测策略,将检测过程分为候选区域生成阶段和区域分类阶段,可以大大提高目标的检测精度。但是由于两个阶段需要交互,无法满足实时检测要求。文献[ 8]提出了采用单步检测策略的YOLO网络结构,将目标检测问题转化为回归问题,极大地提高了检测速度。文献[ 9]提出的SSD(Single Shot multibox Detector)网络结构,结合了YOLO网络的端到端和Faster RCNN的锚点思想来提高物体的检测能力。YOLOv2网络[10]在YOLO网络的基础上添加了锚点,并使用K-means[11]算法自动训练边界框以找到更好的目标检测框,从而能够更容易、更准确地检测物体的位置。YOLOv3[12]网络在Darknet-53的基础上使用了网络适应特性,极大地提高了目标检测精度。

基于CNN的目标检测算法的鲁棒性以及检测精度、速度与传统的目标检测算法相比都有较大提升,而YOLOv3网络是当前目标检测算法满足无线光传输的最优秀算法之一。为了给光遗传实验提供更为稳定的实验环境,本文提出一种基于YOLOv3网络的改进型网络,使用分组卷积的方法减少网络参数,从而减少卷积计算量,加快检测速度。同时,为了提高检测精度,用焦点损失函数替换交叉熵损失函数。为了证明该网络可以应用于光遗传学实验,本文设计了激光投影系统,并采用小鼠图像作为检测对象,制作了小鼠图像数据集。结果表明,改进型网络的检测速度和检测精度都优于YOLOv3网络,完全可以对光遗传学实验中的小鼠图像进行实时目标检测,更好地满足了激光投影系统的需求。

2 基本原理

2.1 激光投影系统结构

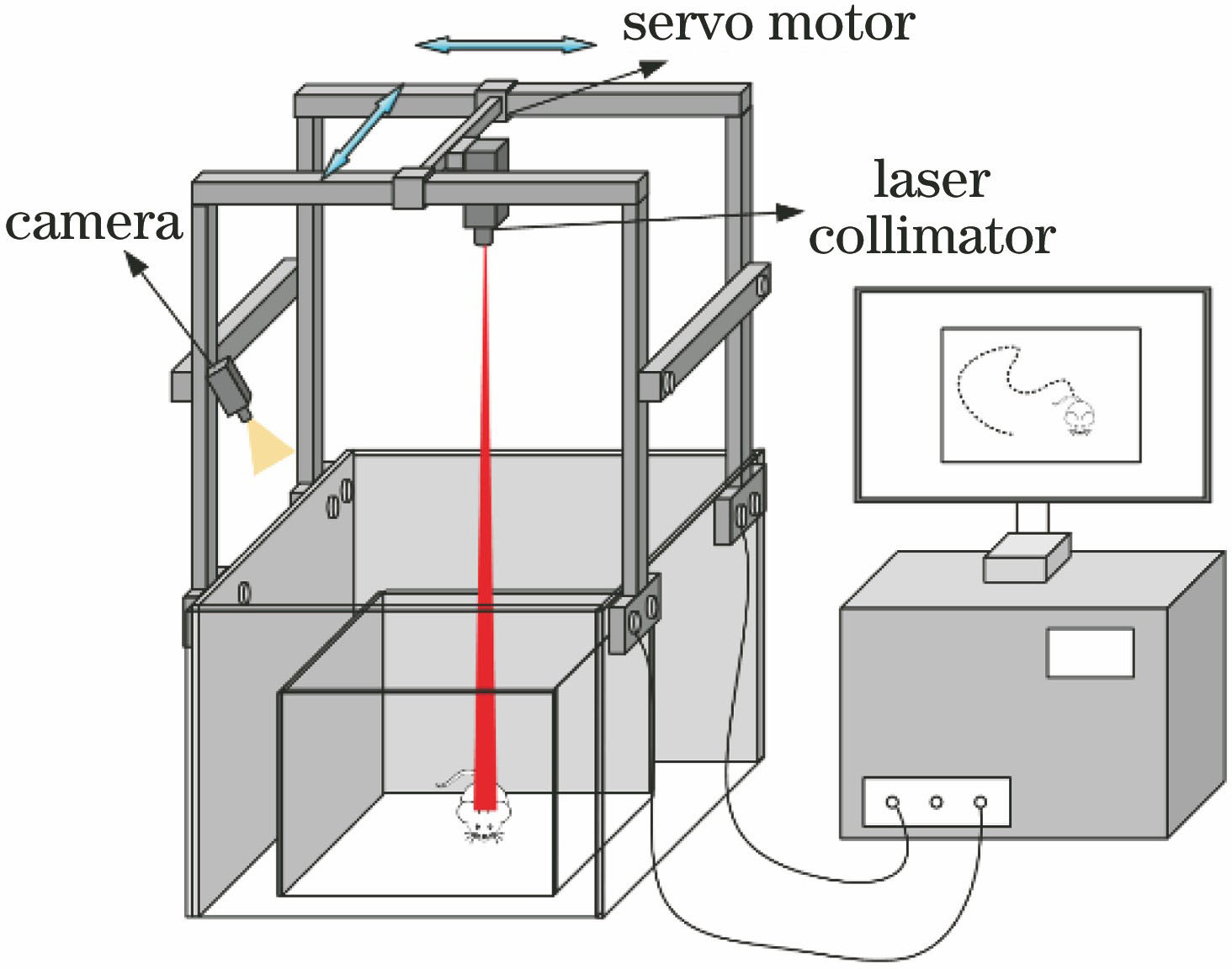

为了实现小鼠头部实时、准确的无线光传输,记录小鼠的行走路径、运动体态,以及满足垂直照射小鼠头部的要求,设计了用于光遗传学实验的激光投影系统,如

激光投影系统使用工字导轨结构,满足了光遗传实验垂直照射小鼠头部的要求;激光准直器和目标检测等模块的配合使用,可以实现对小鼠头部的自动追踪;相机传感器实时记录小鼠的行走路径和运动体态,为光遗传实验的后续分析提供了有效数据。因此,该系统为光遗传实验提供了一种全新的实验环境。

2.2 网络结构

YOLOv3网络由Darknet-53特征提取网络和检测定位网络组成,如

为了压缩网络参数,改进型网络使用分组卷积的方法替换Darknet-53特征提取网络中的标准卷积。使用分组卷积[13]的方法(分为4组)进行3×3卷积以获得特征图;采用通道混洗[14]增强网络间的信息流通能力。因为在第一层卷积必须从输入图像中获得尽可能多的特征,所以该卷积层使用标准卷积。

2.3 分组卷积

分组卷积是一种特殊的稀疏连接卷积。分组卷积操作流程如

假设分组数为G,则分组卷积的计算量N可以表示为

分解卷积与标准卷积的计算量比例关系式可以表示为

从(3)式可以得到,分组卷积的卷积计算量是标准卷积的1/G,减少的计算量与分组数成正比。

在分组卷积降低网络卷积的计算量的同时,由于将特征图进行了分组,这会导致各组之间的特征图存在信息不通畅的问题,这无疑会影响网络的检测精度。为了解决这一问题,采用通道混洗的方法。将各组特征图的通道进行切割重组,可以增强网络之间的信息流通,提高信息表达能力,通道混洗原理如

图 3. 分组卷积。(a)操作流程;(b)通道混洗

Fig. 3. Packet convolution. (a) Operation flow; (b) channel shuffle

2.4 损失函数

评价一种目标检测算法的优劣,除了检测速度要求外,还有一个重要指标,即检测精度。本文网络是基于YOLOv3网络改进的目标检测方法,属于单步检测方法。文献[ 15]指出单步检测方法的检测精度不如双步检测方法,原因在于没有很好地解决正负样本分布不均衡的问题。本文网络中采用了焦点损失函数,在交叉熵损失函数的基础上增加两个超参数,可解决分布不均衡的问题。对于二分类,标准的交叉熵损失函数(C)为

式中:y∈

式中:pt为不同类别的分类概率;γ是大于0的值;αt是属于

3 分析与讨论

3.1 实验准备

实验需要的小鼠图像数据集委托天津大学生命科学学院进行采集。考虑到实验环境影响检测性能,在图像采集的过程中使用了多角度拍摄以及不同的照明条件。实验一共采集了1500张形态各异、不同颜色的小鼠图像。为了增强实验数据集的丰富性,将收集的图像在颜色、亮度、旋转等方面进行了图像预处理,增强后的图片数量达到15000张,并按照8∶2的比例分为训练集和测试集,部分图像数据集图片如

实验中网络搭建和训练环境如下:GPU型号为NVIDIA RTX2080,64位Windows10操作系统以及TensorFlow 1.8.0版本。训练迭代次数调整为70000次,初始学习率、权重衰减正则化参数等与YOLOv3网络设置一致,学习率在40000步后降至0.0001,在50000步后降至0.00001。

3.2 检测实验

焦点损失函数中有两个超参数γ和αt,其值直接影响网络的性能。因此,实验首先需要确定γ和αt的值。超参数使用不同值时,改进型网络在测试集中取得的均值平均精度(mAP)如

改进型YOLOv3网络、SSD网络及YOLOv3网络在小鼠图像数据集的准确率(Precision)与召回率(Recall)结果曲线,如

图 6. 不同算法在小鼠图像数据集上的召回率与准确率结果曲线

Fig. 6. Recall and precision results of different algorithms on mouse image dataset

不同主流检测网络及改进型YOLOv3网络在小鼠图像数据集及PASCAL VOC2007[16]数据集上的mAP值和检测时间如

由

表 1. 不同算法的精度与速度结果

Table 1. mAP and speed results of different algorithms

| |||||||||||||||||||||||||||||

不同算法的小鼠图像检测对比如

图 7. 不同算法的小鼠图像检测对比。(a)(e) Faster RCNN;(b)(f) SSD;(c)(g) YOLOv3;(d)(h)改进型YOLOv3

Fig. 7. Comparison of mouse image detection with different algorithms. (a)(e) Faster RCNN; (b)(f) SSD; (c)(g) YOLOv3; (d)(h) proposed YOLOv3

4 结论

结合YOLOv3网络出色的目标检测实时性与准确性,提出一种改进型YOLOv3目标检测网络用于辅助光遗传实验。为了提高检测速度与检测精度,使用了分组卷积和改进交叉熵损失函数的方法。实验结果表明,改进后的网络对小鼠头部图像的检测精度达到90.3%,检测速度达到26 ms,优于传统的YOLOv3网络,完全可以满足激光投影系统对小鼠进行实时检测的要求。提出的激光投影系统可以为光遗传实验提供稳定可靠的无线光传输环境,使小鼠可以自由移动,并且进一步改善脑部神经刺激范围,为远程控制小鼠脑部的神经活动开辟了新的可能性。

[2] Boyden E S, Zhang F, Bamberg E, et al. Millisecond-timescale, genetically targeted optical control of neural activity[J]. Nature Neuroscience, 2005, 8(9): 1263-1268.

[3] Zhang F, Gradinaru V, Adamantidis A R, et al. Optogenetic interrogation of neural circuits: technology for probing mammalian brain structures[J]. Nature Protocols, 2010, 5(3): 439-456.

[4] Wang Y, Lin X D, Chen X, et al. Tetherless near-infrared control of brain activity in behaving animals using fully implantable upconversion microdevices[J]. Biomaterials, 2017, 142: 136-148.

[5] 龙鑫, 苏寒松, 刘高华, 等. 一种基于角度距离损失函数和卷积神经网络的人脸识别算法[J]. 激光与光电子学进展, 2018, 55(12): 121505.

[6] 欧攀, 张正, 路奎, 等. 基于卷积神经网络的遥感图像目标检测[J]. 激光与光电子学进展, 2019, 56(5): 051002.

[7] Ren S Q, He K M, Girshick R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149.

[8] RedmonJ, DivvalaS, GirshickR, et al. You only look once: unified, real-time object detection[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 779- 788.

[9] LiuW, AnguelovD, ErhanD, et al. SSD: single shot MultiBox detector[M] ∥Leibe B, Matas J, Sebe N, et al. Computer vision-ECCV 2016. Lecture notes in computer science. Cham: Springer, 2016, 9905: 21- 37.

[10] RedmonJ, FarhadiA. YOLO9000: better, faster, stronger[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 6517- 6525.

[11] Tang X L, Yang W, Hu X S, et al. A novel simplified model for torsional vibration analysis of a series-parallel hybrid electric vehicle[J]. Mechanical Systems and Signal Processing, 2017, 85: 329-338.

[12] RedmonJ, Farhadi A. Yolov3: an incremental improvement[EB/OL]. ( 2018-04-08)[2018-09-07]. https:∥arxiv.org/abs/1804. 02767.

[13] HuangG, Liu S C, van der Maaten L, et al. CondenseNet: an efficient DenseNet using learned group convolutions[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE, 2018: 2752- 2761.

[14] Zhang XY, Zhou XY, Lin MX, et al. ShuffleNet: an extremely efficient convolutional neural network for mobile devices[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE, 2018: 6848- 6856.

[15] Lin T Y, Goyal P, Girshick R, et al. Focal loss for dense object detection[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 1.

史再峰, 叶鹏, 孙诚, 罗韬, 王汉杰, 潘惠卓. 一种应用于光遗传激光投影系统的目标检测算法[J]. 激光与光电子学进展, 2020, 57(6): 061503. Zaifeng Shi, Peng Ye, Cheng Sun, Tao Luo, Hanjie Wang, Huizhuo Pan. Object Detection Algorithm Applied to Optical Genetic Laser Projection System[J]. Laser & Optoelectronics Progress, 2020, 57(6): 061503.