基于多尺度残差注意力网络的壁画图像超分辨率重建算法  下载: 979次

下载: 979次

1 引言

古代壁画具有十分重要的文化、社会、人文、艺术和历史价值,但由于环境变迁、人为活动等外在因素以及绘画材料、绘制环境等内在因素的影响,许多存留数百年甚至上千年的珍贵壁画出现了严重的质变[1]。近年来,国内针对丝绸之路沿线各石窟的壁画开展了一系列保护工作。其中,壁画图像的数字化[2]处理与展示有效提高了壁画保护等相关工作的效率和质量。

单幅图像超分辨率(SISR)重建技术是从单幅低分辨率(LR)图像中重建出高分辨率(HR)图像。该技术可以使重建后的壁画图像展现出更丰富的高频细节信息,有效提升壁画图像的展示效果,对石窟壁画图像的数字化展示具有推动作用。SISR技术按原理可分为基于插值、基于重建和基于学习的方法。简单的插值方法如双三次插值法[3],计算简捷且能增加图像的细节信息,但当图像分辨率增加时,会出现震荡和伪影。基于重建的方法,如迭代反向投影(IBP)法[4],改善了插值法引起的图像过平滑问题,但其重建性能依赖于精准的图像配准,在实际应用中很难实现。基于学习的方法,通过学习HR图像和LR图像之间的特征映射进行超分辨率图像重建,如Zhu等[5]提出的邻域嵌入(NE)方法,Yang等[6]提出的稀疏编码方法。这类方法重建效率高,但通常需要预先指定字典原子数量以及噪声方差模型等,且图像重建中所需的最优参数只能通过试验方法获取。

基于深度学习的重建方法通过端到端的自主学习方式,运用逐层特征逼近的方法提高LR图像的重建质量,得到了广泛关注。Dong等[7]提出了基于卷积神经网络的图像超分辨率重建(SRCNN)算法,该模型利用3层卷积神经网络(CNN),从高低分辨率空间中学习了一种端到端的非线性映射,相比传统方法的重建效果有显著提升。为了提高网络模型的训练速度,Shi等[8]直接对LR图像进行特征提取,通过亚像素卷积层将特征图像进行重新排列,提出了基于亚像素卷积的SISR重建模型。为了提取更多的图像特征,Kim等[9]加深了卷积层数,提出了一个20层的极深卷积神经网络超分辨率(VDSR)重建模型,该模型充分利用大型图像区域上下文之间的信息,提高了图像的重建质量。为了解决网络层数加深带来的参数增加问题,Kim等[10]提出了深度递归卷积网络(DRCN),该网络在执行更多的递归时不会增加参数,使网络能快速收敛。近年来,人们发现神经网络模型可以捕捉到通道关联性,可通过在网络模型中嵌入相应的学习机制改善网络的学习性能。Hu等[11]充分考虑了图像的全局信息,通过对卷积特征在各个通道之间的作用关系进行精确建模,改善了网络模型的表达能力。

上述方法以自然图像为处理对象时均获得了较好的重建结果。但对于具有线描轮廓、特定艺术风格,纹理特征丰富、细节多变的壁画图像而言,还需进一步完善的地方:1)部分方法通过单纯地增加网络深度增强模型获取壁画图像特征的能力,但在深层映射过程中,会丢失许多重要的低频信息,影响模型的收敛性能;2)由于壁画图像结构信息的尺度不同,单一尺度的特征提取无法利用局部区域之外的上下文信息,完全恢复壁画图像的中高频特征信息;3)部分方法在超分辨率重建时忽略了特征通道间的相互依赖性,从而减弱了网络对壁画图像特征细节的逼近能力。

综上所述,根据壁画图像的纹理和结构特征,本文借鉴残差网络的设计思想,提出了一种基于多尺度残差注意力网络的壁画图像超分辨率重建算法,通过多尺度特征提取壁画图像的上下文信息。在深度残差映射阶段,通过级联若干残差通道注意力块,促进特征信息的快速流通,使其通道注意力机制专注于壁画图像的高频纹理和边缘信息,从而增强网络的表达能力,提升了网络对壁画图像边缘信息和纹理区域的重建精度。实验结果表明,本算法可以减小重建误差,增强重建壁画图像的结构和纹理信息,使重建壁画图像的细节更加丰富。

2 相关工作

2.1 残差学习

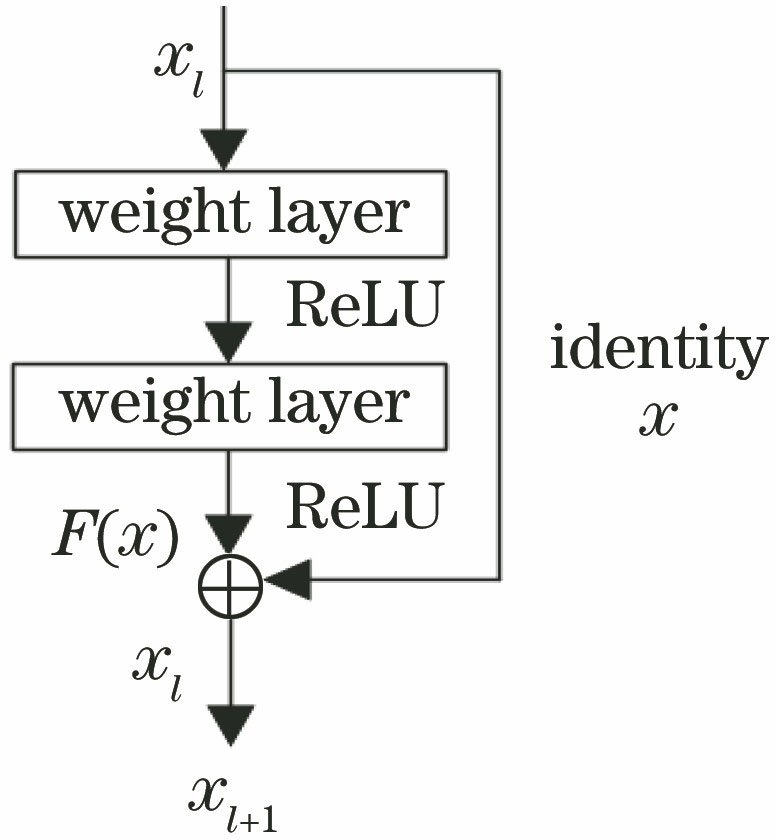

传统CNN随着网络深度的增加会出现退化现象,且在信息传递时存在信息丢失、损耗等问题。残差网络(ResNet)[12]可通过将输入信息快速连接到输出解决该问题,增强了信息的完整性。同时网络主要学习输入与输出之间的残差部分,大大减小了网络学习的复杂度。依据ResNet,结合恒等残差映射[13]的思想,对图像的深度特征进行提取。其中,残差块(residual block)由前馈卷积网络加上一个恒等跳跃连接组成。相比标准网络,ResNet减少了收敛损失,也不会因为梯度消失而产生过拟合,使网络更容易优化,从而保证输出特征的表达能力。实验使用的残差学习块结构如

式中,函数F(x)为残差映射函数,xl为第l层残差块的输入,xl+1为残差块的输出。

2.2 通道注意力机制

在不增加特征维度的前提下,对特征通道间的非线性相关性进行建模,以增强网络的深度表达能力。采用特征重新标定策略[14],通过学习的方式自动获取每个特征通道的重要程度,从而实现特征通道的自适应校准,通道注意力机制结构如

使用全局平均池化方法[15]将网络上一级输入的特征通道空间信息转换为通道描述符,并将其设置为x=[x1,…,xc-1,xc]的输入,其具有尺寸为H×W的c个特征映射。通道统计z∈Rc可以通过空间维度H×W收缩x得到,Rc为特征映射图进行全局平均池化后的特征通道,z的第c个元素可表示为

式中,xc(i,j)为第c个特征在(i,j)处的通道特征值,HGP(·)为全局池化功能,该通道统计方式有助于表达整个图像。

为了从全局平均池化后的聚合信息中完全捕获通道相关性,引入了Sigmoid函数的简单门控机制,该机制能够学习通道之间的非线性相互作用,可表示为

式中,f(·)和δ(·)分别为s形门控和ReLU函数,WD为conv层的权重,以比率r减少通道数。再通过ReLU函数激活后,用权重WU以比率r增加通道数,获得最终的通道统计数据s,用s重新调整输入xc,可表示为

式中,sc为第c个通道的缩放因子,残差通道注意力块中的残差分量被自适应的进行缩放。

3 本文算法

相比自然风景和纹理图像,壁画图像具有丰富的结构信息,如佛陀、菩萨、天王、弟子、飞天、供养人、建筑、植被、动物,且画面上通常包含大量复杂的纹理信息和重复性图案,极具艺术风格。壁画图像的结构和纹理特征具有不同的尺度,因此需用不同尺度的特征提取层,直接对目标壁画图像的特征信息进行多尺度提取。实验使用的特征提取层由1×1、3×3、5×5、7×7四种不同尺度的卷积层并列组成,采用级联方式将提取的多尺度信息合并重组,构成新的特征图。该过程可表示为

式中,F1为对多尺度映射单元特征进行提取融合操作后得到的特征图,F2为进行映射操作f后得到的图像,n=4为多尺度卷积核的数量,W和B分别为该网络的权重和偏置,ILR为LR壁画图像,Φ(x)为激活函数。

考虑到壁画图像的线描边缘和纹理区域信息在深层映射阶段容易丢失,从而导致重建壁画图像出现边缘锯齿状、纹理模糊的问题。实验在深层映射过程中,使用尺寸较小的卷积核,结合残差结构和通道注意力机制,保证了壁画图像特征和边缘信息的完整性。在深度残差映射阶段,将融合后的特征图输入残差结构进一步提取特征。深度残差映射部分包含g个残差通道注意力块(RCAB)和长跳跃连接(LSC)。LSC可以确保特征信息的快速流通和完整性。而注意力机制的引入可以通过自动校准特征通道的权重增强网络的表达能力。第g个残差注意力块可表示为

式中,Fg-1和Fg分别为残差通道注意力块的输入和输出,Rg为通道注意力函数,Xg为残差块输入F2学习的残差部分,主要包含两个堆叠的卷积层,

式中,Hg为残差通道注意块函数,WLSC为残差映射尾部设置的卷积层权重,FDF为经最后一个残差注意力块输出的特征图。

最后,将通过残差通道注意力块深层映射后的特征图输入亚像素卷积层[8]进行重建,得到放大r倍的HR图像。重建过程可表示为

式中,HREC为经CNN输出的HR壁画图像,XPS为一个周期变换算子,可将一个H×W×C×r2的张量重新排列成一个形状为rH×rW×C的张量

4 网络结构

通过结合GoogleNet[16]中的Inception block和Resnet中的Residual learning block,拓展了网络的宽度和深度,以增强模型的特征提取能力,提升壁画图像重建的质量。该网络的构如

4.1 特征提取

在特征提取阶段,从输入层输入尺寸为27 ×27的LR壁画图像,然后通过尺寸为3×3的卷积层使通道数增加到128个,再经过尺寸为1×1的卷积层将特征通道压缩为4r2个(r为重建壁画图像的上采样倍数)。为了有效聚合4r2个特征图的局部信息,用多尺度卷积层进行特征映射。多尺度卷积层包含1×1、3×3、5×5、7×7四个尺寸不同且平行的滤波器。设置步长stride为1,填充边界padding为0,1,2,3,且每个滤波器都输出r2个特征图,然后将4r2个特征图结合并输出,以获得更佳的特征映射效果。其中,尺寸为3×3的卷积层提取的特征映射图比较清晰,梯度线条也更加锐利。而尺寸为5×5、7×7的卷积层在特征提取时能够获得较大感受野的特征映射图,可以利用壁画图像的局部特征信息,提取更为全局、语义层次更高的特征。

4.2 特征映射

为了进一步对壁画图像进行特征提取,将通道注意力机制嵌入残差学习块,构成的RCAB结构如

4.3 网络训练与优化

用L1损失函数训练优化网络参数,给定壁画图像训练集{

式中,θ为网络在训练优化时的权重和偏置,‖‖2为2范数。用Adam[17]算法优化网络,训练开始阶段,学习率为1×10-3,迭代次数为100000。在训练过程中,观察损失函数,动态微调学习率,最低将其降至1×10-4,网络的动量和权值衰减参数分别为0.9和10-4。

5 实验设置与结果分析

5.1 实验环境与数据集

按照佛像、飞天、藻井的类别,组成HR壁画图像集。每类约采集150幅图像,图像尺寸为300 pixel×300 pixel。训练集从每类数据集中随机选取60幅,共180幅,测试集从每类数据集中随机选取15幅,共45幅。为了获取更多的数据样本,提高网络的超分辨率重建准确率,对训练集图像进行旋转和缩放处理,在分别旋转90°、180°和270°的基础上,再按照0.9、0.8、0.7、0.6的系数缩小,共生成2160幅训练图像。对2160幅壁画图像进行r倍下采样得到LR图像集,LR图像的尺寸为27 pixel×27 pixel。实验环境:系统为Windows10,显卡为NIVIDIA GeForce GTX 1060,处理器是CPU为Intel Core i7-7700HQ,内存为16 G的台式机。在Pytorch1.1.0框架下训练和优化模型,软件配置包括python3.7,CudA10.1,Matlab R2014。

5.2 主观实验结果分析

用训练好的网络模型对训练集中的LR壁画图像进行超分辨率重建,以验证本算法的有效性。为保证实验结果的合理性,在测试集上选择具有代表性,且纹理细节丰富的三幅壁画图像进行测试和对比,并与双三次插值算法和SRCNN[7]、亚像素卷积神经网络(ESPCN)[8]和VDSR算法[9]的结果进行对比,其主观视觉对比和峰值信噪比(PSNR)如

图 5. 不同算法的重建结果。(a)原图;(b)双三次插值算法;(c) SRCNN算法;(d) ESPCN算法;(e) VDSR算法;(f)本算法

Fig. 5. Reconstruction results of different algorithms. (a) Original images; (b) bicubic interpolation algorithm; (c) SRCNN algorithm; (d) ESPCN algorithm; (e) VDSR algorithm; (f) our algorithm

5.3 客观实验结果分析

PSNR是使用最广泛的一种图像客观评价指标,因此,实验选取PSNR和结构相似度(SSIM)两种基于误差敏感的图像质量评价指标作为本算法重建性能的客观衡量指标,可表示为

式中,M×N为LR壁画图像的尺寸,f为真实的HR壁画图像,

5.3.1 网络层数的设置

为了验证加入残差通道注意力机制后网络深度对壁画重建质量的影响,选取佛像、飞天和藻井壁画各一幅,在上采样因子为3,残差通道注意力块为5,7,10时,对三幅壁画图像进行重建,结果如

表 1. 不同网络深度的重建图像质量

Table 1. Reconstructed image quality at different network depths

| |||||||||||||||||||||||||||||||||||||||||||||

5.3.2 残差通道注意力块对壁画重建的影响

选取佛像和藻井壁画图像各一幅,在上采样因子为3时,分别使用加入通道注意力机制的残差网络和标准的残差网络进行重建,结果如

图 6. 重建壁画图像的PSNR曲线。(a)佛像壁画;(b)藻井壁画

Fig. 6. PSNR curves of reconstructed mural image. (a) Buddha mural; (b) caisson mural

5.3.3 网络训练参数设置与运行时间的对比

将SRCNN、ESPCN、VDSR和本算法的参数量进行了对比,结果如

图 7. 不同重建算法的参数量和训练时间。(a)参数量;(b)训练时间

Fig. 7. Parameter amounts and training time of different reconstruction algorithms. (a) Parameter amount; (b) training time

5.3.4 壁画图像重建质量

为验证本算法的性能,从每类壁画中随机选取五幅,构成佛像壁画Test(a)、飞天壁画Test(b)、藻井壁画Test(c)测试集,分别在上采样因子为2、3、4时进行重建,重建壁画图像的PSNR、SSIM平均值如

表 2. 不同算法对壁画图像的测试结果

Table 2. Test results of mural images by different algorithms

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

6 结论

为了提升壁画图像的重建精度,改善壁画图像的视觉质量,通过多尺度残差注意力网络对壁画图像进行超分辨重建。首先,提取壁画图像的多尺度特征,获得不同感受野的特征映射图,以充分利用壁画图像的上下文信息。然后,在残差结构中嵌入通道注意力机制,确保特征信息的快速流通和完整性,并通过自动校准特征通道的权重,增强网络的表达能力。实验结果表明,本算法重建的壁画图像在客观指标和主观视觉上均优于其他几种经典的重建算法,且本算法搭建的网络模型收敛性能更好。

[1] 刘建明. 古代壁画图像保护与智能修复技术研究[D]. 杭州: 浙江大学, 2010.

Liu JM. Intelligent image processing and inpainting for ancient fresco preservation[D]. Hangzhou: Zhejiang University, 2010.

[2] Aswatha S M, Mukherjee J, Bhowmick P. An integrated repainting system for digital restoration of vijayanagara murals[J]. International Journal of Image and Graphics, 2016, 16(1): 1650005.

[3] BätzM, EichenseerA, SeilerJ, et al. Hybrid super-resolution combining example-based single-image and interpolation-based multi-image reconstruction approaches[C]∥2015 IEEE International Conference on Image Processing, September 27-30, 2015, Quebec City, Canada. New York: IEEE, 2015: 58- 62.

[4] Medoff B P, Brody W R, Nassi M, et al. Iterative convolution backprojection algorithms for image reconstruction from limited data[J]. Journal of the Optical Society of America, 1983, 73(11): 1493-1500.

[5] Zhu QD, SunL, Cai CT, et al. Image super-resolution via sparse embedding[C]∥Proceeding of the 11th World Congress on Intelligent Control and Automation, June 29-July 4, 2014, Shenyang, China. New York: IEEE, 2014: 5673- 5676.

[6] Yang J C, Wright J, Huang T S, et al. Image super-resolution via sparse representation[J]. IEEE Transactions on Image Processing, 2010, 19(11): 2861-2873.

[7] Dong C, Loy C C, He K M, et al. Image super-resolution using deep convolutional networks[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2016, 38(2): 295-307.

[8] Shi WZ, CaballeroJ, HuszárF, et al. Real-time single image and video super-resolution using an efficient sub-pixel convolutional neural network[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition, June 27-30 ,2016, Las Vegas, NV, USA. New York: IEEE, 2016: 1874- 1883.

[9] KimJ, Lee JK, Lee KM. Accurate image super-resolution using very deep convolutional networks[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition, June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 1646- 1654.

[10] KimJ, Lee JK, Lee KM, et al. Deeply-recursive convolutional network for image super-resolution[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition, June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 1637- 1645.

[11] HuJ, ShenL, AlbanieS, et al. Squeeze-and-excitation networks[EB/OL]. [2019-11-30].https:∥arxiv.org/abs/1709. 01507.

[12] He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition, June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 770- 778.

[13] He KM, Zhang XY, Ren SQ, et al. Identity mappings in deep residual networks[M] ∥Leibe B, Matas J, Sebe N, et al. Computer Vision-ECCV 2016. Lecture Notes in Computer Science. Cham: Springer, 2016, 9908: 630- 645.

[14] Zhang YL, Li KP, LiK, et al. Image super-resolution using very deep residual channel attention networks[EB/OL]. [2019-12-03].https:∥arxiv.org/abs/1807. 02758.

[15] YamanakaJ, KuwashimaS, KuritaT. Fast and accurate image super resolution by deep CNN with skip connection and network in network[M] ∥Liu D, Xie S, Li Y, Zhao D, et al. Neural Information Processing. ICONIP 2017. Lecture Notes in Computer Science. Cham: Springer, 2017, 10635: 217- 225.

[16] SzegedyC, LiuW, Jia YQ, et al. Going deeper with convolutions[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition, June 7-12, 2015, Boston, MA, USA. New York: IEEE, 2015: 1- 9.

[17] ShenH. Towards a mathematical understanding of the difficulty in learning with feedforward neural networks[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE, 2018: 811- 820.

[18] ChatfieldK, SimonyanK, VedaldiA, et al. Return of the devil in the details: delving deep into convolutional nets[EB/OL]. [2019-12-01].https:∥arxiv.org/abs/1405. 3531.

Article Outline

徐志刚, 闫娟娟, 朱红蕾. 基于多尺度残差注意力网络的壁画图像超分辨率重建算法[J]. 激光与光电子学进展, 2020, 57(16): 161012. Zhigang Xu, Juanjuan Yan, Honglei Zhu. Mural Image Super Resolution Reconstruction Based on Multi-Scale Residual Attention Network[J]. Laser & Optoelectronics Progress, 2020, 57(16): 161012.