协作稀疏字典学习实现单幅图像超分辨率重建  下载: 883次

下载: 883次

1 引言

图像超分辨率(SR)重建的目标是从低分辨率(LR)图像恢复出对应的高分辨率(HR)图像。成像设备由于受硬件成本、成像环境等的制约,获取图像的空间分辨率受到限制,因此对SR的研究得到了大量的关注。目前主流的SR方法主要分为:基于插值的方法、基于重建的方法和基于学习的方法。

传统基于插值的方法假设图像局部是线性光滑的,根据这一假设通过已知像素点估计待插值像素点。由于人类视觉感知系统对图像边缘信息更敏感,也有学者提出了边缘引导插值方法改善边缘信息[1-2]。基于插值的方法算法复杂度低,执行速度快,但在恢复图像边缘以及高频细节信息方面有较大的局限。

基于重建的方法将图像先验信息,如梯度轮廓[3]、非局部自相似性[4]等,作为约束条件引入SR重建模型。这类方法在保留图像边缘信息和抑制伪影方面有一定的改进,但是仍然面临作为约束条件的先验信息往往难以选择、建模参数难以估计等问题。

基于学习的方法通过训练样本图像学习LR和HR间的映射关系,然后利用学习到的映射关系将LR映射到HR实现SR重建。这类方法由于可以通过训练样本引入更丰富的高频细节信息而获得更好的重建质量,因此获得越来越多的关注。文献[ 5]提出局部线性嵌入(LLE)方法,该方法基于流形假设,利用近邻图像块间的局部线性性质实现SR重建。文献[ 6-7] 假设在合适的稀疏字典下,LR/HR图像块有相同的稀疏表示系数,并利用这一性质提出基于稀疏编码的超分辨率重建(SCSR)方法。文献[ 8]提出了一种耦合特征空间下的字典学习方法,在独立学习LR/HR字典的同时学习LR到HR稀疏表示系数间的映射矩阵。文献[ 9]将层次聚类与稀疏表示相结合,实现了一种新的基于层次聚类的图像超分辨率重建算法。随着深度学习理论的发展,基于深度学习的方法也开始应用于图像SR重建。文献[ 10-12]通过样本图像训练深度卷积神经网络,利用该网络将LR的插值图像映射到HR。文献[ 13]则通过在网络中引入去卷积层实现将LR直接映射到HR,也取得不错的效果。

传统基于学习的方法往往耗时较长。为改进时间效率,文献[

14]和[15]在SCSR基础上将

2 基于稀疏编码的图像超分辨率重建原理

在给定LR/HR稀疏字典对

式中

在求解得到LR图像块的稀疏表示系数

LR/HR稀疏字典对

式中

3 本文算法的实现

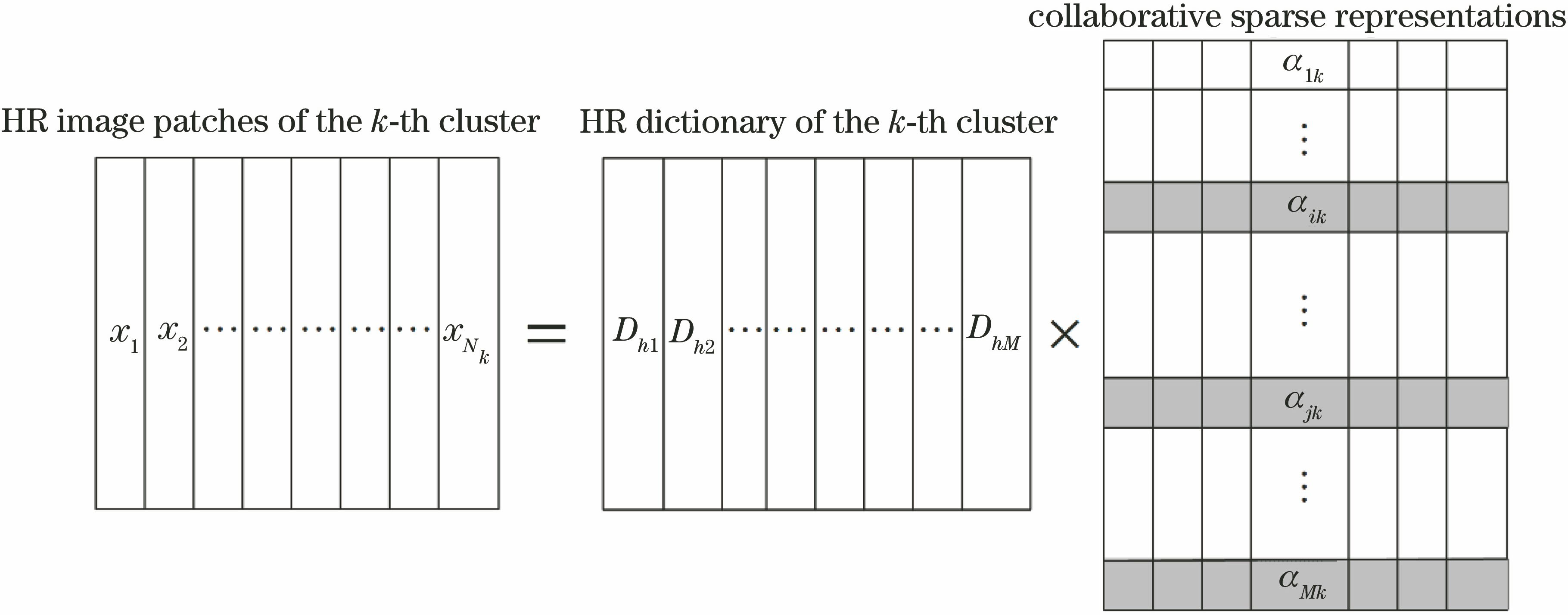

3.1 基于协作稀疏的LR/HR字典学习

与文献[

16]所述算法类似,在学习稀疏字典前,通过

式中

通过优化目标函数(5)式可以获得与各聚类相应的HR/LR字典。而(5)式是一个半凸函数,即当分别固定

对于第

这是一个凸优化问题,为实现快速收敛,应用交替方向乘子算法(ADMM)求解。为此,目标函数(6)式改写为如下等价形式:

其增广拉格朗日函数形式为

式中:

式中

式中

式中

当固定

进一步通过下式得到最优解:

通过以上方法,可得到与

3.2 基于稀疏编码的超分辨率图像重建

对于任意LR图像块

该模型有解析解:

待重建的HR图像块为

由于稀疏字典对

LR图像SR重建详细流程如下:

1) 分割LR图像得到一组图像块

2) 对每个图像块

3) 通过

4) 将映射得到的所有HR图像块(

4 实验结果

4.1 算法参数性能影响分析

为验证本文算法,采用文献[

6]提供的91幅图像作为样本图像进行训练。测试图像如

在字典学习阶段,为设置合适的迭代次数,分别测试了字典大小

聚类数

为测试不同字典大小

测试了参数

图 3. (a)目标函数(5)式随迭代次数增加而收敛的情况;(b)聚类数K取不同值时的平均PSNR;(c)字典大小M取不同值时的平均PSNR;(d)参数λ取不同值时的平均PSNR

Fig. 3. (a) Convergence of objective function Eq. (5) along with the increasing of iteration number; (b) average PSNR with different clustering number K; (c) average PSNR with different dictionary size M; (d) average PSNR with different λ

4.2 实验结果与性能比较

为评价本文算法性能,用本文算法对测试图片进行3倍超分辨率重建实验,并将测试结果与双三次方插值算法、局部线性邻域嵌入(NE+LLE)算法[5]、基于稀疏编码(SCSR)算法[6]、Zeyde算法[7]、锚定邻域回归(ANR)[14]及其改进的方法(A+)[15]和基于卷积神经网络(SRCNN)[10]等SR重建算法进行比较。待比较的基于学习的算法与本文算法一样,均采用文献[ 6]提供的91幅图像作为样本图像进行训练。

在训练阶段,HR图像块从样本图像中提取,图像块大小为9×9。LR图像块由对应的HR图像块经高斯模糊后下采样得到,采样因子为3。聚类因子设置为

实验结果如

表 1. PSNR (dB)与SSIM性能比较

Table 1. Performance of magnification in PSNR (dB) and SSIM

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

图 4. 不同方法实现第1幅图像超分辨率重建的视觉结果比较。(a)原始HR图像;(b) Bicubic算法;(c) NE+LLE算法;(d) SCSR算法;(e) Zeyde算法;(f) ANR算法;(g) A+算法;(h) SRCNN算法;(i)本文算法

Fig. 4. Visual comparisons of different SR results on No. 1 image using different methods.(a) Original HR image; (b) Bicubic algorithm; (c) NE + LLE algorithm; (d) SCSR algorithm; (e) Zeyde algorithm; (f) ANR algorithm; (g) A+ algorithm; (h) SRCNN algorithm; (i) proposed algorithm

图 5. 不同方法实现第3幅图像超分辨率重建的视觉结果比较。(a)原始HR图像;(b) Bicubic算法;(c) NE+LLE算法;(d) SCSR算法;(e) Zeyde算法;(f) ANR算法;(g) A+算法;(h) SRCNN算法;(i)本文算法

Fig. 5. Visual comparisons of different SR results on No. 3 image using different methods.(a) Original HR image; (b) Bicubic algorithm; (c) NE + LLE algorithm; (d) SCSR algorithm; (e) Zeyde algorithm;(f) ANR algorithm; (g) A+ algorithm; (h) SRCNN algorithm; (i) proposed algorithm

本文算法与其他基于学习的算法的平均重建耗时对比如

执行效率比其他算法有了显著提高;平均重建耗时与ANR算法和A+算法相当。可见,由于改进了稀疏字典学习算法,因此在图像重建质量上取得了更好的结果。

表 2. 不同算法的平均重建耗时

Table 2. Average running time of different methods

| |||||||||||||||||||||||

5 结论

提出了一种基于协作稀疏的LR/HR字典联合学习算法用于实现单帧图像SR重建。算法以图像的稀疏性作为先验约束条件,在训练阶段通过K-Means聚类算法将样本图像块划分为不同的类,并对不同的聚类训练相应的LR/HR字典。在训练字典时通过基于

[3] Yan Q, Xu Y, Yang X K, et al. Single image superresolution based on gradient profile sharpness[J]. IEEE Transactions on Image Processing, 2015, 24(10): 3187-3202.

[5] ChangH, Yeung DY, XiongY. Super-resolution through neighbor embedding[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2004, 1: 275- 282.

[7] ZeydeR, EladM, ProtterM. On single image scale-up using sparse-representations[C]∥International Conference on Curves and Surfaces, 2010, 6920: 711- 730.

[8] 詹曙, 方琪, 杨福猛, 等. 基于耦合特征空间下改进字典学习的图像超分辨率重建[J]. 电子学报, 2016, 44(5): 1189-1195.

[9] 曾台英, 杜菲. 基于层次聚类的图像超分辨率重建[J]. 光学学报, 2018, 38(4): 0410004.

[10] Dong C, Loy C C, He K M, et al. Image super-resolution using deep convolutional networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2016, 38(2): 295-307.

[11] 肖进胜, 刘恩雨, 朱力, 等. 改进的基于卷积神经网络的图像超分辨率算法[J]. 光学学报, 2017, 37(3): 0318011.

[12] 郑向涛, 袁媛, 卢孝强. 自外而内的单幅图像超分辨率复原算法[J]. 光学学报, 2017, 37(3): 0318006.

[13] 孙超, 吕俊伟, 李健伟, 等. 基于去卷积的快速图像超分辨率方法[J]. 光学学报, 2017, 37(12): 1210004.

[14] TimofteR, DeV, Gool LV. Anchored neighborhood regression for fast example-based super-resolution[C]∥IEEE International Conference on Computer Vision, 2013: 1920- 1927

[15] TimofteR, Smet VD, Gool LV. A+: Adjusted anchored neighborhood regression for fast super-resolution[C]∥Asian Conference on Computer Vision, 2014, 9006: 111- 126.

[18] MairalJ, BachF, PonceJ, et al. Non-local sparse models for image restoration[C]∥IEEE International Conference on Computer Vision, 2010: 2272- 2279.

[19] NieF, HuangH, CaiX, et al. Efficient and robust feature selection via joint l2,1-norms minimization[C]∥International Conference on Neural Information Processing Systems, 2010: 1813- 1821.

[21] Wright S J, Nowak R D. Figueiredo M A T. Sparse reconstruction by separable approximation[J]. IEEE Transactions on Signal Processing, 2009, 57(7): 2479-2493.

Article Outline

邱康, 易本顺, 向勉, 肖进胜. 协作稀疏字典学习实现单幅图像超分辨率重建[J]. 光学学报, 2018, 38(9): 0910002. Kang Qiu, Benshun Yi, Mian Xiang, Jinsheng Xiao. Collaborative Sparse Dictionary Learning for Reconstruction of Single Image Super Resolution[J]. Acta Optica Sinica, 2018, 38(9): 0910002.