结合全卷积神经网络与条件随机场的资源3号遥感影像云检测  下载: 1118次

下载: 1118次

1 引言

遥感影像中常存在云区遮挡问题,直接影响对地观测和地物提取,准确的遥感影像云区检测是保证影像后续分析与利用的重要前提。目前,遥感影像的云区检测方法有多种,但主要是利用可见光或近红外光谱阈值法进行云检测,原理是利用云的高反射率和低温特性而将云层与其他地物进行分离,该方法的优点是计算简单,检测效率高;缺点是当地面覆盖了冰、雪、沙漠,或云为薄卷云、层云、小积云时,由于大部分光谱方法只适用于特定的场景或是识别不同的云[1],很难将云和地面区分开来。随着卷积神经网络[2]方法的提出,陈洋等[3]采用卷积的方法进行遥感影像的云检测,有效地解决了由于资源3号卫星影像波段少、光谱范围受限而导致的阈值法检测效果不佳的问题,但该方法只能获得云检概率图,不能实现像素级的影像输出。2015年,Long等[4]提出了全卷积神经网络(FCN),用于图像的语义分割,将FCN-8s网络模型应用于遥感影像的云检测中,结果表明,该方法可以大致检测云区范围,实验结果精度为83.96%。

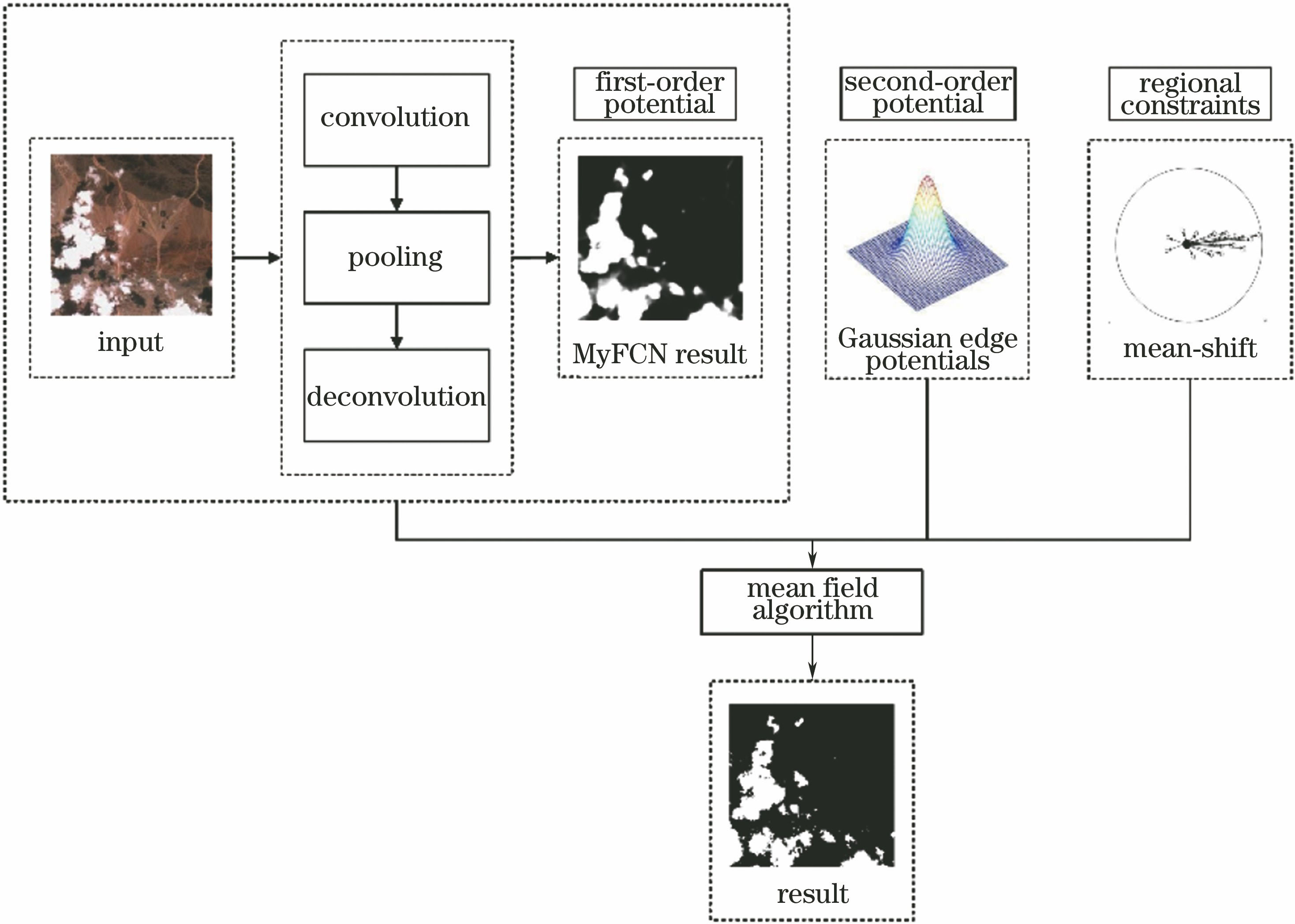

近年来,基于图论和概率论的概率图模型[5]被广泛应用于机器学习领域,1984年,马尔可夫随机场(MRF)[6]模型第一次被应用在图像处理工作中,并解决了关于图像分类的一些问题。2001年,Lafferty等[7]在MRF的基础上提出了条件随机场(CRF)模型,该模型可以有效利用观察图像与标签图像的上下文空间信息并直接对类后验概率进行建模[8-9]。早期的CRF模型多用于自然语言处理领域,直到2003年Kumar等[10]将CRF模型扩展到图像分割与分类,并推动了该领域的蓬勃发展。目前,关于FCN与CRF结合的研究在场景标记[11]、估计单目图像深度[12]、人体姿态估计[13]等方面均有所成绩,但在遥感图像检测领域的应用甚少。本文提出一种结合FCN与CRF的资源3号遥感影像的云检测算法,首先优化FCN模型获取前端一阶势,取高斯核模型作为CRF二阶势,充分考虑影像的空间上下文信息。由于传统的CRF模型存在的过平滑现象,严重影响遥感影像的分类与识别,故加入mean-shift区约束条件来优化云区分类结果,划分云区边缘细节,提高了云检测的分类精度。

2 基本原理

为了有效利用空间域信息和先验知识,结合全卷积神经网络和条件随机场两种算法完成检测,全卷积神经网络利用标签图像的先验知识作为监督以训练网络模型,输出结果作为前端一阶势,条件随机场则对全卷积神经网络的粗分割图像与空间域上下文信息进行优化,取高斯核模型作为后端二阶势,

2.1 全卷积神经网络基本原理

卷积神经网络因其局部连接和权值共享的优点被广泛应用于遥感影像的分割与分类任务中,其中卷积层和池化层是实现影像特征提取任务的核心组成结构,卷积层滤波矩阵作用于整个感受野范围内对输入影像作内积,形成输入影像的特征图从而提取出影像的目标特征,计算公式为

式中:

池化层的作用是进行非线性降采样,在两个相邻的卷积层之间插入池化层对卷积特征进行降维。常用的池化操作有最大池化和平均池化两种。本研究采用最大池化方法,减小了上层隐藏层的计算复杂度,增强了对输入影像平移缩放等操作的稳健性,计算公式为

式中:

在参数优化方面,采用自适应动量算法,利用梯度的一阶矩估计和二阶矩估计动态调整每个参数的学习率,有效解决传统参数优化算法仅适用于小批量网络训练,下降速度慢且在非最优点持续震荡等问题,加快了模型收敛。

为了实现端到端的像素级检测能力,全卷积神经网络FCN-8s将牛津大学计算机视觉组和Google DeepMind公司的研究员一起研发的16层深的卷积神经网络VGG-16[15]网络的后3层全连接层全部转化为1×1大小的卷积核所对应的等同向量长度的多通道卷积层,利用上采样操作结合VGG-16的池化层输出结果,一方面增加了输出结果的分辨率,另一方面保留了网络收缩过程中产生的影像特征,获得精确度为8 pixel的输出结果,原理如

由于FCN-8s的训练过程需要移植FCN-32s和FCN-16s的训练结果,训练耗时超过40 h,训练过程复杂且训练时间漫长。MyFCN的网络结构如

表 1. 改进的全卷积神经网络算法结构代码对应表

Table 1. Structural code mapping in improved fully convolutional neural network algorithm

|

2.2 结合条件随机场模型的精细化云区检测

条件随机场是一种经典的判别型概率图模型,将CRF模型引入到遥感影像的云区检测中,不仅考虑了空间的上下文信息,而且反映了观测变量之间的相互依赖关系,细化了全卷积神经网络的分割边缘,剔除较小的误分割区域。定义隐变量

式中:

式中:

因此,云区检测问题的目标是找到一个标签

为了简化,用

式中:

一阶势函数需要判别像素点的类成员概率,本文使用全卷积神经网络的分类结果定义一阶势函数,其公式表示为

式中:

相比于传统仅利用4连接或8连接邻域的CRF模型,建立一种全连接的CRF模型,表达式为

式中:

然而上述CRF模型的云区分类结果依旧存在过平滑现象,云区边缘细节依旧难以划分,加入mean-shift区域约束算法来修正像素点的分类结果,即

式中:

整个模型的后验概率的求解是一个NP-Hard问题,且所提CRF模型为全连接模型,传统算法的推断速度过慢,故采用平均场算法[16]。该方法提出了一种可以替代CRF原始分布

由此可得迭代更新公式

式中:[

整个推断过程,以全卷积神经网络的最终预测图像为输入,以迭代结束后的

3 实验与分析

为了验证所提方法的优越性,本实验从数十景米级分辨率的资源3号遥感影像上截取了数千个(256×256) pixel大小的数据样本,通过目视解译从中挑选200个样本制作训练集和测试集,使用Photoshop对样本中的云区进行勾画提取,得到黑白的标签图片,如

将实验结果与传统云区检测方法中效果较好的模糊

图 3. 输入影像与标签图片。(a)输入影像1;(b)标签图片1;(c)输入影像2;(d)标签图片2

Fig. 3. Input images and label pictures. (a) Input image 1; (b) label picture 1; (c) input image 2; (d) label picture 2

图 4. 不同方法云检测结果对比。(a)输入影像;(b)标签影像;(c) FCN+CRF;(d) MyFCN;(e) FCN-8s;(f) FCM+SVM

Fig. 4. Comparison of cloud detection results with different methods. (a) Input image; (b) label picture; (c) FCN+CRF; (d) MyFCN; (e) FCN-8s; (f) FCM+SVM

由

为了客观定量地评价所提算法的优越性,采用了4个评价指标:准确率、精确度、召回率和F1-综合评价指标。云区检测识别结果可以分为4种情况:正确云区检测范围(

其中F1综合了精确度和召回率的结果,F1-综合指标越高说明实验方法越有效。

表 2. 不同方法的云检测精度与检测时间比较

Table 2. Comparison of accuracy and detection time of cloud area detection by different methods

|

由

4 结论

针对资源3号卫星遥感影像提出了一种结合全卷积神经网络与条件随机场的云区检测算法,该算法可接受任意尺寸大小的输入影像,达到像素级的检测效果。对全卷积神经网络FCN-8s进行改进,有效解决了其训练过程繁、收敛效果差、训练时间长且云检结果精度低等问题。将高斯核作为条件随机场二阶势,充分考虑输入影像的空间上下文信息,通过加入mean-shift区域约束条件,解决了模型输出影像存在过平滑的问题,精细化处理了云区边缘范围,将检测准确率提高至97.38%。实验结果表明,改进的全卷积神经网络与条件随机场结合的检测算法无论是在图像检测效果还是定量分析上都具有明显优势。

然而,本文算法还存在诸多不足,例如,薄雾本属于气溶胶,不属于云的范畴,而本文方法易将薄雾识别为云,存在误判。另外,对于具有相同光谱和纹理特性的云、雪的识别亦存在困难,随着深度学习理论的不断深入,下一步将致力于解决以上问题。

[1] 刘大伟, 韩玲, 韩晓勇. 基于深度学习的高分辨率遥感影像分类研究[J]. 光学学报, 2016, 36(4): 0428001.

[2] KrizhevskyA, SutskeverI, Hinton G E. ImageNet classification with deep convolutional neural network[C/OL]//Advances in Neural Information Processing Systems, 2012: 1097-1105. [2018-08-28].https://papers.nips.cc/paper/4824-imagenet-classification-with-deep-convolutional-neural-networks.pdf.

[3] 陈洋, 范荣双, 王竞雪, 等. 基于深度学习的资源三号卫星遥感影像云检测方法[J]. 光学学报, 2018, 38(1): 0128005.

[4] LongJ, ShelhamerE, DarrellT. Fully convolutional networks for semantic segmentation[C]//2015 IEEE Conference on Computer Vision and Pattern Recognition, June 7-12, 2015, Boston, MA, USA. New York: IEEE, 2015: 3431- 3440.

[5] KollerD, FriedmanN. Probabilistic graphical models principles and techniques[M]. Cambridge: MIT Press, 2009.

[6] Geman S, Geman D. Stochastic relaxation, Gibbs distributions, and the Bayesian restoration of images[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1984, 6(6): 721-741.

[8] 夏梦, 曹国, 汪光亚, 等. 结合深度学习与条件随机场的遥感图像分类[J]. 中国图象图形学报, 2017, 22(9): 1289-1301.

[9] 李竺强, 朱瑞飞, 高放, 等. 三维卷积神经网络模型联合条件随机场优化的高光谱遥感影像分类[J]. 光学学报, 2018, 38(8): 0828001.

[10] KumarS, HebertM. Discriminative random fields: a discriminative framework for contextual interaction in classification[C]//Proceedings Ninth IEEE International Conference on Computer Vision, October 13-16, 2003, Nice, France. New York: IEEE, 2003: 1150- 1157.

[14] 刘笑, 王光辉, 杨化超, 等. 全卷积神经网络遥感影像道路提取方法[J]. 遥感信息, 2018, 33(1): 69-75.

[16] KrähenbühlP, KoltunV. Efficient inference in fully connected CRFs with Gaussian edge potentials[J]. Advances in Neural Information Processing Systems, 2011( 24): 109- 117.

[17] 赵晓. 高分辨率卫星遥感图像云检测方法研究[D]. 哈尔滨: 哈尔滨工业大学, 2013: 40- 47.

ZhaoX. Study on cloud detection method for high resolution satellite remote sensing images[D]. Harbin: Harbin Institute of Technology, 2013: 40- 47.

Article Outline

裴亮, 刘阳, 高琳. 结合全卷积神经网络与条件随机场的资源3号遥感影像云检测[J]. 激光与光电子学进展, 2019, 56(10): 102802. Liang Pei, Yang Liu, Lin Gao. Cloud Detectionof ZY-3 Remote Sensing Images Based on Fully Convolutional Neural Network and Conditional Random Field[J]. Laser & Optoelectronics Progress, 2019, 56(10): 102802.