基于时间感知和自适应空间正则化的相关滤波跟踪算法  下载: 1067次

下载: 1067次

1 引言

目标跟踪[1-2]是计算机视觉领域里的一个研究热点,其结合了模式识别、目标检测、图像处理以及数学等众多领域的核心思想,在无人驾驶、人机交互以及智能监控等方向有着广泛的应用。近10年来,基于相关滤波跟踪的算法性能在不断提升,但是在目标遮挡、目标变形和光照变化等复杂场景的干扰下,研制出一个稳健性优异且高效的跟踪器仍然是个挑战。

最近,相关滤波跟踪算法[3-14]在保证精度的同时具备较快的跟踪速度,从而受到国内外研究者的广泛关注。Bolme等[3]提出输出平方误差(MOSSE)相关滤波器,这标志着相关滤波正式应用到目标跟踪领域中,但MOSSE相关滤波器通过密集采样得到的训练样本数量严重不足,导致跟踪效果较差。Henriques等[4]针对此问题提出基于循环结构的核相关滤波跟踪算法(CSK),该算法通过对目标区域进行循环移位来采样出大量样本作为训练集,但CSK采用灰度特征,存在对目标外观表达能力不足的问题。Henriques等[5]提出具有多通道特征的核相关滤波跟踪算法(KCF),该算法采用31个通道的方向梯度直方图(HOG)特征,增强了模型辨别能力,且与岭回归和循环矩阵结合,利用核方法得出了相关滤波跟踪器,该跟踪器具有较快的跟踪速度。

以上几种相关滤波跟踪算法对目标仅采用单一尺度策略进行定位,当目标尺寸发生变化时跟踪器容易漂移。Danelljan等[6]提出基于精确尺度估计的相关滤波跟踪算法(DSST),先用目标图像训练出位置滤波器,然后采用33个尺度的目标图像训练出尺度滤波器,由于尺度比较精细,因此跟踪速度得到降低。此外,国内研究者[7-8]也在相关滤波框架上对多尺度定位策略进行了一定的探索。葛宝义等[7]用一维尺度相关滤波器对目标尺度进行最优估计,并采用融合的手工特征与目标跟丢重检测模块,提高了算法在遇到目标遮挡等复杂场景时的跟踪稳健性。李双双等[8]建立了RGB直方图模型,该模型采用RGB颜色特征和改进的HOG特征对目标进行尺度最优估计,使算法在遇到同类别目标干扰时有更好的分辨力。

相关滤波框架中的训练集是通过对目标区域进行循环移位获取的,其中只有一张中心样本是正确的,这导致了边界效应的产生,使得跟踪器在有背景干扰时容易发生漂移。为了更好地解决边界效应问题,Danelljan等[9]提出基于空间正则化的相关滤波(SRDCF)跟踪算法,该算法对滤波器进行空间惩罚,使得训练出的滤波器更加关注目标的中心区域。但加入空间正则化之后,原来相关滤波框架的闭式解结构被破坏,之后采用Gauss-Seidel迭代法进行求解时,跟踪速度大大降低,仅约为5 frame/s。Dai等[10]提出基于自适应空间正则化的相关滤波跟踪算法(ASRCF),此算法可以学习到空间正则化权重的变化,对非目标区域的惩罚更为准确,且使用交替方向乘子法(ADMM)进行优化求解,在非常少的迭代中就可以收敛,但是该算法没能在时间上建立起滤波器之间的联系,在遇到有较大形变目标时,滤波器对当前不准确目标的学习容易过于拟合。Li等[11]提出基于时空正则化的相关滤波跟踪算法(STRCF),该算法通过加入时间正则化项来建立相邻滤波器之间的关系,但空间正则化权重没有学习能力,在遇到背景干扰时易发生跟踪漂移现象。

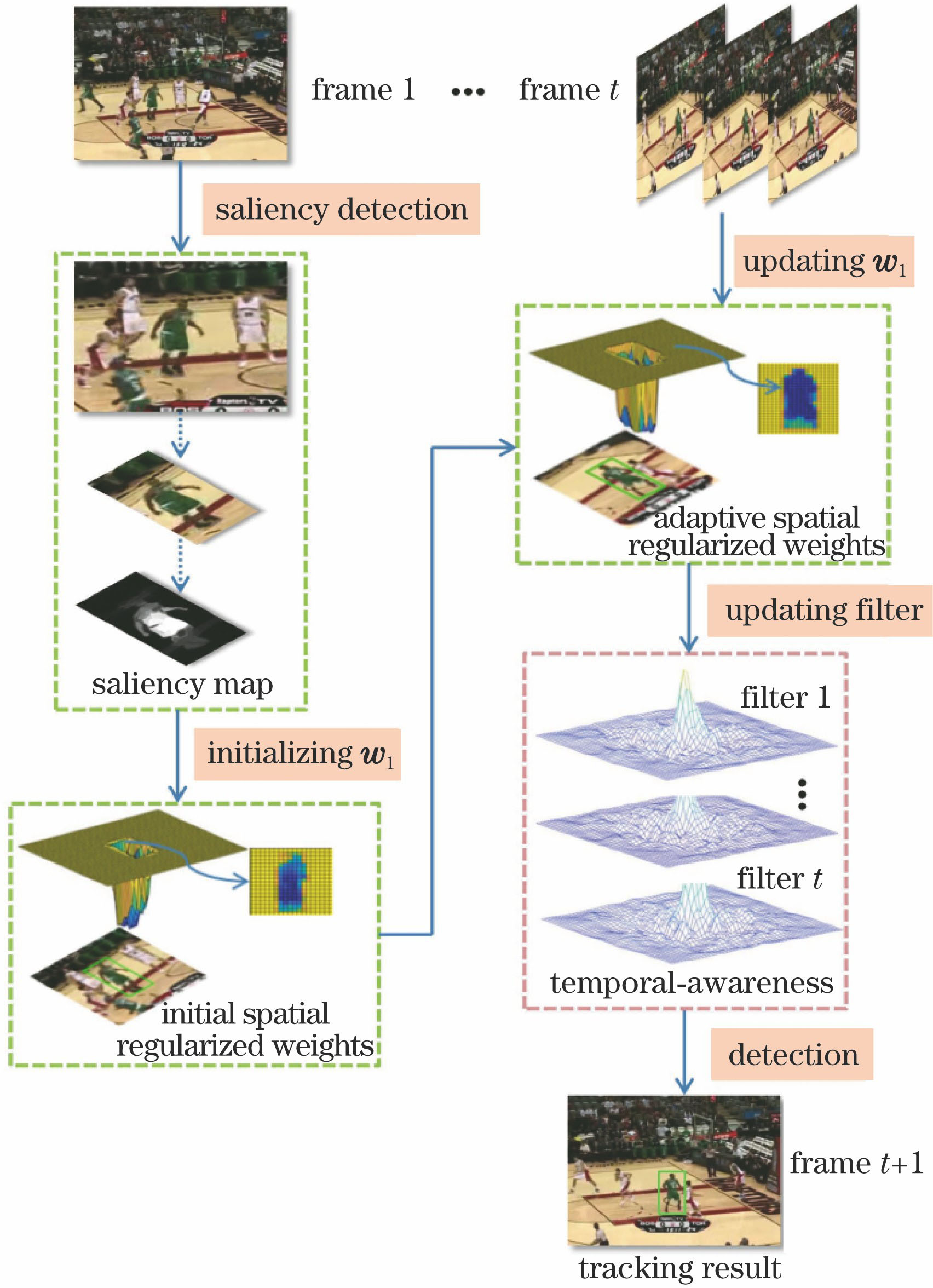

通过对上述算法的研究,本文提出一种基于时间感知和自适应空间正则化(TASRDCF)的相关滤波跟踪方法。该方法能自适应地更新空间正则化权重,并与时间感知项结合,使跟踪器在目标遇到遮挡和发生大幅形变时仍具有较好的稳健性。本工作主要贡献如下:1)本文算法在第一帧图像中用图像显著性检测算法,计算出带有目标内容信息的空间正则化初始权重;2)在SRDCF算法的基础上把自适应空间正则化项与时间感知项结合,使得空间正则化权重在跟踪过程中随着目标的变化进行自适应调整的同时,也建立起相邻帧滤波器之间的联系,增强了跟踪器的判别能力与跟踪稳健性;3)采用ADMM对相关滤波器和自适应空间正则化参数进行迭代求解,降低了计算复杂度,提高了滤波器的跟踪速度;4)本算法在OTB-2013和OTB-2015公开数据库上进行性能测试,取得了较好的跟踪效果,并且在CPU上的速度达到了24.2 frame/s,可以满足实时性要求。

2 本文算法的总体框架

本文总体算法的流程如

3 本文算法

3.1 时间感知和自适应空间正则化模型

SRDCF跟踪算法[9]在跟踪效果上表现较好,但是跟踪速度非常慢,并且空间正则化权重只是在第一帧图像中计算得到,在后面的跟踪过程中不再更新,所以模型在遇到目标形变时,空间正则化权重不能对背景进行良好的抑制,容易出现跟踪漂移现象。

为了解决SRDCF跟踪算法中存在的问题,本文提出一种基于时间感知和自适应空间正则化的相关滤波跟踪方法。自适应空间正则化项可以在跟踪过程中使空间正则化权重随着目标的变化而更新,能够更加准确地突出目标区域和抑制背景区域。时间感知项可以有效利用当前帧和前一时刻学习到的滤波器,在目标发生遮挡或者形变时,约束当前帧学习到的滤波器与前一时刻的滤波器尽可能类似,在时间上建立起滤波器之间的联系,从而有效地缓解模型污染问题。综合两项之后,本文算法的目标函数为

式中:K表示总通道数;xk表示第k通道的特征;hk表示第k通道的滤波器;y表示期望输出,设定为以目标为中心的二维高斯分布;wr表示带有目标内容信息的空间正则化指导权重;λ1表示空间正则化参数;μ表示时间感知项参数;ht-1表示前一时刻学习到的滤波器;

3.2 滤波器模型的优化求解

由于(1)式是凸函数,本文采用ADMM来获得全局最优解,这能降低计算复杂度,加快跟踪速度。首先引入惩罚参数β,然后加入辅助变量g来构造限制等式,即h=g,最终(1)式可写成不带约束项的增广拉格朗日公式,即

式中:z表示拉格朗日乘子;样本xk大小为M×N。接下来,用ADMM来交替迭代,进而求解子问题。

子问题1:求解h。假设g、ht-1、z、y都是已知变量,利用帕塞瓦尔定理可将目标函数写成

式中:

式中:Vj(

式中:S=Vj(

子问题2:求解g。假设w1、z、h都是已知变量,可将目标函数写成

式中:W表示K个通道的空间正则化惩罚权重w1对角化后的矩阵,即W∈ℝKMN×KMN;G由K个通道中的g堆叠并且向量化后得到,即G∈ℝKMN×1。令

子问题3:求解

式中:

3.3 自适应空间正则化权重优化求解

在g确定后,为了有更快的收敛速度,用ADMM对自适应空间正则化参数w1进行求解,可将目标函数写成

式中:w表示向量化后的空间正则化参数,即w∈ℝMN×1,Pk=diag(gk)∈ℝMN×MN。在第一帧图像中,使用带有目标区域内容信息的惩罚权重对wr进行初始化,即

式中:Smap表示单层元胞自动机[15]优化后带有目标内容信息的显著性图,取值范围为[0,1];ϕ表示固定参数。当接近目标中心区域时,Smap的值趋向1,导致指导权重wr降低;反之,在目标边缘区域时,Smap的值趋向0,导致指导权重wr升高。这使得原本的惩罚权重w0带上了目标的内容信息,因此可以保留目标,进而能对背景进行更好的惩罚。w0矩阵元wo(x,y)表达式为

式中:xo和yo分别表示第一帧目标中心的横坐标和纵坐标;W和H分别表示目标的宽和高;ψ和κ都是固定的参数。

在(10)式中先加入惩罚参数η,然后加入辅助变量t构造出限制等式w=t,得到不带限制项的增广拉格朗日公式:

子问题1:求解w。假设t和ζ已知,可得出

子问题2:求解t。假设w和ζ已知,可得出

子问题3:求解ζ。拉格朗日乘子向量ζ的更新方案为

惩罚参数的选择方案为

在跟踪过程中,本文把解出的w变换成相应形式代入到(7)式中,重新对相关滤波器h进行迭代求解,使得自适应空间正则化参数可以对背景进行有效抑制。

3.4 目标定位

在目标定位阶段,把前一帧学习到的相关滤波器

取响应结果图的最大值所在的位置对当前帧t进行定位。本文采用尺度自适应多特征跟踪器(SAMF)[14]的尺度池搜索策略来估算目标的最佳尺度,以αr为尺度因子提取前一帧目标区域Zt-1,其中r∈

4 实验结果与分析

4.1 实验环境与参数设置

实验所用操作系统为Windows 10,编程软件为Matlab R2017b,硬件配置为Intel i7 7700k CPU,32 GB内存的主机。本实验中,以目标为中心,边长为

4.2 数据集和评估指标

采用OTB-2013[16]和OTB-2015数据集[17]对本文算法进行性能评估,数据集包括了遮挡、快速运动、低分辨率、超出视野、运动模糊、平面外旋转、光照变化、尺度变化、复杂背景、平面内旋转和非刚性形变等各种场景。实验中采用OTB数据集,选择一次通过评估模式(OPE)的成功率曲线下面积(AUC)和距离精度(DP)两个指标来评估跟踪效果。重叠率计算公式为

式中:ST表示真实框区域;SP表示预测框区域。成功率曲线表示预测框和真实框区域重叠率大于0.5的帧数占总帧数的百分比,实际成功率用AUC表示。距离精度曲线表示预测所得的目标中心位置与实际位置的平均欧氏距离小于20 pixel的帧数占总帧数的百分比。

4.3 定量分析

在OTB-2013和OTB-2015数据集中分别对算法进行评估,得到各自的成功率曲线和距离精度曲线,对比算法包括7个手工特征的相关滤波跟踪算法和2个深度学习跟踪算法,即SRDCFDecon[18]、C-COT(HOG+CN)[19]、ECO-HC[20]、STRCF[11]、SRDCF[9]、Staple[21]、DSST[6]、SiameseFC[22]、CNN-SVM[23],实验结果如

图 2. 10种算法在OTB-2013和OTB-2015数据集上的距离精度曲线和成功率曲线。(a) OTB-2013上的距离精度曲线;(b) OTB-2013上的成功率曲线;(c) OTB-2015上的距离精度曲线;(d) OTB-2015上的成功率曲线

Fig. 2. Distance precision and success rate curves of ten algorithms on OTB-2013 and OTB-2015 datasets. (a) Distance precision curves in OTB-2013; (b) success rate curves in OTB-2013; (c) distance precision curves in OTB-2015; (d) success rate curves in OTB-2015

从

图 3. OTB-2013数据集中11种视频序列的跟踪成功率。(a)快速运动;(b)复杂背景;(c)运动模糊;(d)非刚性形变;(e)光照变化;(f)平面内旋转;(g)低分辨率;(h)遮挡;(i)平面外旋转;(j)超出视野;(k)尺度变化

Fig. 3. Tracking success rate curves of 11 video sequences on OTB-2013 dataset. (a) Fast motion; (b) background clutter; (c) motion blur; (d) non-rigid deformation; (e) illumination variation; (f) in-plane rotation; (g) low resolution; (h) occlusion; (i) out-of-plane rotation; (j) out of view; (k) scale variation

为了分析本文算法面对不同场景时的跟踪性能研究了OTB-2013和OTB-2015数据集中11种不同属性场景下的跟踪成功率,结果如

图 4. OTB-2015数据集中11种视频序列的跟踪成功率。(a)快速运动;(b)复杂背景;(c)运动模糊;(d)非刚性形变;(e)光照变化;(f)平面内旋转;(g)低分辨率;(h)遮挡;(i)平面外旋转;(j)超出视野;(k)尺度变化

Fig. 4. Tracking success rate curves of 11 video sequences on OTB-2015 dataset. (a)Fast motion; (b) background clutter; (c) motion blur; (d) non-rigid deformation; (e) illumination variation; (f) in-plane rotation; (g) low resolution; (h) occlusion; (i) out-of-plane rotation; (j) out of view; (k) scale variation

从

综合

4.4 定性分析

1) 复杂背景:序列Shaking和Box都有这个属性,很多算法的跟踪效果较差。本文算法通过图像显著性算法计算出的带有目标内容信息的空间正则化初始权重和自适应空间正则化项对非目标区域进行了准确惩罚,有效解决了模型在复杂背景属性下的跟踪问题,如序列Shaking中的第22帧和第66帧,序列Box中的第473帧和578帧。

2) 光照变化:序列Shaking具有这个属性,而且表现十分明显。由于本文算法采用的是HOG特征、CN特征和灰度特征三种互补特征,其中HOG特征对光照不敏感,这有效提高了算法对光照变化场景的稳健性,如序列Shaking中的第59帧和第103帧。

3) 遮挡:所选视频序列除了Shaking外都发生了遮挡,较为明显的是Girl2序列和Skating2-1序列。在Girl2序列中,从第108帧开始出现大面积遮挡,到了第291帧目标重新出现时,只有本文算法能重新跟踪到目标。在Skating2-1序列中,第45帧和第112帧都有部分遮挡,但是本文算法仍然可以正确定位到目标。由于本文算法加入了时间感知项,滤波器可以学习到相邻帧之间的信息,且用的是多通道特征,这就提升了算法在目标遮挡场景下的稳健性。

4) 尺度变化:所选视频序列全都发生了尺度变化。DragonBaby序列和Girl2序列表现较为明显。如DragonBaby中的第32~85帧,目标明显从小变大,只有本文算法没有发生漂移;Girl2中的第422~894帧,目标从大变小,只有本文算法和C-COT(HOG+CN)算法能一直准确跟踪目标。本文算法采用5种不同尺度对目标进行尺寸估计,加上时间感知项对模型退化的抑制,本文算法对目标尺度变化情景有着良好的适应性。

5) 旋转变化:本文所选视频序列都具有旋转属性,较为明显的是Skating2-1和DragonBaby。在目标发生旋转后,较多算法出现漂移和跟丢现象,本文利用时间感知项和多通道特征有效解决了此问题,如Skating2-1中的第25帧和第45帧,DragonBaby中的第32帧和第44帧。

6) 非刚性形变:序列Skating2-1和Girl2具有非刚性形变属性。在Skating2-1序列中第112~269帧和Girl2序列中第42~894帧,目标都发生了明显形变。在此属性中基准算法SRDCF表现较差,而本文算法采用了自适应空间正则化项和时间感知项,取得了较好的跟踪效果,有效解决了目标非刚性形变的跟踪问题。

5 结论

在空间正则化相关滤波跟踪算法的基础上,提出了一种结合时间感知与自适应空间正则化的相关滤波跟踪算法。采用灰度特征、HOG特征和CN特征三种互补特征对目标进行建模,增强了算法对目标的表达能力;接着,在目标函数中引入自适应空间正则化项,使空间惩罚权重可以学习到目标区域的变化,能对非目标区域进行更加准确的惩罚,使边界效应对相关滤波器的影响得到有效缓解;然后加入时间感知项,使相关滤波器学习到相邻帧之间的信息,缓解了算法模型随时间而退化的问题。实验结果表明,本文算法对多种复杂场景都具有良好的稳健性,并且跟踪速度能满足跟踪实时性的要求。接下来的工作将尝试把手工特征和深度特征进行自适应融合后加入到本文算法中来提升跟踪性能。

[1] Yilmaz A, Javed O, Shah M. Object tracking: a survey[J]. ACM Computing Surveys, 2006, 38(4): 13.

[2] Yang H X, Shao L, Zheng F, et al. Recent advances and trends in visual tracking: a review[J]. Neurocomputing, 2011, 74(18): 3823-3831.

[3] BolmeD, Beveridge JR, Draper BA, et al. Visual object tracking using adaptive correlation filters[C]∥2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition, June 13-18, 2010, San Francisco, CA, USA. New York: IEEE, 2010: 2544- 2550.

[4] Henriques JF, CaseiroR, MartinsP, et al. Exploiting the circulant structure of tracking-by-detection with kernels[M] ∥Fitzgibbon A, Lazebnik S, Perona P, et al. Computer vision-ECCV 2012. Lecture notes in computer science. Berlin, Heidelberg: Springer, 2012, 7575: 702- 715.

[5] Henriques J F, Caseiro R, Martins P, et al. High-speed tracking with kernelized correlation filters[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(3): 583-596.

[6] DanelljanM, HägerG, Khan FS, et al.Accurate scale estimation for robust visual tracking[C]∥Proceedings of the British Machine Vision Conference 2014, September 1-5, 2014, Nottingham, UK.UK: BMVA Press, 2014.

[7] 葛宝义, 左宪章, 胡永江. 基于特征融合的长时目标跟踪算法[J]. 光学学报, 2018, 38(11): 1115002.

[8] 李双双, 赵高鹏, 王建宇. 基于特征融合和尺度自适应的干扰感知目标跟踪[J]. 光学学报, 2017, 37(5): 0515005.

[9] DanelljanM, HägerG, Khan FS, et al. Learning spatially regularized correlation filters for visual tracking[C]∥2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 4310- 4318.

[10] Dai KN, WangD, Lu HC, et al. Visual tracking via adaptive spatially-regularized correlation filters[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, June 16-20, 2019, Long Beach, CA. New York: IEEE, 2019: 4670- 4679.

[11] LiF, TianC, Zuo WM, et al. Learning spatial-temporal regularized correlation filters for visual tracking[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE, 2018: 4904- 4913.

[12] 赵高鹏, 沈玉鹏, 王建宇. 基于核循环结构的自适应特征融合目标跟踪[J]. 光学学报, 2017, 37(8): 0815001.

[13] Feng W, Han R Z, Guo Q, et al. Dynamic saliency-aware regularization for correlation filter-based object tracking[J]. IEEE Transactions on Image Processing, 2019, 28(7): 3232-3245.

[14] LiY, Zhu JK. A scale adaptive kernel correlation filter tracker with feature integration[M] ∥Agapito L, Bronstein M, Rother C. Computer vision-ECCV 2014 Workshops. Lecture notes in computer science. Cham: Springer, 2015, 8926: 254- 265.

[15] QinY, Lu HC, Xu YQ, et al. Saliency detection via cellular automata[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 7-12, 2015, Boston, MA, USA. New York: IEEE, 2015: 110- 119.

[16] WuY, LimJ, Yang MH. Online object tracking: a benchmark[C]∥2013 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2013, Portland, OR, USA. New York: IEEE, 2013: 2411- 2418.

[17] Wu Y, Lim J, Yang M H. Object tracking benchmark[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1834-1848.

[18] DanelljanM, HagerG, Khan FS, et al. Adaptive decontamination of the training set: a unified formulation for discriminative visual tracking[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 1430- 1438.

[19] DanelljanM, RobinsonA, Khan FS, et al. Beyond correlation filters: learning continuous convolution operators for visual tracking[M] ∥Leibe B, Matas J, Sebe N, et al. Computer vision-ECCV 2016. Lecture notes in computer science. Cham: Springer, 2016, 9909: 472- 488.

[20] DanelljanM, BhatG, Khan FS, et al. ECO: efficient convolution operators for tracking[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 6931- 6939.

[21] BertinettoL, ValmadreJ, GolodetzS, et al. Staple: complementary learners for real-time tracking[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 1401- 1409.

[22] BertinettoL, ValmadreJ, Henriques JF, et al. Fully-convolutional Siamese networks for object tracking[M] ∥Hua G, Jégou H. Computer vision-ECCV 2016 Workshops. Lecture notes in computer science. Cham: Springer, 2016, 9914: 850- 865.

[23] HongS, YouT, KwakS, et al.Online tracking by learning discriminative saliency map with convolutional neural network[C]∥Proceedings of the 32nd International Conference on Machine Learning, July 6-11, 2015, Lille, France.USA: MIT Press, 2015: 597- 606.

Article Outline

胡昭华, 韩庆, 李奇. 基于时间感知和自适应空间正则化的相关滤波跟踪算法[J]. 光学学报, 2020, 40(3): 0315003. ZhaoHua Hu, Qing Han, Qi Li. Correlation Filter Tracking Algorithm Based on Temporal Awareness and Adaptive Spatial Regularization[J]. Acta Optica Sinica, 2020, 40(3): 0315003.