一种基于注意力模型的无锚框交通标志识别算法  下载: 532次

下载: 532次

1 引言

根据世界卫生组织统计,全球每年有超过一百万人因交通事故死亡,而且该事故已经成为青少年以及儿童的首要死亡原因之一。为了减少交通事故的发生,各国家的科研院校和高科技企业都投入了大量的资金来研发先进驾驶辅助系统,而交通标志的识别是驾驶辅助系统中非常重要的一项研究内容。

传统的交通标志识别算法利用交通标志特殊的形状和颜色对其进行分类[1]。Madani等[2]提出了一种基于监督距离分类器的颜色分割算法,使用6种随机值代表HSV(Hue, Saturation, Value)颜色空间[3]中的主要颜色并进行训练,该算法能够在不同的天气条件下对6个颜色区域中的标志进行分割。随着深度学习的发展,Faster R-CNN(Faster Region-Convolutional Neural Network)[4]和YOLO(You Only Look Once)[5]等各种卷积神经网络模型均被应用在交通标志识别的领域,而且取得了出色的效果。此外,许多学者都对经典的卷积神经网络进行了改进,并应用在交通标志识别的领域。张毅等[6]提出了一种基于改进Faster R-CNN的交通标志识别算法,通过拟合交通标志特征来设计锚框以获取更好的推荐区域,从而进一步降低误检率与漏检率。童英等[7]对YOLOv2网络模型进行了改进,并使用标准的边界框宽度和高度来计算损失函数。常用的目标检测算法都将锚框作为先验框,一些学者对锚框的生成方式进行了改进并提出了无锚框的方法。CenterNet模型[8]将目标建模为其边界框的中心点,检测目标的过程中利用关键点估计来找到中心点,再回归出其余目标的属性,例如边界框的大小、3D位置、方向甚至姿势等。虽然这些方法在复杂的现实场景中均能准确识别近距离的交通标志,但对于远距离和小尺寸的交通标志,识别率仍旧较低,如何准确识别小型目标仍然是交通标志识别领域的一大难点。

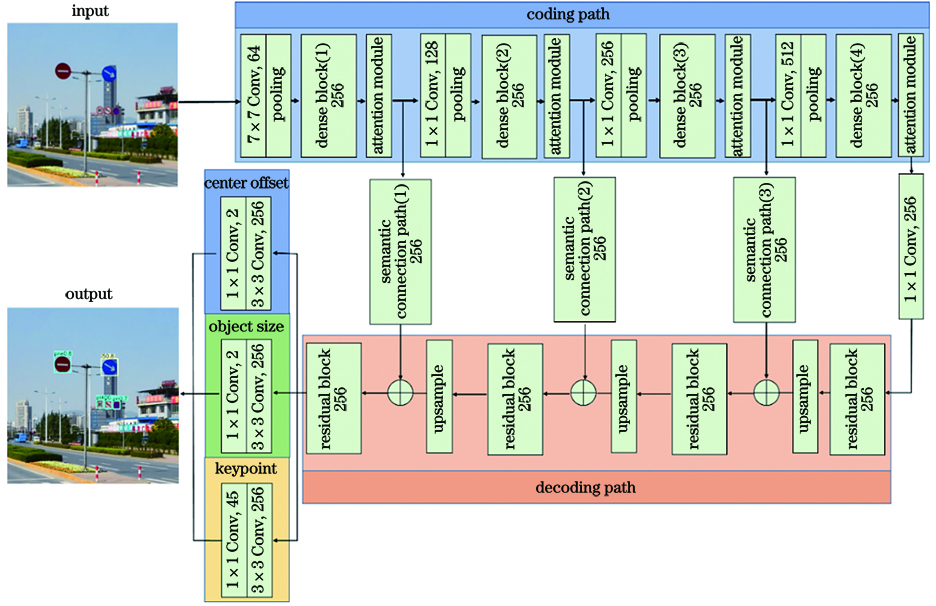

本文提出一种基于注意力模型的无锚框交通标志识别网络,利用密集连接网络(DenseNet-121)[9]作为骨干网络并用来对特征进行提取,特征的重复利用可缓解梯度消失的现象,有效加强了特征传播。网络整体采用编码器-解码器的结构,在编码路径中加入注意力模型可对提取到的特征图进行空间和通道上的自适应调整,用来获取有益于交通标志分类的信息。本文提出一种语义连接路径,可以将编码路径的浅层语义信息与解码路径的深层语义信息进行融合。网络采用无锚框的检测方式,通过定位交通标志的中心点来回归边界框的位置与尺寸信息,有效解决锚框所带来的正负样本不均衡问题。

2 算法原理

2.1 卷积神经网络结构

基于注意力模型的无锚框卷积神经网络(AAFCNN)模型的结构如

受到CenterNet模型的启发,AAFCNN模型采用中心点预测的方式来识别交通标志。输入的街景图像经过编码器-解码器结构中的全卷积网络后,得到包含交通标志语义信息的热力图。使用网络模型对热力图进行3×3卷积与1×1卷积操作后,得到关键点热力图、中心点偏移量与目标尺寸。其中关键点热力图的峰值点就是交通标志的中心点,检测与识别交通标志的过程就是提取峰值点的过程。首先针对每个类别分别提取关键点热力图中的峰值,然后检测出所有大于或等于其相邻8个响应点的峰值点并保留前100个点。令

式中:(∂

2.2 语义连接路径

对于一些经典的编码器-解码器结构,如U-Net[10]和V-Net[11]等均会在编码路径的池化层和解码路径的反卷积层之间加入跳跃连接路径。因此,编码路径中提取到的多尺度特征便可以传播到解码路径,编码路径中经过池化操作后丢失的空间信息得到了恢复。虽然保留了编码路径中损失的空间特征,但跳跃连接路径仍然存在缺陷。编码路径的特征是在浅层网络中所提取到的低层次语义特征,而解码路径中的特征是深层神经网络所提取到的高层次语义特征,二者之间存在语义鸿沟[12]。将这两组不兼容的特征直接进行融合,这会影响神经网络的学习,而且会对交通标志的识别产生不利影响。

为了减小编码路径与解码路径之间的语义鸿沟,可以在跳跃连接路径中加入一些卷积层,用来对编码路径传播过来的特征进行更多处理。此外,随着卷积神经网络的加深,编码路径中的特征图与解码路径中的特征图之间的语义鸿沟逐渐减小。由于语义鸿沟的大小与卷积层的数量呈正相关,所以每个跳跃连接路径中加入的卷积层数量也应该不同。综上,提出语义连接支路,结构如

2.3 注意力模型

注意力机制是一种模拟人类大脑处理视觉任务的机制,其可以引导神经网络关注交通标志区域,排除交通场景中其他背景特征的干扰。受到文献[ 14]的启发,在解码路径中加入注意力模型,该注意力模型由通道注意力模块与空间注意力模块构成。

通道注意力模块利用不同特征通道间的关系来生成通道注意图,使其更关注输入特征图中不同通道信息的重要性。通道注意力模块的结构如

图 3. 不同的注意力模块。(a)通道注意力模块;(b)空间注意力模块

Fig. 3. Different attention modules. (a) Channel attention module; (b) spatial attention module

空间注意力模块利用特征之间的空间关系来生成空间注意图,使其更关注输入特征图中不同位置信息的重要性。空间注意力模块的结构如

集成的注意力模型如

式中:

2.4 无锚框预测方式

目标检测算法中通常使用滑动窗口的方式来产生大量的锚框,然后以锚框作为先验框生成候选区域,但锚框中负样本的数量远大于正样本,这为模型的训练带来困难。为了避免此类问题,实验采用无锚框的方法对标志进行识别,首先确定交通标志的中心点与类别信息,再回归出中心点的偏移量与边界框的尺寸。

采用基于编码器-解码器结构的全卷积网络处理输入的街景图像,目的是获得C通道的关键点热力图,其中C表示关键点热力图的种类,即数据集中的45类交通标志。对于真值图中的每个关键点,一个低分辨率的等效点可表示为

式中:R为输出的跨度,实验中R值为4;p为原始真值图中的关键点;

使用σp表示目标自适应尺寸的标准差,卷积神经网络在训练过程中利用高斯核公式将真值图中的所有关键点映射到热力图中,表达式为

式中:(x,y)表示热力图中对应点的平面坐标。交通标志中心点预测的损失函数Lk可表示为

式中:α和β为损失函数的超参数;N为街景图像中关键点的数量;

网络中的编码器-解码器会对输入的图像进行多次池化操作,但在重新映射回原图像后会产生位置偏差,因此使用位置偏差损失函数Loff来补偿交通标志中心点的位置偏差,表达式为

式中:

使用(

综上,网络的整体损失函数由中心点预测损失Lk、位置偏差损失Loff和尺寸损失Lsize构成,表达式为

式中:λs和λo分别为控制位置偏差损失Loff和尺寸损失Lsize的超参数,实验中λs和λo分别设为0.1和1.0。

3 实验结果与分析

3.1 交通标志识别的数据集

TT100K数据集[15]是非常具有挑战性的交通标志数据集之一,共包含1×105张从腾讯街景全景图中收集的图像,图像涵盖各种天气条件和光照变化。数据集中街景图像的分辨率为2048 pixel×2048 pixel,分辨率比其他数据集更大,并且涵盖的交通标志种类更多,尺寸更小。在[0,32]像素之间的交通标志约占总数的42%,这些小型交通标志所占面积不到街景图像面积的1/4000。在[32,96]像素之间的交通标志约占总数的49%,而在[96,400]像素之间的大型交通标志仅占总数的9%,

由于TT100K数据集中不同类别的交通标志数量不均匀,一些罕见的交通标志数量稀少,为此实验忽略了在数据集中出现频次小于100的类别,对剩余的45类交通标志进行训练。为了平衡样本并确保每个类别至少包含1000张样本,实验对数据集中数量少于1000的类别进行重采样操作。为了证明所提算法的鲁棒性,将数据集中的交通标志按照像素范围分为小型(像素区间为(0,32],S)、中型(像素区间为(32,96],M)与大型(像素区间为(96,400],L)三种尺度并进行指标评测。

3.2 实验设置

神经网络是使用深度学习框架PyTorch搭建的并在Ubuntu 16.04的环境中进行训练,实验中使用的显卡型号为英伟达GTX1080Ti。网络的输入是经过裁剪与数据增强后的街景图像,分辨率为512 pixel×512 pixel。实验选择的优化算法为随机梯度下降(SGD)算法,网络的初始学习率设为0.00125,批量处理的数据规模为8,共进行120轮迭代训练,分别在第50轮、80轮和110轮学习率降低90%。

3.3 实验结果分析

3.3.1 交通标志识别性能评价

在交通标志数据集TT100K中进行对比实验,将所提模型的实验结果与TT100K数据集的提出者Zhu等[15]使用的网络模型、三个经典的目标检测网络Faster R-CNN[4]、FPN(Feature Pyramid Networks)[16]和RetinaNet[17]以及两个无锚框的目标检测网络FCOS(Fully Convolutional One-Stage Object Detection)[18]和CenterNet[8]进行比较,各对比实验中均对TT100K数据集进行相同处理,实验结果如

表 1. 不同交通标志识别方法的性能对比

Table 1. Performance comparison of different traffic sign recognition methods

|

![三种尺度交通标志的准确率-召回率曲线。(a)(0,32]的像素区间;(b)(32,96]的像素区间;(c)(96,400]的像素区间](/richHtml/lop/2021/58/16/1610020/img_6.jpg)

图 6. 三种尺度交通标志的准确率-召回率曲线。(a)(0,32]的像素区间;(b)(32,96]的像素区间;(c)(96,400]的像素区间

Fig. 6. Accuracy-recall curves of traffic signs at three scales. (a) Pixel interval of (0,32); (b) pixel interval of (32,96]; (c) pixel interval of (96,400]

3.3.2 模块有效化验证

为了探究解码路径中密集连接网络的深度对网络整体性能的影响,在TT100K数据集中分别利用DenseNet-121、DenseNet-161、DenseNet-169和DenseNet-201 4种骨干网络对特征进行提取,实验结果如

表 2. 密集连接网络的深度对识别性能的影响

Table 2. Effect of depth of densely connected network on recognition performance

| ||||||||||||||||||||||||||||

在网络的编码路径与解码路径中均加入注意力模型,用来研究注意力模型的位置对网络识别性能的影响,结果如

表 3. 注意力模型的位置对识别性能的影响

Table 3. Effect of location of attention model on recognition performance

| |||||||||||||||||||||||

为了验证注意力模型与语义连接路径的有效性,对模型进行了消融实验,实验结果如

表 4. 各模块的性能对比

Table 4. Performance comparison of each module

| ||||||||||||||||||||||||||||

4 结论

本文提出一种基于注意力模型的无锚框交通标志识别网络,其由编码路径与解码路径两部分构成。编码路径采用密集连接网络DenseNet-121作为骨干网络并进行特征提取,可以获取交通标志的轮廓信息;解码路径通过上采样层逐步修复交通标志的细节信息。为了减小编码路径与解码路径之间的语义鸿沟,本文设计一种语义连接路径。实验结果表明,加入语义连接路径后,神经网络对小型、中型与大型交通标志的精确率分别提高1.1、0.3与1.3个百分点。为了提升对小型交通标志的识别效果,本文在编码路径中加入注意力模型,可以抑制特征图中背景元素的权重,能够使网络关注交通标志区域。通过采用交通标志中心点的检测方式,本文成功解决正负样本的不均衡问题。与目前领先的几种目标检测网络相比,所提的AAFCNN模型在TT100K数据集中获得了更出色的识别效果。

[1] 屈治华, 邵毅明, 邓天民, 等. 复杂光照条件下的交通标志检测与识别[J]. 激光与光电子学进展, 2019, 56(23): 231009.

[2] MadaniA, YusofR, MalihaA. Traffic sign segmentation using supervised distance based classifiers[C] //2015 10th Asian Control Conference (ASCC), May 31-June 3, 2015, Kota Kinabalu, Malaysia.New York: IEEE Press, 2015: 15436782.

[3] Wang YQ, Liu LM, ZhaoY. Traffic sign detection based on fixed color combination and intensity restraint[C] //2009 International Symposium on Computer Network and Multimedia Technology, January 18-20, 2009, Wuhan, China.New York: IEEE Press, 2009: 11069873.

[4] Ren S Q, He K M, Girshick R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149.

[5] RedmonJ, DivvalaS, GirshickR, et al.You only look once: unified, real-time object detection[C] //2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE Press, 2016: 779- 788.

[6] 张毅, 龚致远, 韦文闻. 基于改进Faster R-CNN模型的交通标志检测[J]. 激光与光电子学进展, 2020, 57(18): 181015.

[7] 童英, 杨会成. 基于改进神经网络的交通标志识别[J]. 激光与光电子学进展, 2019, 56(19): 191002.

[9] HuangG, LiuZ, van der MaatenL, et al. Densely connected convolutional networks[C] //2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA.New York: IEEE Press, 2017: 2261- 2269.

[10] RonnebergerO, FischerP, BroxT. U-net: convolutional networks for biomedical image segmentation[M] //Navab N, Hornegger J, Wells W, et al. Medical image computing and computer-assisted intervention-MICCAI 2015. Lecture notes in computer science. Cham: Springer, 2015, 9351: 234- 241.

[11] MilletariF, NavabN, Ahmadi SA. V-Net: fully convolutional neural networks for volumetric medical image segmentation//2016 Fourth International Conference on 3D Vision (3DV), October 25-28, 2016, Stanford, CA, USA. New York: IEEE Press, 2016: 565- 571.

[12] Ibtehaz N, Rahman M S. MultiResUNet: rethinking the U-Net architecture for multimodal biomedical image segmentation[J]. Neural Networks, 2020, 121: 74-87.

[14] WooS, ParkJ, Lee JY, et al. CBAM: convolutional block attention module[M] //Ferrari V, Hebert M, Sminchisescu C, et al. Computer vision-ECCV 2018. Lecture notes in computer science. Cham: Springer, 2018, 11211: 3- 19.

[15] ZhuZ, LiangD, Zhang SH, et al.Traffic-sign detection and classification in the wild[C] //2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA.New York: IEEE Press, 2016: 2110- 2118.

[16] Lin TY, DollárP, GirshickR, et al.Feature pyramid networks for object detection[C] //2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA.New York: IEEE Press, 2017: 936- 944.

[17] Lin T Y, Goyal P, Girshick R, et al. Focal loss for dense object detection[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2020, 42(2): 318-327.

[18] TianZ, Shen CH, ChenH, et al. FCOS: fully convolutional one-stage object detection[C] //2019 IEEE/CVF International Conference on Computer Vision (ICCV), October 27-November 2, 2019, Seoul, Korea. New York: IEEE, 2019: 9626- 9635.

[19] Lin TY, MaireM, BelongieS, et al. Microsoft COCO: common objects in context[M] //Fleet D, Pajdla T, Schiele B, et al. Computer vision-ECCV 2014. Lecture notes in computer science. Cham: Springer, 2014, 8693: 740- 755.

Article Outline

褚晶辉, 黄浩, 吕卫. 一种基于注意力模型的无锚框交通标志识别算法[J]. 激光与光电子学进展, 2021, 58(16): 1610020. Jinghui Chu, Hao Huang, Wei Lü. Anchor-Free Traffic Sign Recognition Algorithm Based on Attention Model[J]. Laser & Optoelectronics Progress, 2021, 58(16): 1610020.