融合特征和决策的卷积-反卷积图像分割模型  下载: 1398次

下载: 1398次

1 引言

2015年,Long等[1]提出了全卷积网络(FCN)用于图像的语义分割,网络的输出结果为像素对应的类别的概率图,将传统的分类神经网络模型改为分割模型。而后,图像分割领域展示出新的生机与活力[1-2]。目前采用深度卷积神经网络(CNN)进行图像分割的挑战主要有:1) 卷积阶段的池化操作降低了特征分辨率,由其通过上采样进行预测结果比较粗略,难以精确保留目标区域边缘、位置等细节特征;2) 图像和目标自身的复杂性,如遥感影像目标混杂、存在遮挡、阴影等,进一步增加了分割的困难性;3) 研究表明,加深网络层次有利于提取特征,但将使参数增多,需要更多的标记样本来训练网络,而对于多数实际应用难以提供充足的训练样本。

现有研究针对上述问题,提出了一些解决手段。第一类研究方法:改进全卷积网络内部结构,如卷积结构和池化方式等改变感受野,提升特征分辨率以改善分割结果。Liu等[2]将全局均值池化得到的全局特征与全卷积网络的局部特征相结合,来纠正局部分类错误。Wang等[3]对上采样和膨胀卷积进行修改,提出密集向上采样卷积(DUC)来捕获和解码更详细的信息。第二类研究方法:采用识别性能更强且更深层次的卷积网络来提高分割性能,如Noh等[4]提出DeconvNet,加深反卷积过程以获得更精细的分割结果。Ghiasi等[5]提出了基于拉普拉斯金字塔的多分辨率重建结构,使用高分辨率特征映射和乘法门控的跳跃连接,提高分割边界精度。Zhao等[6]以残差网络为基础提出了金字塔场景分割网络,得到了更好的上下文信息来提升分割效果。第三类研究方法:针对目标自身复杂性带来的困难,Dai等[7]在CNN中引入了学习空间几何形变的能力,更好地解决了具有空间形变的图像识别任务。Zhang等[8]提出比例自适应调节感受野的卷积方式来实现场景识别任务。第四类研究方法:特征融合方法,刘帆等[9]在网络前端将彩色图像和深度图像融合再进行特征提取,李庆武等[10]针对双目视觉图像分别进行处理并将结果融合,徐岩等[11]分别使用不同大小的卷积核提取图像中不同尺度的特征,再将特征融合来重建无雾图像。

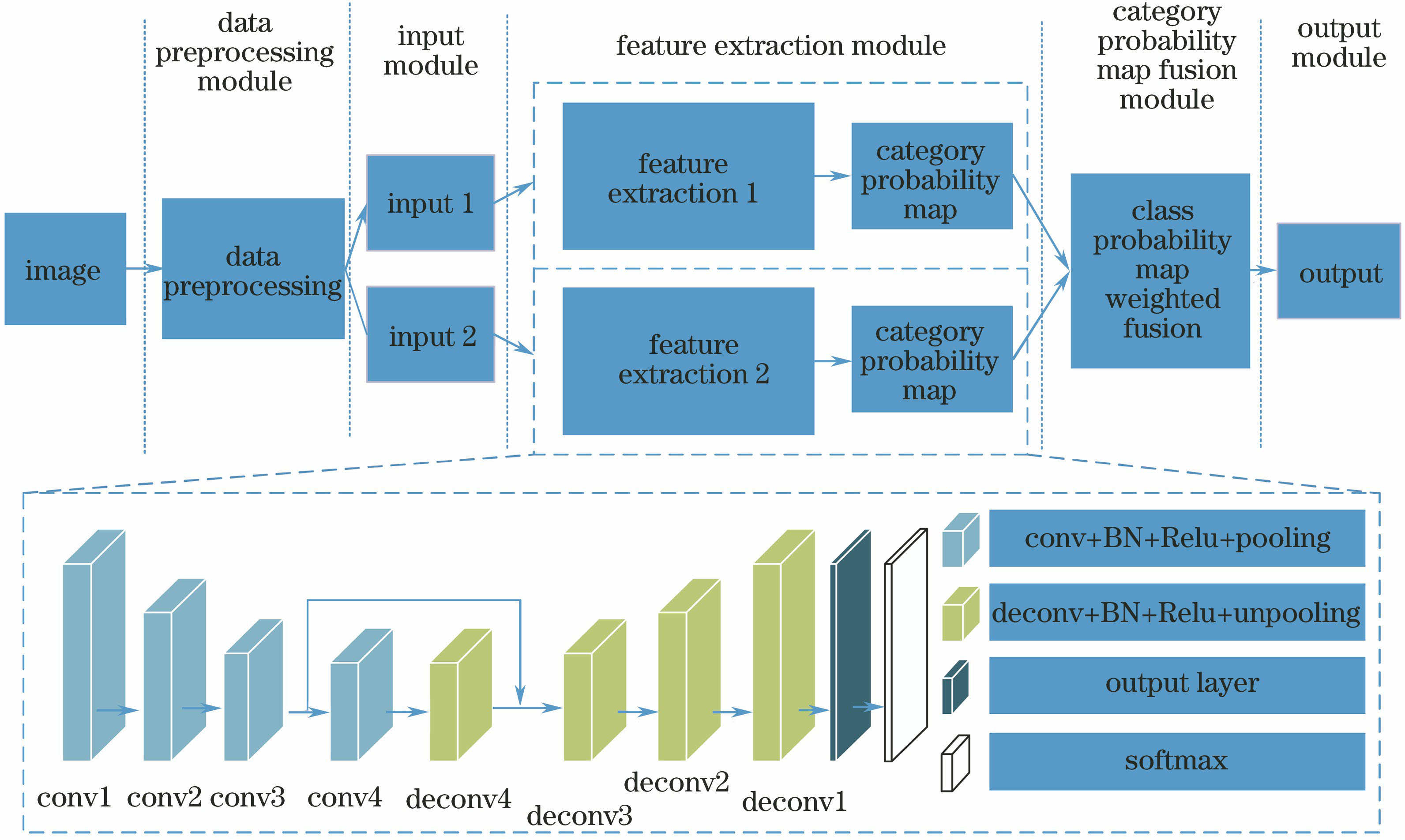

上述研究探索了深度学习在图像分割中的应用,但仍然存在一些不足。首先,上述文献以大型数据集为研究基础,小样本数据集应用研究少。其次,目前深度网络分割模型研究多考虑使用融合方法,但是针对边缘特征和位置的保持、提升分割精度仍然存在不足。为此,本文提出融合特征和决策的卷积-反卷积(CD-FFD)图像分割模型,所提模型新颖性主要体现在三个方面:1) 模型包括不同分支,从不同来源的图像中获取特征,如对于多光谱遥感影像,一个分支接收多光谱通道图像输入,另一个分支接收全色通道图像输入或高程信息等,构建并联的神经网络从不同源的输入提取特征,获取更多的、互补的信息,进而预测像素类别;2) 每个分支构建深度卷积-反卷积网络提取特征,在特征层级进行多尺度特征融合;3) 在两个分支网络末端使用类别概率图加权融合,在决策层级进行不同源决策的融合,充分融合两个神经网络分支的优势性能,使性能更优的网络分支在融合时发挥更大的作用。

2 CD-FFD图像分割模型

CD-FFD图像分割系统采用并联结构,由数据预处理模块、输入模块、特征提取和类别预测模块、类别概率图融合模块、输出模块组成,如

2.1 数据预处理模块

1) Weizmann Horse数据集

Weizmann Horse数据集[12]包含RGB彩色图像、二值标记图像、灰度图像各328幅,其中前200幅图像作为训练集,后128幅作为测试集。其样本量对于深度网络的训练远远不够,进行数据增强,方法为对训练集图像间隔5°进行旋转,间隔5 pixel对图像进行向右、向左移动,同时按照不同比例进行放大和缩小,得到RGB图像、灰度图像、二值标记图像各11973幅(包含11773幅训练图像+200幅验证图像)。在Weizmann Horse数据集中,RGB图像与二值标记图像、灰度图像尺寸不一致,为了使样本图像与标签图像对应起来,将所有图像归一化为同一尺寸(500×500)。扩充后数据集图像中的目标(马)具有不同的姿态、位置,光照、色彩、纹理、背景等信息也复杂各异,分割出目标具有挑战性。

2) vaihigen数据集

vaihigen数据集[13]包含33幅IRRG(红外、红、绿三通道)图像和数字表面模型(DSM)信息,图像尺寸不一,其中IRRG图像的三通道内容分别对应近红外、红色和绿色波段,DSM为单通道图像,对应于DSM高度,图像空间分辨率为9 cm。vaihigen数据集中仅有16幅图像包含标记图像,将其中11幅图像(1、3、5、7、13、17、21、23、26、32、37)作为训练集,5幅图像(11、15、28、30、34)作为测试集。训练集图像按照不同比例进行放大和缩小,并按90°、180°、270°方向进行旋转。将训练图像按步长进行裁剪,裁剪后每个图像块尺寸为500×500,得到IRRG图像、DSM图像、二值标记图像各34712幅。遥感图像中建筑物尺寸、方向、周围环境各异,目标边缘模糊等,分割出目标具有挑战性。

图 1. 融合特征和决策的卷积-反卷积网络图像分割模型

Fig. 1. Convolution-deconvolution image segmentation model for fusion features and decision

2.2 输入模块

CD-FFD图像分割系统采用并联结构,具有两个神经网络分支,分别采用不同源信息输入。在Weizmann Horse数据集实验中采用RGB图像和灰度图像,vaihigen数据集实验中采用IRRG图像和DSM图像,分别按照500×500的尺寸对各图像进行裁剪作为网络输入。

2.3 特征提取和类别预测模块

CD-FFD模型包含两个结构相同的特征提取和类别预测模块,分别用于对不同类型的输入信息进行学习和预测,并得到两组权重系数。特征提取和类别预测模块采用卷积-反卷积结构,卷积阶段通过深度CNN进行特征提取,反卷积阶段根据特征进行重建,通过Softmax层将具有相似特征的像素以高的概率赋予所属类别。卷积和反卷积阶段通过多级尺度特征融合,在全局和局部细节方面为模型提供更多的信息,从而得到更高的分割完整度。

特征提取和类别预测模块由卷积、下采样(池化)、反卷积、上采样(反池化)、输出层及Softmax层构成,卷积阶段和反卷积阶段完全对称,呈镜像关系。由于应用中样本数目和目标类别数目相对PASCAL VOC等数据集较少,因此选择了有限的深度,包括10层卷积层(conv)和4层池化层(pooling),反卷积阶段同样包括10层反卷积层(deconv)和4层反池化层(unpooling)。在每层卷积层和反卷积之后进行数据归一化(BN)和激活操作(Relu)。网络的输入尺寸设置为300×300。

卷积阶段采用3×3的卷积核进行特征提取,通过多个3×3的堆叠卷积层可以获得和大尺寸卷积层相同大小的感受野,且参数更少。池化层选择最大池化,保留更多的纹理信息,并将特征图进行2倍下采样。反卷积阶段使用3×3大小的核进行反卷积操作来恢复特征图,连接反池化层将特征图进行2倍上采样。反卷积末端连接输出层得到两张特征图,输入Softmax层获得两张与输入图像具有相同大小的概率图。

在卷积网络学习过程中,不同深度的卷积层学习到的特征其层次是不同的,浅层的卷积层学习到的是局部特征,随着卷积层深度增加,感受野也随之增大,学习到的特征包含的全局信息更多,一般来说卷积第三阶段(conv3)后得到的分割结果较好,这是由于太过浅层学习的特征对局部变化比较敏感,抗噪性能不佳,而更高层学到的特征对于局部变化不敏感,但缺点是梯度消失使恢复的边界模糊,仅利用这样的特征只能得到一个笼统的预测,很难获得准确的目标边界。因此,将浅层的特征与深层的特征融合有助于解决深层特征梯度消失的问题,以便获得更精细的分割结果。具体到CD-FFD模型,conv1、conv2阶段层次浅,学习到的特征多为局部特征;conv3、conv4阶段则包含较多的全局信息,conv4特征由于卷积层数较深,目标特征则更为突出且背景干扰少,但conv3与conv4相比包含更多的细节信息,因此将conv3与conv4的特征融合以提升模型的细节处理能力。在反卷积阶段将conv4提取的特征图上采样得到的特征图和conv3得到的特征图融合,加强边缘等细节恢复能力。

在CD-FFD网络中池化层导致特征分辨率减小,因此在反卷积阶段使用反池化层扩大特征图的尺寸,并且利用卷积阶段池化操作时保留的特征位置信息,实现特征上采样的精细化,提高特征恢复的准确性。反池化操作扩充的位置使用0填充得到稀疏的特征图,再对其进行反卷积操作,将稀疏的特征图变得致密,获得更为精细的预测结果图,送入类别概率图融合模块。

2.4 类别概率图融合模块

目标分割任务实际上是预测每个像素的类别,既要较好地表征目标全局特征,又要较多地保留目标边缘特征,因此对细节特征的要求非常高,不同源的数据提供的信息虽有冗余,但又互补,深度模型有利于从不同数据中提取更多的信息,通过融合互补为分割、分类等任务性能的提升提供可能。所提模型通过两个神经网络分支从不同数据中提取特征,进而得到两组类别概率预测图,分别对应于不同数据得到的类别预测结果,在此进行决策级的融合,对两个网络分支的结果加权融合,进一步提升分割性能。用

式中

2.5 输出

类别概率图融合模块对两个分支网络获得的两组概率图采用加权融合进行决策级的融合,得到两张融合后的结果概率图,分别代表了最终的每个像素属于目标和背景的概率,输出模块将两张新的概率图基于最大概率进行类别决策,属于目标的像素点标记为1,非目标像素点为0。

2.6 CD-FFD模型数据处理流程

图 2. 数据处理流程。(a) CD-FFD 数据处理流程;(b) CD-FFD 每一分支网络数据处理流程

Fig. 2. Flow charts of data processing. (a) Data processing of CD-FFD; (b) each branch network data processing of CD-FFD

2.7 网络训练

由于分割任务较VGG16在ImageNet上的目标类别和训练样本少很多,本文提出的网络模型卷积层数、卷积核数量均大大减少,因此不使用VGG16的预训练模型初始化权重,而是重新训练网络。基于迁移学习的思想训练模型,训练包括两步:1) 在Weizmann Horse实验中先使用PASCAL VOC 2012 数据集训练各分支网络,vaihigen数据集实验中先使用Aerial Image数据集训练各分支网络;2) 使用不同类型的输入信息对上一步训练好的网络模型进行微调得到两个具有不同权重系数的分支网络。

在网络训练时,Weizmann Horse实验参数设定:批量输入大小为6;使用随机梯度下降训练模型,学习率为0.01,每10000次迭代将学习率降低0.1;动量为0.95;训练损失最大迭代次数为100000。vaihigen数据集实验参数设定:批量输入大小为6;使用随机梯度下降训练模型,学习率为0.01,每20000次迭代将学习率降低0.1;动量为0.95;训练损失最大迭代次数为100000。

2.8 评价方式

采用目标完整度(COM)[14]、全局精度(Global acc)和交并比(IOU)三个指标定量评价分割结果。Global acc表示每个像素点分类的正确率,COM度量分割图像目标区域匹配标记图像目标区域的比例,IOU是一个总体度量,和COM相比,IOU还考虑了目标被错分为背景的情况。它们被定义为

式中

3 实验结果和分析

实验包括两部分,第一部分是CD-FFD模型在Weizmann Horse和vaihigen数据集的实验结果和分析,第二部分是CD-FFD与现有算法在Weizmann Horse和vaihigen数据集上的性能评价。实验在配备64位Ubuntu系统的工作站上完成,硬件配置为Intel(R) Xeon(R) CPU E5-2690 v32.60GHz处理器、256 GB内存和4 TB硬盘。使用一块NVIDIA Tesla K40c 12 GB显存GPU进行加速。CD-FFD模型的训练使用Caffe[15]平台,代码在MATLAB上编写完成。

3.1 CD-FFD实验结果和分析

3.1.1 Weizmann Horse数据集

实验采用RGB图像和灰度图像分别训练两个神经网络分支,得到两个具有不同权重系数的分支网络,分别用RGB-Net和GRAY-Net表示。

图 3. CD-FFD模型分割结果。(a) RGB图像;(b)灰度图像;(c) RGB-Net分割结果;(d) GRAY-Net分割结果;(e) CD-FFD分割结果;(f)标签图像

Fig. 3. Segmentation results of CD-FFD model. (a) RGB image; (b) gray image; (c) segmentation result of RGB-Net; (d) segmentation result of GRAY-Net; (e) segmentation result of CD-FFD; (f) ground-truth

由

为了充分验证CD-FFD模型的分割性能,分别在Weizmann Horse数据集实验验证图像(样本量200,目标形态复杂,包含各种角度样本)和Weizmann Horse测试集(样本量128,目标形态简单,样本角度单一)上进行了测试,评价结果分别如

表 1. CD-FFD Weizmann Horse 200幅验证图像评价结果

Table 1. Evaluation results of CD-FFD on 200 validation images from Weizmann Horse

|

表 2. CD-FFD Weizmann horse 128幅测试图像评价结果

Table 2. Evaluation results of 128 test images from Weizmann horse dataset

|

由

3.1.2 vaihigen数据集

vaihigen数据集实验中采用IRRG图像和DSM图像分别训练两个神经网络分支,DSM图像包含成像对象的高度信息,有利于区分高低不同的目标,可为建筑物提取提供有效的信息,来源于两种输入的分支网络分别用IRRG-Net和DSM-Net表示。

图 4. CD-FFD模型分割结果。(a) IRRG图像;(b) DSM图像;(c) IRRG-Net分割结果;(d) DSM-Net分割结果;(e) CD-FFD分割结果;(f)标签图像

Fig. 4. Segmentation results of CD-FFD model. (a) IRRG image; (b) DSM image; (c) segmentation result of IRRG-Net; (d) segmentation result of DSM-Net; (e) segmentation result of CD-FFD; (f) ground-truth

由

表 3. CD-FFD Vaihigen 5幅测试图像评价结果

Table 3. Evaluation results of 5 test images from vaihigen dataset

|

3.2 CD-FFD模型和其他模型的比较分析

3.2.1 Weizmann Horse数据集

在Weizmann Horse数据集[12]上对CD-FFD模型和现有的研究成果进行了比较。由于现有文献对实验结果均采用Global acc和IOU两个指标进行评价,为了统一也选用Global acc和IOU两个评价指标。CD-FFD模型与现有研究成果对比如

表 4. Weizmann Horse数据集128幅测试图像现有成果对比

Table 4. Comparison among existing results of 128 test images from Weizmann Horse dataset

|

3.2.2 vaihigen数据集

为了与现有的研究成果比较,在vaihigen数据集测试集上采用Global acc进行评价,结果对比如

表 5. Vaihigen数据集5幅测试图像现有成果对比

Table 5. Comparison among existing results of 5 test images from vaihigen dataset

|

比较方法中SegNet是具有对称结构的编码-解码深度卷积网络,编码阶段使用卷积网络提取特征,解码阶段使用卷积网络来进行特征上采样。CNN+RF方法针对原图及手工提取特征分别使用CNN、随机森林(RF)方法进行类别预测,再将输出结果进行融合获取最终分割结果,其中CNN包含4层卷积卷积层和两个全连接层。CNN+RF+CRF是在CNN+RF方法基础上再结合CRF进行平滑处理获取分割结果。文献[ 22]方法在SegNet网络的末端引入多核卷积层来进行多尺度预测,并使用残差网络将原图及手工提取进行融合特征。上述研究方法均未考虑神经网络内部不同深度卷积层之间特征提取层次不同,CD-FFD模型将浅层的特征与深层的特征进行融合,有助于解决深层特征梯度消失的问题,获得更精细的分割结果;在考虑信息融合时,CNN+RF采用乘法运算融合,预测结果受分割性能差的一方影响较大,文献[ 22]方法直接对特征进行融合,而CD-FFD采取决策级融合方式,在两个分支网络末端使用类别概率图加权融合,充分融合两个神经网络分支的优势性能,使性能更优的网络分支在融合时发挥更大的作用。与上述方法相比,CD-FFD模型取得了最高的分割精度,与文献[ 22]方法相比,其平均Global acc提高了2.98%。

4 CD-FFD模型其他图像实验

在CD-FFD实验中,分别对训练集进行了数据增强,以及缩放、旋转等操作,除了能扩充训练集样本数量使得模型训练充分之外,旋转等操作还可以增加目标角度变化范围,使得模型可以应对具有多种角度变化,以及形态多样的目标的复杂图像分割。以Weizmann Horse数据集训练得到的CD-FFD模型为例进行说明。

图 5. CD-FFD模型对其他图像的分割结果。(a)原始RGB图像;(b) CD-FFD分割结果

Fig. 5. Segmentation results of other images by CD-FFD model. (a) Original RGB images; (b) segmentationresults of CD-FFD

由

5 结论

提出CD-FFD图像分割模型,该模型从不同分支、不同来源的图像中获取特征,获取更多互补的信息。每个分支构建深度卷积-反卷积网络提取特征,分别在特征层级和决策层级进行融合,充分融合两个神经网络分支的优势性能,提升算法性能。在Weizmann Horse、vaihigen数据集上获得了有竞争力的性能,分割精度分别提高了6.1%和2.98%。另外,通过数据增强方法,模型获得了更强的稳健性,并且在随机选取网络上的其他图像上依然可以获得很好的分割结果,也体现了该模型具有比较广泛的应用范围。未来的研究内容主要是解决高分辨率遥感图像识别中存在的目标遮挡问题。

[1] LongJ, ShelhamerE, DarrellT. Fully convolutional networks for semantic segmentation[C]∥IEEE Conference on Computer Vision and Pattern Recognition(CVPR), 2015: 3431- 3440.

[3] Wang PQ, Chen PF, YuanY, et al. Understanding convolution for semantic segmentation[C]∥IEEE Winter Conference on Applications of Computer Vision (WACV), 2018: 1451- 1460.

[4] NohH, HongS, HanB. Learning deconvolution network for semantic segmentation[C]∥IEEE International Conference on Computer Vision(ICCV), 2015: 1520- 1528.

[5] GhiasiG, Fowlkes CC. Laplacianpyramid reconstruction and refinement for semantic segmentation[C]∥European Conference on Computer Vision. Springer, 2016: 519- 534.

[6] Zhao HS, Shi JP, Qi XJ, et al. Pyramid scene parsing network[C]∥IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2017: 6230- 6239.

[7] Dai JF, Qi HZ, Xiong YW, et al. Deformable convolutional networks[C]∥IEEE International Conference on Computer Vision (ICCV), 2017: 764- 773.

[8] ZhangR, TangS, Zhang YD, et al. Scale-adaptive convolutions for scene parsing[C]∥IEEE International Conference on Computer Vision (ICCV), 2017: 2050- 2058.

[9] 刘帆, 刘鹏远, 张峻宁, 等. 基于双流卷积神经网络的RGB-D图像联合检测[J]. 激光与光电子学进展, 2018, 55(2): 021503.

[10] 李庆武, 周亚琴, 马云鹏, 等. 基于双目视觉的显著性目标检测方法[J]. 光学学报, 2018, 38(3): 0315002.

[11] 徐岩, 孙美双. 基于多特征融合的卷积神经网络图像去雾算法[J]. 激光与光电子学进展, 2018, 55(3): 031012.

[13] Gerke M. Use of the stair vision library within the ISPRS 2D semantic labeling benchmark (vaihingen)[J]. Technical Report, University of Twente, 2014.

[14] Heipke C, Mayer H, Wiedemann C, et al. Evaluation of automatic road extraction[J]. International Archives of Photogrammetry and Remote Sensing, 1997, 32(3 SECT 4W2): 151-160.

[15] JiaY, ShelhamerE, DonahueJ, et al. Caffe: convolutional architecture for fast feature embedding[C]∥Proceedings of the 22nd ACM International Conference on Multimedia. ACM, 2014: 675- 678.

[16] BertelliL, YuT, VuD, et al. Kernelized structural SVM learning for supervised object segmentation[C]∥Computer Vision and Pattern Recognition, 2011: 2153- 2160.

[17] YangJ, PriceB, CohenS, et al. Patchcut: data-driven object segmentation via local shape transfer[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.2015: 1770- 1778.

[19] VisinF, CicconeM, RomeroA, et al. Reseg: a recurrent neural network-based model for semantic segmentation[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition Workshops.2016: 41- 48.

[21] PaisitkriangkraiS, SherrahJ, JanneyP, et al. Effective semantic pixel labelling with convolutional networks and conditional random fields[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition Workshops.2015: 36- 43.

[22] AudebertN, Le SauxB, LefèvreS. Semantic segmentation of earth observation data using multimodal and multi-scale deep networks[C]∥Asian Conference on Computer Vision. Cham: Springer, 2016: 180- 196.

Article Outline

冯晨霄, 汪西莉. 融合特征和决策的卷积-反卷积图像分割模型[J]. 激光与光电子学进展, 2019, 56(1): 011008. Chenxiao Feng, Xili Wang. Convolution-Deconvolution Image Segmentation Model for Fusion Features and Decision[J]. Laser & Optoelectronics Progress, 2019, 56(1): 011008.