基于卷积神经网络去噪正则化的条纹图修复  下载: 1140次

下载: 1140次

1 引言

条纹投影轮廓术(FPP)是一种广泛使用的主动光学三维(3D)测量技术。基本测量过程如下:投影一幅或一组结构条纹到物体表面,相机捕获被物体高度调制的条纹图像,采用相关算法计算条纹中携带的相位信息;根据相位与高度之间的映射关系以及世界坐标与图像像素坐标之间的映射关系来得到最终的三维信息。条纹投影轮廓术具有高精度、快速、全场测量以及应用广泛的优点[1-2],但是在测量表面具有严重不均匀反射的物体,例如金属、陶瓷制品时,采集到的条纹中某些区域会因为反射光过强而出现像素饱和甚至条纹丢失现象。这种 “高光区域”的存在会导致三维面形重建出现误差。

为了测量高反物体,有学者陆续提出了一些解决方案。例如:文献[ 3]从反射光的偏振特性出发,在测量系统中添加偏振片来辅助完成测量;文献[ 4]则多次调整曝光时间,获取多组相移条纹图,从每个同名像素中选择强度最高而未饱和的像素融合出质量好的条纹图,实现被测物体的三维面形测量;文献[ 5]通过预先投影灰度图序列来确定投影光场的强度分布范围,避免物体表面高反区域存在饱和像素,同时保证低反射率区域有较高的信噪比(SNR);文献[ 6]从测量系统的硬件改进入手,一方面通过提高投影仪的刷新频率,减少了投影时间,另一方面通过使用多个LED芯片和脉冲宽度调制(PWM)技术的配合提高了投影仪的动态范围以及输出光强度,从而实现快速、高质量的高动态范围测量。

上述方法需要复杂的操作流程或者额外的硬件设备开销。为了降低测量过程的时间开销以及硬件需求,人们利用图像处理方法,研究直接对高光区域的条纹进行修复的方法。文献[ 7]提出利用双树复小波变换对条纹图进行迭代正则化修复的方法。文献[ 8]进一步根据高光区域邻域条纹的几何形貌计算出高光区域的条纹分布的初值迭代值来引导修复过程。

本文提出了一种新的更可靠的条纹迭代修复方法。该方法引入携带物体真实高度信息的条纹来指导高光区域的条纹迭代修复。所以本文方法利用两个不同曝光时间条纹图,通过预处理将其融合形成迭代修复过程的初值,并将卷积神经网络(CNN)去噪正则化的图像修复方法[9-10]引入条纹的迭代修复中。模拟与实际实验结果表明,所提方法在条纹修复效果以及运算时间上都比其他方法具有较大优势。利用修复之后的条纹可以还原物体的3D面形信息。

2 基本原理

2.1 结构光三维重建

傅里叶变换轮廓术(FTP)和相移轮廓术(PMP)是常用的结构光三维重建方法,它们具有相同的原理光路图。傅里叶变换轮廓术测量速度快,相移轮廓术具有更高精度。测量时,投影装置将条纹图投射到置于参考平面的物体上,相机获取受到物体调制的条纹图。不失一般性,采集条纹图可表示为

式中:Ii(x,y)是条纹的灰度分布;a(x,y)为背景强度;b(x,y)是条纹对比度;ϕ(x,y)是条纹的相位信息;f0为条纹的载频;N是相移步数;i=0,1,…,N-1(傅里叶变换轮廓术,N=1;相移轮廓术,N≥3)。

相移轮廓术采用相移算法计算相位,重建物体面形。以四步相移算法为例,截断相位表示为

调制度作为条纹质量好坏评价参数的调制信息(也反映相位计算的可靠性),对于相移轮廓术可以用如下公式计算[11]:

FTP[12]只需采集单幅条纹进行面形重建。设以(1)式表示的条纹图,其傅里叶变换表示为

式中:F0(u,v)、F1(u-f0,v)和

(5)式的模值即为调制度分布,而相位信息ϕ(x,y)可以用形变条纹的相位减去参考平面相位获得。

无论FTP还是PMP方法,直接计算出的是截断相位,通过相位展开便可以获取其连续相位分布。在本文方法中,利用条纹的调制度信息来确定出高反光区域,融合出条纹修复作为迭代算法的初始值。

2.2 基于CNN去噪正则化的图像修复

图像修复属于图像复原范畴,图像退化过程可以表示为y=Ax+n,其中n为噪声项,A是退化函数。从一幅退化后图像y复原出未退化图像x的估计值

式中:1/2‖y-Ax‖2和R(x)分别为保真项和正则化项。前者保证最终估计值符合实际退化形式,后者在迭代过程中提供有效的先验信息,参数λ控制先验项所占权重。求解(6)式的方法主要分为模型优化法和辨别学习法,它们各具特点。使用不同的退化矩阵,模型优化法可以灵活处理各类图像退化问题,不足之处是耗时;辨别学习法则需要大量训练数据,针对特定问题实现快速且高质量的图像复原。融合上述两种方法的优点,研究图像复原问题,近年来受到越来越多的关注。本文将模型优化方法与学习方法相结合。采用变量分离技术,如半二次方分裂(HQS)[9,13]、交替方向乘子法(ADMM)[14],分别处理保真项和正则化项,即:将对

采用HQS分解方法,引入辅助变量z,令z=x,则(6)式转化为

式中:μ为在迭代过程中的惩罚系数。对(7)式的求解过程可以用交替求解以下两个子问题来代替:

第一个公式是受约束的最小二乘问题,可以用下式求解,其中I为单位矩阵。

第二个公式是对z的求解最终化简为高斯去噪问题,其中λ/μ为高斯噪声的方差。

卷积神经网络具有良好的去噪性能,可以用于求解(10)式,并且具有高度并行的特性,在GPU上运算可以大幅缩短运算时间。

3 高光区域条纹修复

为了修复存在高光区域的条纹,本文采集两幅不同曝光时间的条纹图,采用基于卷积神经网络去噪正则化方法进行条纹修复。由于不同曝光时间条纹图的平均灰度、条纹对比度以及信噪比存在差异,而去噪正则化方法假设输入值与理想值的差异分布形式为高斯噪声形式,即噪声问题在迭代过程中更容易被消除,所以在条纹修复中,需要尽可能减小融合后条纹在融合区域及其周围区域的强度与对比度的差异。本文引入灰度调节过程去得到期望的迭代初值,然后把灰度调节过程引入的噪声问题以及灰度调节过程未完全处理的灰度分布差异问题交给去噪正则化过程去处理。在条纹修复中,采用二元矩阵A(高光区域为0,其余区域为1)来标记出需要修复的区域。

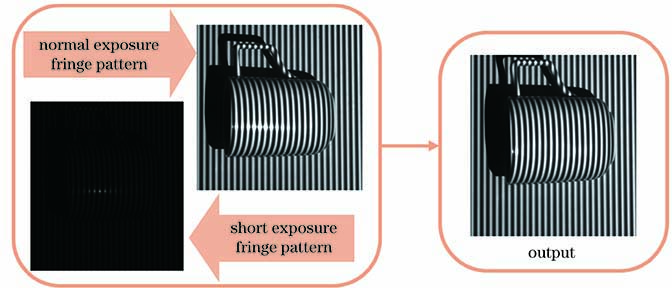

完整修复流程如下:1)采集两幅条纹,一幅正常曝光时间(T)条纹图,其中包含高光区域,一幅短曝光时间(实验中使用T/30~T/40)条纹图,对应区域条纹未饱和;2)对短曝光条纹调制度采用Otsu[18]方法确定高光区域;3)融合两次不同曝光时间的条纹图,确定条纹图修复的初值迭代值;4)使用基于CNN去噪正则化方法修复条纹。

3.1 高光区域确定

由于条纹呈周期分布,直接采用阈值分割方法来分割高光区域存在困难。条纹的调制度信息标识了条纹质量的好坏和相位计算的可靠性。由于高光区域内条纹很容易被淹没在过亮的反射光中,其调制度低,而其他条纹质量不好的区域调制度也低,不利于阈值确定,本文选择计算短曝光情况下获取的条纹图的调制度来确定高光区域。短曝光条纹图,虽然避免了高光区域过曝,但其他地方的条纹对比度和信噪比较低。为了有效且方便地抑制噪声,本文采用傅里叶变换方法来计算短曝光时间条纹图的调制度分布。

图 3. 不同方法确定的高光区域对比。(a)正常曝光的条纹图;(b)短曝光的条纹图; (c)图3 (a)的调制度;(d)图3 (b)的调制度;(e)Otsu方法对图3 (a)的结果; (f) Otsu方法对图3 (d)的结果

Fig. 3. Comparison of highlight areas determined by different methods. (a) Normal exposure time fringe pattern; (b) short exposure time fringe pattern; (c) modulation of Fig. 3 (a); (d) modulation of Fig. 3 (b); (e) result image of Fig. 3 (a) using Otsu threshold method; (f) result image of Fig. 3 (b) using Otsu threshold method

3.2 迭代初值的确定

条纹修复过程中关键一步是获得携带物体表面的真实高度信息的迭代初始值。获取的短曝光条纹图在高光区域未出现像素饱和,反映了该区域物体高度的真实分布。将两个不同曝光时间的条纹图像相融合,能得到反映物体高度分布的条纹。但相对于正常曝光时间采集的条纹,短曝光条纹图有着相对较低的对比度和SNR。如果直接将该条纹对应区域插入正常曝光的条纹中高光区来形成迭代初值,会因为迭代初值与理想结果相似度较低,而引起

1) 利用高光区域R附近的亮条纹的强度信息,调节填入高光区域的暗条纹的强度,使其与周围条纹有相近的灰度动态范围。具体做法为:对R进行膨胀操作后得到区域Ω,Ω中不包括R的区域表示为Ω\R;分别计算短曝光条纹图中R区域和正常曝光条纹图Ω\R区域的平均灰度,然后减去各自区域内最小灰度值,得到短曝光条纹图R区域的条纹强度动态范围Rdark ,正常曝光条纹Ω\R区域的动态范围Rbright。将

2) 为了避免灰度拉伸后的条纹图中灰度动态范围不均匀或出现灰度饱和,将短曝光条纹图调制度分布M(x,y)进行归一化,即M*(x,y)=

最后,预处理过程中的灰度调节可以表示为

3) 通过公式Ifused=

3.3 条纹图迭代修复过程

本文提出的获取不同曝光时间的两帧条纹图,利用基于CNN去噪正则化方法进行条纹修复的整个处理流程如

4 模拟与实验

模拟与实验用以验证所提方法用于条纹图修复的有效性和优势。

4.1 计算机仿真

计算机模拟的物体用二维高斯函数表示,设条纹投影测量系统中相机与投影仪夹角为30°。将物体表面法线方向与入射光线夹角余弦值大于0.95的部分设为条纹缺失区域,用以模拟强反射区域,模拟原始完整条纹如

![修复结果。(a) 标准条纹图;(b)具有高光区域的模拟条纹图; (c)添加高斯噪声的迭代初值;(d)文献[19]方法的修复结果;(e)文献[20]方法修复结果;(f)本文方法修复结果](/richHtml/gxxb/2020/40/18/1810002/img_6.jpg)

图 6. 修复结果。(a) 标准条纹图;(b)具有高光区域的模拟条纹图; (c)添加高斯噪声的迭代初值;(d)文献[ 19]方法的修复结果;(e)文献[ 20]方法修复结果;(f)本文方法修复结果

Fig. 6. Results of inpainting. (a) Standard fringe pattern; (b) simulated fringe pattern with highlight region; (c) initial value of the iteration with Gaussian noise; (d) inpainting result of Ref. [19] method; (e) inpainting result of Ref. [20] method; (f) inpainting result of proposed method

由不同曝光时间获取的条纹图融合后得到的迭代初值有效地约束了(7)式的解空间,同时深度卷积神经网络提供的先验项足够强大,整个过程只用了5次迭代就获得了令人满意的结果。

4.2 实验验证

通过实验验证了本文方法用于实际采集到的存在高光区域条纹修复的有效性,并从融合的条纹中获取了反映物体三维面形的相位信息。实验装置如

表 1. 文献[ 19]方法、文献[ 20]方法和本文方法在用时、PSNR和重建相位的RMSE对比

Table 1. Comparison in execution time, PSNR, and RMSE of phase reconstruction with Ref. [19] method, Ref. [20] method, and proposed method

|

本文先验证低曝光条纹的引入在CNN修复方法中的效果。作为对比,也对具有高光区的条纹直接采用默认迭代初始值的图像复原卷积神经网络(IRCNN)方法进行了修复。对比结果如

另外,还与文献[ 4]所提的多重曝光融合方法进行了实验对比。实验中采集了25帧不同曝光时间的条纹。曝光时间为2000~50000 μs,每隔2000 μs采集一帧。用于本文方法修复的两张条纹图的曝光时间为2000~50000 μs。

对文献[

19]方法、文献[

20]方法、本文方法以及文献[

4]方法得到的图像进行对比。不同方法修复的条纹如

从不同的条纹修复算法所修复的条纹中计算出相位信息就能用于三维面形重建。采用四步相移方法计算截断相位,用基于调制度的相位展开方法展开截断相位得到最终相位分布。

图 8. 不同初值的修复结果对比。(a)正常曝光条纹图;(b)直接对图8 (a)修复的结果;(c) 两帧融合得到的迭代初始图;(d)利用图8 (c)修复的结果

Fig. 8. Comparison of inpainting results with different initial values. (a) Normal exposure time fringe pattern; (b) inpainting result of Fig. 8 (a); (c) initial image-fused by proposed method; (d) inpainting result of Fig. 8 (c)

![条纹图修复结果。(a)原始条纹图;(b)迭代初值图;(c)文献[4]方法修复的结果;(d)文献[19]方法修复的结果;(e)文献[20]方法修复的结果;(f)本文方法修复的结果](/richHtml/gxxb/2020/40/18/1810002/img_9.jpg)

图 9. 条纹图修复结果。(a)原始条纹图;(b)迭代初值图;(c)文献[ 4]方法修复的结果;(d)文献[ 19]方法修复的结果;(e)文献[ 20]方法修复的结果;(f)本文方法修复的结果

Fig. 9. Fringe pattern inpainting results. (a) Original fringe pattern; (b) initial value for iteration; (c) inpainting result of Ref. [4] method; (d) inpainting result of Ref. [19] method; (e) inpainting result of Ref. [20] method; (f) inpainting result of proposed method

![相位恢复结果。(a) 文献[4]方法结果;(b)文献[19]方法结果;(c) 文献[20]方法结果;(d)直接用迭代初值的结果;(e)本文方法结果](/richHtml/gxxb/2020/40/18/1810002/img_10.jpg)

图 10. 相位恢复结果。(a) 文献[ 4]方法结果;(b)文献[ 19]方法结果;(c) 文献[ 20]方法结果;(d)直接用迭代初值的结果;(e)本文方法结果

Fig. 10. Phase reconstruction results. (a) Result of Ref. [4] method; (b) result of Ref. [19] method; (c) result of Ref. [20] method; (d) result of iterative initial value; (e) result of proposed method

为了进一步分析本文方法在更大缺失范围下的适用性,对其他物体使用本文方法进行测量。

本文采用四步相移的方法分别从修复前后的条纹图中重建了物体的相位分布,如

图 11. 不同曝光时间下条纹图的灰度分布对比。(a)正常曝光时间条纹图;(b)短曝光时间条纹图;(c)本文方法修复的条纹图;(d)正常曝光时间条纹图和(e)修复过后条纹图第256行,170~370列的灰度分布

Fig. 11. Comparsion of gray distribution of fringe pattern under different exposure time. (a) Normal exposure time fringe pattern; (b) short exposure time fringe pattern; (c) inpainting result of proposed method; gray distribution of 170--370 columns in 256 row of (d) normal exposure time fringe pattern and (e) inpainting fringe pattern

图 12. 重建结果对比。(a)正常曝光时间条纹图重建结果;(b)使用本文方法修复的条纹图重建结果

Fig. 12. Comparison of reconstruction results. (a) Reconstruction result using normal exposure time fringe pattern; (b) reconstruction result using proposed method inpainting fringe pattern

5 结论

本文提出条纹投影轮廓术测量高反射物体时条纹修复的方法。该方法只需要额外获取一张短曝光条纹图,通过短曝光条纹图调制度信息确定高光区域,并对短曝光条纹图做预处理,融入正常曝光条纹中,作为基于卷积神经网络去噪正则化算法的初值,再用迭代修复方法进行修复得到高质量条纹图。仿真和实验结果表明,通过结合合适的迭代初值以及有效的修复算法,所提方法能快速实现条纹图的局部高光区域修复,并且对于大范围的条纹图缺失情况仍然具有较高的适用性,从而实现高动态范围反射物体的三维面形重建。

[1] 苏显渝, 张启灿, 陈文静. 结构光三维成像技术[J]. 中国激光, 2014, 41(2): 0209001.

[2] 陈雨婷, 曹益平, 陈澄, 等. 采用不等占空比二元光栅的相位测量轮廓术[J]. 光学学报, 2018, 38(8): 0815021.

[4] Zhang S, Yau S T. High dynamic range scanning technique[J]. Optics Engineering, 2009, 48(3): 033604.

[6] Zhao H J, Liang X Y, Diao X C, et al. Rapid in situ 3D measurement of shiny object based on fast and high dynamic range digital fringe projector[J]. Optics and Lasers in Engineering, 2014, 54: 170-174.

[7] BudiantoB, Lun D P K. Inpainting for fringe projection profilometry based on iterative regularization[C]∥2014 19th International Conference on Digital Signal Processing. 20-23 Aug. 2014, Hong Kong, China.New York: IEEE Press, 2014: 668- 672.

[8] Budianto B, Lun D. Inpainting for fringe projection profilometry based on geometrically guided iterative regularization[J]. IEEE Transactions on Image Processing, 2015, 24(12): 5531-5542.

[9] ZhangK, Zuo WM, Gu SH, et al.Learning deep CNN denoiser prior for image restoration[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). 21-26 July 2017, Honolulu, HI, USA.New York: IEEE Press, 2017: 2808- 2817.

[10] MeinhardtT, MoellerM, HazirbasC, et al.Learning proximal operators: using denoising networks for regularizing inverse imaging problems[C]∥2017 IEEE International Conference on Computer Vision (ICCV). 22-29 Oct. 2017, Venice, Italy. New York: IEEE Press, 2017: 1799- 1808.

[11] Su X Y, Su L K, Li W S, et al. A new 3D profilometry based on modulation measurement[J]. Proceedings of SPIE, 1998, 3558: 1-7.

[12] Su X Y, Chen W J. Fourier transform profilometry: a review[J]. Optics and Lasers in Engineering, 2001, 35(5): 263-284.

[13] ZoranD, WeissY. From learning models of natural image patches to whole image restoration[C]∥2011 International Conference on Computer Vision. 6-13 Nov. 2011, Barcelona, Spain.New York: IEEE Press, 2011: 479- 486.

[14] Venkatakrishnan SV, Bouman CA, WohlbergB. Plug-and-play priors for model based reconstruction[C]∥2013 IEEE Global Conference on Signal and Information Processing. 3-5 Dec. 2013, Austin, TX, USA.New York: IEEE Press, 2013: 945- 948.

[15] Elad M, Aharon M. Image denoising via sparse and redundant representations over learned dictionaries[J]. IEEE Transactions on Image Processing, 2006, 15(12): 3736-3745.

[16] Dabov K, Foi A, Katkovnik V, et al. Image denoising by sparse 3D transform-domain collaborative filtering[J]. IEEE Transactions on Image Processing: a Publication of the IEEE Signal Processing Society, 2007, 16(8): 2080-2095.

[17] Zhang K, Zuo W M, Chen Y J, et al. Beyond a Gaussian denoiser: residual learning of deep CNN for image denoising[J]. IEEE Transactions on Image Processing: a Publication of the IEEE Signal Processing Society, 2017, 26(7): 3142-3155.

[18] Otsu N. A threshold selection method from gray-levelhistograms[J]. IEEE Transactions on Systems, Man, and Cybernetics, 1979, 9(1): 62-66.

[19] Bertozzi A, Schönlieb C B. Unconditionally stable schemes for higher order inpainting[J]. Communications in Mathematical Sciences, 2011, 9(2): 413-457.

[20] BertalmioM, SapiroG, CasellesV, et al.Image inpainting[C]∥Proceedings of the 27th Annual Conference on Computer Graphics and Interactive Techniques-SIGGRAPH'00.New York: ACM Press, 2000: 417- 424.

[21] VedaldiA, LencK. MatConvNet: convolutional neural networks for MATLAB[C]∥Proceedings of the 23rd ACM International Conference on Multimedia-MM'15. New York: ACM Press, 2015: 689- 692.

Article Outline

彭广泽, 陈文静. 基于卷积神经网络去噪正则化的条纹图修复[J]. 光学学报, 2020, 40(18): 1810002. Guangze Peng, Wenjing Chen. Fringe Pattern Inpainting Based on Convolutional Neural Network Denoising Regularization[J]. Acta Optica Sinica, 2020, 40(18): 1810002.