基于深度网络模型的视频序列中异常行为的检测方法  下载: 1234次

下载: 1234次

1 引言

异常行为识别在机器视觉和模式识别领域中备受关注,具有广泛的应用价值,如医疗辅助、家居养老等[1]。但是视频中的光线变化及背景的灵活多变、镜头的晃动、待识别对象的遮挡等都会给行为识别带来很大的困难[2]。在深度学习出现之前,有3种常见的行为识别方法:参数建模、视频立方体分析和模板匹配[3]。参数建模是建立一个用于表述视频中行为的模型,如隐马尔可夫模型[4]、贝叶斯网络[5]等。视频立方体分析[6]是把待测视频当作一个含有三维时空信息的立方体,并对这个立方体进行一系列的研究。模板匹配[7]是提取视频数据的特征,将之与已经定义的特征模板相匹配后进行识别。上述方法均难以客观地实现行为特征的提取。深度学习在特征提取过程中减少了人为参与,避免了人工选择的主观性和随意性,提高了提取的精确度[8]。

深度学习推动了人工智能的发展,在学术界掀起了探索和研究的热潮。相较于传统方法,深度学习算法可以有效提高识别精度,基于深度学习的人脸识别可以极大提高识别结果的准确率[9],实现根据人脸进行性别判断[10];深度学习也可以实现手写字的辨别[11]以及文本的识别与理解[12-14],能够有效提取那些因信息量大[15-16]、解析度低[17]而导致特征提取不准确的样本图像的特征。深度学习在行人检测[18]、手势识别[19]、语音识别[20]等领域也有广泛的应用。

在深度学习中,卷积神经网络(CNN)是一种常用的特征提取方法。通过卷积层对视频序列进行特征提取可以避免因人为因素导致特征提取不准确的问题;通过网络的池化层,改善对复杂高维数据的特征提取效果;通过共享卷积核的权值可以直接将未经过预处理的原始视频序列作为CNN的输入,有效地提高输入数据特征提取的精确度,提高深度网络的学习性能。基于CNN的识别方法大致有以下几种:基于单帧的识别方法——截取视频中的关键帧,然后基于每一帧进行深度学习表达,将截取自视频中的帧输入网络即可获得相应的识别结果;基于CNN扩展网络的识别方法——通过在CNN框架中找到时间域上的信息来描述局部的动态信息,最终实现整体识别效果的提升;基于双路CNN的识别方法——双路CNN就是2个CNN,最终的识别结果就是对2个CNN得到的结果取平均值,其中一个CNN是基于单帧的CNN,另一个则是把一个序列中连续帧的光流叠加后输入;基于长短期记忆网络(LSTM)的识别方法——通过LSTM在时间轴上对CNN的全连接层进行整合,其好处有2个:1) 有充分的时间对CNN提取的特征进行融合,2) LSTM可以帮助分辨出视频帧在原始视频中的顺序;三维卷积核(3D CNN)法——将原始视频序列堆砌成一个立方体,扩展卷积核,从相邻帧中得到每一个特征。

本文通过在CNN网络中引入自适应池化层,提高了最终的识别结果。

2 引入自适应的卷积神经网络

2.1 CNN结构

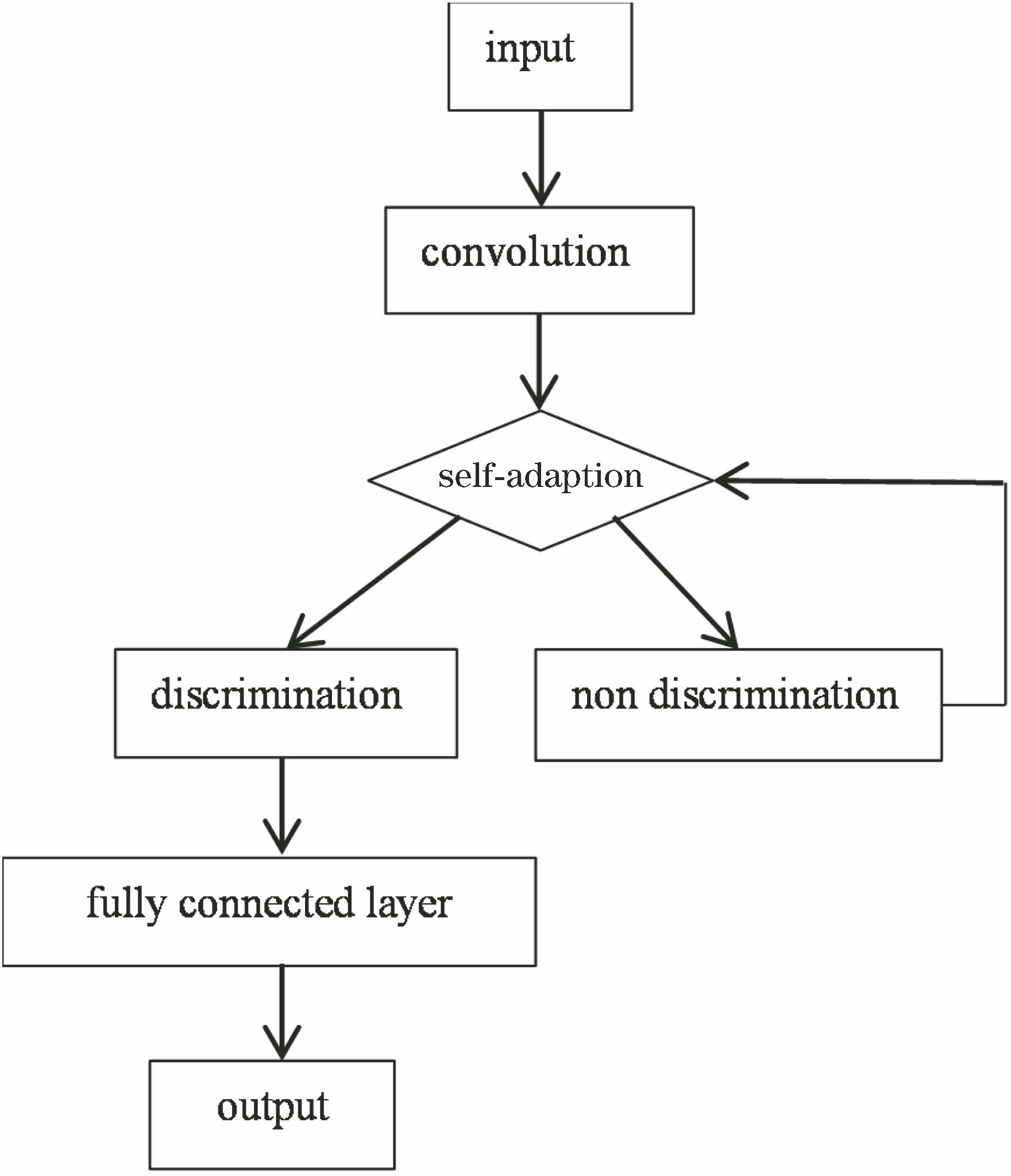

通过卷积层对输入的图片样本进行特征提取,经过自适应池化层对卷积层提取的特征进行特征压缩,降低计算量并提取主要特征,再由全连接层上的softmax分类器进行识别,最后输出分类结果。本文使用的网络在网络的池化层中添加了一个特征筛选的依据,将所有特征分为判别的特征和非判别的特征,如

2.2 自适应池化层

自适应池化层是该方法的关键模块,它可以在给定特征向量和已经合并的特征向量的情况下推断当前特征向量的重要性。如果它包含与已定义的正常行为或者异常行为正相关的特征,并且可能与其他行为负相关,那么它就是判别的特征信息;如果是冗余的特征,那么它就是非判别的特征信息。

将自适应合并向量

式中:

使用标准交叉熵损失

式中:

正则化器使用softmax最小化判别分数的熵,这样有助于选择判别的特征,并丢弃非判别的特征。参数

3 仿真与实验

3.1 样本选择

选取法国国家信息与自动化研究所(INRIA)圣诞动作采集序列(IXMAS)作为训练模型的样本。由11个人分别表示站立、交叉手臂、挠头、坐下、转身、步行、拳、踢等动作。该数据库从5个视角获得,室内4个方向和头顶一共安装5个摄像头。将拳、踢等行为标记为异常行为,共有7000张图片,其中有6000张用于训练,1000张用于测试;其他行为标记为正常行为,共有12000张图片,其中有10000张用于训练,2000张用于测试。在Caffe框架下使用CNN对该数据集进行二分类。

3.2 实验

Caffe是一种常用的深度学习框架。通过配置solver文件,训练模型并对其进行优化。同时还可以选择调用中央处理器(CPU)或者图形处理器(GPU)来训练模型。

3.2.1 网络结构

CNN共有1个输入层,3个卷积层,3个池化层,2个全连接层和1个输出层。设定的基本学习率是0.01,采用的是step学习策略,最大迭代次数为4000。

表 1. 卷积神经网络参数

Table 1. Convolutional neural network parameters

|

为保障模型的精度,做了3组对比实验:

1) 对数据集不做任何处理,按照两类行为的定义分成训练集和测试集并使用CNN进行训练和测试,如

2) 使用crop(Caffe深度学习框架里用于图像裁剪的参数)限制待测图片的有效区域,减轻了网络的计算量,最后使用CNN进行训练和测试,如

3) 使用Caffe(一种深度学习框架)提供的6种优化算法对神经网络进行优化。它们分别是随机梯度下降法(SGD),稳健的学习率方法(AdaDelta),自适应梯度算法(AdaGrad),基于梯度的优化方法(Adam和RMSProp),Nesterov的加速梯度法(NAG)。

本文采用误识率,即识别错误的结果占识别结果总数的比例,来评价各个算法识别结果的好坏。据

表 2. 6种优化算法误识率对比[21]

Table 2. Comparison of misidentification rates of six optimization algorithms[21]

|

3.2.2 引入自适应池化层后的结果对比

首先测试

原始CNN与引入自适应池化层的CNN在INRIA圣诞动作采集序列(IXMAS)上分别迭代4000次。由

由

本文算法与目前识别效果较好的几种算法作了对比。

1) 改进的轨迹跟踪(iDT):除深度学习外最好的算法,是改进的DT算法,利用相邻两帧的光流消除相机等外在因素的影响,识别结果稳定可靠,但是速度慢。

表 3. 误识率对比

Table 3. Misrecognition rate comparison

|

2) 双流融合(Two-Stream Fusion):对早期的双流网络中加以改进的双流网络,能更好地融合时空信息。

3) 时间分割网络(TSN):提高了双流网络处理长时间视频序列的能力。

4) 时间关系网络(TRN):TSN的改进版本。

由

表 4. 不同算法识别效果

Table 4. Recognition effect of different algorithms

|

本文还引用了UT-interaction database来验证算法的效果。取其中的punch和kick两种行为共6000 frame作为异常行为,其余几种动作共12000 frame作为正常行为加以测试。经过10000次迭代后,所有算法均已收敛,结果如

表 5. 在UT-interaction database上的识别效果

Table 5. Recognition effect on UT-interaction database

|

由于UT-interaction database是一个交互行为数据库,多人互动带来的干扰对几种模型产生了不同程度的影响。对比

4 结论

选用CNN对预定义的几种正常与异常行为进行训练并得到识别模型,最后将Caffe提供的几种优化算法进行对比。基于Adam算法,引入自适应池化层,通过进一步筛选卷积层提取出的特征来提高CNN模型的判别能力。与其他几种算法对比,结果表明训练出的模型能够基本满足预期的识别要求。但是本文算法实时性较差,只能用于线下视频的处理,能够以3 frame/s的速度处理视频序列。因此,今后研究目标为结合能够实现时序动作检测的CNN,做到实时识别智能监控系统中的异常行为。

[1] 汪力, 叶桦, 夏良正. 基于半马尔可夫和large-margin的动作识别[J]. 中国图象图形学报, 2009, 14(11): 2304-2310.

[2] 徐光祐, 曹媛媛. 动作识别与行为理解综述[J]. 中国图象图形学报, 2009, 14(2): 189-195.

[3] 胡琼, 秦磊, 黄庆明. 基于视觉的人体动作识别综述[J]. 计算机学报, 2013, 36(12): 2512-2524.

[6] 陈婷婷, 阮秋琦, 安高云. 视频中人体行为的慢特征提取算法[J]. 智能系统学报, 2015, 10(3): 381-386.

[8] 马永杰, 李雪燕, 宋晓凤. 基于改进深度卷积神经网络的交通标志识别[J]. 激光与光电子学进展, 2018, 55(12): 121009.

[9] 龙鑫, 苏寒松, 刘高华, 等. 一种基于角度距离损失函数和卷积神经网络的人脸识别算法[J]. 激光与光电子学进展, 2018, 55(12): 121505.

[10] 汪济民, 陆建峰. 基于卷积神经网络的人脸性别识别[J]. 现代电子技术, 2015, 38(7): 81-84.

[11] 金连文, 钟卓耀, 杨钊, 等. 深度学习在手写汉字识别中的应用综述[J]. 自动化学报, 2016, 42(8): 1125-1141.

[13] 常亮, 邓小明, 周明全, 等. 图像理解中的卷积神经网络[J]. 自动化学报, 2016, 42(9): 1300-1312.

[14] 蔡国永, 夏彬彬. 基于卷积神经网络的图文融合媒体情感预测[J]. 计算机应用, 2016, 36(2): 428-431, 477.

[17] 史紫腾, 王知人, 王瑞, 等. 基于卷积神经网络的单幅图像超分辨[J]. 激光与光电子学进展, 2018, 55(12): 121001.

[18] 张红颖, 王赛男, 胡文博. 改进的基于卷积神经网络的人数估计方法[J]. 激光与光电子学进展, 2018, 55(12): 121503.

[19] 蔡娟, 蔡坚勇, 廖晓东, 等. 基于卷积神经网络的手势识别初探[J]. 计算机系统应用, 2015, 24(4): 113-117.

[20] GoldbergY, HirstG. Neural network methods for natural language processing[M]. Williston, VT: Morgan & Claypool, 2017.

[21] 刘万军, 梁雪剑, 曲海成. 自适应增强卷积神经网络图像识别[J]. 中国图象图形学报, 2017, 22(12): 1723-1736.

吴沛佶, 梅雪, 何毅, 袁申强. 基于深度网络模型的视频序列中异常行为的检测方法[J]. 激光与光电子学进展, 2019, 56(13): 131101. Peiji Wu, Xue Mei, Yi He, Shenqiang Yuan. Method of Detecting Abnormal Behavior in Video Sequences Based on Deep Network Models[J]. Laser & Optoelectronics Progress, 2019, 56(13): 131101.