结合DenseNet与通道注意力机制的空对地目标检测算法  下载: 1148次

下载: 1148次

1 引言

空对地的目标检测广泛应用于多个领域中,如对地面的侦察与精确打击、海面的巡航与搜救、地面交通状况的监控、自然灾害救援。近年来,计算机视觉的研究推动了人工智能技术的快速发展,赋予了机器“看”的能力,而目标检测是计算机视觉领域中一个长期和具有挑战性的任务,也是解决更复杂视觉问题的基础。可将对目标检测的研究分为两种类型[1-2],一种是对特定实例的检测,包括检测单个类别(如面孔、行人)或少数特定类别。第二种是通用目标检测,可检测不同的预定义目标类别(如人、飞机、汽车)。自深度学习系统在2012年ImageNet举办的图像分类竞赛中获得冠军后,卷积神经网络(CNN)在图像领域取得了更高的分类精度[3],多数计算机视觉的相关研究都集中在深度学习方法上。近年来,基于深度学习的目标检测取得了巨大进步[4],主要算法框架分为一步(One-stage)目标检测算法与两步(Two-stage)目标检测算法。代表性的Two-stage[5-7]算法有R-CNN(Region-CNN)、Fast R-CNN、Faster R-CNN[8]等,这些算法放弃使用滑动窗口进行区域选择,采取有建议性的区域生成算法,如选择性搜索(SS)算法,减少了冗余候选区域的生成;特征提取也从传统的手工设计变为利用深度卷积网络[9-10]学习和提取图像中目标的深层特征,最后将特征向量进行分类和精确定位。Two-stage系列检测算法在检测精度上取得了很好的效果,但仍然无法实现端对端的实时检测。One-stage检测算法[11-12]可直接对输入图像进行类别预测与定位,比Two-stage算法的精确度略低,但检测速度有很大的提升,可实现端对端的检测,很好地平衡了检测精度和检测速度,如YOLO(You only look once)[12]和单步多框检测(SSD)[11]算法。

SSD算法是基于多尺度图像的检测,在理想条件下对小目标的检测效果较好,但在成像视角单一的空对地场景下,拍摄的目标尺寸较小、结构信息较少,且容易受到复杂背景的干扰,对SSD算法的特征提取网络性能要求较高。针对传统SSD算法的主干网络-视觉几何组(VGG16)网络[13]参数量大、检测率低的问题,本文提出了一种结合密集连接网络(DenseNet)和压缩激励(SE)的单步多框检测(SE-DenseSSD)算法。用DenseNet作为SSD算法的主干网络,DenseNet具有参数少和特征复用的特点,能提取到更丰富有效的特征;考虑到空对地目标易受到背景干扰,一些背景信息可能分布在特征图的某些通道上,在生成候选区域的不同尺度特征图中引入通道注意力机制。在训练过程中,可根据各通道特征的有效程度赋予不同的权值,将权值大的有效信息进行重点表达,权值小的特征通道作为冗余通道,从而减少背景信息的干扰。

2 算法描述

用SSD算法作为基本框架,用DenseNet作为SSD算法的特征提取网络,同时引入通道注意力学习机制,提出了一种适用于空对地任务的目标检测算法。

2.1 特征提取网络DenseNet

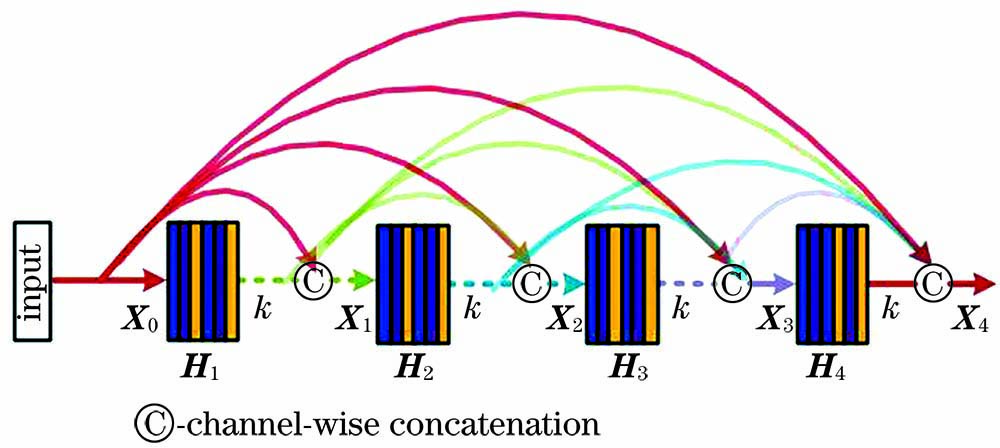

相比常规图像,空对地图像的目标特征较少,VGG网络的连接方式与浅层特征提取网络对目标特征的提取能力有限,而直接增加网络层数会导致参数量变大,容易出现过拟合问题,因此,需要对网络进行改进。传统改进方法通过加深网络层数或加宽网络结构使网络能更好地挖掘输入数据,如Google公司提出的Inception系列网络[14]。He等[10]提出的残差神经网络(ResNet)通过引入残差块[15],有效提高了网络性能。但随着网络层数的加深,网络提取的特征越抽象,导致模型丢失了中间层部分的细节信息,同时增加了运行成本。DenseNet可以缓解中间层信息随网络深度增加和变宽带来的问题,主要由多个Dense block组成,每个Dense block内部的连接如

设增长速率为

传统CNN中,如果网络层数为L,则有

2.2 通道注意力机制

在空对地场景中,一些复杂的背景干扰信息会分布在特征图的某些通道上,从而在训练过程中阻碍检测精度的提升,导致误检率与漏检率上升。因此,用注意力机制重新调整特征通道,不再平均考虑特征图中所有通道的特征信息,而是赋予特征图各通道不同的权值。根据权值大小对特征通道进行筛选,使模型聚焦于更有效的特征,从而减轻背景对目标的干扰。为了通过学习得到每个通道的权值,引入压缩激励网络(SENet)[16],并将其简化为一般形式,如

式中,

为了自适应生成各通道的注意力权值,引入一个具有隐含层的多层感知机。隐含层的神经元个数为

式中,g(Z,W) 为两层的神经网络,W为整个网络的权重,W1、W2分别为网络中第一、第二隐层的权重,

用

式中,

2.3 SE-DenseSSD算法的网络化描述

实验使用的检测算法结构如

3 实验分析

为验证本算法的性能,在空对地数据集上进行测试,并与基于VGG16的SSD算法进行对比分析。

3.1 实验数据集

常用于深度学习目标检测算法研究的数据集,如Pascal VOC[18]、ILSVRC[19]、COCO[20]数据集,虽然可为目标检测算法提供大量的训练资源,但这些数据集获取的大多是常规视角下的内容,难以满足空对地背景下的目标检测。空对地检测的数据集往往需要无人机等飞行器进行采集,因此,公开的空对地目标检测数据集相对较少,且规模和样本质量差异较大。针对该问题,实验通过无人机对道路进行拍摄,共获得7000张样本图像。由于成像传感器的焦距、分辨率等内参和高度会影响空对地的成像结果,从而对目标检测的设计和实际检测效果产生影响。因此,根据目标在整张图像中所占的像素,衡量实验获得的数据集。在标注过程中,目标占用的像素应不少于10pixel。共标定了5类检测目标,分别为汽车、卡车、厢式货车、公交车、人。

3.2 实验参数设置

数据集中的图像尺寸为1920pixel×1080pixel,为了验证本算法的有效性,用SSD512算法直接对原始图像进行训练。训练阶段,按7∶1∶2的比例将数据集划分为训练集、验证集和测试集,设置模型的初始学习率为0.001,batch size为16,训练次数(epoch)为800次。

3.3 评价指标和结果分析

为了对比本算法和VGG-SSD系列算法的检测性能,用平均精度均值(mAP)作为性能评价指标。平均精度(AP)能衡量检测算法在每个类别上的性能好坏,可表示为

式中,

mAP可评价检测算法在多目标类别检测中的性能,可表示为

式中,

为了验证本算法用DenseNet作为特征提取网络与引入通道注意力学习机制的有效性,在相同数据规模下,用基于VGG16的SSD算法、只使用DenseNet作为特征提取网络的SSD(DenseSSD)算法、本算法分别进行训练,得到三种算法的mAP和模型参数大小如

表 1. 不同算法得到模型参数和mAP

Table 1. Model parameters and mAP obtained by different algorithms

|

不同算法的可视化结果如

图 6. 不同算法的检测结果。 (a) VGG-SSD; (b) DenseSSD; (c) SE-DenseSSD

Fig. 6. Test results of different algorithms. (a) VGG-SSD; (b) DenseSSD; (c) SE-DenseSSD

4 结论

针对空对地场景中目标信息量少且容易被复杂背景干扰的问题,基于SSD算法的检测框架提出了SE-DenseSSD算法。通过引入DenseNet的密集连接方式,在加深网络的同时有效防止过拟合、提高训练过程的收敛速度;通过引入通道注意力SE机制,构建了卷积特征通道之间的相互依赖性,自适应地校准通道权值,减少复杂背景特征的响应。实验结果表明,本算法能有效提高对空对地目标的检测精度。

[2] Grauman K, Leibe B. Visual object recognition[J]. Synthesis Lectures on Artificial Intelligence and Machine Learning, 2011, 5(2): 1-181.

[3] 徐乐先, 陈西江, 班亚, 等. 基于深度学习的车位智能检测方法[J]. 中国激光, 2019, 46(4): 0404013.

[4] 崔家华, 张云洲, 王争, 等. 面向嵌入式平台的轻量级目标检测网络[J]. 光学学报, 2019, 39(4): 0415006.

[5] He K M, Gkioxari G, Dollár P, et al. Mask R-CNN[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2020, 42(2): 386-397.

[7] GirshickR. Fast R-CNN[C]//2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 1440- 1448.

[8] Ren S Q, He K M, Girshick R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149.

[9] Howard AG, Zhu ML, ChenB, et al. MobileNets: efficient convolutional neural networks for mobile vision applications[EB/OL]. [2020-01-30].https://arxiv.org/abs/1704. 04861.

[10] He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 770- 778.

[11] LiuW, AnguelovD, ErhanD, et al. SSD: single shot MultiBox detector[M] //Leibe B, Matas J, Sebe N, et al. Computer Vision-ECCV 2016. Lecture Notes in Computer Science. Cham: Springer, 2016, 9905: 21- 37.

[12] RedmonJ, DivvalaS, GirshickR, et al. You only look once: unified, real-time object detection[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 779- 788.

[13] 赵恒, 安维胜. 结合深度学习的图像显著目标检测[J]. 激光与光电子学进展, 2018, 55(12): 121003.

[14] SzegedyC, VanhouckeV, IoffeS, et al. Rethinking the inception architecture for computer vision[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 2818- 2826.

[15] 吴鹏, 林国强, 郭玉荣, 等. 自学习稀疏密集连接卷积神经网络图像分类方法[J]. 信号处理, 2019, 35(10): 1747-1752.

Wu P, Lin G Q, Guo Y R, et al. Self-learning sparse DenseNet image classification method[J]. Journal of Signal Processing, 2019, 35(10): 1747-1752.

[16] HuJ, ShenL, AlbanieS, et al. Squeeze-and-excitation networks[EB/OL]. [2020-01-31].https://arxiv.org/abs/1709. 01507.

[17] 张萌, 王仕成, 杨东方. 重点区域注意力学习的空对地目标检测算法[J]. 激光与光电子学进展, 2020, 57(4): 041006.

[19] Russakovsky O, Deng J, Su H, et al. ImageNet large scale visual recognition challenge[J]. International Journal of Computer Vision, 2015, 115(3): 211-252.

[20] Lin TY, MaireM, BelongieS, et al. Microsoft COCO: common objects in context[EB/OL]. [2020-01-27].https://arxiv.org/abs/1405. 0312.

Article Outline

王文庆, 丰林, 刘洋, 杨东方, 张萌. 结合DenseNet与通道注意力机制的空对地目标检测算法[J]. 激光与光电子学进展, 2020, 57(22): 221010. Wenqing Wang, Lin Feng, Yang Liu, Dongfang Yang, Meng Zhang. Air-to-Ground Target Detection Algorithm Based on DenseNet and Channel Attention Mechanism[J]. Laser & Optoelectronics Progress, 2020, 57(22): 221010.