显著性偏振参量深度稀疏特征学习的目标检测方法  下载: 1132次

下载: 1132次

1 引言

同传统的成像探测技术相比,偏振成像技术在获取光强、光谱和空间信息的前提下,能同时得到各观测目标直观的偏振特性,从而为实现目标空间结构的反演提供基础[1]。随着偏振成像探测技术的快速发展,其在**应用的需求也从人工离线判读辅助侦察行动逐步发展到对目标的快速自动检测和识别。在目标检测方法研究领域,利用大规模训练数据集[2],在基于区域的卷积神经网络(CNN)[3]框架下,基于候选区域、特征学习和目标分类等基本步骤的目标检测算法取得了显著检测效果,是目前的主流方法之一[4]。其中,特征学习是目标检测的必备步骤,选择合适的特征模型将图像区域映射为特征向量,然后利用从训练样本学习到的分类器对该特征向量进行分类,判断其所属类型。在此过程中如何根据不同成像方式和目标特征选择合适的特征模型进行特征学习,对其后的候选框回归计算以及目标分类等有重要影响,同时特征的表达能力也影响分类器精度。

特征学习包括人工设计特征和自动学习特征两个方面。典型的人工特征从早期的边缘检测算子[5]和角点检测算子[6],到SIFT(scale-invariant feature transform)[7]和HOG(histogram of oriented gridients)[8]等,具有良好的可扩展性。为弥补利用单一特征进行目标表示的不足,后来有学者提出多种特征组合方法[9],该方法被广泛应用于行人检测[10]、目标跟踪[11]以及人体姿态估计[12]等任务并取得了良好效果。但是依靠人工设计特征,需要丰富的专业知识并且花费大量的时间,特征的好坏在很大程度上还要依靠经验和运气。近年来,一方面,深度学习在图像分类和目标检测等领域取得了突破性进展,成为目前最有效的自动特征学习方法,且深度学习模型具有强大的表征和建模能力,避免了人工设计特征的繁琐低效[13];另一方面,辨别字典学习(DDL)近年来在稀疏表示领域也取得了巨大的成功[14-17],并且在计算机视觉领域如行人重识别[18]任务中取得良好效果。

DDL的目的是学习一个字典,在此字典下对图像信号形成稀疏表示,并考虑其表示精度和判别能力,而稀疏特征更适合作为目标类别分类的分类器,通常有两个方法可以提高字典的判别能力。一种方法是提高编码向量的判别分类能力,如:Jiang等[17]提出二值分类标签稀疏编码矩阵以提高相同分类中具有相似稀疏编码的样本泛化能力;Mairal等[14]提出任务驱动字典学习框架,针对不同任务求解编码系数的不同目标函数;Yang等[16]提出Fisher判别字典学习方法,利用Fisher准则刻画稀疏表示系数。另一种方法是通过学习结构化字典提高判别能力,如:Ramirez等[19]提出用结构不相关项来描述字典的独立性;Gao等[20]提出学习一个额外字典供所有的分类共享共有特征编码;Gu等[21]还提出投影字典对学习方法,利用分析字典来估计表示系数,大大提高了稀疏特征表示性能。如果将这些方法直接应用于偏振成像,虽然能够进行目标检测,但是由于无法有效利用不同目标的偏振信息,在图像目标较小或者不良成像条件下探测精度就会受到影响。

为此,本文针对偏振成像特点并结合实际应用需求,提出基于斯托克斯(Stokes)偏振信息解析和深度稀疏特征学习的偏振图像目标检测方法。该方法首先进行偏振参量图像解析,为充分利用目标图像的偏振信息,对获得的不同偏振方向图像利用Stokes进行解析,得到偏振参量图像;其次,受显著性检测方法启发[22],在目标检测时不直接对偏振方向图像进行检测,而是通过Choquet模糊积分[23]构造显著性偏振参量图像,以人眼视觉和信噪比高的偏振参量图像进行目标检测;然后,对得到的待检测偏振图像在判别式字典下进行稀疏特征学习;最后,以偏振参量图像的稀疏特征设计字典对分类器层在CNN框架完成目标检测。实验验证结合偏振成像目标探测实际应用需求,在某型偏振成像设备采集缩比仿真目标和实际空中小目标等不同场景下展开。

2 偏振参量图像原理

2.1 Stokes变换

同光强度成像探测相比,偏振成像技术是一种探测物体偏振态的成像技术,在获取光强、光谱和空间信息的前提下,能同时得到更多的易于区分目标的特征信息,如偏振度、偏振角和偏振椭圆率等,可以显著提高目标与背景,及不同目标之间的对比度。Stokes向量是Stokes G G在1852年研究部分偏振光时提出的,它既可以用来表示完全偏振光,也可以表示部分偏振光甚至自然光,同时Stokes向量带有丰富的信息。因此,偏振成像探测多用Stokes参量

偏振度

另外,还可以得到

为描述方便,这里把Stokes参量(

2.2 显著性偏振参量图像

由于偏振参量是多通道图像,偏振图像目标检测应根据检测具体任务需求在不同的偏振参量上进行,同时也可以大大提高检测速度。就人眼视觉及识别任务来说,要求偏振参量图像在图像细节、纹理和清晰度上表现较好。标准差是图像对比度测量,反映图像细节信息量和图像中数据的集中与离散程度,信息熵反映图像纹理,纹理越丰富,信息熵越大,清晰度反映图像清晰程度以及纹理变换程度。因此,首先选用标准差、信息熵和清晰度这3个属性来衡量偏振参量图像;然后构造这3个属性的信任函数;最后采用Choquet积分自适应选择显著性偏振参量作为目标检测的图像。

1) 评价指标

采用标准差

式中:

2) 信任函数

对3个属性构建信任函数,表示为

式中:

模糊测度

3) Choquet积分

在得到各偏振参量图像的信任函数和模糊测度后,采用Choquet积分自适应选择最佳的偏振参量图像作为显著性偏振参量进行目标检测和显示等。

设非负函数

式中:

当

式中:

由(9)式和(10)式可知,模糊测度利用与模糊测度相关的模糊积分代替了普通的加权求和法,可以被看作是非线性可加函数。根据(10)式求得模糊积分值,选取最大的模糊积分值作为显著性偏振参量图像。

3 深度稀疏特征表示

3.1 分析-合成字典对

字典学习是图像和信号稀疏表示的核心问题,DDL在过去几年获得了极大发展,而且在计算机视觉领域如目标跟踪应用中取得良好效果,因此字典编码所得到的稀疏特征更适合作为目标检测分类器。将判别式特征学习与稀疏特征表示模型相结合,能够充分利用CNN的复杂特征结构以提高目标检测效果[24]。

在CNN框架下进行目标分类需要两个字典,一个是分析字典

与用于图像超分辨率的高-低分辨率双字典学习方法[25]相似,同时学习分析-合成双字典

式中:上标*表示目标预测值(下文同);

在得到分析-合成字典对

3.2 字典对学习

为求解(11)式,将约束条件进一步放松,引入编码系数矩阵

式中,

由于目标函数的所有项都以相同的Frobenius范数来刻画,可以采用交替最小化算法进行求解。在初始化阶段,利用归一化Frobenius范数构成随机矩阵,以生成

3.3 CNN参数更新

在CNN的端到端工作模式下,当利用基于字典对的稀疏特征进行目标分类时,需要进行字典对反向传播计算以联合完成分类器层设计与CNN参数训练。由于字典对(

式中,

将(13)式分别对{

式中,

求得所有的

4 字典对分类器层

在CNN框架下利用稀疏特征进行目标检测有两个主要过程,首先由CNN提取偏振参量图像特征,然后由分类器层进行目标检测和定位,而分类器层又进一步分为目标分类器和类别分类器。目标分类器负责将目标从背景中分辨出来,而类别分类器则用于判定目标所属类别,两个分类器都由字典对{

而目标分类规则定义为

式中:

4.1 目标分类器

在目标分类时,目标定义为涵盖所有类别的目标得分。为了判定输入区域内的目标,目标分类器层分别用字典对{

式中,参数

4.2 类别分类器

为计算目标所属类别概率,类别分类器由

式中,

将目标分数

由分类得分F

式中:

4.3 联合任务回归

在利用字典对分类器进行目标检测时,由于目标、分类和定位是密不可分的三个任务。综合考虑这三个方面,定义联合多任务损失函数以提高目标检测算法性能。令

式中:

综合

在字典

5 目标检测算法

5.1 目标检测框架

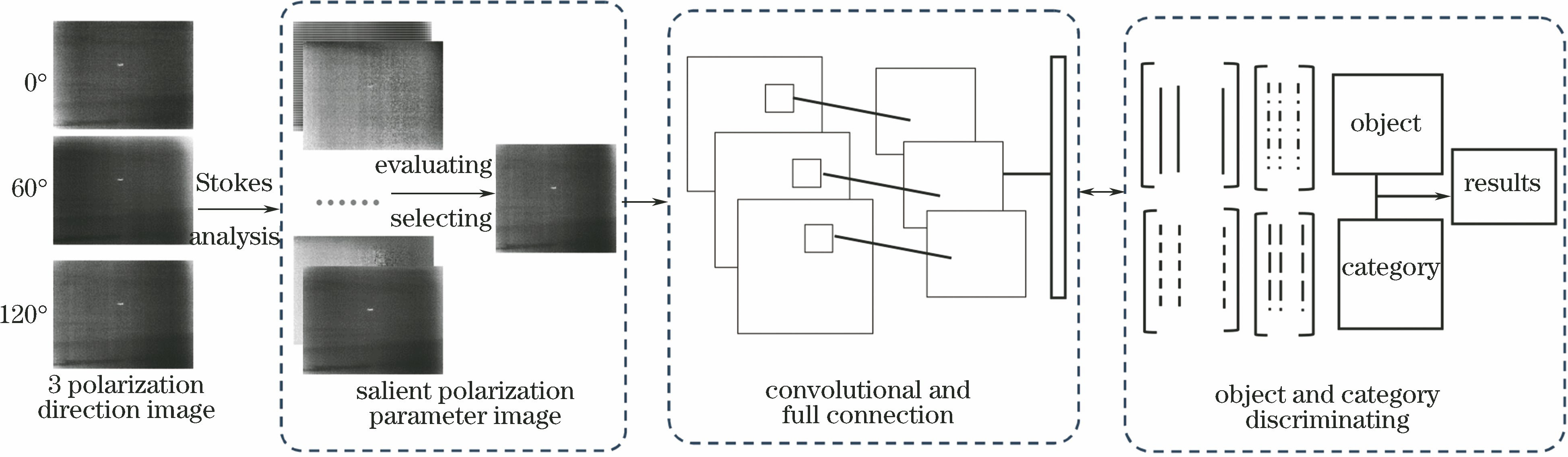

整个目标检测框架由显著性偏振参量图像构造、CNN特征提取及目标与类别判定3个模块组成,如

CNN模块由卷积层和全连接层构成,用于提取图像特征。目标与类别判定模块基于CNN提取的图像特征,分为目标分类器字典对和类别分类器字典对。利用分类器字典对得到评估分数,判断是否为目标;利用类别分类器字典对计算特定目标类别的得分。每个图像区域的最后得分是目标和类别的组合。在目标与类别判定过程中,需要进行字典对反向传播计算以联合完成分类器层的字典对更新、边界框回归以及CNN参数优化微调。

5.2 目标检测算法

在CNN架构下,目标检测由卷积网络训练和目标检测两部分组成。CNN的初始参数通过ImageNet模型[2]预先训练,字典

图 2. 显著性偏振参量图像目标检测算法

Fig. 2. Object detection algorithm for salient polarization parameter image

算法运行效率主要受3个方面的影响。首先是显著性选择,由于偏振解析及模糊积分是数值计算,无需循环迭代,具有实时性;其次是特征计算及目标和类别判定,该过程主要取决于CNN卷积层和全链接层的时间复杂度:

6 实验与分析

6.1 实验说明

实验验证主要从两个方面进行,一是在全场景仿真实验室内模拟无人机平台对地面目标低空侦察,目标对象为缩比仿真模型;二是实测对空目标,以民航飞机为对象进行数据获取并进行实验验证。其中,室内仿真数据采集主要是样本采集和训练,目标有草地坦克和沙地卡车等,这些目标在低空场景下能够被识别,在良好气象条件下对民航飞机小目标进行跟踪采集,以进行训练样本准备。实验设备为自行研制的3方向及红外同时成像偏振相机,采集的部分数据如

图 3. 测试数据(0°方向)。(a)民航飞机;(b)草地坦克;(c)沙地卡车

Fig. 3. Test data (0° polarization direction). (a) Airplane; (b) tank; (c) truck

实验环境为戴尔PRECISION TOWER 5810工作站,具体参数为:Intel(R)Xeon(R) E5-1660 v4 3.2 GHz,32.0 GB RAM,8 GB SGRAM,Windows 8(64位)专业版+Matlab(R2016a)。由于偏振目标检测任务明确,故将分类器字典的类别参数

以Faster R-CNN[3]为基本模型框架,CNN参数在ImageNet[2]上进行预训练,然后利用采集的数据进行验证微调,其他参数设置采用文献[

24]的默认值。在微调过程中的背景与目标的判定阈值设定上,以候选框与原标记框的交叠率,即交并比(IoU)

6.2 实验结果比较和分析

1) 显著性选择实验

实验首先验证显著性偏振参量图像选择情况。

图 4. 显著性参量图像选择结果。(a1)~(c1)飞机1,飞机2,卡车图像;(a2)~(c2)显著性选择结果

Fig. 4. Results of salient parameter image selection. (a1)-(c1) Images of airplane 1, airplane 2, and truck; (a2)-(c2) salient selected results

表 1. 偏振解析显著性参量图像选择前后评价结果

Table 1. Results before and after polarization analysis and salient parameter image selection

| ||||||||||||||||||||||||||||||||||

根据上述三个指标综合评价来选择待检测图像时,在3.2节的模糊积分中,不同的目标或同一目标在不同的背景条件下,选择的偏振参量图像应该不同。由实验结果可以看出,三组结果的显著性目标选择分别为偏振度图像、

2) 目标检测实验

在目标检测实验中,分别对同一目标及不同目标在不同场景下进行检测,并与直接利用偏振方向图像检测结果进行比较,实验中每种目标分8组,每组10个样本,室内样本采集时主要模拟不同光照、雾气等变化条件下的图像数据,室外实际样本采集时主要采集不同距离和天气状况下的民航飞机图像数据,检测结果如

图 5. 目标检测结果。(a1)~(c1)飞机1,飞机2,卡车图像;(a2)~(c2)显著性图像检测结果

Fig. 5. Results of object detection. (a1)-(c1) Images of airplane 1, airplane 2, and truck; (a2)-(c2) salient image detection results

为进一步评价检测效果,将解析前的各偏振方向图像以及各偏振参量图像的各目标检测精度以均值平均精度(mAP)进行客观评价,

表 2. 不同图像目标检测结果比较

Table 2. Comparison of detection results of different image objects

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

另外,为验证字典对分类器效果,将本方法与基本CNN框架Faster R-CNN[3]进行比较,检测结果如

表 3. 不同模型的检测结果比较

Table 3. Comparison of detection results of different models

|

7 结论

针对偏振成像目标探测中的偏振参量图像丰富、目标显示及识别任务在不同的目标及背景下用某一种固定偏振参量图像无法达到实际需求的问题,提出基于显著性偏振参量图像深度稀疏特征学习的偏振图像目标检测方法。通过标准差、信息熵和清晰度构造模糊积分,得到显著性偏振参量,并以稀疏表示的字典对改进卷积神经网络框架中的分类器以用于目标检测,利用反向传播对分类器进行端到端学习和CNN参数更新。对实际目标探测中的典型目标和背景数据进行测试,验证了其有效性。但是在实际的目标探测任务中,目标及背景会更加复杂,如何充分利用探测目标的物理特性及偏振成像数据特点、结合快速CNN研究成果并利用不同偏振参量图像的冗余互补来提高预训练效果和设计特征学习模型,从而提高检测性能和效率将是下一步的研究重点。

[1] 王小龙, 王峰, 刘晓, 等. 荒漠背景下典型伪装目标的高光谱偏振特性[J]. 激光与光电子学进展, 2018, 55(5): 051101.

[2] KrizhevskyA,[\s]{1}SutskeverI,[\s]{1}Hinton[\s]{1}GE.[\s]{1}ImageNet[\s]{1}classification[\s]{1}with[\s]{1}deep[\s]{1}convolutional[\s]{1}neural[\s]{1}networks[C]∥25th[\s]{1}International[\s]{1}Conference[\s]{1}on[\s]{1}Neural[\s]{1}Information[\s]{1}Processing[\s]{1}Systems,[\s]{1}December[\s]{1}3-6,[\s]{1}2012,[\s]{1}Lake[\s]{1}Tahoe,[\s]{1}Nevada.[\s]{1}New[\s]{1}York:[\s]{1}ACM,[\s]{1}2012:[\s]{1}1097-[\s]{1}1105.[\s]{1}

[3] GirshickR.[\s]{1}Fast[\s]{1}R-CNN[C]∥2015[\s]{1}IEEE[\s]{1}International[\s]{1}Conference[\s]{1}on[\s]{1}Computer[\s]{1}Vision[\s]{1}(ICCV),[\s]{1}December[\s]{1}7-13,[\s]{1}2015,[\s]{1}Santiago,[\s]{1}Chile.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2015:[\s]{1}1440-[\s]{1}1448.[\s]{1}

[4] GirshickR,[\s]{1}DonahueJ,[\s]{1}DarrellT,[\s]{1}et[\s]{1}al.[\s]{1}Rich[\s]{1}feature[\s]{1}hierarchies[\s]{1}for[\s]{1}accurate[\s]{1}object[\s]{1}detection[\s]{1}and[\s]{1}semantic[\s]{1}segmentation[C]∥2014[\s]{1}IEEE[\s]{1}Conference[\s]{1}on[\s]{1}Computer[\s]{1}Vision[\s]{1}and[\s]{1}Pattern[\s]{1}Recognition,[\s]{1}June[\s]{1}23-28,[\s]{1}2014,[\s]{1}Columbus,[\s]{1}OH,[\s]{1}USA.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2014:[\s]{1}580-[\s]{1}587.[\s]{1}

[5] Canny J. A computational approach to edge detection[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1986, 8(6): 679-698.

[6] Rosten E, Porter R, Drummond T. Faster and better: a machine learning approach to corner detection[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2010, 32(1): 105-119.

[8] DalalN,[\s]{1}TriggsB.[\s]{1}Histograms[\s]{1}of[\s]{1}oriented[\s]{1}gradients[\s]{1}for[\s]{1}human[\s]{1}detection[C]∥2005[\s]{1}IEEE[\s]{1}Computer[\s]{1}Society[\s]{1}Conference[\s]{1}on[\s]{1}Computer[\s]{1}Vision[\s]{1}and[\s]{1}Pattern[\s]{1}Recognition[\s]{1}(CVPR),[\s]{1}June[\s]{1}20-25,[\s]{1}2005,[\s]{1}San[\s]{1}Diego,[\s]{1}CA,[\s]{1}USA.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2005:[\s]{1}886-[\s]{1}893.[\s]{1}

[9] Felzenszwalb P F, Girshick R B. McAllester D, et al. Object detection with discriminatively trained part-based models[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2010, 32(9): 1627-1645.

[10] Yan[\s]{1}JJ,[\s]{1}Zhang[\s]{1}XC,[\s]{1}LeiZ,[\s]{1}et[\s]{1}al.[\s]{1}Robust[\s]{1}multi-resolution[\s]{1}pedestrian[\s]{1}detection[\s]{1}in[\s]{1}traffic[\s]{1}scenes[C]∥2013[\s]{1}IEEE[\s]{1}Conference[\s]{1}on[\s]{1}Computer[\s]{1}Vision[\s]{1}and[\s]{1}Pattern[\s]{1}Recognition,[\s]{1}June[\s]{1}23-28,[\s]{1}2013,[\s]{1}Portland,[\s]{1}OR,[\s]{1}USA.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2013:[\s]{1}3033-[\s]{1}3040.[\s]{1}

[11] 李敬轩, 宗群. 基于多特征和局部联合稀疏表示的目标跟踪[J]. 激光与光电子学进展, 2017, 54(10): 101502.

[12] AndrilukaM,[\s]{1}IqbalU,[\s]{1}InsafutdinovE,[\s]{1}et[\s]{1}al.[\s]{1}Pose[\s]{1}Track:[\s]{1}a[\s]{1}benchmark[\s]{1}for[\s]{1}human[\s]{1}pose[\s]{1}estimation[\s]{1}and[\s]{1}tracking[C]∥2018[\s]{1}IEEE/CVF[\s]{1}Conference[\s]{1}on[\s]{1}Computer[\s]{1}Vision[\s]{1}and[\s]{1}Pattern[\s]{1}Recognition,[\s]{1}June[\s]{1}18-23,[\s]{1}2018,[\s]{1}Salt[\s]{1}Lake[\s]{1}City,[\s]{1}UT,[\s]{1}USA.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2018:[\s]{1}5167-[\s]{1}5176.[\s]{1}

[13] 黄凯奇, 任伟强, 谭铁牛. 图像物体分类与检测算法综述[J]. 计算机学报, 2014, 37(6): 1225-1240.

Huang K Q, Ren W Q, Tan T N. A review on image object classification and detection[J]. Chinese Journal of Computers, 2014, 37(6): 1225-1240.

[15] Feng Z Z, Yang M, Zhang L, et al. Joint discriminative dimensionality reduction and dictionary learning for face recognition[J]. Pattern Recognition, 2013, 46(8): 2134-2143.

[18] 陈兵, 查宇飞, 李运强, 等. 基于卷积神经网络判别特征学习的行人重识别[J]. 光学学报, 2018, 38(7): 0720001.

[19] RamirezI,[\s]{1}SprechmannP,[\s]{1}SapiroG.[\s]{1}Classification[\s]{1}and[\s]{1}clustering[\s]{1}via[\s]{1}dictionary[\s]{1}learning[\s]{1}with[\s]{1}structured[\s]{1}incoherence[\s]{1}and[\s]{1}shared[\s]{1}features[C]∥2010[\s]{1}IEEE[\s]{1}Computer[\s]{1}Society[\s]{1}Conference[\s]{1}on[\s]{1}Computer[\s]{1}Vision[\s]{1}and[\s]{1}Pattern[\s]{1}Recognition,[\s]{1}June[\s]{1}13-18,[\s]{1}2010,[\s]{1}San[\s]{1}Francisco,[\s]{1}CA,[\s]{1}USA.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2010:[\s]{1}3501-[\s]{1}3508.[\s]{1}

[21] Gu[\s]{1}SH,[\s]{1}ZhangL,[\s]{1}Zuo[\s]{1}WM,[\s]{1}et[\s]{1}al.[\s]{1}Projective[\s]{1}dictionary[\s]{1}pair[\s]{1}learning[\s]{1}for[\s]{1}pattern[\s]{1}classification[C]∥27th[\s]{1}International[\s]{1}Conference[\s]{1}on[\s]{1}Neural[\s]{1}Information[\s]{1}Processing[\s]{1}Systems,[\s]{1}December[\s]{1}8-13,[\s]{1}2014,[\s]{1}Montreal,[\s]{1}Canada.[\s]{1}Canada:[\s]{1}NIPS,[\s]{1}2014:[\s]{1}793-[\s]{1}801.[\s]{1}

[22] 刘峰, 沈同圣, 娄树理, 等. 全局模型和局部优化的深度网络显著性检测[J]. 光学学报, 2017, 37(12): 1215005.

[23] Mesiar R. Fuzzy measures and integrals[J]. Fuzzy Sets and Systems, 2005, 156(3): 365-370.

[24] Wang[\s]{1}KZ,[\s]{1}LinL,[\s]{1}Zuo[\s]{1}WM,[\s]{1}et[\s]{1}al.[\s]{1}Dictionary[\s]{1}pair[\s]{1}classifier[\s]{1}driven[\s]{1}convolutional[\s]{1}neural[\s]{1}networks[\s]{1}for[\s]{1}object[\s]{1}detection[C]∥2016[\s]{1}IEEE[\s]{1}Conference[\s]{1}on[\s]{1}Computer[\s]{1}Vision[\s]{1}and[\s]{1}Pattern[\s]{1}Recognition[\s]{1}(CVPR),[\s]{1}June[\s]{1}27-30,[\s]{1}2016,[\s]{1}Las[\s]{1}Vegas,[\s]{1}NV,[\s]{1}USA.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2016:[\s]{1}2138-[\s]{1}2146.[\s]{1}

[26] Cun[\s]{1}YL,[\s]{1}BoserB,[\s]{1}Denker[\s]{1}JS,[\s]{1}et[\s]{1}al.[\s]{1}Handwritten[\s]{1}digit[\s]{1}recognition[\s]{1}with[\s]{1}a[\s]{1}back-propagation[\s]{1}network[M][\s]{1}∥Touretzky[\s]{1}D[\s]{1}S.[\s]{1}Advances[\s]{1}in[\s]{1}neural[\s]{1}information[\s]{1}processing[\s]{1}systems[\s]{1}2.[\s]{1}San[\s]{1}Francisco:[\s]{1}Morgan[\s]{1}Kaufmann[\s]{1}Publishers[\s]{1}Inc.,[\s]{1}1989:[\s]{1}396-[\s]{1}404.[\s]{1}

Article Outline

王美荣, 徐国明, 袁宏武. 显著性偏振参量深度稀疏特征学习的目标检测方法[J]. 激光与光电子学进展, 2019, 56(19): 191101. Meirong Wang, Guoming Xu, Hongwu Yuan. Object Detection by Deep Sparse Feature Learning of Salient Polarization Parameters[J]. Laser & Optoelectronics Progress, 2019, 56(19): 191101.