一种基于改进SiameseRPN的全景视频目标跟踪算法  下载: 1029次

下载: 1029次

1 引言

目标跟踪算法是根据视频序列中给定的第一帧目标位置信息来估计之后视频帧中同一目标的位置与尺度信息,在智能监控、交通系统和人机交互等领域均有广阔的应用前景。受运动模糊、背景相似干扰、遮挡、光照变化和尺度变化等因素的影响,目标跟踪算法精度低,适用性差。因此,如何提高目标跟踪算法的鲁棒性和准确性是一项挑战[1-2]。

全景图像具有较大的视野范围、较多的场景信息和较高的分辨率,同时也伴随着较大的计算量和较高的目标区分复杂度。尤其是当目标与全景相机的距离发生较大变化时,全景视频内目标尺度和形状的变化非常大[3]。目前,针对单目视频的目标跟踪算法在全景视频下难以应对这种变化,容易出现目标丢失的情况,因此开展全景视频目标跟踪算法的研究具有重要的意义,而提高算法的跟踪精度和稳健性是亟需解决的问题。

深度学习是近些年来人工智能领域的研究热点之一。卷积神经网络有强大的特征表征能力,在提取特征方面具有较大优势,因此被广泛应用于目标跟踪领域。Nam等[4]提出了MDNet(Multi-Domain Convolutional Neural Networks)模型,这是一种新颖的卷积神经网络架构,其将共用信息与特定信息分开,利用从深度网络中提取的多维特征进行模型参数的反向更新,并学习用于目标跟踪的通用特征表示。 Yun等[5]通过结合有监督学习和强化学习,提出了ADNet(Action-Decision Networks)算法,该算法采用有监督学习训练网络跟踪目标,通过强化学习预测目标的状态及动作,较好地解决了目标跟踪过程中目标尺度变化的问题,但算法精度不佳。 Jung等[6]在MDNet的基础上提出RT-MDNet,通过改进损失函数并采用自适应的RoIAlign层,简化了多域网络结构,在保持跟踪精度基本不变的情况下将运算速度提升了近25倍,但是该算法缺少尺度变化模块,无法直接应用于全景视频图像的目标跟踪。MobileNetV3[7]是谷歌提出的轻量级神经网络,其利用空洞卷积显著减少了网络参数,在移动端中的准确率较高。Li等[8]将Siamese FC[9]与区域生成网络(Region Proposal Network,RPN)结合,提出了SiameseRPN,解决了Siamese FC尺度不能变化的问题,并利用相关滤波的方法取得了很高的准确率,同时保持了实时性,但该算法容易受相似特征背景的干扰。

针对上述问题,本文提出了一种基于改进SiameseRPN网络的目标跟踪算法,将AlexNet替换为可以利用更深层特征的MobileNetV3,并使用深层特征来训练网络以降低背景的干扰。该算法在MobileNetV3的网络结构中提取了多层间的特征,通过双线性插值来增大网络的特征输出,然后将回归和分类后的特征进行加权融合,加强了网络鲁棒性。实验结果表明,本文算法显著提高了跟踪精度,保持了实时的运算速度,能够解决全景图像目标跟踪的尺度变化和局部欠曝光问题。

2 全景视频的目标跟踪

2.1 全景数据

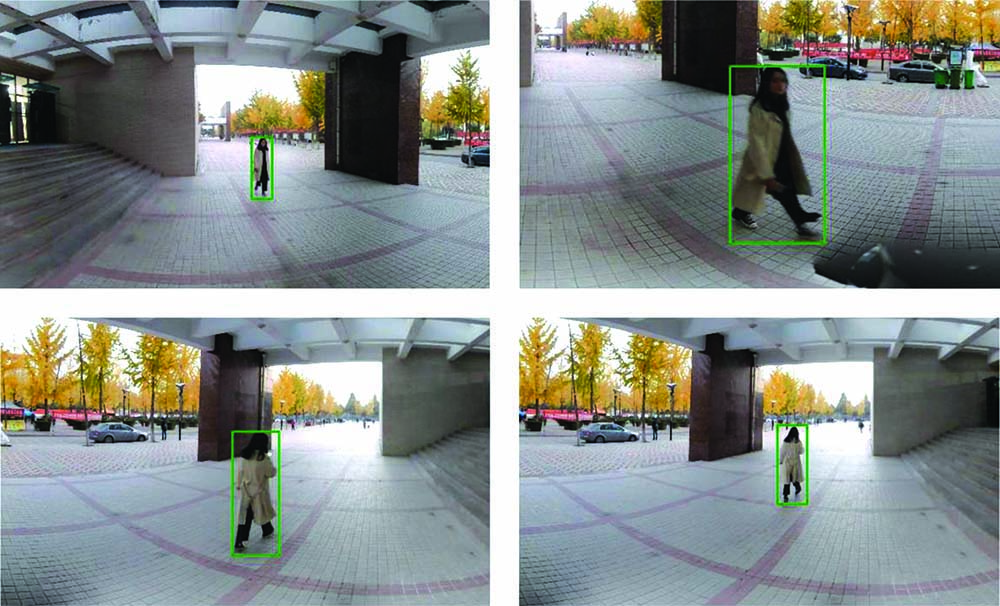

全景视频的可视范围大,没有视野盲区,在固定场景的目标跟踪过程中,目标再识别时不易出现特征损失。全景视频是由七目相机拍摄的视频拼接而成的,全景相机中不同摄像头的曝光程度不同,视频拼接时会发生过曝光或者欠曝光的情况,这对全景图像局部特征会产生较大的影响。当目标对象与摄像头相对运动时,距离的变化在全景图像中会以尺度变化的方式表现出来,距离越近,这种尺度变化程度越严重。全景视频中目标尺度变化的过程如

目前,常用的基于深度学习的目标跟踪算法都是在公开数据集如OTB[10]、VOT[11]上训练的卷积神经网络。尽管这些方法可以获得有效的特征表示,但由于数据集之间的特征不一致,因此跟踪能力受到数据集的限制。为了克服全景数据中的欠曝光、小目标和尺度变化等问题,使算法具有更佳的表现能力,就需要对专门用于视觉跟踪的网络结构及数据进行训练。本文建立了用于目标跟踪的全景数据集,该数据集包含多个场景和不同时间(白天、夜晚)条件下的行人、车辆等75个视频序列,使用labelImg标注了12112 frame,单张图片标注单个目标,可以用于训练网络,实现端到端的训练。

表 1. 全景数据集的跟踪难点分布

Table 1. Distribution of tracking difficulties in panoramic data sets

|

2.2 深度特征

传统手工特征如HOG和Haar等,由于颜色特征不明显,在图像质量差的场景下难以保持鲁棒性,而采用增强方法提高图像质量又会导致特征的损失。深度特征与传统手工特征不同,在深层的卷积神经网络中,高维度特征对图像质量的要求较低,对雾霾、雨天和光照等场景的适应性较强,但是提取的浅层神经网络特征有限,所以在网络搭建中就需要考虑应用场景,既满足场景的特征需求,又不会浪费计算资源。

图 3. 卷积网络提取的深度特征的可视化结果。 (a) Conv 1; (b) Relu 1; (c) Pool 1; (d) Conv 3; (e) Relu 3; (f) Pool 3; (g) Conv 5; (h) Relu 5; (i)原图

Fig. 3. Visualization results of deep features in convolutional neural networks. (a) Conv 1; (b) Relu 1; (c) Pool 1; (d) Conv 3; (e) Relu 3; (f) Pool 3; (g) Conv 5; (h) Relu 5; (i) original image

3 本文算法流程框架

SiameseRPN利用AlexNet前五层进行了特征提取,利用真实值模板中的特征与当前视频帧目标区域的特征执行了相关操作,得到当前分类和回归值[13]。在全景视频序列中,目标相对镜头的运动会使尺度和光照等条件发生变化,从而导致目标特征发生变化。在光照条件改变时,目标特征变化较大,网络的适应性较差,跟踪时会出现目标丢失的情况。通过对卷积网络的分析,利用深度神经网络可以有效地降低图片质量对特征提取过程的干扰。本文针对已有算法应用于全景图像目标跟踪时跟踪精度较低且特征变化适应性差的问题,提出了一种基于改进SiameseRPN的全景视频目标跟踪算法,利用MobileNetV3网络提取特征,在网络中融合多层网络特征,使网络可以利用不同类型特征进行分类和回归,加强算法对相似目标和图片区域质量问题的适应性[14]。本文算法的网络框架如

由

3.1 MobileNetV3

深度学习算法对算力要求很高,应用场景有限,为了满足神经网络的应用需求,诞生了如MobileNet等轻量级的神经网络。算法通过MobileNet得到多个输出得分,选取其中得分最高的为当前预测输出。网络整体参数是根据全景数据进行改进的。 MobileNetV3是谷歌提出的轻量级神经网络,可减少神经网络中的计算冗余,使算法具有实时的性能,其网络结构是通过结合NAS[15]算法和NetAdapt[16]算法得到的。NAS算法是在定义的网络架构内,通过对结构进行评估来搜索出最优网络结构。NetAdapt算法是优化预训练网络的算法,可以度量优化网络结构,在降低计算消耗的同时,保证网络精度。

3.1.1 深度可分离卷积

在神经网络计算中,卷积的运算量占比很大。为了减少卷积过程中的计算量,学者们提出了深度可分离卷积。深度可分离卷积[17]是MobileNet中使用的卷积网络结构,将卷积过程分为深度卷积和逐点卷积,大幅度减少了卷积中所用的参数数量,使得网络结构较深的算法也可以具有实时的性能。

在

3.1.2 SE模块

SE模块[18]是注意力模型。在

3.1.3 h-swish激活函数

swish函数已经在大量的神经网络中得到了应用,并在实践中取得了较好的性能。swish函数与Relu函数较为相似,但是与Relu函数不同的是,swish函数是非单调的,过渡更为平滑,不会出现梯度消失的问题。但是, swish函数的计算量太大,不适合应用于轻量级神经网络中,所以学者们提出了h-swish函数:

式中:

图 6. Relu6、h-swish、swish的激活函数对比

Fig. 6. Comparison among Relu6, h-swish, and swish activation functions

3.2 多层融合

SiameseRPN基于SiameseFC的相关滤波思想,引入了RPN网络,进一步提升了网络速度和跟踪准确性。SiameseRPN利用五层的AlexNet网络进行特征提取,修改了AlexNet中的步长,去掉了填充步骤,扩大了网络特征的输出尺度。

本文算法基于SiameseRPN算法改进了网络结构。使用MobileNetV3作为特征提取网络,神经网络中不同卷积层得到的特征类型不同;为了增强网络在目标跟踪过程中的鲁棒性,将边缘特征与高层语义特征相结合,选取不同层特征进行了加权融合。本文选取MobileNetV3中Conv 13、Conv 14和Conv 15层的输出特征进行融合。三个层卷积网络的输出尺度不同,且深层特征尺度较小,为了融合多层特征,通过双线性插值将MobileNetV3中的输出特征放大到同一目标尺度,以便于在后续RPN网络中保留更多的特征进行相关操作。

在RPN网络中,为了消除网络中模板可能的累积误差,只选用第一帧的真实值作为模板。使用权重共享的MobileNetV3提取目标模板和当前帧中的特征,在RPN网络中通过相关操作完成对k个预选框的预测。RPN网络中有分类分支和回归分支,回归分支得到4k个特征图,分别代表预选框的中心位置及预选框的宽和高。分类分支得到2k个特征图,通过分离出正样本和负样本,从多个可能的预测结果中选取得分最高的候选区域作为当前预测结果。

3.3 损失函数

算法中使用的损失函数与Faster R-CNN[19]中使用的损失函数相同,在分类分支中使用交叉熵损失(Cross Entropy Loss),在回归分支中使用smooth L1损失。整体的损失函数

式中:

Lcls

式中:

截取了一个视频域中的4frame图像进行对比,如

图 8. SiameseRPN与改进网络的实验结果对比

Fig. 8. Comparison of experiment results by SiameseRPN and improved network

4 实验结果与分析

本文使用的训练及测试数据集均由泰科易720 Pro七目全景相机采集所得,分为4个类别并进行了标注,处理后的图片分辨率为2000×1000。

硬件配置为CPU Intel Xeon E5-2620v4,显卡为GPU Nvidia Titan XP。在Ubuntu系统中使用Python作为实验平台,网络用Pytorch框架搭建,经过10000次迭代。

4.1 主观分析

为了评估算法在全景图像中的有效性,本文选取了多个不同场景不同目标的全景视频作为测试数据,并与MDNet、ADNet、RT-MDNet、SiameseRPN++和SiameseRPN算法的跟踪结果进行主观和客观对比,主观结果如

突出对比性能的好坏,对整幅全景图进行了截取,选取出其中具有较复杂尺度变化问题的视频序列。不同的颜色代表不同的跟踪算法的目标框,其中本文改进算法用红色表示。

图 9. 四个不同场景下不同算法的结果对比

Fig. 9. Comparison of results by different algorithms in four different scenarios

图 10. 小目标和遮挡情况下的实验结果

Fig. 10. Experimental results for small targets and target occlusion

综上所述,RT-MDNet与MDNet都达到了很好的跟踪精度,但是难以适应尺度变化问题。ADNet和SiameseRPN应对尺度变化问题的能力强于RT-MDNet,但是不能满足全景数据的需求。在出现欠曝光场景的全景视频序列中,四种算法都容易出现丢失目标的情况。全景图像由于具有很高的分辨率,对算法运算速率的要求很高。本文算法在应对不同曝光条件和不同目标时可以较好地应对目标的尺度变化,并保持了实时的运算速度,有较好的准确率和重叠率。

4.2 客观分析

为了评估算法性能,利用重叠率(Intersection over Union,IOU)和距离精度作为客观分析指标。重叠率表示预测结果与真实值之间的重叠面积与整体面积的比值,距离精度表示预测结果中心位置与真实值结果中心位置的欧氏距离。计算视频序列中所有帧的IOU和距离精度,IOU大于一定阈值的视频帧数与视频总帧数的比值称为成功率(Success rate),距离精度小于一定阈值的视频帧数与视频总帧数的比值称为精度(Precision),可以满足阈值条件的帧数所占的比率越高,表示算法跟踪性能越好。

表 2. 各算法的性能对比

Table 2. Performance comparison of all algorithms

|

由

利用全景图像数据集上得到的预测结果IOU和目标框,计算成功率和精确率的阈值。在对比算法性能时采用一次性评估(One Pass Evaluation,OPE)准则,给定初始第一帧的真实值,根据初始目标特征,对之后视频帧中的目标进行跟踪和预测,如果算法丢失目标,不会进行修正,结果如

图 13. 六种算法在全景数据集上的测试结果。(a)精确率;(b)成功率

Fig. 13. Test results of six algorithms on panoramic dataset. (a) Precision; (b) success rate

综上所述,RT-MDNet与MDNet都达到了很好的精度,但是难以应对尺度变化问题。ADNet应对尺度变化问题的能力强于RT-MDNET和MDNet,但无法满足全景数据中尺度变化的需求。SiameseRPN和SiameseRPN++较好地应对了尺度变化的问题,但相关滤波方法容易受相似特征背景的影响,精确率较低。当视频质量不好时,四种算法的性能会受到一定影响。通过以上对比可以得出,本文算法在不同曝光条件和不同目标时可以较好地应对目标的尺度变化和遮挡问题,在全景图像上的准确率和重叠率较高,跟踪效果得到明显提升。

5 结论

为了解决基于全景数据集的目标跟踪问题,提出了一种基于SiameseRPN的全景视频目标跟踪算法。采用MobileNetV3提取深层特征,使用SE模块加强网络对特征的选择,通过h-swish激活函数提升网络性能,并利用双线性插值方法来扩大卷积输出尺度,将扩大尺度后的多层特征进行融合,增强了网络的鲁棒性。分类分支分离当前预测的正负样本,回归分支回归出当前目标的位置和尺度信息,利用交叉熵损失和smooth L1损失优化网络性能,针对数据集改进了网络结构。实验结果表明,所提算法具有较高的跟踪精度,能够适应当前视频帧质量不佳和复杂场景中目标扭曲、旋转剧烈、目标运动快、背景相似干扰等多种挑战,可以长期稳定地跟踪目标,在保持精度的同时实现了实时的运算性能,在全景图像上的精确率和成功率较高。但是,由于跟踪过程中模板不更新,SiameseRPN算法容易出现目标漂移的情况。因此,设计模板的更新策略,权衡算法性能和模板更新,将会是以后的重点研究方向。

[1] 卢湖川, 李佩霞, 王栋. 目标跟踪算法综述[J]. 模式识别与人工智能, 2018, 31(1): 61-76.

Lu H C, Li P X, Wang D. Visual object tracking: a survey[J]. Pattern Recognition and Artificial Intelligence, 2018, 31(1): 61-76.

[3] ZhouY, ZhouZ, ChenK, et al. Persistent object tracking in road panoramic videos[M] ∥Lin W, Wu D, Ho A, et al. Advances in multimedia information processing——PCM 2012. Lecture notes in computer science. Heidelberg: Springer , 2012, 7674: 359- 368.

[4] NamH, HanB. Learning multi-domain convolutional neural networks for visual tracking[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 4293- 4302.

[5] YunS, ChoiJ, YooY, et al. Action-decision networks for visual tracking with deep reinforcement learning[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 1349- 1358.

[6] JungI, SonJ, BaekM, et al. Real-time MDNet[M] ∥ Ferrari V, Hebert M, Sminchisescu C, et al. Computer vision——ECCV 2018. Lecture notes in computer science. Cham: Springer, 2018, 11208: 89- 104.

[7] HowardA, SandlerM, ChuG, et al.( 2019-11-20)[2020-01-18 ]. https:∥arxiv.org/abs/1905. 02244.

[8] LiB, Yan JJ, WuW, et al. High performance visual tracking with Siamese region proposal network[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE, 2018: 18311819 .

[9] BertinettoL, ValmadreJ, Henriques JF, et al. Fully-convolutional Siamese networks for object tracking[M] ∥ Hua G, Jégou H. Computer vision——ECCV 2016 workshops. Lecture notes in computer science. Cham: Springer, 2016, 9914: 850- 865.

[10] WuY, LimJ, Yang MH. Online object tracking: a benchmark[C]∥2013 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2013, Portland, OR, USA. New York: IEEE, 2013: 2411- 2418.

[11] KristanM, LeonardisA, MatasJ, et al. The sixth visual object tracking VOT2018 challenge results[M] ∥ Leal-Taixé L, Roth S. Computer vision——ECCV 2018 workshops. Lecture notes in computer science. Cham: Springer, 2019, 11129: 3- 53.

[12] 杨大伟, 巩欣飞, 毛琳, 等. 重构特征联合的多域卷积神经网络跟踪算法[J]. 激光与光电子学进展, 2019, 56(19): 191501.

[13] 李勇, 杨德东, 韩亚君, 等. 融合扰动感知模型的孪生神经网络目标跟踪[J]. 光学学报, 2020, 40(4): 0415002.

[14] 刘美菊, 曹永战, 朱树云, 等. 基于卷积神经网络的特征融合视频目标跟踪方法[J]. 激光与光电子学进展, 2020, 57(4): 041502.

[15] Tan MX, ChenB, Pang RM, et al. MnasNet: platform-aware neural architecture search for mobile[C]∥2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), June 15-20, 2019, Long Beach, CA, USA. New York: IEEE, 2019: 2815- 2823.

[16] Yang TJ, HowardA, ChenB, et al. NetAdapt: platform-aware neural network adaptation for mobile applications[M] ∥ Ferrari V, Hebert M, Sminchisescu C, et al. Computer vision——ECCV 2018. Lecture notes in computer science. Cham: Springer, 2018, 11214: 289- 304.

[17] Howard AG, Zhu ML, ChenB, et al. ( 2017-04-17)[2020-01-18 ]. https:∥arxiv.org/abs/1704. 04861.

[18] HuJ, ShenL, SunG. Squeeze-and-excitation networks[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE, 2018: 7132- 7141.

[19] Ren S Q, He K M, Girshick R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149.

[20] 沈玉玲, 伍忠东, 赵汝进, 等. 基于模型更新与快速重检测的长时目标跟踪[J]. 光学学报, 2020, 40(3): 0315002.

[21] LiB, WuW, WangQ, et al. SiamRPN++: evolution of Siamese visual tracking with very deep networks[C]∥2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), June 15-20, 2019, Long Beach, CA, USA. New York: IEEE, 2019: 4277- 4286.

Article Outline

王殿伟, 方浩宇, 刘颖, 姜静, 任新成, 许志杰, 覃泳睿. 一种基于改进SiameseRPN的全景视频目标跟踪算法[J]. 激光与光电子学进展, 2020, 57(24): 241008. Dianwei Wang, Haoyu Fang, Ying Liu, Jing Jiang, Xincheng Ren, Zhijie Xu, Yongrui Qin. Algorithm for Panoramic Video Tracking Based on Improved SiameseRPN[J]. Laser & Optoelectronics Progress, 2020, 57(24): 241008.