高速铁路场景的分割与识别算法  下载: 1081次

下载: 1081次

1 引言

基于视频检测技术的铁路周界侵限检测系统能够有效检测侵入轨道区域周界以内的异物,是实现铁路安全运行的重要保障。轨道区域的位置及边界是系统判断异物是否侵限的重要依据,其划分过程却是通过人工操作在监控场景中事先标注的,而随着铁路沿线监控相机数量的激增,单纯依靠人工标注变得费时费力。除此之外,铁路沿线还存在大量的变焦相机,它们会因不同业务需求而临时改变拍摄角度及焦距,变动后的监控场景需要及时地进行重新标注,这同样需要大量的人工操作。因此,如果检测系统能够利用相应的场景分割与识别算法[1-2],自动划分需要监控的轨道区域,将大幅提高检测系统的自动化程度和工作效率。在实际工程应用中,检测系统要求相应算法不仅要有良好的分割精准度和识别准确率,而且要具备快速处理临时变动场景的能力,同时系统对算法本身的计算量也有所限制,以便将算法移植进不同的数据处理硬件平台[3-4]。

传统方法如超级像素点算法[5-6]是将图像从RGB颜色空间转换到CIE-Lab颜色空间,组成一个5维向量,通过计算向量距离,将图像分割成多个碎片化区域。刘亚辰等[7]通过增加图像的灰度、颜色和边缘梯度等融合式空间塔式直方图特征信息,并使用支持向量机(SVM)对特征进行分类。房泽平等[8]在YCbCr颜色空间对图像进行颜色阈值分割,通过相关区域与人工设计模板的匹配来定位和识别现场的交通标志。上述算法说明将图像从RGB颜色空间转换到其他颜色空间可以增加更多维度的特征信息。为了将碎片化区域组合为代表场景组成元素的局部区域,刘凯品等[9-11]将K-Mean(多维度)聚类思想应用到实际工程中,根据不同的场景设定不同的颜色聚类规则,进而对每个碎片化区域中的连通域进行分析,最后对各区域进行组合与聚类。Arbeláez等[12-14]提出多尺度组合聚合(MCG)算法,通过训练随机森林回归器优化碎片化区域的组合方式,最终得到前景物体的完整轮廓。上述算法的聚类过程通常涉及大量的迭代运算,使得局部区域的精准度与计算时间成反比。

新兴的卷积神经网络(CNN)作为深度学习的重要分支,在图像识别、语义分割和目标检测等领域有着广泛的应用。Farabet等[15-16]在卷积神经网络结构的基础上分别并行引入超级像素点、随机效应场和图像语义分割等算法。Gupta等[17-18]提出先对RGB-D图像的深度信息进行水平差异、地面高度和重力倾角的编码,最后串行连接CNN分类网络。全连接卷积神经网络(FCN)算法[19-20]则是通过深度卷积神经网络自身同时完成特征提取、组合及分类,并实现像素级的图像分割与识别。上述算法说明卷积神经网络可以并行、串行和独立完成相关图像的分割与识别工作,其功能及效果取决于网络结构的复杂程度,而大量的网络参数导致相应计算只能依赖于GPU显卡,不利于将算法移植进分布在铁路沿线的不同配置的数据处理平台。

对MCG算法和FCN算法进行比较。MCG算法的计算结果与真值的平均交互重合率(MIU)为80%,但计算时间为7 s(图像分辨率为90 pixel×150 pixel,RGB三色),导致其只适用于固定监控场景的初始划分或后期处理,而不适用于变动场景的快速划分。而FCN算法(运算结果因FCN具体结构而异)的区域分割结果与真值的交互重合率(IU)在70%~80%之间,像素准确率约为90%,网络参数约为57×106~134×106个,只能依赖GPU显卡并行计算。本文结合传统图像分割算法与卷积神经网络算法的优点,提出了先分割得到精确的局部区域边界,再识别局部区域类别的计算方案,并针对上述方法的缺点逐一做出改进。

针对图像分割依赖大量迭代运算的问题,通过充分利用铁路场景直线特征强烈、组成区域类别固定等特点,提出自适应的多尺度边界点权值计算方法,大幅减少传统算法中的计算项,加快碎片化区域的生成;然后通过阈值筛选强弱边界点,减少碎片化区域数量,并进一步通过区域面积及相邻区域边界强度将碎片化区域快速组合成局部区域。

针对卷积神经网络计算量大的问题,提出只将卷积神经网络应用于局部区域的识别,通过简化卷积神经网络及减少网络参数来加快识别速度并摆脱对GPU显卡的依赖;进一步通过对卷积核进行预训练并增加损失函数的稀疏项来提高特征图的差异性,以弥补因简化网络而损失的准确率。

2 高速铁路场景碎片化区域的生成与组合

2.1 基于自适应多尺度边界权值算法的铁路场景碎片化处理

如

多尺度边界点权重计算是在不同缩放比例

由于直角坐标系中的共线点对应着霍夫变换坐标内有共同交点的一组曲线,所以霍夫变换后的极大值

反向计算极值点所代表的直线方程,即可得到直角坐标系中直线的斜率

图 4. 自适应调整角度的高斯卷积核。(a) θ=22°; (b) θ=38°; (c) θ=90°; (d) θ=178°

Fig. 4. Gaussian convolution kernels rotated by adaptive angles. (a) θ=22°; (b) θ=38°; (c) θ=90°; (d) θ=178°

在确定卷积核之后,先将原始图像从RGB色彩空间转换至CIE-Lab色彩空间,并获取包含亮度、色度

定义像素点

利用(3)式可以得到局部区域内任意点到中心点的相似度矩阵

最终求和得到

2.2 基于碎片化区域面积及边界强度的快速组合

通过多尺度边界点权重计算得到的强弱边界点如

1) 对得到的边界点权重

边界点

2) 边界点权值分布统计图如

3) 通过膨胀腐蚀处理连接断点,如

4) 统计碎片化区域面积分布,如

5) 重复步骤4),以减小

6) 若

7) 将分割后的局部区域调整为像素尺寸64 pixel×64 pixel,如

通过多次对比实验并结合铁路场景包含区域的自身特点(放射性、类别少且面积大),将铁路场景图像设定为90 pixel×150 pixel,保留区域个数

图 5. 碎片化区域合并过程图。(a)强弱边界图;(b)边界权重分布图;(c)筛选掉弱边界点;(d)碎片化区域;(e)碎片化区域面积分布;(f)合并后得到的局部区域;(g)-(o)分割后的局部区域

Fig. 5. Procedures of combining fragmented regions. (a) Strong and weak boundaries; (b) distribution of boundary weight; (c) boundaries after deletion of weak points; (d) fragmented regions; (e) distribution of fragmented region area; (f) local areas after combination; (g)-(o) local areas after segmentation

3 高速铁路场景局部区域的识别

3.1 简化卷积神经网络结构

传统深度卷积神经网络算法虽然可以同时实现像素级的图像分割与识别,但是在实际工程应用中除了使用GPU显卡进行并行计算外,还需要大量的人工操作来细化样本区域及边界的像素级标签,因此通过设计一个简化的小型卷积神经网络,可简化人工标注工作并节省成本。卷积神经网络结构主要是由输入层、两层卷积层(C1和C2)、两层均值采样池化层(S1和S2)、一个全连接层(FC)和一个分类层(softmax)组成,如

不同卷积神经网络结构的对比实验结果如

表 1. 不同卷积神经网络结构对比实验结果

Table 1. Comparison of experimental results of different CNN network structures

| |||||||||||||||||||||

为了弥补因简化网络而损失的准确率,需要对网络参数进行优化,因此提出对卷积核进行预处理,使其能够更好地提取图像底层特征,同时增加损失函数中的稀疏项,通过抑制特征图的平均输出并提高个别特征图的输出值来增大特征图的差异性。

3.2 优化卷积神经网络参数

在铁路场景中采集彩色小图像补丁(像素大小为8 pixel×8 pixel,RGB三色),采集数据构成列向量并作为自编码网络AutoEncoder[

图 7. 利用自编码网络预训练卷积核。(a)自编码网络结构;(b)预训练后的卷积核

Fig. 7. Pre-train convolutional kernels using autoencoder network. (a) Structure of autoencoder networks; (b) pre-trained convolution kernels

原有的代价函数可表示为

其中

式中:

不同卷积神经网络结构优化后的对比实验结果如

表 2. 不同卷积神经网络结构优化后的对比实验结果

Table 2. Comparison of experimental results of different convolutional neural network structures after optimization

| |||||||||||||||||||||

4 分析与讨论

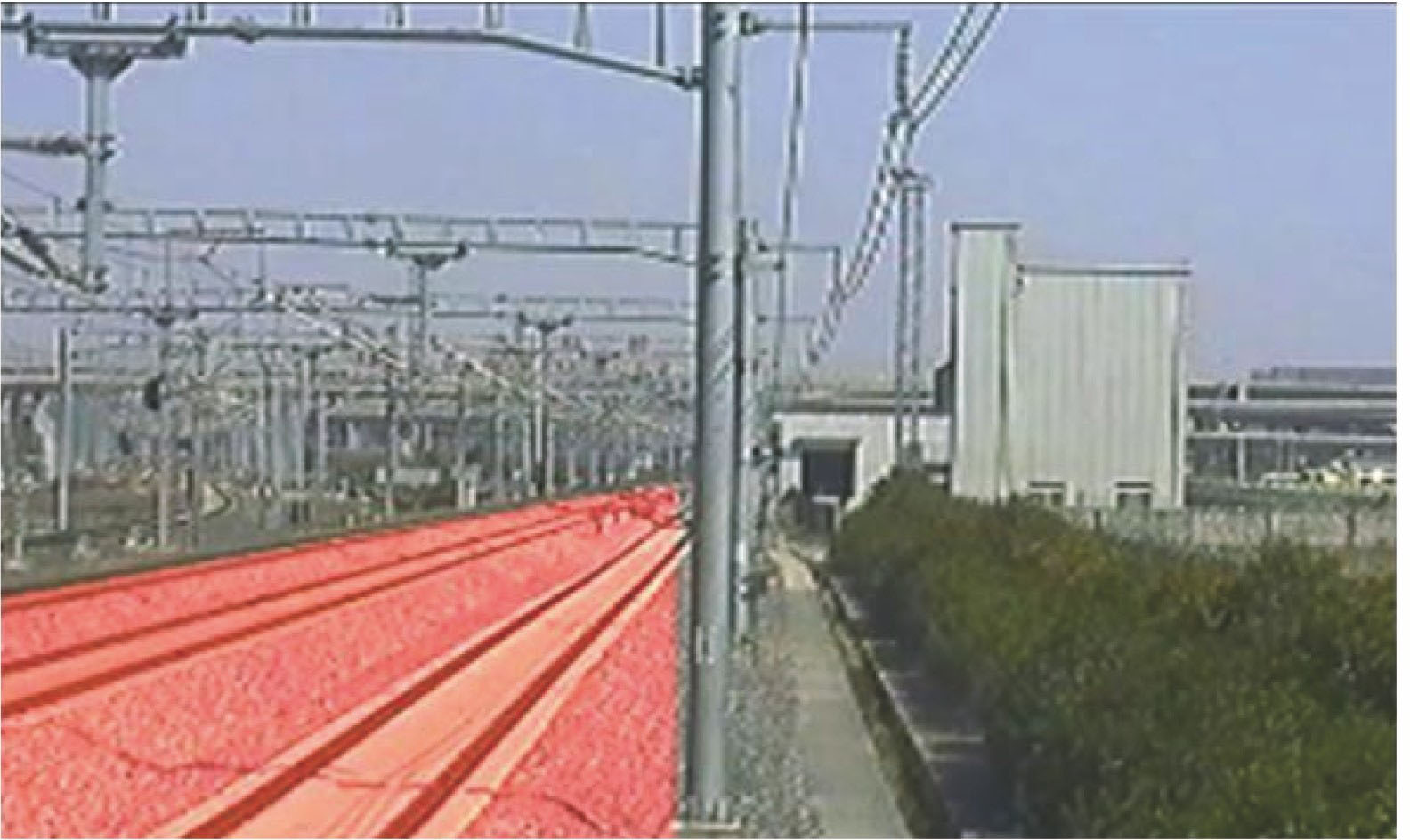

为了验证算法的可行性,本文在沪宁城际高速铁路建立了高速铁路周界侵限检测系统实验平台,如

图 8. 高速铁路周界侵限检测系统组成结构示意图

Fig. 8. Structural schematic of high-speed railway intrusion detecting system

本文算法通过提取直行线路上行方向、下行方向、弯道和公跨铁桥梁等典型铁路场景并进行计算,将其与MCG和FCN算法作对比,实验平台采用统一配置,Intel i5处理器,8 G内存,不使用GPU显卡,实验结果如

图 9. 不同算法识别轨道区域的结果对比图。(a) 铁路场景;(b) 人工标记区域;(c) MCG算法结果;(d) FCN算法结果;(e) 所提算法结果

Fig. 9. Comparison diagrams of results of different algorithms for track area recognition. (a) Railway scenes; (b) manually labeled regions; (c) results of MCG algorithm; (d) results of FCN algorithm; (e) results of proposed algorithm

不同算法实验结果分析如

表 3. 不同算法实验结果对比

Table 3. Comparison of experimental results of different algorithms

|

平均PA值越高意味着越少的轨道区域被漏掉(

不同算法的漏报警区域与误报警区域

Missing alarm area and false alarm area of different algorithms

| Algorithm | MCG | FCN | Proposed algorithm |

|---|---|---|---|

| Result | |||

| Missing area Missing alarm | |||

| Extra area False alarm |

5 结论

所提出的高速铁路场景分割与识别算法结合了传统图像分割算法与卷积神经网络算法的优点,充分利用铁路场景直线特征强烈、组成区域类别固定等特点,对图像分割与识别算法在实际工程应用中遇到的一系列问题做出改进,在边界精准度、识别准确率、计算时间和人工操作复杂度等多对矛盾中寻求有效的平衡点,从而使铁路周界侵限检测系统能够自动、快速、准确地划定监控场景中轨道区域的周界范围,提高了系统的工作效率。

[1] 贺付亮, 郭永彩, 高潮. 复杂环境下用于人体目标红外图像分割的改进PCNN方法[J]. 光学学报, 2017, 37(2): 0215003.

贺付亮, 郭永彩, 高潮. 复杂环境下用于人体目标红外图像分割的改进PCNN方法[J]. 光学学报, 2017, 37(2): 0215003.

[2] 吴晨玥, 易本顺, 章云港, 等. 基于改进卷积神经网络的视网膜血管图像分割[J]. 光学学报, 2018, 38(11): 1111004.

吴晨玥, 易本顺, 章云港, 等. 基于改进卷积神经网络的视网膜血管图像分割[J]. 光学学报, 2018, 38(11): 1111004.

[3] 郭保青, 杨柳旭, 史红梅, 等. 基于快速背景差分的高速铁路异物侵入检测算法[J]. 仪器仪表学报, 2016, 37(6): 1371-1378.

郭保青, 杨柳旭, 史红梅, 等. 基于快速背景差分的高速铁路异物侵入检测算法[J]. 仪器仪表学报, 2016, 37(6): 1371-1378.

[6] 陈海永, 郄丽忠, 杨德东, 等. 基于超像素信息反馈的视觉背景提取算法[J]. 光学学报, 2017, 37(7): 0715001.

陈海永, 郄丽忠, 杨德东, 等. 基于超像素信息反馈的视觉背景提取算法[J]. 光学学报, 2017, 37(7): 0715001.

[7] 刘亚辰, 陈跃鹏, 张赛硕, 等. 融合式空间塔式算子和HIK-SVM的交通标志识别研究[J]. 交通运输系统工程与信息, 2017, 17(1): 220-226.

刘亚辰, 陈跃鹏, 张赛硕, 等. 融合式空间塔式算子和HIK-SVM的交通标志识别研究[J]. 交通运输系统工程与信息, 2017, 17(1): 220-226.

[8] 房泽平, 段建民, 郑榜贵. 基于特征颜色和SNCC的交通标志识别与跟踪[J]. 交通运输系统工程与信息, 2014, 14(1): 47-52.

房泽平, 段建民, 郑榜贵. 基于特征颜色和SNCC的交通标志识别与跟踪[J]. 交通运输系统工程与信息, 2014, 14(1): 47-52.

[9] 刘凯品, 应自炉, 翟懿奎, 等. 基于无监督K均值特征和数据增强的SAR图像目标识别方法[J]. 信号处理, 2017, 33(3): 452-458.

刘凯品, 应自炉, 翟懿奎, 等. 基于无监督K均值特征和数据增强的SAR图像目标识别方法[J]. 信号处理, 2017, 33(3): 452-458.

[10] 张小丹, 范九伦, 徐健, 等. K均值聚类和支持向量数据描述的图像超分辨率算法[J]. 中国图象图形学报, 2016, 21(2): 135-144.

张小丹, 范九伦, 徐健, 等. K均值聚类和支持向量数据描述的图像超分辨率算法[J]. 中国图象图形学报, 2016, 21(2): 135-144.

[11] 马国强, 田云臣, 李晓岚. K-均值聚类算法在海水背景石斑鱼彩色图像分割中的应用[J]. 计算机应用与软件, 2016, 33(5): 192-195.

马国强, 田云臣, 李晓岚. K-均值聚类算法在海水背景石斑鱼彩色图像分割中的应用[J]. 计算机应用与软件, 2016, 33(5): 192-195.

[12] ArbeláezP, Pont-TusetJ, Barron JT, MarquesF, et al. Multiscale combinatorial grouping[C]∥2004 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2014, Columbus, OH, USA. New York: IEEE, 2014: 328- 335.

ArbeláezP, Pont-TusetJ, Barron JT, MarquesF, et al. Multiscale combinatorial grouping[C]∥2004 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2014, Columbus, OH, USA. New York: IEEE, 2014: 328- 335.

[14] ArbeláezP. Boundary extraction in natural images using ultrametric contour maps[C]∥2006 Conference on Computer Vision and Pattern Recognition Workshop (CVPRW'06), June 17-22, 2006, New York, USA. New York: IEEE, 2006: 182.

ArbeláezP. Boundary extraction in natural images using ultrametric contour maps[C]∥2006 Conference on Computer Vision and Pattern Recognition Workshop (CVPRW'06), June 17-22, 2006, New York, USA. New York: IEEE, 2006: 182.

[16] CouprieC, FarabetC, NajmanL, et al. Indoor semantic segmentation using depth information[EB/OL]. ( 2013-03-14)[2019-01-25]. https:∥arxiv.org/abs/1301. 3572.

CouprieC, FarabetC, NajmanL, et al. Indoor semantic segmentation using depth information[EB/OL]. ( 2013-03-14)[2019-01-25]. https:∥arxiv.org/abs/1301. 3572.

[17] GuptaS, GirshickR, ArbeláezP, et al. Learning rich features from RGB-D images for object detection and segmentation[M] ∥Fleet D, Pajdla T, Schiele B, et al. Computer Vision-ECCV 2014. Cham: Springer, 2014, 8695: 345- 360.

GuptaS, GirshickR, ArbeláezP, et al. Learning rich features from RGB-D images for object detection and segmentation[M] ∥Fleet D, Pajdla T, Schiele B, et al. Computer Vision-ECCV 2014. Cham: Springer, 2014, 8695: 345- 360.

[18] PetrelliA, Pau D, di Stefano L. Analysis of compact features for RGB-D visual search[M] ∥Murino V, Puppo E. Image Analysis and Processing-ICIAP 2015. Cham: Springer, 2015, 9280: 14- 24.

PetrelliA, Pau D, di Stefano L. Analysis of compact features for RGB-D visual search[M] ∥Murino V, Puppo E. Image Analysis and Processing-ICIAP 2015. Cham: Springer, 2015, 9280: 14- 24.

[20] 郑婷月, 唐晨, 雷振坤. 基于全卷积神经网络的多尺度视网膜血管分割[J]. 光学学报, 2019, 39(2): 0211002.

郑婷月, 唐晨, 雷振坤. 基于全卷积神经网络的多尺度视网膜血管分割[J]. 光学学报, 2019, 39(2): 0211002.

Article Outline

王洋, 朱力强, 余祖俊, 郭保青. 高速铁路场景的分割与识别算法[J]. 光学学报, 2019, 39(6): 0610004. Yang Wang, Liqiang Zhu, Zujun Yu, Baoqing Guo. Segmentation and Recognition Algorithm for High-Speed Railway Scene[J]. Acta Optica Sinica, 2019, 39(6): 0610004.