基于视角信息嵌入的行人重识别  下载: 1263次

下载: 1263次

1 引言

行人重识别是用来匹配来自不相交区域摄像头捕捉到的行人图像技术。随着“天网行动”在我国的大力开展,作为智能安防领域主要技术之一的行人重识别技术成为研究热点。受不同摄像头的安放位置、内部硬件差异以及所处区域环境不同等因素的影响,所拍摄的行人图像存在光照、形变、遮挡、姿态差异和视角差异等问题。目前主流的行人重识别的方法是基于手工特征表示的方法,寻找一个能够充分描述行人图像的描述模型来表示每个特定行人的特征(如纹理特征[1]、边缘特征[2]、颜色直方图[3]和联合特征[4]),从而判断不同摄像头中的行人是否为同一个人。尽管采用手工特征表示方法能够考虑到行人的多方面特征,但对于行人重识别这样一个行人图像受多方面因素影响的情况来说,这些手工特征表示方法的能力仍十分有限。

近年来,深度学习理论[5]的提出为信号处理尤其是图像处理带来了全新的进展。特别地,在图像特征提取方面,深度学习方法取得了远超越基于手工特征表示方法的卓越效果。Li等[6]将深度学习方法引入行人重识别中,通过在网络中添加一个补丁匹配层,将两个图像的卷积响应与不同的水平条纹相乘得到最终的特征向量,进而进行匹配,该方法在一定程度上解决了行人匹配错位的问题。Geng等[7]通过改变深度学习训练策略,将分类任务损失函数与验证任务损失函数一同引入行人重识别中,让两种模式互相学习,提高了行人重识别模型的泛化能力。Zheng等[8]将行人图片局部对齐的思想引入模型设计中,利用人体姿态估计模型估计出人体关键部件区域,再分别对每个行人的关键区域进行一对一匹配,最终得到匹配结果。Zhang等[9]基于同样局部对齐的思想,通过在局部匹配过程中引入动态对齐算法,动态计算局部最短距离,从而实现匹配,该方法在有效地减少模型复杂程度的同时保证了匹配准确度。上述基于深度学习的方法虽然取得了优于手工特征表示方法的效果,但忽视了行人的侧面、正面和背面这些视角变化所带来的深层信息,而这些视角信息能更全面地描述行人,对于行人重识别有着重要的影响。2018年,Saquib等[10]提出一种PSE(pose-sensitive embedding)网络,将行人姿态朝向的信息引入网络的设计中,取得了较好的识别效果。但是PSE网络没有做到有效地利用姿态朝向的角度信息,导致模型识别能力受限。为了提升行人重识别模型性能进而提高识别率,本文从行人视角信息出发,在PSE网络上进行改进,利用视角朝向信息提出基于视角信息嵌入的行人重识别模型,并取得了更好的行人图像识别效果。

2 行人重识别技术

对于一张预查询行人图片,如何在候选库中找到与其匹配的行人图片是行人重识别需要解决的问题。目前主流的基于手工特征表示方法的步骤如下:1)设计一个具有代表性的特征提取器;2)使用该特征提取器分别对预查询行人图片以及候选集中所有的图片进行特征向量提取,并依次利用候选集中的图片特征向量与预查询行人图片的特征向量,计算其向量空间距离;3)将候选集中的图片按特征向量间距离从小到大顺序排列,排在第一位的行人最有可能与预查询行人为同一个人。

上述过程中,关键的步骤在于设计一个具有代表性的特征提取器。目前行人重识别中的特征提取器主要分为两类,分别是基于手工特征表示的方法和基于深度学习的方法。基于手工特征表示的方法受限于表达能力,在行人重识别的特征提取过程中,很难取得良好的识别效果。而基于深度学习的方法以其优秀的学习机制,能够通过学习得到合适的特征表示,并取得比基于手工特征表达方法更好的效果。目前,在行人重识别中,基于深度学习方法的特征表示有PSE网络[10]、DPFL(deep pyramidal feature learning)[11]和QAN(quality aware network)[12]等。本研究算法就是基于PSE模型进行改进的。

2.1 姿态敏感嵌入网络

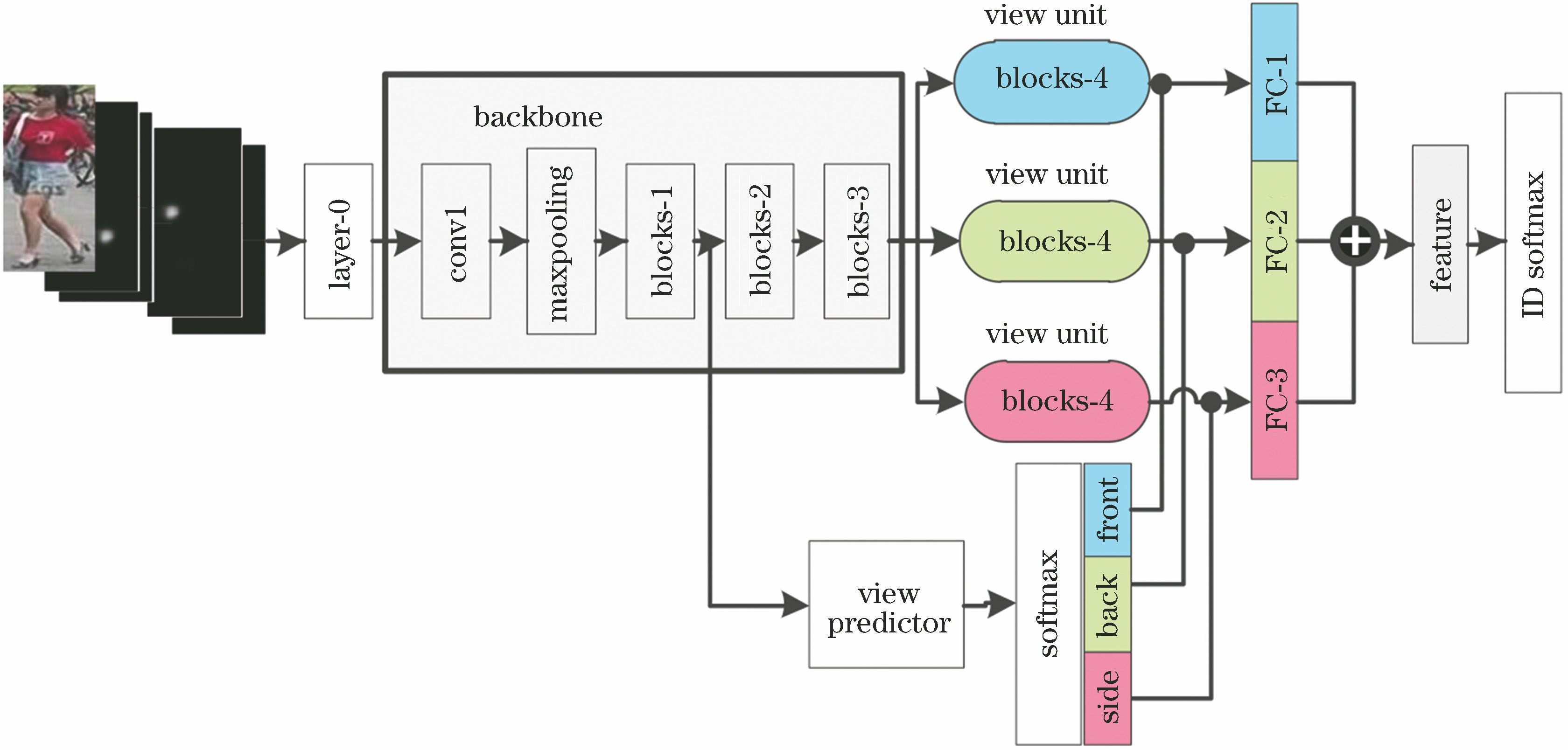

最近,Saquib等[10]在计算机视觉顶级会议CVPR2018上提出了一种PSE网络。该网络具有良好的泛化能力,在行人重识别的多个数据集上取得了最优的结果。PSE网络的主要思想是将行人姿态与朝向信息引入网络,在骨架网络侧面引入姿态朝向预测模块来辅助骨架网络,最终取得了良好的泛化结果。PSE网络模型结构如

PSE网络模型由骨架、视角预测以及视角单元三个部分组成。整个网络是在ResNet50的基础上进行设计,图中blocks-1、blocks-2、blocks-3与blocks-4对应ResNet50中的模块。

PSE网络的输入是行人图片及其14通道的人体姿态热图。 layer-0层是将输入转化为适应ResNet50网络输入的形状。骨架部分的各个模块就是ResNet50中的对应模块。整个骨架部分用于特征预提取。将视角预测分支从骨架网络的blocks-1中的降维步骤后分离出来,用于预测行人图像的朝向,并输出各个朝向对应的概率值。将ResNet50中的blocks-4的结构复制三份,分别作为代表正面、侧面和背面的视角单元,并分别与视角预测分支的三路softmax输出进行加权,三路加权结果从FC (fully connected layer) 输出并进行特征融合,最终得到一个嵌入向量,用于最终匹配。

2.2 PSE网络模型训练

PSE网络模型的训练整体分为预训练和训练两个部分。在所有训练之前需将行人重识别数据集分成训练集与测试集,训练集由一定ID(identity)数量的行人构成,测试集由ID不属于训练集的行人构成。

预训练分为三步。首先对骨架网络部分进行参数初始化,采用在ImageNet数据集上预训练的方法进行参数初始化。然后固定骨架网络与视角单元部分,使用RAP(richly annotated pedestrian)数据集对视角预测部分进行预训练。最后固定视角预测部分与骨架部分,使用行人重识别训练集对视角部分进行预训练。

完成预训练后,进行正式训练。首先根据训练集的ID数量,使用softmax分类器设置成相同ID数量的类别,分类器接在PSE网络的全连接层之后,用于分类。一般地,使用卷积神经网络框架对行人图片进行特征表示时,需要使用softmax分类函数,由于PSE网络模型的本质是一种卷积神经网络框架,这里采用同样的操作。接着使用接有softmax分类器的PSE网络,在分好的训练集上对行人图片进行分类训练,并采用随机梯度下降算法。最后将训练好的模型参数保存在PSE网络模型中,取下softmax分类器,得到最终的PSE网络。

虽然采用PSE网络模型取得了目前最优的效果,但PSE网络并没有有效地利用视角朝向信息,它对三路视角单元的特征采用的是特征融合的方式,对于三路视角特征的利用不够充分有效,造成模型的识别能力受限。在此通过实验发现,模型结构上还有更合理的设计方案,下面就这个方案进行说明。

3 基于视角信息嵌入的行人重识别模型

在此对PSE网络进行了三个方面的改进:1)将最终特征向量的组合方式从特征融合改成特征拼接;2)采用骨架网络更浅层的blocks-3作为视角单元分离位置;3)利用改进的深度可分离卷积,设计一个深度可分离模块,代替blocks-4对视角单元进一步进行特征提取。改进后的模型变成三个部分,分别是骨架网络部分、视角预测部分以及视角分离部分。

3.1 基于视角信息嵌入的模型结构

所提出的基于视角信息嵌入的模型结构如

首先,将视角预测部分输出的三个朝向预测概率与三个视角单元的输出进行加权后,可使网络在进行梯度更新时,针对输入行人图片的朝向着重更新对应朝向的视角单元,如当输入行人图片是正面朝向时,视角预测部分正面概率较大,该大概率会让梯度流向被大权值加权的那一路,即正面朝向的视角单元,因此不同视角单元都能特定学习对应行人朝向的特征,这使得三路分开的视角单元具备分别以正面、侧面和背面方式描述特征的能力。实际上,这种特征表达方式的不同反映在特征层面就是表示特征的特征空间不同。Cao等[13]在人脸识别任务中提出一个假设,认为人脸的侧面与正面分别对应不同的特征空间,并通过实验进行了验证。与人脸类似,不同朝向的行人图像对应的特征空间也是不同的。而在PSE网络模型的视角部分,网络对三个复制的分别代表正面、侧面和背面的特征图谱直接进行了加权融合,而三个特征图谱所在的特征空间不同,原PSE模型不太适合对来自不同特征空间的特征图谱进行线性加权融合。因此,将特征融合改为特征拼接,即将最终的三路768维特征向量首尾连接成2304维向量,并将其作为最终的特征向量,这就避免了在不同特征空间进行线性加权融合。

其次,为了更好地利用不同空间的信息,与PSE网络在blocks-4分出三份视角单元不同的是,所提出的方法在骨架网络更浅层的blocks-3层进行分离,其中blocks-3_f表示ResNet50中的conv4_1,blocks-3_b表示ResNet50中的conv4的剩余部分,这样的操作可以减少视角单元共享的学习参数,增大分离的三个姿态单元的差异性,从而能够更好地利用不同空间的信息。

最后,在PSE骨架的更浅层分离视角单元,把Blocks-3原有的一路增加到三路,这大大增加了模型参数量。为了防止网络过大而产生过拟合,并保证网络的非线性,以充分利用特征信息,在此设计了一种深度可分离模块。深度可分离模块采用深度可分离卷积[14]。深度可分离卷积由depthwise操作与pointwise操作构成,其结构如

所采用的深度可分离卷积是在原有结构的基础上进行改进。深度网络在提取特征时,往往会提取大量特征,而有些特征并不是识别所需要的特征。一个具备特征选择机制的网络,不仅能够降低网络的冗余,还能更加精准地进行匹配。受文献[

15]的启发,本研究在depthwise操作与pointwise操作之间引入挤压和激励块。挤压和激励块能对输入的各个通道特征进行加权,通过网络学习,对有利特征进行高加权,对不利特征进行低加权,从而达到特征选择的目的。改进的深度可分离卷积结构如

深度可分离模块采用两个连续的深度可分离卷积堆叠而成,其中每个深度可分离卷积后分别接一个BN(batch normalization)层与ReLU单元。与原始卷积相比,这种结构增加了网络非线性。将堆叠中间层的输出特征图谱与模块输出一同作为输出。文献[ 16]证明,深度神经网络一般取最后一层输出作为特征匹配向量,忽视了处在网络稍浅层的中层特征。而在进行匹配时,不仅深层特征重要,图像的中层特征也很重要,中层特征在识别过程中同样能够提升识别性能。

改进的深度可分离卷积既保证充分利用了每个通道的特征图谱信息,又减少了模型的参数,防止了模型过拟合情况的发生。

3.2 算法实现步骤

为了便于理解,在此给出所提算法的具体实现步骤。

1) 将所提出的模型分为三个部分,分别为ResNet50骨架网络、行人预测分支以及视角分离。模型损失函数采用交叉熵函数。

2) 采用RAP(richly annotated pedestrian)数据集对行人预测分支进行预训练。其中,使用在ImageNet上的预训练参数作为骨架网络的参数进行初始化。训练过程中,骨架网络部分的参数固定不训练。

3) 用行人重识别数据集预训练视角分离部分。这里对整个网络进行训练,但是需先固定行人预测分支与骨架网络的参数。进行反向传播时,梯度只更新视角分离部分,其目的是为视角分离部分的参数提供一个较为理想的初始化状态。

4) 分别设定各个部分的学习率,其中骨架网络、视角预测部分和视角分离部分的识别率分别为0.01,0.001,0.01,用行人重识别数据集对整个网络进行训练。另外,所提出的算法不需要引入PSE网络中的精细粒度的关节点信息,仅使用粗粒度的行人朝向信息就能取得较原PSE网络更好的效果。

4 仿真实验与结果分析

4.1 实验环境和参数设置

实验中采用的硬件环境配置为Intel® CoreTMi7 8700K 酷睿六核 3.7 GHz、32 G内存、64位处理器,并采用GeForce GTX 1080 Ti GAMING X TRIO 11GB GDDR5X进行运算加速,操作系统为64位Ubuntu 16.04,采用基于Python3.6的深度学习框架Pytorch0.4.0完成程序编程。基础学习率为0.01,视角单元部分的学习率为0.001,迭代世代数为130,批量大小为32。

4.2 数据集描述

为了验证所提出的改进模型在行人重识别任务中的优势,在此选用目前行人重识别主流的公开数据集Market1501[17]、Duke-MTMC-reID[18]和MARS[19]进行实验,其中数据集的划分标准与PSE网络模型中所采用的标准[10]一致。

Market1501数据集采集自清华大学校园,由来自6台摄像机视频上的行人检测器生成的32668个边界框组成,包括1501个不同ID行人。751人用于训练,750人用于测试。训练集包含12936个图像,候选集设置19732个图像,查询集包含3368个图像。

Duke-MTMC-reID数据集是根据8台摄像机的数据创建的。包含1404个ID行人、16522个训练图像、2228个查询图像和17661个图库图像。由于采用8台摄像机捕获了数量较多的图像,Duke-MTMC-reID数据集成为迄今为止最具挑战性的行人重识别数据集之一。

MARS数据集是根据6台摄像机的数据创建的,由20478个视频片段构成,图片总数达到1191993,包含1261个重复出现的行人,625人用于训练,636人用于测试。其中训练集由8298个视频片段构成,测试集由12180个视频片段构成,将图片训练集、测试集分别分割为509914、681089张图像。测试集中,查询集由1980个视频片段构成,候选集由9330个视频片段构成。在此,训练集中所有视频片段的图片均参与训练,对测试集中的查询集与候选集的每个行人视频片段均采用均匀抽样方法进行测试,抽样数目为15。对该15张图片的特征向量进行加权,得到该行人的特征向量。

为防止模型出现过拟合现象,通过对行人图片进行随机水平翻转与随机裁剪实现数据集增强。其中,随机裁剪方法是把输入图片先调整到288 pixel×144 pixel大小,再使用大小为256 pixel×128 pixel的框对调整后的图片进行随机裁剪。

4.3 仿真实验与结果分析

实验从模型的有效性与先进性两个方面进行验证,并与目前最好的几种深度学习方法和主流机器学习方法进行对比验证。两个实验将测试集分成查询集与候选集,本实验采用单查询方式验证结果,单查询方式的查询集由每个ID行人在每个摄像头下的一张图片构成,剩下的图片作为候选集。实验评价指标采用行人重识别通用评价指标——累积匹配特征(CMC) 的排名1(rank-1)识别率和平均精度(mAP)。

4.3.1 算法有效性验证实验

为了验证所提模型的有效性,实验选用Market1501、Duke-MTMC-reID和MARS数据集。

首先,所提出的模型将PSE网络中的特征融合改为特征拼接,此时视角预测模块的用途发生改变。因此,为了验证视角预测模块对于改进后的PSE网络仍然有效,在此进行了视角预测模块有效性验证实验。实验结果如

表 1. 视角预测模块有效性验证实验结果

Table 1. Results of perspective predictor module verification experiment

| ||||||||||||||||||||||||||||||||||||||||||||||

为了验证改进深度可分离卷积在所提模型中的有效性,在此进行了改进深度可分离卷积有效性验证实验。实验结果如

为了验证在深度可分离模块中使用中层特征方法的有效性,进行了中层特征方法有效性验证实验,实验结果如

表 2. 改进深度可分离卷积的有效性验证实验结果

Table 2. Results of improved depthwise separable convolution verification experiment

| ||||||||||||||||||||||||||||||||||||||||||||||

表 3. 中层特征方法的有效性验证实验结果

Table 3. Verification experiment results of mid-level feature method

| ||||||||||||||||||||||||||||||||||||||||||||||

最后,通过与PSE网络进行比较来验证所提模型的有效性。改进模型有效性验证实验结果如

表 4. 改进模型有效性验证实验结果

Table 4. Results of improved model verification experiment

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

在

由

对比⑥和⑧模型可知,采用浅层分离改进的模型在三个数据集上的识别率比不采用时的识别率高。说明当模型同时采用拼接特征改进与深度可分离模块改进时,浅层分离改进方法有效。

对比③和④模型可知,采用深度可分离模块改进的模型在三个数据集上的识别率比不采用时的识别率高。说明当模型采用浅层可分离改进时,深度可分离模块的改进方法有效。同时对比⑦和⑧模型可知,采用深度可分离模块改进的模型在三个数据集上的识别率比不采用时的高。说明当模型同时采用拼接特征与浅层可分离进行改进时,深度可分离模块改进方法有效。

对比④和⑧模型可知,采用拼接特征改进的模型在三个数据集上的识别率比不采用时的识别率高。说明当模型同时采用浅层可分离改进与深度可分离模块进行改进时,拼接特征改进的模型有效。

综上所述,当模型同时采用拼接特征、浅层分离以及深度可分离模块改进方法时,所提算法对模型的改进有效,并能够提升模型性能。这验证了所提算法的有效性。

4.3.2 算法运行速度分析实验

对所提算法与PSE网络的运行速度进行对比。任取一张查询集中的行人图片,对比所提网络与PSE网络完成查询的时间。查询集选用Market1501的查询集,候选集选用Market1501的候选集。算法运行速度对比实验结果如

表 5. 算法运行速度对比实验结果

Table 5. Results of algorithm running speed comparison experiment

| |||||||||||

4.3.3 算法先进性验证实验

对目前在三个数据集上最主流的算法DPFL、QMA和PSE进行对比,结果如

在

表 6. 算法结果对比

Table 6. Comparison of algorithm results

| |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

5 结论

针对目前最好的PSE算法进行行人重识别时视角朝向信息利用方面的不足,进行了模型结构的改进。首先改进了特征向量的融合方式,采用特征拼接的方式使得不同视角特征空间的差异能够得到更好的利用。改进了视角单元分离位置,通过在更浅层分离视角单元,增大视角单元间的差异性,更好地构建了不同视角的特征空间。通过引入深度可分离模块,降低了模型的复杂度,防止了模型的过拟合现象。通过这两方面的改进可以得到判别性更强的网络特征,进一步提高了重识别精度。利用Market1501和Duke-MTMC-reid以及MARS数据集这三种主流的数据库对所提算法进行了验证,实验结果表明该算法具有很好的判别性。

实验结果表明,与PSE模型相比,所提的改进算法取得了更好的识别效果,同时也提高了模型的泛化能力。对于行人重识别这种存在大量朝向影响的问题,所提算法具有非常广阔的应用前景。

[1] 郭鹏宇, 苏昂, 张红良, 等. 结合纹理和形状特征的在线混合随机朴素贝叶斯视觉跟踪器[J]. 光学学报, 2015, 35(3): 0315002.

郭鹏宇, 苏昂, 张红良, 等. 结合纹理和形状特征的在线混合随机朴素贝叶斯视觉跟踪器[J]. 光学学报, 2015, 35(3): 0315002.

[2] 孙熊伟, 徐青山, 蔡熠, 等. 基于边缘相位编码的复杂背景下海天线检测[J]. 光学学报, 2017, 37(11): 1110002.

孙熊伟, 徐青山, 蔡熠, 等. 基于边缘相位编码的复杂背景下海天线检测[J]. 光学学报, 2017, 37(11): 1110002.

[3] GrayD, TaoH. Viewpoint invariant pedestrian recognition with an ensemble of localized features[M] //Forsyth D, Torr P, Zisserman A. Lecture Notes in Computer Science. Berlin, Heidelberg: Springer, 2008, 5302: 262- 275.

GrayD, TaoH. Viewpoint invariant pedestrian recognition with an ensemble of localized features[M] //Forsyth D, Torr P, Zisserman A. Lecture Notes in Computer Science. Berlin, Heidelberg: Springer, 2008, 5302: 262- 275.

[4] Prosser BJ, Zheng WS, GongS, et al.Person re-identification by support vector ranking[C]//Proceedings of the British Machine Vision Conference. August 31-September 3, 2010, Aberystwyth, UK. Durham, England,UK: BMVA Press, 2010: 21.

Prosser BJ, Zheng WS, GongS, et al.Person re-identification by support vector ranking[C]//Proceedings of the British Machine Vision Conference. August 31-September 3, 2010, Aberystwyth, UK. Durham, England,UK: BMVA Press, 2010: 21.

[5] 陈洋, 范荣双, 王竞雪, 等. 基于深度学习的资源三号卫星遥感影像云检测方法[J]. 光学学报, 2018, 38(1): 0128005.

陈洋, 范荣双, 王竞雪, 等. 基于深度学习的资源三号卫星遥感影像云检测方法[J]. 光学学报, 2018, 38(1): 0128005.

[6] LiW, ZhaoR, XiaoT, et al. DeepReID: deep filter pairing neural network for person re-identification[C]//2014 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28 ,2014, Columbus, OH, USA. New York: IEEE, 2014: 152- 159.

LiW, ZhaoR, XiaoT, et al. DeepReID: deep filter pairing neural network for person re-identification[C]//2014 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28 ,2014, Columbus, OH, USA. New York: IEEE, 2014: 152- 159.

[10] Saquib SarfrazM, SchumannA, EberleA, et al. A pose-sensitive embedding for person re-identification with expanded cross neighborhood re-ranking[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE, 2018: 420- 429.

Saquib SarfrazM, SchumannA, EberleA, et al. A pose-sensitive embedding for person re-identification with expanded cross neighborhood re-ranking[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE, 2018: 420- 429.

[11] Chen YB, Zhu XT, Gong SG. Person re-identification by deep learning multi-scale representations[C]//2017 IEEE International Conference on Computer Vision Workshops (ICCVW), October 22-29, 2017, Venice, Italy. New York: IEEE, 2017: 2590- 2600.

Chen YB, Zhu XT, Gong SG. Person re-identification by deep learning multi-scale representations[C]//2017 IEEE International Conference on Computer Vision Workshops (ICCVW), October 22-29, 2017, Venice, Italy. New York: IEEE, 2017: 2590- 2600.

[12] LiuY, Yan JJ, Ouyang WL. Quality aware network for set to set recognition[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 4694- 4703.

LiuY, Yan JJ, Ouyang WL. Quality aware network for set to set recognition[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 4694- 4703.

[13] Cao KD, RongY, LiC, et al. Pose-robust face recognition via deep residual equivariant mapping[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE, 2018: 5187- 5196.

Cao KD, RongY, LiC, et al. Pose-robust face recognition via deep residual equivariant mapping[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE, 2018: 5187- 5196.

[17] ZhengL, Shen LY, TianL, et al. Scalable person re-identification: a benchmark[C]//2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 1116- 1124.

ZhengL, Shen LY, TianL, et al. Scalable person re-identification: a benchmark[C]//2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 1116- 1124.

[18] RistaniE, SoleraF, ZouR, et al. Performance measures and a data set for multi-target, multi-camera tracking[M] //Hua G, Jegou H. Lecture Notes in Computer Science. Cham: Springer, 2016, 9914: 17- 35.

RistaniE, SoleraF, ZouR, et al. Performance measures and a data set for multi-target, multi-camera tracking[M] //Hua G, Jegou H. Lecture Notes in Computer Science. Cham: Springer, 2016, 9914: 17- 35.

[19] ZhengL, BieZ, Sun YF, et al. MARS: a video benchmark for large-scale person re-identification[M] //Leibe B, Matas J, Sebe N, et al. Computer Vision-ECCV 2016. Cham: Springer, 2016, 9910: 868- 884.

ZhengL, BieZ, Sun YF, et al. MARS: a video benchmark for large-scale person re-identification[M] //Leibe B, Matas J, Sebe N, et al. Computer Vision-ECCV 2016. Cham: Springer, 2016, 9910: 868- 884.

Article Outline

毕晓君, 汪灏. 基于视角信息嵌入的行人重识别[J]. 光学学报, 2019, 39(6): 0615007. Xiaojun Bi, Hao Wang. Person Re-Identification Based on View Information Embedding[J]. Acta Optica Sinica, 2019, 39(6): 0615007.