基于时间正则化及背景感知的滤波器跟踪  下载: 874次

下载: 874次

1 引言

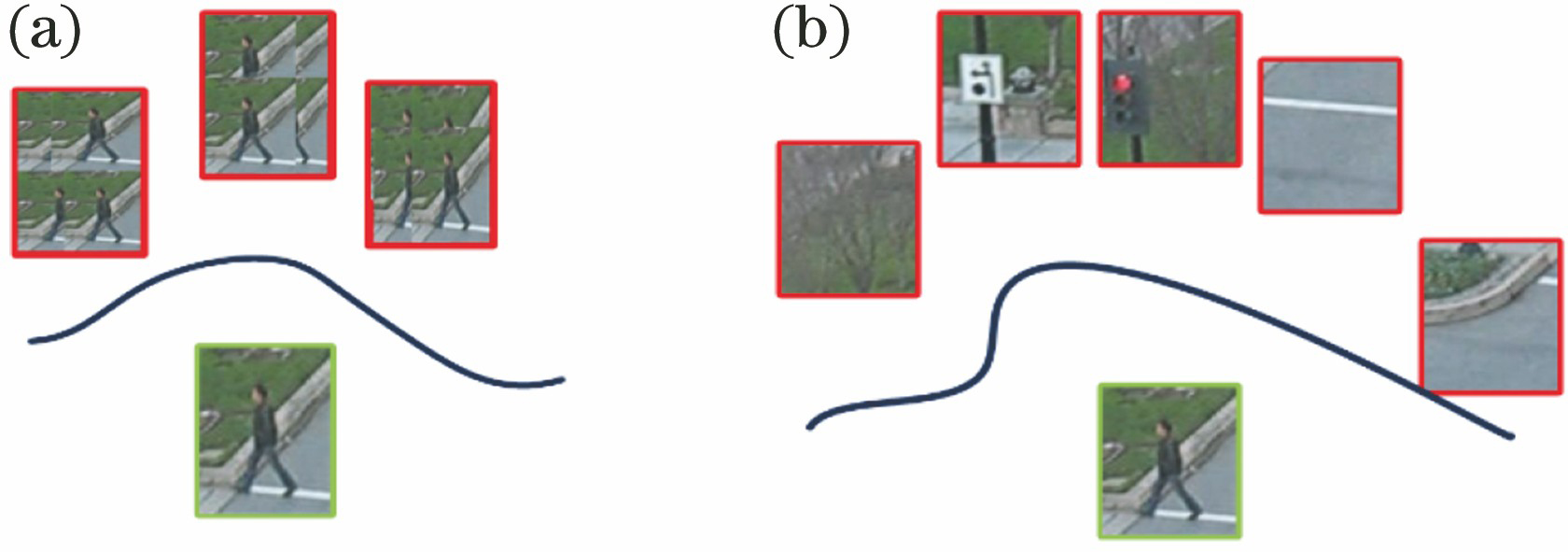

相关滤波器(CF)具有优越的计算能力,且在光照和几何形变的情况下仍然具有良好的稳健性,已被广泛应用于视觉跟踪领域[1-4]。CF在频域中的学习和检测速度快,其中速度最快的是MOSSE跟踪器,跟踪速度为700 frame/s[5]。该跟踪器采用图像的灰度特征,并用峰值旁瓣比来判别目标是否被遮挡或有无跟踪失败的情况,在运动模糊、缩放和光照变化的情况下仍然能够稳健地跟踪目标。然而,大多数CF学习所需的样本是从循环位移中得到的。从循环位移得到的图像容易受边界效应的影响,使目标响应区域变大且响应不能集中在目标中心区域,从而影响跟踪的准确度与成功率[6]。另外,从有限的循环位移中学习可能会导致滤波器在训练的过程中出现过度拟合的现象,进而导致滤波器泛化性能变差。最后,真实负样本学习的缺乏会极大地降低此类跟踪器对杂乱背景的辨别能力,当目标及其周围背景具有相似视觉信息时,此类跟踪器的虚假检测风险就会升高。

最近的相关滤波器跟踪算法通过在大空间中训练样本、提取深度特征来学习滤波器。空间正则化的CF(SRDCF)[2]可从大空间训练样本中学习。该方法的主要缺点是:即使在傅里叶频域中,正则化目标的优化成本也很高,故SRDCF方法不适用于实时跟踪。此外,为了形成正则化权重,必须仔细调整一组超参数,如果不正确执行则会导致跟踪性能较差。深度卷积神经网络(CNN)提取的特征[7-8]在CF上有着出色的性能表现,但这种方法也有着自身的缺点。与采用梯度直方图(HOG)[9]等手工提取特征的CF相比,具有CNN功能的CF在光照和几何变化情况下具有显著的跟踪性能。这主要是因为CNN在大规模数据上进行了训练,CNN所提取的特征具有高度辨别能力。但是,若从每帧图像中提取CNN特征并在高维深度特征上训练/更新CF,将会导致计算复杂度非常高,处理速度仅能达到0.2 frame/s[8,10],最终导致实时性能较差。类似地,纯粹的深度滤波器也存在同样的缺点[11-12],一些方法的处理速度只有1 frame/s。

为此,本文提出了一种基于时间正则化及背景感知的滤波器跟踪(TBACF)算法。该方法能从目标场景中提取真实的负样本来学习/更新滤波器,同时结合时间正则提高了其跟踪遮挡目标的稳健性。本文的主要贡献如下:1)提出了一种用于实时视觉跟踪的相关滤波器。传统CF的负样本仅限于从循环位移产生,而本文设计的滤波器所需的训练样本是从真实的背景中提取所得,这些样本包含了更大的搜索区域和更真实的背景。本文算法采用交替方向乘子法(ADMM)来学习多通道特征(例如HOG),计算成本为

2 相关滤波器

相关滤波器可通过最小均方误差函数来求解,其目标函数多通道一般可表示为[16]

式中:

式中:[Δ

图 1. 样本提取对比结果。(a)传统CFS样本提取结果;(b) TBACF样本提取结果

Fig. 1. Comparison results of sample extraction. (a) Traditional CFS sample extraction results; (b) Results of TBACF sample extraction

3 时间背景感知相关滤波器

本文所提出的TBACF跟踪算法,主要分为两个部分:时间正则化及感知跟踪模块和更新模块。

3.1 时间正则化及背景感知跟踪

为了更好地解决目标精确定位和目标遮挡问题,采用真实的负样本来增强滤波器的分类能力,并利用相邻滤波器的时间信息来更新当前帧的滤波器。TBACF滤波器的岭回归计算方法为

式中:

(2)式和(3)式的计算成本

在频域中,学习相关滤波器的计算效率可表示为

式中:对

3.2 更新滤波器

3.2.1 优化求解目标

在求解目标约束问题时,一般是通过设置惩罚权重来近似求解约束目标。这种方法计算复杂度大,求解目标收敛速度慢,且近似求解的目标函数很不稳定。为了解决这个问题,本文采用增广拉格朗日乘子法(ALM)[18],将约束项放到优化函数里来求解(4)式。

式中:

1)求解

式中:

2)求解

直接求解(7)式的成本是

式中:

进行求解。(9)式的计算成本

式中:

拉格朗日更新公式为

式中:

3.2.2 在线更新与检测

1)在线更新。与其他CF跟踪器类似[1,5,18],本研究采用在线自适应的方法来提高算法对尺度变换和光照强度的稳健性。在

2)检测。通过滤波器

4 实验与分析

4.1 实验环境与参数设置

实验在内存为16 G,处理器为I5-7500(主频为3.4 Hz)的计算机上进行,软件编程环境为 MATLAB 2014a。在TBACF中,采用31通道HOG特征,使用4×4个单元乘以汉宁窗口(Hann)[5]。设定正则化因子

4.2 评估方法

OTB-2015[1]是一个常用的跟踪数据集,由100个完全注释的视频序列组成,具有11种不同的属性,如遮挡、平面外旋转和背景嘈杂。本文基于一次性通过评价(OPE)来分析和评价不同算法的性能。同时,为更好地分析本文所提算法,即TBACF算法的性能,将其与其他5种算法(KCF[20],Staple[21],DSST[22],SRDCF[2]和BACF[23])进行比较分析。

4.3 TBACF跟踪定量分析

4.3.1 整体性能分析

图 3. 6种算法在OTB-2015数据集上的精确度得分和成功率得分。(a)精确度得分;(b)成功率得分

Fig. 3. Precision and success rate scores of six algorithms on OTB-2015 dataset. (a) Precision score; (b) success rate score

4.3.2 基于视频属性的性能分析

为了更好地分析TBACF算法在不同视频属性上的表现性能,分别记录6种算法在11种视频属性上的精确度得分和成功率得分[13],结果如

图 4. 6种算法在11种属性序列上的跟踪精度图。(a)低分辨率精度图;(b)出视野精度图;(c)运动模糊精度图;(d)背景嘈杂精度图;(e)光照变化精度图;(f)快速运动精度图;(g)形变精度图;(h)遮挡精度图;(i)平面内旋转精度图;(j)平面外旋转精度图;(k)尺度变化精度图

Fig. 4. Tracking precision scores of six algorithms on eleven attribute sequences. (a) Precision plots of low resolution; (b) precision plots of out-of-view; (c) precision plots of motion blur; (d) precision plots of background clutter; (e) precision plots of illumination variation; (f) precision plots of fast motion; (g) precision plots of deformation; (h) precision plots of occlusion; (i) precision plots of in-plane rotation; (j) precision plots of out-plane rotation; (k) precision plots of scale vari

图 5. 6种算法在11种属性序列上的跟踪成功率得分。(a)低分辨率成功率得分;(b)出视野成功率得分;(c)运动模糊成功率得分;(d)背景嘈杂成功率得分;(e)光照变化成功率得分;(f)快速运动成功率得分;(g)形变成功率得分;(h)遮挡成功率得分;(i)平面内旋转成功率得分;(j)平面外旋转成功率得分;(k)尺度变化成功率得分

Fig. 5. Tracking success rate scores of six algorithms on eleven attribute sequences. (a) Success rate scores of low resolution; (b) success rate scores of out-of-view; (c) success rate scores of motion blur; (d) success rate scores of background clutter; (e) success rate scores of illumination variation; (f) success rate scores of fast motion; (g) success rate scores of deformation; (h) success rate scores of occlusion; (i) success rate scores of in-plane rotation; (j) success rate scores of out-of-pla

图 6. 6种跟踪算法在目标被遮挡、目标发生平面外旋转和背景嘈杂三种情况下跟踪结果

Fig. 6. Tracking results of six algorithms in three cases as occlusion of target, off-plane rotation of target, and background ambiguity

从OTB-2015的11种属性视频序列的实验结果可以推测,TBACF算法采用真实的背景样本和目标样本对滤波器进行训练,故其分类性能更高。在目标被遮挡时,在TBACF算法中引入时间正则,利用相邻滤波器的时间信息,解决了目标被遮挡时的重定位问题,故TBACF算法具有更高的跟踪精度。采用线性插值策略来应对目标的响应位置和尺度变换,提高了TBACF算法的稳健性。

4.4 定性分析

4.5 数据分析

为了直观表现TBACF算法的性能,

从

表 1. 6种算法在OTB-2015数据集上的测试结果

Table 1. Testing results of six algorithms on OTB-2015 dataset

|

5 结论

相关滤波器的目标背景因未根据时间建模而导致其性能无法达到最优。为解决该问题,提出基于时间正则化及背景感知的相关滤波器跟踪算法。该算法利用真实的背景样本和目标样本学习跟踪器来提高跟踪精确度,结合时间正则来应对目标遮挡问题,利用在线自适应策略来更新跟踪器模型,旨在解决目标遮挡和背景嘈杂的问题。在OTB-2015数据集上进行实验,实验结果表明TBACF算法的精确度得分和成功率得分为别为0.801和0.762,在6种算法中排名第一。相比于KCF算法,TBACF算法的精确度得分和成功率得分分别提高了20%和46.8%;相比排名第二的BACF算法,TBACF算法的精确度得分和成功率得分分别提升了0.4%和2.1%。TBACF算法能有效地解决目标被遮挡、目标发生平面外旋转和背景嘈杂情况下的目标跟踪任务。

[1] Wu Y, Lim J, Yang M H. Object tracking benchmark[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1834-1848.

[2] DanelljanM, HägerG, Khan FS, et al. Learning spatially regularized correlation filters for visual tracking[C]∥2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 4310- 4318.

[3] 董秋杰, 何雪东, 葛海燕, 等. 基于概率模型的自适应融合互补学习跟踪算法[J]. 激光与光电子学进展, 2019, 56(16): 161505.

[4] 何雪东, 周盛宗. 快速尺度自适应核相关滤波目标跟踪算法[J]. 激光与光电子学进展, 2018, 55(12): 121501.

[5] BolmeD, Beveridge JR, Draper BA, et al. Visual object tracking using adaptive correlation filters[C]∥2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition, June 13-18, 2010, San Francisco, CA, USA. New York: IEEE, 2010: 2544- 2550.

[6] 张宇阳. 基于相似背景与HSV空间颜色直方图的目标跟踪[J]. 电光与控制, 2019, 26(4): 100-105.

[7] MaC, Huang JB, Yang XK, et al. Hierarchical convolutional features for visual tracking[C]∥2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 3074- 3082.

[8] DanelljanM, RobinsonA, Khan FS, et al. Beyond correlation filters: learning continuous convolution operators for visual tracking[M] ∥Leibe B, Matas J, Sebe N, et al. Computer vision-ECCV 2016. Lecture notes in computer science. Cham: Springer, 2016, 9909: 472- 488.

[9] DalalN, TriggsB. Histograms of oriented gradients for human detection[C]∥2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition (CVPR'05), June 20-25, 2005, San Diego, CA, USA. New York: IEEE, 2005: 8588935.

[10] DanelljanM, HagerG, Khan FS, et al. Convolutional features for correlation filter based visual tracking[C]∥2015 IEEE International Conference on Computer Vision Workshop (ICCVW), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 621- 629.

[11] BertinettoL, ValmadreJ, Henriques JF, et al. Fully-convolutional Siamese networks for object tracking[M] ∥Hua G, Jégou H. Computer vision-ECCV 2016 Workshops. Lecture notes in computer science. Cham: Springer, 2016, 9914: 850- 865.

[12] PosseggerH, MauthnerT, BischofH. In defense of color-based model-free tracking[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 7-12, 2015, Boston, MA, USA. New York: IEEE, 2015: 2113- 2120.

[13] 毛宁, 杨德东, 李勇, 等. 基于形变多样相似性的空间正则化相关滤波跟踪[J]. 光学学报, 2019, 39(4): 0415002.

[14] 杨德东, 毛宁, 杨福才, 等. 利用最佳伙伴相似性的改进空间正则化判别相关滤波目标跟踪[J]. 光学精密工程, 2018, 26(2): 492-502.

[15] LiF, TianC, Zuo WM, et al. Learning spatial-temporal regularized correlation filters for visual tracking[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE, 2018: 4904- 4913.

[16] Galoogahi HK, SimT, LuceyS. Multi-channel correlation filters[C]∥2013 IEEE International Conference on Computer Vision, December 1-8, 2013, Sydney, NSW, Australia. New York: IEEE, 2013: 3072- 3079.

[17] 张汇, 杜煜, 宁淑荣, 等. 基于Faster RCNN的行人检测方法[J]. 传感器与微系统, 2019, 38(2): 147-149, 153.

[20] Henriques J F, Caseiro R, Martins P, et al. High-speed tracking with kernelized correlation filters[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(3): 583-596.

[21] BertinettoL, ValmadreJ, GolodetzS, et al. Staple: complementary learners for real-time tracking[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 1401- 1409.

[22] DanelljanM, HägerG, Khan FS, et al.Accurate scale estimation for robust visual tracking[M] ∥Valstar M, French A, Pridmore T. Proceedings of the British machine vision conference. UK: BMVA Press, 2014.

[23] Galoogahi HK, FaggA, LuceyS. Learning background-aware correlation filters for visual tracking[C]∥2017 IEEE International Conference on Computer Vision (ICCV), October 22-29, 2017, Venice, Italy. New York: IEEE, 2017: 1144- 1152.

Article Outline

刘明明, 裴东, 刘举, 祝东辉, 孙浩翔. 基于时间正则化及背景感知的滤波器跟踪[J]. 激光与光电子学进展, 2019, 56(23): 231503. Mingming Liu, Dong Pei, Jü Liu, Donghui Zhu, Haoxiang Sun. Filter Tracking Based on Time Regularization and Background-Aware[J]. Laser & Optoelectronics Progress, 2019, 56(23): 231503.