目标跟踪中基于光流映射的模板更新算法  下载: 891次

下载: 891次

1 引言

基于视频图像的计算机视觉在当今社会中的地位越来越高,目标跟踪作为其中一个非常重要的研究方向,近年来受到了国内外研究者的广泛关注,也取得了一系列令人瞩目的研究成果,目前已广泛应用于视频监控、自动驾驶及人机交互等领域[1]。简要来讲,目标跟踪的基本任务是:在视频的第一帧中人为给定初始目标后,在后续帧中逐帧计算目标的位置和尺寸大小。由于任务场景的复杂性和多样性,目标跟踪算法仍然面临很多具有挑战性的问题,如背景杂乱、有相似干扰物、遮挡、形变、目标平面内和外旋转等[2]。虽然目标跟踪技术种类繁多且发展迅猛,但至今仍然没有一个通用的跟踪算法能够完全解决这些挑战性问题。

目标跟踪算法按照跟踪方法主要分为两类,分别是相关滤波类目标跟踪算法和深度学习类目标跟踪算法。其中,相关滤波类目标跟踪算法的核心思想是通过使用手工标注或深层网络提取出目标特征来训练滤波器,计算目标模板与输入图像的相关性,依靠相关图判断目标位置和大小。在这类算法中,一些工作会通过强化滤波器的训练过程、优化滤波器模板的求解方法来使其具有良好的二分类性能,主要包括:Danelljan等[3]提出的C-COT跟踪算法,该算法利用多尺度特征训练滤波器,获得亚像素精度的目标位置;Danelljan等[4]提出的ECO跟踪算法,该算法在C-COT[3]的基础上进一步提升了时间效率和空间效率,调整了模型大小、训练集大小及更新机制;孟琭等[5]提出的双特征模型核相关滤波目标跟踪算法,该算法采用深度特征和手工特征联合的方式进行训练,提升了滤波器性能;Danelljan等[6]提出的SRDCF跟踪算法,该算法利用Gauss-Seidel函数求解滤波器,同时加入空间正则项来解决边界效应;王殿伟等[7]提出的基于多特征融合的核相关滤波目标跟踪算法,该算法通过融合梯度方向梯度直方图(HOG)特征和颜色特征来进行多特征训练及计算;Danelljan等[8]提出的SRDCFdecon跟踪算法,该算法在SRDCF[6]的基础上增强训练样本质量,动态管理训练集,提升了滤波器的训练质量;Galoogahi等[9]提出的BACF跟踪算法,该算法通过利用多通道特征来求解滤波器最小化岭回归问题,进而求解滤波器模板。而另一些工作则通过多特征融合、多尺度计算、改进滤波器模板更新机制等方法来增强滤波器模板的适应能力,以应对跟踪任务中出现的挑战性问题,主要包括:王凯宇等[10]提出的基于相关滤波器的目标抗遮挡算法,该算法通过保留原目标模板和优化小范围预测,缓解了滤波器对于目标被遮挡时性能下降的问题;杨亚光等[11]提出的基于相关滤波融合卷积残差学习的目标跟踪算法,该算法融合卷积残差学习,将相关滤波器构建为神经网络中的一层进行端到端的训练和跟踪,缓解了复杂场景下传统单一手工特征表达能力的不足;成悦等[12]提出的基于模型与尺度更新的相关滤波跟踪算法,该算法通过定性分析改变了在线更新机制,同时采用了快捷的尺度更新方法;虞跃洋等[13]提出的基于前景感知的时空相关滤波跟踪算法,该算法通过增加具有时空正则化功能的滤波器和重新定义目标重检测器的激活机制,增强了滤波算法的适应能力;李健鹏等[14]提出的融合多层卷积特征的相关滤波运动目标跟踪算法,该算法通过丰富特征信息、融合多特征来估计目标的位置和最佳尺度。

虽然上述方法改进了相关滤波类算法,缓解了目标跟踪中的一些问题,但受相关滤波方法本身的局限,在应对挑战性问题时,该类方法的综合性能仍然低于深度学习类方法。深度学习类目标跟踪算法主要分为基于目标检测的跟踪算法和基于孪生网络的跟踪算法。其中,基于目标检测的跟踪算法主要利用多次采样分类正负样本,将跟踪问题转换为前景和背景的二分类问题,主要算法包括:Wang等[15]提出的LMCF跟踪算法,该算法利用结构化支持向量机(SVM)分类器分类候选框;Danelljan等[16]提出的ATOM算法,该算法经过IoU-Net多次迭代求解目标位置。这类算法精度较高,但速度较慢,难以满足实时性要求。基于孪生网络的目标跟踪算法主要采用匹配初始化帧目标模板特征和搜索区域特征的方法,将初始化目标模板当作特征分类器的分类前景和背景,该类算法主要包括:Bertinetto等[17]提出的Siam-FC跟踪算法,该算法通过目标模板特征和搜索区域特征的匹配及多尺度搜索机制确定目标位置和大小;任珈民等[18]提出的一种改进的基于孪生卷积神经网络的目标跟踪算法,该算法通过构建特征通道之间的相互关系来增强特征表达能力;Li等[19]提出的SiameseRPN++跟踪算法,该算法利用多层级联的区域候选网络来提高跟踪精度;周迪雅等[20]提出的基于孪生网络与注意力机制的目标跟踪方法,该方法通过利用注意力机制来增强网络对目标前景的提取和搜索能力,实现跟踪器性能的提升。这类算法较好地平衡了跟踪算法的速度和精度,既满足实时性要求,又有较好的精度和鲁棒性。但是,这类算法通常缺乏在线更新机制,在一些目标物体运动变化快或被遮挡的场景中,跟踪结果会发生较为明显的偏移。受相关滤波类方法在线更新滤波器模板的启发,本文在孪生网络框架中增加基于光流映射的模板更新机制,既保证了算法的速度和精度,又增强了算法对困难场景的适应能力。

本文提出一种基于孪生网络结构且包含目标模板在线更新的跟踪算法,通过光流映射和逐帧更新目标模板实现对算法性能的提升。利用目标跟踪任务中视频序列和目标空间变化的连续性,通过视频序列两帧之间的光流信息指导生成包含目标变化的新模板;对深层神经网络进行特征提取,有关目标变化的信息也在网络中完成了特征编码;当搜索区域出现遮挡或目标变化较大等情况时,跟踪器能通过目标变化信息的特征及时捕捉目标运动、适应目标运动变化;此外,还利用初始化帧目标模板生成修正项,修正光流映射产生的位置偏差,抑制跟踪过程中的误差累积。

2 基本原理

2.1 基于光流映射的目标运动表示

当视频序列中的某一物体进行空间运动时,视频序列中每一帧每个像素点的瞬时速度都可以用光流表示,且由于视频序列中相邻两帧之间具有连续性,目标物体运动变化位置上对应的光流变化可以较为准确地描述该物体的运动变化。在目标跟踪任务中,由于视频序列前后帧中的光照强度变化幅度小,目标的运动变化通常在时域和空间域上都具有较强的连贯性,因此视频序列基本满足运用光流计算物体运动变化的前提条件,同时,目标跟踪算法也可将光流信息作指导,以获取目标的运动变化信息。

FlowNetC[21]是一种基于卷积神经网络(CNN)预测视频序列某两帧或某两幅图像之间光流的网络框架,近年来一直被广泛应用于提取视频序列相邻两帧之间的光流信息中。在堆叠前后两帧图像后,该网络首先通过CNN计算前后两帧图像的特征,再通过互相关层计算前后两帧图像特征之间的关系,最后通过解码层计算前后两帧图像之间的光流。本文利用FlowNet[21]中的FlowNetC模块,计算目标从起始位置运动到当前位置时目标模板之间的光流,再通过基于双线性插值的映射函数和此光流信息将目标当前帧模板映射到目标初始化帧模板,该模板即为由光流信息指导的目标初始化帧模板,表达式为

式中:

式中:

2.2 基于奇异值分解(SVD)的修正项计算

在跟踪过程中,跟踪结果会随着跟踪过程中的误差积累而发生不同程度的偏移,这些偏移将使光流信息产生偏差,进而导致由光流信息指导生成的目标运动变化信息产生偏差,且由于跟踪算法本身对跟踪结果没有判断能力,这些偏差会逐渐累积并表现为目标位置上的偏差。为缓解上述问题,提出一种基于奇异值分解生成修正项的方法来修正所述目标位置偏差,通过重构初始化帧目标模板及线性叠加其与目标运动变化信息,实现对位置偏差的修正,抑制位置偏差带来的误差累积。首先对目标初始化帧模板进行奇异值分解:

式中:

式中:

式中:

2.3 目标跟踪算法中的模板更新策略

采用SiameseRPN++[19]作为目标跟踪的基础网络框架。与实现该网络框架的目标跟踪方法不同,所提算法在目标模板分支处增加了在线更新机制,根据从初始帧到前一帧目标模板的变化,逐帧更新后一帧的目标模板,表达式为

式中:

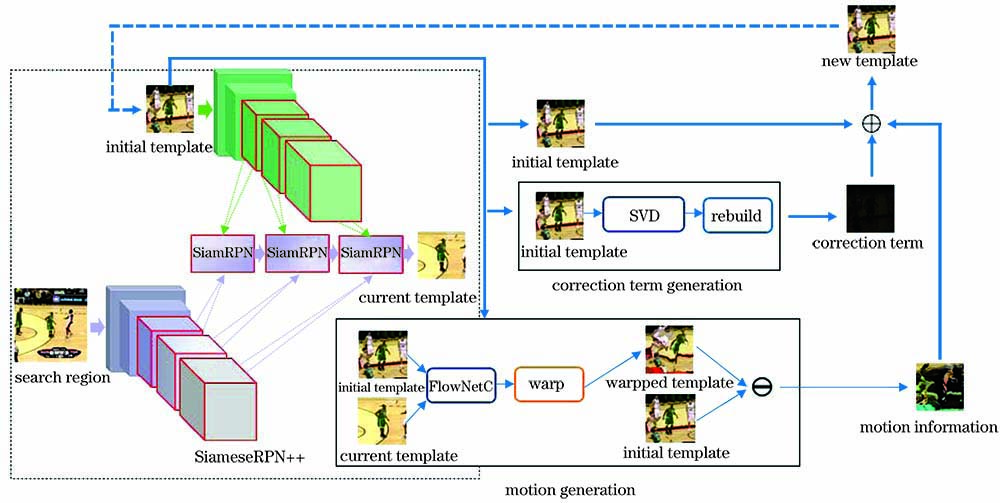

所提跟踪算法的框架如

所提算法运行过程如下:首先经初始化获取初始化帧目标模板及第二帧搜索区域的中心位置和尺寸大小;再将目标模板和搜索区域同时输入到SiameseRPN++网络[19],获取第二帧的跟踪模板及第三帧搜索区域的中心位置和大小,经过(1)、(2)式生成由光流信息指导的目标变化信息;再经过(3)~(5)式生成基于初始化帧目标模板的修正项,最后经过(6)式生成第三帧所需的新目标模板;重复上述步骤,逐帧实现目标模板在线更新。

3 实验分析

3.1 实验设置

所提算法采用的网络框架基于Python、Pytorch[23]实现,并使用CPU Intel(R) Core(TM) i7-7800X和GPU GeForce GTX 2080Ti在计算机上实验。采用SiameseRPN++[19]作为基础跟踪网络框架,通过光流映射和残差计算获取目标的运动变化信息,

3.2 数据集和衡量指标

在标准数据集OTB100、VOT2016上分别进行实验。其中OTB100数据集包含有100个不同的视频序列,其中25个为灰度序列。该数据集中每个视频序列都有特定的标签,包含目标跟踪任务中的各种挑战,例如遮挡、尺度变化、形变及光照变化等。对OTB100数据集,采用的评价指标为一次通过评估(OPE)。VOT2016数据集中包含60个不同的视频序列,均为彩色序列。对VOT2016数据集,采用的评价指标为准确率(Accuracy)、鲁棒性(Robustness)、期望平均重叠率(EAO)。

在OTB100数据集上测试算法时,由OPE计算精确率图和成功率图。前者通过计算目标预测位置的中心点和真实值之间的距离,计算距离小于设定阈值的帧数占序列总帧数的比例,不同的阈值设定得到的结果不同。后者通过计算目标回归框的预测值和真实值之间的交并比(IoU)并得到重合率得分(overlap score),计算得分大于设定阈值的帧数占序列总帧数的比例,不同的阈值设定得到的结果也不同。在VOT2016数据集上,测试指标中的准确率用于计算视频序列中目标回归框的预测值和真实值之间的平均IoU,准确率值越大,表明算法的预测结果越接近真实值;鲁棒性值根据在某一序列上跟踪失败(即IoU为0)的总帧数来评估算法稳定性,鲁棒性值越小,表明算法越稳定;EAO值用于衡量算法在不同特定总帧数的短时视频序列片段上非重置重叠率的平均期望值,由于EAO值的计算过程综合评估了准确率和鲁棒性两个指标,因此通常把EAO值作为衡量跟踪算法综合性能的重要指标,EAO值越大,表明跟踪算法的综合性能越好。

3.3 消融实验

为了证明基于光流映射的目标模板在线更新策略和基于奇异值分解的修正项生成方法对目标模板适应目标运动变化有效,在OTB100、VOT2016数据集上分别设计了消融实验。在OTB100数据集上测试的消融实验结果如

图 2. 在OTB100数据集上的消融实验结果。(a)成功率;(b)精确率

Fig. 2. Results of ablation experiments on OTB100 dataset. (a) Success rate; (b) precision

在VOT2016数据集上的测试结果如

表 1. 在VOT2016数据集上的消融实验结果

Table 1. Results of ablation experiments on VOT2016 dataset

|

从

此外,为了直观说明基于光流映射的在线更新策略和基于奇异值分解的修正项有效,分别在3个具有挑战性的序列上进行主观结果的比较,并计算在该序列上的平均精度。

图 3. Coke序列中消融实验的主、客观(平均精度)结果

Fig. 3. Subjective and objective (average precision) results of ablation experiments in Coke sequence

图 4. Dudek序列中消融实验的主、客观(平均精度)结果

Fig. 4. Subjective and objective (average precision) results of ablation experiments in Dudek sequence

图 5. Doll序列中消融实验的主、客观(平均精度)结果

Fig. 5. Subjective and objective (average precision) results of ablation experiments in Doll sequence

综上所述,所提目标模板在线更新策略在OTB100和VOT2016数据集上都具有良好的表现。实验表明,这种在线更新方法为目标模板富集了可靠的目标运动变化信息,能够使目标模板具有一定适应目标变化的能力,从而在跟踪过程中适应后续帧中目标的形态和动作变化。由于跟踪过程本身存在误差累积效应,目标的运动变化信息会随着跟踪过程的跟进而出现偏移、尺度信息失真等情况。所提基于初始化帧目标模板生成的修正项可以在一定程度上抑制这些误差带来的负面影响,降低跟踪失败的概率,提升跟踪算法的稳定性。因此,所提算法可以很好地弥补基础网络框架中目标模板单一、适应能力差的缺陷,从而改善了跟踪算法的适应能力,提高了跟踪算法的综合性能。

3.4 对比实验

在OTB100数据集上对所提算法和9个现有算法进行比较,这些算法不仅包括目前性能较好的相关滤波类算法Staple[24]、BACF[14]、LMCF[15]、SRDCF[10]、SRDCFdecon[12]及ECO-HC[8],还包括使用深层特征提取网络的孪生网络类算法Memtrack[22]、SiamFCRes22[25]及SiamRPNRes22[25]。使用OPE计算精确率图和成功率图来衡量算法性能。各算法整体性能如

图 6. 在OTB100数据集上不同算法的实验结果。(a)成功率;(b)精确率

Fig. 6. Experimental results of different algorithms on OTB100 dataset. (a) Success rate; (b) precision

由于增加了目标模板在线更新策略,所提算法能够更好地应对跟踪中目标遮挡、快速变化等挑战性问题,

图 7. 在OTB100数据集上不同算法在目标出现快速运动时的对比结果。(a)成功率;(b)精确率

Fig. 7. Comparison results of different algorithms when target moves rapidly on OTB100 dataset. (a) Success rate; (b) precision

在VOT2016数据集上对所提算法和9个现有算法进行比较,分别是相关滤波类算法SRDCF[10]、C-COT[4]及ECO-HC[8],深度学习类算法Siam-FC[17]、SiamFCRes22[25]、SiamRPNRes22[25]、TADT[26]、C-RPN[27]及SP

表 2. 在VOT2016数据集上不同算法的实验结果

Table 2. Experimental results of different algorithms on VOT2016 dataset

|

综合对比情况可得,所提算法依靠计算目标的形态变化和位置修正实现目标模板在线更新,提升了跟踪算法在目标出现被遮挡、形变、快速变化等情况时的稳定性和准确性,降低了跟踪结果的误差。

图 8. Coke序列中各算法的主、客观(平均精度)结果

Fig. 8. Subjective and objective (average precision) results of each algorithm in Coke sequence

在Dudek序列上各算法的结果如

图 9. Dudek序列中各算法的主、客观(平均精度)结果

Fig. 9. Subjective and objective (average precision) results of each algorithm in Dudek sequence

各算法在Doll序列上的结果如

图 10. Doll序列中各算法的主、客观(平均精度)结果

Fig. 10. Subjective and objective (average precision) results of each algorithm in Doll sequence

4 结论

基于深度孪生网络的目标跟踪框架,提出一种运用光流映射实现模板在线更新策略的目标跟踪算法。该算法通过计算模板间的残差来表示目标变化信息,在目标模板上富集目标运动变化信息,增强目标模板的适应能力。除此之外,还利用基于奇异值分解的方法计算针对目标运动位置偏移的修正项,提高跟踪算法对目标运动变化的适应能力,增强跟踪算法的稳定性和准确性。分别在OTB100数据集和VOT2016数据集上进行测试,与现有算法相比,所提算法取得了更好的结果。

[1] 陈云芳, 吴懿, 张伟. 基于孪生网络结构的目标跟踪算法综述[J]. 计算机工程与应用, 2020, 56(6): 10-18.

[2] Yilmaz A, Javed O, Shah M. Object tracking: a survey[J]. ACM Computing Surveys, 2006, 38(4): 13-58.

[3] DanelljanM, RobinsonA, Shahbaz KhanF, et al. Beyond correlation filters: learning continuous convolution operators for visual tracking[M] //Leibe B, Matas J, Sebe N, et al. Computer vision—ECCV 2016. Lecture notes in computer science. Cham: Springer, 2016, 9909: 472- 488.

[4] DanelljanM, BhatG, Khan FS, et al. ECO: efficient convolution operators for tracking[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 6931- 6939.

[5] 孟琭, 李诚新. 双特征模型核相关滤波目标跟踪算法[J]. 中国图象图形学报, 2019( 12): 2183- 2199.

MengL, Li CX. Kernel correlation filtering algorithm based on a dual-feature model[J]. Journal of Image and Graphics, 2019( 12): 2183- 2199.

[6] DanelljanM, HägerG, Khan FS, et al. Learning spatially regularized correlation filters for visual tracking[C]//2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 4310- 4318.

[7] 王殿伟, 许春香, 刘颖. 基于多特征融合的核相关滤波目标跟踪算法[J]. 计算机工程与设计, 2019, 40(12): 3463-3468.

[8] DanelljanM, HägerG, Khan FS, et al. Adaptive decontamination of the training set: a unified formulation for discriminative visual tracking[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 1430- 1438.

[9] Galoogahi HK, FaggA, LuceyS. Learning background-aware correlation filters for visual tracking[C]//2017 IEEE International Conference on Computer Vision (ICCV), October 22-29, 2017, Venice, Italy. New York: IEEE, 2017: 1144- 1152.

[10] 王凯宇, 陈志国, 傅毅. 基于相关滤波器的目标抗遮挡算法[J]. 激光与光电子学进展, 2019, 56(3): 030401.

[11] 杨亚光, 尚振宏. 相关滤波融合卷积残差学习的目标跟踪算法[J]. 激光与光电子学进展, 2020, 57(12): 121012.

[12] 成悦, 李建增, 褚丽娜, 等. 基于模型与尺度更新的相关滤波跟踪算法[J]. 激光与光电子学进展, 2018, 55(12): 121015.

[13] 虞跃洋, 史泽林, 刘云鹏. 基于前景感知的时空相关滤波跟踪算法[J]. 激光与光电子学进展, 2019, 56(22): 221503.

[14] 李健鹏, 尚振宏, 刘辉. 融合多层卷积特征的相关滤波运动目标跟踪算法[J]. 计算机科学, 2019, 46(7): 252-257.

Li J P, Shang Z H, Liu H. Visual object tracking algorithm based on correlation filters with hierarchical convolutional features[J]. Computer Science, 2019, 46(7): 252-257.

[15] Wang MM, LiuY, Huang ZY. Large margin object tracking with circulant feature maps[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 4800- 4808.

[16] DanelljanM, BhatG, Khan FS, et al. ATOM: accurate tracking by overlap maximization[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), June 15-20, 2019, Long Beach, CA, USA. New York: IEEE, 2019: 4655- 4664.

[17] BertinettoL, ValmadreJ, Henriques JF, et al. Fully-convolutional siamese networks for object tracking[M] //Hua G, Jégou H. Computer vision-ECCV 2016 workshops. Lecture notes in computer science. Cham: Springer, 2016, 9914: 850- 865.

[18] 任珈民, 宫宁生, 韩镇阳. 一种改进的基于孪生卷积神经网络的目标跟踪算法[J]. 小型微型计算机系统, 2019, 40(12): 2686-2690.

Ren J M, Gong N S, Han Z Y. Improved target tracking algorithm based on siamese convolution neural network[J]. Journal of Chinese Computer Systems, 2019, 40(12): 2686-2690.

[19] LiB, WuW, WangQ, et al. SiamRPN++: evolution of Siamese visual tracking with very deep networks[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), June 15-20, 2019, Long Beach, CA, USA. New York: IEEE, 2019: 4277- 4286.

[20] 周迪雅, 段喜萍. 基于孪生网络与注意力机制的目标跟踪方法[J]. 信息通信, 2019( 12): 61- 63.

Zhou DY, Duan XP. Target tracking method based on siamese network and attention mechanism[J]. Information & Communications, 2019( 12): 61- 63.

[21] IlgE, MayerN, SaikiaT, et al. FlowNet 2.0: evolution of optical flow estimation with deep networks[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 1647- 1655.

[22] YangT, Chan AB. Learning dynamic memory networks for object tracking[M] //Ferrari V, Hebert M, Sminchisescu C, et al. Computer vision—ECCV 2018. Lecture notes in computer science. Cham: Springer, 2018, 11213: 153- 169.

[24] BertinettoL, ValmadreJ, GolodetzS, et al. Staple: complementary learners for real-time tracking[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 1401- 1409.

[25] Zhang ZP, Peng HW. Deeper and wider Siamese networks for real-time visual tracking[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), June 15-20, 2019, Long Beach, CA, USA. New York: IEEE, 2019: 4586- 4595.

[26] LiX, MaC, Wu BY, et al. Target-aware deep tracking[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), June 15-20, 2019, Long Beach, CA, USA. New York: IEEE, 2019: 1369- 1378.

[27] FanH, Ling HB. Siamese cascaded region proposal networks for real-time visual tracking[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), June 15-20, 2019, Long Beach, CA, USA. New York: IEEE, 2019: 7944- 7953.

[28] Wang GT, LuoC, Xiong ZW, et al. SPM-tracker: series-parallel matching for real-time visual object tracking[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), June 15-20, 2019, Long Beach, CA, USA. New York: IEEE, 2019: 3638- 3647.

Article Outline

张静, 郝志晖, 刘婧. 目标跟踪中基于光流映射的模板更新算法[J]. 激光与光电子学进展, 2020, 57(22): 221507. Jing Zhang, Zhihui Hao, Jing Liu. Template-Updating Algorithm Based on Optical Flow Mapping in Object Tracking[J]. Laser & Optoelectronics Progress, 2020, 57(22): 221507.