基于二次生成对抗的人体姿态估计  下载: 889次

下载: 889次

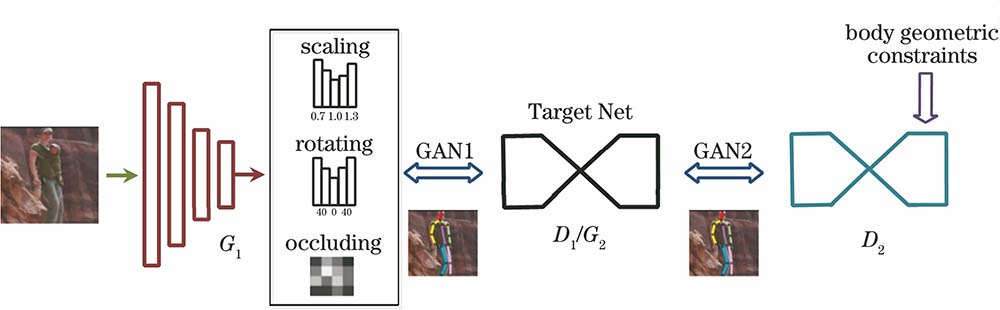

ing at the problem of inaccurate estimation results caused by the complexity of limbs and environment in human pose estimation, a human pose estimation method based on secondary generation adversary is proposed in this work. The stacked hourglass network (SHN) is trained for generation adversary through two stages. First, the SHN is used as a discriminator in the first generation adversarial network model, and the on-line adversarial data is used to strengthen training to improve the estimation performance of the SHN. Then, the SHN acts as a generator in the second generation adversarial network model, and the limb geometric constraints are used as the discriminator. The estimation performance of the SHN is improved again through the second adversarial training, and the final SHN is obtained. The proposed method is tested on the public data sets LSP and MPII, and the results show that it can effectively improve the estimation accuracy of the SHN.

1 引言

对图像进行识别并估计出其中的二维(2D)人体姿态,是机器视觉研究领域的基础性工作。如人体跟踪、动作认知、人机交互应用以及三维(3D)人体姿态研究中,都需要精确地估计人体姿态。由于图像中肢体的复杂性、摄像机角度等客观原因,导致图像中的人体存在不同程度的扭曲和遮挡,使姿态估计变成一项极具挑战性的任务。对于机器视觉而言,标准的深度神经网络(DNN)观察并学习肢体结构需要进行大量训练,在面对复杂的人体姿态时,估计精度不高,是人体姿态估计中的难点。

Andriluka等[1-2]通过图像结构模型或随机部件推理模型进行姿态估计,但均采用人工提取特征的方式,缺乏有效的功能表征,不能充分利用图像信息,受制于图像的视角、外观及几何模糊性。DNN具有自主提取特征以及理解上下文特征关联的能力,使基于DNN的姿态估计得到了深入研究。Toshev等[3]提出的DeepPose方法将DNN应用到人体姿态估计中,采用多阶段回归思路设计卷积神经网络(CNN),直接回归人体骨骼关节点的二维坐标,但该方法缺乏关节间的结构信息,对于多尺度的姿态估计泛化性能较差。Newell[4]提出的堆叠沙漏网络(SHN)通过级联沙漏网络结构和中继监督训练,以热图(heatmap)检测的方式,学习人体关节点的图像特征及关节点间的结构信息,推理出整个图像的检测结果。但当人体图像的肢体存在重叠或遮挡时,SHN对人体的姿态估计不合理。

Luo等[5]提出了生成对抗网络(GAN),通过生成器和判别器之间的对抗训练得到想要的模型。刘坤等[6]使用半监督GAN实现X光图像的分类;杨晓莉等[7]使用GAN在动态平衡中实现图像融合;张清博等[8]基于改进的GAN改善了水下激光图像的去噪和照明。Wang等[9]提出的快速卷积网络(A-Fast-RCNN)使用GAN生成变形输入以达到数据增强的目的,从而进行鲁棒性更强的目标检测。Peng等[10]将姿态估计网络作为判别器,并新建一个神经网络作为生成器,引入奖励、惩罚机制,与姿态估计网络进行对抗训练,实现了在线数据增强,提升了姿态估计网络的泛化能力和精确度;Chou等[11]将SHN作为生成器进行姿态估计,并新建一个神经网络作为判别器,生成器和判别器进行对抗训练,提高了SHN的姿态估计性能;Chen等[12]建立了两个神经网络作为判别器,分别对多任务生成器得到的姿态关节heatmap置信度和关节点定位偏差进行判别并反馈给生成器,达到对抗训练的目的。

本文以SHN为姿态估计网络(Target Net),融合了两种基于GAN的姿态估计模型,并添加了肢体几何约束,将姿态估计网络经过两次生成对抗训练,以提升SHN的姿态估计精确度。

2 模型分析

本方法的结构如

2.1 堆叠沙漏模型

模型中的目标优化网络:SHN[4]通过串联多个沙漏(hourglass)网络估计人体姿态,用多阶段分辨率heatmap学习姿态关节点的坐标,对图像中每个像素对应的概率值进行估算,像素点位置越靠近关节点,其对应的概率值就越接近1,反之则越接近0;将训练后heatmap形式的feature map结果映射到原图像,得到对应关节点的坐标,从而估计人体姿态,如

SHN结构前后对称,形似沙漏,如

将多个沙漏网络级联,每个沙漏网络作为一个姿态估计阶段,在每个阶段建立残差连接,避免网络退化。其输出的混合特征经过一个1×1全卷积网络分支输出混合特征和heatmap,两者合并后传输到下一个阶段,实现多阶段姿态估计,从而得到SHN,如

SHN通过级联结构的沙漏网络和多阶段中间监督对整个图像的初始特征和检测结果进行评估,通过隐式学习关节点特征之间的结构关系,在最后一个沙漏网络输出最终的姿态估计结果。每个沙漏网络输出的估计结果包含M个关节点,可采用均方误差损失LMSE对预测的heatmap(

式中,j为第j个关节点。SHN根据姿态估计得到所有输出heatmap的LMSE损失添加中间监督,从而在多个阶段调整姿态的预测精确度,如

2.2 生成对抗模型

GAN由Luo等[5]提出,可同时训练生成器(G)和判别器(D)两个网络模型。G接收随机噪声z生成数据分布G(z),D用于评估并判别输入的数据分布,如数据x来自真实的数据分布

式中,E为期望,pdata(

2.2.1 生成对抗模型1

实验中第一个生成对抗模型GAN1采用在线数据增强对抗网络,以SHN作为判别器D1,从生成器G1生成的增强数据中采样,在有限数据集下提升其姿态估计性能。G1使用SHN分支结构上的桥特征作为D1的输入,生成使D1损失增加的hard数据,优化函数可表示为

式中,

G1网络有两种对抗增强训练方式:对抗缩放及旋转(ASR)和对抗多特征图遮挡(AHO)。在ASR增强中,选取m种缩放尺度和n种旋转尺度,将一个batch图像输入G1。计算m×n种增强方式的均方误差损失,并对损失进行归一化处理,生成缩放和旋转分别对应的两个归一化分布Ps和Pr作为ground truth;同时,G1会预测出

训练结果通过m和n种高斯分布进行采样后生成增强样本,如

在AHO增强中,G1以D1的上分支结构特征作为输入,在最低像素(尺寸为4 pixel×4 pixel)的特征图下生成遮挡,将图像分为w×h个网格(w=h=4),在像素增大过程中,统计一个batch图像中每个关键点落在遮挡部分的概率,得到最大概率。以一系列最大概率生成的遮挡概率分布特征

对G1、D1两个网络进行联合对抗训练时,为了将D1的训练状态反向传播到G1,同时避免GAN训练时由标签缺失、无法收敛等原因导致的训练崩溃问题,引入了奖励、惩罚机制。计算由对抗增强τa和随机增强τr造成的D1损失,若L{D[τa(x),y]}-L{D[τr(x),y]}增大,证明对抗增强有效。增大该采样的概率作为奖励,同时减少对其他采样的概率,可表示为

式中,P为由采样获得的ground truth分布,

表 1. 批次图像训练流程

Table 1. Training process of batch images

|

2.2.2 生成对抗模型2

实验中的第二个生成对抗模型GAN2采用对称堆叠沙漏生成对抗网络,以第一次训练得到的SHN作为生成器G2,以另一个SHN作为判别器D2,第二次对抗训练以目标网络G2作为姿态估计网络。生成器G2的目标是从RGB(Red, Green, Blue)图像中学习并生成关节点heatmap热图的映射。引入判别器D2后,将G2生成的heatmap与带有正确标签的heatmap之间的误差反向传播到G2,使G2在学习图像中人体特征及上下文依赖关系的同时,能生成更合理的人体姿态。

表 2. 单图像训练流程

Table 2. Training process of single image

|

对于G2,采用LMSE对堆叠的沙漏网络进行中间监督,并定义对抗损失函数进行训练。假设G2包含N个堆叠的沙漏网络,将原始沙漏网络输出的混合特征heatmap从多维矩阵中提取出来,输出M个单关节点heatmap,每个heatmap都在第l个ground truth的关节点定位下达到高斯峰值,其LMSE可表示为

式中,Ckl为第k个沙漏网络第l个关节点定位的正确标记heatmap,

式中,

式中,λG为对抗损失权重控制的超参数。以G2预测的heatmap和带有正确标签的heatmap作为D2的输入,然后重建对应的两组heatmap,如

式中,kt为权衡参数,t为第t次迭代训练,LD为D2的损失函数,D2通过LD计算输入heatmap和重建heatmap的像素,从而对D2进行优化。

为了使G2网络在第二次GAN训练中生成更合理的姿态估计结果,在G2网络中添加肢体几何约束。在SHN姿态估计结果中,可将人体姿态理解为M个关节点的定位及连接形成的肢体结构,要使预测的人体姿态更接近真实的姿态,则关节点定位应更接近真实的关节点定位,定义

式中,δ为阈值参数,di为预测的第i个关节点与重建heatmap关节点间的归一化距离,

为了避免对抗训练中G2或D2太好或太坏而导致的不稳定问题,采用文献[ 15]中的边界参数均衡思想,用参数kt权衡G2和D2间的对抗训练。在第t+1次迭代中,参数kt的更新可表示为

式中,ξ、λk为权衡自变量,kt为Lfake的相关权重参数。当G2生成的姿态估计结果能使Ladv足够小,表明G2的表现比D2更好,Lfake比ξ(Lreal+

表 3. 第二次生成对抗的训练流程

Table 3. Training process of the secondary generation adversary

|

3 实验及结果分析

3.1 数据集

通过LSP[16]和MPII数据集[17]对本方法进行测试,LSP数据集包括11000张和1000张从运动场景中截取的人体姿态图像,分别用于训练和测试,每张图像有14个注释的关节点;MPII数据集包括30000张和10000张从YouTube网站视频中截取的人体姿态图像,分别用于训练和测试,每张图像有16个注释的关节点。

3.2 实验设置

因为部分训练图像中存在多个人体姿态,因此需对部分样本进行预处理,以图像中主要人体的髋部为中心进行裁剪,同时将图像的分辨率统一为256 pixel×256 pixel。

在生成对抗训练中,堆叠沙漏网络为4个沙漏网络级联的结构,以步长为2的7×7卷积层开始,输入分辨率为256 pixel×256 pixel 的图像,后接沙漏网络中的残差模块均为BN-ReLU-conv(1×1)-BN-ReLU-conv(3×3)-BN-ReLU-conv(1×1)的bottleneck结构[18],其中,BN为批归一化,ReLU为线性整流函数,括号内为卷积层的尺寸。两个1×1卷积层分别用于降维和升维,可在保持bottleneck输入/输出维度不变的情况下减少卷积核的参数数量。同时结合最大池化层在网络前半部不断降低图像分辨率,并在后半部通过上采样恢复分辨率,最终输出分辨率为64 pixel×64 pixel 的heatmap。

在第一次生成对抗训练中,使用RMSProp[19]优化器优化网络,训练时首先将学习率设置为2.5×10-4对D1单独训练,然后保持D1不变,使用相同的学习率训练G1网络的ASR和AHO两种图像增强方式,最后将学习率降低为5×10-5对G1和D1进行联合对抗训练;在第二次生成对抗训练中,同样使用RMSProp优化器,设置学习率为2.5×10-4对G2和D2进行第二次联合对抗训练。

3.3 评估指标

采用关键点正确估计百分比(PCK)评价本方法对LSP数据集[20]的估计结果,PCK以躯干直径作为归一化参考,计算检测的关键点

式中,ylhip和yrshoulder分别为左髋部和右肩部的ground truth坐标,r为大小在0到1之间的阈值。对MPII数据集采用正确关键点的头部归一化概率(PCKh)[17]作为实验评估指标,与PCK不同的是,PCKh以头部长度作为归一化参考。

3.4 实验结果分析

表 4. 不同方法在LSP数据集的PCK

Table 4. PCK of different methods in LSP data setunit: %

|

表 5. 不同方法在MPII数据集的PCKh

Table 5. PCKh of different methods in the MPII data setunit: %

|

将文献[

4]、文献[

10]、文献[

11]以及本方法在MPII测试集上测试的一种heatmap估计结果进行可视化比较,从四种SHN输出的混合特征heatmap中提取出单特征关节点heatmap,并对腕部、肘部、肩部和膝部的关节点heatmap进行可视化,如

![不同方法得到的heatmaps。(a)文献[4];(b)文献[10]; (c)文献[11];(d)本方法](/richHtml/lop/2020/57/20/201509/img_9.jpg)

图 9. 不同方法得到的heatmaps。(a)文献[ 4];(b)文献[ 10]; (c)文献[ 11];(d)本方法

Fig. 9. Heatmaps obtained by different methods. (a) Ref. [4]; (b) Ref. [10]; (c) Ref. [11]; (d) ours

表 6. 模型使用效率的对比

Table 6. Comparison of model efficiency

|

4 结论

以SHN作为优化目标,将SHN与两种不同思路的GAN进行融合,并将肢体几何约束加入训练模型中。实验结果表明,相比其他的人体姿态估计网络,本方法经两次训练得到的人体姿态估计精度有一定程度的提高,在LSP和MPII测试集的平均PCK和PCKh均有所提升,估计误差有所降低。但如何在保持估计精度的前提下降低模型的大小和复杂度,提升模型的使用效率,还需进一步研究。

[1] AndrilukaM, RothS, SchieleB. Pictorial structures revisited: people detection and articulated pose estimation[C]∥2009 IEEE Conference on Computer Vision and Pattern Recognition, June 20-25, 2009, Miami, FL, USA. New York: IEEE, 2009: 1014- 1021.

[2] LadickyL, Torr P H S, Zisserman A. Human pose estimation using a joint pixel-wise and part-wise formulation[C]∥2013 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2013, Portland, OR, USA. New York: IEEE, 2013: 3578- 3585.

[4] NewellA, Yang KY, DengJ. Stacked hourglass networks for human pose estimation[M] ∥Leibe B, Matas J, Sebe N, et al. Computer Vision-ECCV 2016. Lecture Notes in Computer Science. Cham: Springer, 2016, 9912: 483- 499.

[5] Luo JY, XuY, Tang CW, et al. Learning inverse mapping by autoencoder based generative adversarial nets[M] ∥ Liu D, Xie S, Li Y, et al. Neural Information Processing. ICONIP 2017. Lecture Notes in Computer Science. Cham: Springer, 2017, 10635: 207- 216.

[6] 刘坤, 王典, 荣梦学. 基于半监督生成对抗网络X光图像分类算法[J]. 光学学报, 2019, 39(8): 0810003.

[7] 杨晓莉, 蔺素珍, 禄晓飞, 等. 基于生成对抗网络的多模态图像融合[J]. 激光与光电子学进展, 2019, 56(16): 161004.

[8] 张清博, 张晓晖, 韩宏伟. 基于改进生成对抗网络的水下激光图像后向散射光修复方法[J]. 激光与光电子学进展, 2019, 56(4): 041004.

[9] Wang XL, ShrivastavaA, GuptaA. A-fast-RCNN: hard positive generation via adversary for object detection[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 3039- 3048.

[10] PengX, Tang ZQ, YangF, et al. Jointly optimize data augmentation and network training: adversarial data augmentation in human pose estimation[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE, 2018: 2226- 2234.

[11] Chou CJ, Chien JT, Chen HT. Self adversarial training for human pose estimation[EB/OL]. [2020-01-02].https:∥arxiv.org/abs/1707. 02439.

[12] ChenY, Shen CH, Wei XS, et al. Adversarial PoseNet: a structure-aware convolutional network for human pose estimation[C]∥2017 IEEE International Conference on Computer Vision (ICCV), October 22-29, 2017, Venice, Italy. New York: IEEE, 2017: 1221- 1230.

[13] SzegedyC, IoffeS, VanhouckeV, et al. Inception-v4, inception-ResNet and the impact of residual connections on learning[EB/OL]. [2019-12-28].http:∥arxiv.org/abs/1602. 07261.

[14] TompsonJ, JainA, LecunY, et al. Joint training of a convolutional network and a graphical model for human pose estimation[EB/OL]. [2020-01-01].https:∥arxiv.org/abs/1406. 2984.

[15] BerthelotD, SchummT, MetzL. BEGAN: boundary equilibrium generative adversarial networks[EB/OL]. [2019-12-30].https:∥www.arxiv.org/abs/1703. 10717.

[16] JohnsonS, EveringhamM. Clustered pose and nonlinear appearance models for human pose estimation[C]∥Procedings of the British Machine Vision Conference, BMVC 2010, August 31-September 3, 2010, Aberystwyth, UK. UK: BMVA, 2010: 1- 11.

[17] AndrilukaM, PishchulinL, GehlerP, et al. 2D human pose estimation: new benchmark and state of the art analysis[C]∥2014 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2014, Columbus, OH, USA. New York: IEEE, 2014: 3686- 3693.

[18] Sze V, Chen Y H, Yang T J, et al. Efficient processing of deep neural networks: a tutorial and survey[J]. Proceedings of the IEEE, 2017, 105(12): 2295-2329.

[19] Tieleman T, Hinton G. Lecture 6.5-rmsprop: divide the gradient by a running average of its recent magnitude[J]. COURSERA: Neural Networks for Machine Learning, 2012, 4(2): 26-31.

[20] YangY, RamananD. Articulated pose estimation with flexible mixtures-of-parts[C]∥CVPR 2011, June 20-25, 2011, Providence, RI, USA. New York: IEEE, 2011: 1385- 1392.

[21] Wei SH, RamakrishnaV, KanadeT, et al. Convolutional pose machines[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 4724- 4732.

张显坤, 张荣芬, 刘宇红. 基于二次生成对抗的人体姿态估计[J]. 激光与光电子学进展, 2020, 57(20): 201509. Xiankun Zhang, Rongfen Zhang, Yuhong Liu. Human Pose Estimation Based on Secondary Generation Adversary[J]. Laser & Optoelectronics Progress, 2020, 57(20): 201509.